霉霉開口唱碧昂絲的歌,又是AI!口型不出戲,五官姿態也自然,復旦百度等出品|GitHub攬星1k+ 精華

一張人像、一段音頻參考,就能讓霉霉在你面前唱碧昂絲的《Halo》。

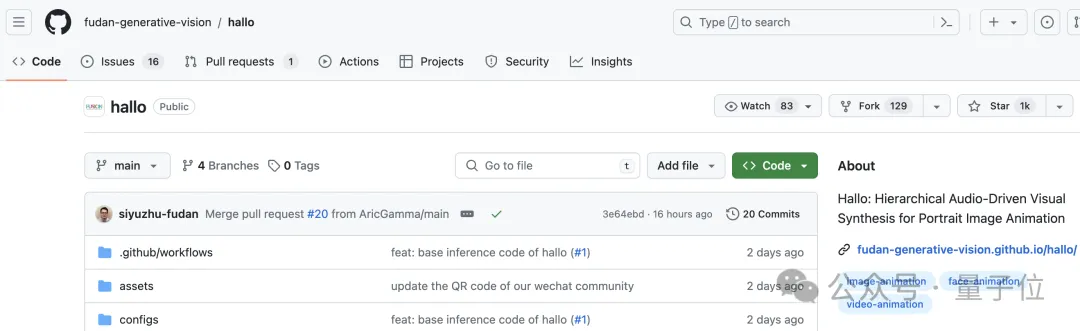

一種名為Hallo的研究火了,GitHub已攬星1k+。

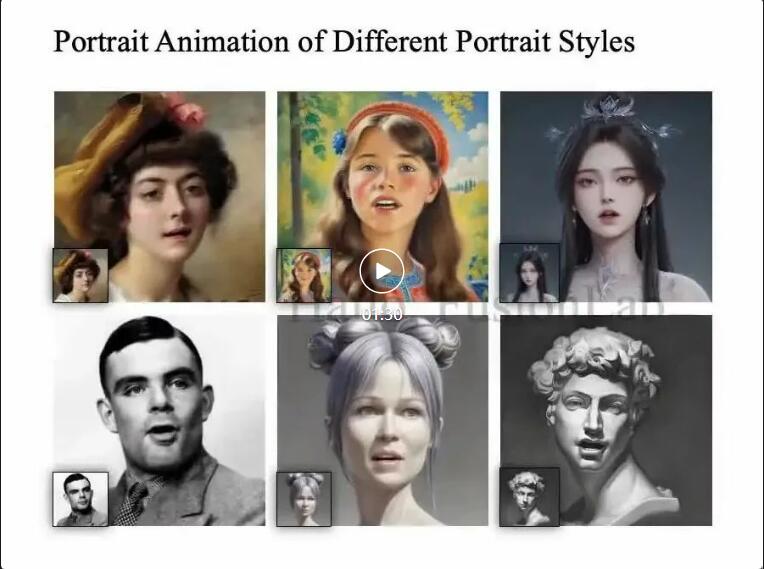

話不多說,來看更多效果:

不論是說話還是唱歌,都能和各種風格的人像相匹配。從口型到眉毛眼睛動作,各種五官細節都很自然。

單獨拎出不同動作強度的比較,動作幅度大也能駕馭:

單獨調整嘴唇運動幅度,表現是這樣嬸兒的:

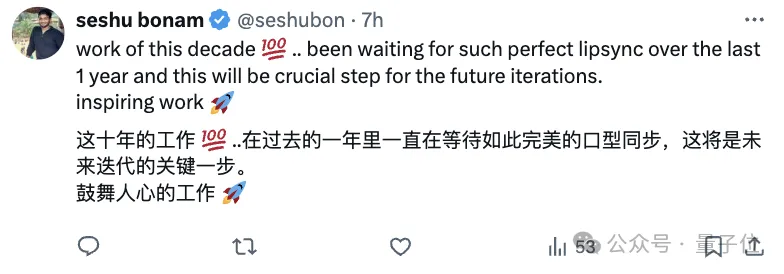

有不少網友看過效果后,直呼這是目前最好的開源口型同步視頻生成:

這項工作由來自復旦大學、百度、蘇黎世聯邦理工學院和南京大學的研究人員共同完成。

團隊提出了分層的音頻驅動視覺合成模塊,將人臉劃分為嘴唇、表情和姿態三個區域,分別學習它們與音頻的對齊關系,再通過自適應加權將這三個注意力模塊的輸出融合在一起,由此可以更精細地建模音視頻同步。

Hallo長啥樣?

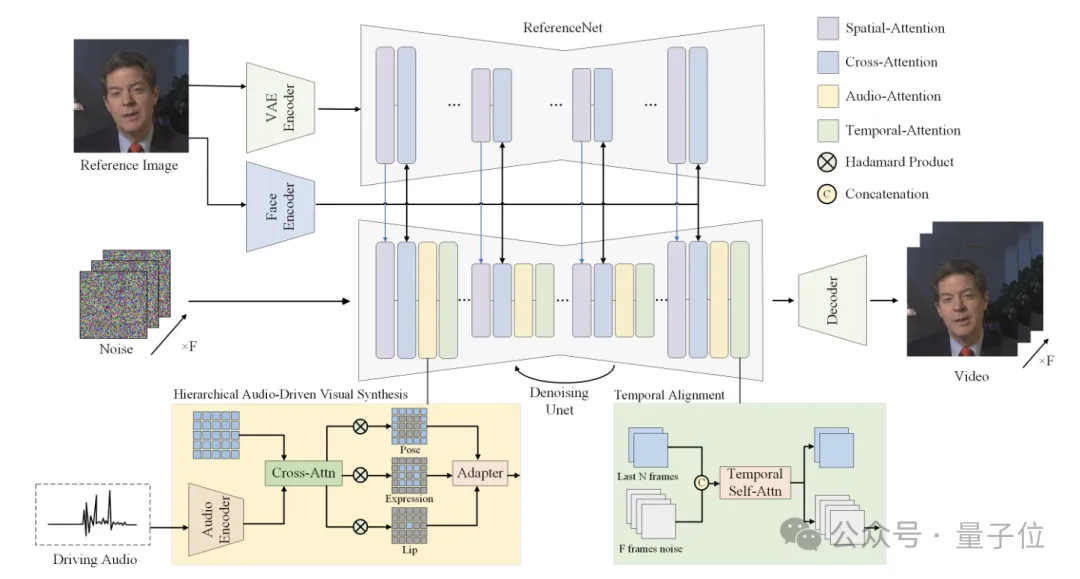

如前文所述,Hallo通過使用參考圖像、音頻序列以及可選的視覺合成權重,結合基于分層音頻驅動視覺合成方法的擴散模型來實現。

整體架構是這樣嬸兒的:

參考圖像經過一個ReferenceNet編碼全局視覺特征;人臉編碼器提取身份相關的特征;音頻編碼器將輸入語音轉換為與運動相關的特征表示;分層音頻驅動視覺合成模塊用于在唇部、表情、姿態三個層次建立音視頻的關聯;最后通過擴散模型中的UNet完成去噪,生成視頻幀。

- 擴散模型主干網絡(Diffusion Backbone)

采用Stable Diffusion 1.5作為基礎架構,包括三個主要部分:VQ-VAE編碼器、基于UNet的去噪模型、條件編碼模塊。與傳統的文本驅動擴散模型不同,Hallo去掉了文本條件,轉而使用音頻特征作為主要的運動控制條件。

- 參考圖像編碼器(ReferenceNet)

ReferenceNet用于從參考圖像中提取全局視覺特征,指導視頻生成過程的外觀和紋理。結構與擴散模型的UNet解碼器共享相同的層數和特征圖尺度,便于在去噪過程中融合參考圖像特征。在模型訓練階段,視頻片段的第一幀作為參考圖像。

- 時序對齊模塊(Temporal Alignment)

Temporal Alignment用于建模連續視頻幀之間的時間依賴關系,保證生成視頻的時序連貫性。從前一推理步驟中選取一個子集(例如2幀)作為運動參考幀,將其與當前步驟的latent noise在時間維度上拼接,通過自注意力機制建模幀間的關聯和變化。

此外,分層音頻驅動視覺合成方法是整個網絡架構的核心部分。

其中人臉編碼器,使用預訓練的人臉識別模型,直接從參考圖像提取高維人臉特征向量;音頻編碼器使用wav2vec模型提取音頻特征,并通過多層感知機映射到運動特征空間,由此可以將語音轉換為與面部運動相關的特征表示,作為視頻生成的條件。

之后再將音頻特征分別與唇部、表情、姿態區域的視覺特征做交叉注意力,得到三個對齊后的特征表示,再通過自適應加權融合為最終的條件表示。

該方法還可以通過調節不同區域注意力模塊的權重,來控制生成視頻在表情和姿態上的豐富程度,可適應不同的人物面部特征。

Hallo表現如何?

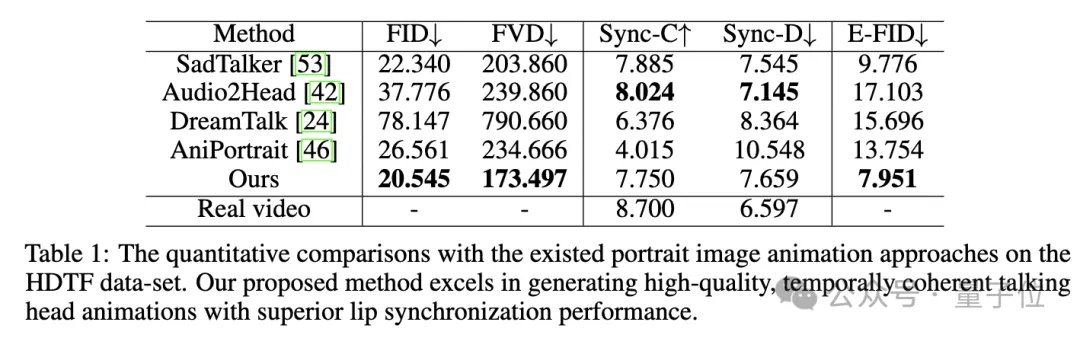

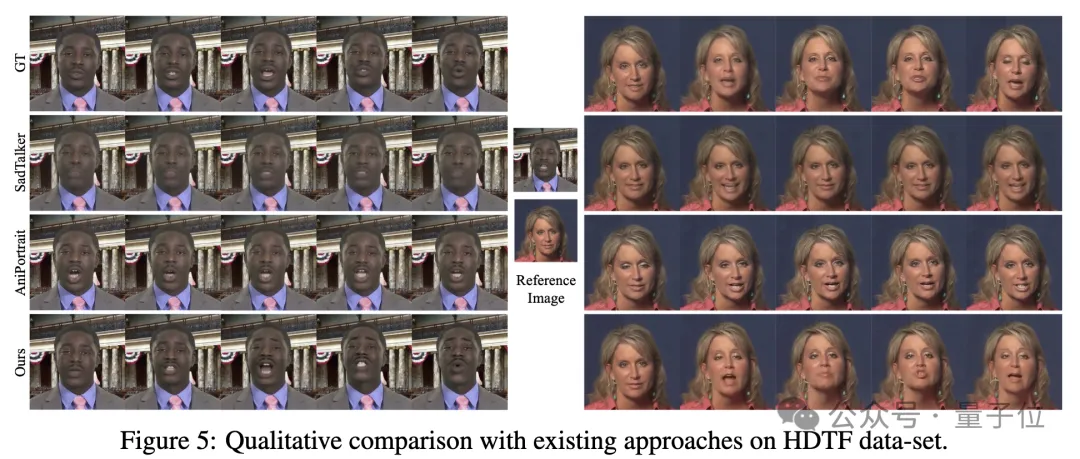

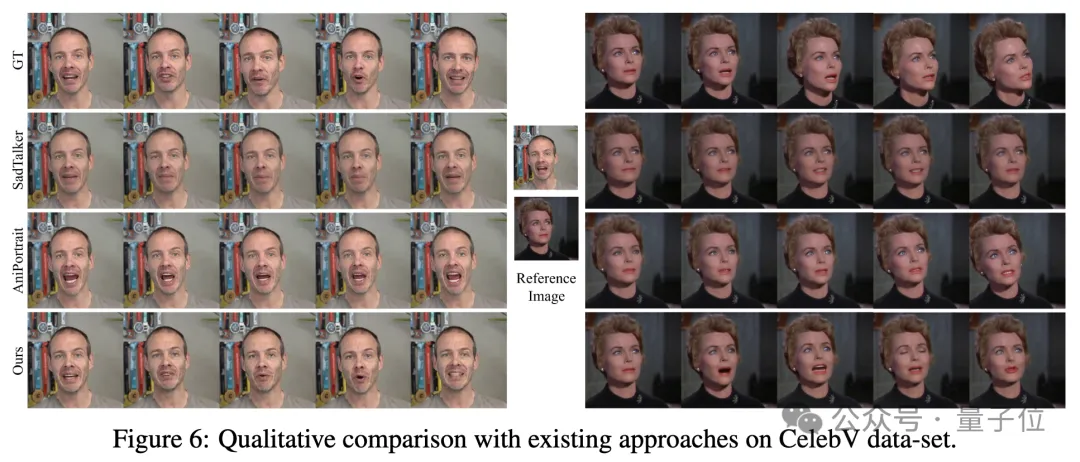

之后研究團隊將Hallo與SadTalker、DreamTalk、Audio2Head、AniPortrait等SOTA方法進行定量和定性比較。

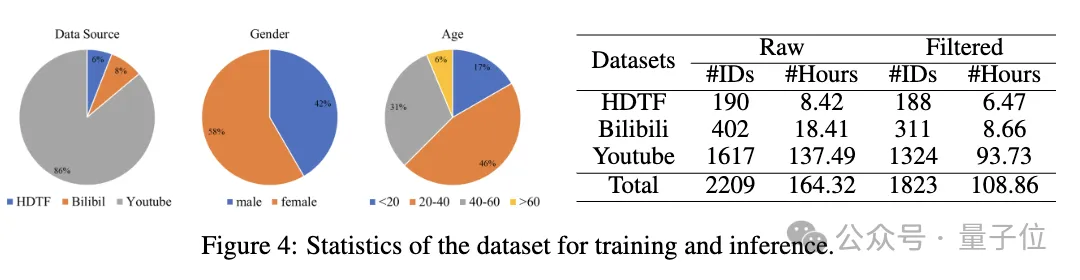

用HDTF和Bilibili、Youtube等來源的數據構建了一個大規模人像視頻數據集,經過清洗后用于訓練。

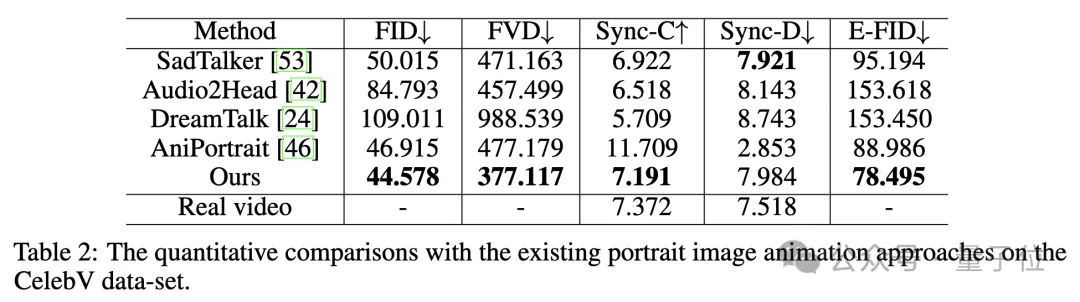

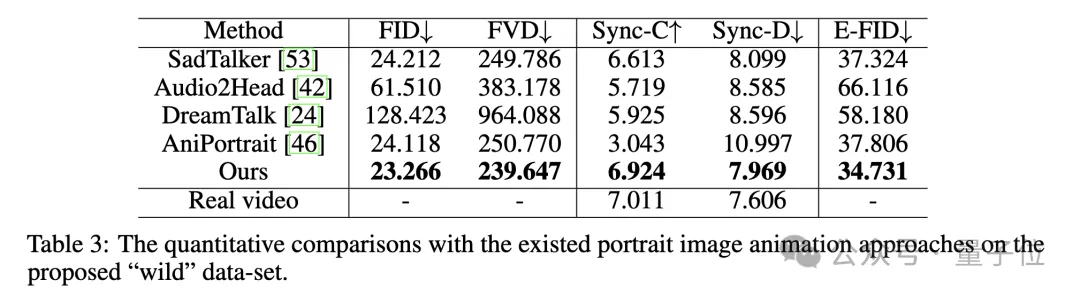

評估指標方面,采用FID、FVD評估生成視頻的真實性,Sync-C、Sync-D評估唇形同步性,E-FID評估生成人臉的保真度。

定量評估方面,在HDTF數據集上,Hallo在多個指標上表現最優:

在增強唇部同步的同時,Hallo保持了高保真視覺生成和時間一致性:

在CelebV數據集上,Hallo展示了最低的FID和FVD以及最高Sync-C:

可視化比較如下:

在自建Wild數據集上,Hallo同樣表現突出:

針對不同數據集的定性比較結果如下。

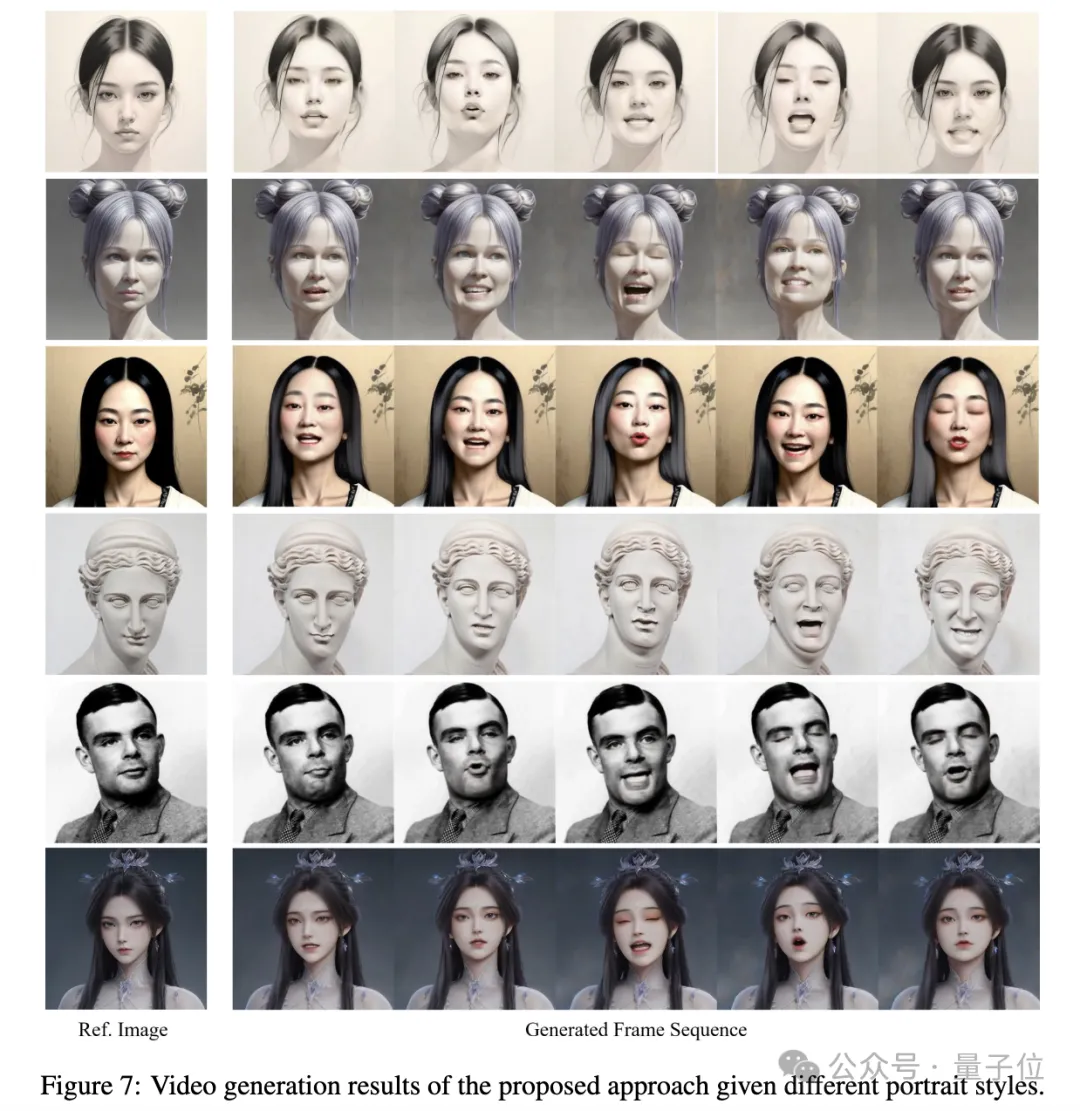

Hallo展示了對不同風格人像的驅動生成能力,體現了該方法的泛化和魯棒性:

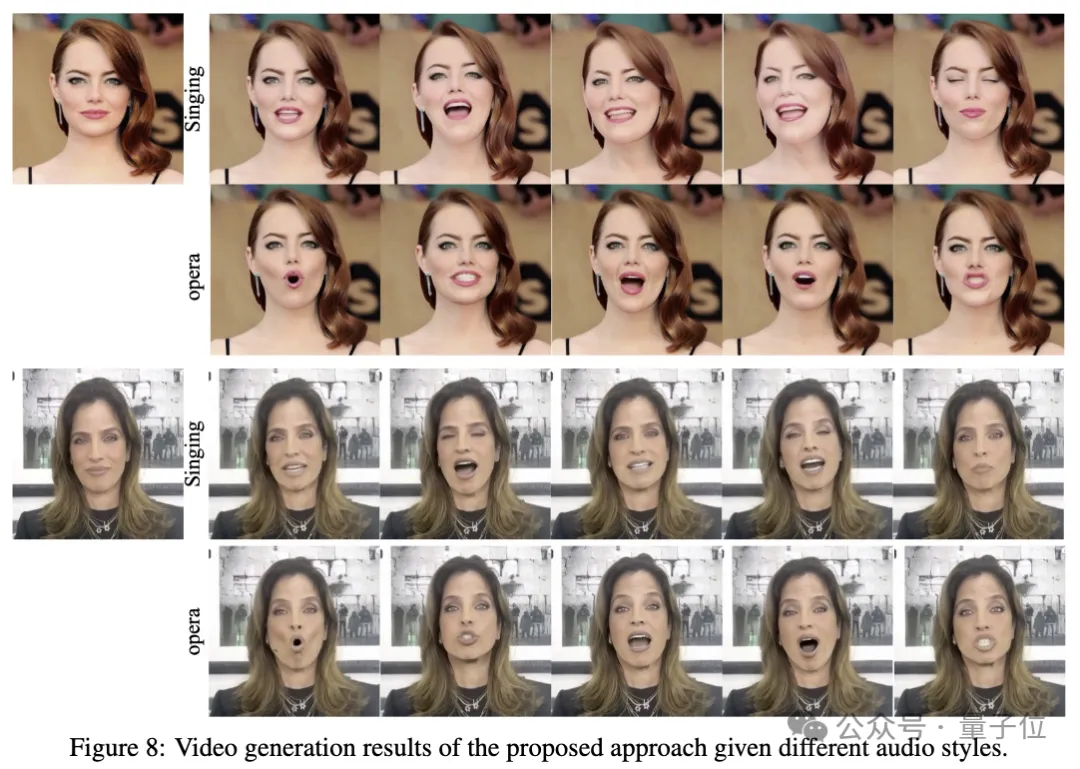

同時展示了對不同音頻的響應能力,能夠生成與音頻內容契合的高保真視頻:

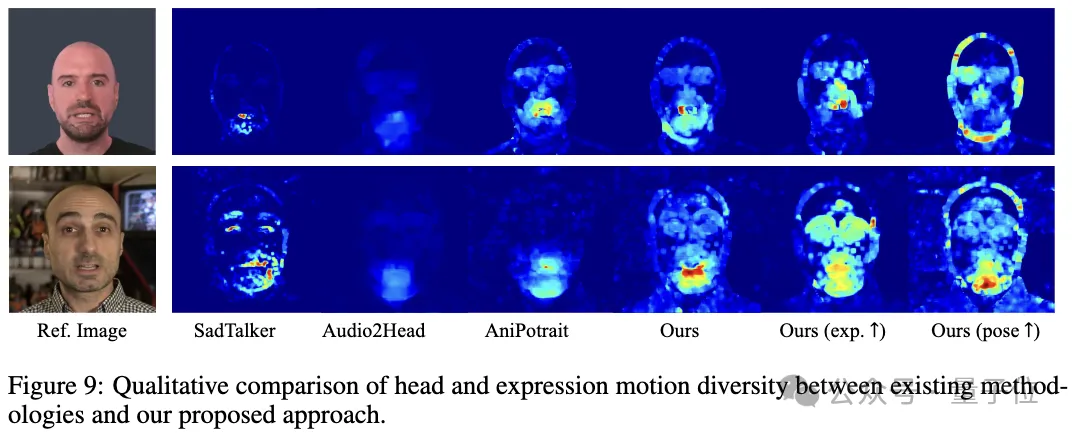

與其它方法對比,Hallo展示了更豐富自然的表情和頭部運動:

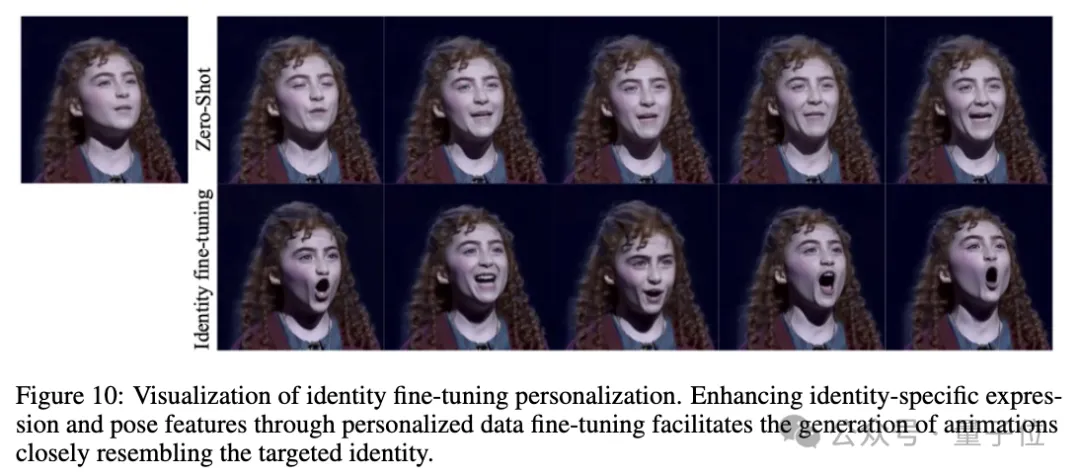

通過特定人物數據微調,展示了該方法捕獲人物特征、個性化生成的能力:

最后研究人員還進行了消融實驗,并總結了該方法的局限性,比如在快速運動場景下時序一致性還有待提高,推理過程計算效率有待優化等。

此外,經作者介紹,目前Hallo僅支持固定尺寸的人像輸入。

且該方法目前也不能實現實時生成。

針對這項研究,也有網友提出Deepfake隱患,對此你怎么看?

本文轉自 量子位 ,作者:量子位