達摩院開源VideoLLaMA3:僅7B大小,視頻理解拿下SOTA | 在線可玩

7B大小的視頻理解模型中的新SOTA,來了!

它就是由達摩院出品的Video LLaMA 3,以圖像為中心構建的新一代多模態視頻-語言模型。

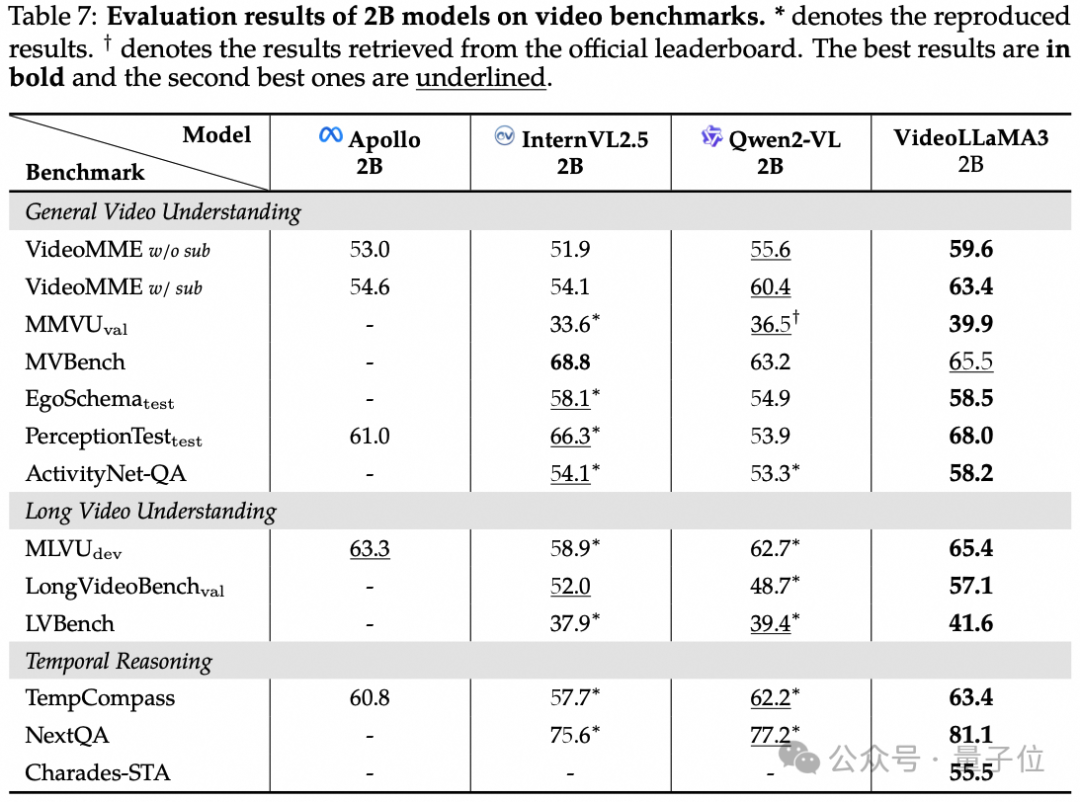

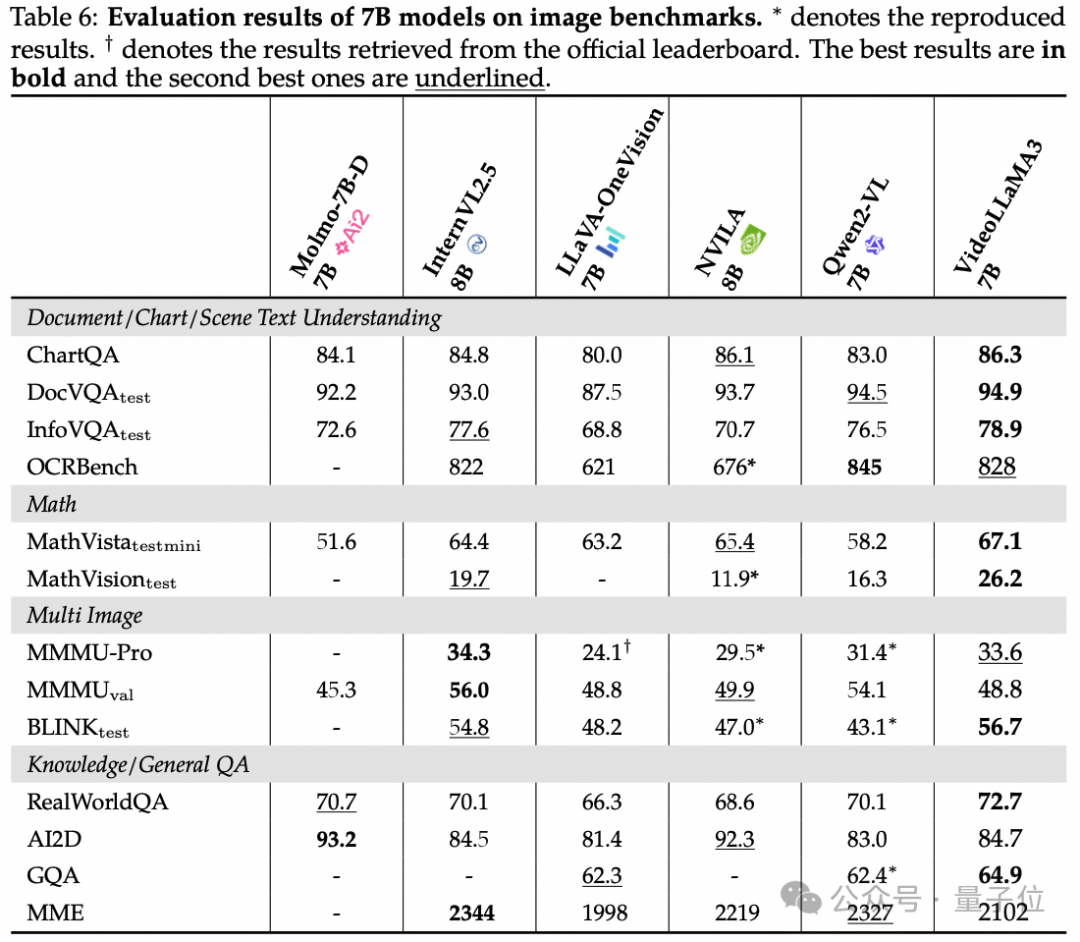

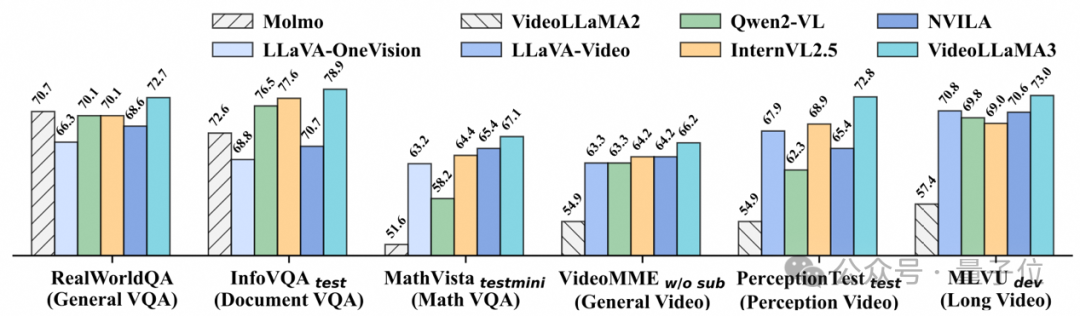

在通用視頻理解、時間推理和長視頻理解三個核心維度進行評估的過程中,VideoLLaMA 3均取得優異成績,超越多數基線模型。

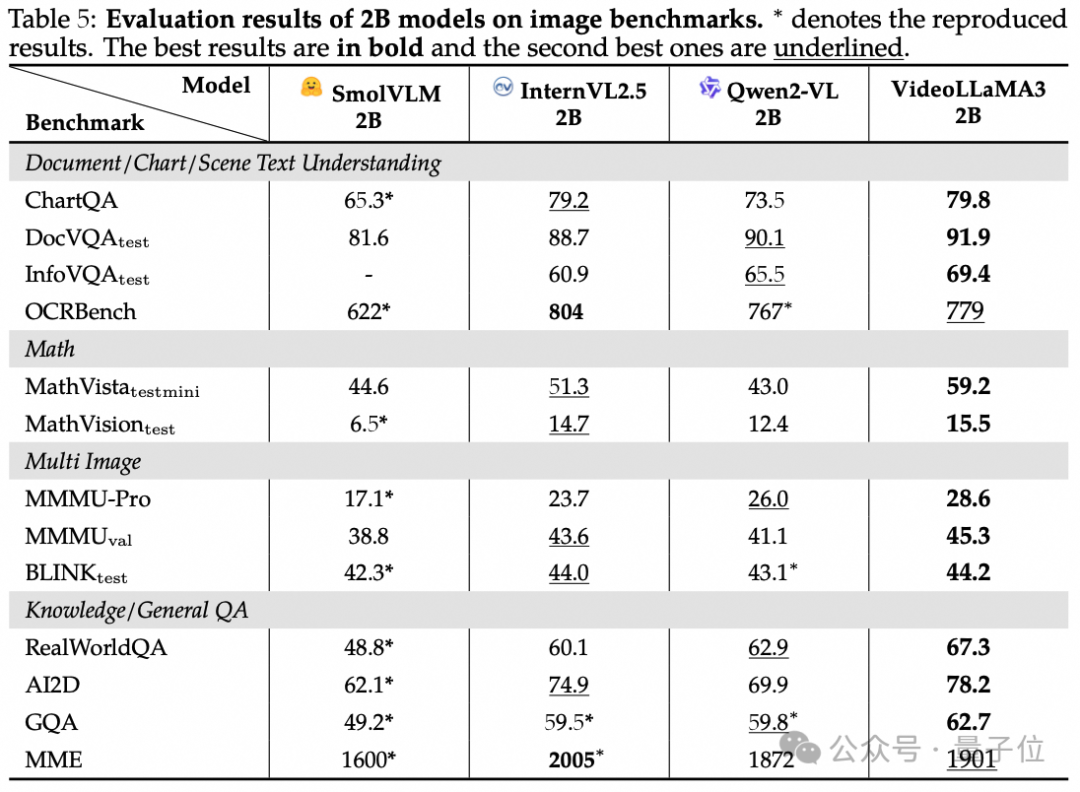

不僅如此,適用于端側的2B大小的Video LLaMA 3,在圖像理解上的表現也是較為出色。

在涵蓋文檔 / 圖表 / 場景文本理解、數學推理、多圖像理解和常識問答等多個維度的基準測試,如在InfoVQA中超越之前最好成績,在MathVista數學推理任務上優勢明顯。

VideoLLaMA 3以圖片為中心的設計理念貫穿于整個模型架構和訓練過程。

通過高質量的圖片文本數據為視頻理解打下堅實基礎,僅使用3M視頻文本數據,實現全面超越同參數量開源模型的視頻理解能力。

在線可玩

目前,VideoLLaMA 3已經在HuggingFace上提供了圖像、視頻理解的demo。

例如我們給一張《蒙娜麗莎的微笑》,并向VideoLLaMA 3提問:

Discuss the historical impact and the significance of this painting in the art world.

討論這幅畫在藝術界的歷史影響和意義。

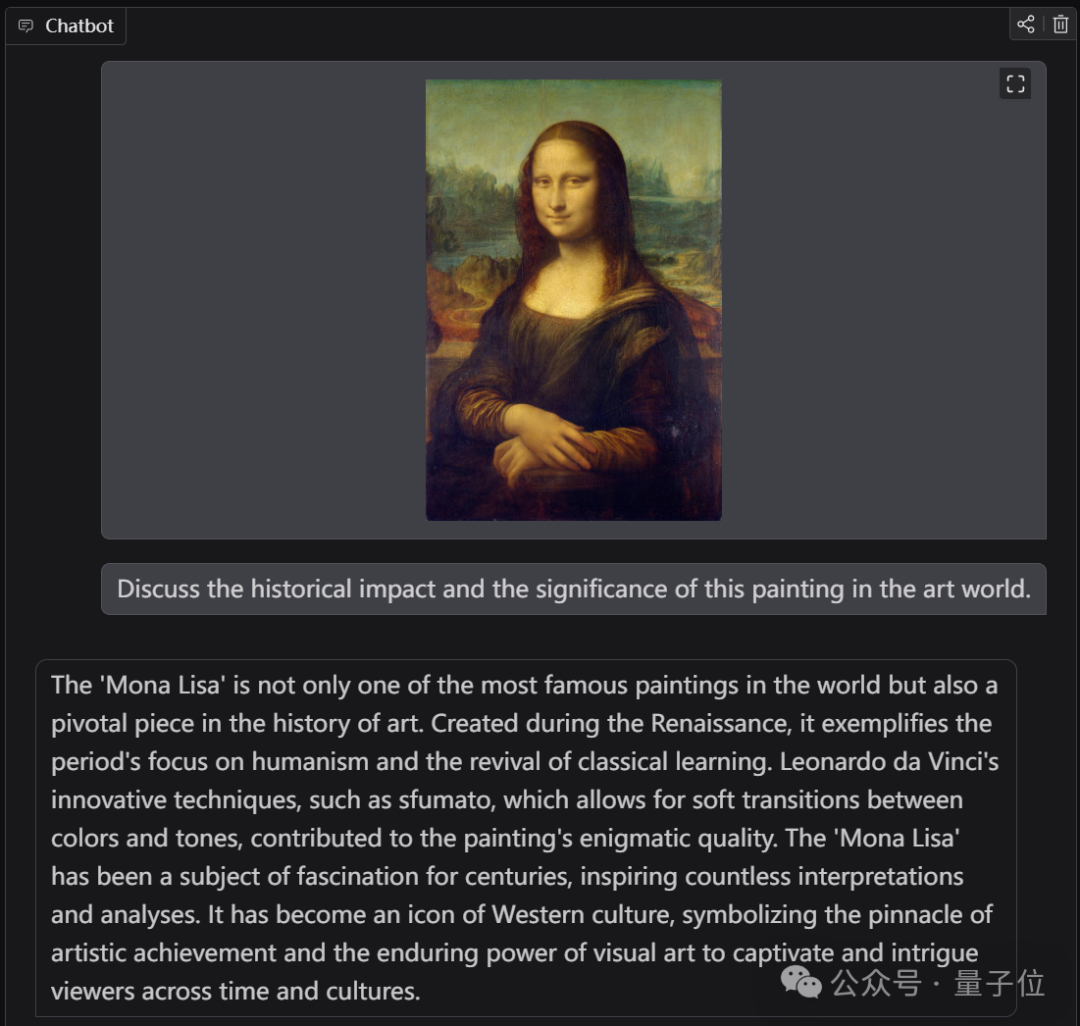

VideoLLaMA 3的回答是這樣的:

《蒙娜麗莎》不僅是世界上最著名的畫作之一,也是藝術史上的重要作品。它創作于文藝復興時期,體現了該時期對人文主義的關注和古典學習的復興。列奧納多·達·芬奇的創新技術,如在色彩和色調之間進行柔和過渡的模糊手法,為這幅畫的神秘品質做出了貢獻。幾個世紀以來,《蒙娜麗莎》一直是一個迷人的主題,激發了無數的解釋和分析。它已成為西方文化的標志,象征著藝術成就的頂峰,象征著視覺藝術對跨越時間和文化的觀眾的持久魅力。

再來看下視頻理解的demo,我們的問題是:

What is unusual in the video?

視頻中有什么不尋常之處?

對此,VideoLLaMA 3表示:

這段視頻的不同尋常之處在于,它展示了熊這種典型的野生動物,正在進行一種類似人類的活動,比如在桌子上吃壽司。

VideoLLaMA 3回答可謂是非常簡約且精準了。

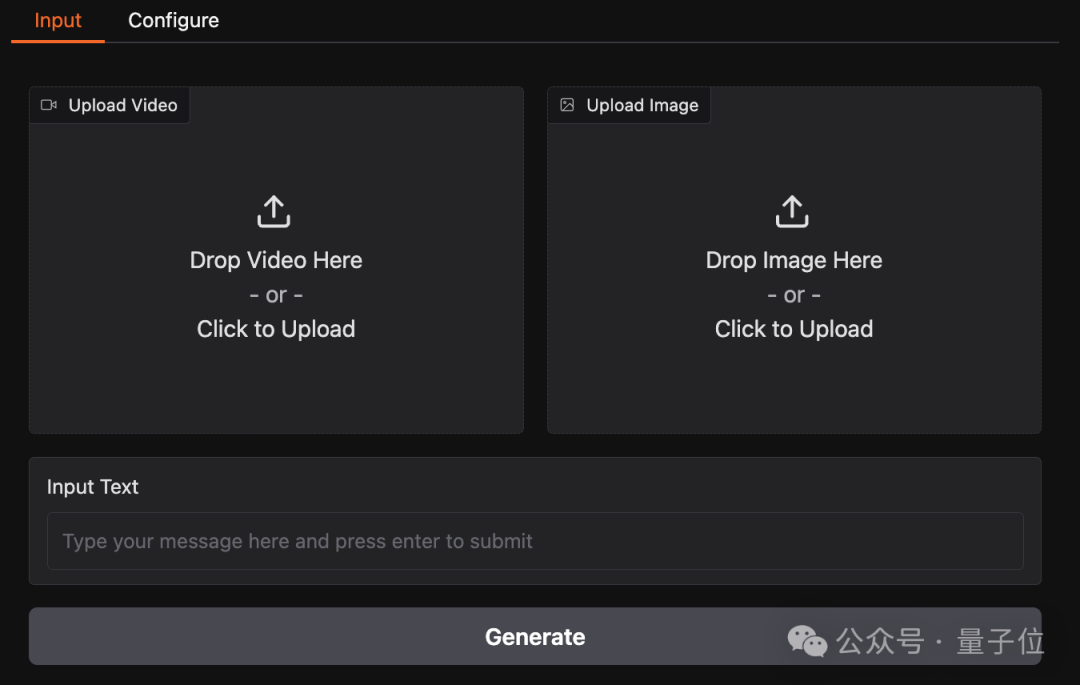

并且這個demo在HuggingFace上的操作也是極其簡單,只需上傳圖片或視頻,再提出你的問題即可。

怎么做到的?

VideoLLaMA 3的關鍵,在于它是一種以圖像為中心的訓練范式。

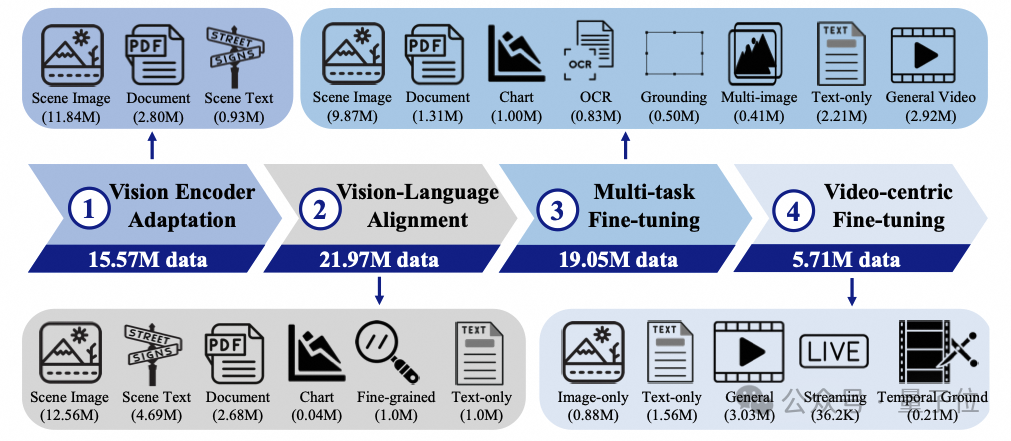

這種范式主要包含四個關鍵內容:

- 視覺編碼器適配:讓視覺編碼器能處理動態分辨率圖像,用不同場景圖像提升其性能,使其能捕捉精細視覺細節。

- 視覺語言對齊:用豐富圖像文本數據為多模態理解打基礎,利用多種數據增強空間推理能力,同時保留模型語言能力。

- 多任務微調:用圖像文本問答數據和視頻字幕數據微調模型,提升其遵循自然語言指令和多模態理解能力,為視頻理解做準備。

- 視頻微調:增強模型視頻理解和問答能力,訓練數據包含多種視頻及圖像、文本數據。

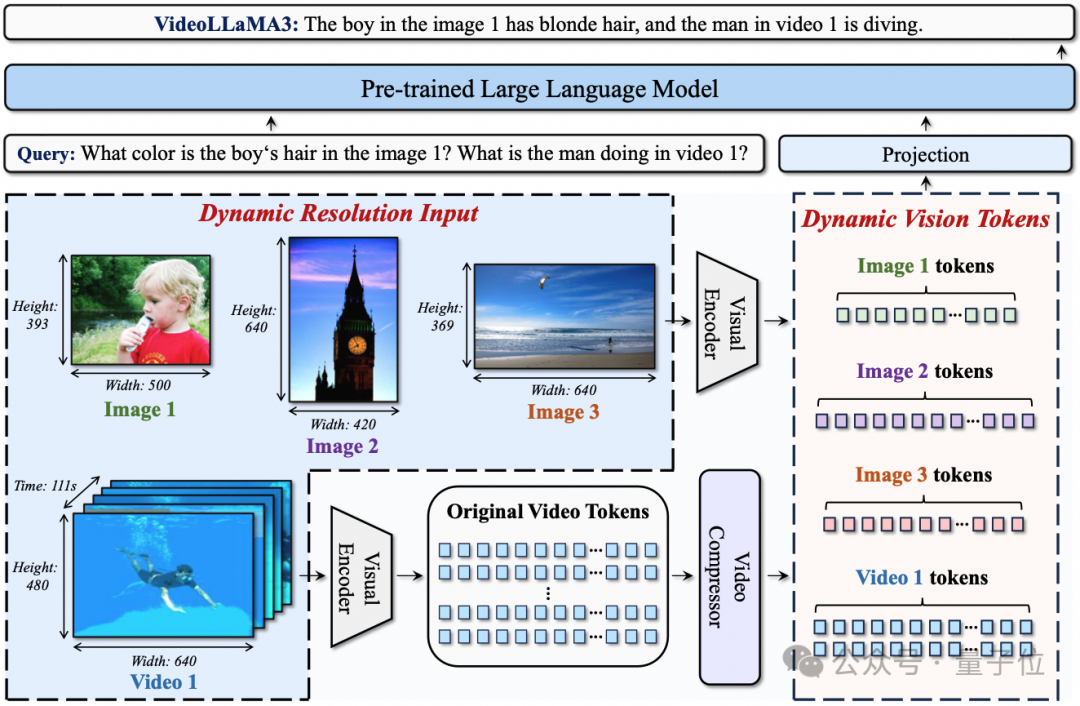

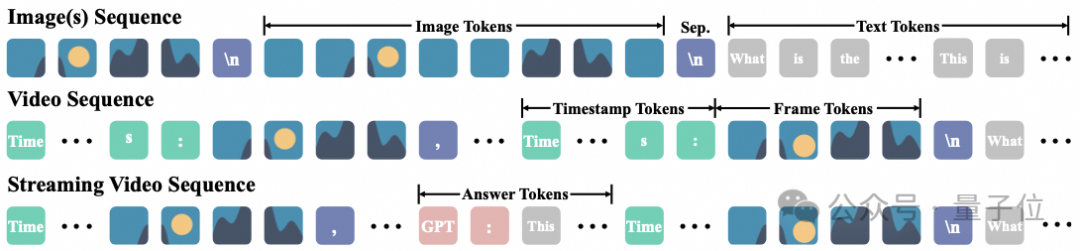

從框架設計來看,主要包含兩大內容。

首先是任意分辨率視覺標記化(AVT)。

這種方法突破了傳統固定分辨率限制,采用2D - RoPE替換絕對位置嵌入,讓視覺編碼器能處理不同分辨率圖像和視頻,保留更多細節。

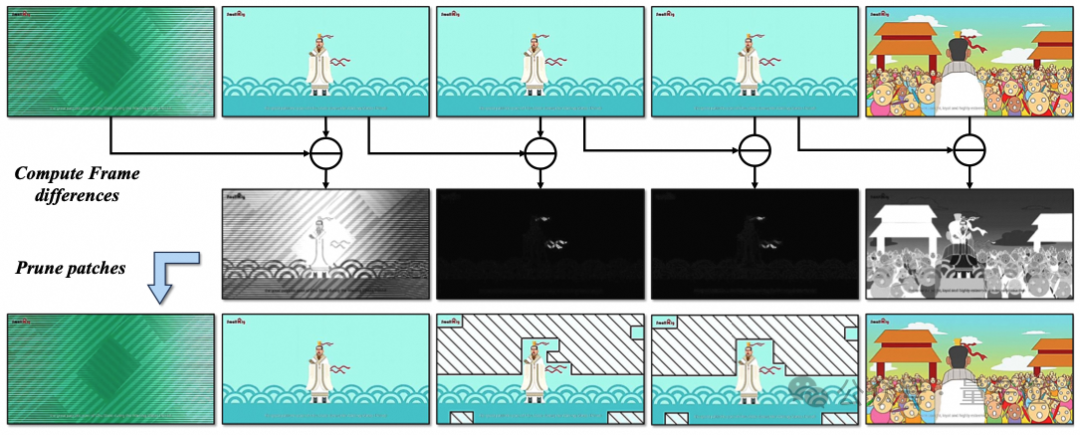

其次是差分幀剪枝器(DiffFP)。

針對視頻數據冗余問題,通過比較相鄰幀像素空間的1-范數距離,修剪冗余視頻標記,提高視頻處理效率,減少計算需求。

除了框架之外,高質量數據也對VideoLLaMA 3的性能起到了關鍵作用。

首先是高質量圖像重新標注數據集VL3Syn7M的構建。

為給 VideoLLaMA 3 提供高質量訓練數據,團隊構建了包含700萬圖像-字幕對的VL3Syn7M數據集。

- Aspect Ratio Filtering(長寬比過濾):圖像長寬比可能影響模型特征提取。像一些長寬比極端的圖像,過寬或過長,會使模型在處理時產生偏差。通過過濾,確保數據集中圖像長寬比處于典型范圍,為后續準確的特征提取奠定基礎。

- Aesthetic Score Filtering(美學評分過濾):利用美學評分模型評估圖像視覺質量,舍棄低評分圖像。這一步能去除視覺效果差、構圖不佳的圖像,減少噪聲干擾,保證模型學習到的圖像內容和描述質量更高,進而提升模型生成優質描述的能力。

- Text-Image Similarity Calculation with Coarse Captioning(帶粗略字幕的文本-圖像相似度計算):先用 BLIP2 模型為圖像生成初始字幕,再借助CLIP模型計算文本 - 圖像相似度,剔除相似度低的圖像。這一操作確保剩余圖像內容與描述緊密相關,使模型學習到的圖文對更具可解釋性和代表性。

- Visual Feature Clustering(視覺特征聚類):運用CLIP視覺模型提取圖像視覺特征,通過k-最近鄰(KNN)算法聚類,從每個聚類中心選取固定數量圖像。這樣既保證數據集多樣性,又維持語義類別的平衡分布,讓模型接觸到各類視覺內容,增強其泛化能力。

- Image Re - caption(圖像重新標注):對過濾和聚類后的圖像重新標注。簡短字幕由InternVL2-8B生成,詳細字幕則由InternVL2-26B完成。不同階段訓練使用不同類型字幕,滿足模型多樣化學習需求。

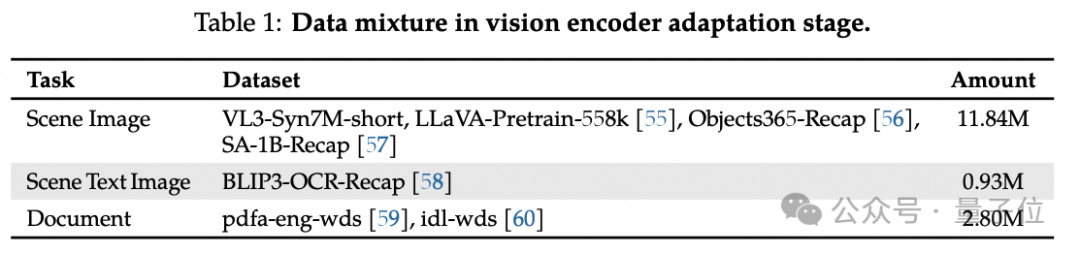

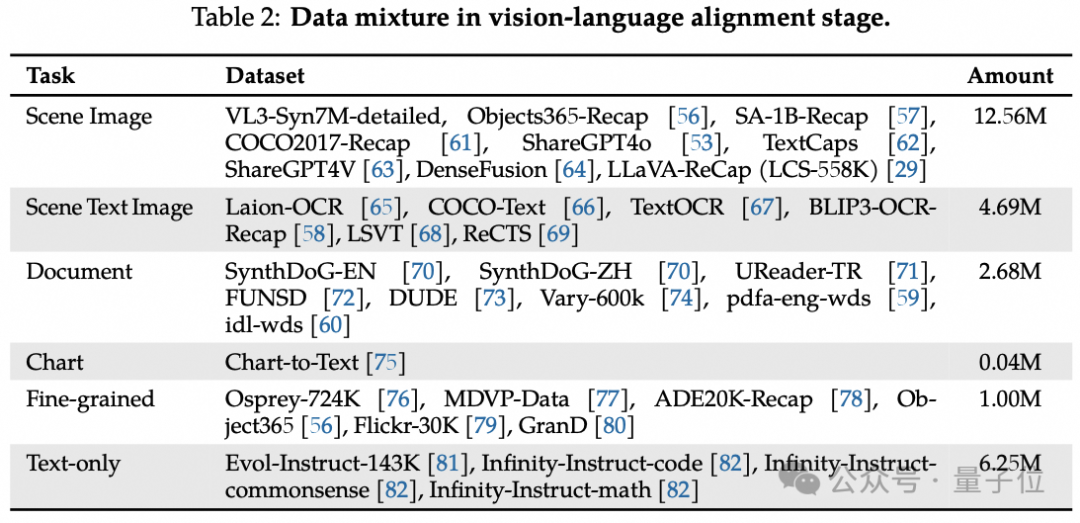

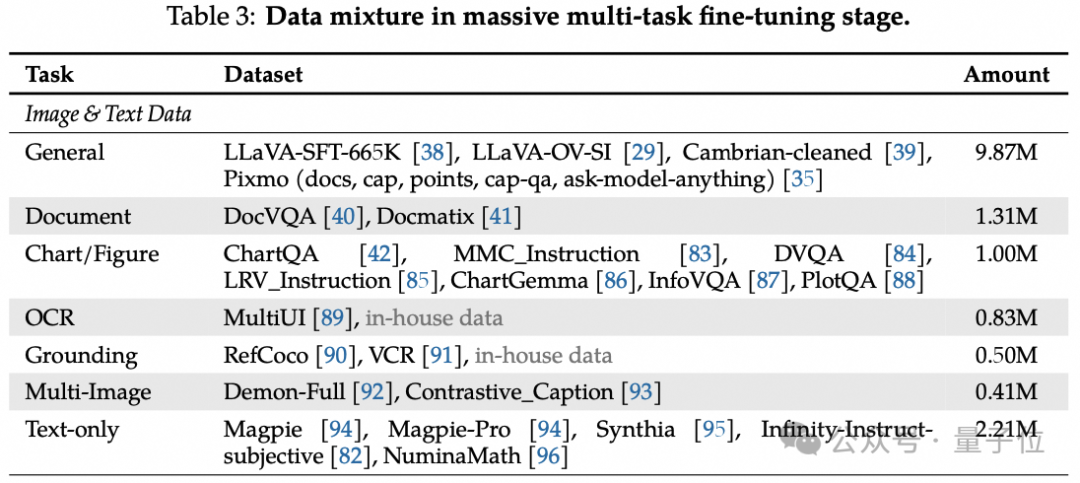

其次是各訓練階段的數據混合。

在VideoLLaMA 3的不同訓練階段,數據混合策略為模型提供了豐富多樣的學習場景。此外,團隊使用統一的數據組織形式以統一各個階段的訓練。

- Vision Encoder Adaptation(視覺編碼器適配):此階段旨在增強模型對多樣場景的理解和特征提取能力,訓練數據融合場景圖像、文檔識別圖像和少量場景文本圖像。

場景圖像來源廣泛,像VL3-Syn7M-short等,其中Object365和SA-1B數據集的引入增加了數據多樣性;場景文本圖像來自BLIP3-OCR,其文本內容和簡短重新標注都作為字幕;文檔圖像選取自pdfa-eng-wds和idl-wds,文檔文本內容按閱讀順序作為圖像字幕。

Vision-Language Alignment(視覺語言對齊):該階段使用高質量數據微調模型,涵蓋場景圖像、場景文本圖像、文檔、圖表、細粒度數據以及大量高質量純文本數據。

場景圖像整合多個數據集并重新標注;場景文本圖像包含多種中英文數據集,并對LAION數據集中圖像篩選形成 Laion-OCR數據集,其字幕包含文本內容和文本位置的邊界框注釋。

文檔圖像除常見數據集外,還加入手寫和復雜文檔數據集;圖表數據雖量少,但來自Chart-to-Text 數據集;細粒度數據包含區域字幕數據和帶框字幕數據,增強模型對圖像細節的理解。

Multi-task Fine-tuning(多任務微調):用指令跟隨數據進行指令微調,數據混合覆蓋多種任務。

圖像數據分為一般、文檔、圖表 / 圖形、OCR、定位和多圖像六類,每類針對特定視覺理解方面。同時包含大量純文本數據,提升模型處理涉及視覺和文本輸入的指令跟隨任務的能力。

視頻數據則結合常用高質量視頻字幕數據集、少量問答數據,以及VideoLLaMA2的內部數據和內部時間定位數據,增強模型視頻理解能力。

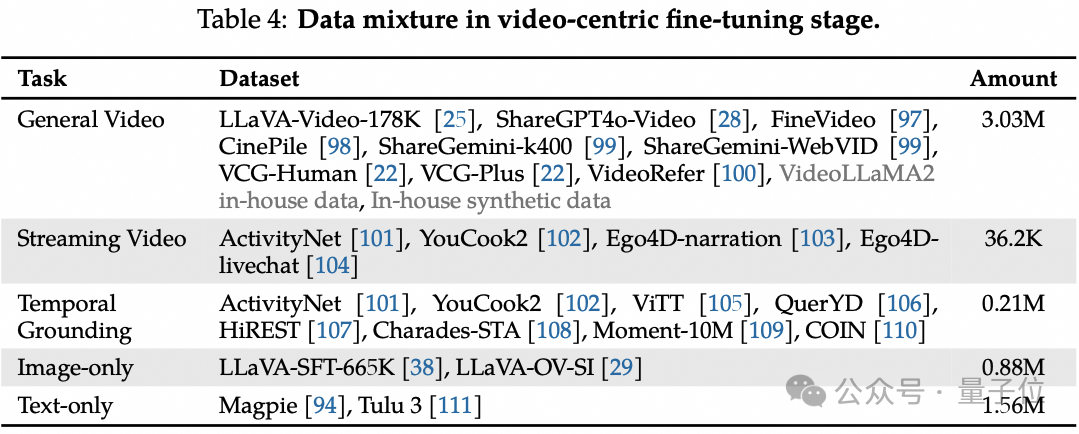

Video - centric Fine - tuning(視頻微調):此階段聚焦提升模型視頻理解能力,收集多個開源數據集中帶注釋的視頻數據,還通過合成特定方面的密集字幕和問答對擴展數據規模。

此外,引入流媒體視頻理解和時間定位特征,同時使用一定量的純圖像和純文本數據,緩解模型災難性遺忘問題。

論文和demo地址放在下面了,感興趣的小伙伴可以去體驗嘍~

論文地址:??https://arxiv.org/abs/2501.13106??

GitHub項目地址:??https://github.com/DAMO-NLP-SG/VideoLLaMA3/tree/main?tab=readme-ov-file??

圖像理解demo:??https://huggingface.co/spaces/lixin4ever/VideoLLaMA3-Image??

視頻理解demo:??https://huggingface.co/spaces/lixin4ever/VideoLLaMA3??

HuggingFace地址:??https://huggingface.co/collections/DAMO-NLP-SG/videollama3-678cdda9281a0e32fe79af15??

本文轉自量子位 ,作者:量子位