GPT-4系列模型,在文檔理解中的多維度評測

著名云數據平臺Snowflake的研究人員發布了一篇論文,主要對OpenAI的GPT-4系列模型進行了研究,查看其文本生成、圖像理解、文檔摘要等能力。

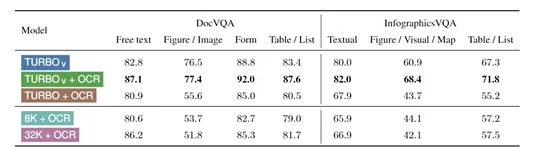

在DocVQA、InfographicsVQA、SlideVQA和DUDE數據集上對GPT-4、GPT-4 V、GPT-4 Turbo V +OCR等進行了多維度測試。

結果顯示,使用GPT-4去執行解讀文檔任務時,無法達到滿意的效果。這是因為,文檔理解不僅是對文本的解析,還涉及到對文檔布局、圖片視覺內容的理解、推理和整合。

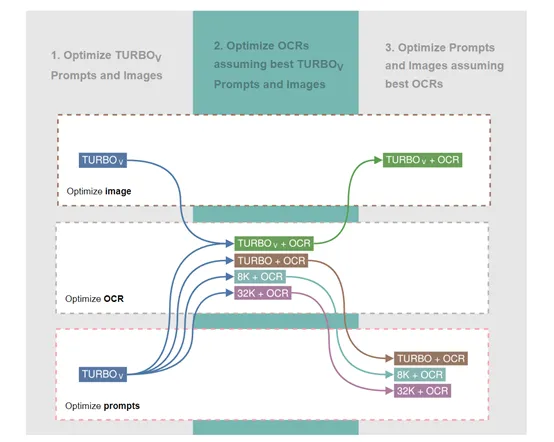

使用GPT-4 V去執行時評測數據有了很大的改善,當使用GPT-4 Turbo V+第三方OCR(光學字符識別)視覺引擎時,例如,Tesseract、Azure Cognitive 、Amazon Textract等,可明顯提升大模型的視覺理解能力。

可能存在數據污染

?

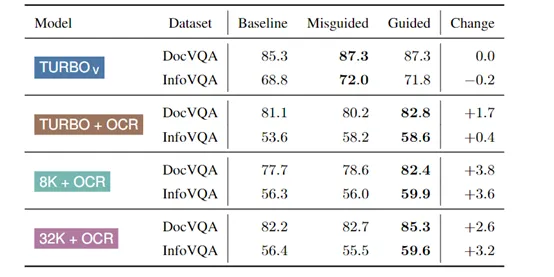

研究人員在DocVQA和InfographicsVQA兩個數據集測試GPT-4系列模型時,發現它并不是完全理解測試問題,而是之前在預訓練過程中接觸過該數據集給出了看似正確的答案,可能存在數據污染的現象。

這是因為,DocVQA和InfographicsVQA兩個數據集在GPT-4之前就已經發布,有可能在GPT-4模型訓練時被包含在內。如果這些數據集真的被包含在訓練數據中,那么模型在這些數據集上的高得分可能并不代表其真正的理解能力,而只是對訓練數據的一種記憶。

為了解開這個謎題,研究人員采用了一種“指導性指令”的技術。這種方法通過在模型的輸入提示中加入特定的數據集名稱,來檢查模型是否能夠根據數據集的特定特征給出不同的答案。

例如,如果模型在接收到“回答DocVQA數據集測試分割中的問題”的指令后,給出了與接收到“回答SQuAD數據集測試分割中的問題”的指令不同的答案,這可能表明模型對不同數據集有特定的反應。

在進行數據污染分析時,當在提示中明確提及數據集名稱時,模型的性能有所提高,這可能意味著模型在訓練時已經接觸過這些數據集,因此在評估時能夠給出更加符合預期的答案。

此外,即使是使用不同的數據集名稱進行誤導性的指導,也可能會改變模型的輸出,這進一步表明模型的輸出受到了預訓練數據的影響。

OCR能提升模型的視覺性能

?

在測試的實驗中,研究者還發現,當GPT-4 Turbo V結合了第三方OCR引擎識別的文本和文檔圖像輸入時,其在文檔理解任務上的表現有了顯著提升。

這種提升在SlideVQA和DUDE數據集上尤為明顯,能夠達到最先進的性能水平。這表明OCR技術在增強模型對文檔的視覺理解方面發揮了重要作用。

這是因為,OCR能夠將圖像中的文本內容轉換為機器可讀的格式,從而使模型能夠直接處理文本信息。

在文檔理解任務中,這意味著模型不僅能夠“看到”文檔中的文本,還能夠“理解”這些文本的含義。

但不同的OCR例如,Tesseract、Azure Cognitive Services和Amazon Textract。在不同的測試數據集上表現也各不相同。這表明在實際應用中,開發者可以根據應用場景來選擇不同的OCR來搭配使用。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區