看AI如何大海撈針,探索LLM能力邊界實戰(zhàn)?

關(guān)鍵鏈接

- 視頻介紹

- 相關(guān)代碼

概覽

隨著人工智能模型處理能力的增強,能夠處理的上下文信息越來越多,達到百萬級別的詞匯量,對于這類長上下文的大型語言模型(LLMs)的研究興趣也隨之增長。在這些模型中,一個流行的測試方法是將一個事實(稱為“針”)嵌入到大量的上下文信息(稱為“干草堆”)中,然后測試模型是否能在這個上下文中找到并回答與這個事實相關(guān)的問題。通過這個方法我們能夠評估并理解模型在處理長文本和檢索信息方面的能力邊界。

然而,這種方法并不完全適用于所有情況,尤其是對于那些需要檢索多個事實并在此基礎(chǔ)上進行推理的應(yīng)用。為了解決這個問題,我們提出了一個新的測試基準,即多針檢索加推理測試。在這個測試中,我們發(fā)現(xiàn)了兩個主要結(jié)果:

- 當要求模型檢索更多的事實時,其性能會下降。

- 當模型需要對檢索到的事實進行推理時,性能也會下降。

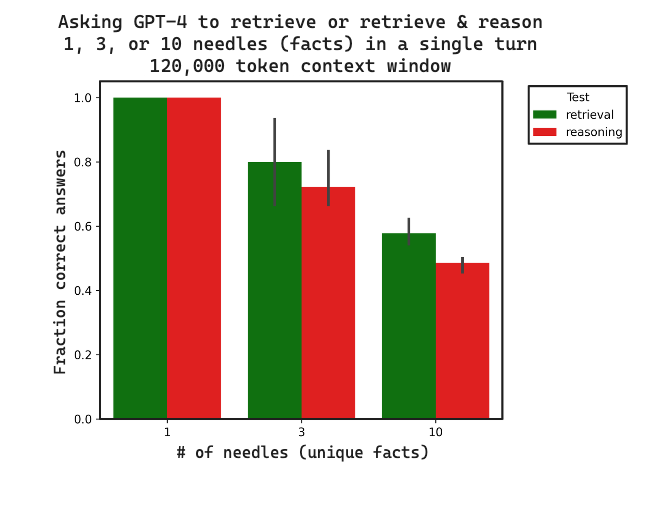

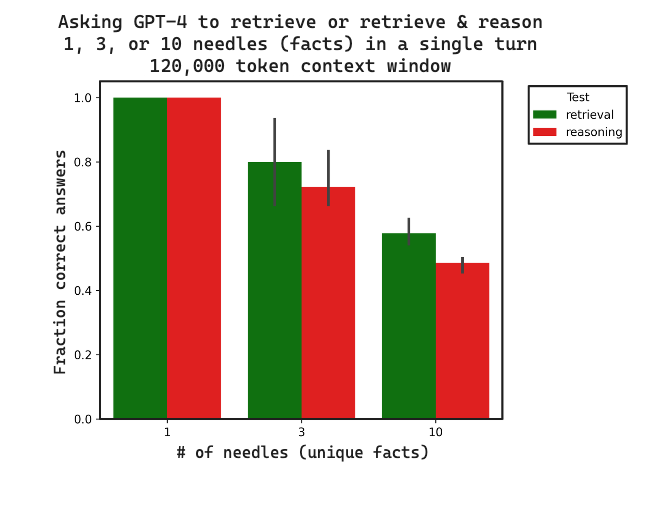

下圖展示了測試結(jié)果的概覽:隨著“針”的數(shù)量增加,檢索的準確性降低;而且,對這些“針”進行推理的難度比單純檢索更大。

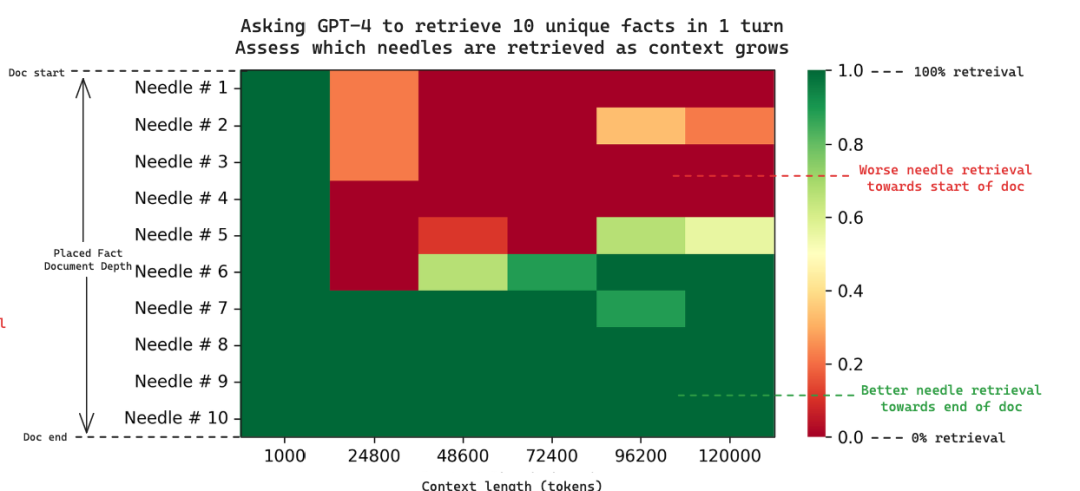

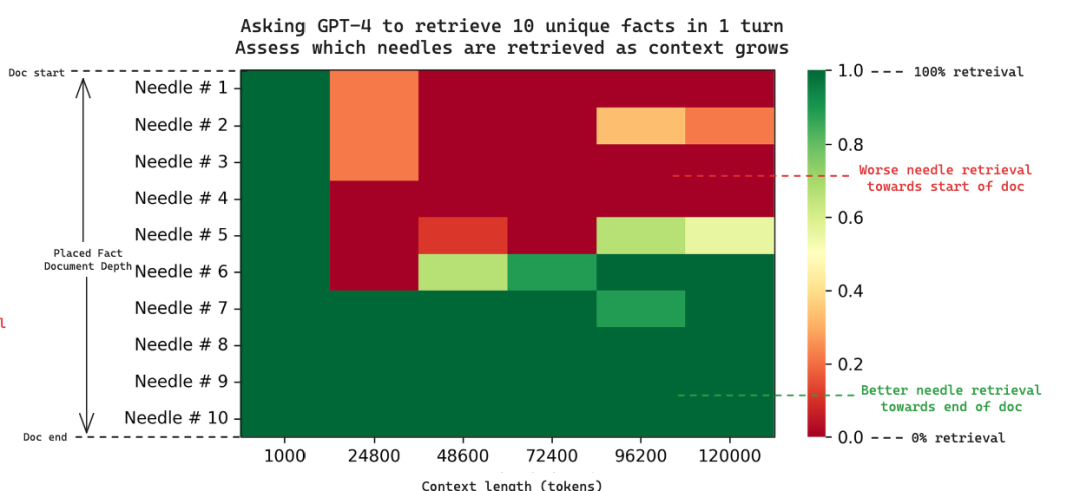

我們還發(fā)現(xiàn),隨著提供給模型的上下文信息量的增加,性能也會下降。此外,我們還深入研究了性能下降的原因,特別是當檢索多個“針”時。通過分析結(jié)果的熱圖,我們發(fā)現(xiàn)當檢索多個“針”時,GPT-4模型傾向于檢索位于上下文末尾的“針”,而忽略了開頭的“針”,這與之前的單“針”研究結(jié)果相似。

接下來,我們將詳細介紹如何使用這個基準測試,并討論在 GPT-4 模型上的測試結(jié)果。

如何使用

要進行“多針檢索加推理”的評估,用戶需要準備三個要素:

- 一個需要多個“針”來回答的“問題”

- 一個基于這些“針”得出的“答案”

- 一個將要插入上下文的“針”的列表

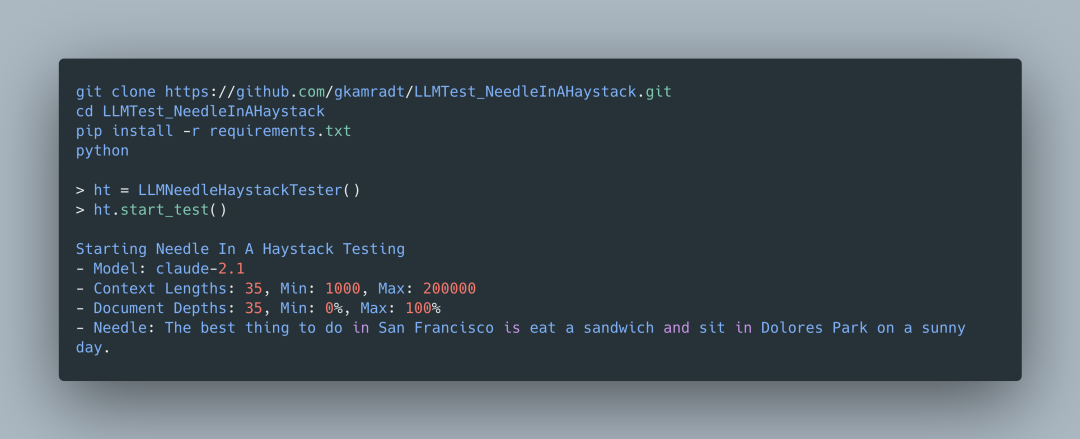

我們擴展了 Greg Kamradt 的“LLMTest_NeedleInAHaystack”項目,以支持多針評估,并且使用了 LangSmith 作為評估工具。通過 LangSmith,我們創(chuàng)建了一個評估集,其中包含了上述的“問題”和“答案”。

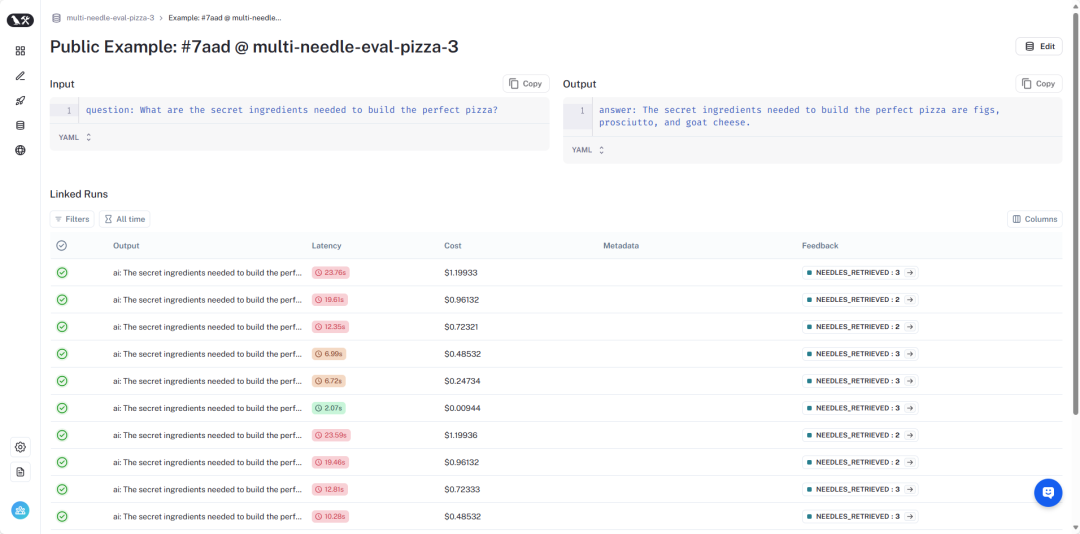

以一個實際案例為例,我們創(chuàng)建了一個新的 LangSmith 評估集,名為“multi-needle-eval-pizza-3”,其中包含了關(guān)于披薩秘密配料的問題和答案:

問題:

制作完美披薩需要哪些秘密配料?

答案:

制作完美披薩的秘密配料包括無花果、帕爾馬火腿和山羊奶酪。在創(chuàng)建了數(shù)據(jù)集之后,我們可以通過設(shè)置一些參數(shù)來運行評估,例如:

- document_depth_percent_min - 第一個“針”插入的位置。其余的“針”將在第一個之后均勻插入

- multi_needle - 執(zhí)行多針評估的標記

- needles - 要插入上下文的“針”的完整列表

- evaluator - 選擇評估工具 LangSmith

- eval_set - 選擇我們創(chuàng)建的評估集“multi-needle-eval-pizza-3”

- context_lengths_num_intervals - 測試的上下文長度數(shù)量

- context_lengths_min(和最大值)- 測試的上下文長度范圍

我們可以使用以下命令來執(zhí)行評估:

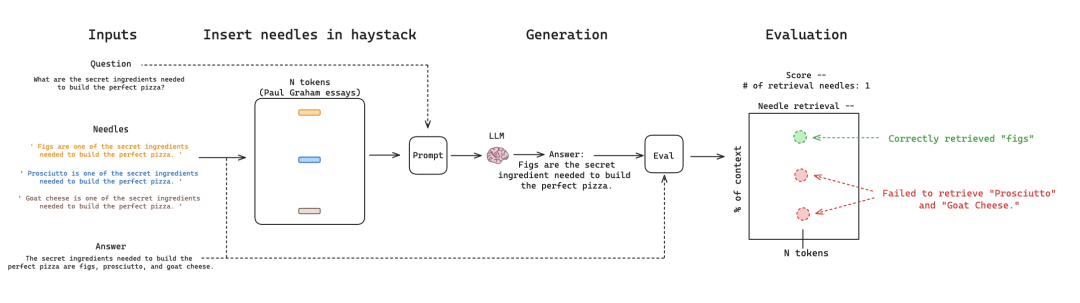

python main.py --evaluator langsmith --context_lengths_num_intervals 6 --document_depth_percent_min 5 --document_depth_percent_intervals 1 --provider openai --model_name "gpt-4-0125-preview" --multi_needle True --eval_set multi-needle-eval-pizza-3 --needles '[ "無花果是制作完美披薩的秘密配料之一。", "帕爾馬火腿是制作完美披薩的秘密配料之一。", "山羊奶酪是制作完美披薩的秘密配料之一。"]' --context_lengths_min 1000 --context_lengths_max 120000這個命令將啟動一個工作流程,其中包括將“針”插入到上下文中,使用帶有這些“針”的上下文提示模型生成回答,并評估模型的生成是否正確地檢索了“針”。

“多針檢索加推理”評估工作流程圖

GPT-4 的檢索結(jié)果

為了測試 GPT-4 的多針檢索能力,我們創(chuàng)建了三個 LangSmith 評估集:

- “multi-needle-eval-pizza-1” - 插入一個“針”。

- “multi-needle-eval-pizza-3” - 插入三個“針”。

- “multi-needle-eval-pizza-10” - 插入十個“針”。

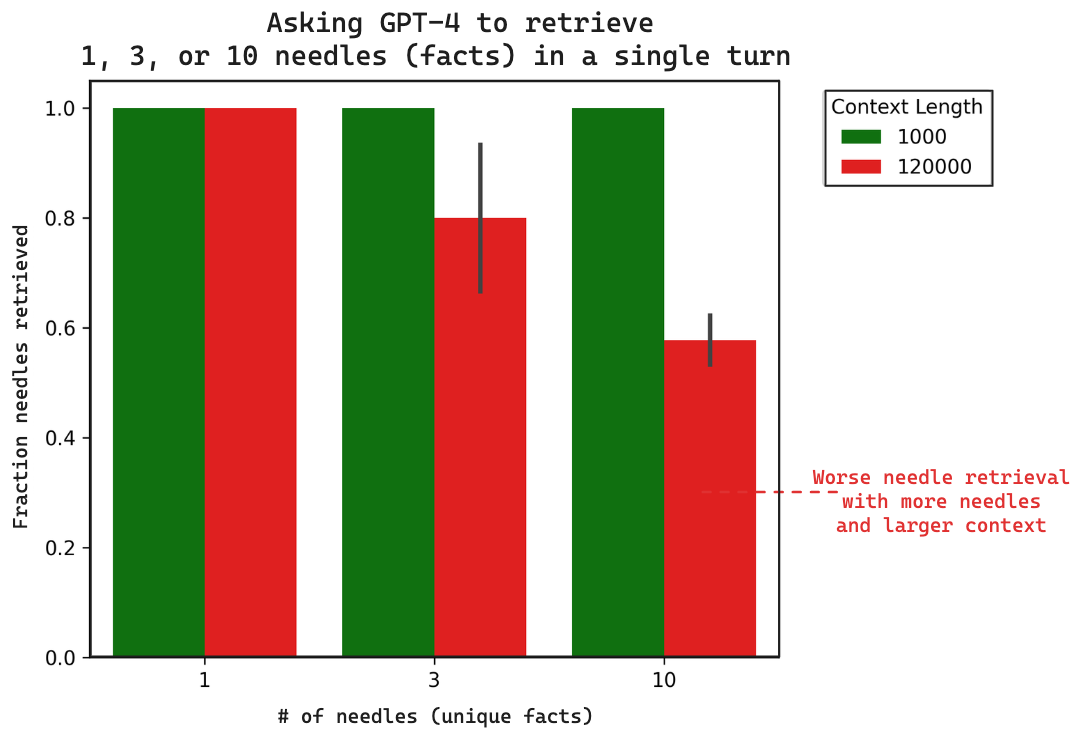

我們評估了 GPT-4(能夠處理 128k 標記長度的上下文)在單個回合中檢索 1、3 或 10 個“針”的能力,上下文長度分別為小(1000 標記)和大(120,000 標記)。所有運行的命令和生成結(jié)果的鏈接都已提供。

https://github.com/gkamradt/LLMTest_NeedleInAHaystack/blob/main/viz/multi-needle-datasets/這里是我們的結(jié)果摘要圖:

我們可以看到:

- 當“針”的數(shù)量從 1 增加到 10 時,模型的性能有所下降。

- 當上下文長度從 1000 增加到 120,000 標記時,性能也會下降。

為了進一步探索和驗證這些結(jié)果,我們可以查看 LangSmith 跟蹤的一個例子,其中我們插入了 10 個“針”。GPT-4 的生成結(jié)果如下:

制作完美披薩所需的秘密配料包括浸泡在濃縮咖啡中的棗、甜藍紋奶酪、糖核桃和梨片。在這次生成中,只有 四個 “秘密配料” 被正確提及。根據(jù)跟蹤結(jié)果,我們確認所有 10 個“針”都存在于上下文中,并記錄了它們被插入的順序:

* 無花果

* 帕爾馬火腿

* 煙熏蘋果木培根

* 檸檬

* 山羊奶酪

* 松露蜂蜜

* 梨片

* 浸泡在濃縮咖啡中的棗

* 甜藍紋奶酪

* 糖核桃我們發(fā)現(xiàn),GPT-4 在生成中只提及了我們上下文中最后四個“針”。這揭示了檢索失敗的一個有趣現(xiàn)象:當上下文變長時,模型更容易忽略位于文檔開頭的“針”。

因為我們記錄了每個“針”的插入位置,我們還可以探究這一點:下面的熱圖顯示了隨著上下文長度的增加,10 個“針”檢索的情況。每一列代表一個實驗,我們要求 GPT-4 在上下文中檢索 10 個“針”。

隨著上下文長度的增加,我們觀察到模型在文檔開頭的檢索失敗。這種趨勢在多“針”情況下(大約 25k 標記)比單“針”情況(對于 GPT-4 是從 73k 標記開始)更早出現(xiàn)。

GPT-4 的檢索與推理

檢索增強生成(RAG)通常涉及從索引的文檔庫中檢索多個事實,然后在這些事實的基礎(chǔ)上進行推理。為了測試這一點,我們構(gòu)建了三個數(shù)據(jù)集,通過詢問所有秘密配料的首字母來測試模型的檢索和推理能力。

- “multi-needle-eval-pizza-reasoning-1” - 只檢索一個“針”。

- “multi-needle-eval-pizza-reasoning-3” - 檢索三個“針”。

- “multi-needle-eval-pizza-reasoning-10” - 檢索十個“針”。

需要注意的是,這里的推理是非常基礎(chǔ)的形式。在未來的基準測試中,我們計劃包含不同復(fù)雜度的推理任務(wù)。

我們比較了僅檢索和檢索加推理兩種情況下的正確答案比例。所有數(shù)據(jù)和跟蹤結(jié)果都已提供。我們發(fā)現(xiàn),無論是檢索還是推理,隨著上下文長度的增加,性能都會下降,而且推理的性能似乎總是落后于單純的檢索。這表明檢索能力可能限制了模型在推理任務(wù)上的表現(xiàn),這是符合我們預(yù)期的。

總結(jié)

長上下文語言模型的發(fā)展為我們帶來了巨大的潛力。為了有效地利用這些模型,無論是獨立使用還是作為外部檢索系統(tǒng)的替代,了解它們的能力和局限性至關(guān)重要。"多針檢索加推理"基準測試為我們提供了一個評估長上下文檢索性能的有用工具,特別是在與傳統(tǒng)的檢索增強生成(RAG)方法相比較時。

通過這些測試,我們可以得到一些初步的見解,但還需要進一步的驗證:

- 檢索并非萬無一失- 并不能保證所有事實都能被檢索到,尤其是當涉及的事實數(shù)量和上下文規(guī)模增加時。

- 檢索失敗的模式各異- 隨著上下文長度的增加,GPT-4 在檢索位于文檔開頭的事實時表現(xiàn)不佳。

- 提問方式至關(guān)重要- 根據(jù)之前的研究發(fā)現(xiàn),為了提高模型的檢索能力,可能需要精心設(shè)計提問方式。

- 檢索與推理的關(guān)系- 當模型需要對檢索到的信息進行推理時,其性能會受到影響。

通過這些發(fā)現(xiàn),我們可以更好地理解并優(yōu)化長上下文模型在信息檢索和推理任務(wù)中的應(yīng)用。