【LLM】大語言模型在用戶興趣探索中的應用

一、結論寫在前面

傳統的推薦系統通過學習和強化過去的用戶-物品交互形成強烈的反饋循環,這反過來限制了新用戶興趣的發現。

為了解決這一問題,論文引入了一種結合大型語言模型(LLMs)和經典推薦模型的混合層次框架,用于用戶興趣探索。該框架通過“興趣集群”控制LLMs和經典推薦模型之間的接口,集群的粒度可以由算法設計者明確確定。該方法結合了LLMs在推理和泛化方面的優勢,以及經典推薦模型的基礎。它首先使用語言表示“興趣集群”,并利用經過微調的LLM生成嚴格屬于這些預定義集群的新興趣描述。在低層次上,它通過限制經典推薦模型(在這種情況下是一個基于Transformer的序列推薦器)返回屬于高層次生成的新集群的物品,將這些生成的興趣具體化為物品級別的策略。

論文在一個服務于數十億用戶的工業級商業平臺上展示了這種方法的有效性。實時實驗表明,新興趣的探索和用戶對平臺的整體享受度都有顯著提升。未來的工作將重點關注考慮長期效應,以進一步改進使用LLMs進行推薦系統的分層規劃。

二、論文的簡單介紹

2.1 論文的背景

推薦系統在幫助用戶導航如今網絡上龐大且不斷增長的內容方面不可或缺。然而,這些系統往往受到強烈的反饋循環的影響,推薦與用戶過去行為相似的物品。經典推薦系統根據用戶的歷史交互推斷其下一個興趣。雖然這對短期參與可能有效,但它限制了用戶發現新興趣,導致內容疲勞。最近的研究強調了用戶興趣探索的重要性,旨在引入超出用戶歷史偏好的多樣化內容。然而,由于興趣空間的廣闊和用戶對先前未見興趣的親和力的高度不確定性,有效地向用戶引入新興趣是具有挑戰性的。

近期在大語言模型(LLMs)和其他基礎模型方面的突破為革新推薦系統提供了機遇。這些模型中預訓練的世界知識有可能通過引入多樣化和偶然的推薦來打破推薦反饋循環,解決用戶興趣探索的挑戰。盡管先前的工作已經展示了通過將推薦問題轉化為自然語言處理任務來使用LLMs進行推薦的潛力,但在現實世界的工業推薦系統中部署這些方法仍然極其挑戰,原因如下:

(1) 與領域特定的推薦模型不同,LLMs缺乏對工業規模在線平臺上大規模且快速演變的物品庫(例如,YouTube每分鐘上傳超過500小時的內容,Spotify每秒上傳一首新曲目[18])的深入了解;

(2) 現成的LLMs不了解用戶的協作信號,無法捕捉領域特定的用戶行為;

(3) 為每個用戶請求服務的LLMs的延遲和成本巨大,無法滿足工業推薦平臺預期的O(100ms)響應時間和生產查詢每秒(QPS)要求。

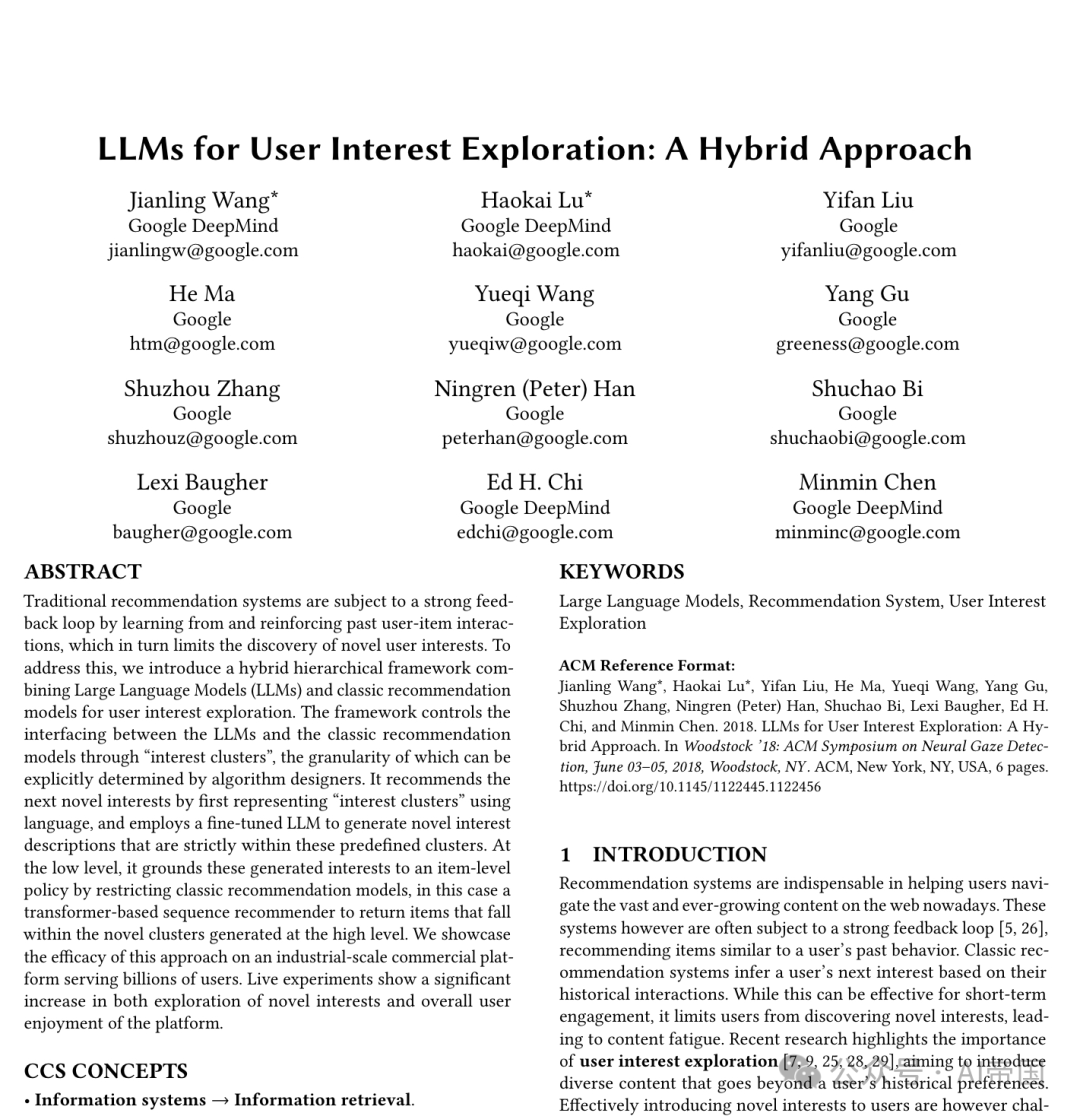

為了克服上述挑戰,論文引入了一種結合LLMs和經典推薦模型的混合層次規劃范式(如圖1所示),用于大規模推薦系統中的用戶興趣探索。

圖1:基于LLM的混合層次規劃圖,用于用戶興趣探索

為了表示動態用戶興趣并將昂貴的LLM推理轉移到離線階段,使其可行地在線提供LLM生成的新的興趣轉換。

2.2 論文的方法

這里論文將介紹混合層次規劃范式以及為實現受控生成和用戶行為對齊而設計的LLM微調過程,以將LLMs應用于現實世界的大規模推薦系統中。

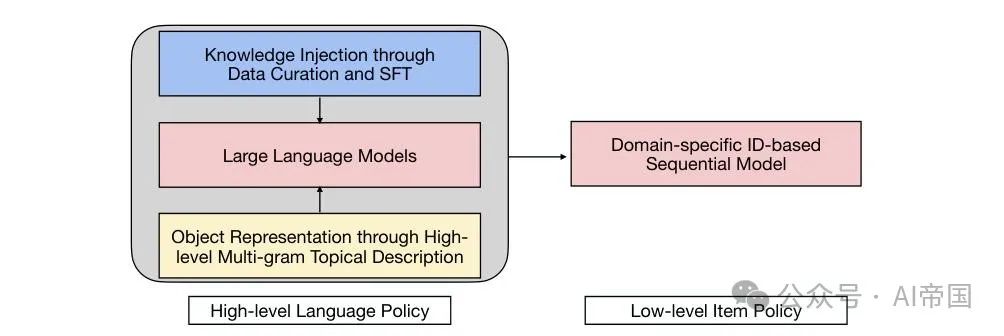

圖2:當K=2時的新興趣預測提示

2.2.1 預備知識

在線平臺上物品數量龐大且新物品不斷涌入,使得在個體物品層面進行LLM規劃變得不可行。因此,論文利用LLM在物品興趣層面的規劃能力來縮小規劃空間。高效層次規劃的前提是一組高質量的物品興趣集群,其中每個集群內的物品在主題上是一致的。遵循與[6]相同的程序,論文根據物品的主題一致性將其分組為N個流量加權的等尺寸集群,這種方法已被證明能很好地擴展到論文問題的規模。

為了創建這些集群,論文首先根據物品的元數據(標題、標簽等)和內容(幀和音頻)將其表示為256維嵌入。然后,論文根據相似性在圖中連接物品并將其聚類為流量平衡的集群。這個聚類過程重復多次以創建一個4級樹結構,每個物品與不同的樹級相關聯。更高級別的集群代表更廣泛的主題,而更低級別的集群代表更具體的主題。

2.2.2 混合層次規劃

混合方法結合了LLM產生語言策略,生成高層級的新興趣,以及經典推薦模型產生物品策略,將這些基于語言的興趣落實到低層級的物品空間。這種混合方法結合了LLM在推理和泛化方面的優勢,以及領域特定的推薦模型在處理物品動態和增強個性化方面的能力。

高級語言策略。鑒于歷史用戶興趣按語言進行表示,論文首先使用大型語言模型(LLM)來學習一個高級語言策略,該策略能夠生成新穎的用戶興趣。論文不再使用物品描述來代表用戶,而是提出采用集群描述(即一組關鍵詞)來代表用戶消費歷史,即用戶的過往興趣被表示為其最近K次交互的獨特集群序列,每個集群由其描述來表示。具體而言,根據用戶先前消費的獨特集群,論文可以要求LLM根據圖2所示的提示生成下一個新穎興趣。

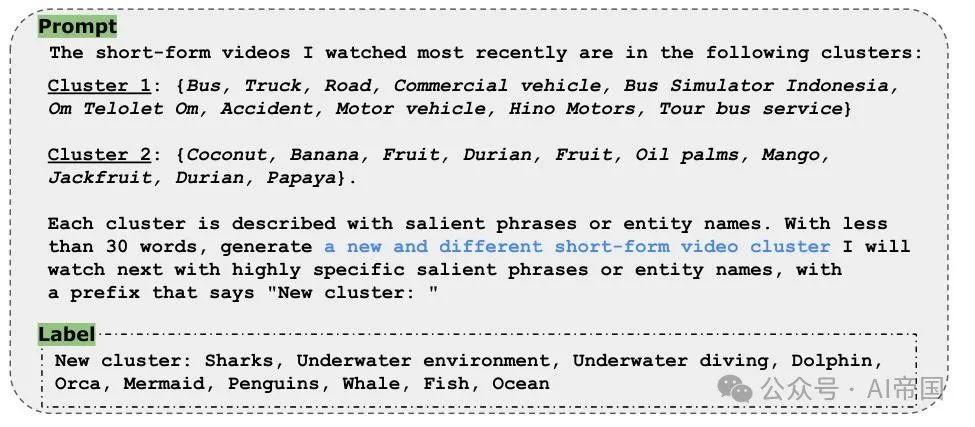

圖3:標簽(即由微調后的LLM生成)分布:X軸表示標簽頻率;Y軸表示每個頻率范圍內標簽的百分比

實際應用意義。將LLM部署到工業規模的推薦系統中的一個主要挑戰在于其高昂的推理成本無法滿足延遲和QPS要求。根據經驗,論文發現依賴少量歷史集群來代表每個用戶可以有效平衡表示粒度和計算效率。在論文的實驗中,二級聚類產生了761個集群。因此,論文可以枚舉所有761 * 761 = 579,121個集群對,并在幾小時內使用LLM進行批量推理,以獲取每個集群對的創新興趣。這些創新興趣連同輸入的集群對可以存儲在一張表中。在線服務期間,當有新用戶請求時,論文首先通過從其觀看歷史中抽樣 個項目來表示用戶,并將它們轉換為集群對以進行查找,以確定推薦的創意興趣集群。

個項目來表示用戶,并將它們轉換為集群對以進行查找,以確定推薦的創意興趣集群。

低級項目策略。一旦獲取了基于語言的新用戶興趣,下一步就是將其轉換為項目級別的推薦策略。一個直接的方法是依賴搜索引擎根據新興趣的關鍵詞檢索最相關的項目。然而,搜索結果往往缺乏個性化,因為這些基于語言的新興趣可能仍然廣泛且缺乏特異性。為了增強個性化,論文建議重用特定領域的推薦模型,特別是基于Transformer的序列推薦模型[8, 27],但將項目限制在由基于語言的新興趣指定的集群中。具體來說,論文遵循以下兩個步驟:(i) 將生成的新興趣映射到集群ID空間,(ii) 在這些集群ID上限制原始項目級別的softmax策略,以僅從這些集群中檢索項目。

受控生成。剩余的挑戰是如何指定LLM生成興趣的粒度,并將生成的新興趣映射到集群ID。LLM的自由格式響應可能是任意的,不太可能直接匹配預定義的集群描述。論文通過層次聚類和選擇集群級別來控制生成的粒度。此外,適當微調使LLM能夠使用興趣集群的語言,生成恰好匹配預定義集群之一的集群描述。

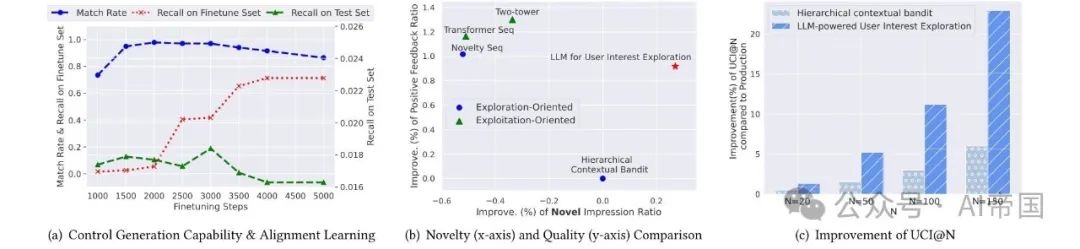

表4 (a) 模型微調過程。(b) 和 (c) 不同推薦系統在實際實驗中的對比。

2.2.3 用戶行為對齊的微調

在大規模公開互聯網數據上訓練的LLMs包含了豐富的全球知識,然而它缺乏以下能力:1) 受控生成(即在興趣集群空間內生成)和2) 特定領域用戶行為對齊。論文建議通過使用商業平臺上真實用戶觀看歷史精心策劃的數據集進行監督微調,注入這些特定領域的知識。因此,用于微調的數據質量對其成功至關重要。

多樣化的數據策劃。以K=2為例,每個微調數據樣本,包含一個集群對以形成提示,以及隨后的新集群作為微調標簽。這些樣本隨后按其標簽分組,并針對每個標簽選擇出現頻率最高的10個集群對,形成最終的多樣化數據樣本,覆蓋所有標簽。通過這些步驟,論文獲得761 * 10 = 7,610個數據樣本(每個標簽集群10個),并使用這些樣本對LLM進行監督微調。

在圖3中,論文展示了經過微調的大型語言模型(LLM)在579,121個上下文集群對上生成的興趣集群分布。當使用多樣性較低的微調數據時,論文從初始的25萬個數據中隨機選取7,610個轉換及其對應的后續集群來構成數據集,微調后的LLM生成的興趣呈現出高度偏斜,少數生成的集群具有非常高的頻率(如圖中區域B所示)。當論文增加微調數據的多樣性時,這些主導標簽消失,生成集群中頻率非常低的數量(如圖中區域A所示)也減少。確保微調數據均勻覆蓋所有集群,使論文能夠解決模型生成集群中的長尾分布問題。這種處理不僅減輕了行為數據中的反饋循環效應,而且提高了整體用戶滿意度。

控制生成能力與用戶行為對齊。微調步驟的數量決定了LLM的全球知識與任務特定知識之間的平衡。論文的微調過程主要有兩個目標:(1) 控制LLM生成,使其語言與興趣集群相符。論文評估微調后LLM生成的匹配率,以確定輸出是否與集群描述完全匹配;(2) 與真實世界用戶轉換對齊,通過比較微調和測試集中微調后LLM的輸出與成功的用戶興趣轉換來計算召回率。較高的召回率表明LLM從微調數據中學習到領域特定的創新轉換,并與用戶行為對齊。

在圖4(a)中,當批量大小為16時,論文展示了匹配率和召回率隨著微調步驟進展而發生的變化。論文注意到,格式化學習,即學習感興趣集群的語言,首先啟動,在約2,000步達到峰值。在高匹配率(超過99%)的情況下,論文能有效地將生成內容映射到集群ID空間,并限制在這些集群上對原始項級softmax策略的應用。隨后,模型開始與用戶行為對齊,導致在微調集上的召回率顯著增加。此外,論文發現,在過渡對齊之后,獨立測試集的召回率也隨之增加,在約3,000步達到峰值后逐漸下降。因此,論文選擇微調了3,000步的模型。需要注意的是,測試集上的召回率遠低于微調集,表明LLM仍然嚴重依賴其全局知識,而不是在生成新興趣時記憶日志中的興趣過渡。

2.3 論文的效果

2.3.1 實驗設置

論文在一個服務于數十億用戶的商業短視頻推薦平臺上進行了一系列現場實驗。論文的實驗使用Gemini-Pro 進行,但同樣的微調過程和流程可以輕松適應其他LLM。論文為LLM推理設定了歷史集群數量K = 2,然而它很容易在未來的迭代中通過稀疏表擴展以適應更大的數量。

基準模型。論文將所提出的方法與現有的生產模型進行比較:(1)探索導向模型包括:一種新穎性增強的序列推薦器[9],該推薦器使用來自正樣本和以前未在用戶消費歷史中出現的聚類中的新穎物品的標簽進行訓練;基于3.1節介紹的分層聚類的分層上下文強盜,通過基于樹的LinUCB探索用戶的興趣以獲取下一個聚類,然后使用序列模型將檢索限制在物品上。盡管這些模型旨在探索用戶興趣,但它們是在系統中存在的興趣轉移上訓練的,因此仍然受到反饋循環的影響。(2)利用導向模型包括常規的雙塔模型[34]和基于Transformer的[8, 27]序列模型,這些模型是根據所有正向用戶反饋進行訓練的。論文的實時實驗結果表明,與這些現有模型相比,所提出的方法能夠帶來更具新穎性和更高品質的推薦。

2.3.2 結果與分析

新穎性與質量。在圖4(b)中,論文將所提出的方法與當前生產中的各種基準模型進行了比較。以分層上下文強盜的性能為參考,論文衡量了其他模型的改進。具體來說,論文繪制了新穎印象比例的增加(僅考慮用戶從未交互過的興趣聚類中的印象)以突出推薦的新穎性(x軸),以及正向反饋率的增加以展示推薦的質量(y軸)。所提出的方法相比所有基準方法推薦了更多新穎的物品(x軸右側)。此外,它在質量上遠超現有的探索導向方法,與利用導向方法相當(x軸上較高)。換句話說,所提出的方法提供了一種有效的方式,向用戶介紹對其有吸引力的新穎興趣。

用戶興趣探索。為衡量推薦系統是否鼓勵用戶探索新興趣,論文采用了一項指標UCI@N,該指標追蹤過去7天內消費過來自N個獨特聚類興趣項的用戶數量。較高的UCI@N意味著更多用戶正在消費N個興趣。通過監測不同N值(20至200)下的UCI@N,論文能評估系統在用戶興趣探索方面的有效性。圖4(c)總結了論文的方法相較于分層上下文 bandits 在用戶興趣探索方面的改進,以評估其效果。值得注意的是,與當前生產中部署的顯著探索模型相比,論文提出的方法在不同N值下展現出了非常顯著的改進。

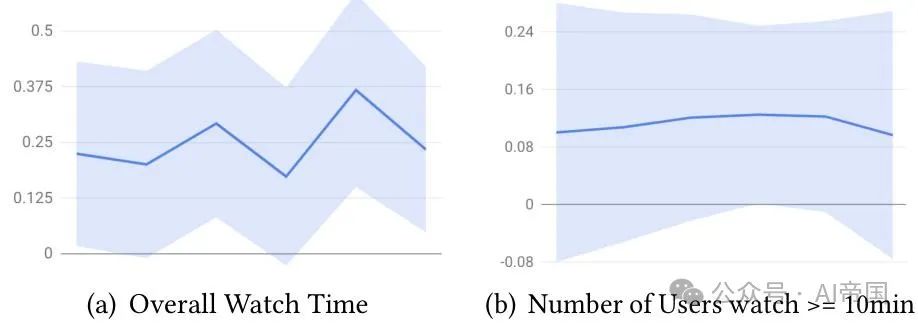

用戶增長。同時,論文監測了總體觀看時間的增長以及活躍用戶數量(總觀看時間≥10分鐘),以衡量短視頻平臺上用戶的增長情況(見圖5)。x軸代表實驗周期(具體日期已隱去),y軸顯示實驗組與對照組之間的相對百分比差異,對照組排除了所提出的系統。論文的方法通過推薦多樣且新穎的內容成功拓寬了用戶興趣,促進了用戶增長。這突顯了推薦的新穎內容的質量和相關性。

圖5:所提出的方法驅動用戶增長

論文標題:LLMs for User Interest Exploration: A Hybrid Approach

論文鏈接:??https://arxiv.org/pdf/2405.16363??

本文轉載自 ??AI帝國??,作者: 無影寺