預測未來模型能力!微調揭示LLM涌現能力的關鍵 原創

預測未來模型能力!微調揭示LLM涌現能力的關鍵 在加州大學伯克利分校的智慧殿堂中,一群天才研究者們正試圖解開現代大型語言模型(LLM)擴展中的一個根本性難題:涌現能力的不可預測性。想象一下,你正在訓練一個語言模型,它的預訓練損失隨著計算量的增加而可預測地下降,就像一個乖巧的學生按部就班地學習。但當涉及到下游任務時,情況就變得復雜了——有時模型會在某個看似隨機的點上突然“開竅”,這種“涌現”現象讓預測未來模型的能力變得異常困難。

在這項研究中,Charlie Snell、Eric Wallace、Dan Klein、Sergey Levine等研究者們提出了一個有趣的任務:給定當前LLM在某個任務上的隨機少樣本準確率,我們能否預測未來的模型(比如GPT-N+1)在這個任務上是否會有顯著的準確率提升?他們發現了一個簡單的洞察:通過在特定任務上微調LLM,可以提前“喚醒”這些模型,使其在更少的計算量下展現出涌現能力。這就像是在考試前給學生一些針對性的練習題,讓他們在考試中表現得更好。

為了驗證這一洞察,研究者們在四個標準的NLP基準測試(MMLU、GSM8K、CommonsenseQA和CoLA)上進行了實驗,這些測試中大型開源LLM已經展示了涌現能力。他們發現,通過微調小規模的LLM,有時可以準確預測那些使用多達4倍計算量訓練的模型是否會出現涌現現象。這就像是在小規模實驗中發現了一種神奇的“涌現法則”,然后用它來預測更大規模的實驗結果。

研究者們還展示了兩個實際應用案例:一是利用涌現預測來廉價評估預訓練數據的質量,二是預測未來前沿模型的更復雜能力。這就像是用一種新的“涌現法則”來預測未來的科技發展,幫助科學家們更好地規劃和準備。

這項研究不僅展示了微調在預測涌現能力中的重要作用,還為未來的研究指明了方向。雖然目前的“涌現法則”還不能像預測天氣那樣精確,但它已經為我們打開了一扇通往未知世界的大門,讓我們對未來充滿期待。 在現代大型語言模型(LLM)的擴展中,一個根本性的開放挑戰是對涌現能力的理解不足。特別是,語言模型的預訓練損失作為計算的函數是高度可預測的,但下游能力卻遠不可預測,有時甚至會出現突變,這使得預測未來模型的能力變得困難。本文提出了一種通過微調來預測未來模型(如GPT-N+1)在特定任務上是否會有顯著準確率的方法。

主要方法

- 微調與涌現能力的關系:

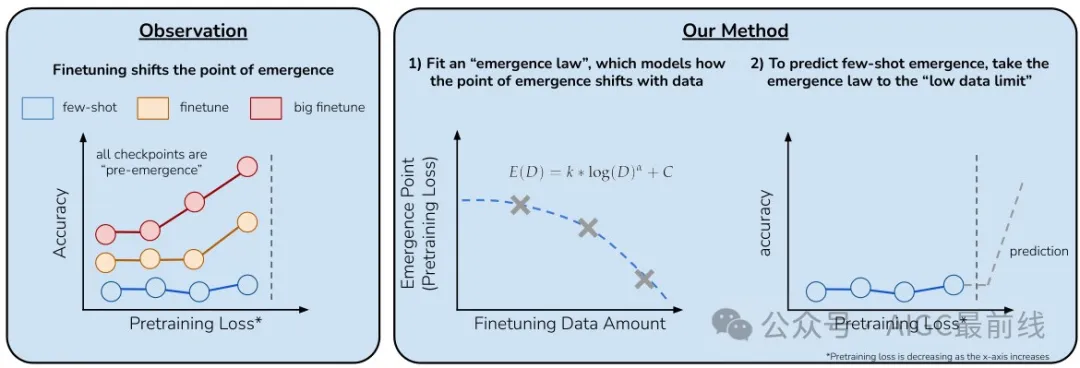

- 研究發現,對LLM進行特定任務的微調可以系統地將涌現能力出現的點向能力較弱的模型轉移。通過微調,模型在較少的數據量下就能展現出顯著的性能提升,從而提前預測未來模型在特定任務上的表現。

圖:微調對涌現能力的影響

- 涌現定律的建立:

- 通過微調不同數據量的LLM,研究人員建立了一個參數化函數(即“涌現定律”),該函數預測了涌現能力出現的點。這個定律可以用來外推預測在少樣本設置中涌現能力出現的點。

圖:通過微調預測涌現能力

實驗過程及結果

實驗設置

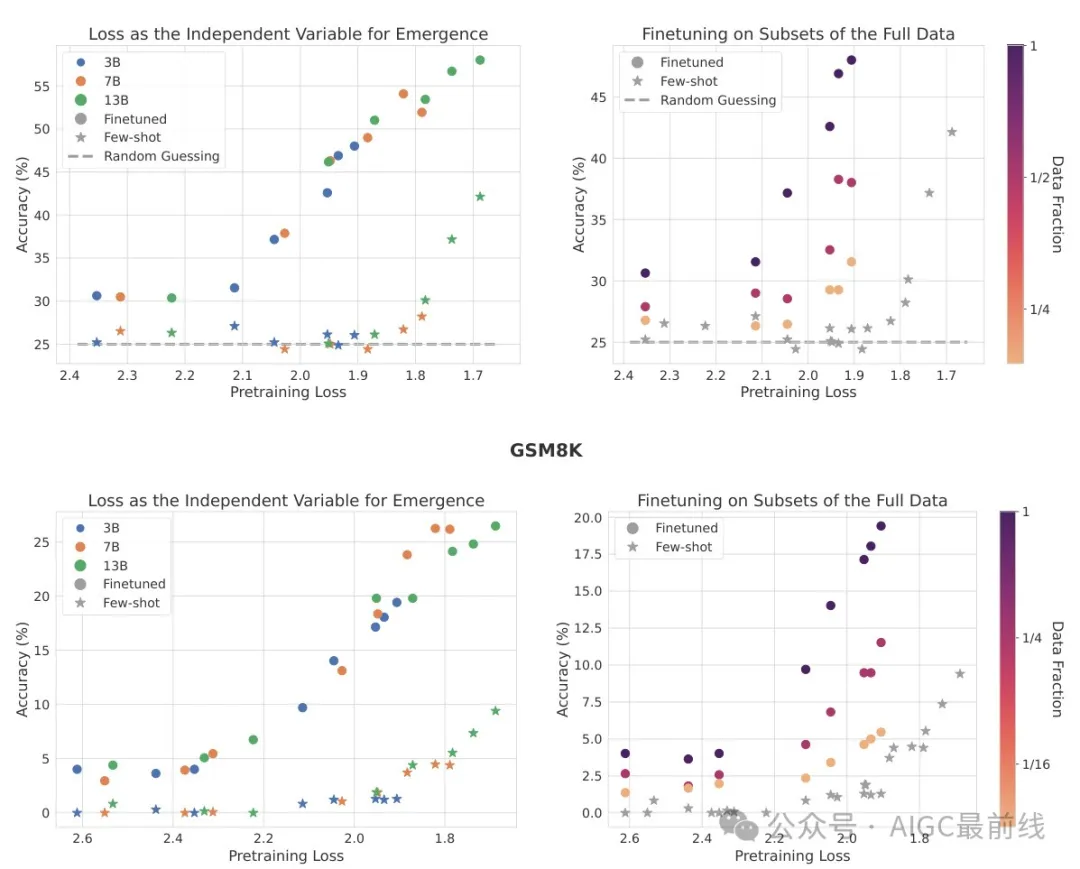

研究在四個標準NLP基準測試上進行了實驗:MMLU、GSM8K、CommonsenseQA和CoLA。這些基準測試已經被大規模開源LLM證明存在涌現現象。實驗使用了不同規模的模型(3B、7B和13B)的中間檢查點,并在這些模型上進行了微調。

實驗發現

- 微調對涌現點的影響:

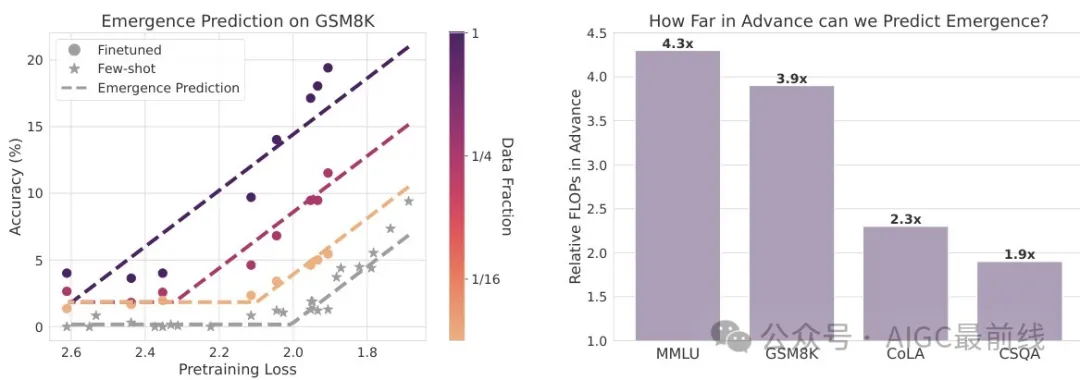

- 通過微調,模型在MMLU和GSM8K任務上的涌現點顯著提前。

- 微調數據量的增加會進一步提前涌現點。

- 這些發現表明,微調可以系統性地將涌現點向能力較弱的模型轉移。

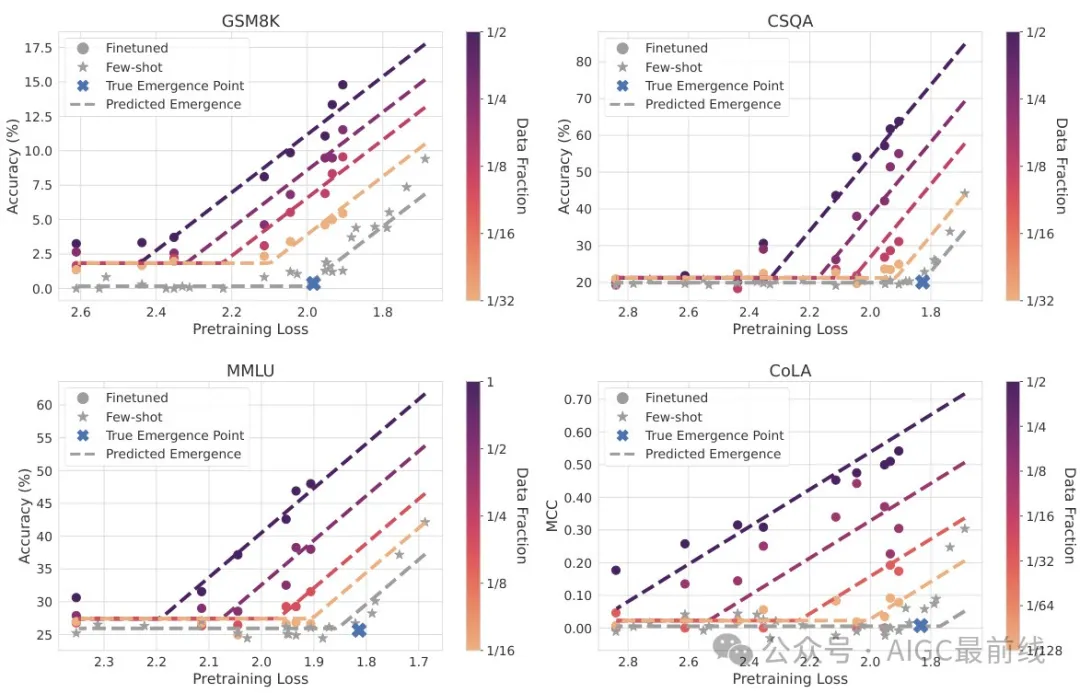

- 涌現預測模型:

- 研究開發了一個“涌現定律”,該模型描述了微調數據量與涌現點之間的關系。

- 通過擬合這個模型,可以預測在少樣本設置下的涌現點。

- 驗證與評估:

- 在MMLU和GSM8K任務上,使用小規模LLM進行擬合,成功預測了更大規模模型的涌現點。

- 在某些情況下,預測的準確性非常高,誤差在0.1 nats以內。

- 實際應用案例:

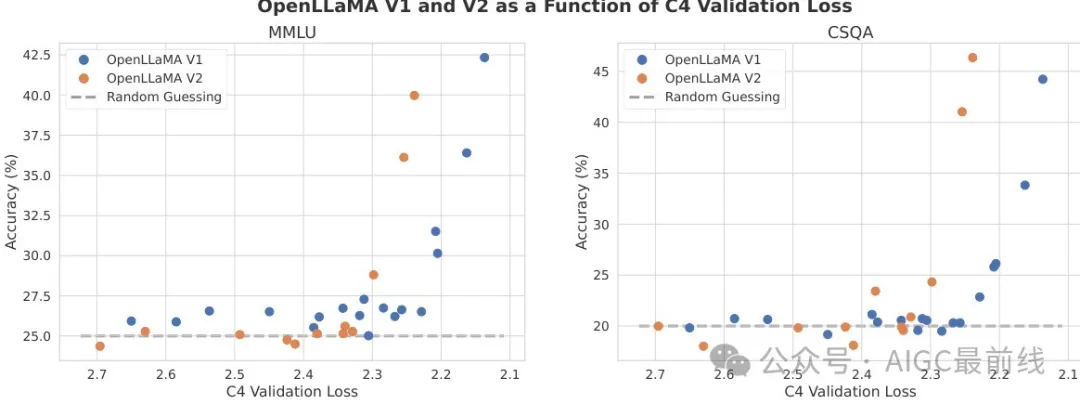

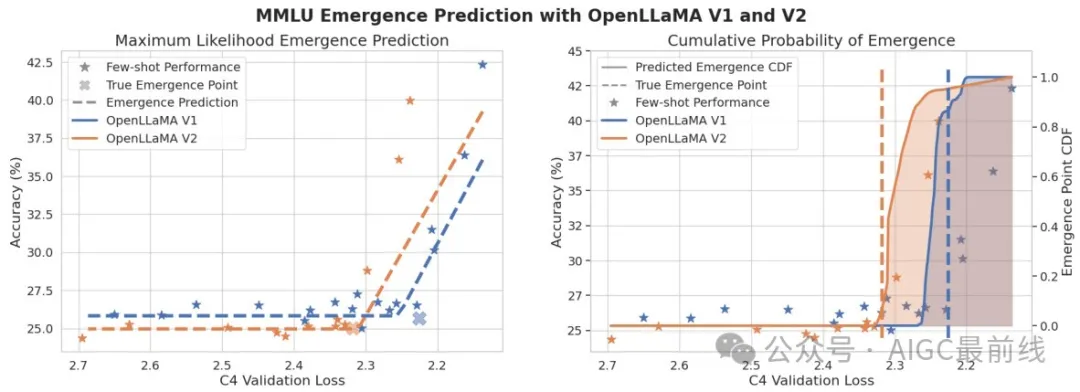

- 評估預訓練數據質量:通過比較OpenLLaMA V1和V2模型在MMLU任務上的涌現點,發現V2模型涌現更早,表明V2的預訓練數據質量更高。

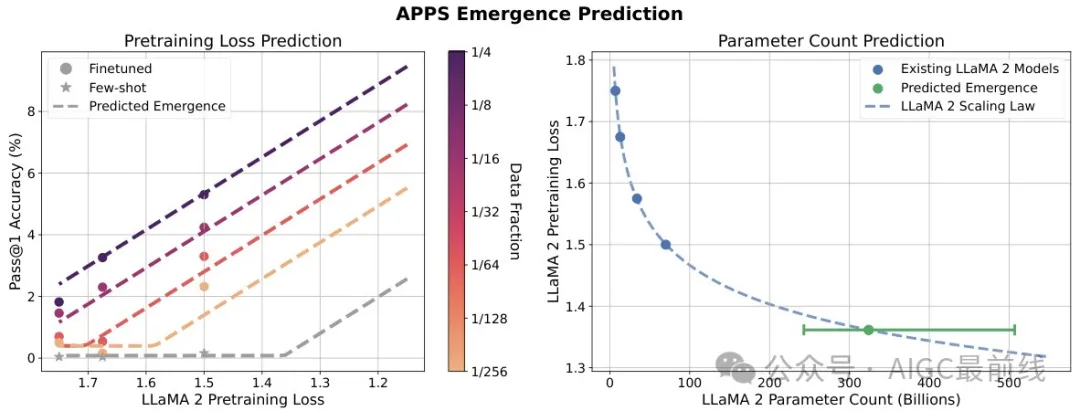

- 預測未來LLM的能力:在更具挑戰性的APPS編碼基準測試上,使用LLaMA 2模型進行微調,預測了未來模型在代碼生成任務上的涌現點。

實驗結果圖示

- 左圖展示了微調后和少樣本設置下模型的性能;右圖展示了不同微調數據量對涌現點的影響。

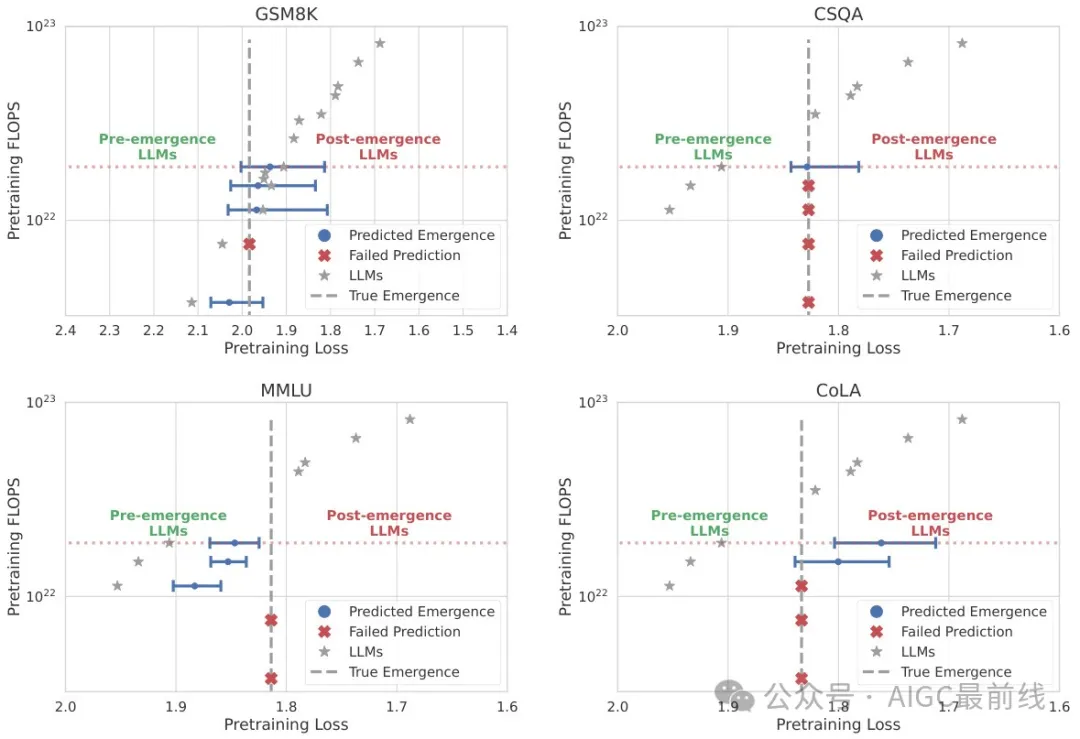

- 展示了在各任務上的最大似然涌現預測。

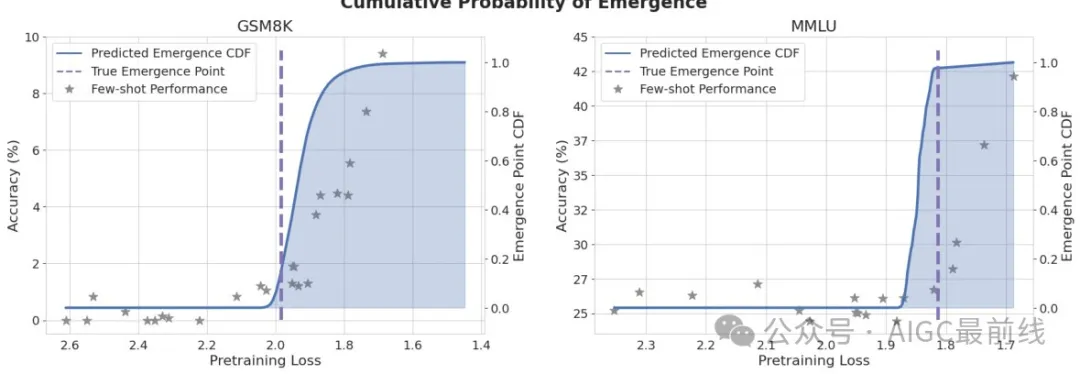

- 展示了GSM8K和MMLU任務上涌現后驗的累積分布函數(CDF)。

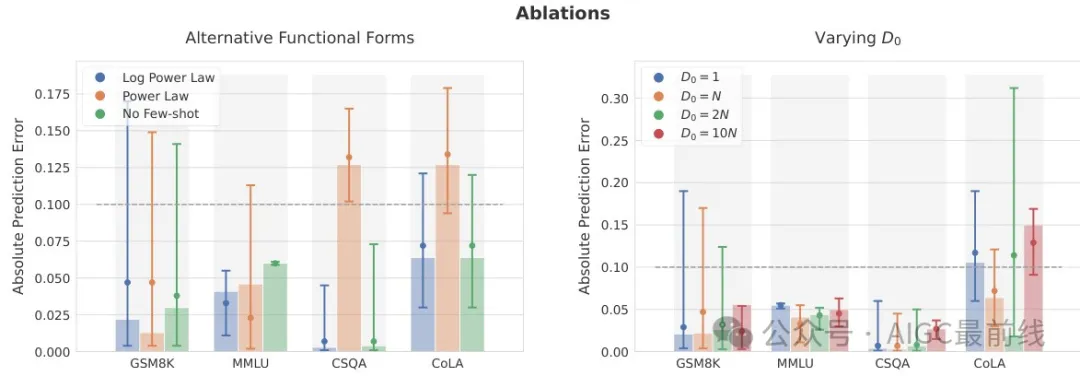

- 展示了不同設計決策對涌現預測準確性的影響。

- 展示了在不同任務上提前預測涌現的能力。

- 比較了OpenLLaMA V1和V2模型在MMLU和CommonsenseQA任務上的涌現點。

- 展示了在MMLU任務上對OpenLLaMA V1和V2模型涌現點的預測。

- 展示了在APPS任務上使用LLaMA 2模型預測涌現點。

結論

研究通過微調LLM,成功預測了未來模型在多個任務上的涌現能力。實驗結果表明,微調可以顯著提前涌現點,并且通過擬合“涌現定律”,可以在少樣本設置下進行準確的預測。此外,研究還展示了如何利用這一方法評估預訓練數據質量和預測未來LLM的復雜能力。 在現代大型語言模型(LLMs)的發展中,預測其涌現能力(emergent capabilities)是一個關鍵且未解的挑戰。本文由加州大學伯克利分校的研究團隊提出了一種新穎的方法,通過微調(finetuning)來預測未來模型在特定任務上的涌現能力。研究的核心發現是,通過在特定任務上微調當前的LLMs,可以顯著提前預測未來模型(如GPT-N+1)在該任務上的非平凡準確性。這一發現不僅為模型開發者提供了寶貴的指導,也為政策制定者和商業決策者提供了關于未來LLMs能力的可靠預測。

研究團隊通過在四個標準NLP基準測試(MMLU, GSM8K, CommonsenseQA, 和 CoLA)上的實驗驗證了這一方法的有效性。他們發現,即使在只有小規模LLMs的情況下,也能準確預測訓練計算量增加四倍的未來模型是否會出現涌現能力。此外,研究還展示了兩個實際應用案例:一是通過預測涌現能力來廉價評估預訓練數據的質量;二是預測更復雜任務的能力,這些任務可能僅在未來前沿模型中出現。

展望未來,盡管本文提出的方法在預測涌現能力方面取得了顯著進展,但仍有許多未解之謎和挑戰。例如,微調為何會導致涌現能力的提前出現,這一機制尚不完全清楚。此外,不同架構和訓練方法的LLMs是否會在相同預訓練損失下表現出相同的下游能力,也是一個需要進一步研究的問題。未來的研究可以探索更有效的數據選擇方法,深入理解微調與涌現能力之間的機制,以及評估在更廣泛應用場景中該方法的適用性。

總之,本文為理解和預測大型語言模型的涌現能力開辟了新的道路,為未來的研究和應用提供了豐富的啟示。鼓勵讀者常來公眾號學習,與我們一同探索AI技術的無限可能。

本文轉載自公眾號AIGC最前線 作者: 不是小馬哥啊