單圖創造虛擬世界只需10秒!斯坦福&MIT聯合發布WonderWorld:高質量交互生成 精華

文章鏈接:https://arxiv.org/pdf/2406.09394

項目地址: https://WonderWorld-2024.github.io/

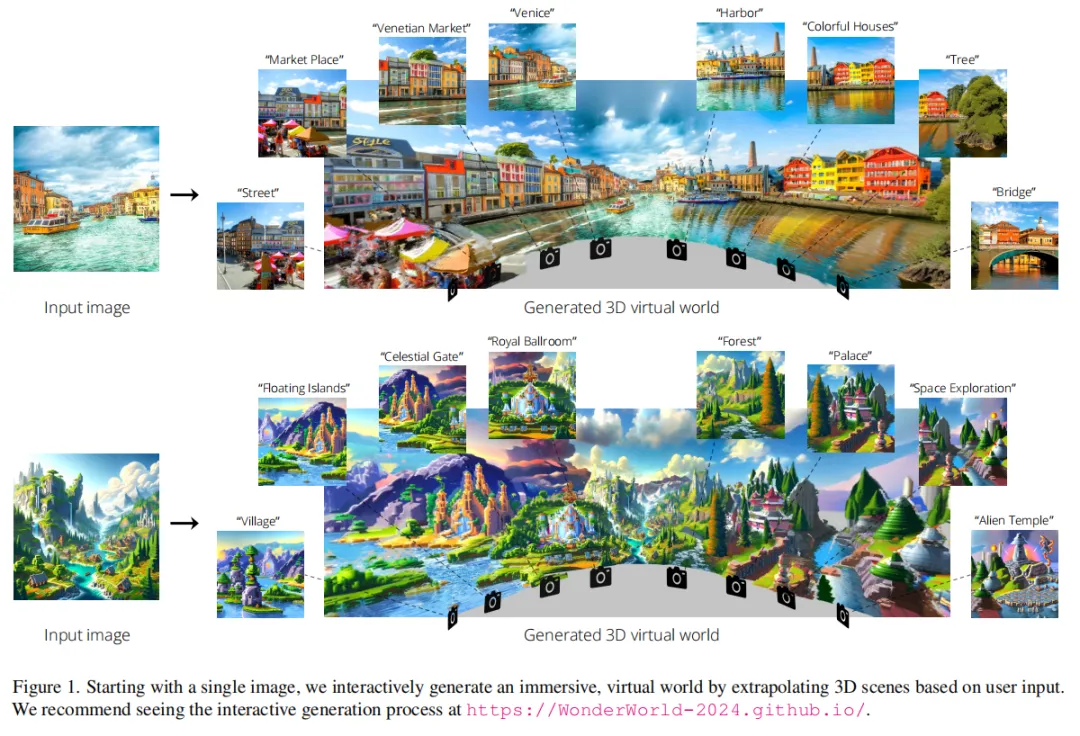

今天推薦一種新穎的框架—— WonderWorld,它可以進行交互式三維場景外推,使用戶能夠基于單張輸入圖像和用戶指定的文本探索和塑造虛擬環境。盡管現有方法在場景生成的視覺質量上有了顯著改進,但這些方法通常是離線運行的,生成一個場景需要幾十分鐘到幾個小時。通過利用快速高斯曲面(Fast Gaussian Surfels)和基于引導擴散的深度估計方法,WonderWorld 在顯著減少計算時間的同時,生成了幾何一致的外推場景。本文的框架在單個 A6000 GPU 上生成相關且多樣的三維場景用時不到10秒,實現了實時用戶交互和探索。展示了 WonderWorld 在虛擬現實、游戲和創意設計中的潛力,用戶可以從單張圖像快速生成和導航身臨其境的、可能無限的虛擬世界。本文的方法代表了交互式三維場景生成的重大進展,為用戶驅動的內容創建和虛擬環境中的探索開辟了新的可能性。

介紹

在過去的一年中,3D場景生成變得非常熱門,許多研究成功地探索了強大的生成圖像先驗和單目深度估計的改進。這些工作大大提高了生成場景的視覺質量、可能的視角和多樣性。然而,所有這些工作都是離線完成的,用戶提供單個起始圖像或文本提示后,系統在幾十分鐘到幾小時后返回一個固定的3D場景或特定攝像路徑的視頻。雖然離線生成可能適用于小型、離散的場景或視頻,但這種設置對于許多場景生成的使用場景來說是有問題的。例如,在游戲開發中,世界設計師希望逐步構建3D世界,能夠控制生成過程,并能夠低延遲地查看中間步驟。在虛擬現實和視頻游戲中,用戶期望可擴展、多樣化的內容,這些內容比當前生成的場景更大、更豐富。在未來,用戶可能會希望更多:一個系統允許他們自由探索和塑造動態演變的、無限的虛擬世界。所有這些都促使了交互式3D場景生成的問題,在這種情況下,用戶可以低延遲地控制場景外推的內容(例如,通過文本提示),并且可以控制場景外推的位置(例如,通過相機控制)。

為了理解阻礙交互性的技術問題,本文檢查了幾種最先進的3D場景生成方法,并確定了兩個主要限制。首先,場景生成速度太慢,無法實現交互性。每個生成的場景需要幾十分鐘進行多次生成圖像修補和深度估計。其次,生成的場景在場景邊界處存在強烈的幾何失真,阻礙了從生成場景進行外推。

本文提出了一個名為WonderWorld的框架,用于交互式場景生成。輸入是一張單一的圖像,輸出是一組相互連接但多樣化的3D場景。為了解決速度問題,本文的核心技術涉及快速高斯表面(Fast Gaussian Surfels),其優化由于采用了原理性、基于幾何的初始化而需要不到1秒的時間,以及分層場景生成,其中每個場景都解析可能發生遮擋的區域,然后預先生成內容以填充這些特殊區域。為了解決幾何失真問題,本文引入了一種引導擴散的深度估計方法,確保外推場景和現有場景之間的幾何對齊。

使用本文的框架,外推或生成一個場景在單個A6000 GPU上花費不到10秒的時間。這一突破解鎖了交互式場景生成的潛力,使用戶能夠將單一圖像外推成一個廣闊而身臨其境的虛擬世界。本文的方法為虛擬現實、游戲和創意設計中的應用開啟了新的可能性,用戶可以快速生成和探索多樣化的3D場景。

實現

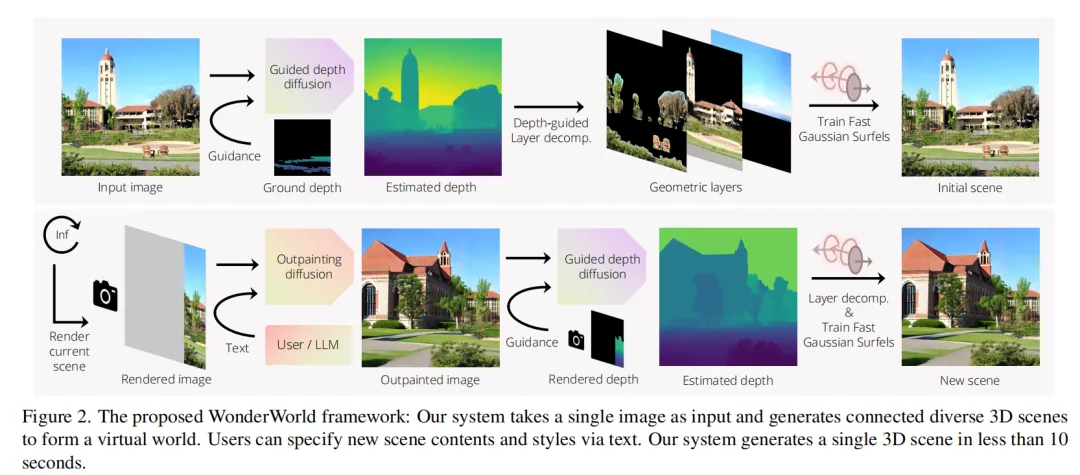

本文的目標是生成一組多樣但連貫連接的3D場景,形成一個潛在的無限虛擬世界。為此提出了WonderWorld,這是一個允許快速場景外推和實時渲染的框架,并提供了交互式視覺體驗。概覽下圖2展示了本文的WonderWorld框架的示意圖。其主要思想是從輸入圖像生成3D場景,并通過外推現有場景逐步擴展。用戶可以提供文本來指定要生成的場景內容,也可以將其留給大型語言模型(LLM)處理。

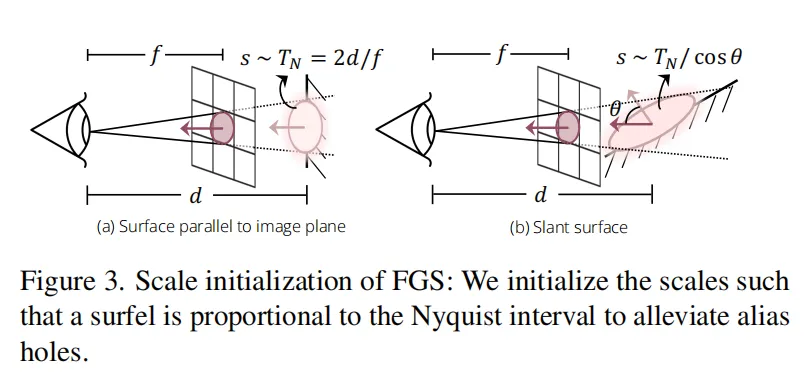

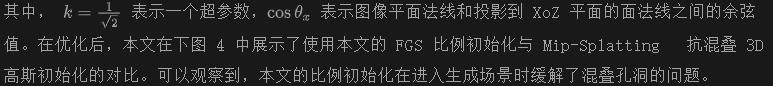

主要的技術挑戰包括場景生成速度和外推場景中的幾何失真問題。為了加快場景生成速度,本文采用了傳統的surfels思想,將其擴展為3DGS,并展示這種擴展允許基于幾何的原則初始化,顯著降低了優化時間至小于1秒。針對生成場景中的透視洞(disocclusion holes),本文引入了逐層場景生成策略,不再依賴多視角圖像生成。因此,WonderWorld能夠在單個GPU上實現快速場景生成(不超過10秒)和實時渲染。為了解決幾何失真問題,本文提出利用引導式深度擴散來生成新場景的幾何形狀。引導式深度擴散具有魯棒性和靈活性,可以指定各種幾何約束。

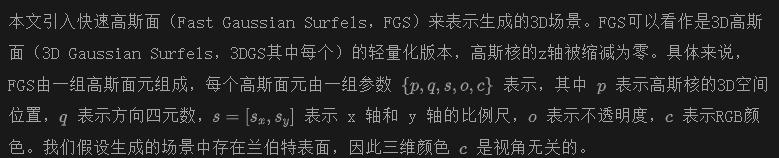

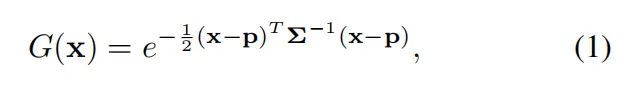

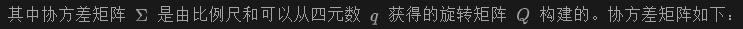

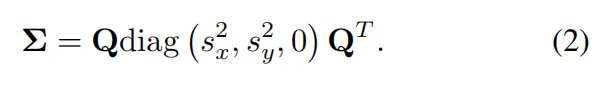

快速高斯面

渲染化和阿爾法混合渲染過程與 3D 高斯分割(3DGS) 相同。

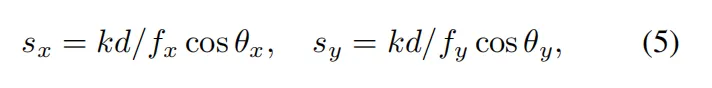

基于幾何的初始化 本文的快速優化核心思想是,因為從單視圖圖像生成快速高斯表面,因此可以假設圖像中的每個像素揭示了底層 3D 場景中的一個表面。因此,可以利用對應像素的信息來直接求解或近似表面的參數,而不是隨機初始化和優化。這樣,優化過程得以簡化、加速并適當正則化。

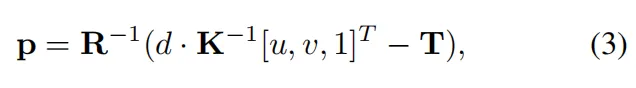

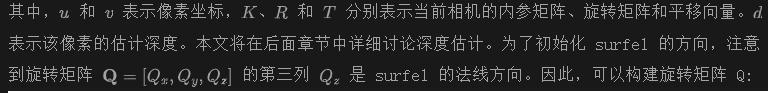

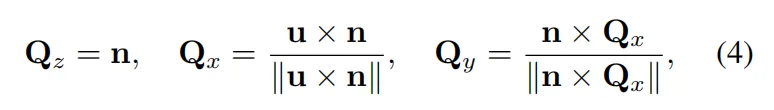

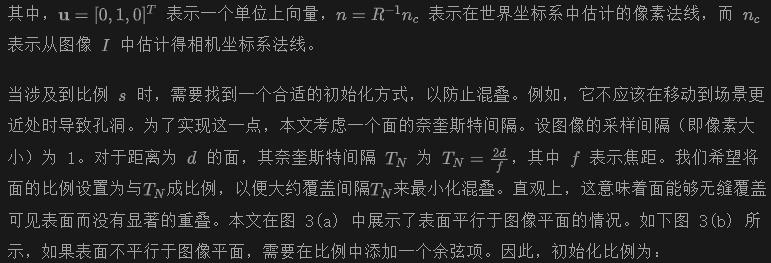

具體來說,給定一個HxW像素的輸入圖像I,目標是生成HxW個表面來表示底層 3D 場景。表面的顏色c初始化為像素的 RGB 值。表面的位置p可以通過反投影估計:

分層場景生成

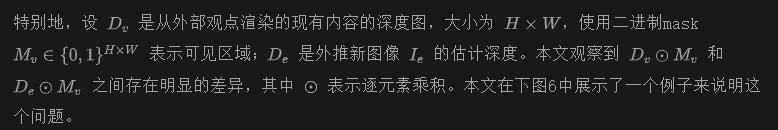

為了填補生成場景中的遮擋空洞,本文引入了一種分層場景生成策略。其主要思想是解析場景的幾何層結構,發現可能出現顯著遮擋的區域,通過去除遮擋內容來顯露這些區域,并生成內容以填補這些區域。本文稱這一過程為深度引導的層分解。上圖2頂部展示了一個示例。

給定層分割后,本文首先通過擴散模型對天空層進行修復,并使用修復后的天空圖像來訓練相應的FGS。然后,對背景層進行修復,并在固定的天空FGS之上訓練背景FGS。最后,本文在固定的背景FGS和天空FGS之上訓練前景FGS。

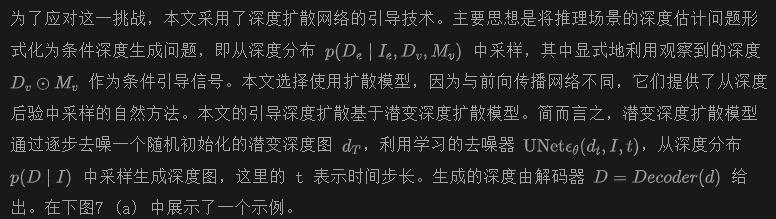

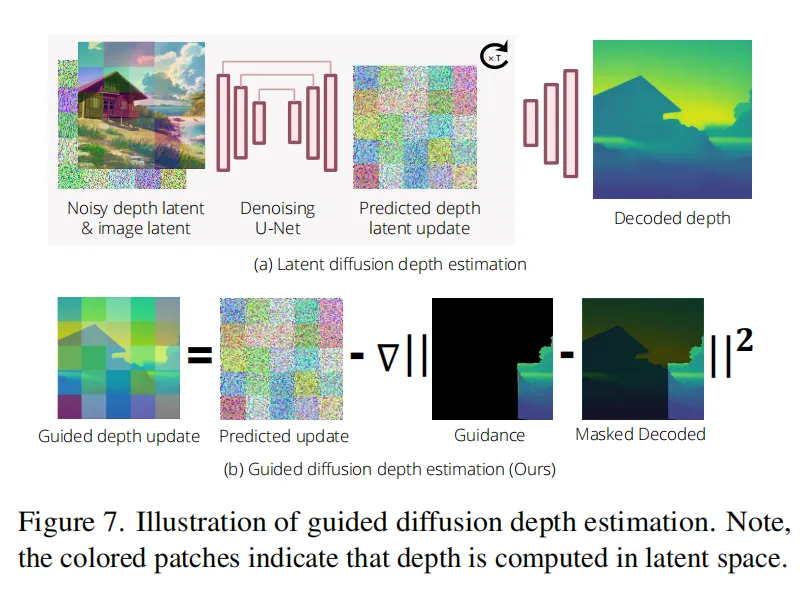

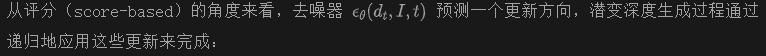

引導深度擴散

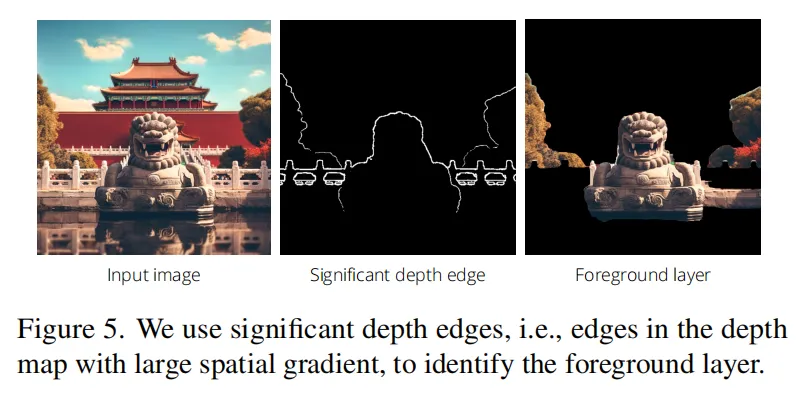

為了生成一個無限的世界,本文需要將現有的場景推廣到未探索的空間。一個基本的挑戰是在推廣過程中的幾何扭曲,即新生成的場景內容可能與現有場景內容存在顯著的幾何差距,因此在從除了外部觀點以外的視角看時會顯得不連貫。這是由于估計的深度與現有幾何之間的不一致造成的。

特別地,設 是從外部觀點渲染的現有內容的深度圖,大小為 ,使用二進制mask 表示可見區域; 是外推新圖像 的估計深度。本文觀察到 和 之間存在明顯的差異,其中 表示逐元素乘積。本文在下圖6中展示了一個例子來說明這個問題。

簡單的后處理啟發式方法,例如通過計算全局平移和縮放來對齊,或者微調深度估計器以匹配估計的深度與現有幾何體,都不足以解決問題,因為它們無法減少在估計新場景深度時存在的固有歧義。

本文通過修改去噪器來注入可見深度作為引導信息,具體做法是

解決地面平面失真問題 本文注意到引入的導向深度擴散公式非常靈活,可以允許指定不同的深度約束。例如,另一個重要的幾何失真是地面平面通常是彎曲的。因此,對于所有生成的場景,本文通過以下方式添加地面平面的深度指導:在公式中,將mask 替換為從語義分割中獲得的地面mask ,并用從分析計算出的平坦地面深度 替換可見內容的深度 。

結果

在本節中,本文展示了WonderWorld的結果。由于不知道任何允許交互式場景生成的基準方法,因此本文專注于展示生成大規模3D場景的質量。為此,本文考慮了開源基準方法,并使用它們的官方代碼。本文展示了交互式場景生成的示例視頻,并強烈建議讀者先觀看視頻。

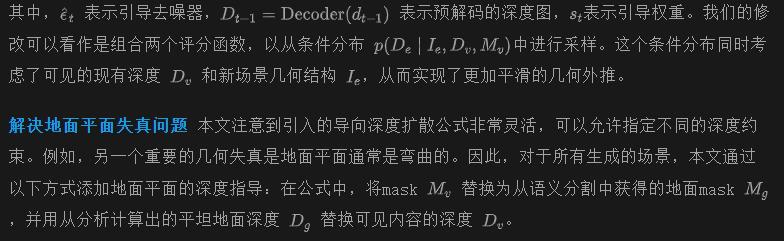

本文的基準方法包括WonderJourney,這是一種最新的永久視角生成方法,以及LucidDreamer,一種最近的3D場景生成方法。WonderJourney接受單張圖像作為輸入,并通過繪制圖像和反投影像素來生成一系列點云。LucidDreamer接受單張圖像作為輸入,并從中合成多視角圖像來訓練3DGS。本文在示例中使用了公開可用的真實和合成圖像。

實現細節

在本文的實現中,使用了Stable Diffusion修復模型作為本文的出畫模型。并且還將它用于修復背景和天空層。本文使用 OneFormer 對天空、地面和前景對象進行分割。在初始場景中,本文使用 SyncDiffusion 離線生成整個天空。本文使用 Marigold 法作為深度擴散模型,并估計法線使用 Marigold 法。在本文的引導深度擴散中,設置了引導權重St,使得引導信號的范數與預測更新的范數成比例。本文使用 Euler 調度器進行深度擴散,共進行 30 步,其中在最后 8 步應用本文的引導。本文使用高效的 SAM 對估計的深度進行后處理,類似于 WonderJourney 。本文還遵循 WonderJourney 的做法,當用戶未提供文本時,使用 GPT-4 生成提示,并根據場景名稱添加可能的對象和背景文本來豐富提示。

定性結果

本文在下圖10中使用相同的輸入圖像展示了WonderWorld和基線方法的定性比較結果。請注意,本文的WonderWorld結果包括9個場景,而LucidDreamer方法的結果只有一個場景。WonderJourney方法僅支持在兩個連續場景之間提取3D點;本文在此擴展了代碼,以支持生成多達4個場景的點。

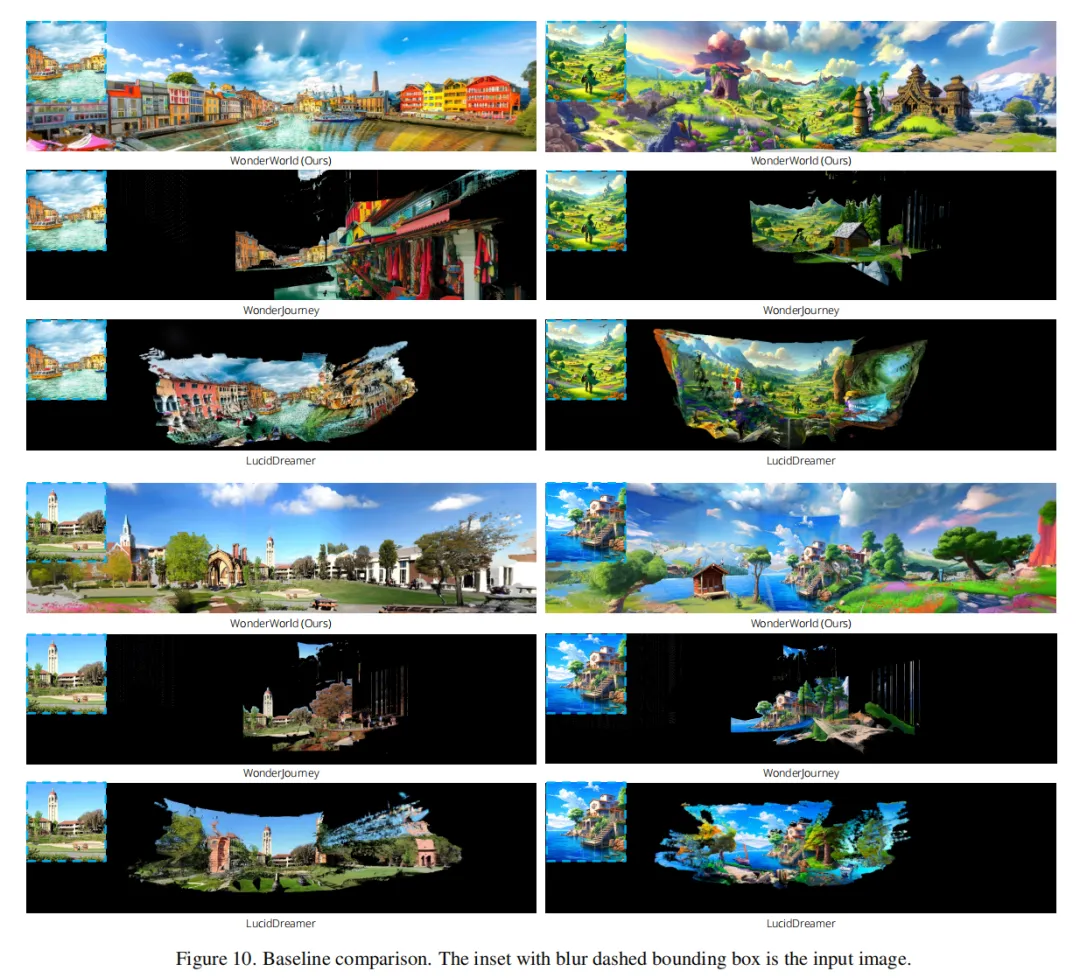

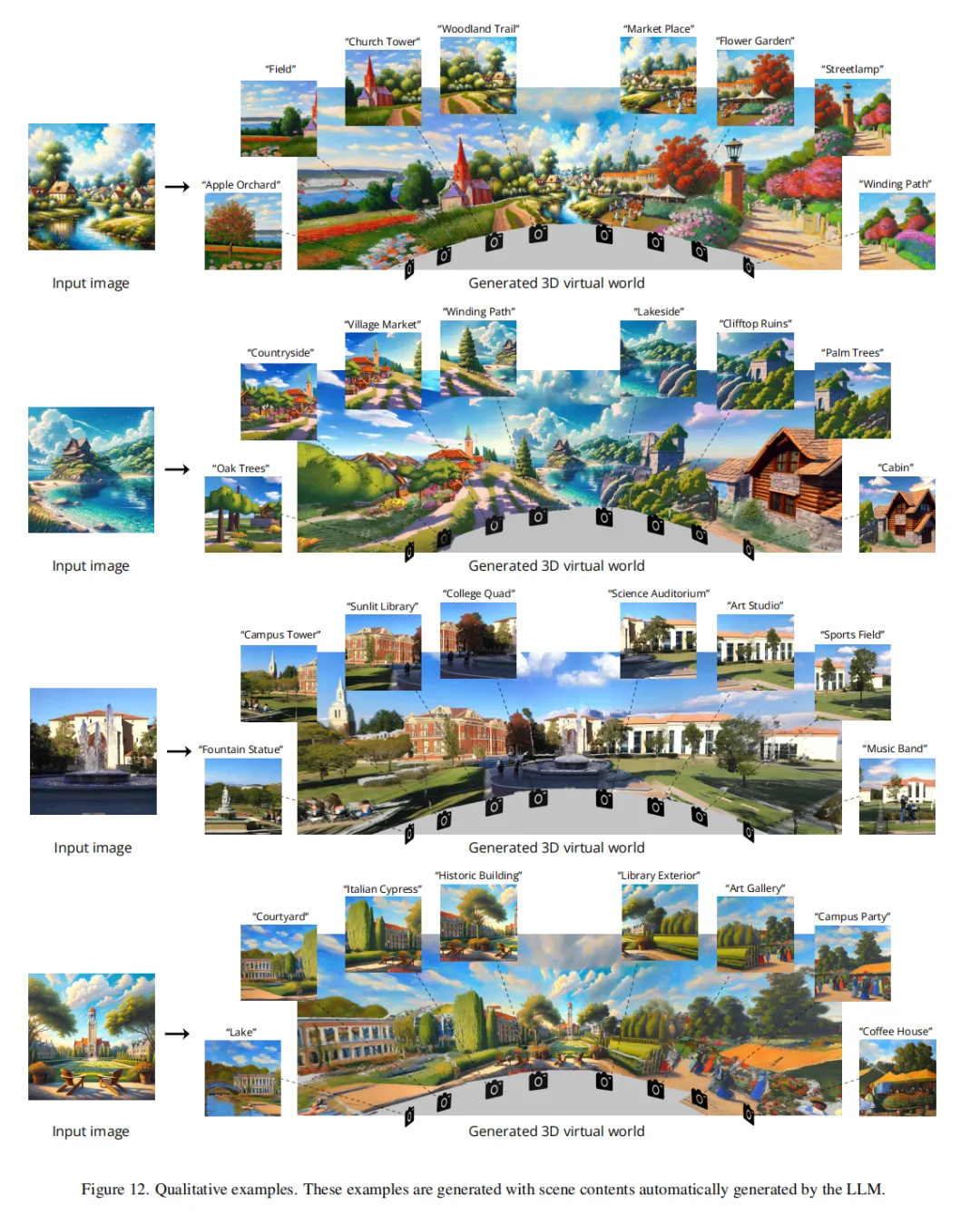

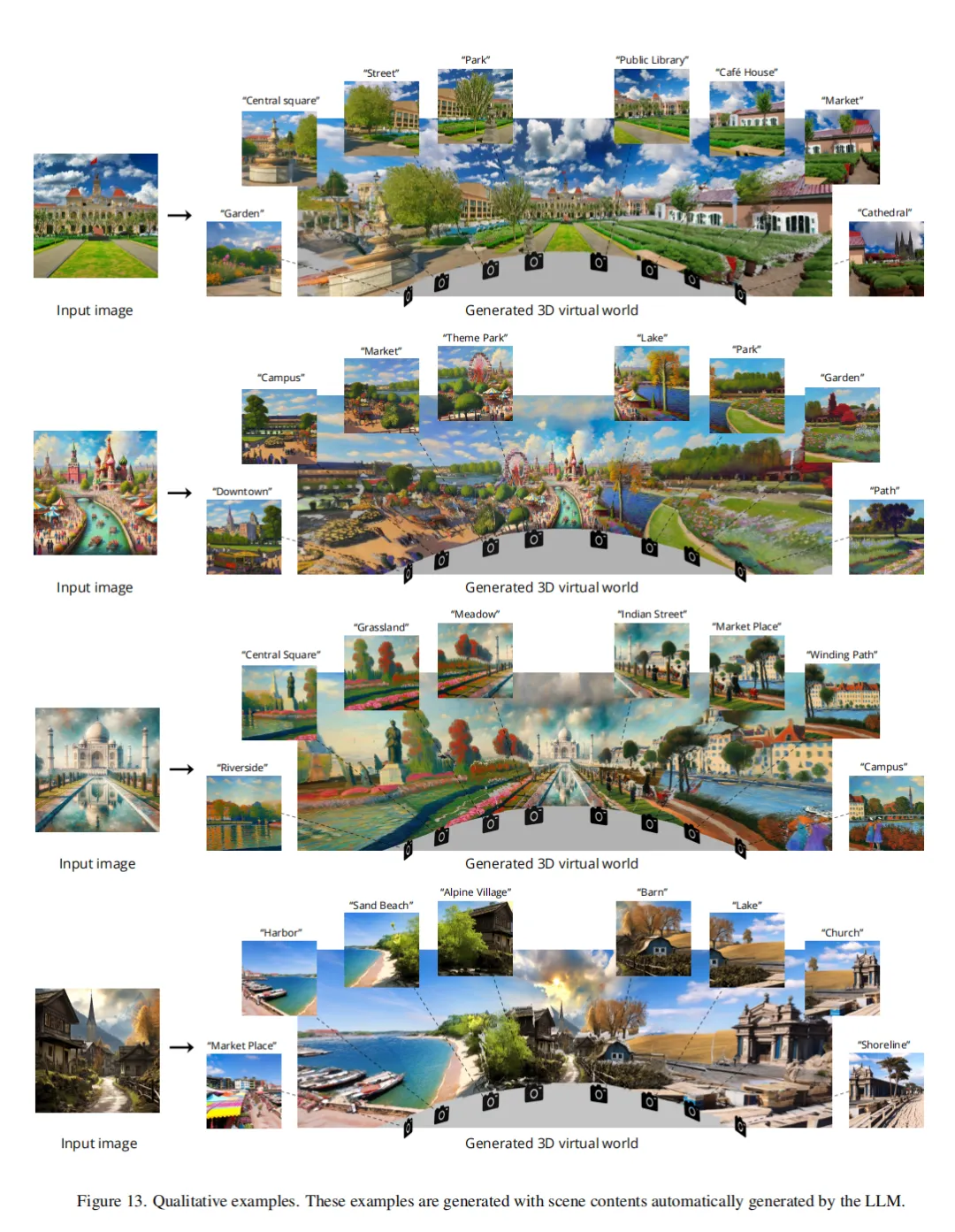

從上圖10中可以看到,像LucidDreamer 這樣的單一3D場景生成方法不會超出預定義的場景范圍,并且在生成場景邊界處存在嚴重的幾何失真。雖然WonderJourney 允許生成多個場景,在特定視角下這些場景看起來是連貫的,但在不同的攝像機角度渲染時,幾何失真問題顯著。與基線方法相比,本文的WonderWorld顯著減輕了幾何失真問題,生成了連貫的大規模3D場景。本文在下圖8、下圖12和下圖13中展示了更多示例。

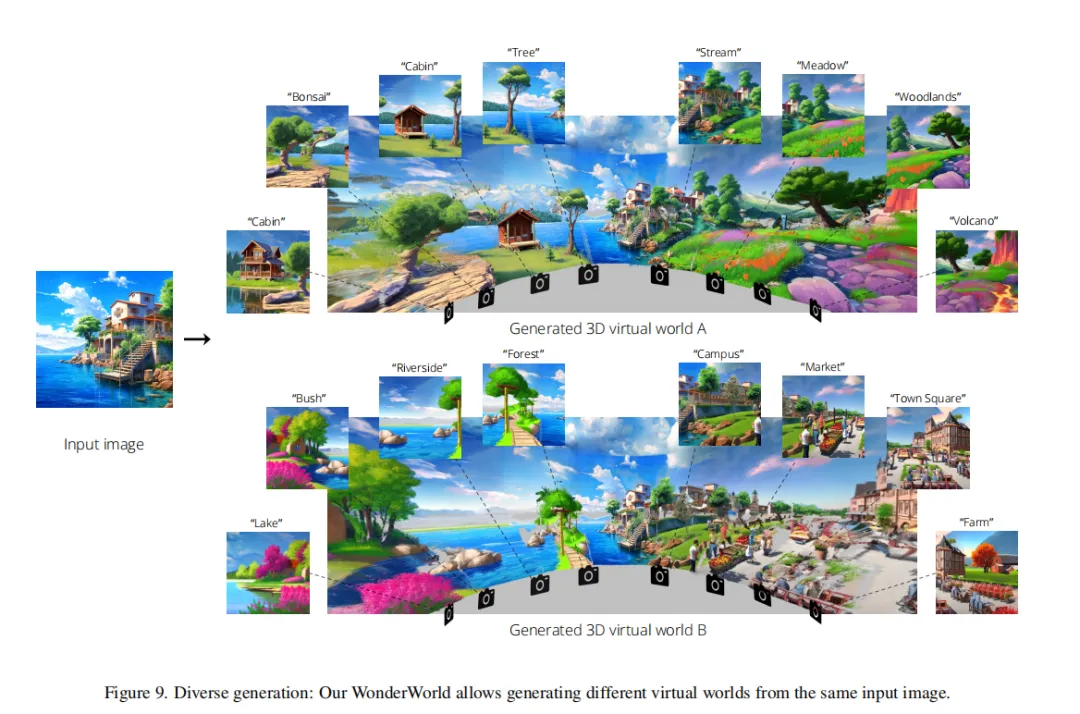

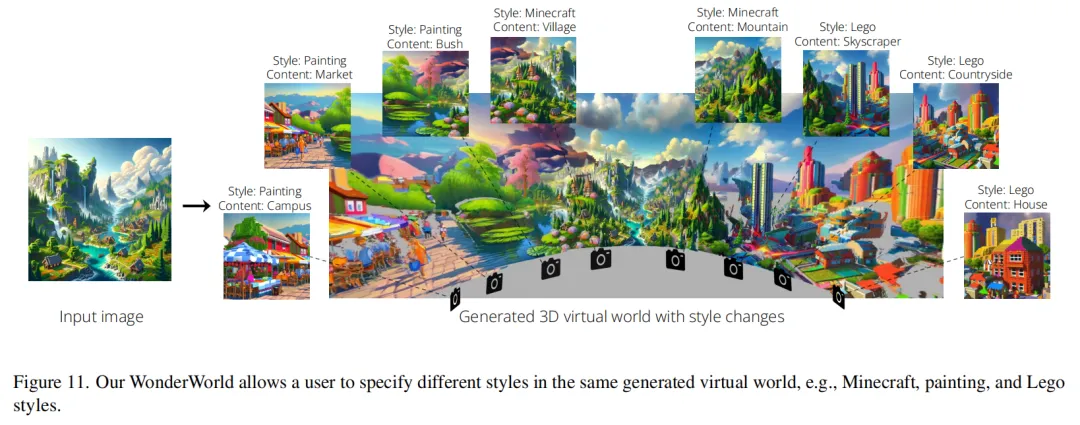

由于WonderWorld允許選擇不同的文本提示來改變內容,生成的場景在每次運行時可以是多樣化和不同的。本文在下圖9中展示了從同一輸入圖像生成的多樣化結果的示例。WonderWorld還允許用戶在同一生成的虛擬世界中指定不同的風格,例如Minecraft、繪畫和樂高風格,如下圖11所示。

生成速度

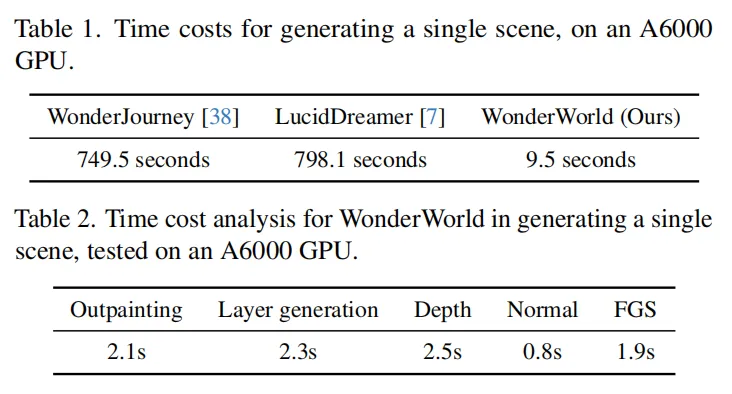

由于本文的重點是使3D場景生成具有互動性,本文報告了從開始生成到可以看到結果的場景生成時間成本。在下表1中顯示了單個場景的生成時間。從下表1可以看出,即使是現有最快的方法WonderJourney,生成單個場景也需要超過700秒,大部分時間花在生成多個視圖以填補現有場景和新生成場景之間的空隙上。LucidDreamer從輸入圖像生成稍微擴展的場景,并花費大部分時間生成多個視圖,調整這些視圖的深度,并訓練一個3DGS以適應這些視圖。總的來說,以往的方法需要生成或提取多個視圖,并花費大量時間優化其3D場景表示。本文通過使用基于幾何的初始化原則的FGS加速了表示優化,并通過分層場景生成策略減少了所需的圖像數量。共同提升快速場景生成的能力。本文在下表2中展示了時間成本的分析。由于擴散模型推理(外繪、層內繪、深度和法線估計)花費了最多時間,本文的方法將受益于未來在加速擴散推理方面的進展。

結論

本文介紹了WonderWorld,一個用于交互3D場景生成的系統,具有顯著加快生成時間和提升大規模多樣場景性能的技術改進。WonderWorld允許用戶以互動方式生成和探索他們想要的場景部分,并按其需求生成內容。

限制:WonderWorld的一個局限性是場景密度較低,因為每個場景最多只有HxW個高斯表面。另一個局限性是處理細節對象(如樹木)的困難,這可能導致深度估計不準確,從而在視點改變時出現“空洞”或“浮動物”。本文在視頻中展示了一個失敗案例。因此,一個令人興奮的未來方向是利用WonderWorld互動地原型化一個粗略的世界結構,然后通過較慢的單場景多視圖擴散模型進行細化,以提高場景密度、填補空洞和去除浮動物。

本文轉自 AI生成未來 ,作者:Hong-Xing Yu等