視頻生成和具身智能強(qiáng)強(qiáng)聯(lián)合!谷歌&卡內(nèi)基梅隆&斯坦福發(fā)布Gen2Act:泛化超棒!

文章鏈接:https://arxiv.org/pdf/2409.16283

項(xiàng)目鏈接:https://homangab.github.io/gen2act/

亮點(diǎn)直擊

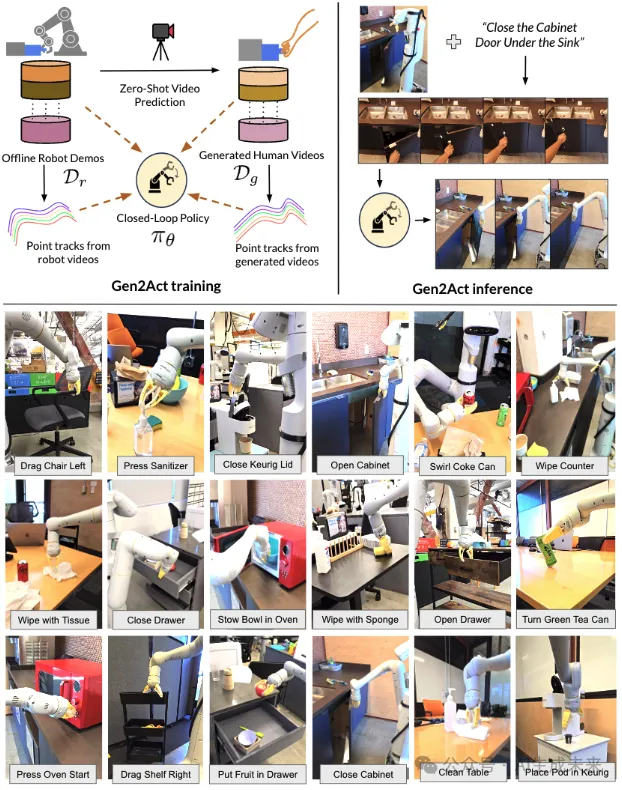

- 人類視頻生成引導(dǎo)機(jī)器人操作:通過(guò)生成零樣本的人類視頻并翻譯成機(jī)器人執(zhí)行策略,避免了直接生成機(jī)器人視頻的復(fù)雜性,利用豐富的網(wǎng)絡(luò)視頻數(shù)據(jù)來(lái)提升泛化能力。

- 現(xiàn)成模型與閉環(huán)策略結(jié)合:不需微調(diào)視頻生成模型,直接使用現(xiàn)成模型生成視頻,并通過(guò)結(jié)合機(jī)器人觀察歷史與點(diǎn)軌跡優(yōu)化,確保策略能夠動(dòng)態(tài)調(diào)整,提升操作準(zhǔn)確性。

- 強(qiáng)大的泛化能力:在面對(duì)新物體類型和新動(dòng)作時(shí),Gen2Act表現(xiàn)出顯著的泛化能力,相較于其他基線方法,成功率平均提升30%。

- 支持復(fù)雜任務(wù)的長(zhǎng)時(shí)執(zhí)行:Gen2Act能夠連續(xù)完成多個(gè)中間任務(wù),如“制作咖啡”等復(fù)雜操作任務(wù),展示了其處理長(zhǎng)時(shí)任務(wù)的潛力。

總結(jié)速覽

解決的問(wèn)題

機(jī)器人操作策略在面對(duì)新任務(wù)時(shí),往往難以處理未見過(guò)的物體類型和新動(dòng)作。由于機(jī)器人數(shù)據(jù)采集成本高,如何實(shí)現(xiàn)操作策略的泛化是一個(gè)關(guān)鍵挑戰(zhàn)。

提出的方案

提出Gen2Act方法,通過(guò)從網(wǎng)絡(luò)數(shù)據(jù)中預(yù)測(cè)運(yùn)動(dòng)信息,生成人類視頻,并將機(jī)器人策略與生成的視頻結(jié)合。通過(guò)零樣本的人類視頻生成引導(dǎo)機(jī)器人策略執(zhí)行新任務(wù),避免大量的機(jī)器人數(shù)據(jù)采集。

應(yīng)用的技術(shù)

- 語(yǔ)言條件下的零樣本人類視頻生成。

- 使用預(yù)訓(xùn)練的視頻生成模型,直接生成人類視頻,不需微調(diào)模型。

- 利用少量的機(jī)器人交互數(shù)據(jù)訓(xùn)練策略模型,并結(jié)合生成的視頻執(zhí)行任務(wù)。

達(dá)到的效果

Gen2Act能夠讓機(jī)器人操作未見過(guò)的物體,并完成機(jī)器人數(shù)據(jù)中未包含的新動(dòng)作任務(wù),在真實(shí)場(chǎng)景中展現(xiàn)出多樣化的泛化能力。

方法

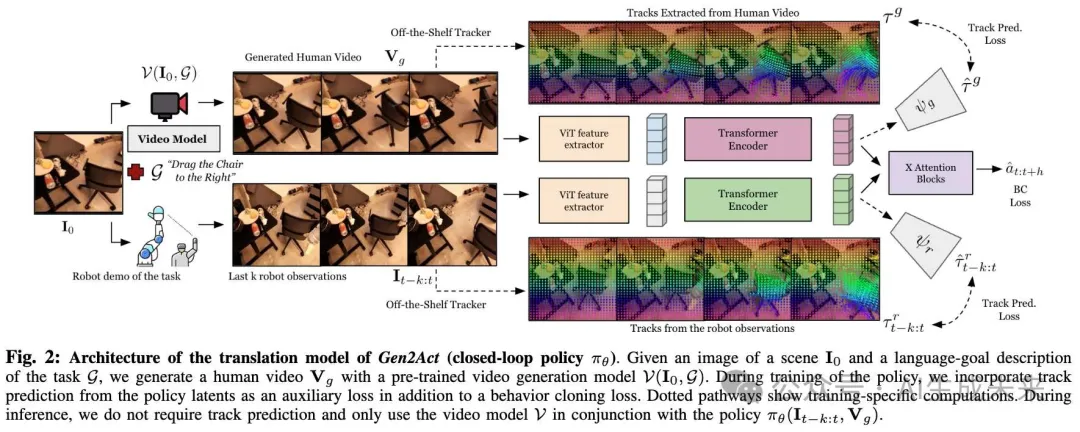

本文開發(fā)了一種基于語(yǔ)言條件的機(jī)器人操作系統(tǒng)Gen2Act,能夠在未知場(chǎng)景中泛化到新任務(wù)。為實(shí)現(xiàn)這一目標(biāo),采用了分解方法:

- 給定一個(gè)場(chǎng)景和任務(wù)描述,使用現(xiàn)有的視頻預(yù)測(cè)模型生成一個(gè)人類解決任務(wù)的視頻;

- 基于生成的人類視頻,通過(guò)一個(gè)學(xué)習(xí)到的人類到機(jī)器人的翻譯模型推斷機(jī)器人動(dòng)作,該模型可以利用生成視頻中的運(yùn)動(dòng)線索。我們表明,這種分解策略在利用大規(guī)模視頻模型中固有的網(wǎng)絡(luò)規(guī)模運(yùn)動(dòng)理解方面具有可擴(kuò)展性,用數(shù)量級(jí)更少的機(jī)器人交互數(shù)據(jù)完成從生成的人類視頻到機(jī)器人應(yīng)執(zhí)行的動(dòng)作的簡(jiǎn)單翻譯任務(wù)。

概述與設(shè)置

人類視頻生成

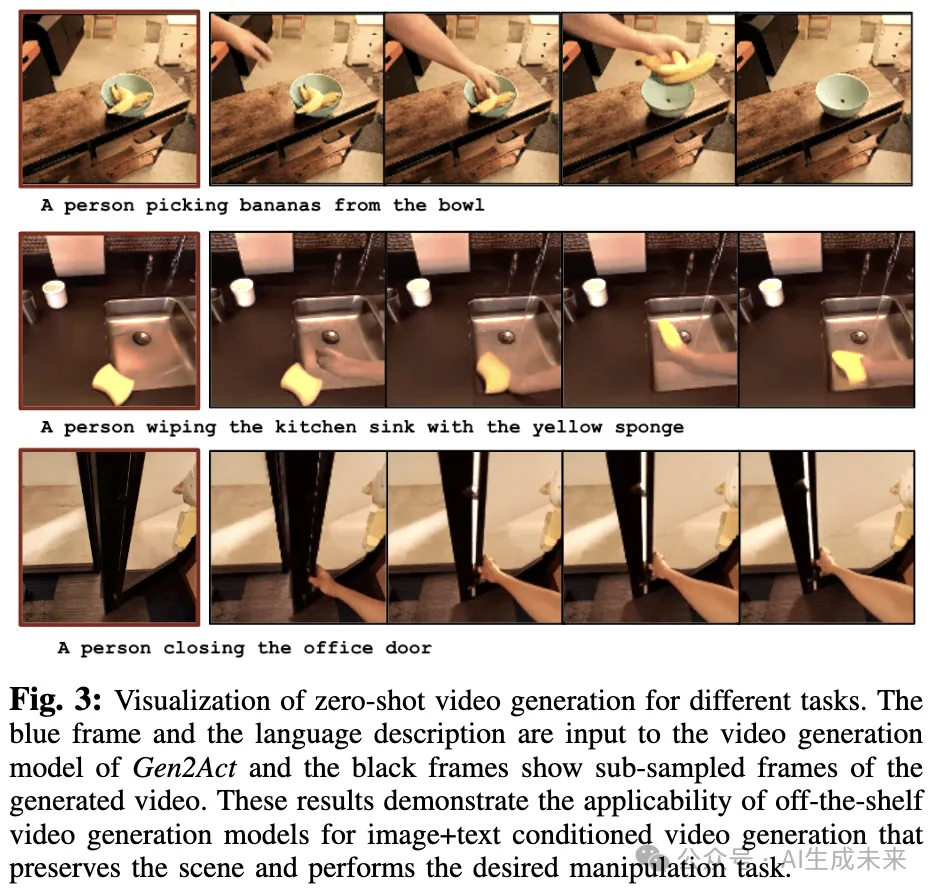

使用現(xiàn)有的文本+圖像條件下的視頻生成模型進(jìn)行任務(wù)的視頻生成。我們發(fā)現(xiàn)當(dāng)前的視頻生成模型能夠在零樣本情況下很好地生成人類視頻,而無(wú)需任何微調(diào)或適配(如下圖3中的示例)。相比于一些之前的工作[57, 58]嘗試生成機(jī)器人視頻,專注于人類視頻生成,因?yàn)楫?dāng)前的視頻生成模型無(wú)法在零樣本情況下生成機(jī)器人視頻,并且需要特定的機(jī)器人微調(diào)數(shù)據(jù)才能實(shí)現(xiàn)。這種微調(diào)往往會(huì)削弱那些基于網(wǎng)絡(luò)大規(guī)模數(shù)據(jù)訓(xùn)練的生成模型在新場(chǎng)景中的泛化優(yōu)勢(shì)。

從生成的人類視頻到機(jī)器人動(dòng)作翻譯

在Gen2Act中,將軌跡預(yù)測(cè)作為訓(xùn)練期間的輔助損失,并與BC損失相結(jié)合,而在測(cè)試時(shí)不使用軌跡預(yù)測(cè)Transformer。這有助于減少測(cè)試時(shí)的計(jì)算量,提高部署效率。

部署

為了部署 Gen2Act 來(lái)解決操作任務(wù),首先根據(jù)任務(wù)的語(yǔ)言描述和場(chǎng)景的圖像生成一個(gè)人類視頻。接著,使用生成的視頻作為條件展開閉環(huán)策略。

對(duì)于執(zhí)行包含多個(gè)任務(wù)的長(zhǎng)時(shí)活動(dòng)鏈,我們首先使用現(xiàn)成的大型語(yǔ)言模型(如 Gemini)來(lái)獲取不同任務(wù)的語(yǔ)言描述。我們通過(guò)使用前一個(gè)策略執(zhí)行后的最后一幀圖像作為生成后續(xù)任務(wù)人類視頻的第一幀,來(lái)為任務(wù)序列鏈接 Gen2Act。我們選擇按順序生成視頻,而不是從最初的圖像生成所有視頻,因?yàn)樵跈C(jī)器人執(zhí)行了中間任務(wù)后,場(chǎng)景中的物體最終狀態(tài)可能會(huì)不同。

實(shí)驗(yàn)

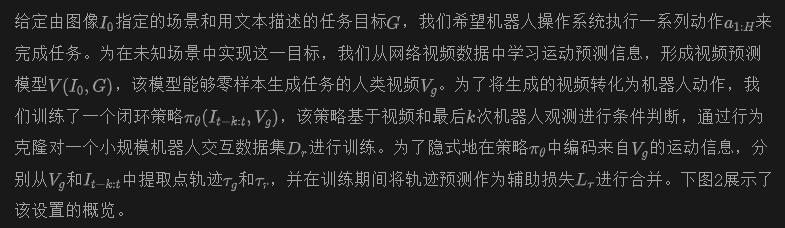

在廚房、辦公室和實(shí)驗(yàn)室等多樣化場(chǎng)景中進(jìn)行實(shí)驗(yàn),涵蓋了大量操作任務(wù)。這些實(shí)驗(yàn)旨在回答以下問(wèn)題:

- Gen2Act 是否能夠在多樣化的日常場(chǎng)景中生成合理的操作類人類視頻?

- Gen2Act 在應(yīng)對(duì)新的場(chǎng)景、物體和動(dòng)作的泛化能力上表現(xiàn)如何?

- Gen2Act 能否通過(guò)視頻生成和視頻條件策略執(zhí)行的鏈接,實(shí)現(xiàn)長(zhǎng)時(shí)操作?

- 通過(guò)加入少量額外的多樣化人類遙操作示范共同訓(xùn)練,能否提升 Gen2Act 在新任務(wù)上的表現(xiàn)?

評(píng)估設(shè)置的詳細(xì)信息

按照以往的語(yǔ)言/目標(biāo)條件策略學(xué)習(xí)工作,用執(zhí)行的機(jī)器人軌跡是否解決了指令中規(guī)定的任務(wù)來(lái)量化成功,并定義基于同一任務(wù)描述的多次展開的成功率。我們根據(jù)不同泛化水平進(jìn)行分類,采用之前工作中的術(shù)語(yǔ):

- 輕度泛化(MG):在已知場(chǎng)景中,已見物體實(shí)例的未見配置;例如照明和背景變化等場(chǎng)景自然變異。

- 標(biāo)準(zhǔn)泛化(G):在已知/未知場(chǎng)景中,未見物體實(shí)例。

- 物體類型泛化(OTG):在未知場(chǎng)景中,完全未見的物體類型。

- 動(dòng)作類型泛化(MTG):在未知場(chǎng)景中,完全未見的動(dòng)作類型。

這里,已見和未見是相對(duì)于機(jī)器人交互數(shù)據(jù)定義的,并假設(shè)視頻生成模型已經(jīng)看過(guò)包括機(jī)器人數(shù)據(jù)未見內(nèi)容在內(nèi)的豐富網(wǎng)絡(luò)數(shù)據(jù)。

數(shù)據(jù)集和硬件細(xì)節(jié)

對(duì)于視頻生成,使用現(xiàn)有的 VideoPoet 模型,并調(diào)整其條件以適應(yīng)方形圖像和任務(wù)的語(yǔ)言描述。在我們的實(shí)驗(yàn)中,沒有對(duì)該模型進(jìn)行任何微調(diào),發(fā)現(xiàn)它可以直接泛化到所有機(jī)器人實(shí)驗(yàn)場(chǎng)景中的人類視頻生成任務(wù)。

對(duì)于機(jī)器人實(shí)驗(yàn),使用了一臺(tái)帶有柔順雙指夾具的移動(dòng)操作機(jī)器人,機(jī)器人通過(guò)末端執(zhí)行器控制進(jìn)行策略部署。機(jī)械臂安裝在機(jī)器人右側(cè)的機(jī)身上。手動(dòng)在辦公室、廚房和實(shí)驗(yàn)室場(chǎng)景中移動(dòng)機(jī)器人,并讓它操作這些場(chǎng)景中的不同物體。機(jī)器人操作頻率為 3Hz,每次任務(wù)開始前,將機(jī)器人的手臂重置到一個(gè)預(yù)定義的位置,以確保機(jī)器人的攝像頭不會(huì)遮擋場(chǎng)景。

為了訓(xùn)練視頻條件策略,使用了由先前工作收集的現(xiàn)有離線機(jī)器人示范數(shù)據(jù)集,并通過(guò)另一先前工作收集的一些人類視頻示范配對(duì)進(jìn)行增強(qiáng)。此外,我們通過(guò)使用視頻生成模型,基于各自機(jī)器人示范的首幀,生成對(duì)應(yīng)的人類視頻,創(chuàng)建了一對(duì)一的形式(生成的人類視頻,機(jī)器人示范)的配對(duì)。對(duì)于生成的人類視頻和機(jī)器人示范中的點(diǎn)軌跡,使用了現(xiàn)成的跟蹤方法。人類視頻生成和點(diǎn)軌跡生成都完全在離線一次性完成,并不會(huì)增加策略訓(xùn)練時(shí)的成本。

基線與對(duì)比

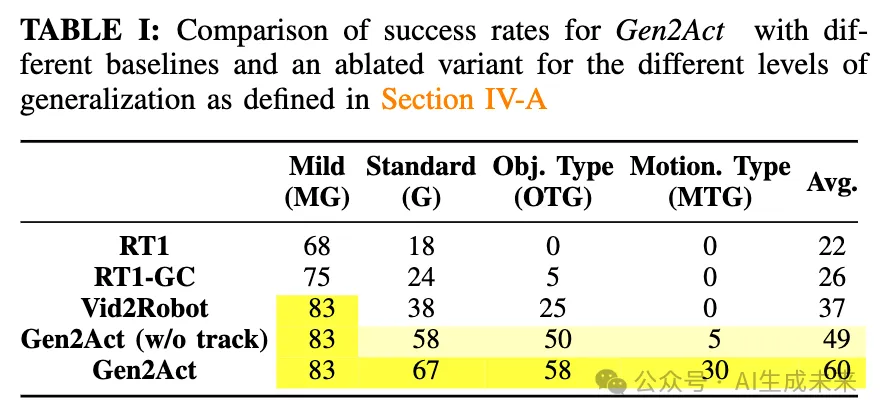

與基線方法和 Gen2Act 的不同變體進(jìn)行了對(duì)比。特別是,與一個(gè)基于語(yǔ)言條件的策略基線(RT1)進(jìn)行了對(duì)比,該策略在與 Gen2Act 相同的機(jī)器人數(shù)據(jù)上訓(xùn)練。此外,我們還與基于視頻條件的策略基線(Vid2Robot)進(jìn)行了對(duì)比,該策略使用配對(duì)的真人和機(jī)器人視頻進(jìn)行訓(xùn)練。另一個(gè)基線是基于目標(biāo)圖像條件的策略(RT1-GC),該策略僅依賴 Gen2Act 的真實(shí)和生成視頻的最后一幀(即目標(biāo)圖像)進(jìn)行條件訓(xùn)練。最后,考慮了不帶軌跡預(yù)測(cè)損失的 Gen2Act 變體。

人類視頻生成分析

前面圖 3 顯示了在多樣化場(chǎng)景中生成的人類視頻的定性結(jié)果。我們可以看到,生成的視頻合理地操作了文本指令中描述的場(chǎng)景。場(chǎng)景中的相應(yīng)物體得到了操作,同時(shí)保持了背景的完整性,并且沒有引入攝像頭移動(dòng)或生成中的偽影。這些結(jié)果令人興奮,因?yàn)檫@些生成在新場(chǎng)景中是零樣本的,并且可以直接用于機(jī)器人任務(wù)中,以想象如何操作未見的物體和場(chǎng)景。

Gen2Act 在場(chǎng)景、物體和動(dòng)作中的泛化能力

本節(jié)比較了 Gen2Act 與基線方法和不同消融變體在不同泛化水平下的表現(xiàn)。下表 I 顯示了任務(wù)在不同泛化水平上的成功率均值。我們觀察到,在更高的泛化水平下,Gen2Act 的成功率明顯更高,表明結(jié)合了運(yùn)動(dòng)信息的提取(通過(guò)軌跡預(yù)測(cè))的人類視頻生成在未見任務(wù)中非常有幫助。

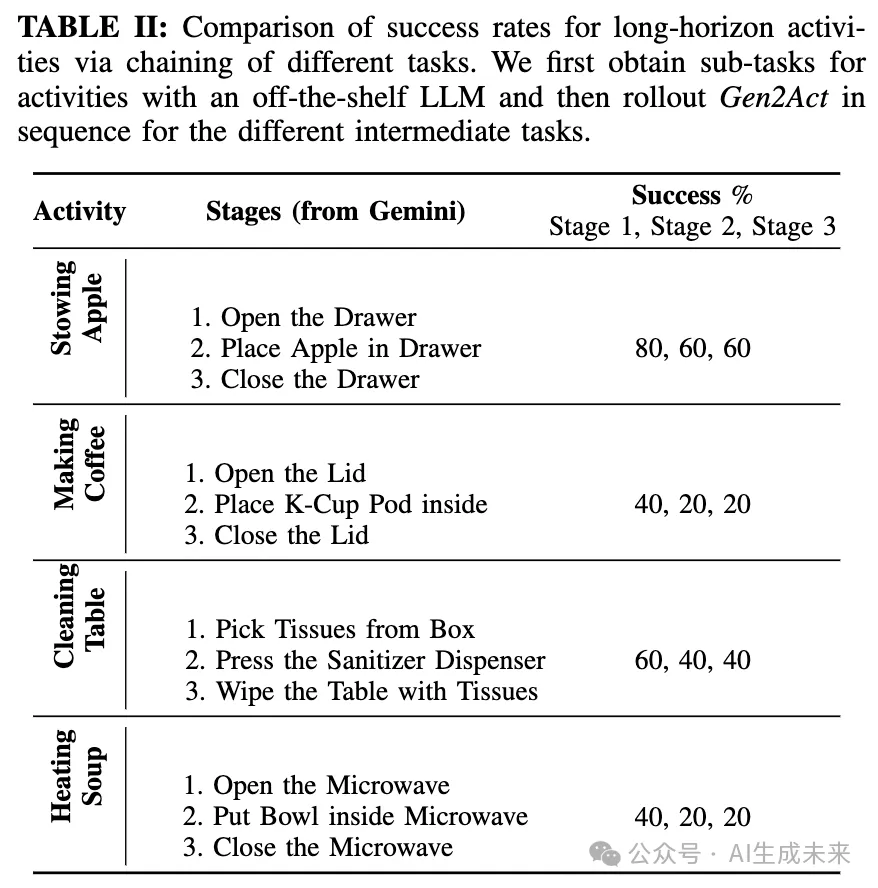

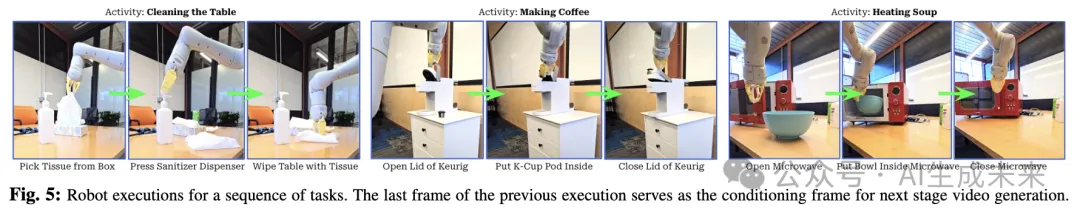

Gen2Act 的長(zhǎng)時(shí)操作任務(wù)鏈接

接下來(lái),分析了 Gen2Act 在通過(guò)任務(wù)鏈接解決一系列操作任務(wù)中的可行性。下表 II 顯示了如“制作咖啡”這類長(zhǎng)時(shí)活動(dòng)的結(jié)果,這些活動(dòng)由多個(gè)按順序執(zhí)行的任務(wù)組成。我們通過(guò) Gemini獲得這些任務(wù)的序列,并對(duì)每個(gè)任務(wù),使用前一個(gè)任務(wù)執(zhí)行后場(chǎng)景的最后一幀作為視頻生成的條件,并在生成的人類視頻的條件下執(zhí)行當(dāng)前任務(wù)的策略。依次重復(fù)此過(guò)程,并報(bào)告每個(gè)階段的成功率(5 次試驗(yàn)中的成功次數(shù))。下圖 5 直觀地展示了來(lái)自四個(gè)長(zhǎng)時(shí)活動(dòng)的單次執(zhí)行展開。

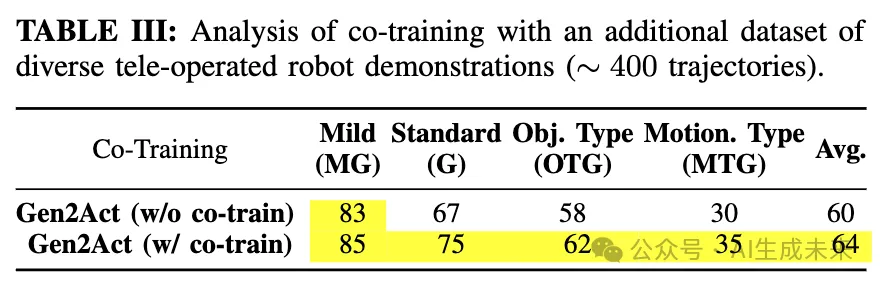

使用額外的遙操作示范進(jìn)行共同訓(xùn)練

之前實(shí)驗(yàn)中使用的離線數(shù)據(jù)集在場(chǎng)景和任務(wù)類型上覆蓋有限,導(dǎo)致在更高的泛化水平(前面表 I 中的 OTG 和 MTG)上 Gen2Act 的成功率不到 60%。在本節(jié)中,我們通過(guò)實(shí)驗(yàn)研究了增加少量額外的多樣化遙操作軌跡,結(jié)合現(xiàn)有的離線數(shù)據(jù)集共同訓(xùn)練,是否可以幫助提升泛化能力。視頻生成模型保持不變。下表 III 的結(jié)果顯示,通過(guò)共同訓(xùn)練,Gen2Act 的表現(xiàn)有所提升。這令人振奮,因?yàn)檫@表明僅通過(guò)少量多樣化的示范,Gen2Act 的翻譯模型就可以更好地根據(jù)生成的視頻在機(jī)器人數(shù)據(jù)有限的更高泛化水平下提升表現(xiàn)。

失敗分析

本節(jié)討論了 Gen2Act 的失敗類型。發(fā)現(xiàn),對(duì)于 MG 和一定程度上的 G,視頻生成中的不準(zhǔn)確與策略失敗的相關(guān)性較小。而在更高泛化水平(物體類型 OTG 和動(dòng)作類型 MTG)下,如果視頻生成的結(jié)果不合理,策略往往無(wú)法成功執(zhí)行任務(wù)。這也證明了 Gen2Act 的策略在執(zhí)行任務(wù)時(shí)利用了生成的人類視頻來(lái)推斷運(yùn)動(dòng)線索,因此當(dāng)視頻生成在機(jī)器人數(shù)據(jù)支持有限的場(chǎng)景中出現(xiàn)錯(cuò)誤時(shí)(例如在 OTG 和 MTG 中),策略將失敗。

討論與結(jié)論

總結(jié)。 本研究提出了一個(gè)結(jié)合零樣本人類視頻生成與有限機(jī)器人演示的框架,用于學(xué)習(xí)具有泛化能力的機(jī)器人操作任務(wù)。總體而言,工作表明,基于非機(jī)器人數(shù)據(jù)集(如網(wǎng)絡(luò)視頻)訓(xùn)練的運(yùn)動(dòng)預(yù)測(cè)模型可以幫助操作策略在未見場(chǎng)景中實(shí)現(xiàn)泛化,而不需要為每個(gè)任務(wù)收集機(jī)器人數(shù)據(jù)。

局限性。 本工作主要依賴于零樣本人類視頻生成,并通過(guò)視頻中的點(diǎn)軌跡預(yù)測(cè)為機(jī)器人操作系統(tǒng)提供運(yùn)動(dòng)線索,幫助其與未見物體交互并執(zhí)行新任務(wù)。因此,系統(tǒng)的能力受限于當(dāng)前視頻生成模型的限制,如無(wú)法生成逼真的手部動(dòng)作,因而在執(zhí)行非常精細(xì)的任務(wù)時(shí)能力有限。

未來(lái)工作。 探索從生成的視頻中恢復(fù)更多密集的運(yùn)動(dòng)信息(例如對(duì)象網(wǎng)格)以解決當(dāng)前的限制,可能是未來(lái)研究的一個(gè)有趣方向。另一個(gè)重要的方向是,通過(guò)學(xué)習(xí)恢復(fù)策略來(lái)處理中間失敗,進(jìn)一步增強(qiáng)任務(wù)鏈的可靠性,以支持長(zhǎng)時(shí)操作任務(wù)。

本文轉(zhuǎn)自AI生成未來(lái) ,作者:AI生成未來(lái)