曠視開源的AI人像視頻生成太炸了!輸入照片即可模仿任意表情包 精華

日前,曠視科技發布了一項新的開源 AI 人像視頻生成框架 ——MegActor。基于該框架,用戶只需輸入一張靜態的肖像圖片,以及一段視頻(演講、表情包、rap)文件,即可生成一段表情豐富、動作一致的 AI 人像視頻。MegActor 所生成的視頻長度,取決于給定的驅動視頻的長度。與阿里 EMO、微軟 VASA 等最新涌現的 AI 視頻模型不同,曠視 MegActor 將采用開源的方式,提供給開發者社區使用。MegActor 能夠呈現出絲毫畢現的效果,面部細節更加豐富自然,畫質更出色。

為了進一步展示其泛化性,MegActor 甚至可以讓 VASA 里面的人物肖像和它們的視頻彼此組合生成,得到表情生動的視頻生成結果。

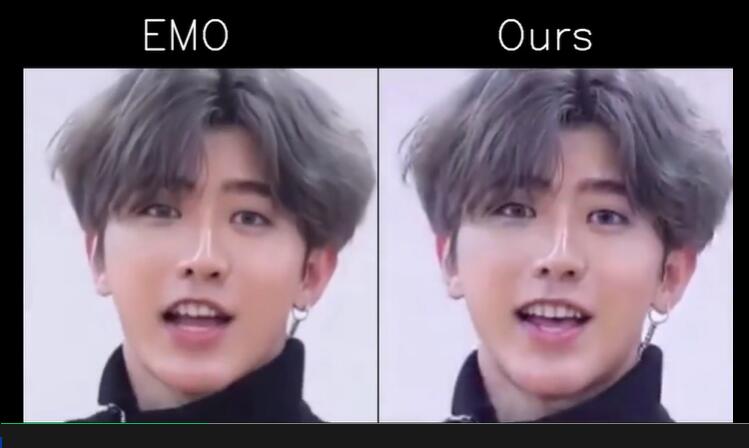

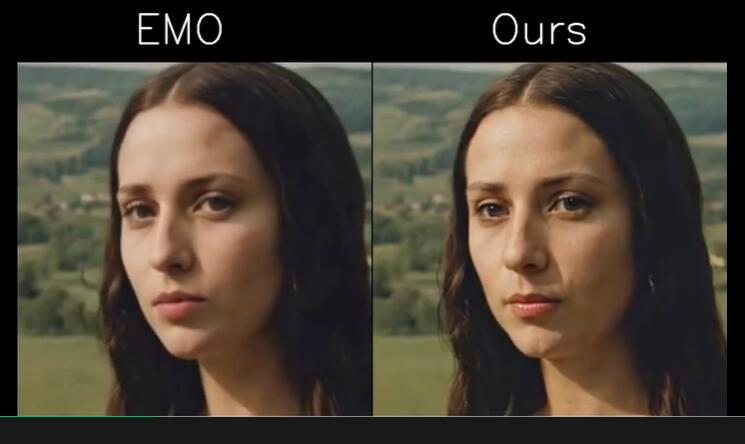

即使是對比阿里 EMO 的官方 Case,MegActor 也能生成近似的結果。

總的來說,不管是讓肖像開口說話,讓肖像進行唱歌 Rap,還是讓肖像模仿各種搞怪的表情包,MegActor 都可以得到非常逼真的生成效果。

- 論文:https://arxiv.org/abs/2405.20851

- 代碼地址:https://github.com/megvii-research/megactor

- 項目地址:https://megactor.github.io/

MegActor 是曠視研究院的最新研究成果。曠視研究院,是曠視打造的公司級研究機構。曠視研究院旨在通過基礎創新突破 AI 技術邊界,以工程創新實現技術到產品的快速轉化。經過多年發展,曠視研究院已成為全球規模領先的人工智能研究院。

在目前的人像視頻生成領域,許多工作通常使用高質量的閉源自采數據進行訓練,以追求更好的效果。而曠視研究院始終堅持全面開源,確保實際效果的可復現性。MegActor 的訓練數據全部來自公開可獲取的開源數據集,配合開源代碼,使得感興趣的從業者可以從頭開始完整復現這些令人驚艷的效果。

為了完全復刻原始視頻的表情和動作,MegActor 采用了原始圖像進行驅動,這與多數廠商使用 sketch、pose、landmark 的中間表示皆然不同,能夠捕捉到細致的表情和運動信息。

曠視科技研究總經理范浩強表示,在 AI 視頻生成領域,我們發現目前主流的骨骼關鍵點控制方式不僅要求用戶提供難以獲取的專業控制信號,同時生成視頻相較于原肖像的保真程度也不盡如人意。通過一系列研究發現,使用原視頻進行驅動,不僅將幫助用戶降低控制信號的門檻,更能生成更加保真且動作一致的視頻。

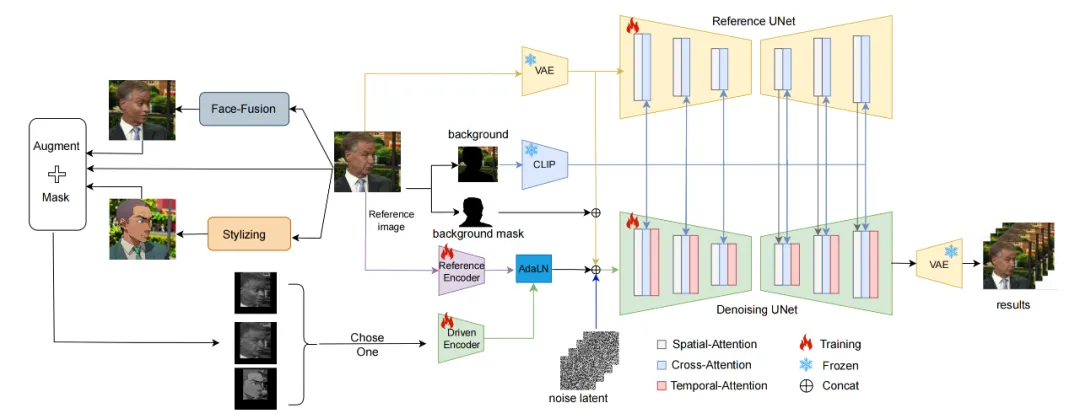

具體來說,MegActor 主要由兩個階段構成:

- 使用了一個 ReferenceNet 對參考圖像進行特征提取,負責得到參考圖像的外觀和背景等信息;

- 使用了一個 PoseGuider,對輸入的視頻進行運動和表情信息提取,負責將運動和表情信息遷移到參考圖像上。

盡管相較于使用音頻或 landmark 等表示方式,使用原始視頻進行驅動能帶來更加豐富的表情細節和運動信息。然而,使用原始視頻進行驅動依然存在兩大核心技術挑戰:一是 ID 泄露問題;二是原始視頻中的背景和人物皺紋等無關信息會干擾影響合成表現。

為此,MegActor 開創性地采用了條件擴散模型。首先,它引入了一個合成數據生成框架,用于創建具有一致動作和表情但不一致身份 ID 的視頻,以減輕身份泄露的問題。其次,MegActor 分割了參考圖像的前景和背景,并使用 CLIP 對背景細節進行編碼。這些編碼的信息隨后通過文本嵌入模塊集成到網絡中,從而確保了背景的穩定性。

在數據訓練方面,曠視研究院團隊僅使用公開的數據集進行訓練,處理了 VFHQ 和 CeleV 數據集進行訓練,總時長超過 700 小時。同時,為了避免 ID 泄露問題,MegActor 還使用換臉和風格化方法 1:1 生成合成數據,實現表情和動作一致、但 ID 不一致的數據。此外,為了提高對大范圍動作和夸張表情的模仿能力,團隊使用注視檢測模型對數據進行處理,獲取大約 5% 的高質量數據進行 Finetune 訓練。

通過采用一系列新的模型框架和訓練方法,曠視研究院團隊僅使用了不到 200 塊 V100 顯卡小時的訓練時長,最終實現的具體特性包括:

- 可以根據輸入的視頻生成任意持續時間的模仿視頻,同時保證角色身份的一致性

- 支持各種驅動視頻,如演講、唱歌、表情包等

- 支持不同的畫風(照片、傳統繪畫、漫畫、AI 數字人等)

與音頻生成的方法相比,MegActor 生成的視頻,不僅能確保表情和動作一致,更能達到同樣的自然程度。

目前,MegActor 已經完全開源,供廣大開發者和用戶即開即用。

本文轉自 機器之心 ,作者:機器之心