阿里商業級視頻生成框架——軌跡控制版視頻生成 Tora 重磅開源!

論文鏈接:https://arxiv.org/pdf/2407.21705

項目鏈接:https://ali-videoai.github.io/tora_video/

代碼鏈接:https://github.com/alibaba/Tora

阿里團隊最近在 GitHub 上推出了其創新的文生視頻生成工具——Tora,為學術界和開源社區提供了新的研究資源。Tora 基于先進的DiT框架,專注于軌跡控制的視頻生成。此次開源的版本包括了完整的推理代碼和模型權重,旨在為研究人員和開發者提供高效的工具,促進技術交流與學習。從GitHub 上的 README 文件來看,由于阿里目前的商業使用計劃,當前開放的是文生視頻版本的Tora。未來,阿里團隊計劃推出 ModelScope 的試用 demo、訓練代碼以及完整版本的 Tora,以滿足更多用戶的需求,這無疑將推動文生視頻技術的進一步發展。

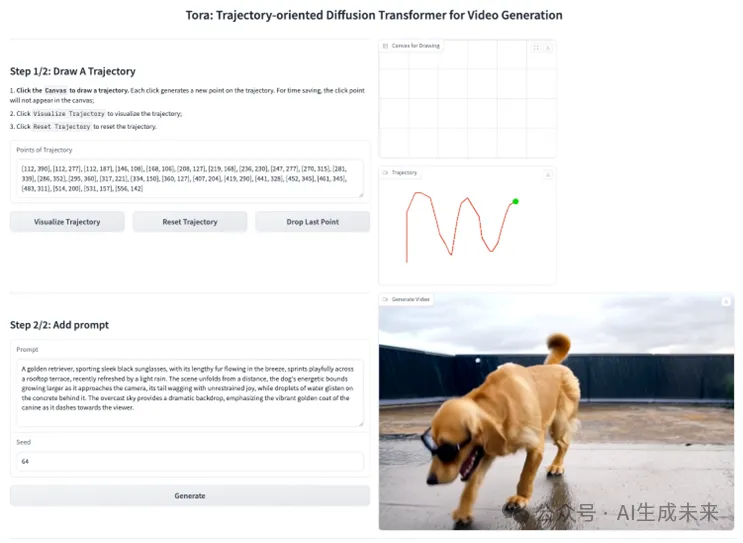

目前從Github倉庫來看,Tora 的文生視頻生成能力通過 Gradio 的可視化界面呈現,確保用戶體驗流暢且易于操作。用戶可以通過以下步驟輕松創建一段6s的軌跡可控視頻:

- 繪制軌跡:用戶可以選擇預設軌跡或自定義繪制路徑,實現個性化的控制。

- 輸入文本提示:通過輸入文本 prompt,用戶能夠定義視頻內容,推薦使用詳細描述以提高生成效果的豐富性。

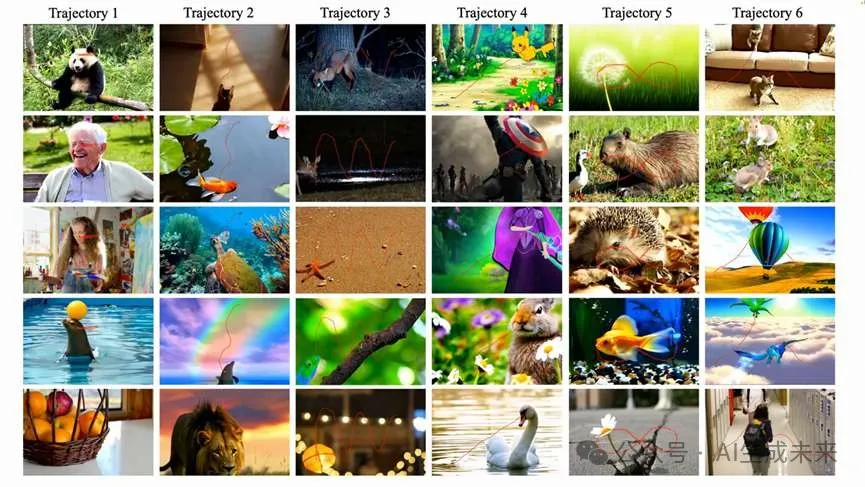

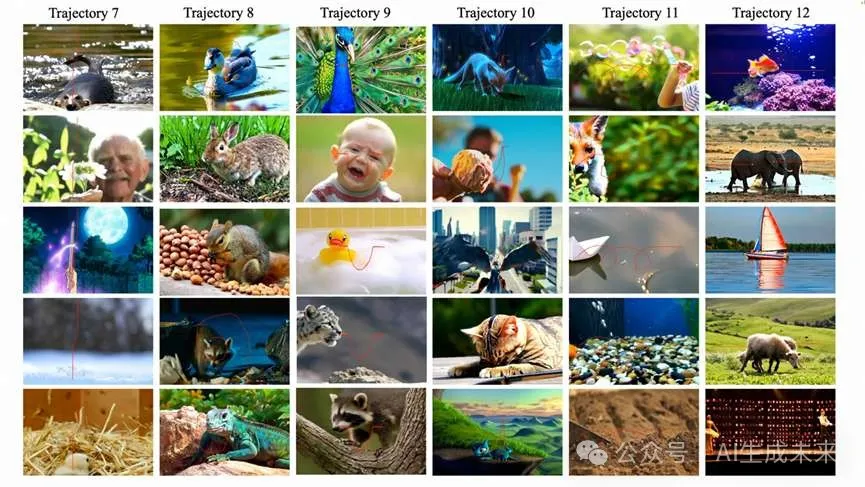

在github倉庫展示的 demo 中,Tora 在處理多種軌跡形式時表現出色。不論是直線軌跡還是曲線路徑,系統皆能精準地生成與之對應的視頻。尤其值得注意的是,當文本提示中的對象與預設軌跡明顯不太可能匹配時,Tora 動態地調整物體的局部運動,確保其整體運動仍然符合自然規律,并保持視覺的一致性。這種機制使得生成的視頻在自然度和協調性上都有了顯著提高。如果您對這項技術感興趣,歡迎訪問其github(https://github.com/alibaba/Tora),一同探索這項前沿技術的魅力。

前面AI生成未來分享過Tora的技術文章解讀:

??寥寥數筆,動畫自成!阿里Tora: 首個軌跡引導的DiT創新實現精確運動控制視頻生成??

文章亮點

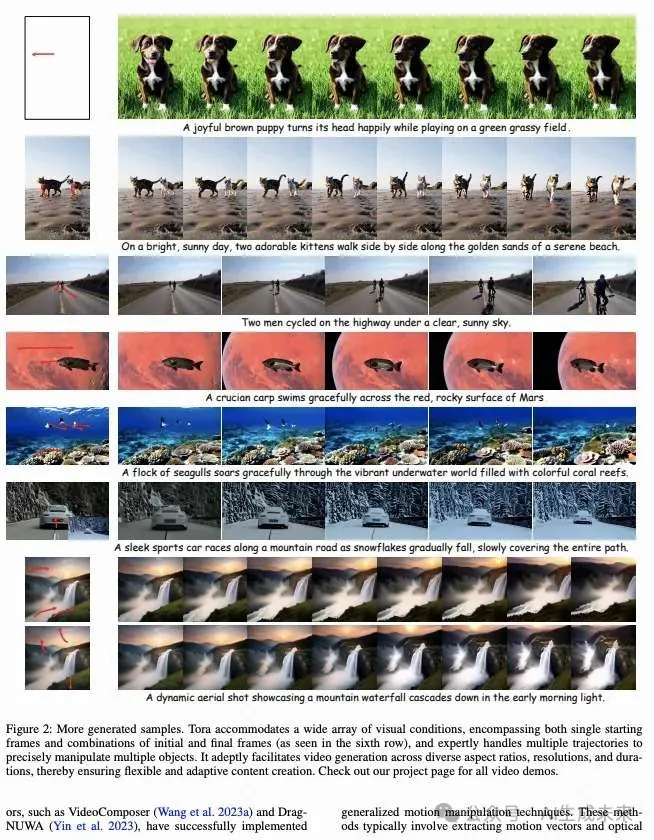

- 本文引入了Tora,這是第一個軌跡導向的DiT用于視頻生成。如下圖2所示,Tora無縫整合了廣泛的視覺和軌跡指令,從而能夠熟練地創建可操控運動的視頻。

- 為了與DiT的可擴展性保持一致,本文設計了一種新穎的軌跡提取器和運動引導融合機制,以獲取時空運動塊,隨后將這些塊注入DiT塊中。本文對幾種架構選擇進行了消融實驗,并為未來基于DiT的運動控制研究提供了實證基線。

- 實驗表明,Tora能夠生成具有不同縱橫比的720p分辨率視頻,最長可達204幀,所有這些都由指定的軌跡引導。此外,它在模擬物理世界中的運動方面表現出色。

結論

Tora是第一個面向軌跡的擴散Transformer框架,用于視頻生成,集成了文本、圖像和軌跡條件。Tora有效地將任意軌跡編碼為時空運動塊,這與DiT的縮放特性相一致,從而實現了更逼真的物理世界運動模擬。通過采用兩階段訓練過程,Tora在各種持續時間、縱橫比和分辨率下實現了運動可控的視頻生成。值得注意的是,它可以生成符合指定軌跡的高質量視頻,最高可達204幀,分辨率為720p。這一能力突顯了Tora在處理多樣化運動模式時的多功能性和魯棒性,同時保持高視覺保真度。本文希望本文的工作為未來的運動引導擴散Transformer方法研究提供一個強有力的基線。

本文轉自 AI生成未來 ,作者:AI生成未來