阿里巴巴AI研究團隊打破視頻生成技術壁壘,EasyAnimate實現高質量長視頻生成

論文標題: EasyAnimate: A High-Performance Long Video Generation Method based on Transformer Architecture

論文:??https://arxiv.org/pdf/2405.18991.pdf??

項目地址:??https://github.com/aigc-apps/EasyAnimate??

EasyAnimate框架介紹

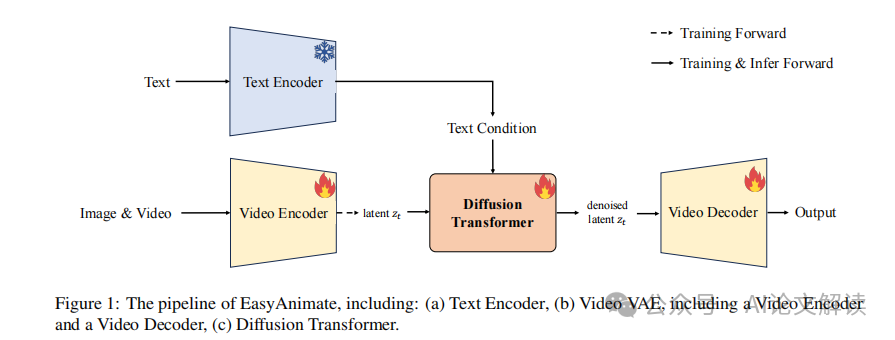

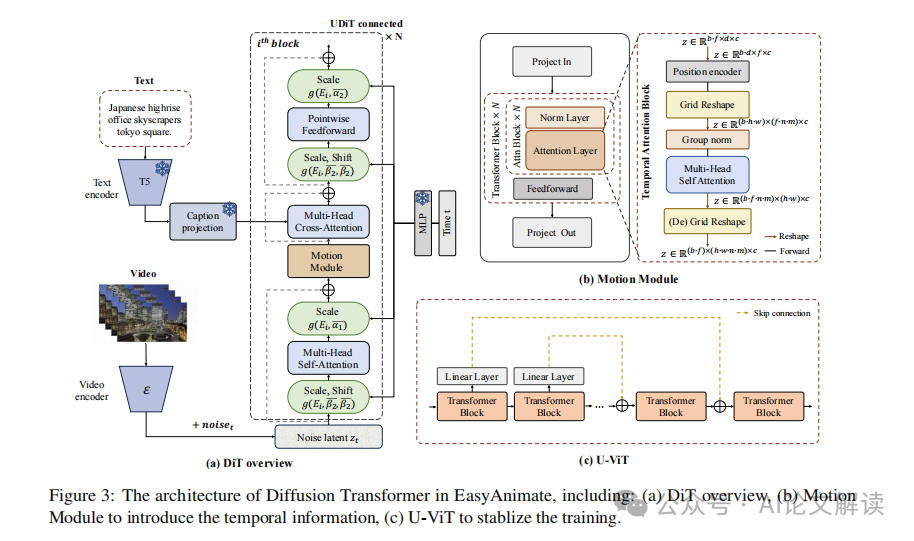

EasyAnimate是一個先進的視頻生成方法,它利用Transformer架構的強大功能來實現高性能的輸出。該框架擴展了最初為2D圖像合成設計的DiT框架,以適應3D視頻生成的復雜性,通過整合一個運動模塊塊來捕捉時間動態,從而確保生成一致的幀和無縫的運動過渡。此外,EasyAnimate引入了切片VAE,這是一種新穎的方法,用于壓縮時間軸,有助于生成長時間視頻。目前,EasyAnimate能夠生成高達144幀的視頻。

EasyAnimate提供了一個全面的視頻生產生態系統,基于DiT,涵蓋數據預處理、VAE訓練、DiT模型訓練(基線模型和LoRA模型)以及端到端視頻推理等方面。

視頻生成的關鍵技術

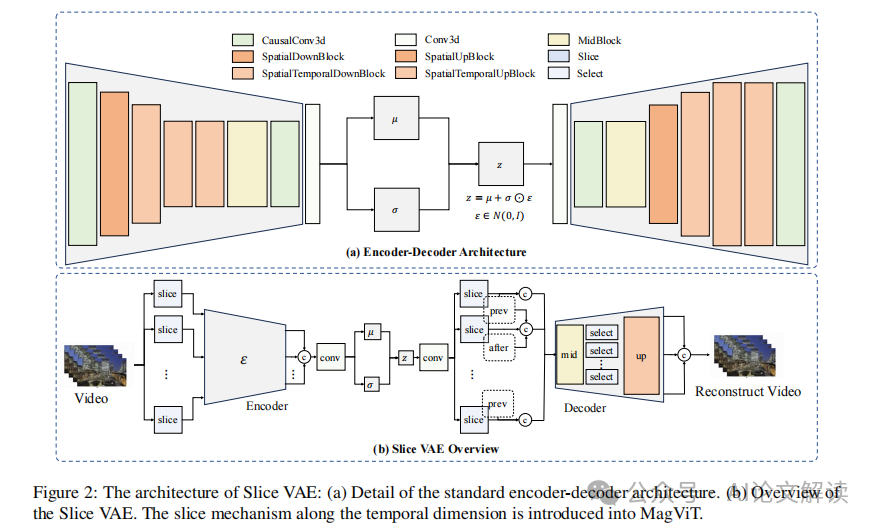

1. 切片VAE技術

在傳統的基于圖像的VAE中,每個視頻幀被編碼為一個單獨的潛在特征,這大大減小了幀的空間尺寸。然而,這種編碼技術忽略了時間動態,將視頻降級為靜態圖像表示。為了有效壓縮視頻編碼器和解碼器中的時間維度,我們引入了切片機制到MagViT中,并提出了切片VAE。通過這種方法,一組視頻幀被分成幾個部分,每個部分分別進行編碼和解碼。

2. 視頻擴散變壓器

視頻擴散Transformer的架構增加了一個運動模塊,使其從2D圖像合成擴展到3D視頻生成。此外,我們還整合了UViT的連接,以增強訓練過程的穩定性。運動模塊專門設計用來利用幀長度內嵌的時間信息。通過在時間維度上整合注意力機制,模型獲得了吸收此類時間數據的能力,這對于生成視頻運動至關重要。同時,我們采用網格重塑操作來增加輸入令牌的池,從而提高圖像中存在的空間細節的利用率,最終實現更優越的生成性能。

這些關鍵技術的應用使EasyAnimate成為未來視頻合成研究的一個強大且高效的基線,推動創新、進步和探索。

訓練過程與策略

1. 訓練策略概述

EasyAnimate采用了三階段的訓練策略,以逐步提升視頻生成的質量和效率。首先,通過對圖像數據的訓練,使DiT模型適應新的視頻VAE。接著,利用大規模的視頻數據集和圖像數據預訓練運動模塊,引入視頻生成能力。最后,使用高質量的視頻數據對整個DiT模型進行精細調整,以優化生成性能。

2. 運動模塊的訓練

運動模塊的訓練是在大規模數據集上進行的,這一步驟至關重要,因為它幫助模型捕捉視頻中的時間動態信息,從而生成連貫的幀和平滑的運動過渡。此模塊通過在時間維度上集成注意力機制,使模型能夠整合這些時間數據,這對于視頻動作的生成至關重要。

3. 分辨率的逐步擴展

在訓練的最后階段,DiT模型通過從較低分辨率到較高分辨率的逐步擴展來訓練,這種方法有效地提高了模型處理高分辨率視頻的能力,同時保持了生成質量。

數據預處理與視頻質量控制

1. 視頻分割

為了保證視頻內容的主題一致性,使用PySceneDetect工具識別視頻中的場景變化,并根據這些過渡進行場景切割。只保留時長在3到10秒之間的視頻段用于模型訓練,這有助于模型更好地學習和生成短視頻。

2. 視頻過濾

視頻數據通過三個方面進行過濾:運動評分、文本區域評分和美學評分。運動過濾確保視頻顯示出運動感,同時保持運動的一致性;文本過濾通過OCR技術檢測視頻幀中的文本區域,過濾掉文本區域超過1%的視頻段;美學過濾則計算視頻的美學評分,只保留高分的視頻用于訓練。

3. 視頻字幕處理

視頻字幕的質量直接影響視頻生成的結果。通過比較多個大型多模態模型的性能和操作效率,選擇了性能優異的VideoChat2和VILA進行視頻數據的字幕處理,這些模型在視頻字幕的詳細性和時間信息方面表現出色,有助于提高生成視頻的質量。

實驗結果與分析

1. 視頻生成性能

EasyAnimate在視頻生成方面表現出色,能夠生成高達144幀的視頻。通過使用創新的Slice VAE和動態模塊,EasyAnimate不僅提高了視頻的時間壓縮效率,還保持了視頻幀之間的連貫性和流暢的動態過渡。實驗結果顯示,通過在時間維度上進行切片處理,能夠有效地管理視頻幀的編碼和解碼,解決了傳統VAE在處理長視頻時遇到的內存限制問題。

2. 模型訓練與優化

在模型訓練方面,EasyAnimate采用了三階段訓練策略,首先是圖像數據的訓練,然后是動態模塊的大規模數據集訓練,最后是高分辨率視頻和圖像的整體網絡訓練。這種分階段的訓練方法有效地提升了模型的穩定性和生成質量。特別是引入UViT的長跳躍連接,有助于在反向傳播過程中防止梯度消失,從而保證了訓練的穩定性。

3. 視頻質量與創新性

通過對比其他視頻生成模型,EasyAnimate在視頻質量和創新性方面均表現優異。它不僅能夠處理不同幀率和分辨率的視頻生成,還能夠適應不同的DiT基線模型,生成多樣化的視頻風格。此外,其視頻VAE的切片機制創新地解決了視頻長時間維度的壓縮問題,顯著提升了生成視頻的長度和質量。

結論與未來展望

EasyAnimate作為一個基于Transformer架構的高性能視頻生成方法,成功地擴展了DiT框架,將其從2D圖像合成拓展到3D視頻生成。通過引入動態模塊和Slice VAE,EasyAnimate不僅優化了視頻幀的一致性和動態過渡,還提高了模型的訓練效率和視頻的生成質量。

未來展望

- 模型優化:未來的研究可以進一步探索如何優化Slice VAE的架構,以更高效地處理更長時間的視頻,同時減少信息損失。

- 應用拓展:EasyAnimate的應用可以擴展到更多領域,如虛擬現實、游戲開發和電影制作,其中對高質量和長時視頻的需求日益增長。

- 技術迭代:隨著人工智能技術的不斷進步,未來可以探索將更多先進的AI技術,如深度學習和神經網絡,整合到EasyAnimate中,以進一步提升視頻生成的自然性和真實感。

本文轉載自?? AI論文解讀??,作者:柏企