簡單卻有效的Agent推理框架:通過預測未來大幅提升智能體的規劃能力

論文標題:

PreAct: Predicting Future in ReAct Enhances Agent’s Planning Ability

論文鏈接:

??https://arxiv.org/abs/2402.11534??

代碼鏈接:

??https://github.com/Fu-Dayuan/PreAct??

01 概述

1.1 背景

大語言模型(LLM)已顯示出一定的規劃和決策能力。利用這種能力,ReAct 將環境信息和智能體(Agent)可執行的行動提供給大語言模型,就可以利用它確定當前狀態下需要執行的行動。

然而,ReAct 系統通常生成單一、直接的因果推理路徑,這限制了它在具有復雜因果關系的任務中的有效性。以 TOT、GOT 和 RAP 為代表的一系列推理指導范式,它們允許在每一步生成多種可能的行動,并根據多個環境反饋結果和選擇策略決定下一步路徑。

雖然這種方法提高了 agent 處理復雜因果關系的能力,但在真實世界的場景中,在同一情況下執行多個行動往往是不現實的。所以需要一種在每輪中僅生成一種行動但能夠處理多樣、復雜推理的智能體框架。

1.2 動機

處理預測與實際結果之間的差異往往有助于人們擴展思維過程和進行反思,從而促進推理朝著正確的方向發展。受科學研究的過程和任務導向對話中有關預測未來的研究成果的啟發,我們提出了一個將預測、推理和行動融為一體的 agent 推理框架——PreAct。

利用預測提供的信息,基于大語言模型的 agent 可以提供更多樣化、更具戰略導向性的推理,進而產生更有效的行動,幫助 agent 完成復雜的任務。

1.3 效果

我們在 AgentBench 中的 HH、OS、DB、LTP 等數據集上進行了大量的實驗,實驗表明 PreAct 在完成復雜任務方面優于 ReAct 方法,且可以與 Reflexion 結合,進一步增強 agent 的推理能力。

我們用不同數量的歷史預測對模型進行提示,發現歷史預測對 LLM 規劃有持續的正向影響。PreAct 和 ReAct 在單步推理上的差異表明,PreAct 在多樣性和戰略方向性方面確實比 ReAct 更有優勢。

02 方法

2.1 前置知識

2.1.1 Agent與Enviroment

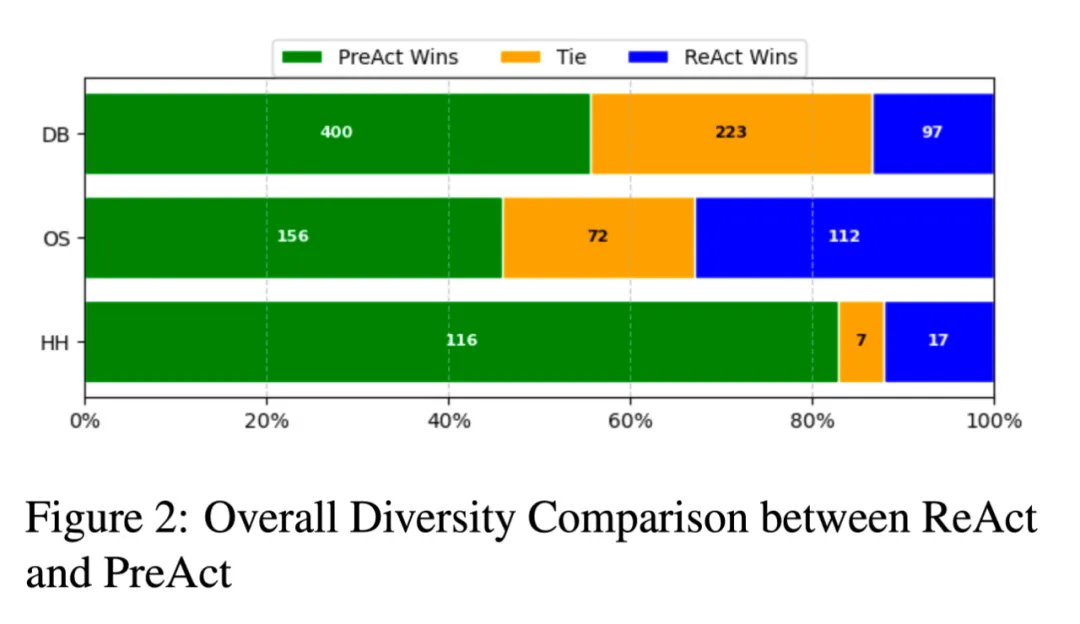

動作 和觀察結果 構成了 agent 與環境交互的過程。對于處于步驟 的代理, agent 將根據歷史信息 、上次觀察結果 及其行動策略 采取動作。

決定要采取的動作后,agent 將在環境中執行動作,并通過環境策略 獲得新的觀察結果。對于 LLM 代理來說,它只能控制 和 的構建。因此,LLM agent 的目標就是設計出高效的 和 。

2.1.2 ReAct

ReAct 是一項面向 LLM agent 的開創性工作,它結合了思考 、行動 和觀察 。ReAct 使用 作為 和一組 作為 。利用 LLM 的規劃能力,ReAct agent可以探索環境并逐步解決問題。

2.1.3 Reflexion

Reflexion 是一種長時記憶策略,用于提高 agent 中 的質量。以 ReAct 的 Reflexion 為例,如果任務失敗,LLM 會被要求進行反思,比如 。一旦進行了反思, 就會更新為 。這種策略可以提示 LLM 一些信息,幫助它避免一些決策錯誤。

2.2 PreAct

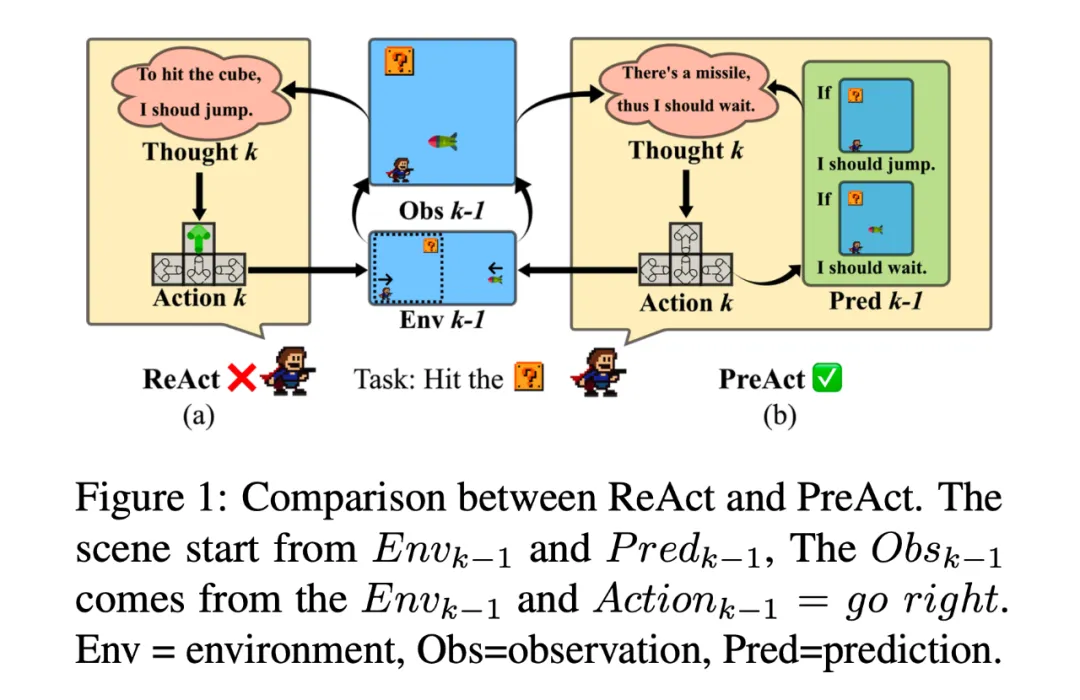

PreAct 的框架如圖 1 所示。它與 ReAct 有兩點不同:對于 部分,PreAct 會在每一步中要求 LLM 生成對未來觀察的預測和相應的應對措施 ,并根據預測觀察與實際觀測之間的差異提示 LLM 反思或改變其計劃方向。

通過這種提示,可以提高 LLM 所做計劃的多樣性和策略導向性。對于 部分,PreAct 會在其中添加對未來觀察的預測。雖然 PreAct 提高了 LLM 的思考和計劃能力,但還有兩個問題有待探究:

(1)PreAct 是否能與 Reflexion 結合使用并進一步提升效果?

(2)預測的效果是永久性的,還是只能影響下一輪?

基于這兩個問題,我們考慮了 3 種 模式:

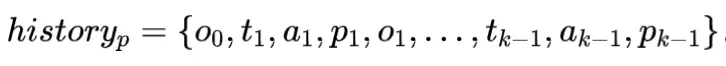

1. 永久模式:所有預測都將保留在永久歷史中,如:

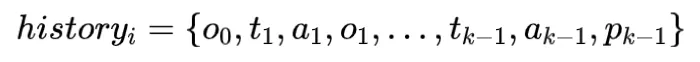

2. 即時模式: 只有最后一次預測會保留在即時歷史中,如:

3. 反思模式:反射和所有預測都將保留在歷史記錄中,如:

03 實驗

我們的實驗旨在解決以下研究問題(RQs)。

- 與 ReAct 相比,不同模式的 PreAct 在處理任務時是否表現得更好?

- PreAct 比 ReAct 能更好促進規劃的內在原因是什么?

- 歷史預測是否有助于持續提高規劃能力?

3.1 實驗設置

我們在 AgentBench 中的 HH、OS、DB 和 LTP4 4 個不同的子數據集上對 PreAct 進行了評估。我們使用 GPT3.5 和 GPT4 作為 agent 的 LLM。更多的實驗設置和所有提示詞都能在論文附錄中找到。

3.2 主要結果

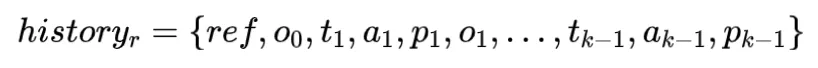

表 1 列出了 PreAct 和 ReAct 在 Permanent 和 Reflexion 兩種不同設置下,在四個數據集上的性能表現。

在 HH 任務中,PreAct 比 ReAct 提高了約 20%。在 OS 和 DB 任務中,在 Permanent 設置下,PreAct 的平均性能相比 ReAct 分別提高了 12% 和 6%,在 Reflexion 設置下,Preact的性能相比同樣采取了 Reflexion 的 React 分別提高了 5% 和 8%。在 LTP 情景下,PreAct 的結果與僅 Act 的結果類似,這可能是由于 GPT 的安全機制導致其多次拒答,從而減少了有效的探索步驟。

總的來說,在大多數情況下,PreAct 都優于 ReAct,在某些指標上甚至超過了帶 Reflexion 的 React。此外,在 PreAct 的基礎上應用 Reflexion 還能持續提升模型性能。這表明,先驗任務信息和觀察預測可以共同提高 LLM 的規劃和決策能力。

3.3 內在原因分析

根據我們的假設,PreAct 可增強推理的多樣性和策略方向性,從而提高 LLM 的規劃能力。在本節中,我們將研究這兩個促進因素。

3.2.1 多樣性

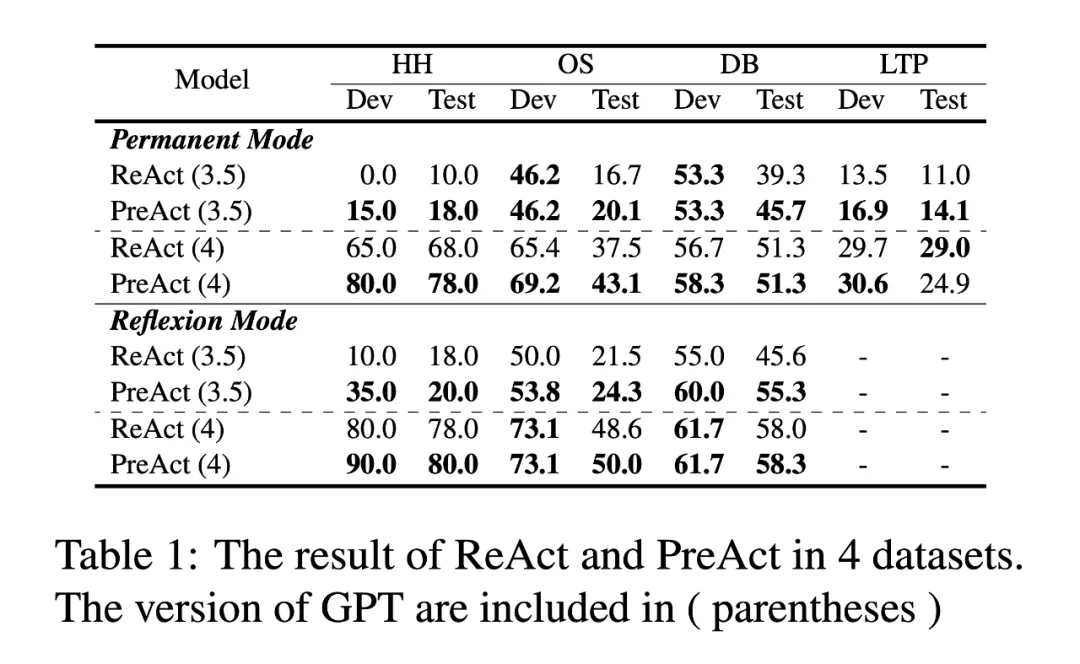

圖 2 展示了 PreAct 和 ReAct 在 HH、OS 和 DB 數據集上的多樣性比較。我們向 GPT-4 輸入了兩條包含思考和行動的軌跡,要求它在 0 到 100 的范圍內對每條軌跡打分。

圖表顯示,在任何給定的數據集上,至少有 45% 的實例顯示出 PreAct 的推理多樣性優于 ReAct,而相反的情況則不超過 34%。這表明,使用 PreAct 可以顯著提高推理多樣性,從而擴大推理空間,拓寬可能行動的范圍。

3.2.2 策略方向性

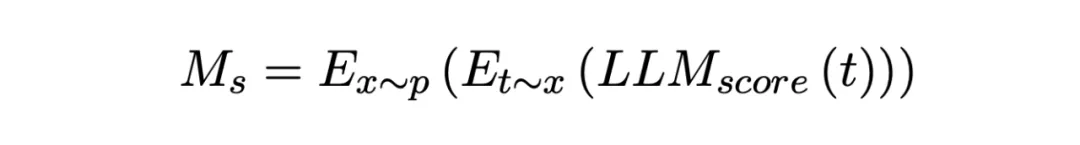

我們選擇 Alfworld 任務來分析策略方向性。對于每條軌跡的每一輪,我們都向模型提供 ground truth、截至本輪次的所有思考和行動,同時去除所有預測。然后,我們要求 GPT-4 對其策略方向性進行評分,分數范圍為-1 ~ 3。策略方向性的評價指標如下:

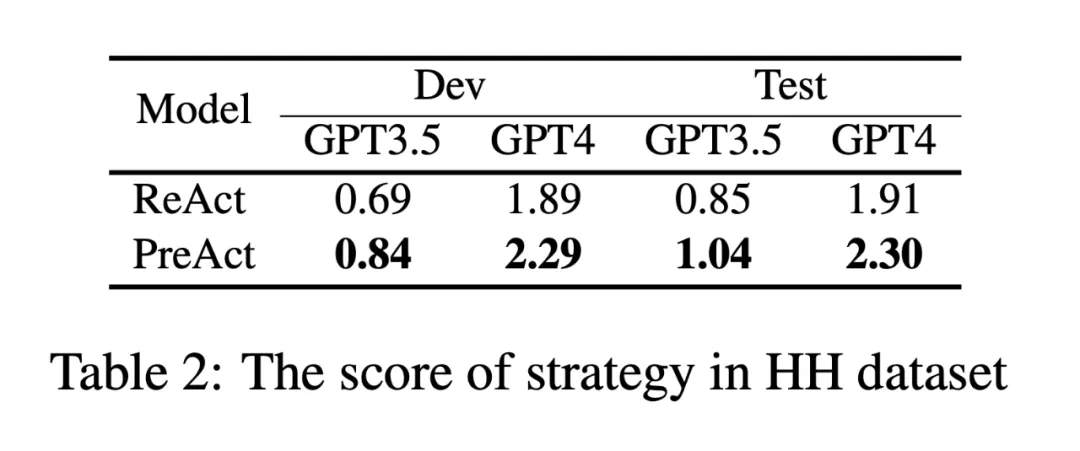

其中, 為樣本, 為一輪思考和行動, 為評分器。如表 2 所示,PreAct 的策略方向性得分比 ReAct 高出至少 20%。這表明 PreAct 在確定規劃方向方面更勝一籌。

3.2.3 相關性研究

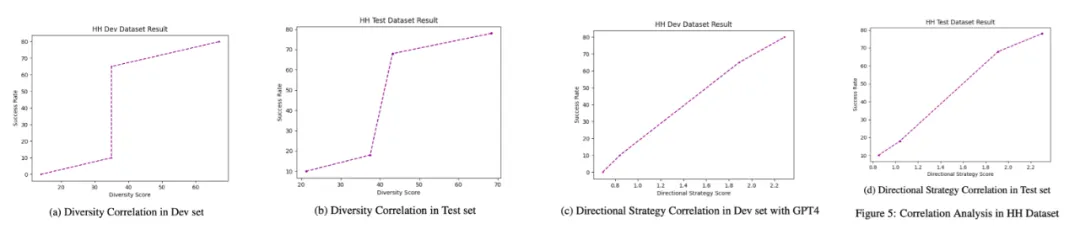

圖 5 顯示了在 HH 數據集上,多樣性、策略方向性和成功率之間的關系,揭示了成功率與這兩個指標之間的正相關關系。此外,策略方向性與成功率的相關系數分別為 99.8%(Dev)和 99.3%(Test),而多樣性與成功率的相關系數分別為 83.7%(Dev)和 91.2%(Test)。

3.2.4 案例分析

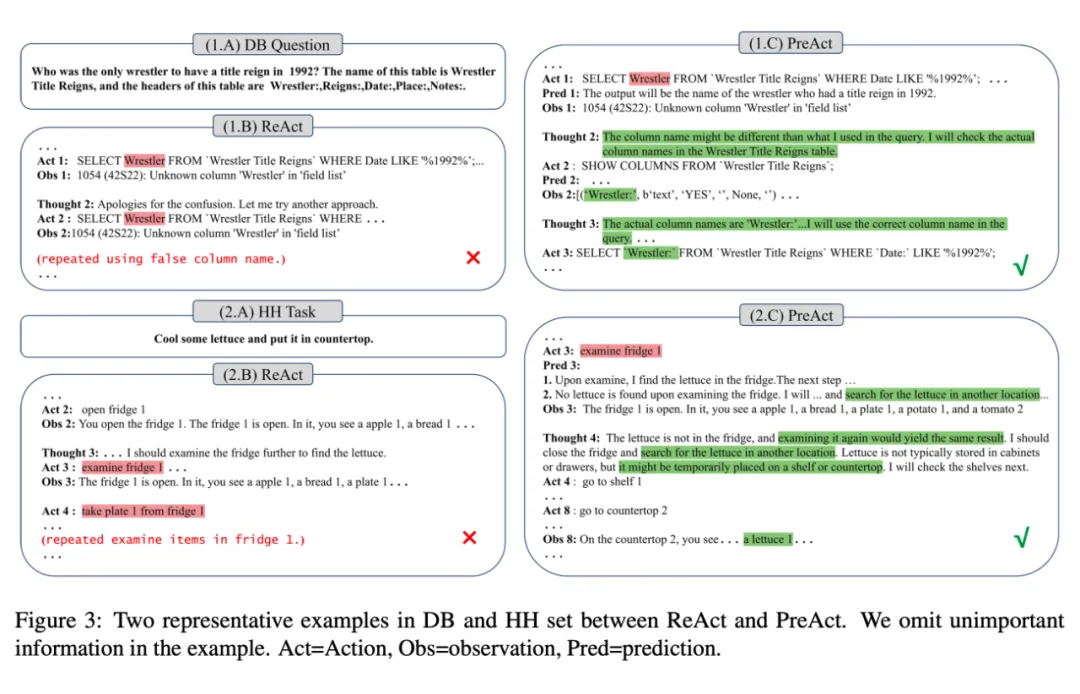

圖 3 顯示了 PreAct 和 ReAct 在 DB 和 HH 數據集上的部分軌跡。雖然 PreAct 和 ReAct 在這兩個數據集的初始執行階段都出現了錯誤,但 PreAct 可以借助預測糾正錯誤,而 ReAct 則不能。

在 DB 數據集中,ReAct 和 PreAct 在第一輪中都使用了相同的錯誤列名。PreAct 通過驗證實際列名糾正了這一錯誤,而 ReAct 則反復使用了錯誤的列名。Pre Act 對查詢和更正列名的考慮反映了其推理的多樣性。

在 HH 任務中,ReAct 檢查完冰箱后,與冰箱內的物體進行了互動,這與任務無關,而 PreAct 則預測到了 "冰箱內沒有生菜 "的條件,并根據 Pred 3 中的預測結果,指導其在其他地方找到生菜,最終完成了任務。這種重新考量生菜的可能位置而不是繼續在冰箱附近尋找的決定表明,PreAct 具有更好的策略方向性。

3.2.5 歷史預測影響范圍

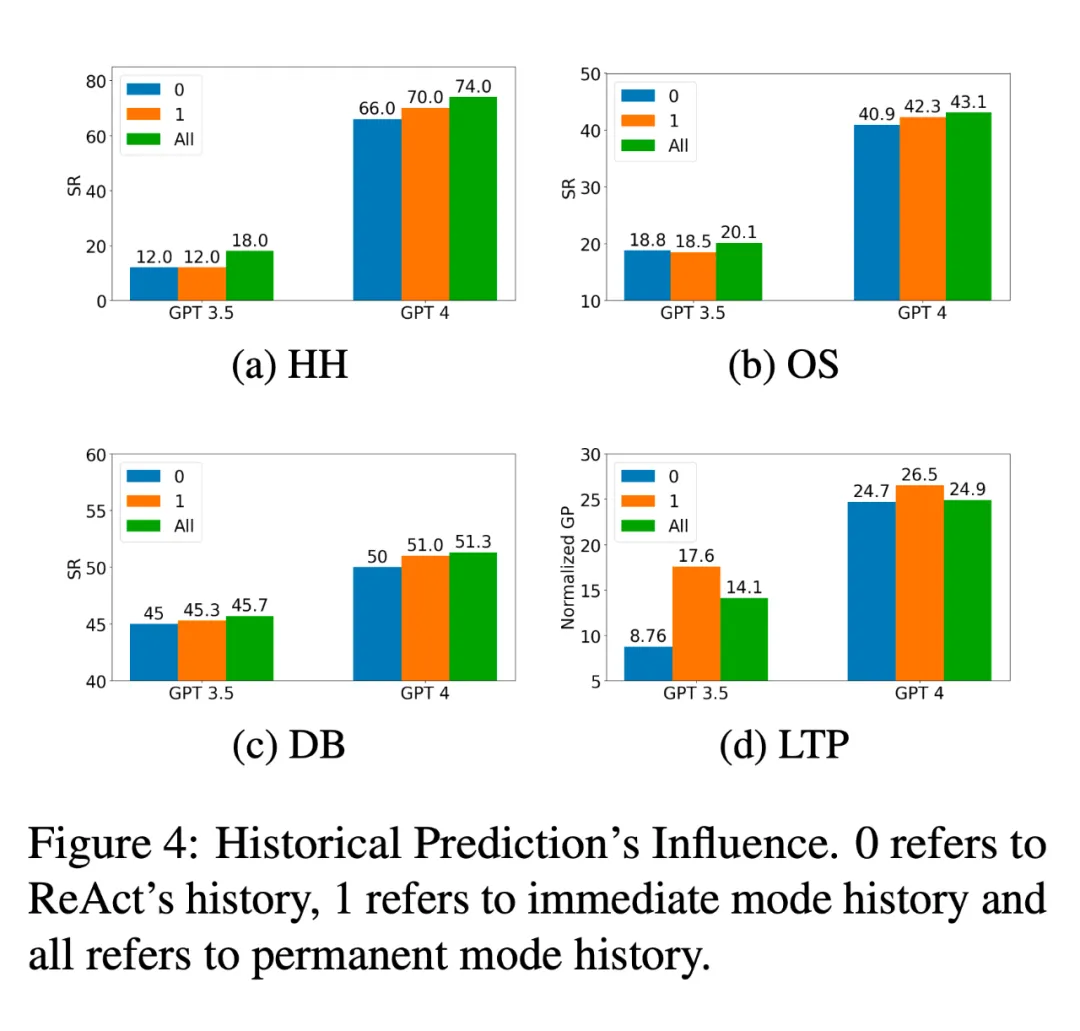

圖 4 展示了不同數量的預測歷史對 LLM 推理性能的影響。在 HH、OS 和 DB 數據集上進行的實驗表明,增加預測歷史的保留量可以提高成功率。

以 PreAct(GPT4)為例,3 種設置下任務的成功率在 HH 中分別為 66%、70%、74%;在 OS 中分別為 40.9%、42.3%、43.1%;在 DB 中分別為 50%、51%、51.3%。這些發現表明,歷史預測對模型的推理能力有持續的正向影響。然而,在 LTP 數據集上,更多的歷史數據會導致更高的拒答概率,進而導致永久模式下的 Preact 性能下降。

04 結論

本文中,我們介紹了一個簡單卻有效的 agent 推理框架——PreAct,它利用預測來增強規劃的多樣性和策略方向性,從而提高 agent 完成任務的能力。這種增強是持續性的,它獨立于 Reflexion,并將隨著歷史預測的積累而不斷提高。基于 PreAct 的研究結果,我們提出了兩個評估規劃的指標,這可能有助于在未來的工作中為強化學習設置過程級的獎勵函數,以訓練出更強大的 agent。

本文轉自 PaperWeekly ,作者:黃健釗、傅大源