o1的規劃能力如何?LRM是未來嗎?

嘿,大家好!這里是一個專注于AI智能體的頻道~

今天給大家分享一個新研究,前頂會AAAI主席Subbarao Kambhampati發布的論文。

能夠規劃一系列行動以實現預期目標,長期以來被認為是智能體的核心能力之一,并自人工智能研究之初便成為其不可或缺的一部分。隨著大型語言模型(LLMs)的出現,關于它們是否具備這種規劃能力的問題引起了廣泛關注。我們于2022年開發的可擴展基準測試PlanBench,緊隨GPT-3的發布推出,至今仍是評估LLMs規劃能力的重要工具。盡管自GPT-3以來涌現了大量新的私有和開源LLMs,但在該基準測試上的進展卻出奇地緩慢。OpenAI聲稱,他們最近推出的o1(草莓)模型是專門構建和訓練的,旨在突破自回歸LLMs的常規限制,使其成為一種新型模型:大型推理模型(LRM)。本文以這一發展為契機,全面考察了當前LLMs和新LRMs在PlanBench上的表現。正如我們將看到的,盡管o1在該基準測試中的表現實現了量級上的飛躍,遠超競爭對手,但距離完全占據這一基準還有相當距離。這一進步也引發了關于準確性、效率和可靠性的討論,這些問題在部署此類系統前必須仔細考慮。

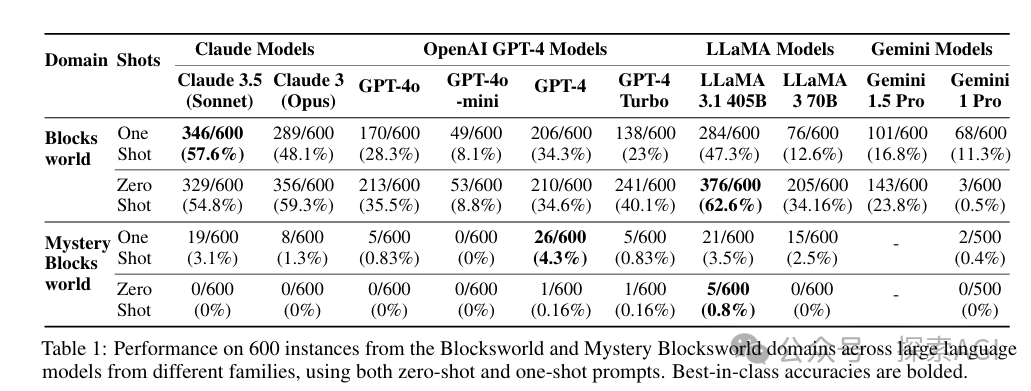

SOTA LLM模型在規劃能力方面仍然非常糟糕! 如下表:

- 在未混淆的數據集-Blocksworld中,最好的LLMs(如LLaMA 3.1 405B)達到了62.6%的準確率。

在語義相同但句法混淆的數據集-Mystery Blocksworld中,所有LLMs的表現都遠遠落后,沒有一款模型的準確率超過5%。

OpenAI的o1模型:是為了突破傳統自回歸LLMs的限制而設計和訓練的,屬于LRMs的一種。特點:

- 結合了基礎LLM(可能是修改版的GPT-4)。

- 通過RL訓練系統來指導推理過程,生成、篩選和選擇私有推理路徑。

- 在預訓練階段和推理時可能使用了新的自適應推理過程。

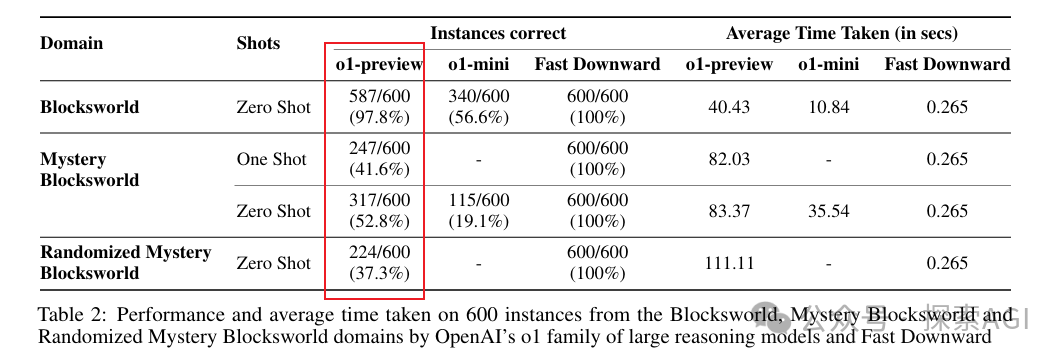

o1評測

- 在PlanBenc上,o1模型在Blocksworld問題上的表現顯著優于之前所有LLMs,正確回答了97.8%的問題。

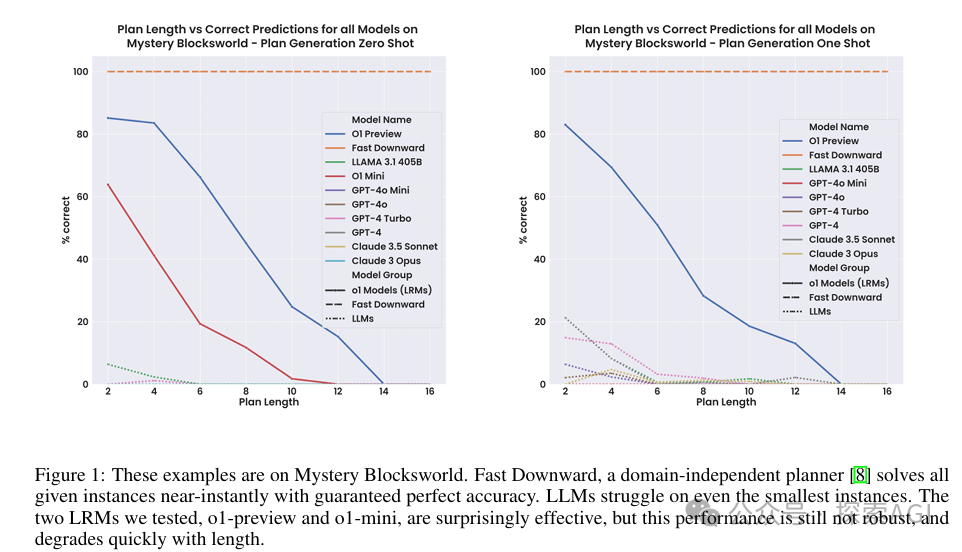

然而,在Mystery Blocksworld問題上,o1的表現雖然超過所有先前的模型,但準確率也只有52.8%。

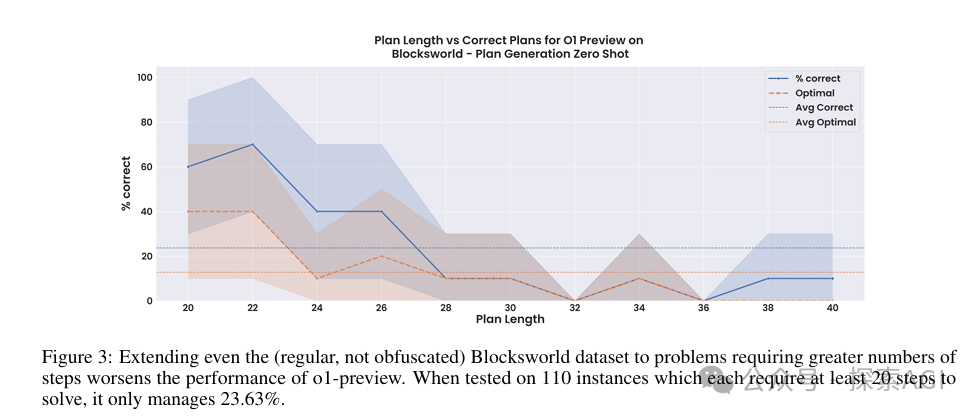

當處理更復雜問題時

o1模型的性能迅速下降。例如,在需要20到40步解決的更大Blocksworld問題上,o1的準確率僅為23.63%。

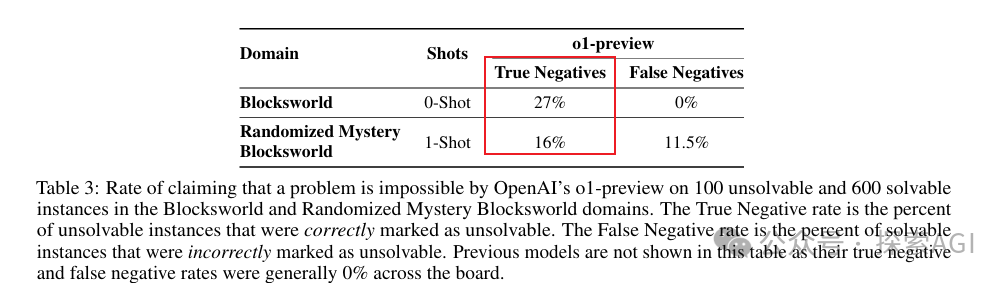

o1最厲害的一點,是宣稱能夠準確識別無法解決的問題,這是規劃能力的一個重要方面。但是,實驗結果顯示,在被修改為無法解決的Blocksworld問題上,o1正確識別不可解問題的比例并不高,為27%,并且有時會錯誤地聲稱可解問題為不可解。

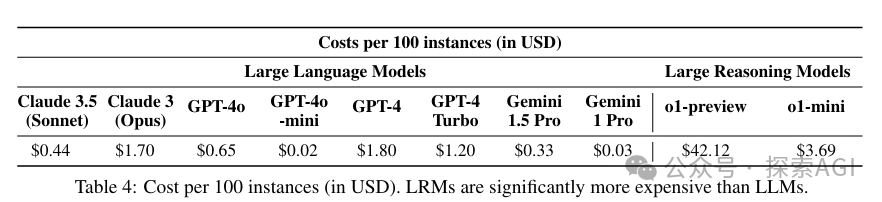

最后是平衡成本和效率

下表中,大型推理模型(LRMs)比大型語言模型(LLMs)的成本要高得多。

- o1模型的推理成本遠高于傳統LLMs,這可能會影響其在實際應用中的可行性。

- o1的推理過程缺乏透明度,用戶無法控制推理過程中生成的“推理token”數量,這增加了成本的不可預測性。

文末,作者提到,雖然我們的主要關注點是對o1在PlanBench上的表現進行量化評估,但我們也注意到一個值得提及的o1特性:當模型給出錯誤答案時,有時還會附帶一個富有創意但荒謬的理由,幾乎讓人覺得o1從“幻覺”進化到了“誤導”! 在一個案例中,模型認為一個不可解決的問題是可解決的,因為雖然目標條件沒有在最終狀態中出現,但在執行過程中某個時刻曾為真,因此它認為應該繼續算數。在另一個案例中,模型聲稱on(a,c)為真,因為它在簡短的括號說明中解釋道,a在b上,b在c上,因此a在某種程度上位于c的上方,應該算作“在它上面”。