蘋果開源視覺模型界的“瑞士軍刀”,能執行數十種任務

蘋果和瑞士洛桑聯邦理工學院的研究人員聯合開源了大規模多模態視覺模型——4M-21。

多數大模型通常針對特定任務或數據類型進行優化,這種專業化雖然能確保在特定領域的高性能,但也限制了模型的通用性和靈活性。

例如,開源模型Stable Difusion只能用于文生圖,即便是Gemini這種多模態模型,也只能生成和解讀圖片。

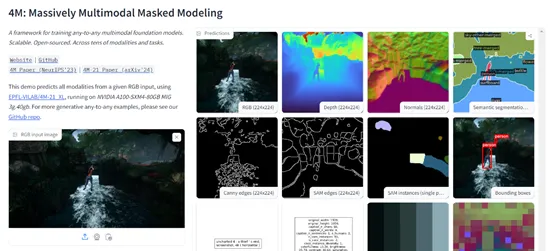

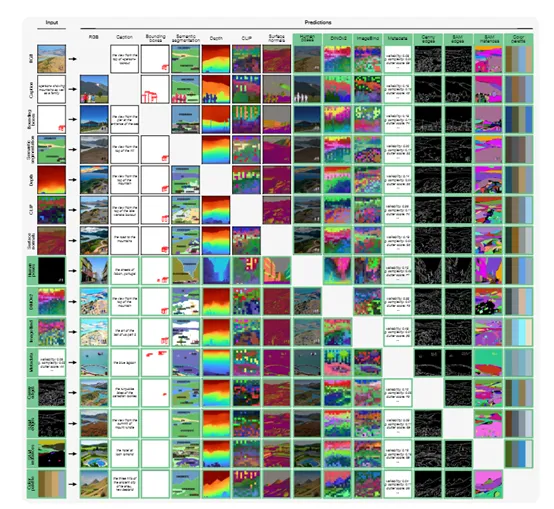

而4M-21只有30億參數,卻可以提供圖像分類、目標檢測、語義分割、實例分割、深度估計、表面法線估計等數十種功能,基本相當于視覺模型界的“瑞士軍刀”功能很全面。

開源地址:https://github.com/apple/ml-4m/

論文地址:https://arxiv.org/abs/2406.09406

在線demo:https://huggingface.co/spaces/EPFL-VILAB/4M

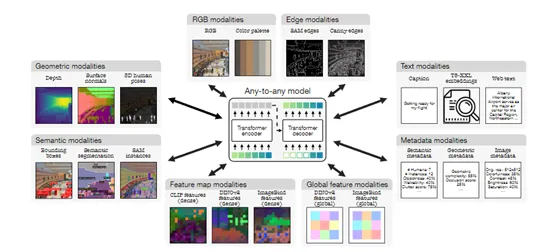

4M-21能提供如此多的功能,其關鍵核心技術是“離散tokens”轉換技術。簡單來說,就是將各種模態的數據轉換為統一格式的tokens序列數據。

無論是圖像類數據、神經網絡特征圖、向量、結構化數據(實例分割或人體姿態),還是以文本形式表示的數據,都可以轉換成模型可以理解的同一數據格式。

這不僅簡化了模型的訓練,還將原本形態各異的數據被映射到一個共享的、易于處理的表示空間,為多模態學習和處理奠定了基礎。

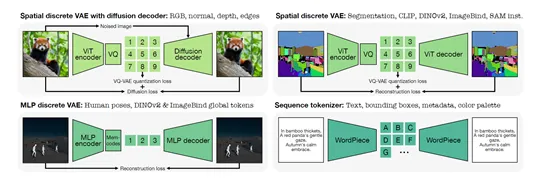

對于圖像類數據,例如,邊緣檢測圖或特征圖,研究人員使用了基于Vision Transformer的變分量化自編碼器進行標記化,生成一個固定大小的小網格tokens陣列。

對于那些需要高保真度重建的任務,例如,RGB圖像,會采用擴散解碼器來增強視覺細節的恢復。

而對于非空間模態,全局嵌入或參數化的人體姿態等,則利用Bottleneck MLP和Memcodes量化方法將其壓縮成少量的離散tokens。

至于文本、邊界框、顏色調色板或元數據等序列數據,則通過WordPiece分詞器編碼為文本tokens,利用共享的特殊tokens來標識它們的類型和值。

在訓練階段,4M-21通過掩碼建模的方法來完成多模態學習,會隨機遮蓋輸入序列中的部分tokens,然后基于剩余未遮蓋的tokens預測被遮蓋的部分。

這種方法迫使模型學習輸入數據的統計結構和潛在關系,從而捕捉到不同模態間的信息共通性和交互性。

此外,掩碼建模不僅提升了模型的泛化能力,還提升了生成任務的準確性,能夠以迭代的方式預測缺失的tokens。

無論是通過自回歸(逐個預測)還是逐步解碼(逐步揭示遮蓋部分)的方式。使得模型在解碼過程中能夠生成連貫的輸出序列,包括生成文本、圖像特征或其他模態的數據,從而支持多模態處理能力。

研究人員將4M-21在圖像分類、目標檢測、語義分割、實例分割、深度估計、表面法線估計以及3D人體姿態估計等測試平臺中進行了綜合評測。

結果顯示,4M-21的多模態處理能力可以媲美當前最先進的模型。例如,在COCO數據集上,在語義和實例分割任務上表現出色,準確識別和區分圖像中的多個對象;

在3DPW數據集上的3D人體姿態估計任務中也取得了顯著的成績,能夠精確捕捉人體的姿態變化。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區