僅需1分鐘,文本生成高質量3D模型—Meta 3D-Gen 精華

全球社交、科技巨頭Meta發布了全新文生3D模型——Meta 3D-Gen。

用戶通過Meta 3D-Gen僅需1分鐘就能生成人物、動物、道具、服飾、工業設計等不同類型的高質量3D模型。

Meta 3D-Gen不僅生成的內容是高分辨率的紋理和材質貼圖,還支持物理渲染光影效果非常好,適用于游戲開發、電影制作、虛擬現實、建筑設計等領域,幫助開發人員節省大量時間。

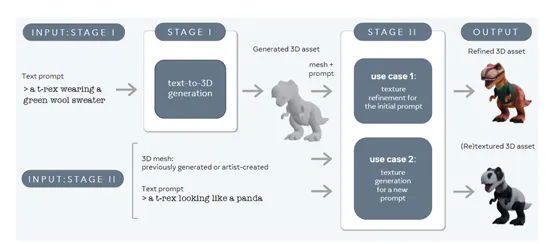

多視圖到3D重建

多視圖到3D重建是Meta 3D-Gen的兩大核心模塊之一,主要將用戶輸入的文本提示轉換為3D空間中的具體形態,包括形狀、結構、材質、紋理等。例如,“一只穿著綠色羊毛毛衣的暴龍”,需要根據文本中的綠色、毛衣、暴龍等元素解析出對應的建模。

首先,Meta使用了自研的一個多視圖和多通道版本的文本到圖像生成模型Emu,來生成一系列相對一致的物體視角圖像。該過程就像是通過不同角度拍攝同一物體的照片,為后續的3D模型重建提供了多視角的視覺信息。

Emu模型經過精心微調,使用了合成3D數據的渲染圖像,以便在視圖空間中進行多視圖生成,同時也在UV空間中進行生成,從而產生更優質的紋理。

然后,從這些多視角圖像中提取出3D物體的初步版本,將其轉換為體積空間中的表示。這是通過從多個角度的圖像中重建3D形狀的過程,類似于從多個快照中拼接出一個立體模型。

重建后的3D模型不僅包含了物體的形狀,還附帶了初步的紋理和物理渲染材質貼圖,這對于在真實世界中應用非常有幫助。

為了更精準地獲取3D形狀,Meta 3D-Gen還使用了基于有符號距離場的優化表示法,這是一種用于描述3D形狀的方法,可以計算出物體表面相對于某點的距離,對于保持形狀的細節和精確性非常有效,能夠在保證3D模型結構完整性和細節豐富性的同時,也確保了模型的拓撲質量。

3D紋理細化

在第一階段獲取精準的3D模型之后,就需要借助3D紋理生成進一步細化、增強3D模型效果。

紋理細化是基于初始的3D模型和用戶提供的文本描述,生成一系列物體的多視圖圖像。這些圖像不僅僅是簡單的渲染,還包含了物體的光照外觀以及其固有色,也就是在沒有外部光源影響下的物體基本顏色。

在優化的過程中,Meta 3D-Gen通過一個神經網絡可將多個視角下的信息進行融合,生成一個在視覺上連貫且一致的紋理。為了增強紋理的效果,Meta 3D-Gen還內置了優化增強神經網絡,輸入的視圖重新投影到紋理空間,生成2K、4K或更清晰的紋理細節。

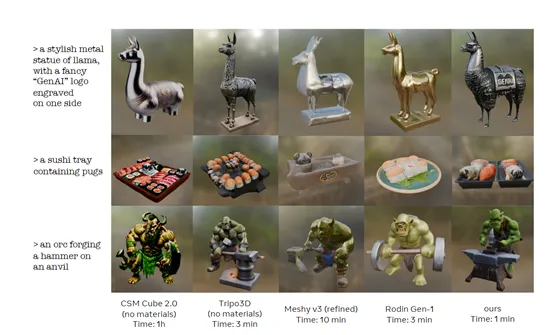

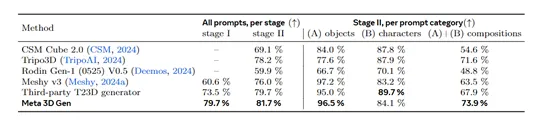

為了測試該模型的性能,研究人員將Meta 3D-Gen與CSM Cube 2.0、Tripo3D、Rodin Gen-1 V0.5和Meshy v3知名文本生成3D模型進行了綜合對比。

結果顯示,Meta 3D-Gen在文本語義還原、視覺質量和紋理、生成效率等關鍵評測指標上超越了這些模型。尤其是Meta 3D-Gen的生成效率非常高,比現有模型快3—60倍左右。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區