谷歌將大模型集成在實(shí)體機(jī)器人中,能看、聽、說執(zhí)行57種任務(wù)

谷歌DeepMind在社交平臺(tái)分享了最新研究,將大模型Gemini 1.5 Pro集成在實(shí)體機(jī)器人中,為其提供導(dǎo)航、推理等服務(wù)。

由于缺乏高級(jí)認(rèn)知、學(xué)習(xí)能力、語義理解以及數(shù)據(jù)存儲(chǔ)等,傳統(tǒng)機(jī)器人的“回憶能力”較差,無法提供更人性化的服務(wù)。而Gemini 1.5 Pro提供的100萬Tokens上下文長(zhǎng)度,可有效解決這些難題,通過語音對(duì)話的方式將能讓機(jī)器人執(zhí)行各種任務(wù)同時(shí)具備回憶的能力。

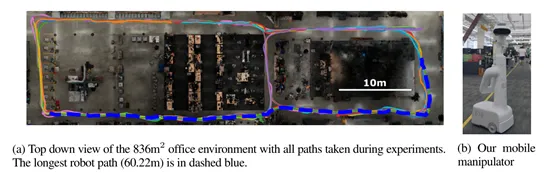

根據(jù)谷歌的測(cè)試結(jié)果顯示,在Gemini 1.5 Pro的幫助下,在836平方米的真實(shí)測(cè)試空間中,讓實(shí)體機(jī)器人執(zhí)行了57種四大類型的指令任務(wù),成功率平均在71%左右。

論文地址:https://arxiv.org/abs/2407.07775

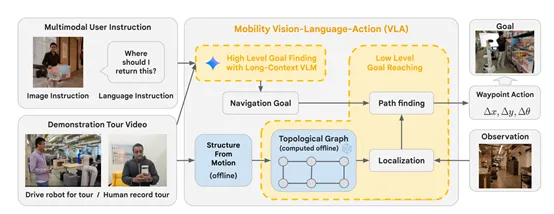

研究人員在Gemini 1.5 Pro的文本、圖像、音頻等能力基礎(chǔ)之上,開發(fā)了多模態(tài)視覺語言導(dǎo)航模型Mobility VLA。

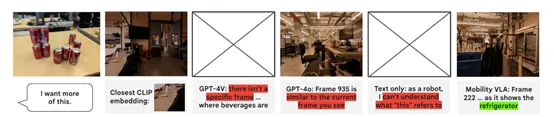

在Mobility VLA模型中,Gemini 1.5 Pro會(huì)被用來理解用戶的多模態(tài)指令。這些指令包括自然語言描述、圖像或者二者的結(jié)合,例如,當(dāng)用戶手持一個(gè)物品并詢問“我應(yīng)該把這個(gè)放在哪里?”時(shí),Gemini 1.5 Pro需要能夠理解這一指令的語義內(nèi)容,識(shí)別出用戶手中的物品。

在理解了用戶的語言指令后,接下來Gemini 1.5 Pro會(huì)在示范旅游視頻中定位與指令相關(guān)的目標(biāo)幀。

一些示范數(shù)據(jù)提供了環(huán)境的先驗(yàn)知識(shí),Gemini 1.5 Pro通過分析這些視頻,能夠識(shí)別出與用戶指令相匹配的場(chǎng)景,并深入分析和對(duì)用戶指令的精確匹配,確保機(jī)器人能夠準(zhǔn)確地導(dǎo)航到正確的位置。

在確定了目標(biāo)幀后,Gemini 1.5 Pro的輸出將被用作Mobility VLA低層策略的輸入。

低層策略主要負(fù)責(zé)生成實(shí)體機(jī)器人的實(shí)際各種動(dòng)作,包括前進(jìn)、后退或轉(zhuǎn)向。Gemini 1.5 Pro通過其長(zhǎng)上下文處理能力,能夠在整個(gè)視頻的背景下識(shí)別出最合適的目標(biāo)幀,并將這些信息傳遞給低層策略,從而幫助機(jī)器人生成精確的導(dǎo)航路徑。

此外,Gemini 1.5 Pro在Mobility VLA模型中的作用不僅限于理解用戶指令和定位目標(biāo)。憑借其超長(zhǎng)的上下文處理能力,還有助于提升導(dǎo)航的準(zhǔn)確性和魯棒性。

在復(fù)雜的真實(shí)環(huán)境中,機(jī)器人可能會(huì)遇到各種意外情況,例如,遭遇座椅等障礙物或?qū)崟r(shí)的環(huán)境變化。Gemini 1.5 Pro能夠通過其對(duì)環(huán)境的深度理解,幫助機(jī)器人快速適應(yīng)這些變化,對(duì)接下來的行動(dòng)指令做出準(zhǔn)確判斷,在面對(duì)復(fù)雜和動(dòng)態(tài)的環(huán)境時(shí),仍能保持高效的導(dǎo)航性能。

為了測(cè)試Mobility VLA在實(shí)體機(jī)器人的幫助能力,研究人員構(gòu)建了一個(gè)836平方米的真實(shí)空間,里面有架子、桌子、椅子等各種日常家具,還使用了無需推理、需要推理、多模態(tài)等多種類型指令進(jìn)行了綜合測(cè)試。

實(shí)驗(yàn)結(jié)果顯示,在無需推理的20個(gè)指令中,機(jī)器人的成功率達(dá)到了80%,顯示出其在處理直接且明確的導(dǎo)航任務(wù)時(shí)的高效性。

在需要推理的15個(gè)指令中,機(jī)器人也達(dá)到了80%的成功率,這證明了其在理解和處理復(fù)雜用戶指令方面擁有相當(dāng)出色的能力。

盡管在小物體類別都得12個(gè)指令中,成功率略有下降至40%,但這也在一定程度上反映了小物體識(shí)別的挑戰(zhàn)性。而在多模態(tài)的10個(gè)指令中,機(jī)器人的成功率再次提升至85%,顯示了其在整合視覺和語言信息方面的優(yōu)勢(shì)。

本文轉(zhuǎn)自 AIGC開放社區(qū) ,作者:AIGC開放社區(qū)