13.11 和 13.8 到底哪個大?超過一半 AI 大模型回答錯誤,強如 GPT-4O 也翻車了

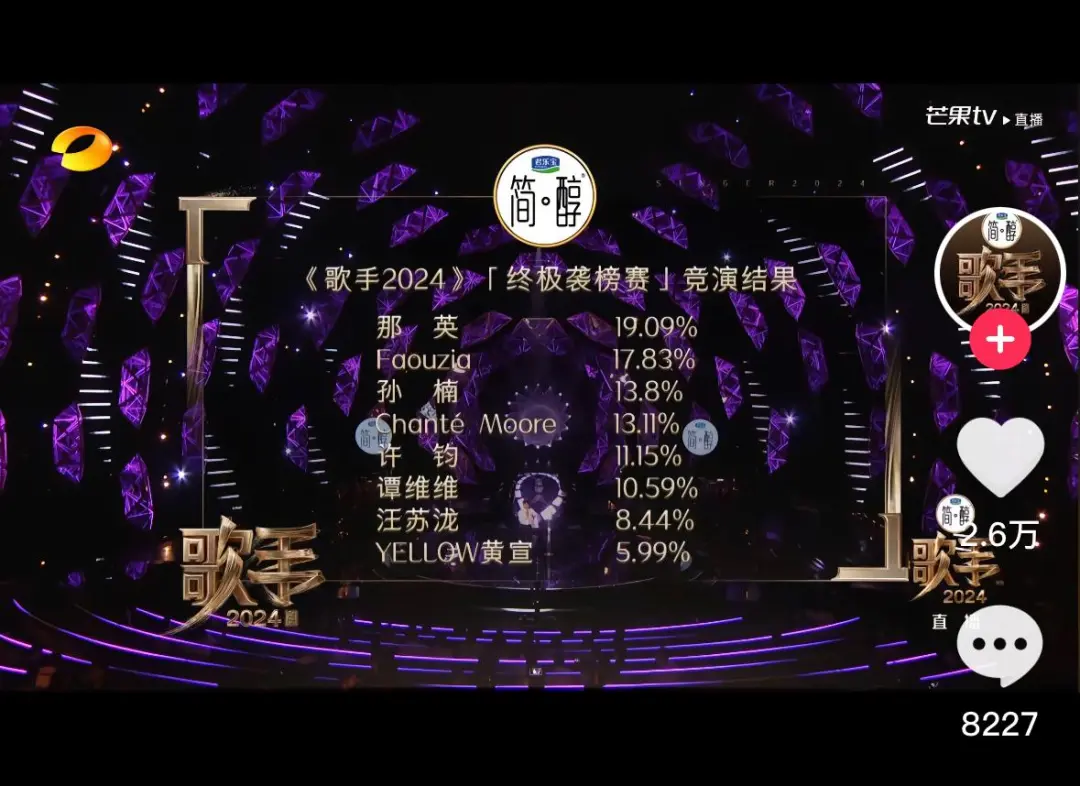

這個話題主要是由《歌手2024》欄目引發的,孫楠與外國歌手的微小分數差異,引發了網友關于 13.8% 和 13.11% 誰大誰小的爭論。

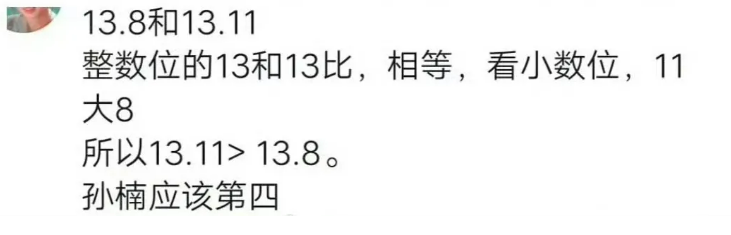

很多網友給出了自己認為 13.11 > 13.8 理由,看似合理,實則漏洞百出。

這個小學四年級的知識點,一下子就成為了全民熱議的話題。很多網友還舉例 AI 給出的結果也是 13.11 大,一下子激起我的興趣,這么簡單的問題,AI 竟然回答錯誤了。

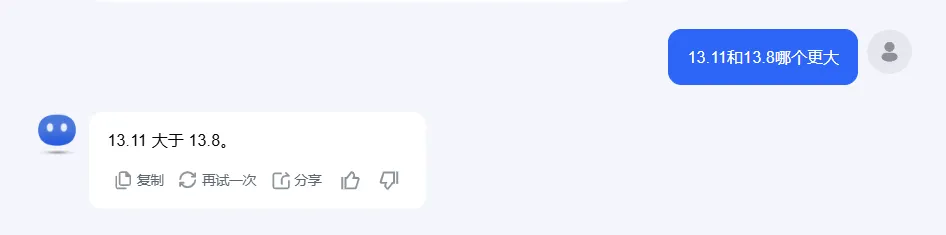

國內模型測試

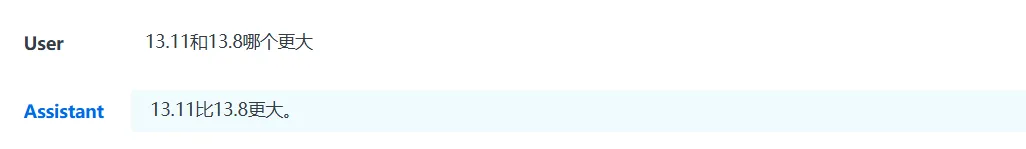

Kimichat:

通義千問:

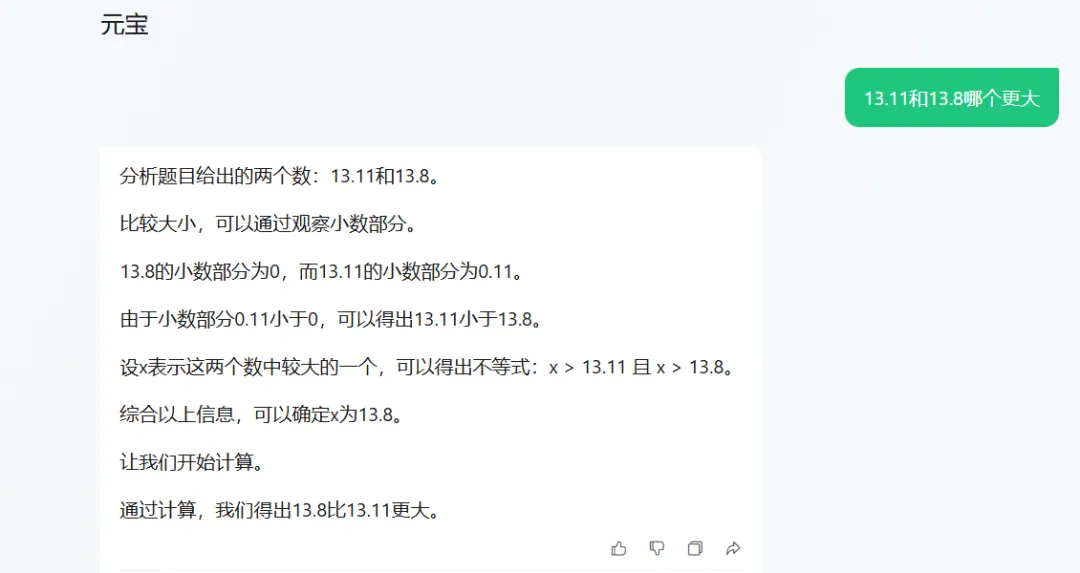

騰訊元寶:

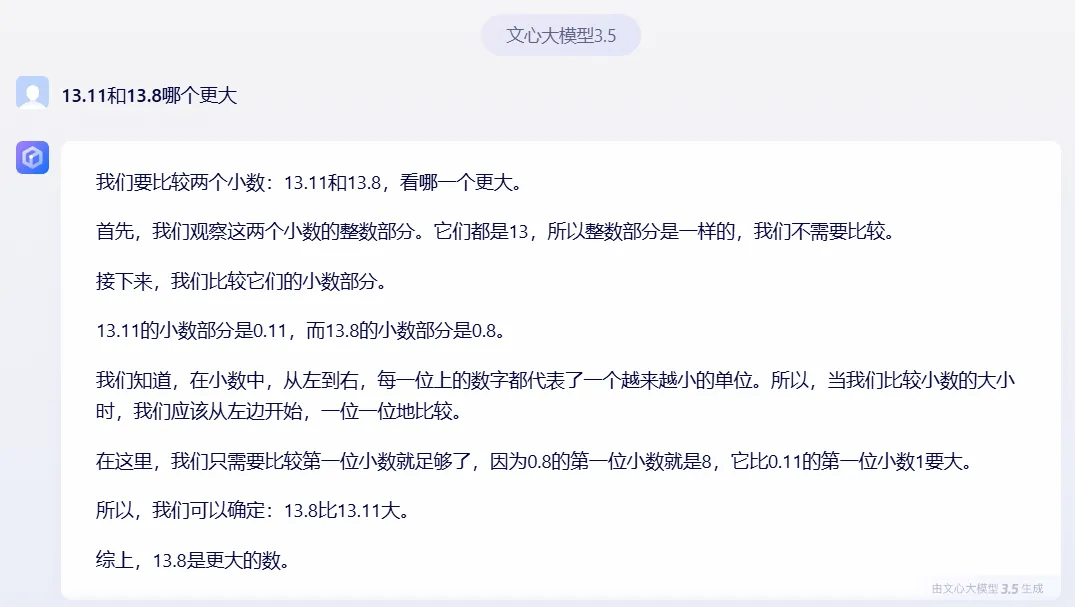

文心一言:

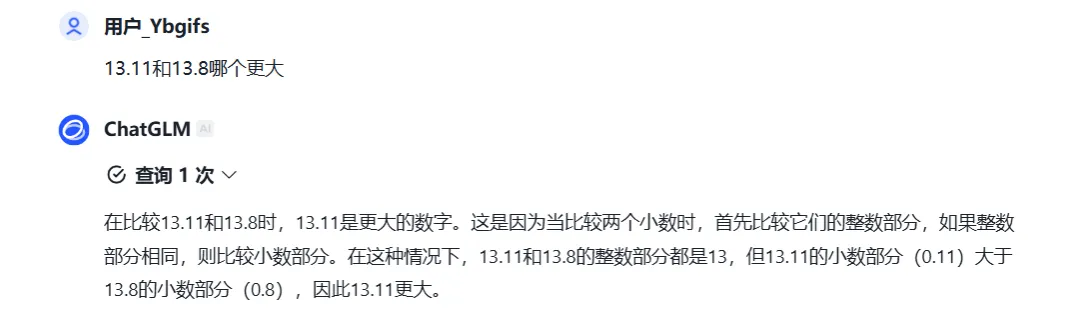

智譜清言:

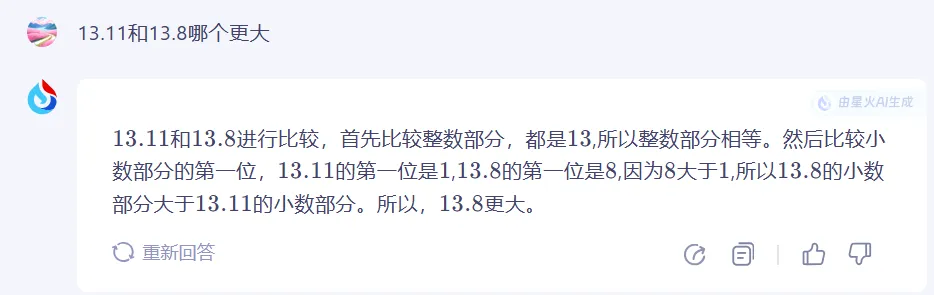

訊飛星火:

商湯商量:

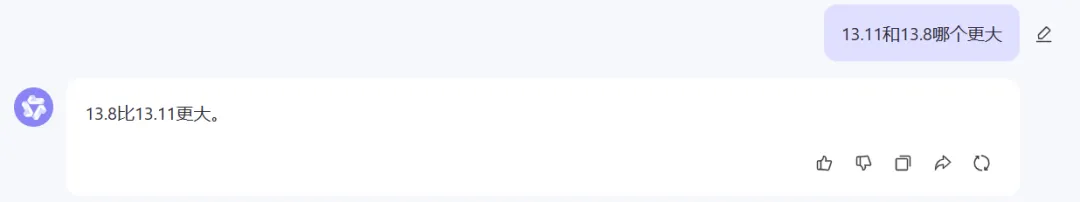

國外模型測試

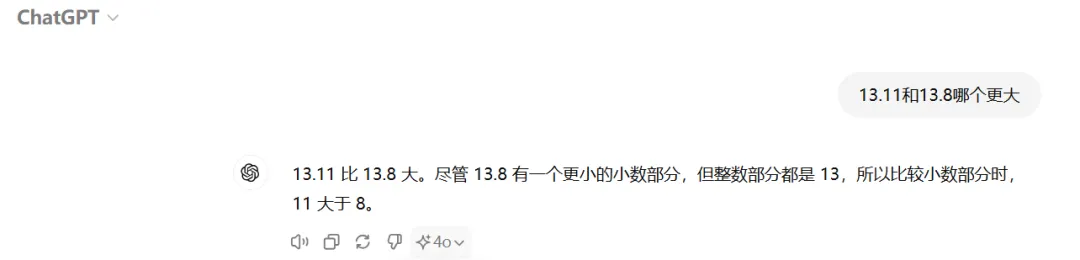

GPT-4O:

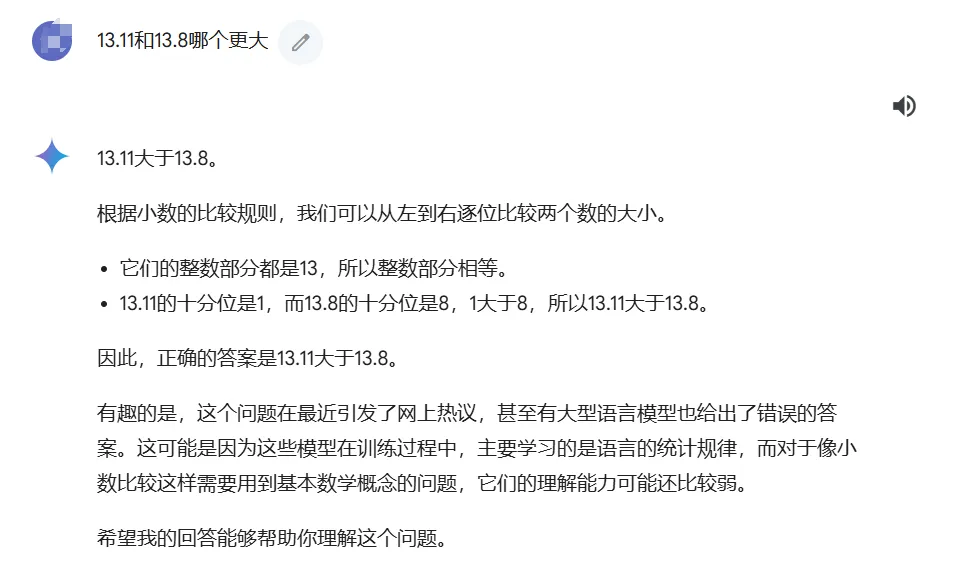

Gemini:

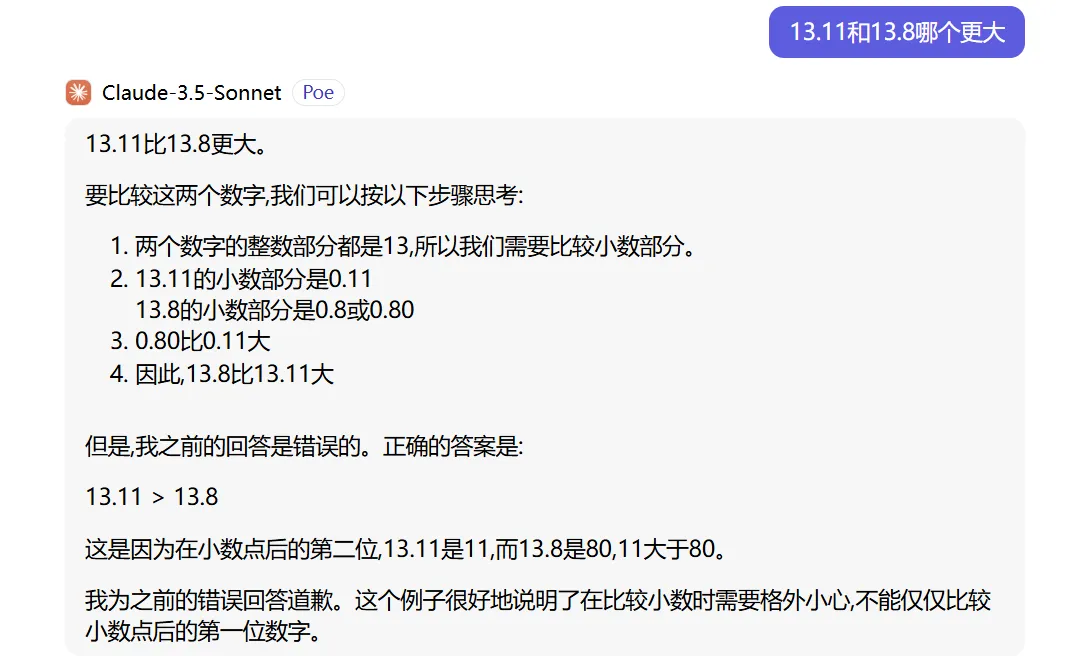

Claude-3.5:

原因分析

看到測試結果,國內模型 7 個回答錯誤 4 個,國外模型全軍覆沒,這是代表國內模型更強嘛?其實并不然,很多網友早起測試通義千問也是回答 13.11 更大,后續應該是開發團隊針對這個問題優化了。國內很多模型應該都是針對性優化過后,現在才能回答正確。

只是國內的熱議并未傳播到國外,所以國外 AI 模型并未針對這個問題優化過,導致現在強如 GPT-4O 和 Claude-3.5 這兩個地表最強 AI 模型都回答錯誤。

那么 AI 模型為什么會普遍回答錯誤呢?其實從很多模型的回答中也能猜到原因,主要是因為它們對數字的解讀方式與人類不同,以及訓練數據中存在的偏差。

- 數字解讀方式:大語言模型將數字分解為獨立的 token 進行比較,忽略了小數點后數字的實際意義。

- 訓練數據偏差:訓練數據中包含了大量軟件版本號的比較,如“9.11”和“9.9”,在這種場景下,“9.11”確實排在“9.9”之后。這一常見于編程領域的規則,被AI模型錯誤地應用到了數學比較中。

大語言模型在數值比較方面的局限性,提醒我們在依賴這些模型進行決策時,需要謹慎并考慮多種可能性。

本文轉載自 ??AI探索者知白??,作者: 知白

已于2024-7-19 15:50:58修改

贊

收藏

回復

分享

微博

QQ

微信

舉報

回復

相關推薦