最強(qiáng)大模型統(tǒng)計(jì)網(wǎng)站,從此告別LLM選擇恐懼癥! 原創(chuàng)

現(xiàn)在市面上的大模型越來(lái)越多,選擇多了也可能成為一種幸福的煩惱。

如何選擇一個(gè)好模型?

在機(jī)器學(xué)習(xí)中,通常會(huì)使用一些評(píng)估指標(biāo)來(lái)選擇模型,例如,用精度、召回率、F1等指標(biāo)來(lái)評(píng)估一個(gè)分類模型的性能;使用IOU,AUC等指標(biāo)評(píng)估目標(biāo)檢測(cè)和分割模型的性能。

同理,大模型也有評(píng)估指標(biāo)。

質(zhì)量:大模型的指令跟隨以及推理能力,例如,通用推理能力,或者具有某一方面的編碼、數(shù)學(xué)推理能力。

性能:大模型的反應(yīng)速度和記憶能力,例如,每秒輸入、輸出token數(shù)、上下文長(zhǎng)度。

價(jià)格:大模型API調(diào)用計(jì)費(fèi),例如,每1M tokens多少刀。

我們當(dāng)然希望能有一個(gè)模型各項(xiàng)指標(biāo)都第一,但這是不現(xiàn)實(shí)的,就像分布式系統(tǒng)中CAP三個(gè)屬性最多只能同時(shí)滿足兩個(gè)一樣,大模型的評(píng)估指標(biāo)之間,通常也存在相互制約關(guān)系,

例如,如果提升了上下文長(zhǎng)度,那必然會(huì)導(dǎo)致反應(yīng)延遲以及更多計(jì)算存儲(chǔ)資源的消耗。

例如,如果想讓其具備某一領(lǐng)域的特長(zhǎng),就可能會(huì)損失一定的通用推理能力。

例如,如果通過(guò)增加模型參數(shù)來(lái)增強(qiáng)模型推理能力,那么推理成本就會(huì)增加,就會(huì)上調(diào)API調(diào)用價(jià)格。

所以,在實(shí)踐中,最常見(jiàn)的做法將所有大模型都擺到明面上,通過(guò)量化指標(biāo)展示各自優(yōu)缺點(diǎn),然后讓用戶結(jié)合自己的需求來(lái)進(jìn)行選擇。

今天給大家介紹一個(gè)大模型統(tǒng)計(jì)網(wǎng)站。

??https://artificialanalysis.ai/??

它通過(guò)可視化方法將市面上常見(jiàn)的大模型的性能指標(biāo)進(jìn)行了量化分析、統(tǒng)籌比較。

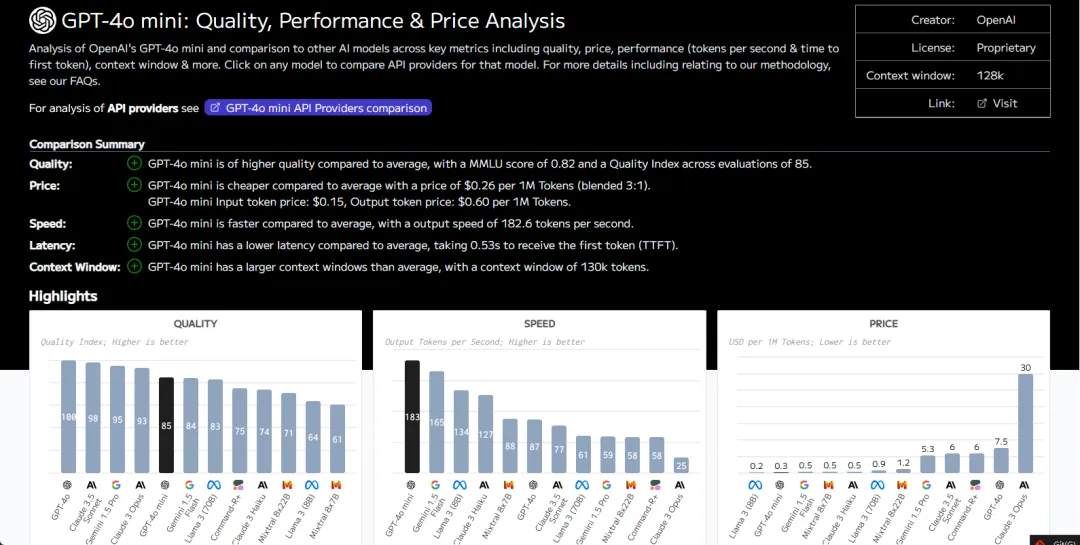

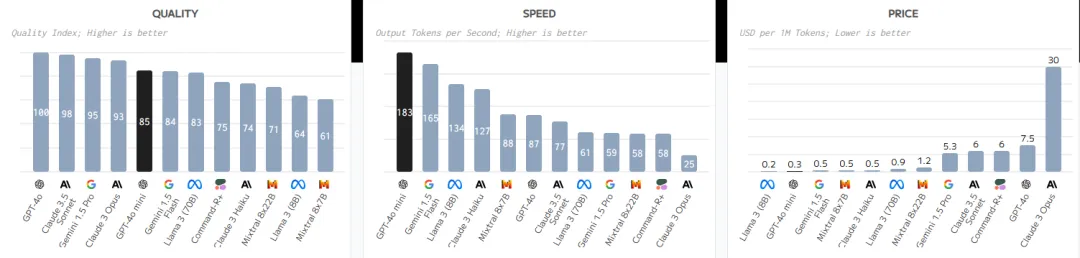

例如,昨天OpenAI進(jìn)行了產(chǎn)品升級(jí),GPT3.5成為歷史,取而代之的是GPT-4o mini,官方數(shù)據(jù)顯示GPT-4o mini具有超快的響應(yīng)速度,同時(shí)兼顧推理能力和極低的API調(diào)用成本。

接下來(lái),通過(guò)該網(wǎng)站的統(tǒng)計(jì)數(shù)據(jù)看看是不是這么回事。

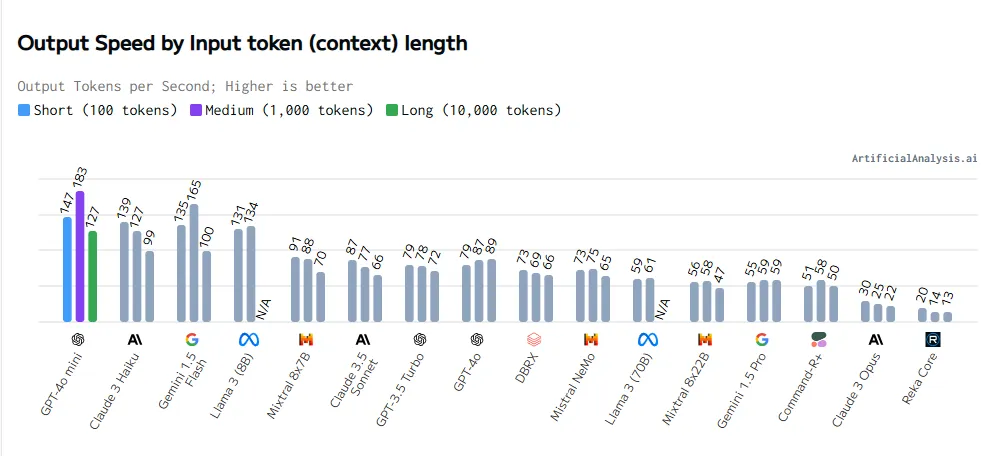

通過(guò)數(shù)據(jù)可見(jiàn),其推理速度第一,API計(jì)費(fèi)僅次于開(kāi)源的llama 3,更重要的是并沒(méi)有因此犧牲太多的推理能力。

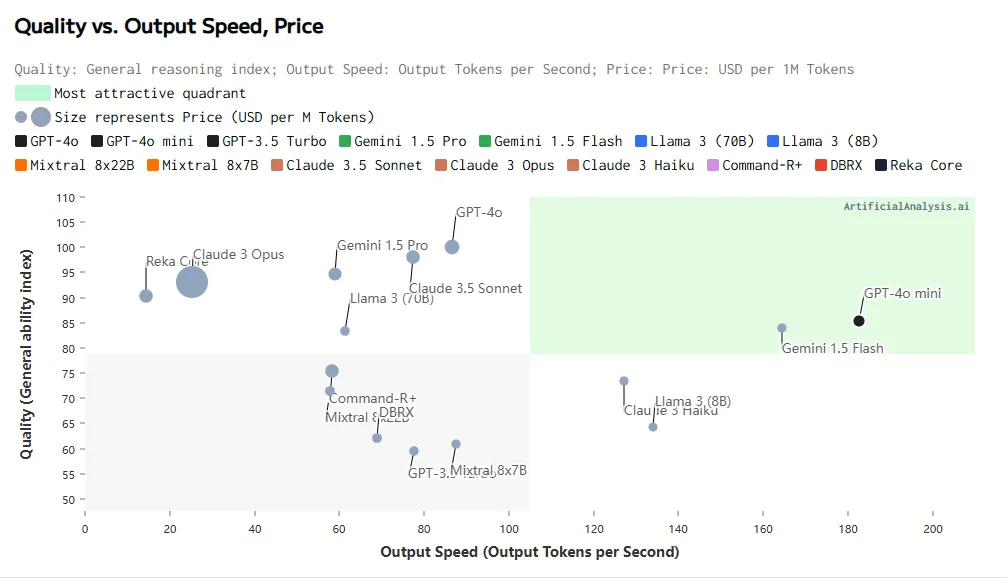

如果想兼顧模型質(zhì)量、推理速度和價(jià)格,就要將所有模型放到同一個(gè)坐標(biāo)系下,坐標(biāo)系下橫軸是推理速度,縱軸是模型質(zhì)量,點(diǎn)的大小代表價(jià)格。最理想的當(dāng)然是靠近右上角且小點(diǎn)的模型。

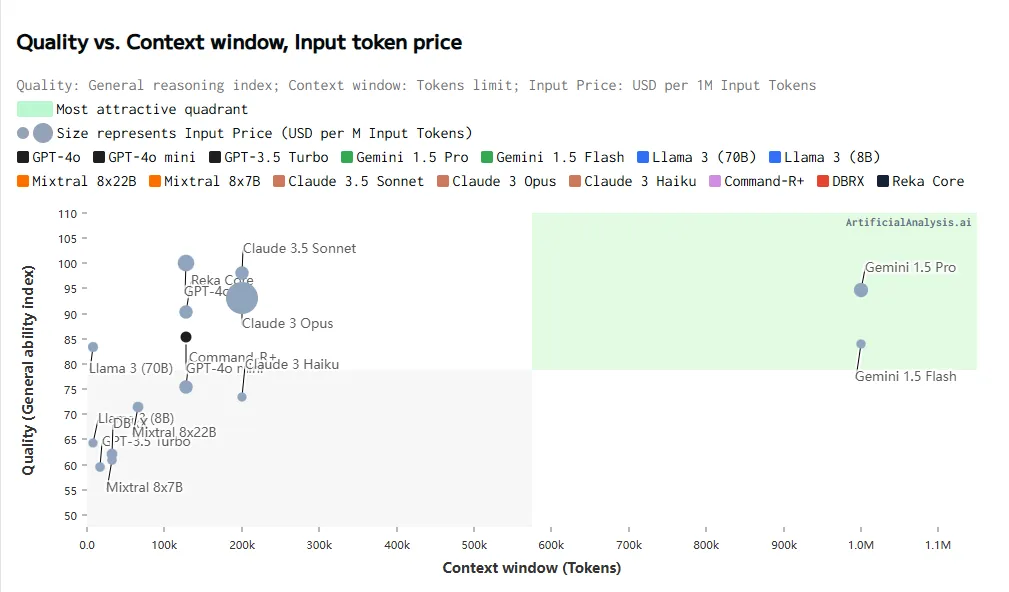

兼顧模型質(zhì)量、上下文長(zhǎng)度和價(jià)格。

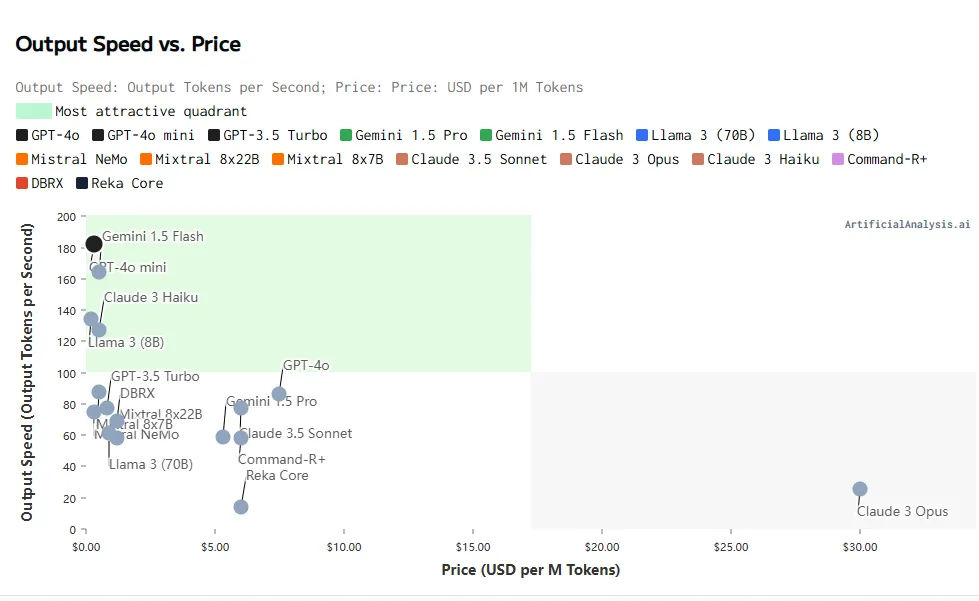

兼顧推理速度和價(jià)格,越靠近左上角的模型質(zhì)量越好。

不同大小輸入token下的輸出速度對(duì)比。

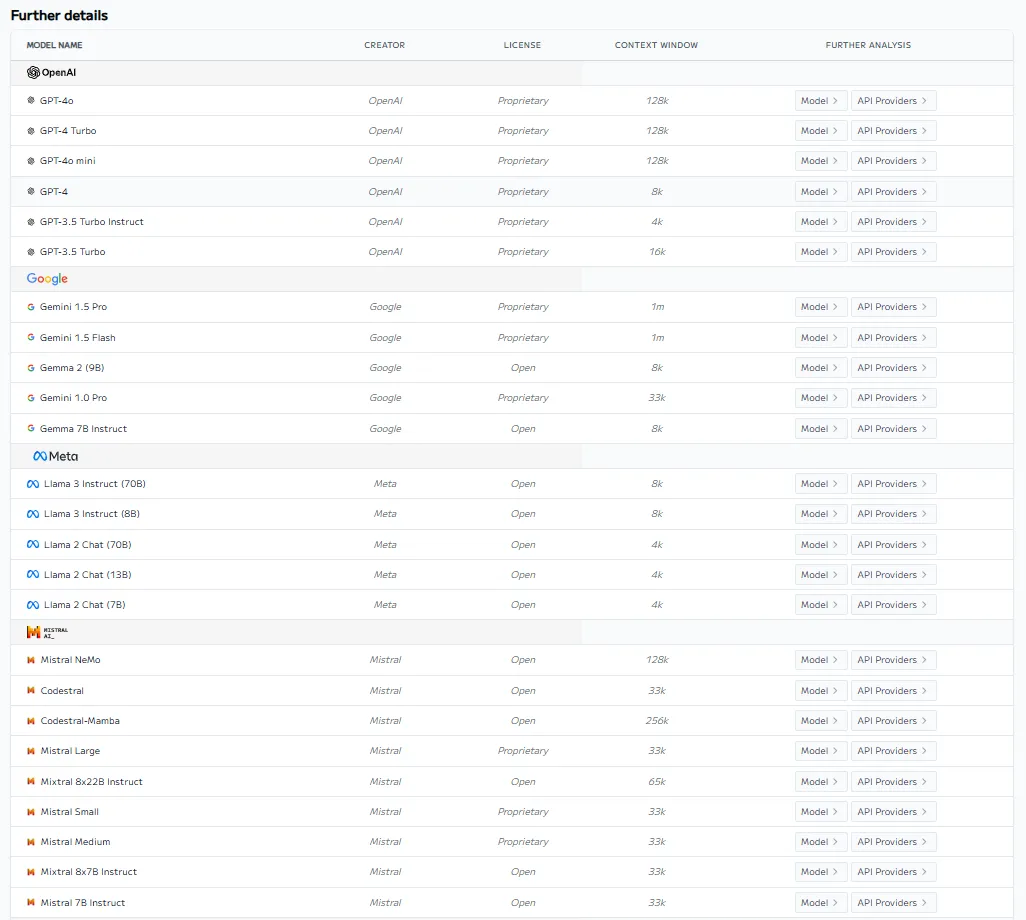

該網(wǎng)站還對(duì)不同組織旗下的大模型進(jìn)行了匯總。

除了大語(yǔ)言模型,該網(wǎng)站還包括文本轉(zhuǎn)語(yǔ)音、語(yǔ)音轉(zhuǎn)文本、文生圖等大模型的統(tǒng)計(jì)數(shù)據(jù)。

本文轉(zhuǎn)載自公眾號(hào)人工智能大講堂

原文鏈接:???https://mp.weixin.qq.com/s/ELDZEIKDekfe-FETbqNP3w???