英偉達(dá)最強(qiáng)勁敵Groq一招絕殺GPU,反超GPT-4o mini2倍,AI大佬Karpathy:直接飛升AGI! 原創(chuàng)

出品 | 51CTO技術(shù)棧(微信號(hào):blog51cto)

Llama 3.1 405B被吐槽太笨重?

英偉達(dá)對(duì)手AI新星Groq一招絕殺:上LPU直接速度翻倍,直接讓Llama 3.1飛升AGI!

Meta 最新發(fā)布的 Llama 3.1 405B 的開(kāi)源讓AI圈不平靜了!

追捧者感慨"GPT-4o的能力已握在手中”,而批評(píng)者反駁說(shuō),大體量消耗這么多算力,有些結(jié)果跑得還不如GPT-4o mini,太失望了!

不過(guò), Meta與英偉達(dá)勁敵Groq 的聯(lián)手直接讓速度問(wèn)題從此消失了!

Groq 利用自己的超級(jí)速度向社區(qū)提供最新的 Llama 3.1 模型,包括 405B Instruct、70B Instruct 和 8B Instruct。

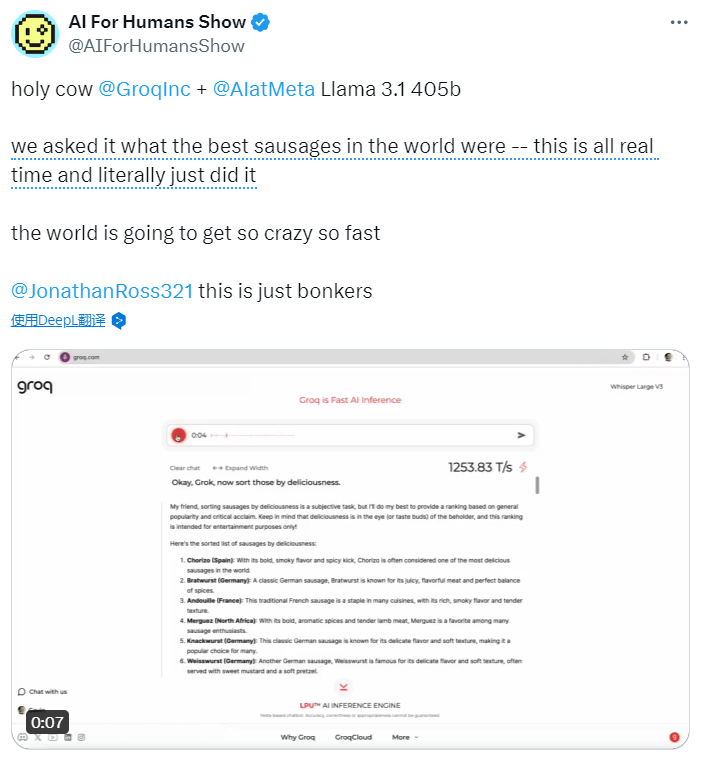

網(wǎng)友試完后驚訝地說(shuō):我的天啊,@GroqInc + @AIatMeta Llama 3.1 405b,我們問(wèn)出的問(wèn)題獲得了實(shí)時(shí)的答案,真的做到了!!!

圖片

圖片

看了這個(gè)視頻展示,不得不感嘆Groq + Llama 3.1的速度太猛了!

小扎對(duì)這場(chǎng)令人驚嘆的合作表示,“真的很高興看到 Groq 為 Llama 3.1 模型的云部署提供超低延遲推理......通過(guò)向社區(qū)提供我們的模型和工具,Groq 這樣的公司可以在我們的工作基礎(chǔ)上再接再厲,幫助推動(dòng)整個(gè)生態(tài)系統(tǒng)向前發(fā)展"。

Groq首席執(zhí)行官喬納森-羅斯(Jonathan Ross)說(shuō):"Meta正在為人工智能開(kāi)發(fā)一個(gè)類(lèi)似于Linux的開(kāi)放操作系統(tǒng)——不僅僅是為提供快速人工智能推理的Groq LPU,而是為整個(gè)生態(tài)系統(tǒng)。”

他補(bǔ)充說(shuō),Meta已經(jīng)趕上了領(lǐng)先的專(zhuān)有模型,超越閉源模型只是時(shí)間問(wèn)題。

前OpenAI研究員、AI大佬Andrej Karpathy稱(chēng)贊Groq的推理速度說(shuō):"這太酷了。這感覺(jué)就像 AGI——你只需與電腦對(duì)話,它就能立即完成任務(wù)。

圖片

圖片

在過(guò)去的幾個(gè)月里,Groq 以其比競(jìng)爭(zhēng)對(duì)手更快、更經(jīng)濟(jì)高效地執(zhí)行人工智能任務(wù)的承諾而備受關(guān)注。這要?dú)w功于它的語(yǔ)言處理單元(LPU),由于其線性操作,在執(zhí)行這些任務(wù)時(shí)比 GPU 更有效率。雖然 GPU 對(duì)模型訓(xùn)練至關(guān)重要,但部署中的人工智能應(yīng)用(稱(chēng)為 "推理")需要更高的效率和更低的延遲。

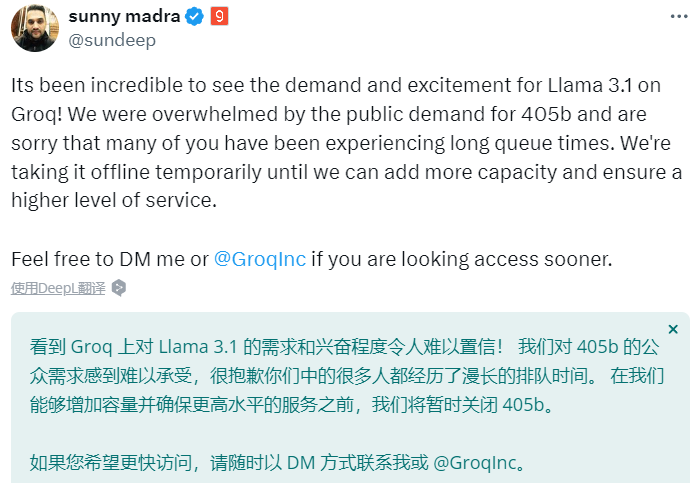

由于試玩者的熱情涌入,GroqCloud 負(fù)責(zé)人Sunny Madra在X上宣布Llama 3.1 405b體驗(yàn)暫時(shí)關(guān)閉了。

他寫(xiě)道,看到 Groq 上對(duì) Llama 3.1 的需求和興奮程度令人難以置信!我們被公眾對(duì) 405b 的需求所淹沒(méi),很抱歉你們中的許多人經(jīng)歷了漫長(zhǎng)的排隊(duì)時(shí)間。我們將暫時(shí)關(guān)閉405b,直到我們能夠增加容量并確保增加容量并提供更高水平的服務(wù)。

圖片

圖片

1.速度稱(chēng)王:Groq+ Llama 3-70B是GPT-4o mini兩倍快

"Groq的速度快得驚人,目前每秒可處理1200多個(gè)令牌。”

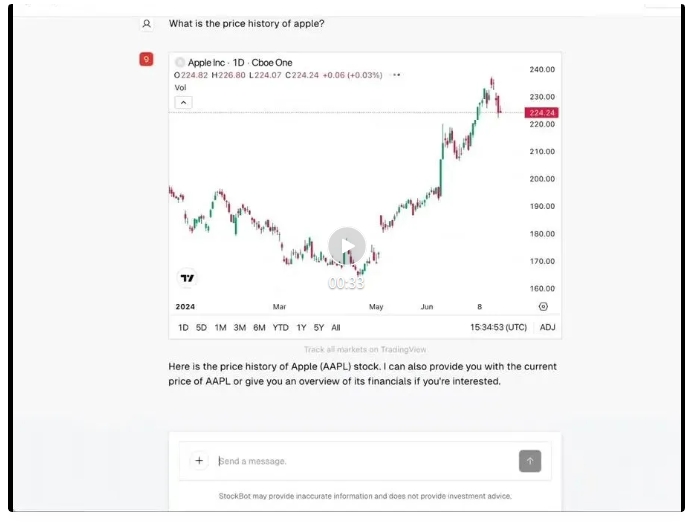

Groq甚至開(kāi)源了一款快如閃電的炒股機(jī)器人。

Groq的人工智能應(yīng)用工程師 Benjamin Klieger 介紹說(shuō):"StockBot——一個(gè)由 Groq 上的 Llama 3-70B 支持的快如閃電的開(kāi)源人工智能聊天機(jī)器人,可提供實(shí)時(shí)股票圖表、財(cái)務(wù)信息、新聞和篩選器。

圖片

圖片

StockBot運(yùn)行起來(lái)的速度是這樣的:

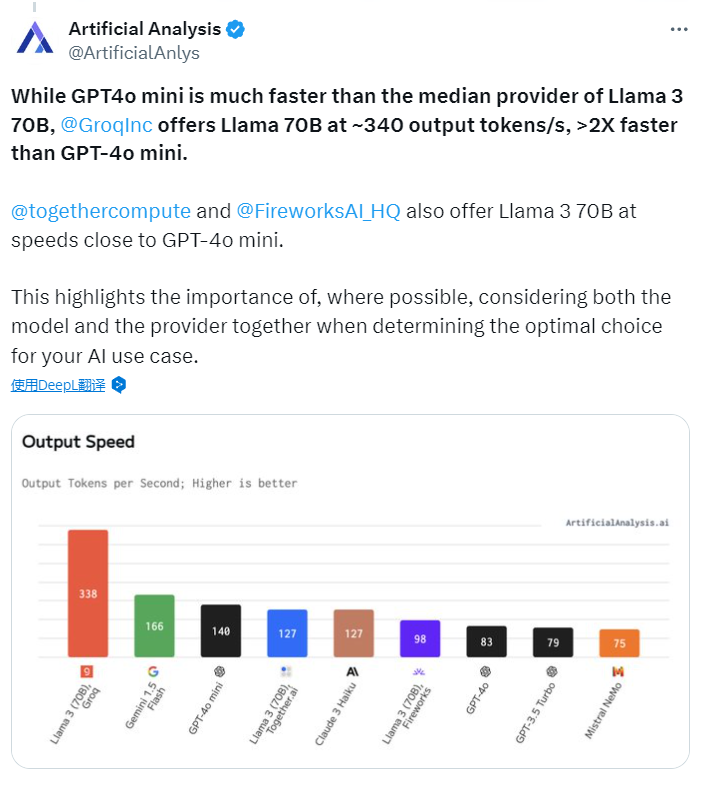

根據(jù) Artificial Analysis 的報(bào)告,在比較不同供應(yīng)商提供的Llama 3 70B(一種人工智能模型)的性能時(shí),GPT-4o Mini的速度明顯快于大多數(shù)供應(yīng)商。然而,Groq公司提供的Llama 70B模型,每秒能輸出約340個(gè)輸出令牌(tokens),這比GPT-4o Mini快了兩倍多。

圖片

圖片

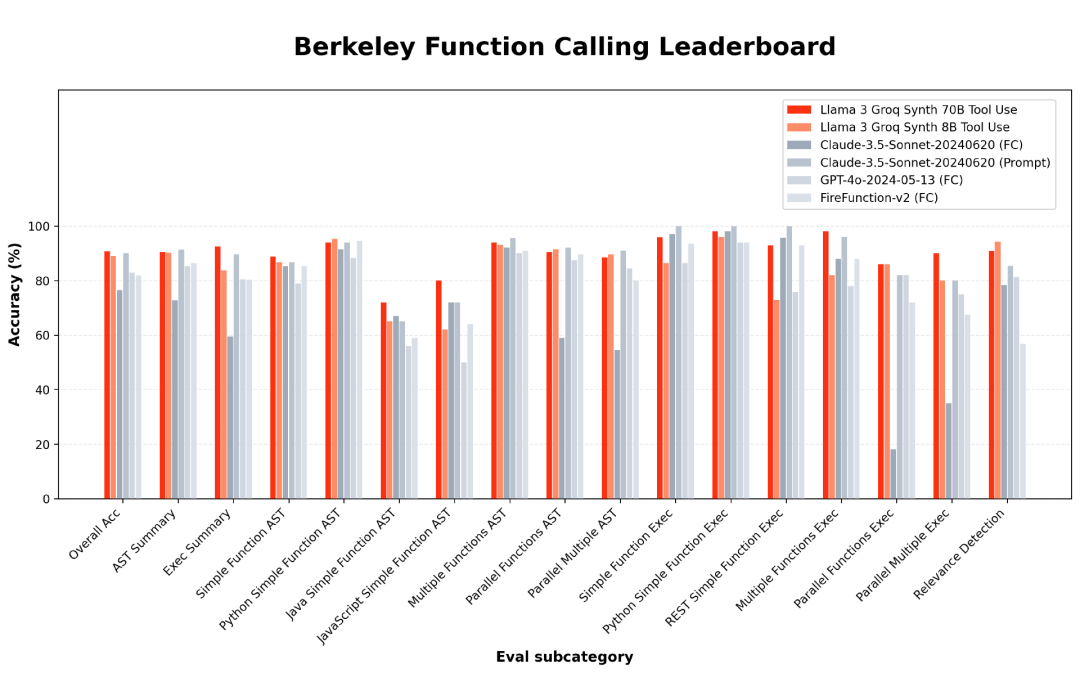

Groq 項(xiàng)目負(fù)責(zé)人 Rick Lamers 最近發(fā)布了 8B 和 70B 版本的 Llama 3 Groq Tool Use 型號(hào)。

圖片

圖片

他在 X 上分享說(shuō),這些模型是開(kāi)源的,并針對(duì)工具使用進(jìn)行了全面微調(diào),在 BFCL 基準(zhǔn)測(cè)試中名列前茅,超越了所有其他模型,包括 Claude Sonnet 3、GPT-4 Turbo、GPT-4o 和 Gemini 1.5 等專(zhuān)有模型。5、GPT-4 Turbo、GPT-4o 和 Gemini 1.5 Pro 等專(zhuān)有型號(hào)。

圖片

圖片

感興趣的朋友可以移步抱抱臉:

??https://huggingface.co/Groq/Llama-3-Groq-8B-Tool-Use??

自推出以來(lái)的 16 周內(nèi),Groq 免費(fèi)提供了為 LLM 工作負(fù)載提供支持的服務(wù),因此得到了開(kāi)發(fā)人員的廣泛歡迎,據(jù) Ross 稱(chēng),目前已有超過(guò) 28.2 萬(wàn)名開(kāi)發(fā)人員。

"Groq的使用非常簡(jiǎn)單,而且不需要任何費(fèi)用。你只需使用我們的應(yīng)用程序接口(API),我們與大多數(shù)已開(kāi)發(fā)的應(yīng)用程序都兼容,"羅斯說(shuō)。他補(bǔ)充說(shuō),如果客戶有大規(guī)模需求,每秒要生成數(shù)百萬(wàn)個(gè)令牌,公司可以為客戶部署內(nèi)部硬件。

2.拋棄GPU,Groq神秘的LPU——不僅快還省電

Groq由羅斯于2016年創(chuàng)立,其與眾不同之處在于摒棄了GPU,轉(zhuǎn)而使用其專(zhuān)有硬件LPU。

在加入Groq之前,羅斯曾在谷歌工作,創(chuàng)建了張量處理單元(TPU)。他負(fù)責(zé)設(shè)計(jì)和實(shí)現(xiàn)原始 TPU 芯片的核心元件,該芯片在谷歌的人工智能工作(包括 AlphaGo 競(jìng)賽)中發(fā)揮了關(guān)鍵作用。

LPU 僅用于運(yùn)行 LLM,而不是訓(xùn)練它們。羅斯說(shuō):"在推理或?qū)嶋H運(yùn)行模型時(shí),LPU的速度大約是GPU的10倍,"他補(bǔ)充說(shuō),在訓(xùn)練LLM時(shí),那是GPU的任務(wù)。

當(dāng)被問(wèn)及這種速度的目的時(shí),羅斯說(shuō):"人類(lèi)不喜歡這樣閱讀,就像老式電傳打字機(jī)打印出來(lái)的東西一樣。眼睛掃描頁(yè)面的速度非常快,幾乎在一瞬間就能判斷出是否得到了想要的東西。"

Groq 的 LPU 對(duì)英偉達(dá)、AMD 和英特爾等傳統(tǒng) GPU 制造商構(gòu)成了巨大挑戰(zhàn)。Groq專(zhuān)門(mén)為加速深度學(xué)習(xí)計(jì)算而打造了張量流處理器,而不是為人工智能修改通用處理器。

LPU旨在克服兩個(gè)LLM瓶頸:計(jì)算密度和內(nèi)存帶寬。就 LLM 而言,LPU 的計(jì)算能力大于 GPU 和 CPU。這就減少了每個(gè)單詞的計(jì)算時(shí)間,從而可以更快地生成文本序列。

此外,由于消除了外部?jī)?nèi)存瓶頸,LPU 推理引擎在 LLM 上的性能比 GPU 高出數(shù)個(gè)數(shù)量級(jí)。LPU 的設(shè)計(jì)優(yōu)先考慮數(shù)據(jù)的順序處理,這是語(yǔ)言任務(wù)所固有的。這與 GPU 形成鮮明對(duì)比,后者針對(duì)圖形渲染等并行處理任務(wù)進(jìn)行了優(yōu)化。"

Ross說(shuō):"在生成第99個(gè)字之前,你無(wú)法生成第100個(gè)字,因此它們有一個(gè)順序部分,而GPU根本無(wú)法做到這一點(diǎn)。

此外,他還補(bǔ)充說(shuō),GPU是出了名的耗電大戶,每個(gè)芯片所需的電量往往相當(dāng)于普通家庭的電量。"他說(shuō):"LPU 的耗電量?jī)H為 GPU 的十分之一。

參考鏈接: https://analyticsindiamag.com/ai-origins-evolution/groq-makes-llama-3-1-agi/

本文轉(zhuǎn)載自??51CTO技術(shù)棧??