擊敗GPT-4o、僅次于o1!英偉達重磅開源超強大模型--Nemotron 精華

全球AI領導者英偉達(Nvidia)開源了超強大模型——Llama-3.1-Nemotron-70B-Instruct。

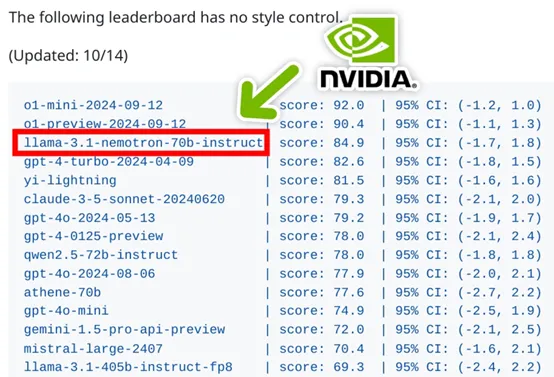

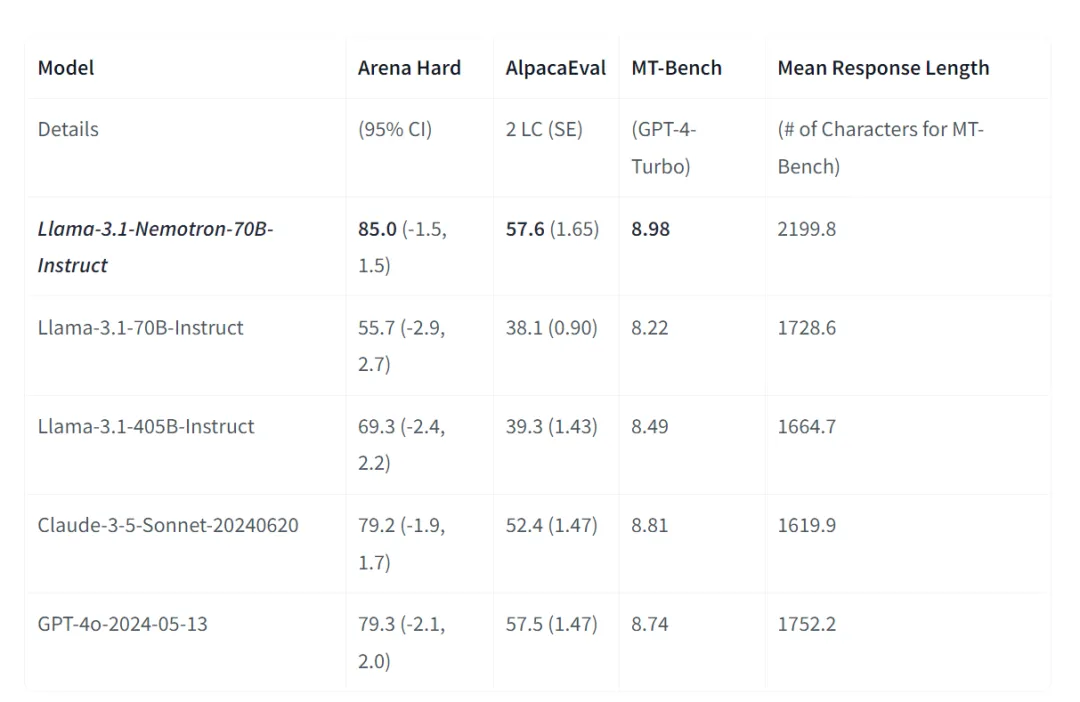

根據測試數據顯示,這個模型已經擊敗GPT-4o、GPT-4turbo、Gemma-2、Gemini-1.5、Claude-3.5 sonnet等140多個開閉源模型,僅次于OpenAI發布的最新模型o1。

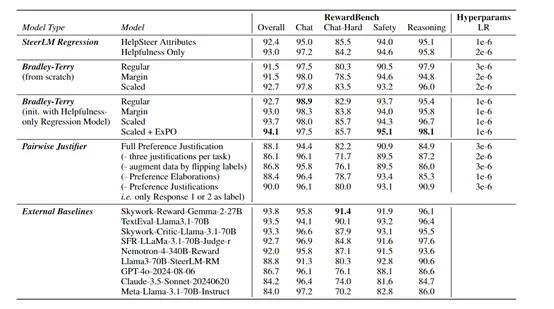

Nemotron的基礎模型是基于Llama-3.1-70B開發而成,這個沒什么新奇。但在訓練的過程使用了一種新的混合訓練方法,將Bradley-Terry和Regression一起用于訓練獎勵模型。

值得一提的是,英偉達把Nemotron的訓練數據集也開源了,這對于開發同類型或超過Nemotron的模型非常重要,因為這個是使用混合訓練方法的關鍵所在。

開源地址:https://huggingface.co/nvidia/Llama-3.1-Nemotron-70B-Reward

數據集:https://huggingface.co/datasets/nvidia/HelpSteer2

在線demo:https://huggingface.co/chat/

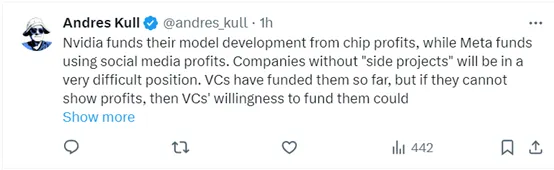

有網友表示,英偉達熱衷于不斷開源超強模型,一方面有大量資金資助他們的科研人員研發,另外主要目的還是為了賣GPU以及培養開發生態。而Meta依托他的社交帝國,在商業化和資金方面都不愁。

最愁的便是那些大模型初創企業了,錢拼不過這些巨頭,商業落地和名氣更不用提。所以,很多小企業可能會因為巨頭的碾壓,很快會出現資金斷裂等各種問題。

很高興看到AI領域的競爭,正在以驚人的速度推動行業向前發展。

這可是重磅開源。

為了新模型,買兩個4090爽一下吧。

模型是免費的,但運行的硬件可不免費啊。

我正在測試這個模型,我是一個高級AI用戶說說使用心得:在商業寫作方面,似乎比Claude3和ChatGPT聰明一些。但它依然會犯一些錯誤,相比于普通的3.1 70b Instruct,確實更聰明。

Nvidia可以以1000倍更低的成本實現這一點。如果Nvidia真的原意這么做,那么將無人能與之競爭。

創新混合訓練方法

在訓練大模型的過程中,為了確保模型在實際使用中能夠準確地理解并遵循用戶的提示指令,準確進行翻譯、文本生成、問答等任務,獎勵模型發揮了很重要的作用,主要通過為模型的輸出打分,指導模型生成更高質量的回答來實現。

目前,主流的獎勵模型方法主要有Bradley-Terry和Regression兩種:Bradley-Terry風格的獎勵模型起源于統計學中的排名理論,通過最大化被選擇響應和被拒絕響應之間的獎勵差距。這種方法強調在給定的提示下,用戶會選擇哪個響應,從而為模型提供了一種直接的、基于偏好的反饋。

Regression則借鑒了心理學中的評分量表,通過預測特定提示下響應的分數來訓練模型。這種方法允許模型對響應的質量進行更細致的評估,但可能不如基于偏好的方法直觀。

但這兩種方法都有明顯的缺點,Bradley-Terry需要用戶在兩個響應中選擇一個;而回歸風格的模型需要評分數據,用戶需要為每個響應打分才能幫助模型提升性能。所以,英偉達直接把兩個模型的優點放在一起使用來解決這個難題。

首先是需要開發一個包含評分和偏好注釋的數據集HELPSTEER2-PREFERENCE。研究人員是在HELPSTEER2基礎上添加偏好注釋。

這些偏好注釋不僅包括用戶在兩個響應中選擇一個的偏好方向,還包括用戶對這種偏好的強度評分。為了確保數據的質量和可解釋性,還要求注釋者為他們的偏好提供書面說明。

在訓練這種新型混合方法時,研究人員使用AdamW優化器來訓練模型,通過引入權重衰減和梯度裁剪來提高訓練的穩定性和效率。

為了進一步提高模型性能,使用了ExPO在訓練過程中對模型的權重進行外推,可以進一步提高模型的性能。可以使模型在訓練時更加關注那些差異較大的響應對,從而提高模型的區分能力。

此外,研究人員還進行了廣泛的超參數搜索,以找到最佳的學習率和KL懲罰項。這些超參數對于模型的訓練至關重要,因為它們直接影響到模型的收斂速度和最終性能。

HELPSTEER2-PREFERENCE數據集

為了開發這個多元化滿足新的混合訓練方法數據集,在數據注釋的過程中,每一對回應都經過3—5名標注者的評價。這些標注者需要從多個維度對每個回應進行評分,包括有用性、準確性、連貫性、復雜性和冗長程度等。為了更好地理解背后的原因,標注者還需要提供簡短的文字說明,解釋為何選擇了某個回應作為更好的答案。這種方法不僅增強了數據的透明度,也為后續分析提供了豐富的上下文信息。

研究人員還使用了嚴格的數據預處理步驟來保證數據質量。例如,他們會識別出每個任務中相似度最高的三個偏好注釋,然后取這三個注釋的平均值并四舍五入到最接近的整數,以此作為該任務的整體偏好得分。

同時,為了排除那些標注者意見分歧較大的樣本,研究人員們會過濾掉那些注釋之間差異超過一定范圍的任務。這些措施共同作用,有效提升了數據的可靠性和一致性。

根據測試數據顯示,使用HELPSTEER2-PREFERENCE數據集訓練的模型性能非常強,在RewardBench評測中達到了94.1的高分,超過了同期幾乎所有其他模型的表現。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區