VLM訓(xùn)練成本降4.5倍!8B參數(shù)媲美GPT-4o mini | 英偉達&MIT等發(fā)布NVILA:前沿高效

文章鏈接:https://arxiv.org/pdf/2412.04468

動機

視覺語言模型(VLMs)在處理和融合視覺與文本信息方面表現(xiàn)出了卓越的能力,推動了先進的視覺-語言交互和對話系統(tǒng)的發(fā)展。近年來,研究界在提高VLMs的準確性方面取得了巨大的進展,并拓展了它們在各個領(lǐng)域的應(yīng)用,包括機器人技術(shù)、自動駕駛和醫(yī)學(xué)影像。然而,提升其效率的研究卻相對較少。

VLMs在多個方面都是高成本的。

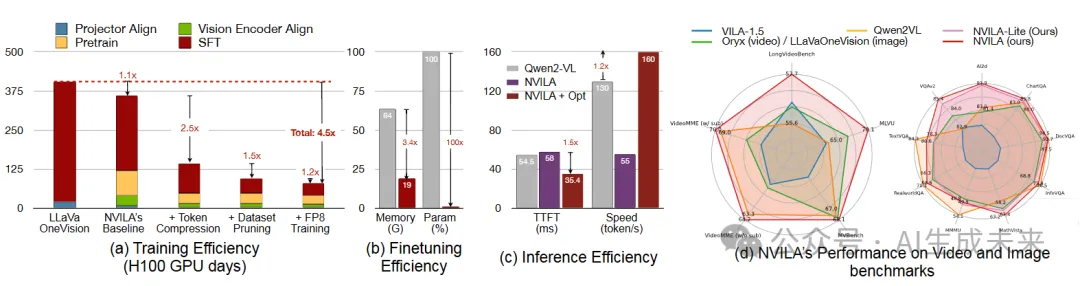

- 首先,訓(xùn)練VLM非常耗時。例如,訓(xùn)練一個最先進的7B參數(shù)VLM可能需要長達400個GPU天,更不用說更大的模型了。這為研究人員設(shè)立了巨大的進入壁壘。

- 其次,VLM在應(yīng)用于特定領(lǐng)域(例如醫(yī)學(xué)影像)時,通常需要進行適應(yīng),但微調(diào)VLM的內(nèi)存開銷非常大。例如,完全微調(diào)一個7B參數(shù)的VLM可能需要超過64GB的GPU內(nèi)存,遠超大多數(shù)消費者級GPU的內(nèi)存容量。

- 最后,VLM常常被部署在計算資源有限的邊緣應(yīng)用中(如筆記本、機器人),因此在這些環(huán)境下部署VLM面臨資源受限的問題。

解決這些挑戰(zhàn)需要一個系統(tǒng)化的方案,以提高VLM在各個維度上的效率。

本文亮點

本文介紹了NVILA,一組旨在優(yōu)化效率和準確性的開源VLM。基于VILA ,通過首先提升空間和時間分辨率,再對視覺token進行壓縮,改進了其模型架構(gòu)。

“擴展”保存了更多視覺輸入的細節(jié),提升了準確性的上限;而“壓縮”則將視覺信息壓縮為更少的token,從而提高了計算效率。這種“先擴展再壓縮”的策略使得NVILA能夠在有效且高效的方式下處理高分辨率圖像和長視頻。此外,還進行了系統(tǒng)的研究,旨在優(yōu)化NVILA在其整個生命周期中的效率,包括訓(xùn)練、微調(diào)和部署。

得益于這些創(chuàng)新,NVILA在效率和準確性上都表現(xiàn)出色。

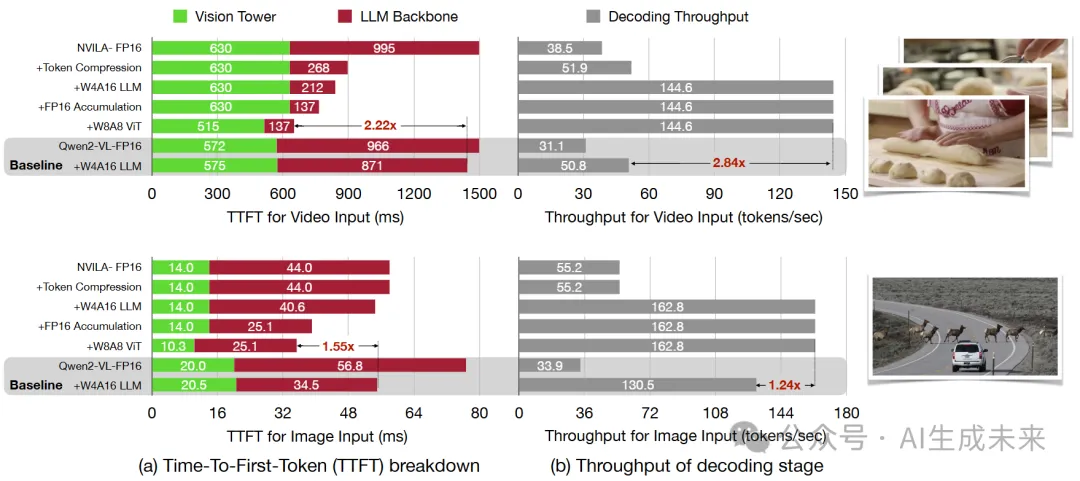

- 將訓(xùn)練成本降低了4.5倍,微調(diào)內(nèi)存使用降低了3.4倍,預(yù)填充延遲減少了1.6-2.2倍,解碼延遲減少了1.2-2.8倍;

- NVILA在多個圖像和視頻基準測試中與許多領(lǐng)先的開源VLM和專有VLM的準確性相當(dāng)或更優(yōu);

- NVILA還支持新的功能,包括時間定位、機器人導(dǎo)航和醫(yī)學(xué)影像等應(yīng)用。

方法

首先設(shè)計了NVILA的高效模型架構(gòu),具體方法是首先通過提高空間和時間分辨率,然后壓縮視覺token。接著,提出了一些策略,以提高NVILA在整個生命周期中的效率——從訓(xùn)練和微調(diào)到部署。除非另有說明,本節(jié)中的所有分析將基于8B模型。

高效模型架構(gòu)

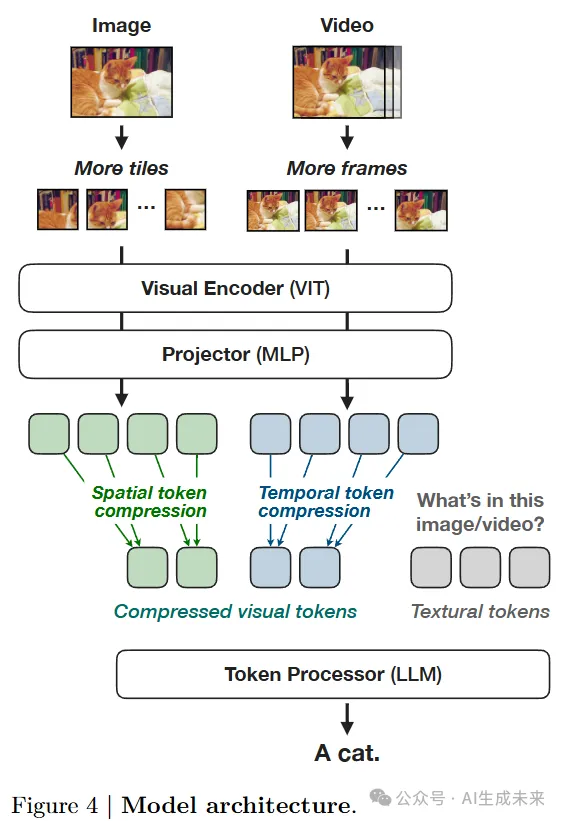

我們在VILA的基礎(chǔ)上構(gòu)建了NVILA。如圖4所示,它是一個自回歸的視覺語言模型(VLM),由三個組件組成:一個視覺編碼器,用于從視覺輸入(如圖像、視頻)中提取特征;一個映射器,用于對視覺和語言模態(tài)的嵌入進行對齊;以及一個token處理器,通常是一個大語言模型(LLM),它接受視覺和語言token作為輸入,并輸出語言token。具體來說,NVILA使用SigLIP作為其視覺編碼器,使用兩層MLP作為映射器,并使用不同大小的Qwen2作為其token處理器。

原始的VILA模型具有非常有限的空間和時間分辨率:例如,它將所有圖像的尺寸調(diào)整為448×448,無論原始圖像的大小或縱橫比如何,并且最多從視頻中采樣14幀。空間調(diào)整和時間采樣都會導(dǎo)致信息的顯著丟失,限制了模型有效處理更大圖像和更長視頻的能力。這一點可以在表8和表9中看到,VILA在一些文本密集型和長視頻基準測試中落后于領(lǐng)先的VLM,尤其在這些基準上表現(xiàn)不佳。

本文提倡“先擴展后壓縮” 的范式:首先提高空間/時間分辨率以提升準確性,然后通過壓縮視覺token來提高效率。提高分辨率能夠提高性能上限,但僅靠這一點會顯著增加計算成本。例如,將分辨率加倍會將視覺token的數(shù)量加倍,從而使得訓(xùn)練和推理成本增加超過2倍,因為自注意力機制的計算復(fù)雜度是與token數(shù)量的平方成正比的。接下來,可以通過壓縮空間/時間token來降低這一成本。壓縮后的視覺token具有更高的信息密度,能夠用更少的token來保留或甚至提高空間和時間細節(jié)。

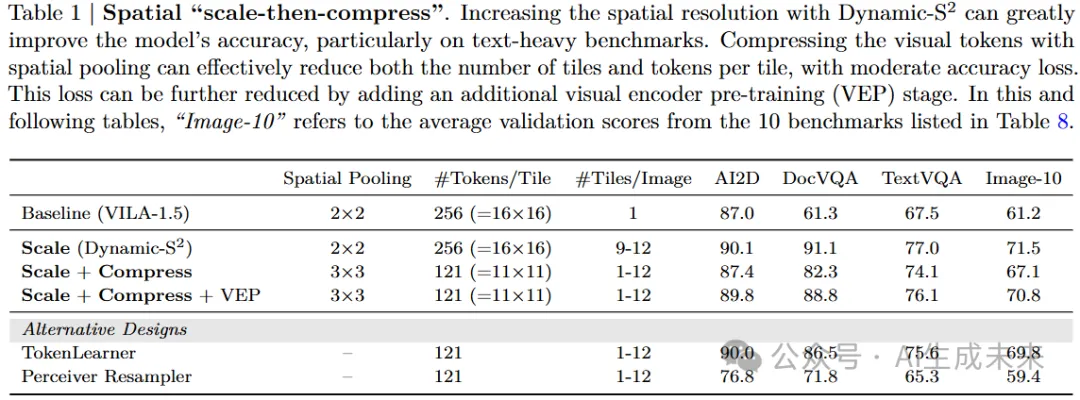

空間“先擴展后壓縮”

對于空間token壓縮,還有許多其他設(shè)計方案,例如RT-1中的TokenLearner和MiniCPM-V中的Perceiver Resampler。然而,即便采用這些可學(xué)習(xí)的壓縮方法,在相同的token壓縮比下,它們的性能并沒有超越簡單的空間到通道設(shè)計,甚至在增加了額外的階段1.5后也未能超過。因此,認為這更多是一個優(yōu)化問題,超出了本文的討論范圍。

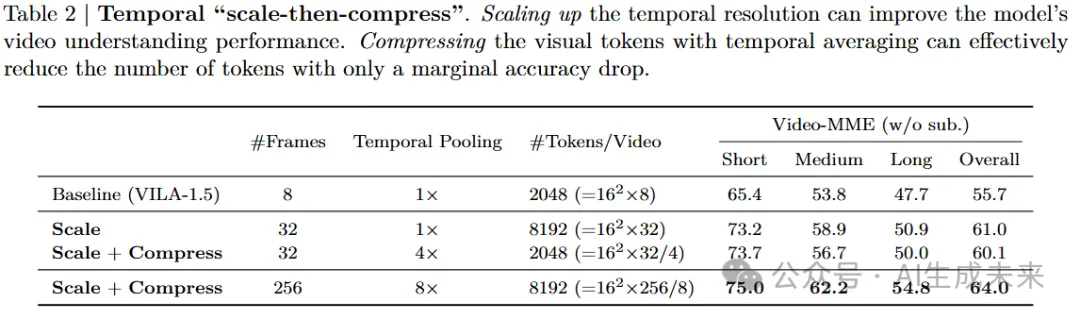

時間“先擴展后壓縮”

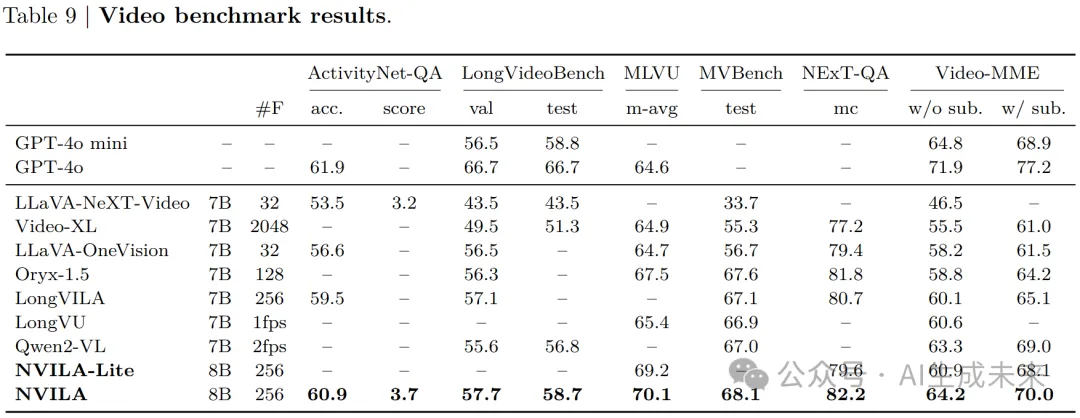

對于時間擴展,只是簡單地增加從輸入視頻中均勻采樣的幀數(shù)。參考之前的方法 [17],通過額外的視頻監(jiān)督微調(diào)(SFT)來訓(xùn)練模型,以擴展其處理更多幀的能力。從后面表9可以看出,將幀數(shù)從8延伸到32,可以使得模型在Video-MME基準測試上的準確性提高超過5%。然而,這也會將視覺token的數(shù)量增加4倍。

類似于空間token壓縮,將對這些視覺token進行壓縮。由于視頻中存在內(nèi)在的時間連續(xù)性,采用了時間平均來進行壓縮,首先將幀分組,然后對每組內(nèi)的視覺token進行時間池化。這樣可以減少時間冗余(因為連續(xù)的幀通常包含相似的信息),同時仍然保留重要的時空信息。從經(jīng)驗來看,將視覺token壓縮4倍后,準確性下降是可以接受的。與原始基準相同token數(shù)的模型相比,擴展和壓縮后的模型幾乎沒有增加成本,但準確性卻大大提高。也使用這種方法進一步擴展了幀數(shù)和壓縮比,從而在該基準測試中取得了最先進的7B模型(見后面表9)。

高效訓(xùn)練

盡管最先進的VLM具有令人印象深刻的能力,但訓(xùn)練這樣一個VLM往往需要高昂的成本和大量的計算資源。本節(jié)探討了系統(tǒng)算法共同設(shè)計,以實現(xiàn)高效的VLM訓(xùn)練。在算法方面,研究了一種新的無監(jiān)督數(shù)據(jù)集剪枝方法來簡化訓(xùn)練數(shù)據(jù)。在系統(tǒng)層面,探索了FP8混合精度加速。

數(shù)據(jù)集剪枝

為了提高模型的準確性,之前的研究[19, 5, 20]不斷從各種來源獲取高質(zhì)量的SFT數(shù)據(jù)集,并顯示出在基準測試分數(shù)上的提升。然而,并非所有數(shù)據(jù)對模型的貢獻相同,數(shù)據(jù)集的持續(xù)增長會導(dǎo)致大量冗余。在NVILA中,遵循“先擴展后壓縮”的理念,首先增加我們的SFT數(shù)據(jù)集混合,然后嘗試壓縮數(shù)據(jù)集。然而,從各種來源選擇高質(zhì)量的示例是一個挑戰(zhàn)。盡管已有一些關(guān)于視覺輸入[21, 22, 23]和僅文本輸入[24, 25, 26]的探索,但很少有研究解決了在VLM訓(xùn)練中這個問題,其中圖像和文本在訓(xùn)練過程中是混合的。NVILA的訓(xùn)練涉及超過1億的數(shù)據(jù),因此需要在保持準確性的同時修剪訓(xùn)練集。

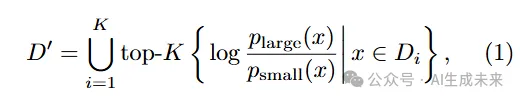

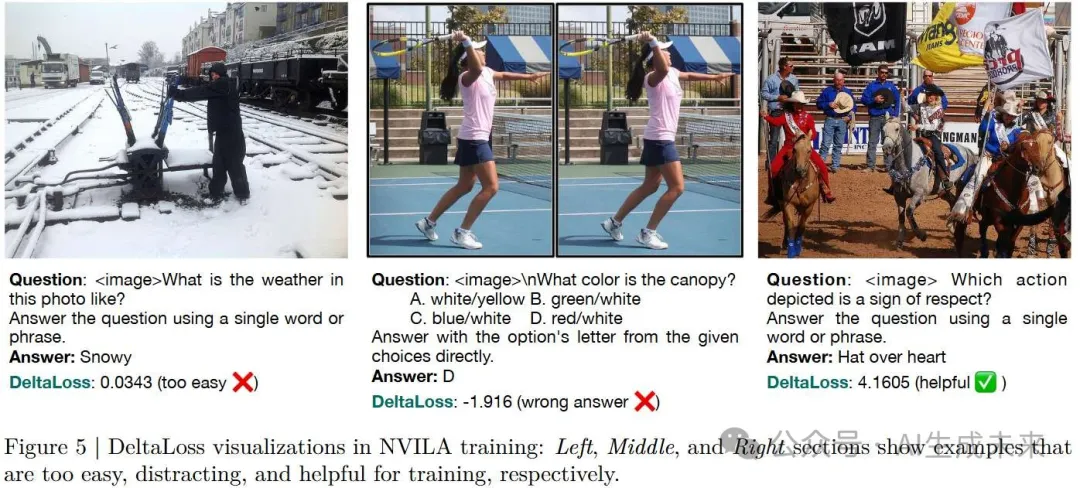

受到最近知識蒸餾研究[27]的啟發(fā),利用DeltaLoss來對訓(xùn)練集進行評分:

因此,我們可以對每個子數(shù)據(jù)集應(yīng)用DeltaLoss,并根據(jù)不同的比例修剪訓(xùn)練集。

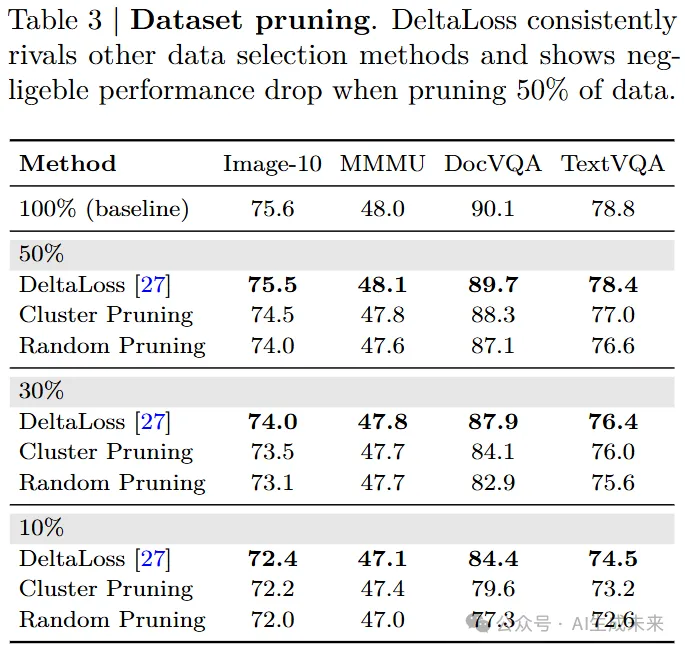

為了評估數(shù)據(jù)修剪標準,將DeltaLoss與隨機修剪基線進行比較,結(jié)果見表3。對于隨機修剪,數(shù)據(jù)是隨機選擇的,進行三次實驗并報告平均值。對于聚類修剪,應(yīng)用k-means聚類并使用siglip特征,在每個質(zhì)心上均勻修剪數(shù)據(jù)。實驗報告了在10個基準測試上的平均表現(xiàn),重點展示了關(guān)鍵任務(wù),以驗證該方法的有效性。

測試了三個修剪閾值:10%、30%和50%,并發(fā)現(xiàn)DeltaLoss在所有情況下始終優(yōu)于隨機基線,特別是在GQA和DocVQA任務(wù)中,隨機修剪顯示出顯著的性能下降,而DeltaLoss保持準確。注意到50%是一個相對安全的閾值,在該閾值下,平均得分保持競爭力,同時訓(xùn)練速度提高了2倍。因此,在后續(xù)實驗中將修剪閾值設(shè)置為50%。

FP8 訓(xùn)練

FP16 和 BF16已經(jīng)成為模型訓(xùn)練的標準精度,因為它們能夠加速計算且不會導(dǎo)致精度損失,這些精度在 NVIDIA GPU 上得到了原生支持。隨著 NVIDIA Hopper 和 Blackwell 架構(gòu)的問世,新的 GPU(如 H100 和 B200)現(xiàn)在原生支持 FP8,這種精度由于其在計算和內(nèi)存效率上的潛力,已經(jīng)成為一種有前景的精度標準。

許多研究者已經(jīng)將 FP8 應(yīng)用到大語言模型(LLM)的訓(xùn)練中。NVIDIA 的 Transformer Engine 在 FP8 精度下執(zhí)行矩陣乘法(GEMM),從而加速了訓(xùn)練速度。FP8-LM 在此基礎(chǔ)上進一步量化了梯度、權(quán)重主副本和一階動量為 FP8,從而減少了通信開銷和內(nèi)存占用。COAT 進一步壓縮了激活值和優(yōu)化器的二階動量,以提高內(nèi)存效率,同時保持準確性。

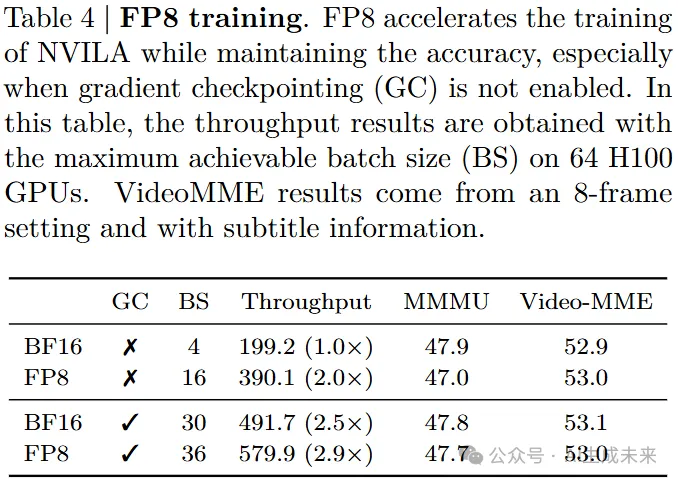

本文借鑒了COAT中的 FP8 實現(xiàn)來加速 NVILA 的訓(xùn)練。LLM 和 VLM 訓(xùn)練工作負載之間的一個關(guān)鍵區(qū)別在于批次中序列長度的變化性。在 LLM 訓(xùn)練中,樣本通常具有統(tǒng)一的長度,增加批次大小到某一程度之后,對訓(xùn)練吞吐量的影響最小。然而,在 VLM 訓(xùn)練中,樣本的長度變化較大:視頻樣本可能需要數(shù)萬個token,圖像樣本可能只需要幾百個,而純文本樣本則需要更少。因此,具有較少token的工作負載通常會被低效利用,可以通過增加批次大小來顯著提升效率。如表4所示,將 FP8 應(yīng)用于權(quán)重和激活后,可以將 NVILA 的批次大小從 4 增加到 16,獲得 2 倍的加速。當(dāng)啟用梯度檢查點時,量化激活變得不那么重要。相反,集成了 Liger 中的交叉熵內(nèi)核,以減少由于 Qwen 的大詞匯表大小帶來的峰值內(nèi)存使用。在這種情況下,F(xiàn)P8 訓(xùn)練仍然可以比 BF16 訓(xùn)練提供 1.2 倍的加速。

高效微調(diào)

一旦基礎(chǔ)的 VLM 模型訓(xùn)練完成,就需要進行領(lǐng)域特定的微調(diào),以適應(yīng)特定的任務(wù)或領(lǐng)域。雖然微調(diào)有效地提高了領(lǐng)域特定的詞匯和概念,但傳統(tǒng)的參數(shù)高效微調(diào)方法主要集中在 LLM 和文本相關(guān)任務(wù)上,而如何最好地微調(diào) VLM 仍然是一個較少探討的問題。

在 NVILA 中,我們發(fā)現(xiàn):

- ViT 和 LLM 的學(xué)習(xí)率應(yīng)該設(shè)置得不同;

- 微調(diào)時,應(yīng)根據(jù)不同的下游任務(wù)選擇微調(diào)部分。

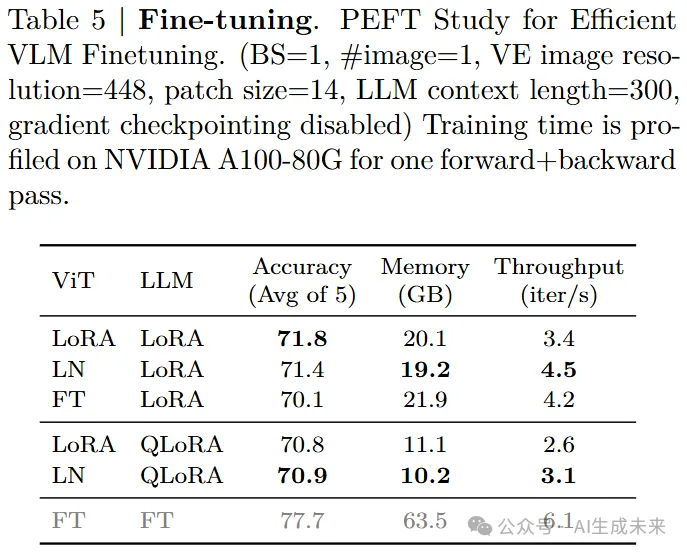

當(dāng)使用參數(shù)高效微調(diào)(PEFT)方法同時微調(diào)視覺編碼器(ViT)和語言模型(LLM)時,觀察到 ViT 部分的學(xué)習(xí)率應(yīng)比 LLM 部分小 5-50 倍。另一方面,還觀察到,使用 Layernorm 微調(diào)視覺編碼器可以與 LoRA 實現(xiàn)類似的性能(表 5),同時更加高效:與應(yīng)用 LoRA 的視覺編碼器相比,這種方法可以減少 25% 的訓(xùn)練時間。通過精心配置,NVILA 可以在 24GB 的內(nèi)存下快速微調(diào)到各種下游任務(wù),并保持與原始性能相當(dāng)。

高效部署

VLM 通常集成到計算預(yù)算緊張的邊緣應(yīng)用中,如機器人。在這一部分,將介紹專門的推理引擎及其量化技術(shù),以加速 NVILA 的部署。

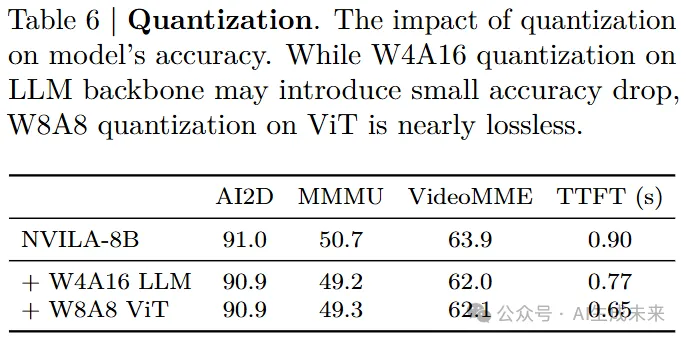

我們開發(fā)了一個專門的推理引擎,并結(jié)合量化技術(shù)來高效地部署 NVILA。推理過程分為兩個階段:預(yù)填充和解碼。在計算受限的預(yù)填充階段,首先應(yīng)用token壓縮技術(shù)來減少 LLM 主干的推理工作量,之后,視覺模塊成為主要瓶頸,占據(jù)了超過 90% 的預(yù)填充延遲。為了解決這個問題,對視覺模塊實施了W8A8量化,以減少 NVILA 在這一計算瓶頸階段的首次token時間(TTFT)。對于內(nèi)存受限的解碼階段,采用 AWQ對 LLM 主干進行 W4A16 量化以加速。進一步優(yōu)化了原始的 AWQ 實現(xiàn),通過將 FP16 累加引入 W4A16 的 GEMM 內(nèi)核,從而在不損失精度的情況下,實現(xiàn)了總共 1.7 倍的內(nèi)核加速。后面圖 6 中附上了詳細的比較。

實驗

實現(xiàn)細節(jié)

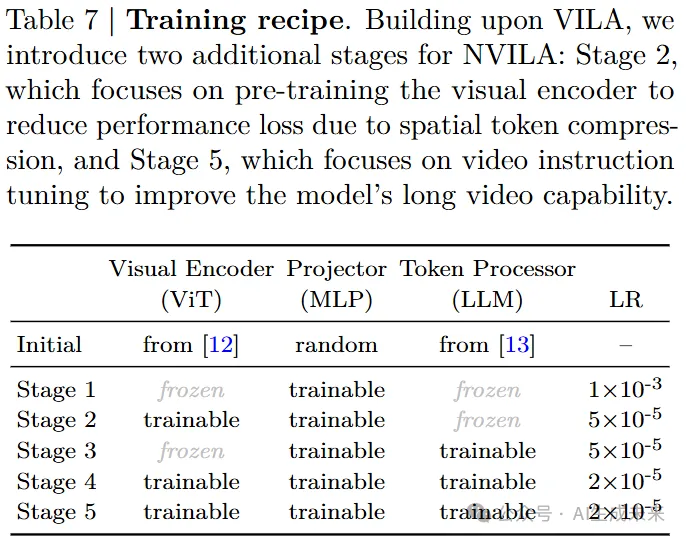

遵循五階段pipeline來訓(xùn)練 NVILA:(1)映射器初始化,(2)視覺編碼器預(yù)訓(xùn)練,(3)token處理器預(yù)訓(xùn)練,(4)圖像指令調(diào)優(yōu),以及(5)視頻指令調(diào)優(yōu)。其中,第 1、3 和 4 階段也包含在 VILA 的訓(xùn)練中。額外的第 2 階段用于恢復(fù)由于空間token壓縮造成的準確度損失(如表 1 所示),第 5 階段有助于擴展模型的長視頻理解能力。在表 7 中提供了詳細的訓(xùn)練配置,數(shù)據(jù)配置則在表 A1 中給出。

實現(xiàn)基于 PyTorch 2.3.0和 Transformers 4.46.0。使用 DeepSpeed 0.9.5將大型模型分片到多個設(shè)備上,并使用梯度檢查點技術(shù)來減少內(nèi)存使用。采用 FlashAttention-2 來加速 LLM 和視覺編碼器的訓(xùn)練。還實現(xiàn)了功能保持的動態(tài)序列打包技術(shù),以融合長度不同的樣本,從而實現(xiàn)約 30% 的加速。使用 128 個 NVIDIA H100 GPU 訓(xùn)練所有模型,跨所有階段的全局批次大小為 2048。所有優(yōu)化都使用 AdamW 進行,并且不使用權(quán)重衰減。采用余弦學(xué)習(xí)率衰減調(diào)度,并在調(diào)度的前 3% 使用線性預(yù)熱。各個階段的初始學(xué)習(xí)率在表 7 中有詳細說明。

結(jié)果

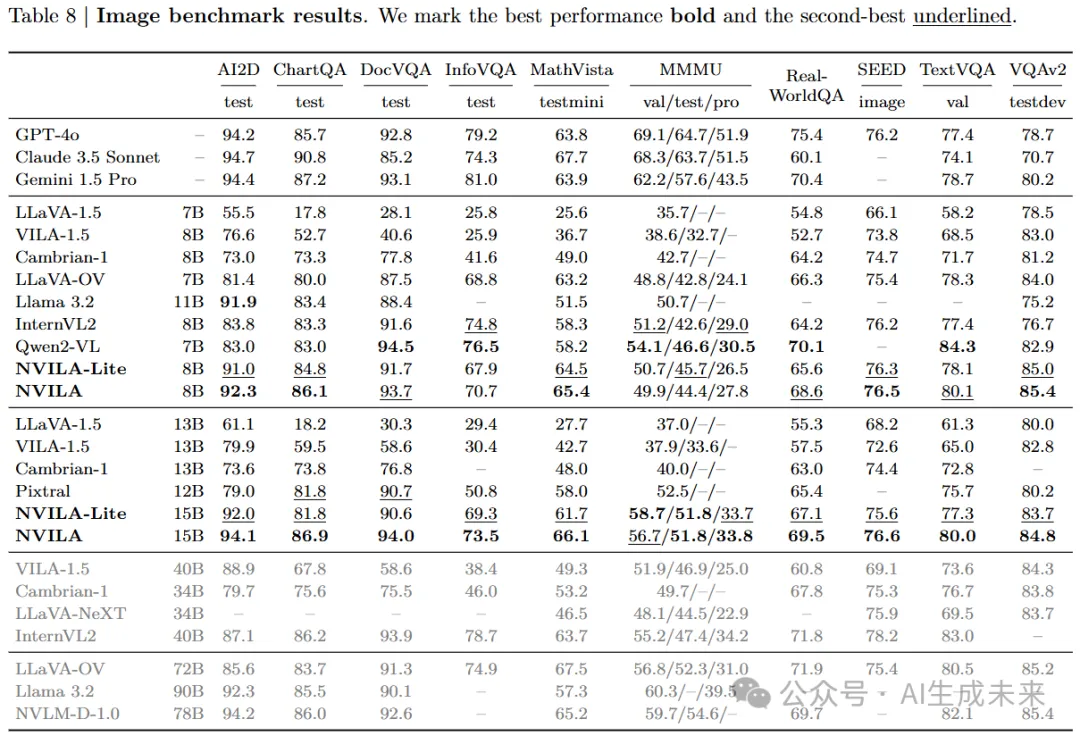

圖像基準測試

如表 8 所示,在多個圖像基準測試上進行了全面評估,包括:AI2D、ChartQA、DocVQA、InfographicVQA、MathVista 、MMMU(zero-shot CoT)、RealworldQA、SEED-Bench 、TextVQA 和 VQAv2。

NVILA 在每個規(guī)模類別中與頂尖的開源模型(如 Qwen2-VL 、InternVL和 Pixtral)表現(xiàn)相當(dāng)。在一般的視覺問答任務(wù)(ChartQA、DocVQA、InfoVQA、TextVQA、VQAv2、Seed)中,NVILA-8B 和 NVILA-15B 在與專有模型(GPT-4o、Gemini)的比較中,取得了競爭力甚至更好的結(jié)果。

在與科學(xué)相關(guān)的基準(如 AI2D)上,NVILA-8B 在開源模型中達到了最先進的性能。將規(guī)模擴展到 15B 時,NVILA 的表現(xiàn)與專有模型相競爭。

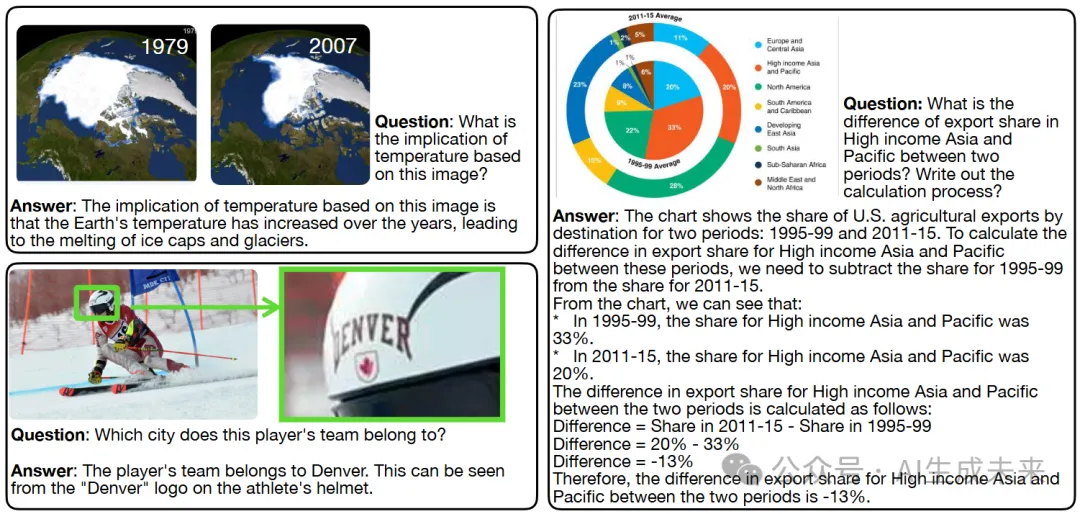

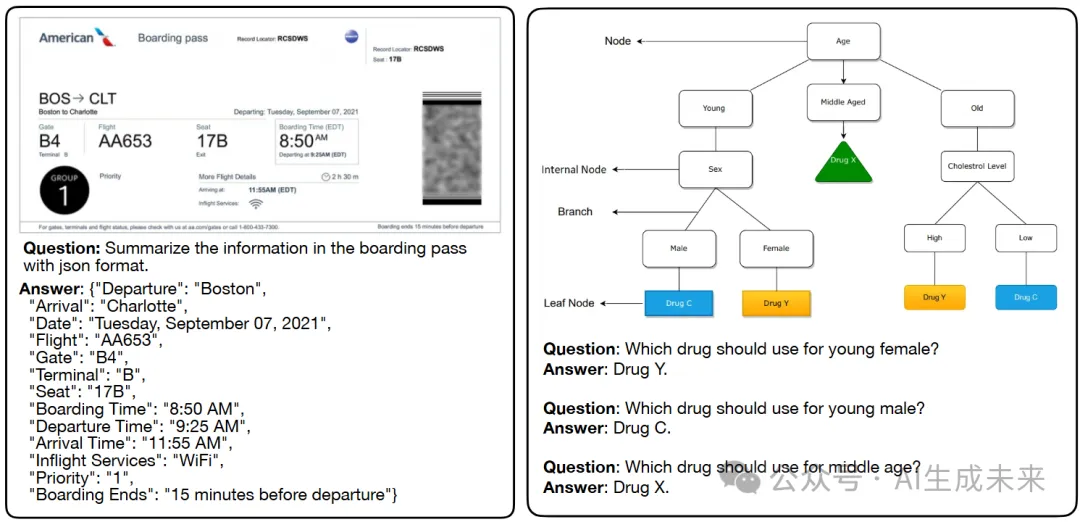

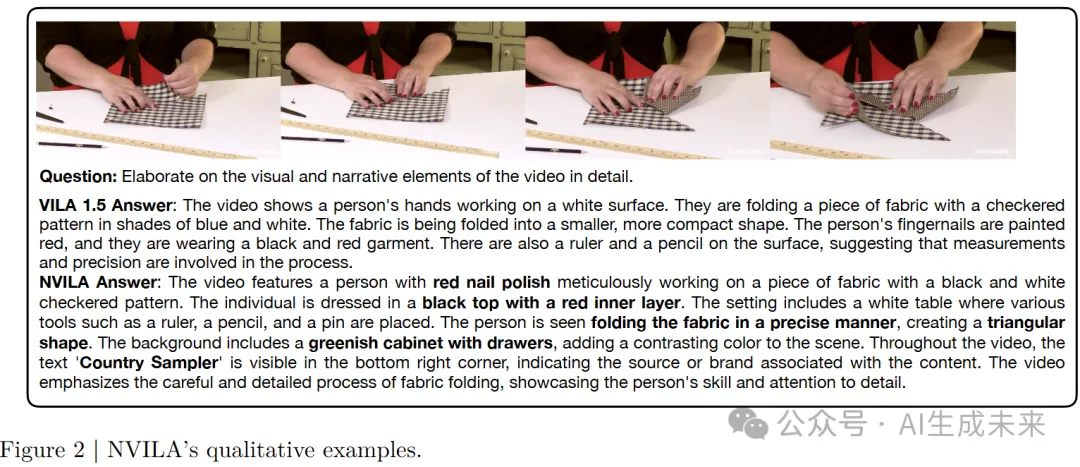

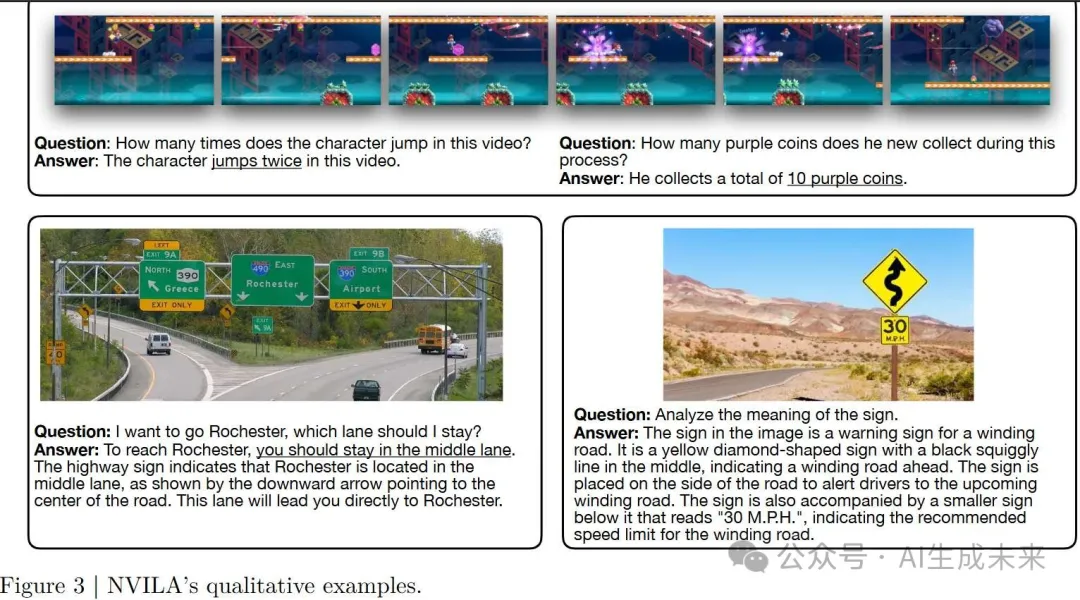

此外,在推理和知識基準(如 MMMU、RealworldQA 和 MathVista)中,隨著模型規(guī)模的增大,成績進一步提高。對于需要 OCR 功能的基準任務(wù)(如 TextVQA、AI2D、ChartQA、DocVQA、InfoVQA),8B 模型同樣表現(xiàn)優(yōu)秀。還在圖 2-3 中展示了一些定性示例,以展示 NVILA 模型在 OCR、推理和多圖像能力方面的表現(xiàn)。

視頻基準測試

在一系列視頻理解基準上評估了模型的性能,涵蓋了從幾秒鐘到一個小時長的視頻。下表 9 展示了 NVILA 與基準模型的比較結(jié)果。NVILA 具備長上下文處理能力,能夠處理多達 256 幀。通過“先擴展再壓縮”的設(shè)計,NVILA-8B 在所有基準測試中都取得了令人印象深刻的結(jié)果,創(chuàng)造了新的最先進表現(xiàn)。值得注意的是,NVILA 僅憑 8B 參數(shù)就達到了與 GPT-4o mini 相當(dāng)?shù)男阅埽⑶页搅嗽S多更大規(guī)模的模型。

效率結(jié)果

NVILA 在圖像和視頻基準測試上表現(xiàn)出色,同時通過“先擴展再壓縮”的方法保持了高效性。在架構(gòu)上,首先將圖像擴展到原始分辨率(1 到 12 倍更多的patches),然后將token壓縮 2.4 倍,從而在稍多的token數(shù)下實現(xiàn)更高的準確度。數(shù)據(jù)集方面,制作了一個多樣的 1000 萬樣本數(shù)據(jù)集,通過 DeltaLoss 壓縮并修剪為一個高質(zhì)量的 500 萬子集,始終優(yōu)于 LlaVa-Onevision,該模型在超過 800 萬數(shù)據(jù)上進行訓(xùn)練。此外,集成了 FP8 來加速訓(xùn)練,優(yōu)化了微調(diào)的學(xué)習(xí)率,并采用 W8A8 格式來提升延遲和吞吐量。這些全棧優(yōu)化使得 NVILA 在使用較少資源的情況下訓(xùn)練,同時實現(xiàn)更好的性能、更少的內(nèi)存占用和更快的推理速度。

將 NVILA 的推理性能與 Qwen2-VL進行了對比,如下圖 6 所示。為了公平比較,兩個模型都通過采樣 64 幀處理視頻輸入,所有實驗都在單個 NVIDIA RTX 4090 GPU 上進行。Qwen2-VL 被量化為 W4A16,并通過 vLLM部署,這是一個具有最先進推理速度的 LLM/VLM 服務(wù)引擎。對于 NVILA,將 LLM 主干量化為 W4A16,視覺模塊量化為 W8A8。通過我們的專用推理引擎,NVILA 在預(yù)填充階段獲得了最高 2.2 倍的加速,在解碼吞吐量上比 Qwen2-VL 高出最多 2.8 倍。

更多能力

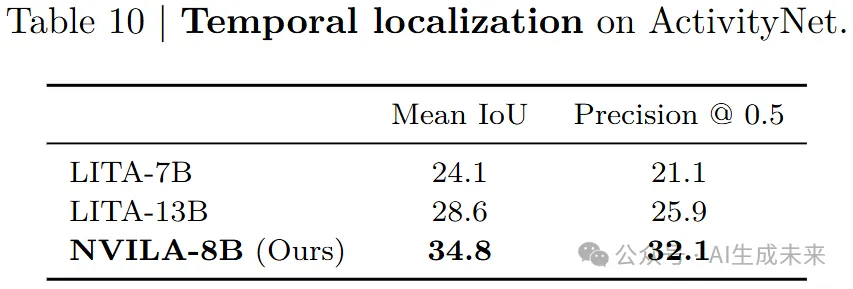

時間定位

繼LITA之后,在NVILA中也加入了對時間定位的支持。我們添加了離散時間token來表示視頻中的時間戳,并使用平滑的交叉熵損失來訓(xùn)練模型。從表10中的結(jié)果可以清晰地看出,NVILA在所有度量上顯著優(yōu)于所有基準方法。

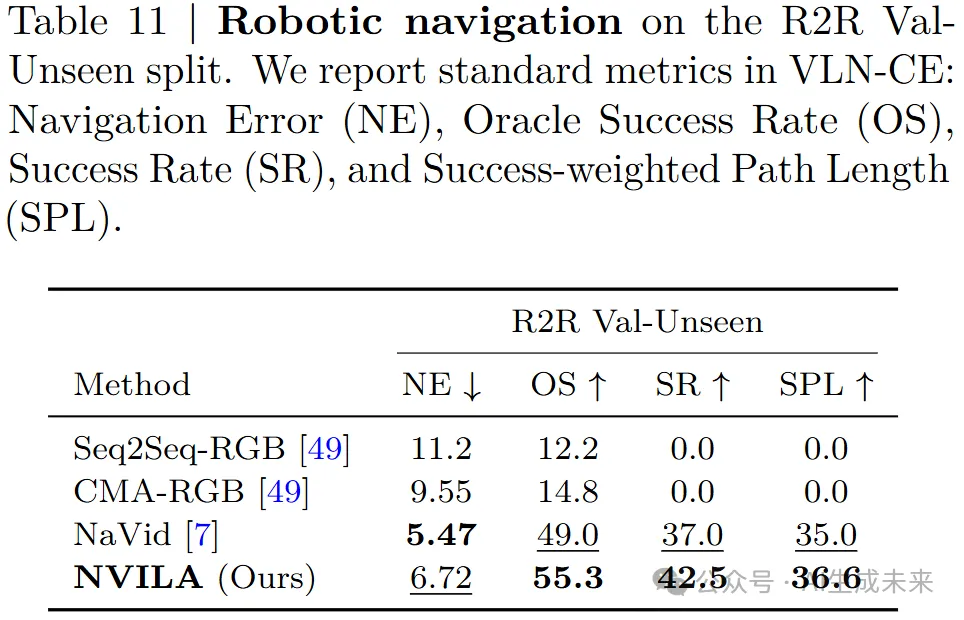

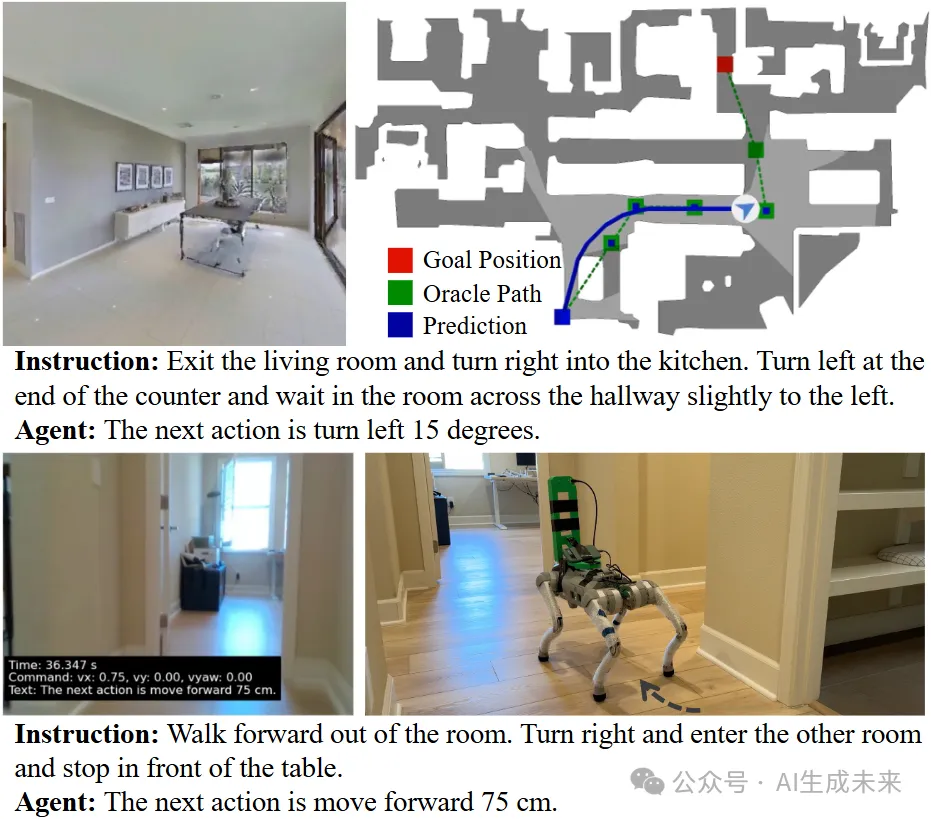

機器人導(dǎo)航

NVILA可以作為視覺-語言導(dǎo)航(VLN)中機器人智能體的強大基礎(chǔ),并支持在非服務(wù)器設(shè)備上的實時部署。在每個時間步??,代理接收語言指令和視頻觀測,規(guī)劃下一步動作,并過渡到下一個狀態(tài)??+1,在該狀態(tài)下接收新的觀測。NVILA高效而靈活地處理多幀輸入,使得歷史觀測和當(dāng)前觀測能夠無縫整合到VLM中。NaVILA框架引入了定制的導(dǎo)航提示,并使用來自仿真器的特定導(dǎo)航SFT數(shù)據(jù)對NVILA進行了微調(diào)。表11中的定量結(jié)果顯示,NVILA的簡潔設(shè)計在VLN-CE任務(wù)中達到了最先進的結(jié)果。基于NVILA-8B的導(dǎo)航模型在單個筆記本GPU上的實時部署視覺結(jié)果展示在下圖7中。整個系統(tǒng)可以無縫運行,采用端到端(相機→GPU→動作)pipeline,運行頻率為1Hz。

醫(yī)療多模態(tài)VILA-M3

NVILA在醫(yī)療領(lǐng)域也具有變革性的潛力。這種集成有望推動診斷準確性、臨床決策和數(shù)據(jù)解讀的進步。

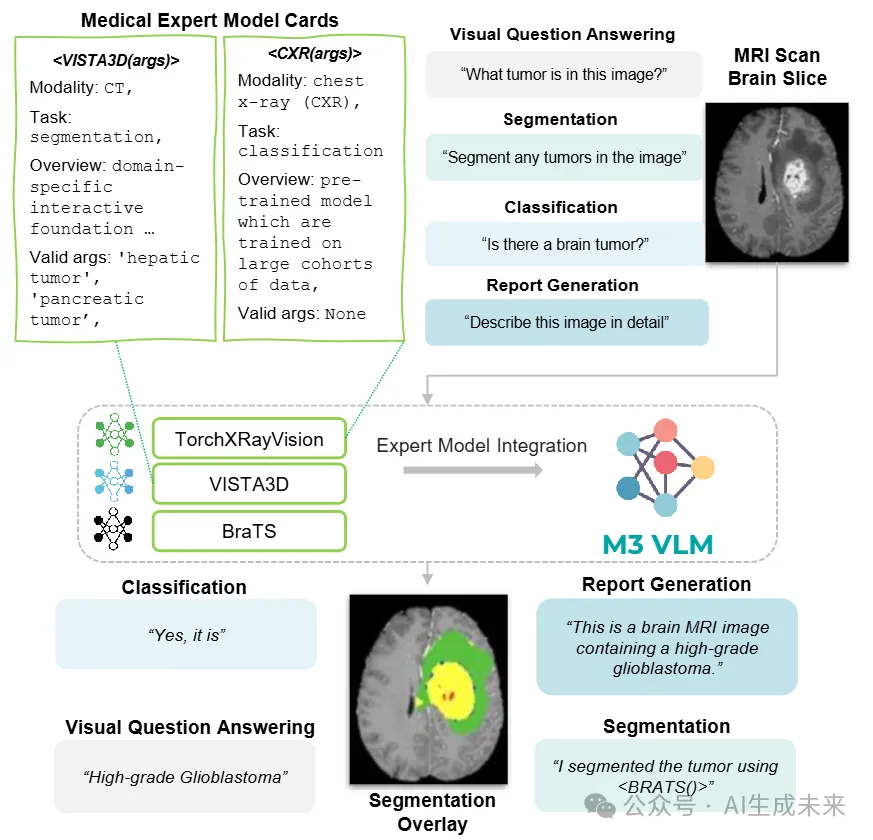

NVILA-M3框架通過整合多個針對特定醫(yī)療任務(wù)的領(lǐng)域?qū)<夷P停岢隽艘环N新的方法,例如圖像分割和分類(下圖8)。這些專家模型旨在提取和解釋一般VLM難以辨識的復(fù)雜特征。通過將這些專業(yè)模型與視覺-語言學(xué)習(xí)范式結(jié)合,NVILA-M3實現(xiàn)了增強的性能,促進了視覺輸入與其文本注釋之間細微關(guān)系的學(xué)習(xí)。這種集成不僅改善了任務(wù)特定的結(jié)果,還為在醫(yī)療領(lǐng)域開發(fā)更強大、更加情境感知的VLM奠定了基礎(chǔ)。

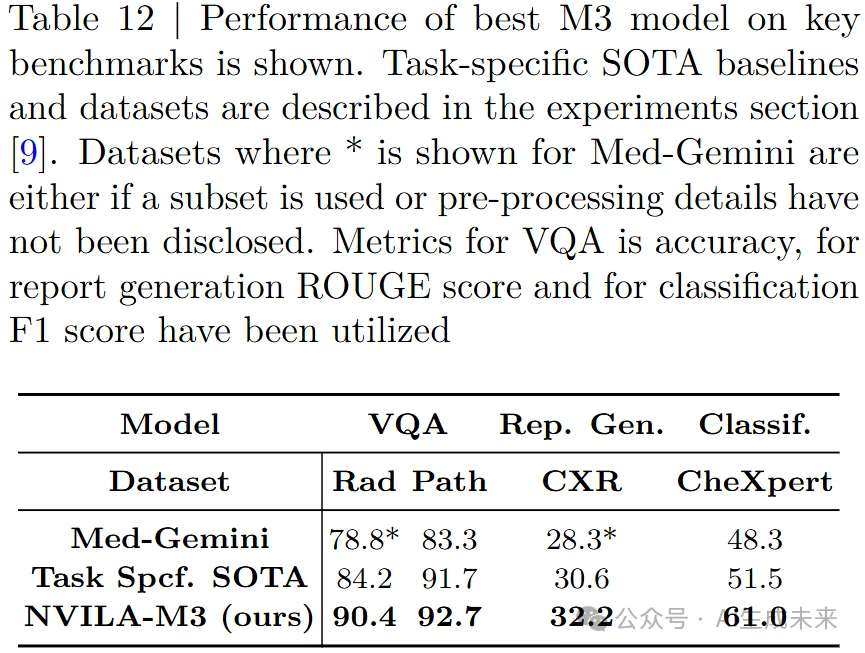

NVILA-M3表明,通過使用專家模型,相比現(xiàn)有的最先進技術(shù),可以實現(xiàn)9%的總體提升,表12中展示了一些關(guān)鍵結(jié)果。這凸顯了利用領(lǐng)域?qū)iL來彌合通用AI能力與專門應(yīng)用需求之間差距的重要性,展示了VLM在精確性和特異性至關(guān)重要的領(lǐng)域中革命化的潛力。

結(jié)論

本文介紹了NVILA,一個旨在實現(xiàn)效率與準確性之間最佳平衡的開放視覺-語言模型(VLM)家族。通過采用“先擴展后壓縮”的范式,NVILA能夠高效地處理高分辨率圖像和長視頻,同時保持高準確性。還在整個生命周期中系統(tǒng)地優(yōu)化了其效率,從訓(xùn)練到微調(diào)再到推理。NVILA提供的性能與當(dāng)前領(lǐng)先的VLM相當(dāng),甚至超越它們,同時在資源使用上顯著更為高效。此外,NVILA為時間定位、機器人導(dǎo)航和醫(yī)學(xué)影像等應(yīng)用開辟了新的可能性。我們將很快發(fā)布我們的模型。希望NVILA能夠幫助研究人員和開發(fā)者充分挖掘其在各個應(yīng)用和研究領(lǐng)域的潛力。

本文轉(zhuǎn)自AI生成未來 ,作者:AI生成未來