為什么最新的LLM使用混合專家(MoE)架構(gòu) 原創(chuàng)

本文詳細(xì)介紹了混合專家 (MoE)架構(gòu),該架構(gòu)通過混合或融合不同的“專家”模型共同解決特定的問題。

專業(yè)化的必要性

醫(yī)院有很多具有不同專長的專家和醫(yī)生,他們擅長解決各自領(lǐng)域內(nèi)的醫(yī)療難題。外科醫(yī)生、心臟病專家、兒科醫(yī)生等各類專家緊密合作,為患者提供了全面而個(gè)性化的醫(yī)療護(hù)理服務(wù)。同樣,人們也可以將這一合作模式應(yīng)用于人工智能領(lǐng)域。

人工智能中的混合專家(MoE)架構(gòu)被定義為不同“專家”模型的混合或融合,能夠共同處理或響應(yīng)復(fù)雜的數(shù)據(jù)輸入。當(dāng)涉及到人工智能時(shí),MoE模型中的每個(gè)專家都專門研究一個(gè)更宏大的問題——就像每位醫(yī)生都專門在其醫(yī)學(xué)領(lǐng)域內(nèi)深耕一樣。這樣的設(shè)計(jì)提高了效率,并增強(qiáng)了系統(tǒng)的有效性和準(zhǔn)確性。

Mistral AI提供的開源基礎(chǔ)大型語言模型(LLM)可以與OpenAI相媲美。并且已經(jīng)在Mixtral 8x7B模型中使用MoE架構(gòu),是一種尖端的大型語言模型(LLM)形式的革命性突破。以下將深入探討Mistral AI的Mixtral為什么在其他基礎(chǔ)LLM中脫穎而出,以及當(dāng)前的LLM現(xiàn)在采用MoE架構(gòu)的原因,并突出其速度、大小和準(zhǔn)確性。

升級LLM的常用方法

為了更好地理解MoE架構(gòu)如何增強(qiáng)LLM,本文將討論提高LLM效率的常用方法。人工智能從業(yè)者和開發(fā)人員通過增加參數(shù)、調(diào)整架構(gòu)或微調(diào)來增強(qiáng)模型。

·增加參數(shù):通過提供更多信息并對其進(jìn)行解釋,模型學(xué)習(xí)和表示復(fù)雜模式的能力得到了提高。這可能會導(dǎo)致過擬合和幻覺,需要從人類反饋中進(jìn)行廣泛的強(qiáng)化學(xué)習(xí)(RLHF)。

- 調(diào)整架構(gòu):引入新的層或模塊可以適應(yīng)不斷增加的參數(shù)數(shù)量,并提高特定任務(wù)的性能。然而,對底層架構(gòu)的更改很難實(shí)現(xiàn)。

- 微調(diào):預(yù)先訓(xùn)練的模型可以根據(jù)特定數(shù)據(jù)或通過遷移學(xué)習(xí)進(jìn)行微調(diào),允許現(xiàn)有的LLM處理新的任務(wù)或領(lǐng)域,而無需從頭開始。這是最簡單的方法,并且不需要對模型進(jìn)行重大更改。

什么是MoE架構(gòu)?

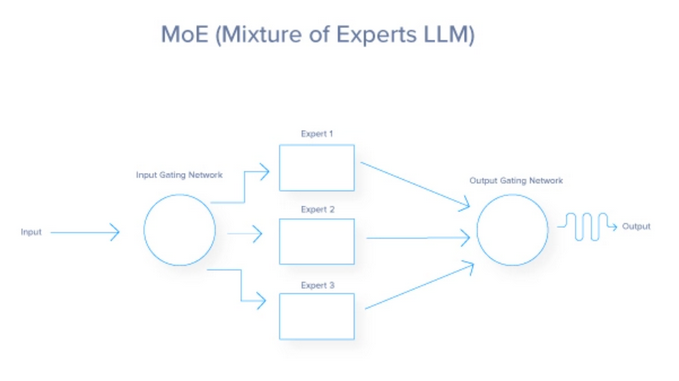

混合專家(MoE)架構(gòu)是一種神經(jīng)網(wǎng)絡(luò)設(shè)計(jì),通過為每個(gè)輸入動態(tài)激活稱為“專家”的專用網(wǎng)絡(luò)子集來提高效率和性能。門控網(wǎng)絡(luò)決定激活哪些專家,導(dǎo)致稀疏激活和減少計(jì)算成本。MoE架構(gòu)由兩個(gè)關(guān)鍵組件組成:門控網(wǎng)絡(luò)和專家網(wǎng)絡(luò)。以下進(jìn)行分析:

從本質(zhì)上來說,MoE架構(gòu)的功能就像一個(gè)高效的交通系統(tǒng),根據(jù)實(shí)時(shí)情況和期望的目的地,將每輛車(或在這種情況下是數(shù)據(jù))導(dǎo)向最佳路線。每個(gè)任務(wù)都被路由到最合適的專門處理該特定任務(wù)的專家或子模型。這種動態(tài)路由確保為每個(gè)任務(wù)使用最有能力的資源,從而提高模型的整體效率和有效性。MoE架構(gòu)利用了三種方法來提高模型的保真度。

(1)通過多個(gè)專家完成任務(wù),MoE通過為每個(gè)專家添加更多參數(shù)來增加模型的參數(shù)大小。

(2)MoE改變了經(jīng)典的神經(jīng)網(wǎng)絡(luò)架構(gòu),它包含了一個(gè)門控網(wǎng)絡(luò),以確定哪些專家被用于指定的任務(wù)。

(3)每個(gè)人工智能模型都有一定程度的微調(diào),因此MoE中的每個(gè)專家都經(jīng)過微調(diào),以達(dá)到傳統(tǒng)模型無法利用的額外調(diào)整層的預(yù)期效果。

MoE門控網(wǎng)絡(luò)

門控網(wǎng)絡(luò)在MoE模型中充當(dāng)決策者或控制器。它評估傳入的任務(wù),并確定哪個(gè)專家適合處理這些任務(wù)。這一決策通常基于學(xué)習(xí)權(quán)值,隨著時(shí)間的推移,通過訓(xùn)練進(jìn)行調(diào)整,進(jìn)一步提高其與專家匹配任務(wù)的能力。門控網(wǎng)絡(luò)可以采用各種策略,從概率方法(將軟任務(wù)分配給多個(gè)專家)到確定性方法(將每個(gè)任務(wù)路由到單個(gè)專家)。

MoE專家

MoE模型中的每個(gè)專家代表一個(gè)較小的神經(jīng)網(wǎng)絡(luò)、機(jī)器學(xué)習(xí)模型或針對問題域的特定子集優(yōu)化的LLM。例如,在Mistral中,不同的專家可能專注于理解某些語言、方言,甚至是查詢類型。專業(yè)化確保每個(gè)專家都精通自己的領(lǐng)域,當(dāng)結(jié)合其他專家的貢獻(xiàn)時(shí),將在廣泛的任務(wù)上實(shí)現(xiàn)卓越的性能。

MoE損失函數(shù)

雖然損失函數(shù)不被視為是MoE架構(gòu)的主要組成部分,但它在模型的未來性能中起著關(guān)鍵作用,因?yàn)樗辉O(shè)計(jì)用于優(yōu)化單個(gè)專家和門控網(wǎng)絡(luò)。

它通常結(jié)合每個(gè)專家計(jì)算的損失,這些損失由門控網(wǎng)絡(luò)分配給他們的概率或重要性進(jìn)行加權(quán)。這有助于在調(diào)整門控網(wǎng)絡(luò)以提高路由準(zhǔn)確性的同時(shí),對專家的特定任務(wù)進(jìn)行微調(diào)。

從始至終的MoE流程

現(xiàn)在總結(jié)MoE整個(gè)流程,并添加更多細(xì)節(jié)。

以下是對路由過程從始至終如何工作的總結(jié)解釋:

- 輸入處理:輸入數(shù)據(jù)的初始處理;主要是在LLM案例中的提示。

- 特征提取:轉(zhuǎn)換原始輸入進(jìn)行分析。

- 門控網(wǎng)絡(luò)評估:通過概率或權(quán)重評估專家的適用性。

- 加權(quán)路由:根據(jù)計(jì)算的權(quán)重分配輸入;在這里,已經(jīng)完成最合適的LLM流程的選擇。在某些情況下,選擇多個(gè)LLM來回答單個(gè)輸入。

- 任務(wù)執(zhí)行:處理每個(gè)專家分配的輸入。

- 整合專家輸出:將各個(gè)專家的結(jié)果結(jié)合起來,形成最終輸出。

- 反饋和適應(yīng):使用性能反饋來改進(jìn)模型。

- 迭代優(yōu)化:不斷優(yōu)化路線和模型參數(shù)。

使用MoE架構(gòu)的流行模型

OpenAI的GPT-4和GPT-40

GPT-4和GPT-40支持ChatGPT的高級版本。這些多模態(tài)模型利用MoE來攝取不同的源媒體,例如圖像、文本和語音。有傳言稱,GPT-4有8個(gè)專家,每個(gè)專家擁有2200億個(gè)參數(shù),整個(gè)模型的參數(shù)總數(shù)超過1.7萬億個(gè)。

Mistral AI的Mixtral 8x7b

Mistral AI 提供了非常強(qiáng)大的開源 AI 模型,并表示他們的 Mixtral 模型是一個(gè) sMoE 模型或稀疏多專家混合模型,以較小的封裝形式提供。Mixtral 8x7b總共有467億個(gè)參數(shù),但每個(gè)令牌只使用129億個(gè)參數(shù),因此以這個(gè)成本處理輸入和輸出。他們的MoE模型一直優(yōu)于Llama2 (70B)和GPT-3.5 (175B),同時(shí)運(yùn)行成本更低。

MoE的好處以及是首選架構(gòu)的原因

最終,MoE架構(gòu)的主要目標(biāo)是呈現(xiàn)復(fù)雜機(jī)器學(xué)習(xí)任務(wù)處理方式的范式轉(zhuǎn)變。它提供了獨(dú)特的優(yōu)勢,并在幾個(gè)方面展示了其優(yōu)于傳統(tǒng)模式的優(yōu)勢。

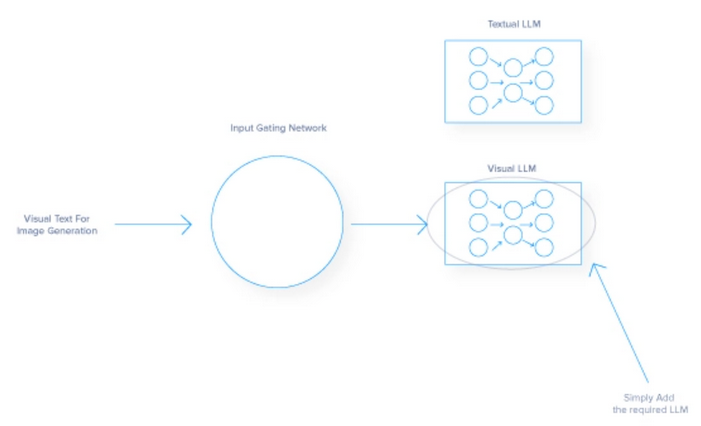

增強(qiáng)的模型可擴(kuò)展性

- 每個(gè)專家負(fù)責(zé)任務(wù)的一部分,因此通過增加專家來擴(kuò)展不會導(dǎo)致計(jì)算需求的成比例增加。

- 這種模塊化方法可以處理更大、更多樣化的數(shù)據(jù)集,并促進(jìn)并行處理,加快操作速度。例如,將圖像識別模型添加到基于文本的模型中可以集成額外的LLM專家來解釋圖像,同時(shí)仍然能夠輸出文本。

- 多功能性允許模型在不同類型的數(shù)據(jù)輸入中擴(kuò)展其功能。

提高效率和靈活性

- MoE模型非常高效,與傳統(tǒng)架構(gòu)使用所有參數(shù)不同,MoE模型只有選擇地只讓必要的專家參與特定的輸入。

- 該架構(gòu)減少了每次推理的計(jì)算負(fù)荷,允許模型適應(yīng)不同的數(shù)據(jù)類型和專門的任務(wù)。

專業(yè)化和準(zhǔn)確性

- MoE系統(tǒng)中的每個(gè)專家都可以針對整體問題的特定方面進(jìn)行微調(diào),從而在這些領(lǐng)域獲得更高的專業(yè)知識和準(zhǔn)確性

- 像這樣的專業(yè)化在醫(yī)學(xué)成像或財(cái)務(wù)預(yù)測等領(lǐng)域很有幫助,在這些領(lǐng)域,精確度是關(guān)鍵。

- MoE可以在范圍狹窄的領(lǐng)域產(chǎn)生更好的結(jié)果,因?yàn)樗屑?xì)致入微的理解,詳細(xì)的知識,以及在專門任務(wù)上優(yōu)于通才模型的能力。

MoE架構(gòu)的缺點(diǎn)

雖然MoE架構(gòu)提供了顯著的優(yōu)勢,但它也帶來了可能影響其采用和有效性的挑戰(zhàn)。

- 模型復(fù)雜性:管理多個(gè)神經(jīng)網(wǎng)絡(luò)專家和用于引導(dǎo)流量的門控網(wǎng)絡(luò)使MoE的開發(fā)和運(yùn)營成本具有挑戰(zhàn)性。

- 訓(xùn)練穩(wěn)定性:門控網(wǎng)絡(luò)和專家之間的相互作用引入了不可預(yù)測的動態(tài),阻礙了實(shí)現(xiàn)統(tǒng)一的學(xué)習(xí)率,需要廣泛的超參數(shù)調(diào)整。

- 不平衡:讓專家閑置是對MoE模型的糟糕優(yōu)化,將資源花費(fèi)在不使用的專家身上或過于依賴某些專家。平衡工作負(fù)載分布和調(diào)優(yōu)有效門對于高性能MoE AI至關(guān)重要。

應(yīng)該注意的是,隨著MoE架構(gòu)的改進(jìn),上述缺點(diǎn)通常會隨著時(shí)間的推移而減少。

專業(yè)化塑造的未來

反思MoE方法及其與人類的相似之處,可以看到,正如專業(yè)團(tuán)隊(duì)比一般勞動力取得更多成就一樣,專業(yè)模型在人工智能模型中的表現(xiàn)也優(yōu)于單一模型。優(yōu)先考慮多樣性和專業(yè)知識可以將大規(guī)模問題的復(fù)雜性轉(zhuǎn)化為專家可以有效解決的可管理部分。

當(dāng)展望未來時(shí),需要考慮專業(yè)系統(tǒng)在推進(jìn)其他技術(shù)方面的更廣泛影響。MoE的原則可以影響醫(yī)療保健、金融和自治系統(tǒng)等行業(yè)的發(fā)展,促進(jìn)更高效、更準(zhǔn)確的解決方案。

MoE的旅程才剛剛開始,其持續(xù)發(fā)展有望推動人工智能及其他領(lǐng)域的進(jìn)一步創(chuàng)新。隨著高性能硬件的不斷發(fā)展,這種專家AI的混合體可以在人們的智能手機(jī)中運(yùn)行,將提供更智能的體驗(yàn),但首先需要有人去訓(xùn)練它們。

原文標(biāo)題:Why the Newest LLMs Use a MoE (Mixture of Experts) Architecture

作者:Kevin Vu

文章鏈接:https://dzone.com/articles/why-the-newest-llms-use-a-moe-mixture-of-experts。