當ChatGPT爆火后,大語言模型LLM的完整修煉之路 | 為什么說AI Agent還不夠?

1、當ChatGPT爆火后,大語言模型LLM的完整修煉之路

圖片

圖片

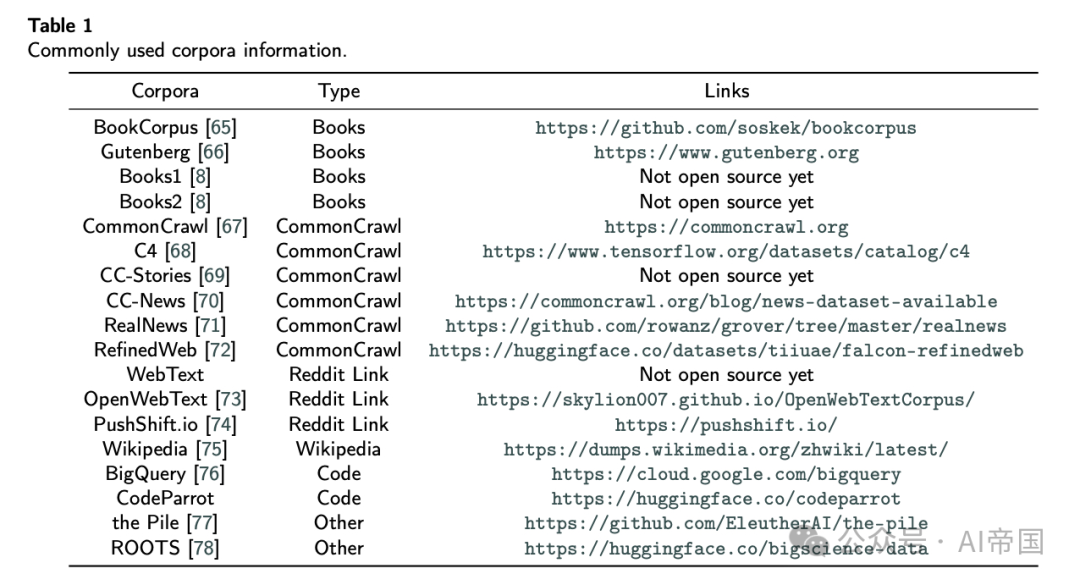

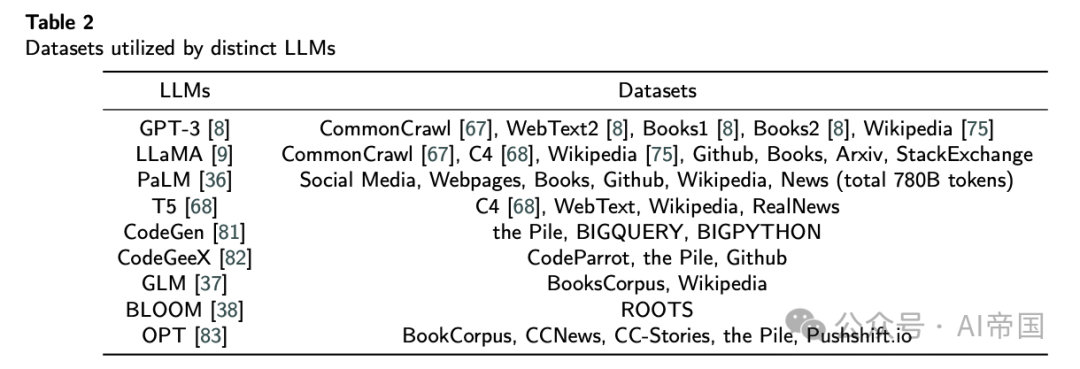

從ChatGPT橫空出世以來,大語言模型(LLM)已經成為了AI領域最炙手可熱的研究方向。最近發表的這篇綜述性論文為我們全面解析了LLM從訓練到推理的完整技術路線圖。

圖片

圖片

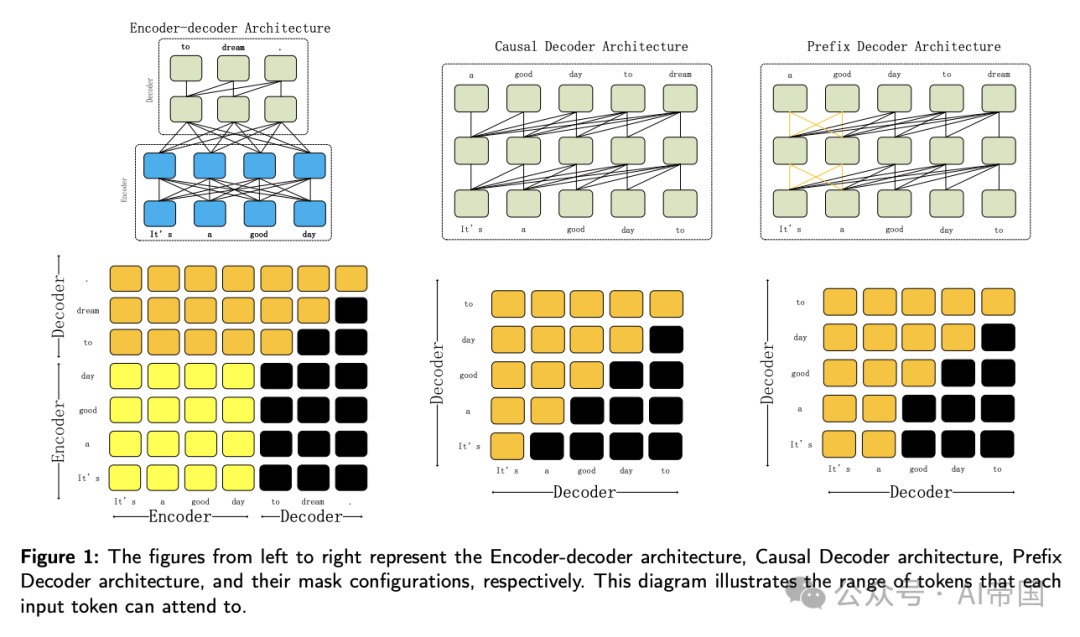

縱觀LLM的發展歷程,我們見證了一個重要的技術演進過程:從最早的統計語言模型(SLM),到基于神經網絡的語言模型(NLM),再到以ELMo為代表的預訓練語言模型(PLM)。而真正的突破性進展,則是Transformer架構的出現。這個支持并行計算的自注意力機制,讓模型可以輕松實現規模化擴展,為后來GPT系列等大模型的誕生鋪平了道路。

圖片

圖片

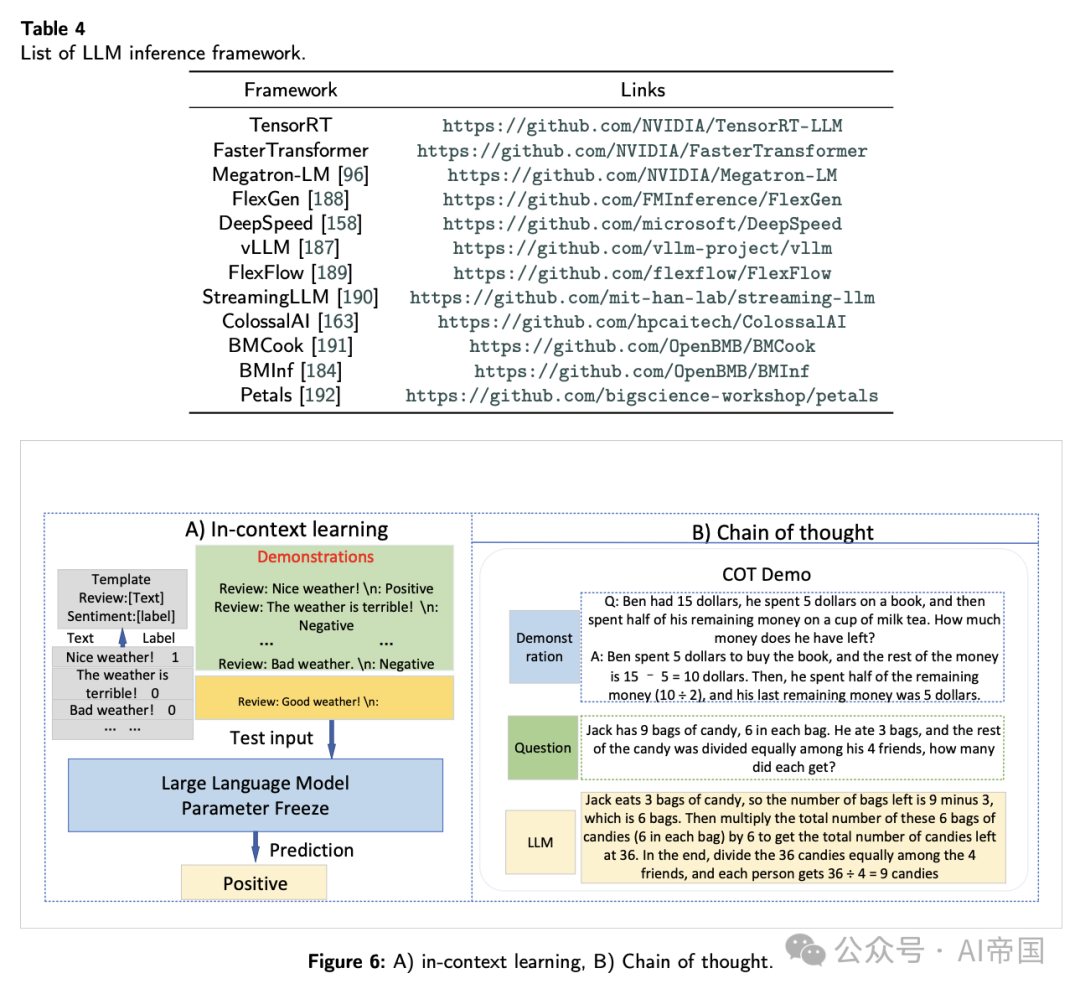

有趣的是,隨著模型規模的不斷擴大(通常超過60-100億參數),研究人員發現了一個令人驚嘆的現象:模型會突然展現出"涌現"能力。它不僅能生成高質量文本,還具備了強大的學習和推理能力,甚至可以通過上下文學習(ICL)來完成少樣本學習任務。這也解釋了為什么ChatGPT能在各類下游任務中展現出如此出色的表現。

圖片

圖片

圖片

圖片

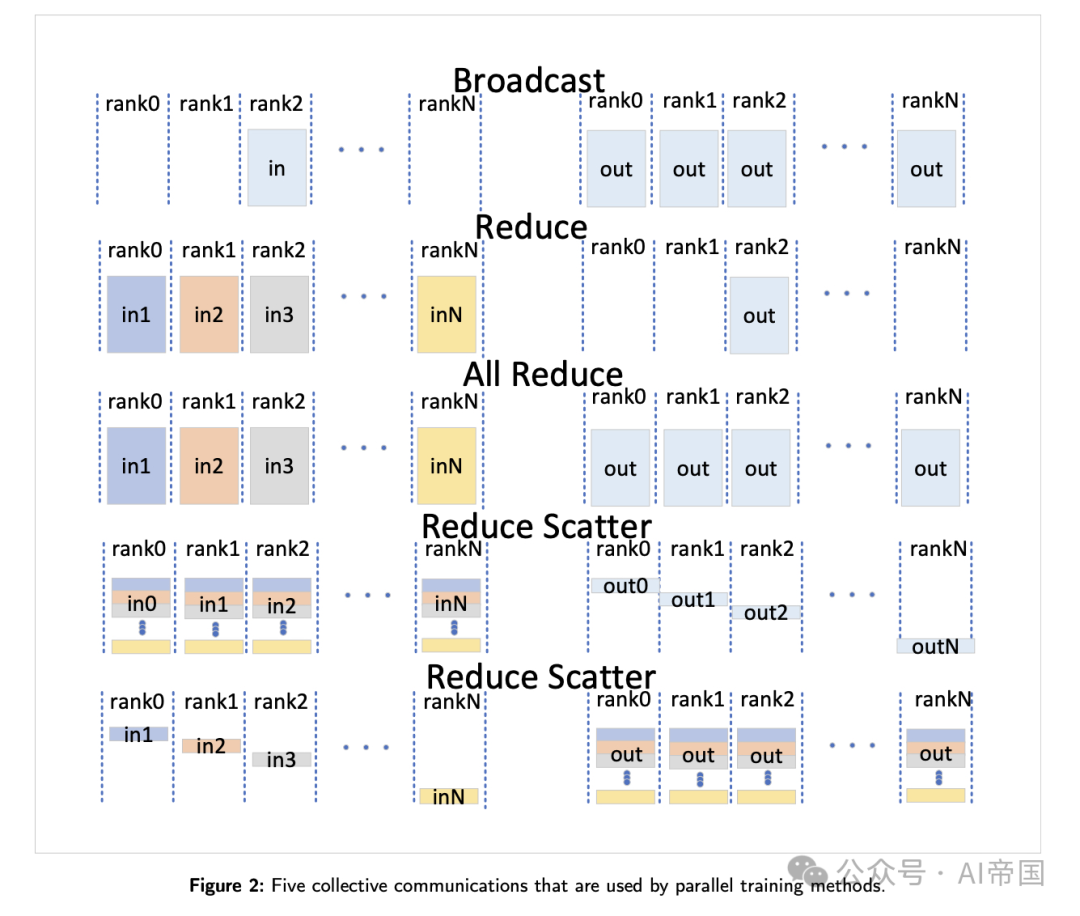

不過,訓練和部署LLM并非易事。論文指出,這需要處理海量數據的專業知識和豐富的分布式并行訓練經驗。未來的發展趨勢將更加注重降本增效:在訓練端,重點關注數據預處理、訓練架構優化、預訓練任務設計等;在推理端,則致力于模型壓縮、并行計算和內存調度等技術創新。這些都將是推動LLM技術繼續演進的關鍵。

圖片

圖片

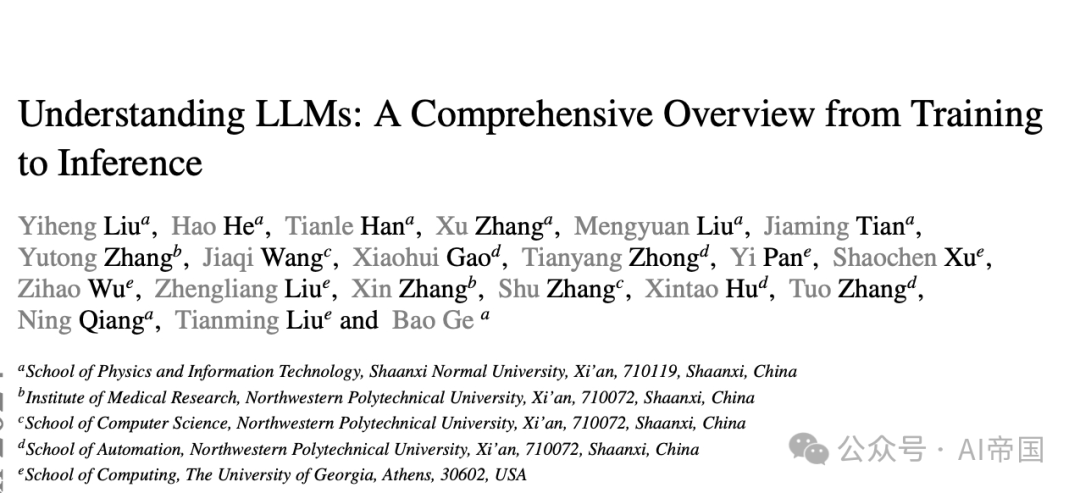

論文標題:Understanding LLMs: A Comprehensive Overview from Training to Inference

論文鏈接:??https://arxiv.org/abs/2401.02038??

2、為什么說AI Agent還不夠?一文讀懂下一代智能助手的關鍵缺陷

圖片

圖片

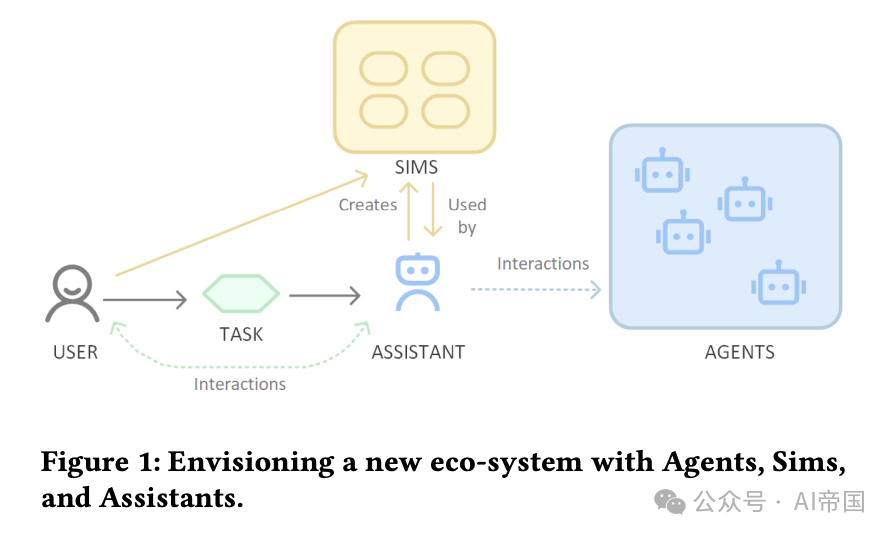

近期AI Agent成為了行業熱點,但一篇最新發表的研究論文指出,僅僅依靠能力更強的AI Agent并不足以解決目前面臨的根本性問題。研究團隊深入分析了當前AI Agent存在的局限性,并提出了一個全新的生態系統解決方案。

圖片

圖片

傳統的AI Agent在執行任務時往往需要頻繁的人工干預,難以適應不同用戶的個性化需求,同時在隱私保護和可信度方面也存在明顯短板。論文提出,要建立一個包含Agents(執行具體任務)、Sims(代表用戶偏好和行為)以及Assistants(直接與用戶交互并協調任務執行)三個核心組件的新型生態系統。

這個創新的生態系統設計獨特之處在于:Agents負責執行專門的任務,Sims作為用戶的數字化表征可以攜帶用戶偏好和隱私設置,而Assistants則作為私密版本的agent,深入理解用戶需求并靈活調用Sims和Agents來完成任務。這種分層架構不僅能提供個性化服務,還能確保用戶隱私和系統可信度。

研究人員預測,未來可能會出現類似應用商店的"agent商店",提供經過驗證的各類agents供用戶或其Assistants調用。但成功的關鍵在于確保整個生態系統的標準化、社會接受度以及持續的價值創造。這需要在技術創新的基礎上,更加注重用戶體驗、信任建設和社會規范的融合。

論文標題:Agents Are Not Enough

論文鏈接:???https://www.arxiv.org/abs/2412.16241??

本文轉載自 ??AI帝國??,作者: 無影寺