LG開源韓語大模型Exaone 3.0,8萬億token訓練數據

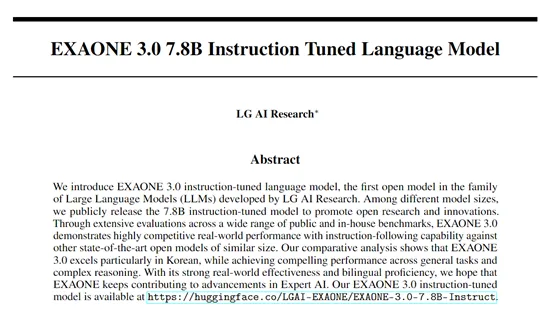

LG的AI研究機構開源了首個開放權重的大模型——EXAONE 3.0。

EXAONE 3.0是一個指令微調模型有78億參數,經過了8萬億token高質量數據進行了綜合訓練。支持韓語和英文兩種語言,尤其是對韓語的支持非常出色。

在KMMLU、KoBEST - BoolQ、KoBEST – COPA等基準測試中,高于Llama 3.1-8B、Gemma 2-9B等知名開源模型。

開源地址:https://huggingface.co/LGAI-EXAONE/EXAONE-3.0-7.8B-Instruct

論文地址:https://arxiv.org/abs/2408.03541

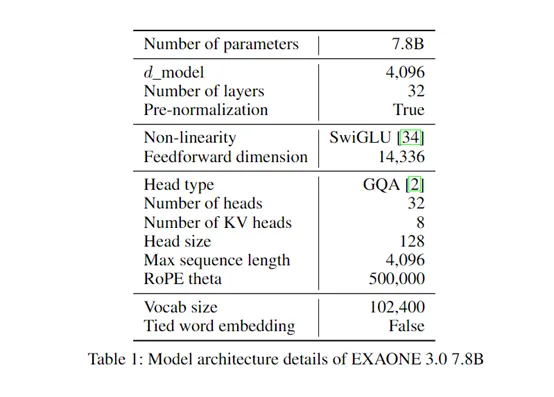

EXAONE 3.0使用了目前主流的解碼器僅變換器架構,與傳統變換器相比,摒棄了編碼器部分,專注于通過解碼器生成輸出序列,減少了模型的復雜性,同時提高了處理長距離依賴關系的能力。

在上下文長度方面,EXAONE 3.0支持4,096 token,使得模型能夠同時處理和記憶高達4,096個連續token的信息,極大地增強了其在理解語言連貫性方面的能力,在生成文本、翻譯、摘要等提供了更好的生成、解讀能力。

EXAONE 3.0還使用了RoPE和GQA來提升對長序列數據的處理能力。RoPE能夠有效地編碼位置信息,幫助模型理解文本中單詞的順序關系,對于處理長文本序列非常重要。而GQA則有助于提高模型對不同查詢的關注能力,使其能夠更準確地聚焦于關鍵信息,從而提升模型的性能。

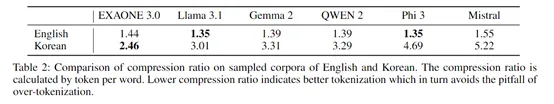

為了更好地處理韓語數據,研究人員使用MeCab對韓語語料進行預標記,然后從零開始訓練BBPE標記器,詞匯量為102400。與其他標記器相比,這種設計在英語上實現了相似的壓縮比,但在韓語上的壓縮比更低。

壓縮比越低意味著標記器為每個單詞生成的標記更少,這有助于避免過度標記化的問題。對于韓語這種具有粘著結構的語言來說,單詞可以通過組合多個詞素形成,減少標記數量可以更好地保留語言的結構和語義信息。

EXAONE 3.0的預訓練一共包含兩個階段:第一階段使用了6萬億token的數據,以優化在一般領域的能力表現;第二階段,進一步接受了額外2萬億token的訓練,重點放在提高語言技巧和專業知識上。

為了達到這一目標,研究團隊重新平衡了數據分布,增加專家領域數據的比例,并通過創建分類器來評估數據質量,確保高價值數據的有效利用。

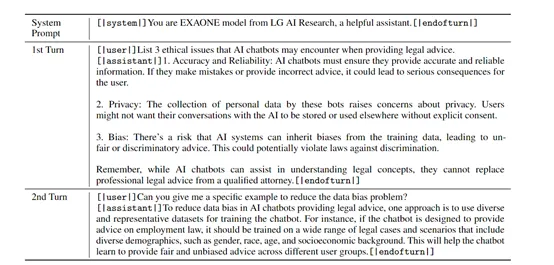

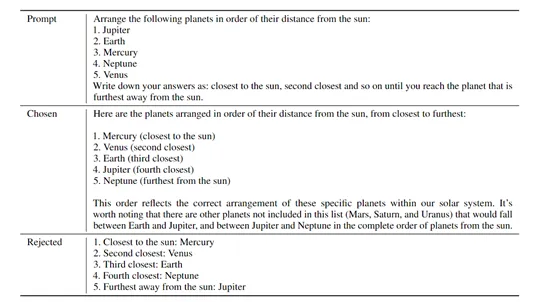

在優化階段,為了增強EXAONE 3.0 模型的指令跟隨能力,LG的研究人員使用了SFT(監督微調)和DPO(直接偏好優化)。

SFT階段涉及創建高質量的指令調優數據,通過定義廣泛的服務導向指令和話題,制作出能夠模擬真實用戶交互的多輪對話數據集。

在DPO優化階段,模型通過人類反饋進行調整,以最大化在偏好數據集中選定和拒絕響應之間的獎勵差異,這一過程包括離線DPO和在線DPO兩個步驟,前者利用預構建的偏好數據進行模型訓練,后者則通過動態配置與離線學習數據分布相似的提示,持續優化模型性能。

為了評估EXAONE 3.0的性能,研究人員在MT-Bench、Arena-Hard-v0.1、WildBench和AlpacaEval 2.0 LC等基準平臺進行了綜合測試。

結果顯示,EXAONE 3.0在韓語和英語雙測試中,其數學、編碼、推理等能力,超過了Llama 3.1 8B、Gemma 2 9B、Phi 3 7B等知名模型。如果你想開發專門用于韓語的類ChatGPT生成式AI應用,使用Exaone 3.0是一個不錯的選擇。

本文轉自 AIGC開放社區 ,作者: AIGC開放社區