大模型的核心之一——大模型預訓練之數(shù)據(jù)預處理 原創(chuàng)

“ 訓練數(shù)據(jù)的好壞,直接影響到大模型的推理質量”

影響大模型質量的原因除了機器學習模型(模型的架構)的之外,更重要的一點就是大模型的訓練數(shù)據(jù)。從某些方面來說,訓練數(shù)據(jù)的質量直接決定大模型的好壞。

那么怎么才能從繁雜的數(shù)據(jù)中梳理出一批高質量的訓練數(shù)據(jù)是一個值得考慮的問題。

大模型訓練數(shù)據(jù)的準備

準備一個合格的大模型訓練數(shù)據(jù)集是一個關鍵且復雜的過程,直接影響到模型的表現(xiàn)。

下面是詳細的步驟,以及需要注意的點:

確定任務目標

有句老話叫:“有的放矢”,首先要明確你的任務和目標,才能知道你需要什么樣的數(shù)據(jù),然后應該怎么準備數(shù)據(jù),這是一切的開始。

任務類型:明確模型需要解決的任務類型,如文本生成,圖像處理,語義理解等

目標:確定模型的預期輸出,定義準確度,精度等評價標準

數(shù)據(jù)收集

數(shù)據(jù)收集同樣包括多個方面,比如數(shù)據(jù)來源,數(shù)據(jù)的多樣性,數(shù)據(jù)量等。

數(shù)據(jù)來源:數(shù)據(jù)來源包括公開數(shù)據(jù)集,如維基百科,網(wǎng)絡論壇等;企業(yè)內部數(shù)據(jù)集,利用公司內部的日志,文檔,數(shù)據(jù)庫等;還有就是自采集數(shù)據(jù)集,如網(wǎng)絡爬蟲,接口(API)等。

數(shù)據(jù)多樣性:確保數(shù)據(jù)覆蓋足夠廣泛的場景和樣本,避免模型過擬合特定領域

數(shù)據(jù)量:大模型通常需要海量數(shù)據(jù),通常在百萬級以上;因此數(shù)據(jù)存儲也是一個問題

數(shù)據(jù)清洗

數(shù)據(jù)清洗是數(shù)據(jù)處理中的重要環(huán)節(jié),由于數(shù)據(jù)源頭不一,直接導致數(shù)據(jù)質量參差不齊,因此必須要做好數(shù)據(jù)清洗。

去重:移除重復的樣本,確保數(shù)據(jù)多樣性

去噪:過濾掉無意義的數(shù)據(jù),如廣告,拼寫錯誤,噪聲圖像等

統(tǒng)一格式:確保所有數(shù)據(jù)采用一致的編碼格式(如UTF-8),并且統(tǒng)一時間,日前等標準格式

數(shù)據(jù)修復:修正數(shù)據(jù)中的錯誤,如拼寫,補全等

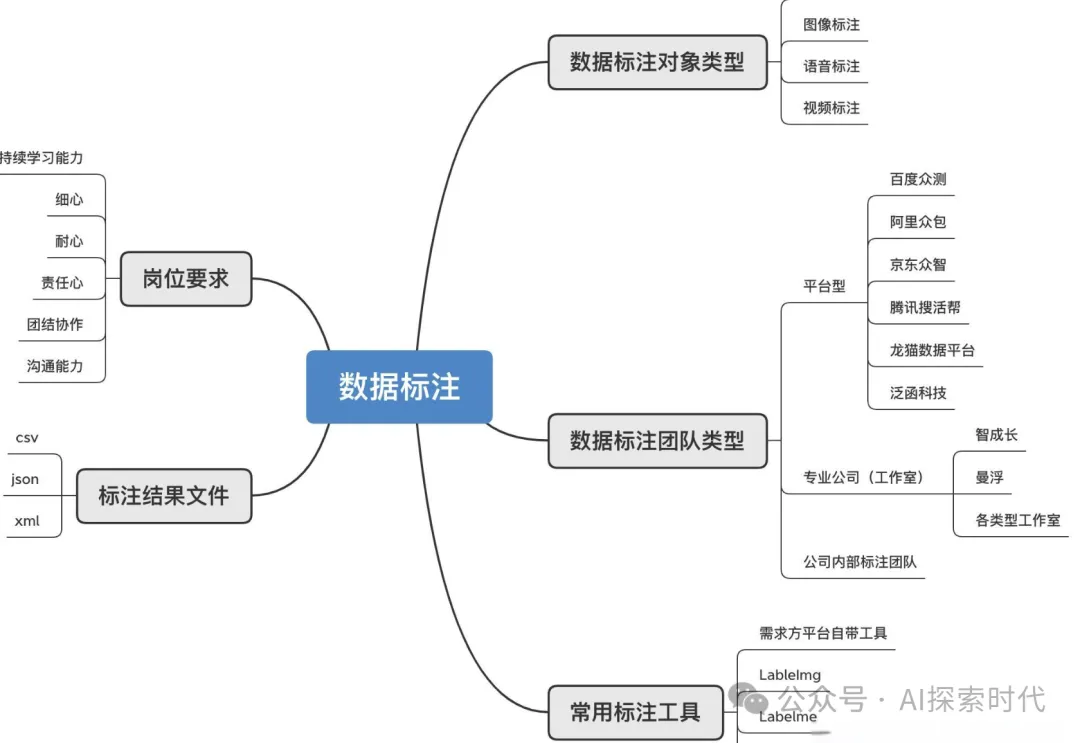

數(shù)據(jù)標注

數(shù)據(jù)標注需要注意多種情況,標注類型,標注質量,一致性檢查等。

標注類型有文本標注,如命名體識別,情感分析等;圖像標注,如物體邊界框,圖像分類標簽等

標注質量:使用自動化工具初步標注,然后進行人工審核和修正

一致性檢查:確保標注的一致性和準確性,尤其是多人標注時

數(shù)據(jù)增強

文本增強:如同義詞轉換,數(shù)據(jù)回譯,隨機插入和刪除單詞等

圖像增強:如旋轉,裁剪,顏色調整等

目的:通過數(shù)據(jù)增強來增加樣本多樣性,提高模型等泛化能力

數(shù)據(jù)分割

數(shù)據(jù)集要分為訓練集,驗證集和測試集,通常按8:1:1的比例分割數(shù)據(jù),確保數(shù)據(jù)集之間沒有交叉

平衡性:確保各個數(shù)據(jù)集中類別分布的一致性,避免類別不平衡問題

數(shù)據(jù)處理與轉換

文本處理:文本處理分為分詞和詞嵌入兩種形式。

分詞:根據(jù)任務要求選擇適當?shù)姆衷~工具(如BPE,WordPiece);

詞嵌入:將分詞后的文本轉換為向量(如Word2Vec,GloVe等)

圖像處理:圖像處理也有兩種方式,歸一化和尺寸調整

歸一化:將像素值歸一化到一個合理的范圍

尺寸調整:統(tǒng)一圖像尺寸,便于批處理

特征提取:特征提取是根據(jù)任務需求提取特征,如文本的n-gram特征或圖像的邊緣化特征

數(shù)據(jù)存儲與管理

存儲格式:文本使用json,csv,parquet等格式;圖像使用jpeg,png等格式

存儲系統(tǒng):使用HDFS,S3,數(shù)據(jù)倉庫/數(shù)據(jù)湖等分布式存儲系統(tǒng)來管理大規(guī)模數(shù)據(jù)

版本控制:對數(shù)據(jù)集進行版本控制,確保每次實驗的可重復性

數(shù)據(jù)隱私與合規(guī)性

隱私保護:確保數(shù)據(jù)處理過程中遵循數(shù)據(jù)隱私法規(guī)(如GDPR)。

合規(guī)性:數(shù)據(jù)的收集、存儲和使用必須符合相關法律法規(guī)

數(shù)據(jù)加載和預處理

數(shù)據(jù)加載器:實現(xiàn)高效的數(shù)據(jù)加載機制,如PyTorch的DataLoader或TensorFlow的tf.data。

在線預處理:在加載數(shù)據(jù)時進行必要的預處理操作,如歸一化、標準化等

注意事項

數(shù)據(jù)偏差:確保數(shù)據(jù)的代表性,避免模型學習到偏見或不平衡。

質量控制:持續(xù)監(jiān)控數(shù)據(jù)質量,定期清理和更新數(shù)據(jù)集。

標注一致性:標注工作中應保持一致性,避免同一類問題不同處理方式。

隱私與合規(guī)性:在所有數(shù)據(jù)處理階段都應嚴格遵守相關法規(guī),確保數(shù)據(jù)安全

總結

通過精心設計的步驟和嚴格的質量控制,可以確保大模型的訓練數(shù)據(jù)高質量、多樣性和合法性,從而為后續(xù)模型訓練提供堅實的基礎

本文轉載自公眾號AI探索時代 作者:DFires

原文鏈接:??https://mp.weixin.qq.com/s/bx8eLxIWghSIAqSf2CfH5g??