最高加速超4倍!不依賴特定模型的統一模型壓縮框架CPD發布 精華

文章鏈接:https://arxiv.org/pdf/2408.03046

git鏈接:https://github.com/Cranken/CPD

亮點直擊

- 提出統一模型壓縮框架:包含梳理、剪枝和蒸餾三個步驟,其中梳理步驟提取架構依賴,使剪枝不依賴特定模型。

- 結合剪枝與知識蒸餾:研究了這兩者的結合,進一步提升剪枝后模型的性能。

- 性能提升與效率優化:通過與基線模型對比,展示了在性能可接受的前提下顯著提高模型效率,如在ResNet-50上實現了超過2倍的加速效果。

輕量且高效的模型對于資源有限的設備(如自動駕駛車輛)至關重要。結構化剪枝提供了一種有前途的模型壓縮和效率提升方法。然而,現有方法通常將剪枝技術與特定的模型架構或視覺任務綁定在一起。為了解決這一局限性,本文提出了一種新穎的統一剪枝框架:Comb, Prune, Distill (CPD),它同時解決了模型無關和任務無關的問題。本文的框架采用梳理步驟來解決分層層次依賴問題,從而實現架構獨立性。此外,剪枝流程根據重要性評分指標自適應地移除參數,無論視覺任務是什么。為了支持模型保留其學習到的信息,在剪枝步驟中引入了知識蒸餾。廣泛的實驗表明,本文的框架具有廣泛的適用性,包括卷積神經網絡(CNN)和Transformer模型,以及圖像分類和分割任務。在圖像分類中,實現了最高4.3倍的加速,準確率損失為1.8%;在語義分割中,最高加速達1.89倍,mIoU損失為5.1%。

方法

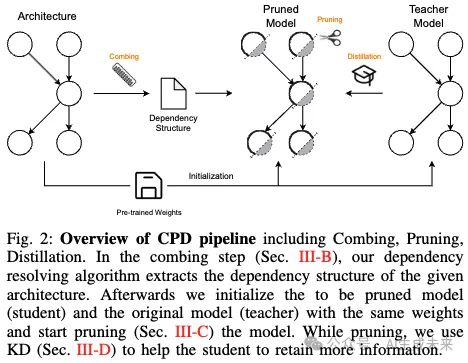

A. 框架概述

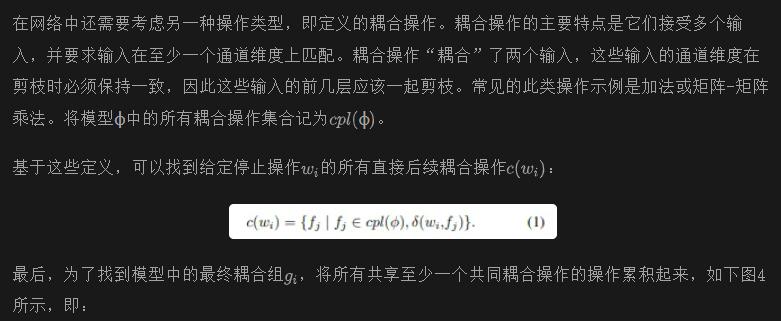

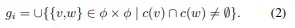

下圖2展示了本文方法的概述。本文的方法依賴于三個組件的結合。如前所述,需要確保輸入到模型中特定操作(如加法和乘法)的維度匹配。為此,引入了一種分層依賴解析算法,旨在檢測這些依賴關系。該算法生成了一組耦合組,其中包括需要同時剪枝的參數以保持一致的通道維度。

基于這些耦合組,可以開始對給定模型進行剪枝。不是隨機選擇一個組并剪枝其中的神經元,而是使用基于Hessian的重要性評分對神經元進行排序,根據其重要性在每次迭代中移除最不重要的神經元。為了輔助剪枝并保持預測性能,還研究了將知識蒸餾與模型的任務特定損失結合使用。

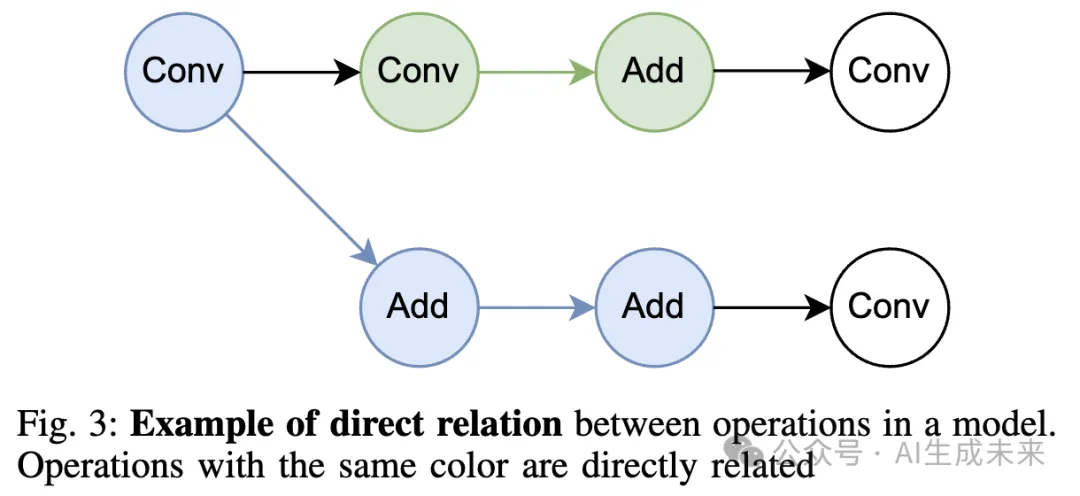

B. 梳理流程

此時,這些耦合組僅用于指定在給定剪枝步驟中哪些操作的輸出通道應一起剪枝。然而,每個耦合組中的操作也有一組直接后續操作。這些后續操作依賴于其前一個操作的輸出通道維度,從而導致固有的輸出依賴性。因此,還必須剪枝后續操作的輸入通道維度,以確保層之間輸入和權重的一致性。

C. 剪枝流程

一旦依賴解析算法識別出耦合組,模型的剪枝過程就可以開始。首先,需要決定在給定的剪枝步驟中要移除哪些操作和通道。為此,采用了一種基于Hessian的重要性評分方法,該方法量化了參數或通道對模型預測性能的重要性。為了在減少模型規模的同時保留性能,通過結合知識蒸餾來增強剪枝過程,使用未剪枝的模型作為教師模型。

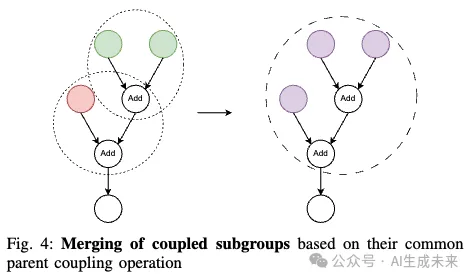

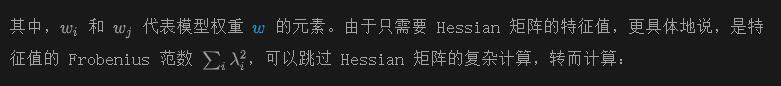

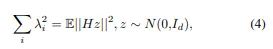

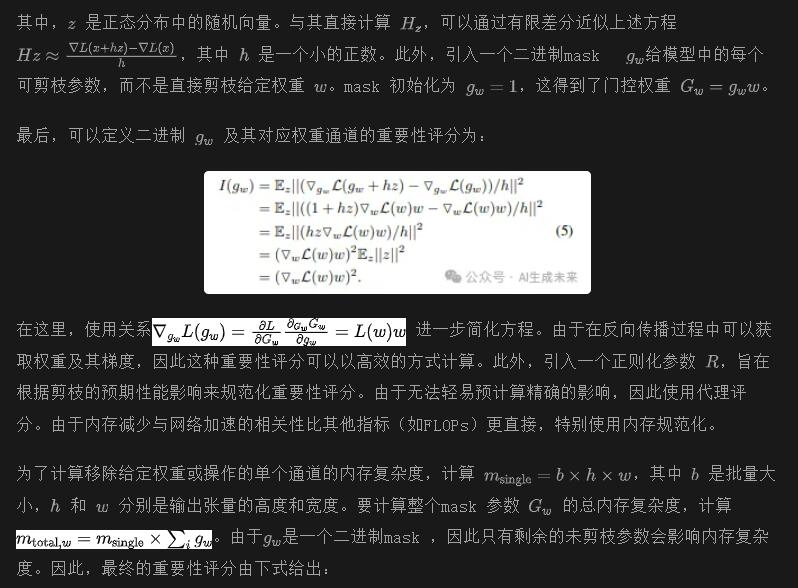

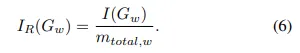

重要性評分。盡管從模型中隨機移除參數可能會取得一定的成功,但采用系統的參數排序和選擇策略被證明是一種更有效的方法。這些策略通過給定模型量化參數的重要性。為此,已經提出了多種重要性評分方法。在這項工作中,選擇基于Hessian重要性評分的貪婪策略。需要注意的是,本文的剪枝方法獨立于實際的重要性評分。本文提出了一種基于Hessian的重要性函數,因為它在剪枝中效果顯著。研究表明,損失函數的平坦曲率輪廓對剪枝引入的小擾動更具抵抗力。巧合的是,損失函數的曲率輪廓對應于Hessian矩陣的特征值集合。對于給定的損失函數L,Hessian矩陣定義為

模型剪枝。通過制定一種對模型中神經元重要性進行排名的方法,可以逐步掩蔽它們,直到達到所需的總體剪枝參數閾值。為此,采用貪婪策略,在固定的訓練迭代間隔內剪枝參數。在這個間隔內,計算反向傳播過程中的每個神經元的重要性評分,并在整個間隔內累積這些評分。由于不僅僅剪枝單個神經元,而是剪枝神經元組,因此在迭代結束時匯總個別評分,以計算整個組的重要性評分。最后,通過掩蔽移除剪枝間隔內重要性最低的神經元組,即重要性評分最低的組。

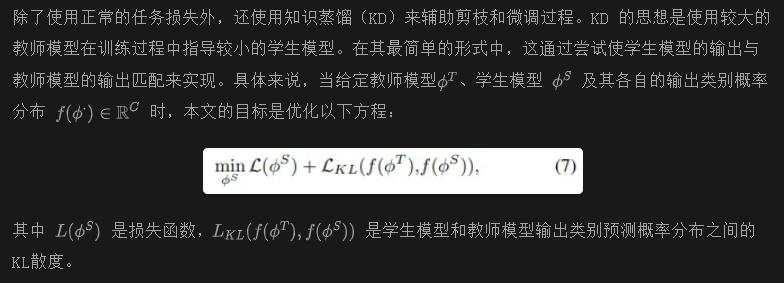

D. 知識蒸餾

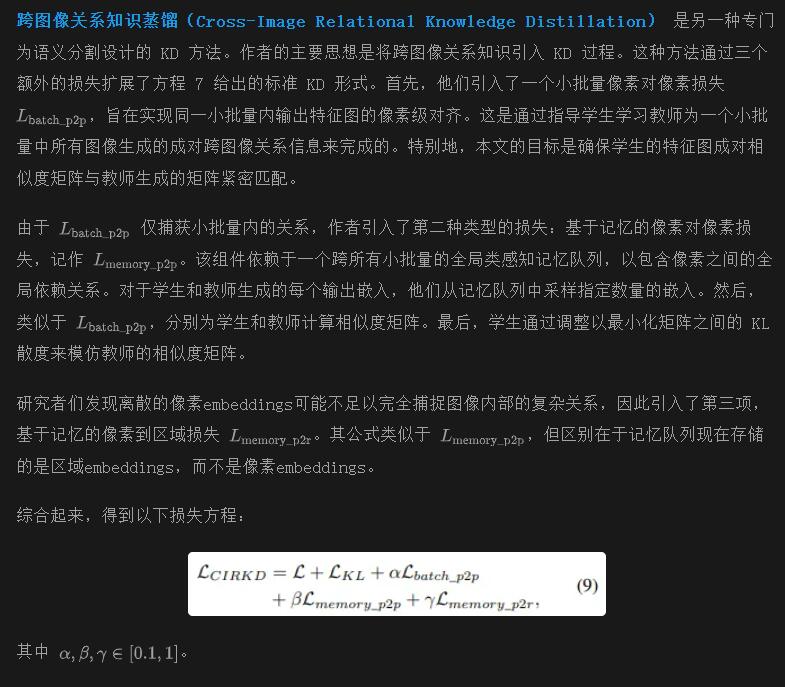

?繼承了基本形式的 vanilla KD,已經引入了各種基于 logit 的 KD 框架,以對齊教師和學生模型的輸出,同時消除結構冗余。選擇其中一些工作來研究它們在與本文提出的剪枝流程相結合時的適用性和普遍性。這意味著嚴格關注模型無關的 KD 方法,并排除例如 transformer 特定的 KD 方法。相反,在實驗中包括任務特定的 KD,因為它不會影響本文剪枝流程的普遍性。

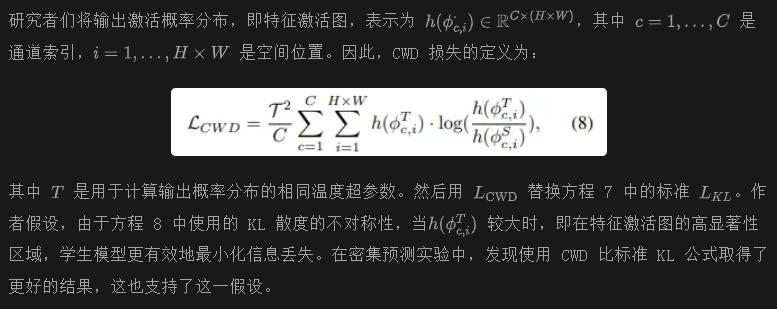

通道級知識蒸餾(CWD) 用于密集預測任務。與基本的基于 KL 的蒸餾方法相比,CWD 的主要區別在于最小化通道級輸出概率分布之間的 KL 距離。具體而言,CWD 不僅計算每個類別概率之間的 KL 距離,而是以通道級的方式計算每個像素的 KL 距離。

實驗

A. 設置

實現細節。實驗中使用的模型來自 MMPretrain 和 MMSegmentation 的現成模型。所有訓練和評估均在 NVIDIA GeForce RTX 2080 Ti GPU 上進行。為了訓練和微調模型,使用了相應模型作者提供的原始配置。

數據集。在 ImageNet 數據集上進行實驗,以評估不同架構的性能。為了驗證本文在密集預測任務(如語義分割)上的剪枝方法,使用了 ADE20K 數據集。該數據集包含150種不同類別的物體和背景,分為超過 2 萬張訓練圖像、2 千張驗證圖像和 3 千張測試圖像。此外,本文還使用該數據集進行剪枝過程中的知識蒸餾(KD)消融研究。

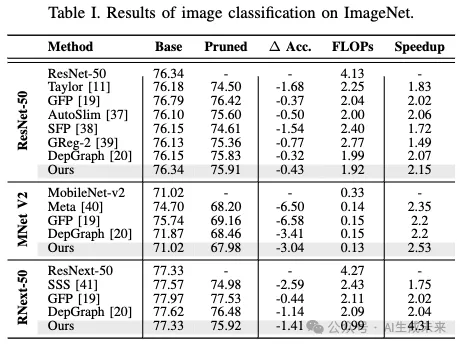

B. 圖像分類

下表 I 展示了本文剪枝方法與之前最先進方法的對比結果。為了展示本文方法的廣泛適用性,選擇了幾種架構不同的模型進行測試,包括使用殘差連接的ResNet、使用深度卷積的MobileNet-v2,以及使用分組卷積的ResNext。結果表明,本文的方法結合了簡單的剪枝標準與知識蒸餾(KD),在保持精度損失在可接受范圍內的同時,達到了或超越了當前最先進的剪枝方法,實現了超過2.15倍的加速效果。以ResNext-50為例,甚至將FLOPs(浮點運算次數)減少了4.31倍,精度僅相對下降了1.8%。

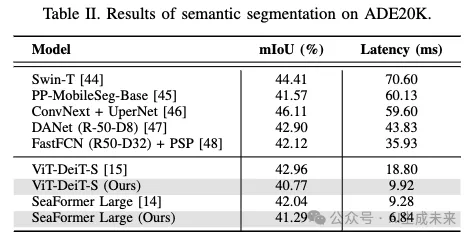

C. 語義分割

在ADE20K數據集上評估了SeaFormer和ViT模型的語義分割性能。在下表II中,所有實驗均使用了通道級知識蒸餾(CWD)作為本文的蒸餾方法。例如,將ViT-DeiT-S的延遲降低了47%以上。對于SeaFormer-L,雖然只實現了26%的延遲改進,但性能損失更小,僅為1.7%。延遲是在導出的ONNX模型上測量的,以模擬真實世界的使用場景。每個結果都是在大量(n≥1000)評估中計算出的平均延遲。

D. 消融研究

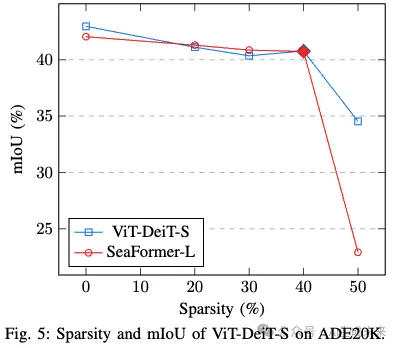

稀疏性與性能的權衡。在下圖 5 中,展示了稀疏性對模型預測性能的影響。稀疏性計算為模型中去除的參數的相對百分比。在這個例子中,使用了 CWD KD 和 ViT-DeiT-S 模型。可以觀察到性能在稀疏性達到約 40% 之前有一個預期的、相對穩定的下降,然后準確率出現了相當大的下降。其他模型也可以觀察到類似的行為,盡管稀疏性的臨界點可能會根據模型的不同而發生在更低或更高的值。假設臨界點可能會隨著原始模型的大小而變化,即較大的模型往往在較高的稀疏性下出現這一臨界點,而較小的模型則相反。

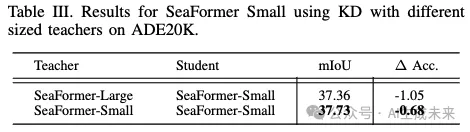

教師選擇的影響。由于許多模型提供不同的架構變體,測試了使用同一家族中的更大教師模型的優勢,而不是使用相同的未剪枝模型作為教師。下表 III 顯示,在實驗中,本文的方法可以使用未剪枝模型,而不是更大的教師模型。

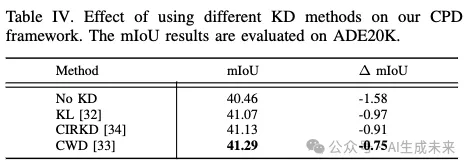

KD 方法的影響。為了測試不同的 KD 方法,選擇使用 SeaFormer-Large 作為 ADE20K 數據集上的基線。在下表 IV 的實驗中,發現使用 CWD 進行剪枝時保留了原始模型最多的性能。在剪枝實驗中,發現 CWD 比 CIRKD 表現更好。假設這是因為在剪枝過程中,使用的是已經預訓練的模型作為起點,而不是從未訓練的學生模型開始。因此,CIRKD 關注的更多的全局語義信息已經由模型學習到,并且在剪枝過程中保持了這些信息,同時去除了較小的細節。因此,理論上認為,在剪枝過程中,KD 的最重要部分是確保沒有細節丟失。

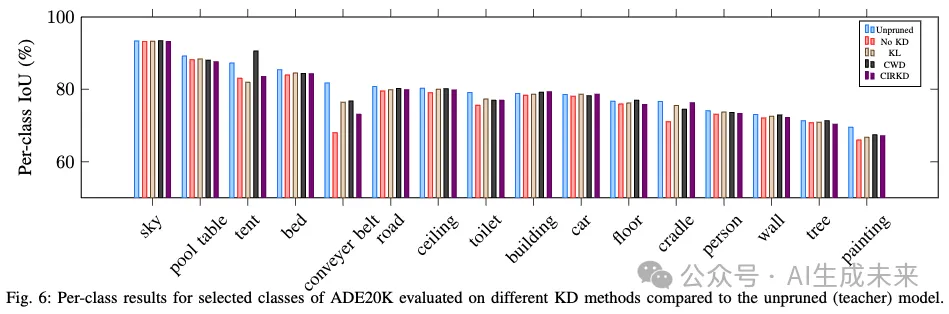

下圖 6 顯示了在 ADE20K 數據集上不同 KD 方法的一些單獨類別得分。由于類別數量眾多,本文選擇了未剪枝教師模型中 mIoU 最高的 16 個類別。每種 KD 方法在模型稀疏性為 20% 時進行了評估。可以觀察到,無論 KD 方法如何,剪枝模型的性能通常與其未剪枝的教師模型相似。KD 方法的選擇似乎對單獨類別的性能沒有大的影響,因為剪枝模型中的類別得分相似。與未剪枝模型相比,最大的差異出現在較小和不常見的類別上。在這些類別中,也可以測量到 KD 方法之間的最大差異。

結論

本文提出了一個新穎的統一模型壓縮框架,稱為 CPD,包含三個主要步驟:梳理、剪枝和蒸餾。為了克服以前依賴于網絡架構的模型特定剪枝方法的局限性,本文的框架結合了一個依賴關系解析算法,確保其靈活性,可以應用于各種架構。此外,將知識蒸餾(KD)結合到框架中,以改善剪枝后的模型。本文展示了與以前的最先進方法相比,在剪枝過程中使用 KD 可以提高模型的性能保留。對兩個數據集的廣泛實驗證明了 CPD 框架的有效性。

本文轉自 AI生成未來 ,作者:Ruiping Liu等