ECCV`24 | 少步比多步好?TurboEdit:少步擴散和解耦控制的實時精確圖像編輯 精華

論文鏈接:https://arxiv.org/pdf/2408.08332

亮點直擊

- 提出一個反演網絡,該網絡通過預測噪聲來重建輸入圖像,并被訓練為在前一步重建的條件下迭代地校正重建圖像。

- 對擴散蒸餾過程的一種新興特性進行分析。

- 方法在反演過程中只需要 8 次功能評估(一次性成本),每次編輯只需 4 次功能評估,而基于多步擴散模型的方法在反演中需要 50 次功能評估,每次編輯需要 30-50 次功能評估。本文方法速度顯著提升(每次編輯小于 0.5 秒,而不是大于 3 秒),且在描述性和指令性文本提示設置中,在文本圖像對齊和背景保留方面表現出比基于多步擴散模型的方法更好的效果。

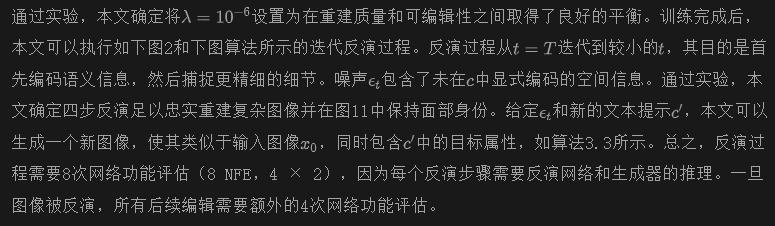

本文解決了在少步擴散模型中精確圖像反演和分解圖像編輯的挑戰。本文引入了一種基于編碼器的迭代反演技術。反演網絡以輸入圖像和前一步的重建圖像為條件,允許對下一步的重建進行修正,使其更接近輸入圖像。本文展示了在少步擴散模型中,通過對(自動生成的)詳細文本提示進行條件化,可以輕松實現分解控制。為了操控反演后的圖像,本文凍結噪聲圖,并修改文本提示中的一個屬性(可以手動修改,也可以通過大型語言模型驅動的指令編輯),從而生成一個與輸入圖像相似但僅改變了一個屬性的新圖像。該方法還可以進一步控制編輯強度并接受指導性文本提示。本文的方法能夠實時實現逼真的文本引導圖像編輯,反演只需進行8次功能評估(一次性成本),每次編輯僅需4次功能評估。本文的方法不僅快速,而且顯著優于現有的多步擴散編輯技術。

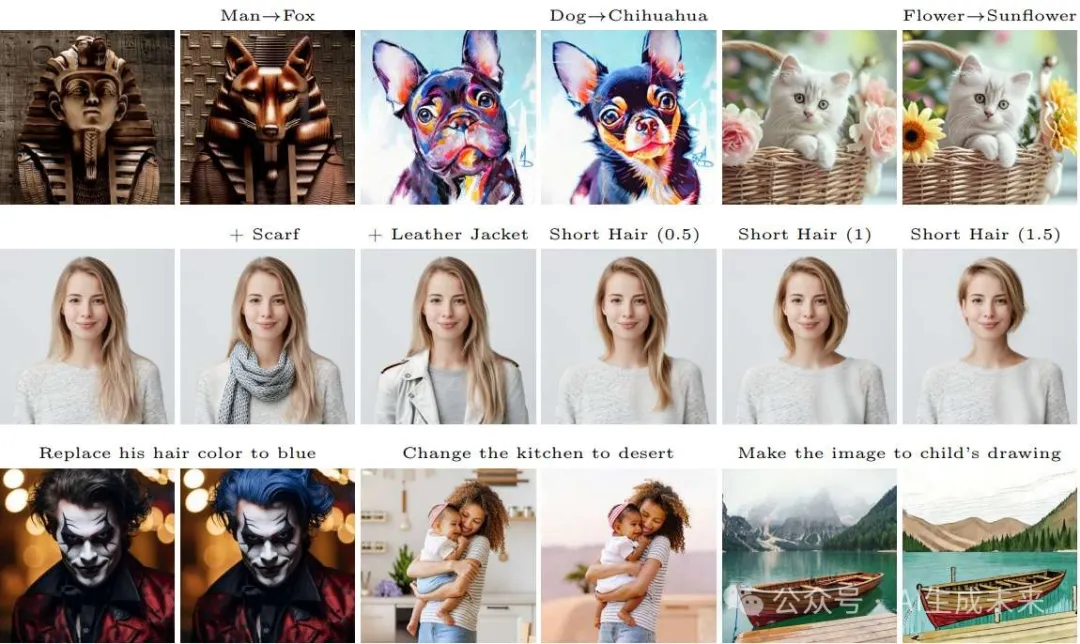

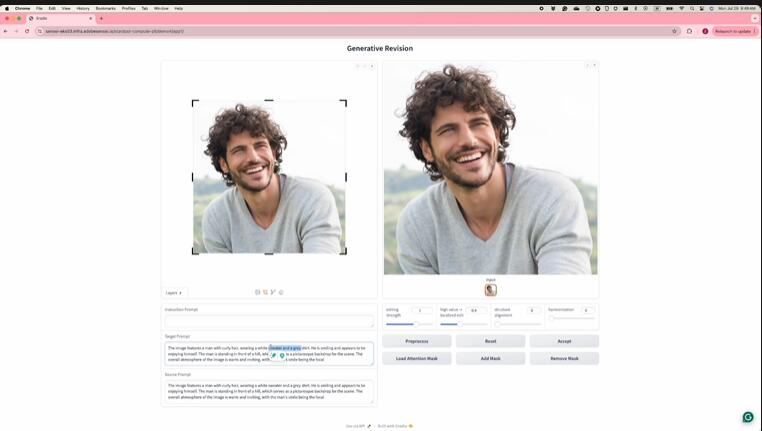

demo展示

方法

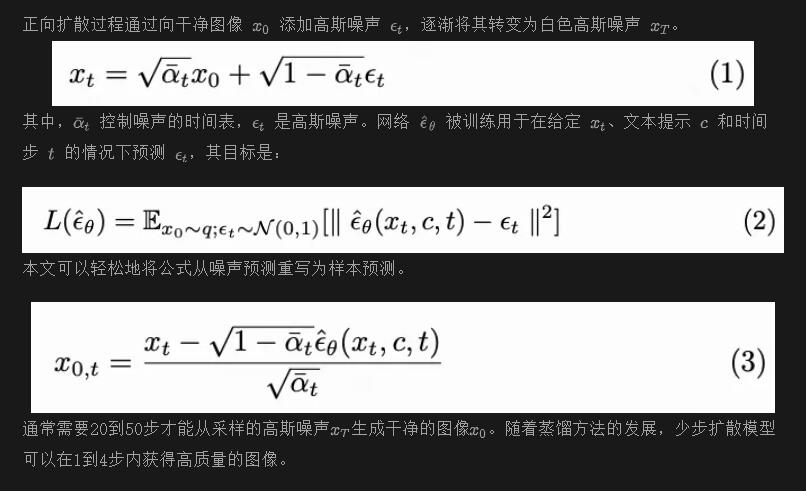

預備知識

單步圖像反演

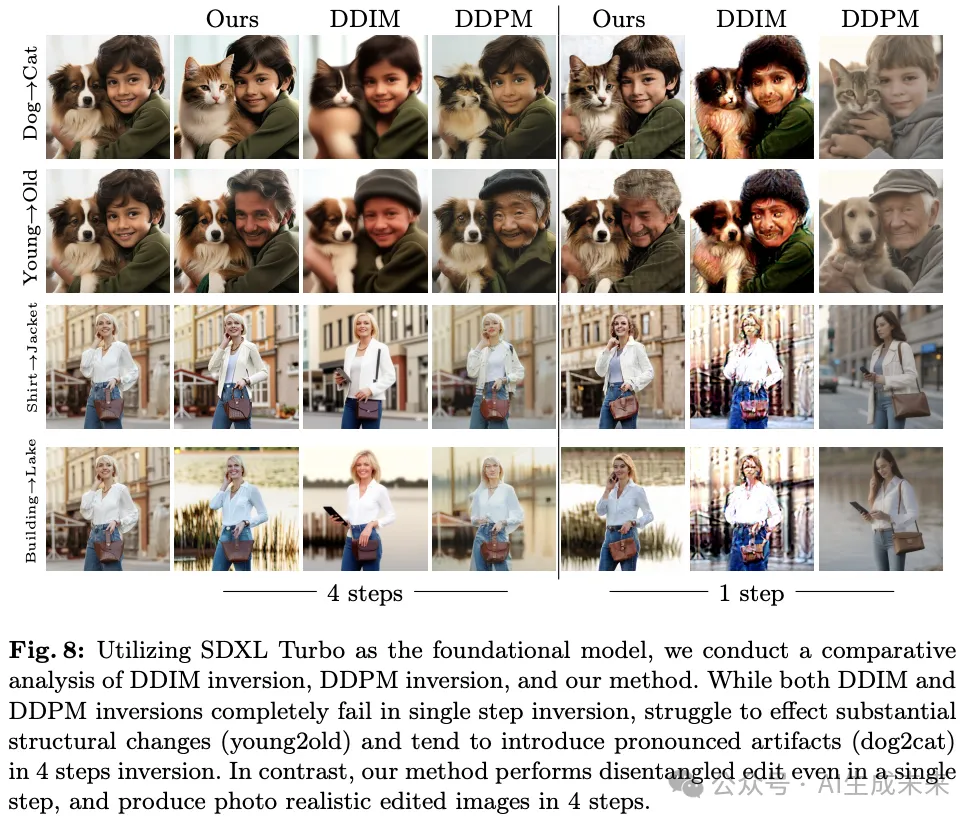

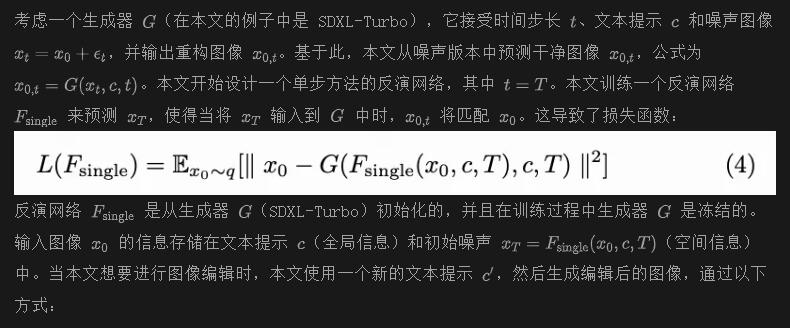

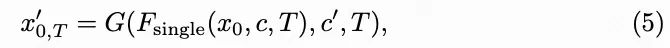

基于擴散的方法在真實圖像編輯中已顯示出實現高質量分解編輯的有希望結果。然而,這些依賴于多步擴散模型的方法由于其計算需求而受到限制,每次編輯至少需要4-5秒,使其不適合交互式應用。此外,由于設計上的根本差異,這些方法無法直接應用于少步擴散模型。例如,許多基于擴散的編輯方法依賴于DDIM反演或DDPM反演將真實圖像投射到擴散噪聲空間。然而,DDIM反演對小步長和大量反演步驟的要求本質上與少步擴散模型的設計原則相悖。而DDPM反演則容易對輸入圖像進行過擬合,并在編輯后的圖像中產生大量偽影。如下圖8所示,當應用于少步反演步驟時,DDIM和DDPM反演都產生次優的編輯結果。

一些研究利用對抗性損失來蒸餾多步擴散模型,使少步擴散模型的優化目標類似于GANs。這啟發本文借鑒GAN反演文獻中的思想,在那里基于編碼器的方法已被證明是高效且可靠的。

盡管單步編碼器方法簡單,但它能夠在保持背景細節的同時進行令人印象深刻的語義編輯,其性能優于DDIM和DDPM反演方法,并成為上圖8中唯一可行的單步反演選項。然而,其結果在諸如手部和面部區域會出現偽影。生成的圖像缺乏清晰度,包含鹽和胡椒噪聲,未能達到照片級真實感。為了解決這個問題,本文將方法擴展到多步反演。

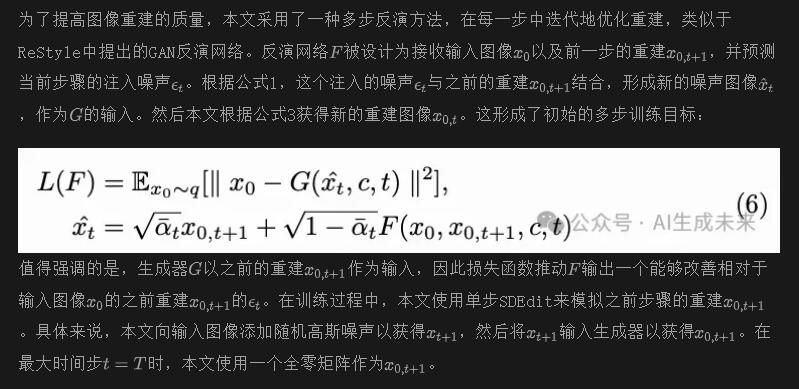

多步圖像反演

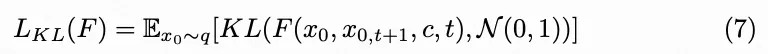

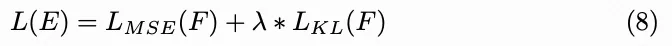

本文的分析顯示,這個模型的簡單實現會導致預測的噪聲包含許多高值(> 10)以及來自輸入圖像的過多結構信息,進而在重建圖像中產生偽影。此外,更改文本提示對輸出圖像的影響很小。為了解決這些問題,本文采用了重參數化技巧,將注入噪聲限制在接近標準高斯分布的范圍內。反演網絡不再直接預測注入噪聲的值,而是輸出每個像素的均值和方差,從中采樣出注入的噪聲。這個修改所需的KL損失為:

這得出了最終的訓練目標:

詳細文字提示條件

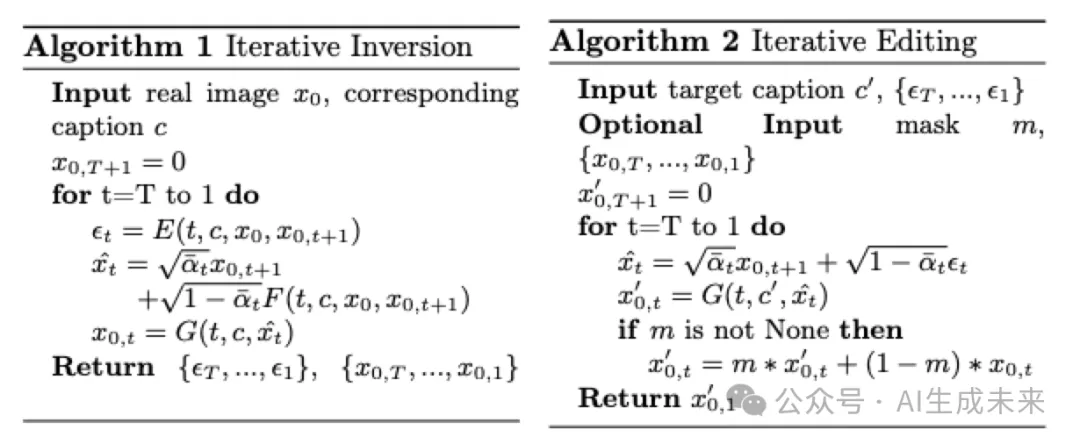

注意力驅動的圖像編輯方法通過凍結自注意力和交叉注意力圖來保持源圖像和目標圖像之間的結構相似性。盡管它們在常規多步擴散模型中表現良好,但本文發現它在單步或四步擴散模型中過度限制了目標圖像的結構,并傾向于在下圖9中產生偽影。

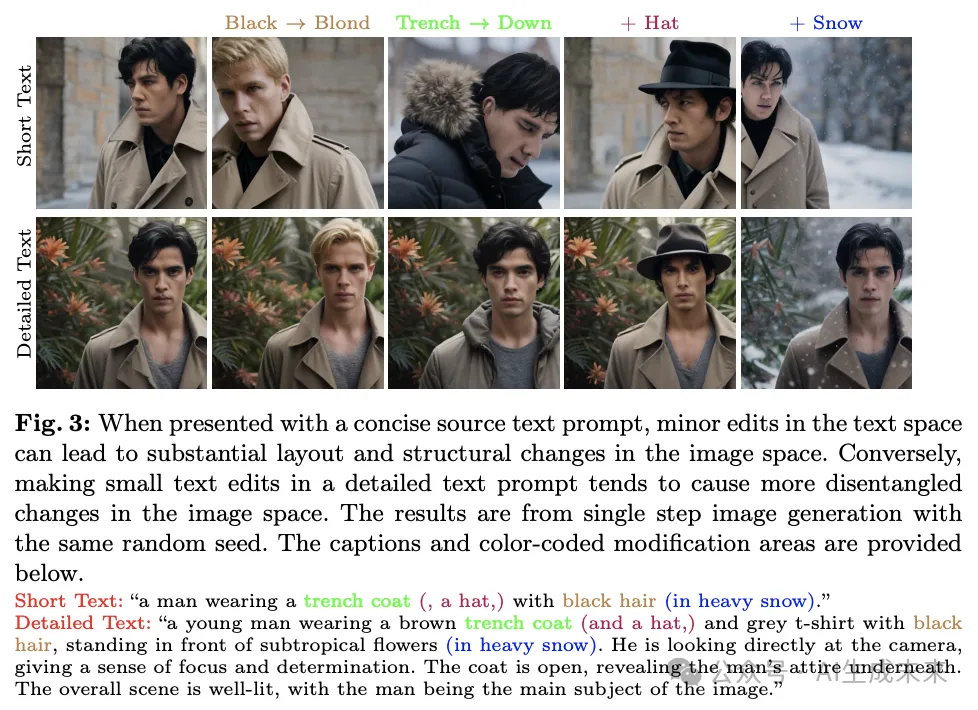

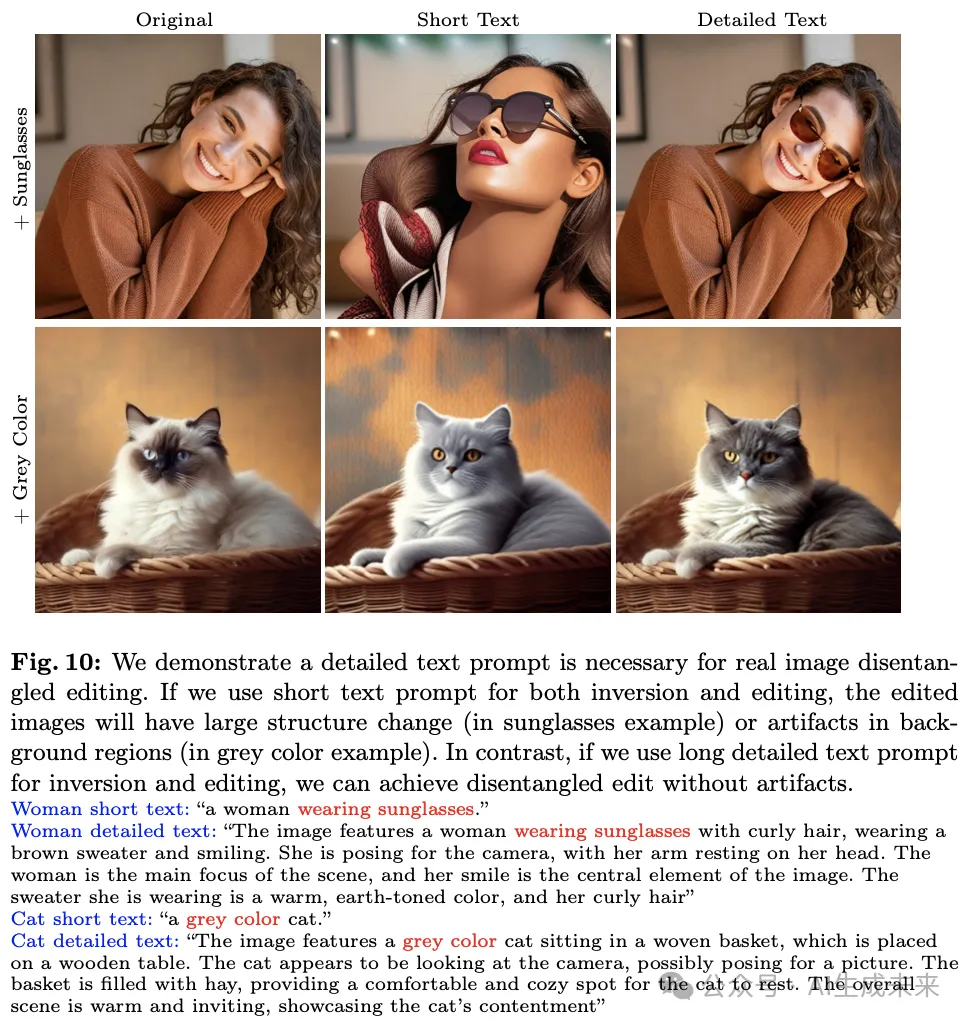

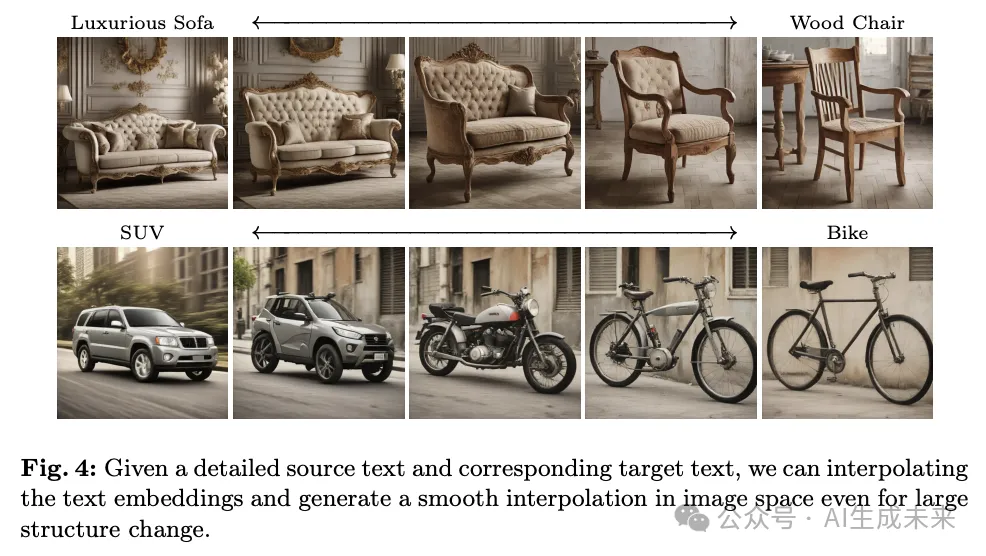

為了在少步擴散模型中實現文本引導的圖像編輯,本文提出了一種極其簡單的方法。本文的直覺是,如果文本提示非常詳細并涵蓋了各個方面的語義信息,那么在文本提示中修改單個屬性只會導致文本embedding的微小變化。因此,源和目標采樣軌跡保持足夠接近,從而生成的圖像幾乎相同,除了下圖3中修改的屬性。同樣的直覺也適用于本文在下圖10中展示的真實圖像編輯。此外,本文可以線性插值詳細的源和目標文本embedding,并在圖像空間中生成平滑的插值,如上圖1和下圖4所示。盡管用戶很難編寫長文本提示,但本文可以輕松利用ChatGPT來擴展簡短的文本提示(例如,“請詳細描述一張{用戶提供的簡短描述}的圖像”),或者使用LLaVA生成給定圖像的詳細描述。

并行研究表明,僅基于文本embedding而不凍結注意力圖也可以實現圖像編輯能力。本文想強調這兩種方法之間的區別。為了進行對象替換或風格控制,他們在文本embedding空間中替換關鍵詞embedding,而本文使用長而詳細的文本提示,并直接在文本空間中替換關鍵詞。為了控制編輯強度,他們重新調整描述性詞embedding的權重,或者使用奇異值分解來發現文本embedding空間中的編輯方向,而本文則直接對源文本和目標文本embedding進行線性插值。

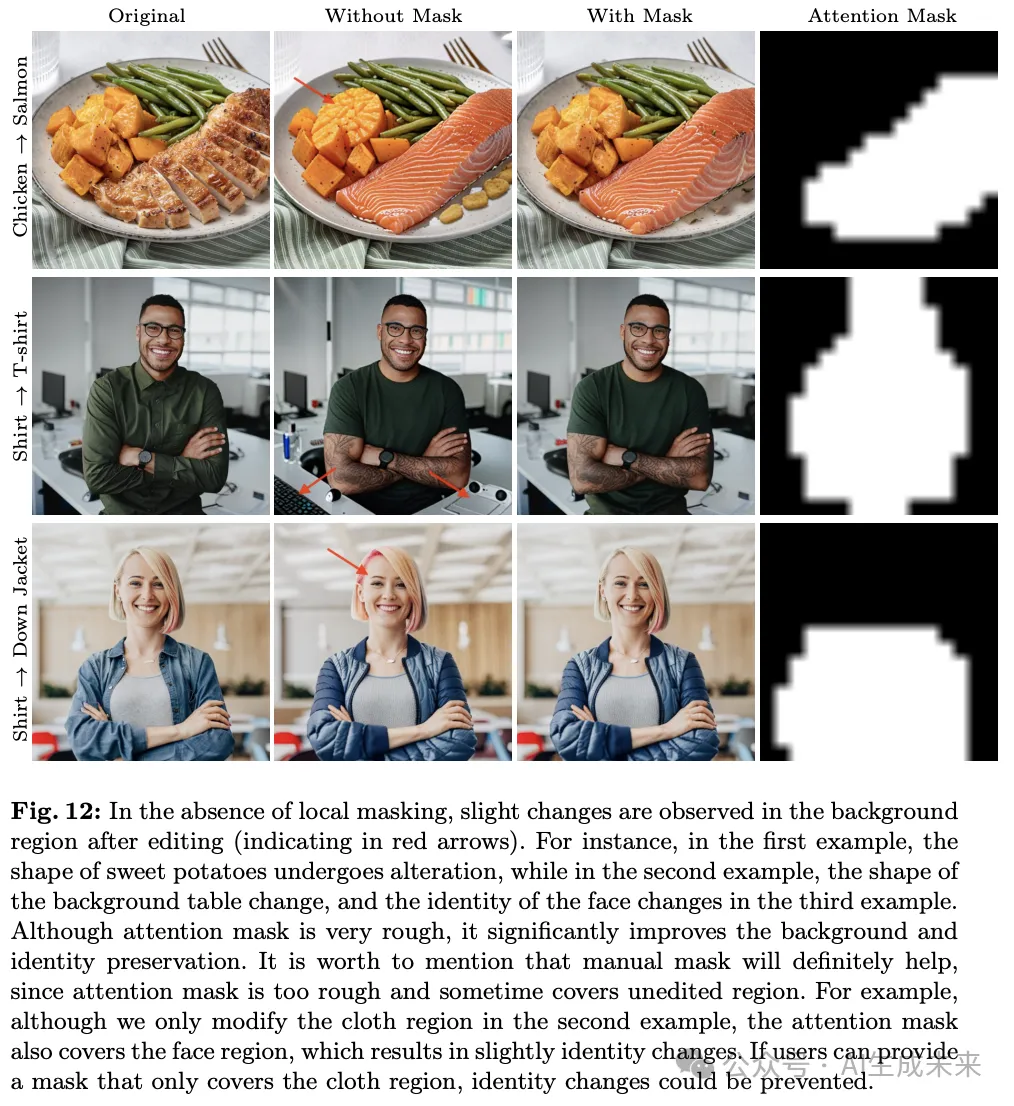

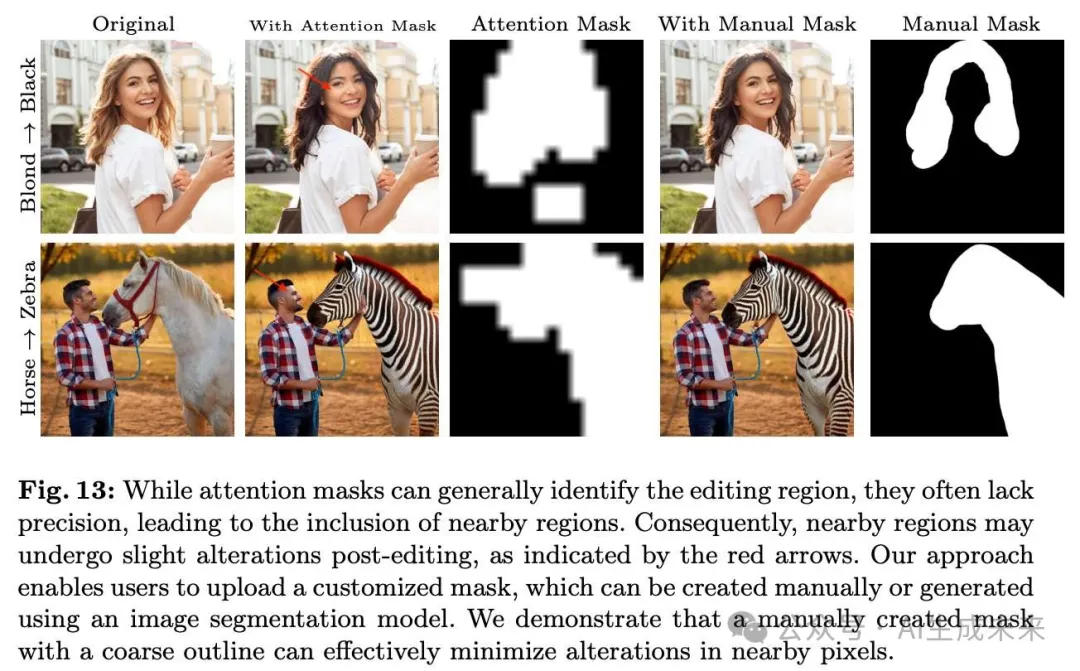

局部 Mask

為了提供mask的初始化,本文建議使用粗略的注意力mask來表示編輯區域。受prompt2prompt中局部混合模式的啟發,本文自動提取分辨率為16 × 16的注意力mask,用于僅存在于源提示或目標提示中的單詞,在通道維度上求和,并將其除以最大值。此過程生成一個單通道的注意力mask,其值范圍為0到1,其中編輯區域以高注意力值為特征,未更改的區域以低注意力值為特征。默認情況下,本文將閾值設置為0.6,并將連續的注意力mask轉換為二進制mask。用戶可以交互式地調整閾值以控制mask的大小,因為每次編輯(4步)需要少于0.5秒。盡管注意力mask非常粗略,但本文展示了它可以顯著改善背景和身份保留,如下圖12所示。在本文的圖中,本文僅使用粗略的注意力mask而不是精確的手動mask。

需要明確的是,本文的方法僅使用注意力mask來限制編輯區域,這與在prompt2prompt中通過凍結注意力圖來實現結構對齊的方法不同。本文的方法與注意力凍結是正交的,可以與之結合。然而,默認情況下,本文在任何時間步都不凍結注意力圖,因為這樣做會強烈限制對象結構,并且在上圖9中顯示的少步擴散模型中容易引入偽影。

基于指令的編輯

在許多編輯場景中,用戶需要更改源提示中的多個詞才能獲得所需的目標提示。例如,當用戶希望將一張小狗的圖片更改為小貓的圖片時,他們需要將“dog”更改為“cat”,并將“puppy”更改為“kitten”,這可能會顯得繁瑣且不吸引人。

幸運的是,針對大型語言模型(LLM)的指令微調和文本空間中的語義編輯已經得到了充分的研究。本文從一個基礎指令開始,例如“請對以下句子做出最小的改變,但...”,然后用戶只需添加任務特定的指令,如“將狗改為貓。”本文將基礎指令、用戶指令和源提示串聯在一起,并將它們輸入到LLM中。LLM會找出最佳的編輯方式并生成目標提示。通過這種方式,復雜的文本編輯由LLM處理,用戶只需輸入簡單的短指令。為了提高效率并節省內存,本文重新使用LLaVA作為本文的LLM,但任何經過指令微調的LLM都可以替換使用。LLaVA構建在Vicuna 之上,即使經過視覺和語言任務的微調后,仍然可以執行文本編輯任務。實驗表明,這種簡單的方法在上圖1、下圖6和下表3中表現良好。

實驗

訓練細節

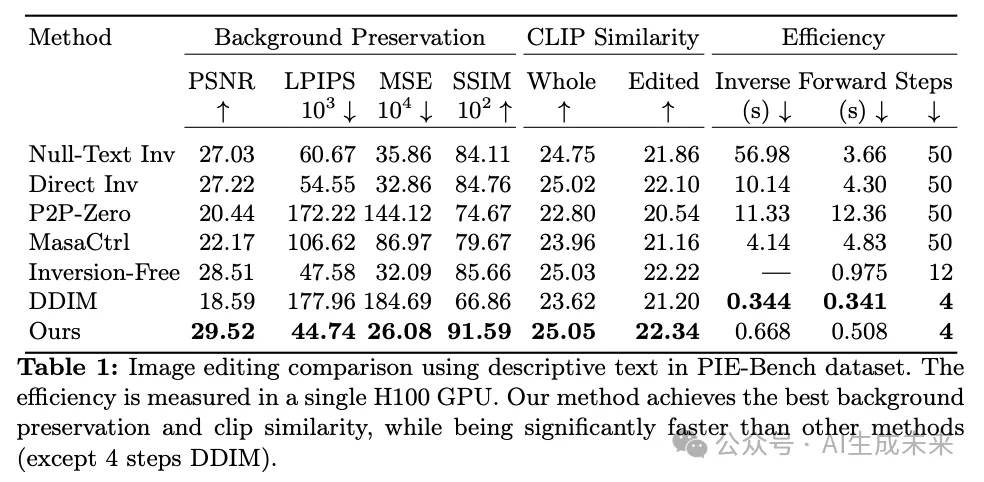

定量比較

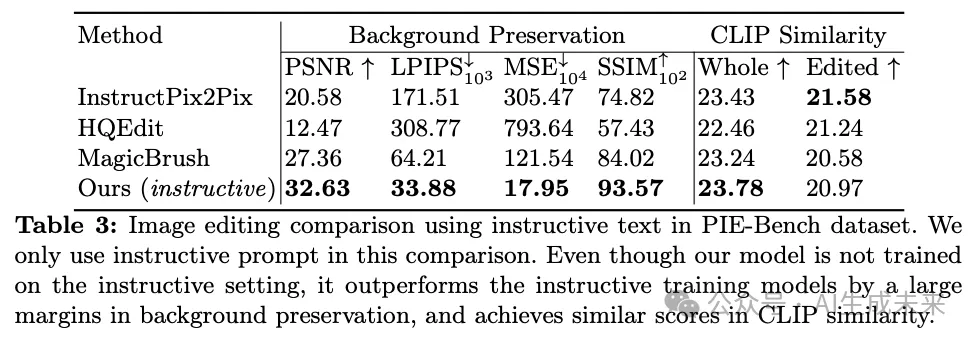

PIE-Bench 數據集包含 700 張圖像,每張圖像對應 10 種不同的編輯類型。每個示例包括一個源提示、目標提示、指令提示和源圖像。在描述性設置中,僅使用源提示和目標提示進行文本指導,而在指令性設置中,僅使用指令提示。

然而,PIE-Bench 數據集僅提供簡短的文本提示,而長且詳細的文本提示對于確保解耦編輯和防止偽影是必要的。為了在描述性設置中確保公平比較,本文使用數據集中的簡短源提示和目標提示,并在第一次采樣步驟中凍結注意力圖。在指令性設置中,本文使用 LLaVA 生成一個長的源標題,并遵循 PIE-Bench 的簡短指令以獲得一個長的目標提示,如前文中所討論。本文的結果顯示,與當前的最新方法相比,本文的方法在描述性和指令性設置中都能更好地遵循文本指導并保留背景(見上表 1 和下表 3)。

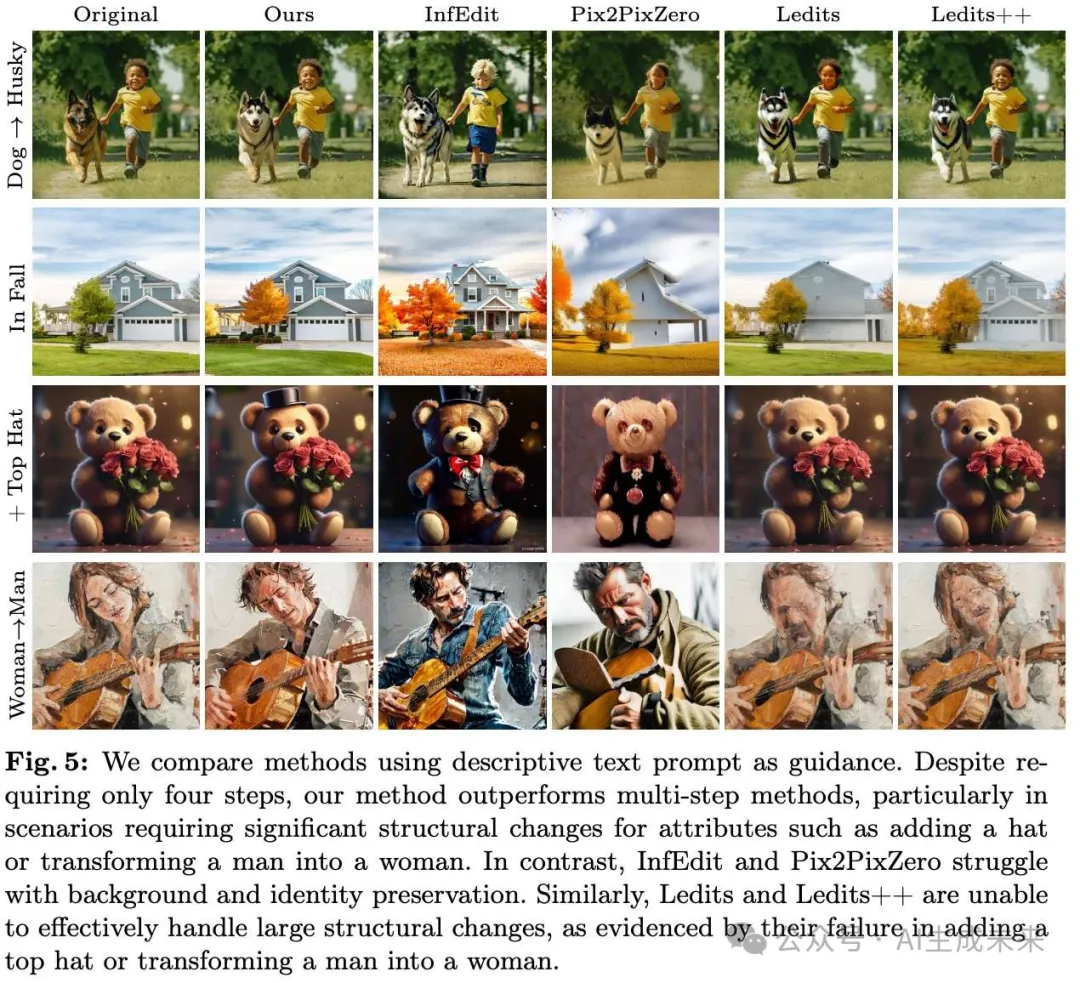

定性比較

本文的方法本質上支持多種反演步驟。在單步反演的情況下,DDIM反演會產生大量偽影,而 DDPM反演生成的圖像雖然具有目標屬性,但在上圖8中未能與輸入圖像相似。相比之下,本文的方法成功生成了與輸入圖像非常相似的正確編輯,盡管在手部和面部區域有輕微的偽影,以及圖像中的椒鹽噪聲。在考慮四步反演時,所有方法相較于單步反演都有更好的結果。然而,當執行大的結構變化(例如,將狗變成貓)時,DDIM反演和DDPM反演容易產生較大的偽影,而本文的方法在上圖8中實現了更高的身份保留和逼真的編輯效果。

此外,本文在下圖5中對比分析了本文的四步方法和基于多步擴散模型的圖像編輯方法,該方法使用描述性提示作為指導。InfEdit和 Pix2PixZero扭曲了房屋、泰迪熊和吉他等物體的結構。此外,Ledits 和 Ledits++ 在進行大規模結構變化(例如添加帽子或將男人變成女人)時遇到了困難。相比之下,本文的方法在進行紋理和結構變化的逼真編輯時表現出色,同時保持了強大的身份保留。與同樣依賴于 SDXL-Turbo 的同期工作 ReNoise 相比,本文每次反演只需要 8 次 NFE,而不是 36 次 NFE,更好地保留了面部身份,并在補充圖14中產生更少的偽影。

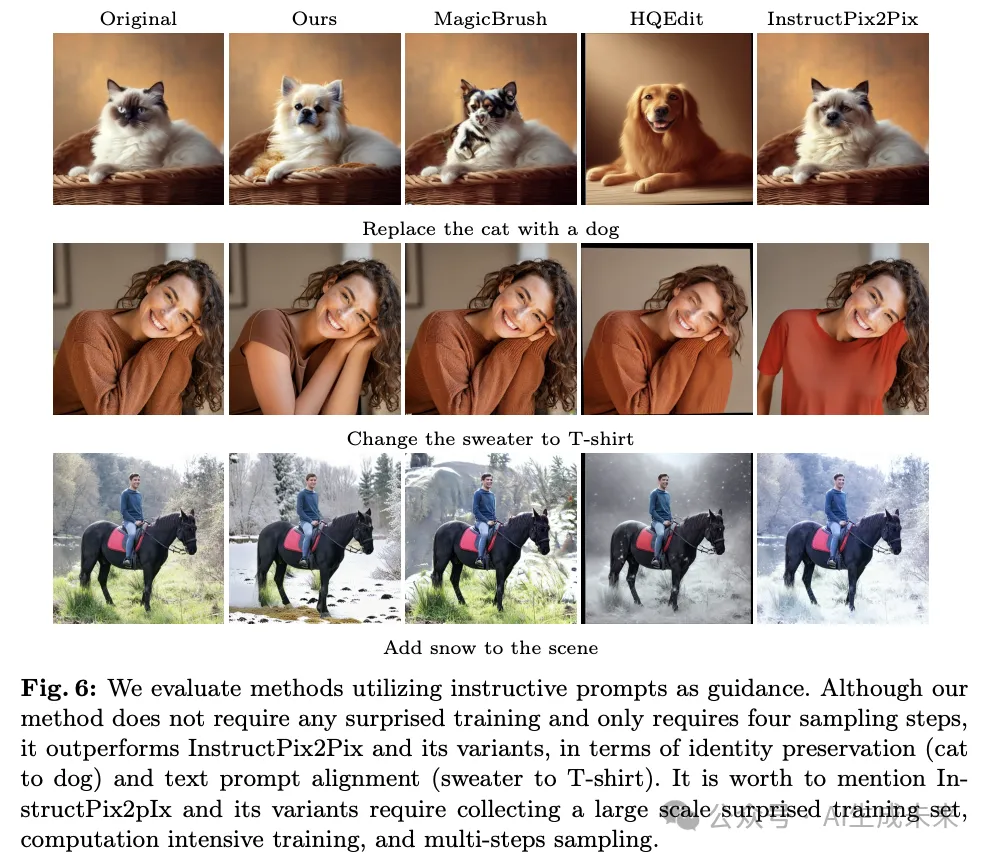

同樣,本文在上圖6中將本文的方法與其他基于指令的方法進行了比較,這些方法使用指導性提示作為指導。雖然 InstructPix2Pix 及其變體需要大規模的監督訓練集、計算密集型訓練和多步采樣,而本文的反演網絡通過重建損失進行無監督訓練,只需要四步采樣,本文的方法在身份保留(從貓到狗)和文本提示對齊(從毛衣到T恤)方面表現更好。

消融實驗

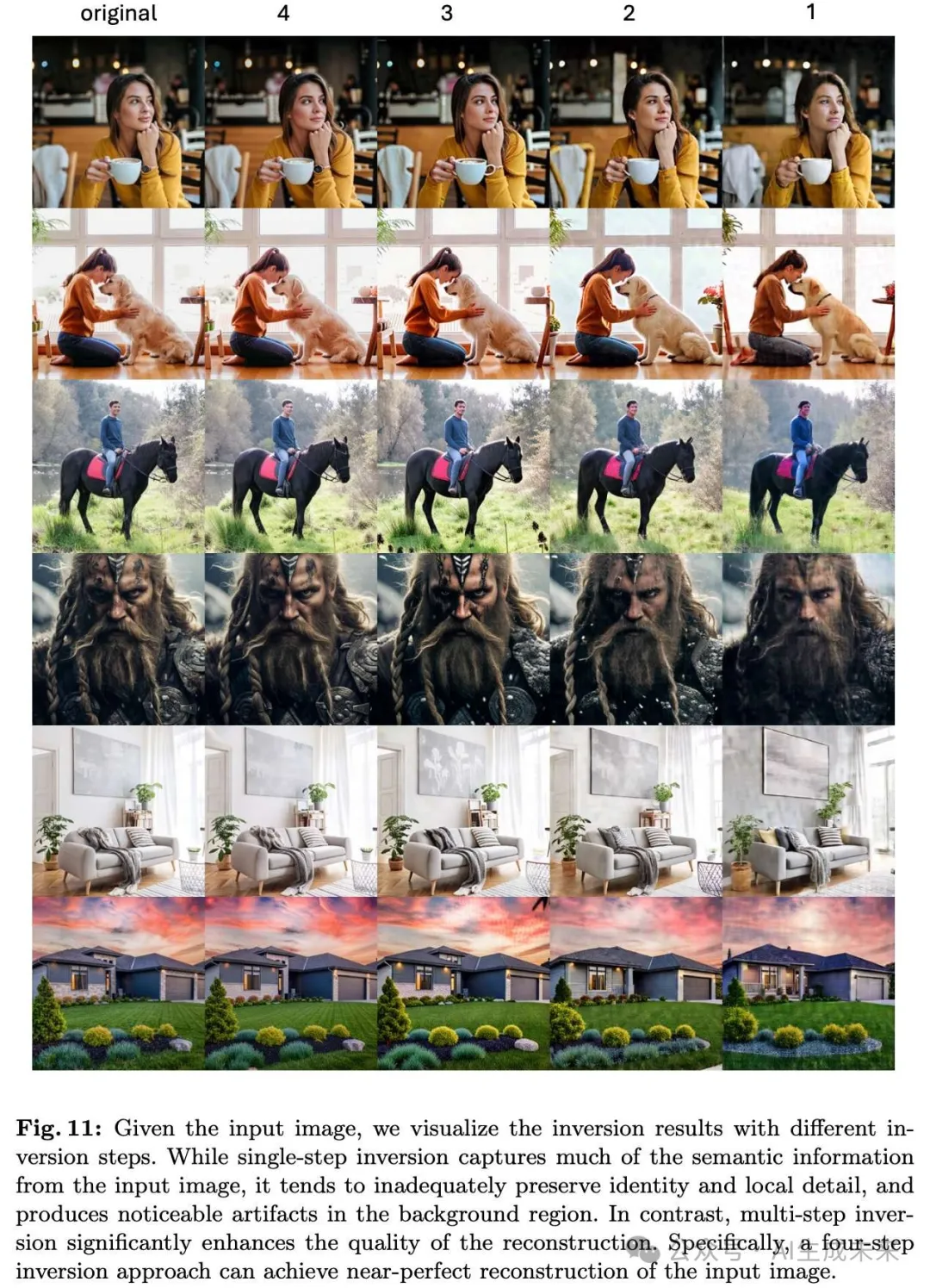

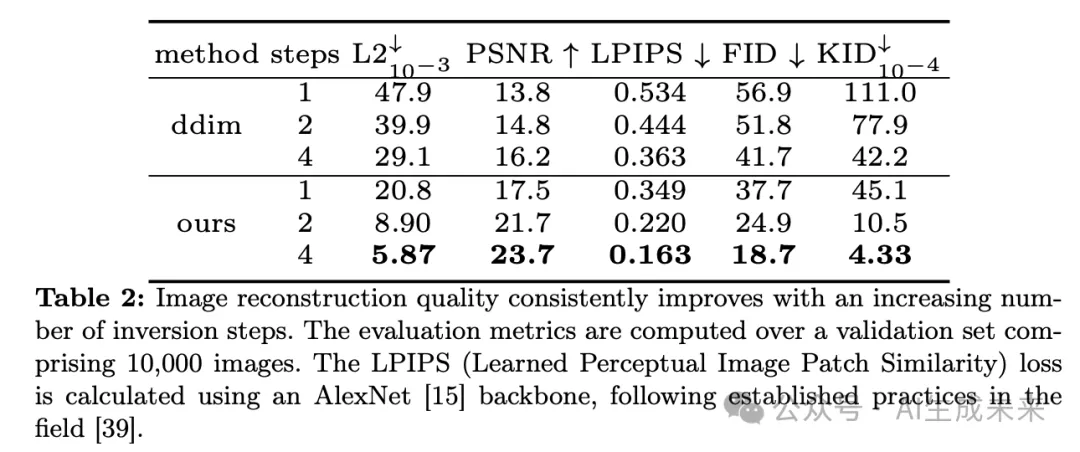

本文通過消融研究驗證了框架中每個組件的必要性。首先,本文可視化了不同反演步數下的反演結果。本文的研究表明,多步反演對于保持面部身份和防止模糊偽影是必不可少的(見下圖11)。隨后,本文使用1萬張驗證圖像計算重建指標,結果顯示,隨著反演步數的增加,重建質量持續改善(見下表2)。此外,本文證明了詳細的文本提示條件對于結構保留和防止背景偽影至關重要(見上圖10)。最后,本文展示了局部掩蔽對于防止背景結構變化和身份偏移的重要性(見上圖12)。

Limitations and Societal Impact

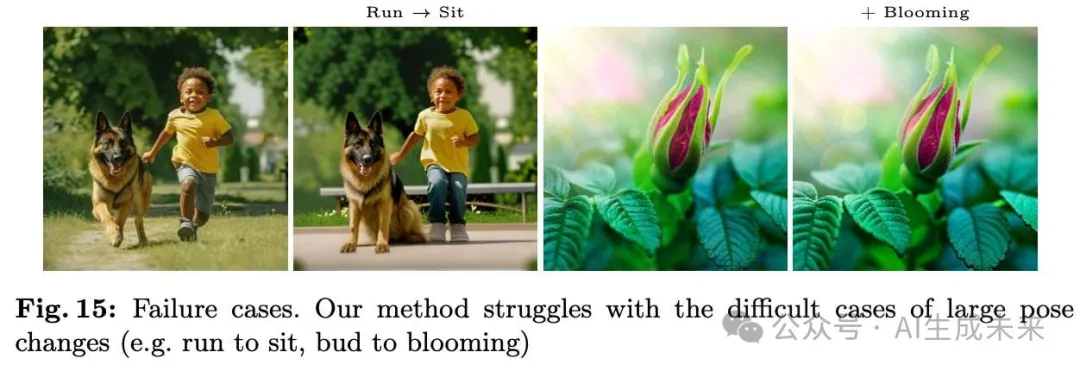

首先,本文的方法依賴于LLaVA來生成詳細的描述。然而,由于本文只進行少步反演,計算密集的LLaVA模型成為了瓶頸。因此,需要探索其他輕量級的描述生成模型,以實現實時圖像反演。其次,雖然注意力mask可以有效地限定編輯區域,但它們通常不夠精確,可能會包含附近的區域,增加注意力閾值也無法完全解決這個問題。這種不精確可能導致輕微的身份偏移,特別是當編輯區域靠近人臉時。本文在下圖13中展示了如何通過使用用戶提供的粗略mask來減輕這一問題。最后,本文的方法無法進行大幅度姿勢改變(例如,將一個奔跑的人變為坐著的人),如下圖15所示。

作為一種生成式圖像編輯工具,本文的方法提供了創造性的機會和挑戰。盡管它實現了創新的圖像編輯能力,但也引發了關于操控數據、誤導信息和垃圾信息傳播的擔憂。其中一個顯著的問題是故意圖像操控的增加,即所謂的“深度偽造”,這種現象對女性的影響尤為嚴重。

結論

根據本文所知,本文的方法是首個在少步擴散模型背景下探索圖像編輯的工作,也是首個在擴散模型中探索基于編碼器反演的工作。本文證明,通過對(自動生成的)詳細文本提示進行條件控制,可以在少步擴散模型中輕松實現解耦控制。本文的方法使用戶能夠以交互速度進行逼真的文本引導圖像編輯,反演和編輯過程都在毫秒內完成。

本文轉自 AI生成未來 ,作者:Zongze Wu等