林達華團隊最新發布ReasonPix2Pix:讓基于指令的高級圖像編輯效果飛升!

文章鏈接:https://arxiv.org/pdf/2405.11190

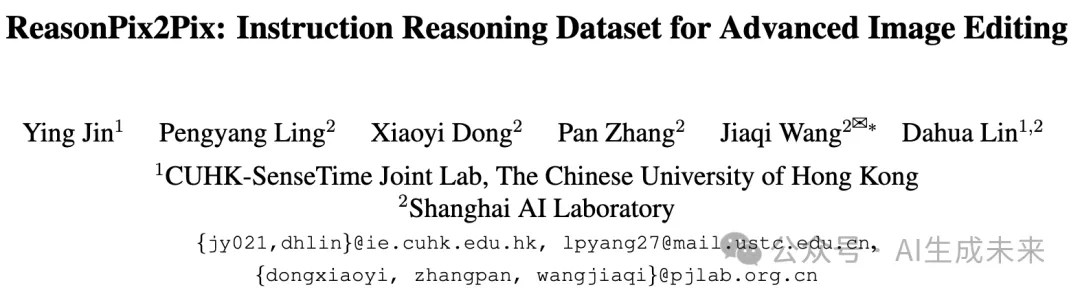

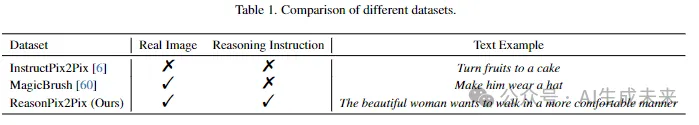

基于指令的圖像編輯專注于使生成模型能夠遵循人類書寫的編輯圖像指令。當前的方法通常能夠理解明確且具體的指令。然而,它們往往在執行所需的主動推理能力上表現不足,無法很好地理解隱含或定義不足的指令。為了增強主動推理能力并賦予編輯模型智能性,本文引入了ReasonPix2Pix,一個綜合性的推理注意指令編輯數據集。

該數據集的特點是:

- 包含推理指令

- 來自細粒度類別的更真實的圖像

- 輸入和編輯圖像之間的更大差異

在監督條件下使用該數據集進行微調時,該模型在指令編輯任務中表現出優越的性能,無論這些任務是否需要推理。

介紹

基于指令的圖像編輯旨在使生成模型具備遵循人類書寫的編輯圖像指令的能力,這對于促進AI生成內容(AIGC)系統理解人類意圖至關重要。

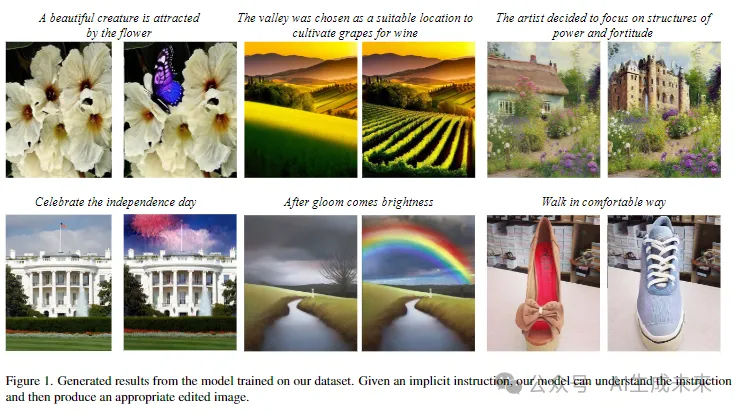

現有的基于指令的圖像編輯框架通常能夠理解明確且具體的指令,例如“將水果換成蛋糕”。不幸的是,這些模型在主動推理能力上表現不足,即理解指令的含義而不僅僅是從中提取詞語。如下圖2所示,一個典型的基于指令的圖像編輯框架InstructPix2Pix未能實現“她更喜歡口罩而不是太陽鏡”,卻給女人添加了太陽鏡,這是不合理的。

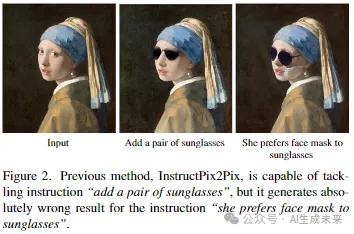

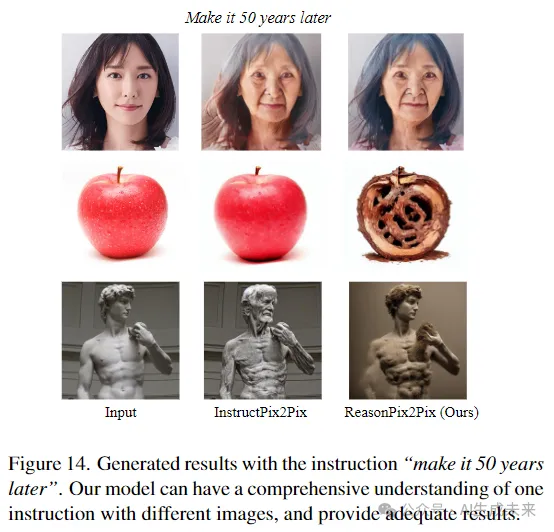

同時,該模型缺乏理解給定圖像的能力。例如,對于一個簡單明確的指令“讓它變成50年后”,對于各種給定的圖像,編輯結果應該是不同的。但是在下圖3中,以前的方法只是簡單地將人變老,甚至未能編輯圖像,這是完全不正確的。

另一方面,這些方法也缺乏理解隱含或定義不足的指令的能力。這需要人工干預,將隱含指令變為明確指令,或將指令分解為多個明確、具體的指令,以符合這些模型的能力。

例如,指令“讓房間整潔”需要手動分解為各種步驟,如“將散落的衣物整齊折疊”,“移除地上的垃圾”,以及“整理床單”等。同樣,隱含指令“她是這場表演的明星”需要人為干預,將其明確為“在圖像中添加一些閃光和聚光燈效果”。因此,增強自我推理能力不僅對用戶更友好,而且是下一代智能AIGC系統發展的關鍵。

借助多模態大模型(MLLM)的生成模型在推理感知指令編輯方面的潛力是巨大的。然而,現有的用于指令編輯的數據集未能充分發揮和利用模型的內在推理能力。

因此,本文研究者們開發了一個綜合性的推理注意指令編輯數據集ReasonPix2Pix,該數據集包含圖像對及其相應的推理指令。ReasonPix2Pix的特點包括:

- 隱含指令以進一步增強模型的推理能力

- 來自細粒度類別的大量真實圖像

- 輸入圖像和編輯后圖像之間在幾何層面上的顯著差異。

在下表1中與之前的數據集進行了比較。

此外,將多模態大模型(MLLM)引入圖像編輯模型,并在數據集上進行微調,從而增強圖像編輯的推理能力,并顯著提升指令編輯的質量。

貢獻可以總結如下:

- 提出了基于指令推理的圖像編輯任務,這是一項有趣的任務,旨在增強模型理解人類意圖的智能。

- 開發了一個綜合性的推理注意指令編輯數據集ReasonPix2Pix,該數據集包含圖像對及其相應的推理指令。

- 在數據集上微調了一個簡單的框架。即使在沒有繁雜操作的情況下,該模型不僅在不需要推理的指令編輯任務中表現出色,而且在需要推理的任務中也表現良好。

相關工作

圖像編輯 圖像編輯是一個基礎的計算機視覺任務,也可以看作是圖像到圖像的轉換。在生成對抗網絡(GAN)提出后,許多工作[13, 14, 19, 29, 35]被發明來解決這一任務。一類方法[1–3, 7, 10, 41, 50]將原始圖像插入潛在空間,然后進行操作。這些方法被證明在轉換圖像風格、添加和移動圖像中的對象方面是有效的。

最近,隨著多模態學習的爆炸性發展,文本信息可以通過諸如CLIP之類的模型嵌入,然后作為圖像編輯的指導。這些方法使模型能夠根據給定的文本編輯圖像。

擴散模型 擴散模型是最受歡迎的生成模型之一,在圖像合成方面表現出色。通過擴散過程學習給定數據集的概率分布。最近,文本到圖像的擴散模型,如Stable Diffusion,在將文本轉換為高質量圖像方面取得了巨大成功。

圖像編輯的擴散模型一些擴散模型天生具備編輯圖像的能力。然而,在實際應用中,這些模型顯示出穩定性較差的問題(即在給定類似文本時生成類似的圖像)。通過Prompt-to-Prompt在模型上施加約束,這個問題得到了緩解。與以往處理生成圖像的方法不同,SDEdit通過加噪和去噪過程編輯真實圖像。

圖像修復可以看作是更精細的圖像編輯。它通過從一小組訓練樣本中學習,將文本輸入和用戶繪制的masks轉換為特定類別或風格的圖像。InstructPix2Pix簡化了生成過程,僅需要一個輸入圖像和一個指令來編輯圖像,而不需要任何訓練。它提出了一個大規模數據集,包含配對的圖像和相應的指令。然而,它僅包含簡單明了的指令,限制了其在復雜的現實場景中的應用。因此,本文構建了一個指令推理數據集,以改善圖像編輯。

多模態大語言模型隨著大語言模型(LLM)的快速發展,它們被擴展到更多的模態(如視覺),形成多模態大語言模型。BLIP-2和mPLUG-OWL引入了視覺編碼器來嵌入圖像,然后將它們與文本embeddings結合起來。Instruct-tuning被廣泛采用,將LLM的能力轉移到視覺領域。另一類工作使用提示工程,犧牲了端到端訓練。多模態大語言模型在視覺任務中的應用被證明在基于視覺的任務和目標檢測方面是有效的。

方法

本文的目標是根據人類指令進行圖像編輯,特別強調推理指令。給定一個輸入圖像和一個人類指令,模型旨在理解人類的顯性或隱性意圖,并隨后生成與提供的指令一致的輸出圖像。為了實現這一目標,本文引入了ReasonPix2Pix,一個專門針對基于指令的圖像編輯并關注推理能力的數據集。以該數據集為基礎訓練數據,微調了一個包含多模態大語言模型與擴散模型的簡單框架。

預備知識

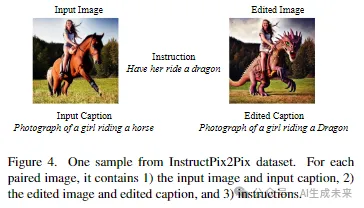

InstructPix2Pix數據集 InstructPix2Pix生成了一個重要的大規模配對數據集,以實現基于指令的圖像編輯。具體地,如下圖4所示

它包含:

- 輸入圖像t和輸入標題

- 編輯后的圖像和編輯后的標題

- 文本指令。

V3Det數據集 V3Det是一個龐大的檢測數據集,包含13,204個類別,超過240,000張圖像。圖像看起來真實且復雜,開發了一個更通用的視覺感知系統。

ReasonPix2Pix

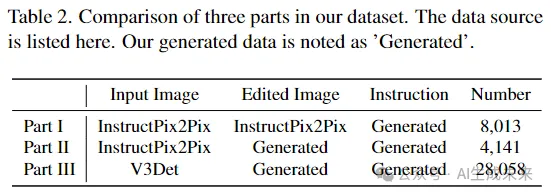

為了將推理能力注入圖像編輯模型,研究者們構建了一個綜合性的推理注意指令編輯數據集。根據生成過程,生成數據集可以分為三個部分。如表2所示:

- Part I:使用InstructPix2Pix中的原始圖像對,并生成指令以實現指令推理。

- Part II:從InstructPix2Pix的輸入圖像開始,生成自己的編輯圖像和指令。

- Part III:從V3Det中獲取更真實的圖像,生成編輯后的圖像和指令。

?

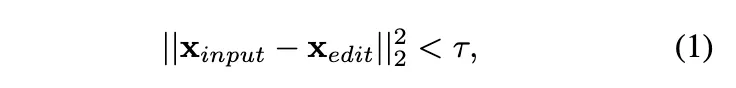

數據過濾盡管在基于指令的圖像編輯中取得了巨大成功,InstructPix2Pix模型仍存在各種失敗案例。一個典型的失敗案例是模型傾向于輸出原始圖像,即不進行任何編輯。深入研究數據集,發現部分編輯后的圖像與輸入圖像非常相似。因此,需要首先過濾這部分數據,通過以下方法區分它們:

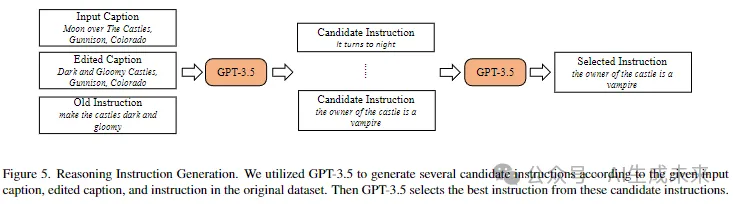

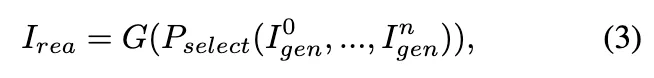

如下圖5所示,將InstructPix2Pix數據集中的輸入標題、編輯標題和原始指令輸入GPT-3.5,并要求GPT-3.5生成候選指令。

然后,再次要求GPT-3.5從中區分出最佳指令。

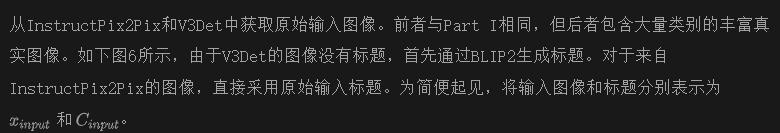

Part II & III:圖像編輯和推理指令生成為了進一步提高模型的能力,研究者們擴展了數據集,加入了其他兩部分數據。這些數據不僅增強了模型的推理能力,還旨在提升模型處理更真實的細粒度類別圖像和輸入與編輯圖像之間更大差異的能力。

標題傳遞給Spacy模型S,這是一個先進的自然語言處理(NLP)模型,用于識別句子中的實體。在這里利用它來提取候選類別。

Spacy模型提取了i個候選類別。例如,在上面圖6中,Spacy提取了i = 2個類別,即蝴蝶和花朵。

通過這些類別,可以使用Grounding DINO在圖像中定位相應的物體。

然后將標題和候選類別注入到GPT-3.5中。在這里,設計了另一個提示,要求GPT-3.5輸出

- 一個被選中的類別

- 需要用其替換的目標類別

- 推理指令。

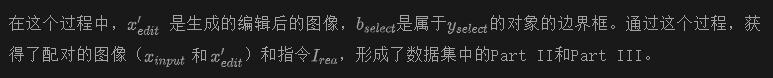

在這里展示了數據集的一些樣本。從下圖7可以看出,數據集具有復雜的推理指令(例如,“一家公司計劃在清潔能源上開展新項目”),輸入和編輯圖像之間的變化更多,特別是在幾何水平上,而且圖像更加真實。

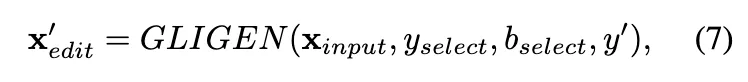

數據集利用

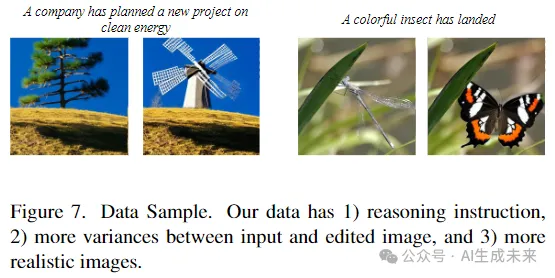

利用廣泛模型來增強編輯模型的主動推理能力。具體來說,設計了一個簡單的框架,將一個多模態大語言模型(MLLM)整合到擴散模型中,如下圖8所示。

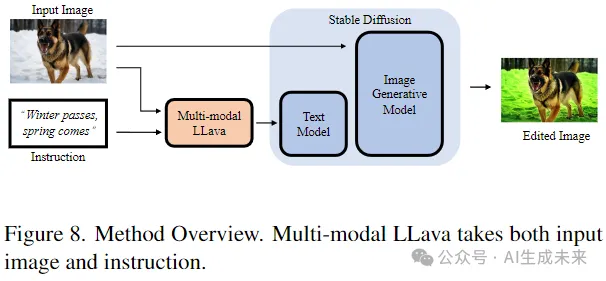

與以往僅通過文本理解人類意圖的方法不同,MLLM通過結合指令和輸入圖像來增強理解能力。形式上,具有人類意圖的指令特征h可以被公式化為

其中,F是MLLM。h是F的輸出,包含了我們指令的多模態理解。

然后,可以無縫地將h注入到編輯模型中。圖像生成模型可以在h的監督下編輯輸入圖像。

考慮到LLM中的大量參數,在對模型進行微調時將其固定。利用ReasonPix2Pix數據集,模型進行端到端的微調。

實驗

實施細節

利用V3Det的測試數據構建了一個基準測試集,具體流程見前面圖6,共有1000張圖像。同時,記錄了所選類別和目標新類別,因此可以通過多種模板制定簡單的指令,例如“將A轉換為B”。

因此,測試數據包括輸入圖像及其標題、真實編輯后的圖像及其標題,以及直觀指令和推理指令。分別在這些數據上評估了ReasonPix2Pix以及之前的方法。

定性結果

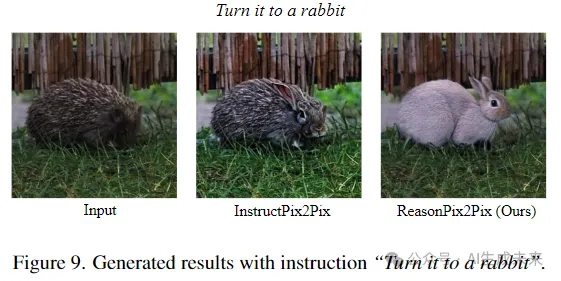

圖像質量 這里將本文的方法與之前的方法在簡單指令下的表現進行了比較。如下圖9所示,InstructPix2Pix未能將圖像中的刺猬變成兔子。而ReasonPix2Pix能夠轉換這些復雜的類別,生成更生動的結果。

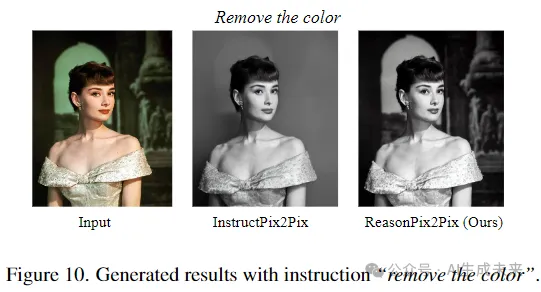

推理能力 為了比較推理能力,首先我們從相對簡單的指令開始。如下圖10所示,當指令是“去除顏色”時。之前的方法在一定程度上能夠理解指令,但生成的結果不準確。

InstructPix2Pix遵循指令將圖像轉換為黑白,但也移除了背景。相反,ReasonPix2Pix理解了指令并給出了充分的結果。

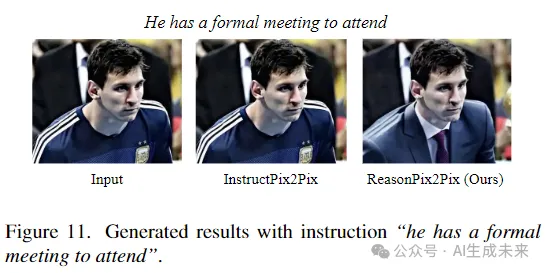

然后我們轉移到更復雜的指令。如下圖11所示,對于間接指令“他有一個正式會議要參加”,之前的InstructPix2Pix無法處理,輸出了原始圖像而沒有進行任何編輯。ReasonPix2Pix能夠理解指令,并讓他穿著正式服裝參加會議。

定量結果

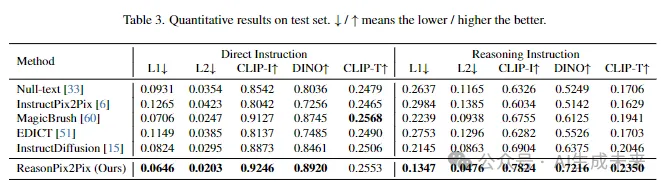

除了上述的定性結果之外,還將定量指標與之前的方法進行了比較,如下表3所示,分別使用直接指令和推理指令。我們報告了生成圖像與真實圖像之間的L1和L2距離,以及它們的CLIP和DINO嵌入之間的余弦距離。此外,還報告了CLIP-T,即目標標題的CLIP特征與生成圖像之間的余弦相似度。

在傳統的直接指令下,ReasonPix2Pix在之前的方法中取得了競爭性的表現,證明了生成的圖像的質量。當涉及需要理解的推理指令時,之前的方法表現下降,但ReasonPix2Pix的結果遠遠高于其他方法。

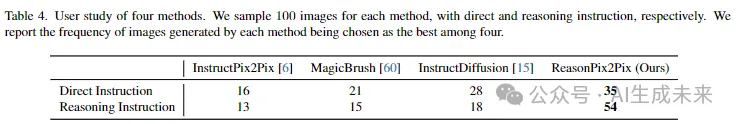

同時,研究者們還進行了用戶研究,以比較ReasonPix2Pix與之前的方法。分別隨機抽取了由不同模型生成的100個樣本,并請5名工作者對它們進行評估(每人20個)。工作者被要求在4個候選項中選擇最佳圖像。從下表4中可以看出,在直接指令下,ReasonPix2Pix略優于之前的方法。當指令變為推理指令時,ReasonPix2Pix與之前的方法之間的差距變得更大。

分析

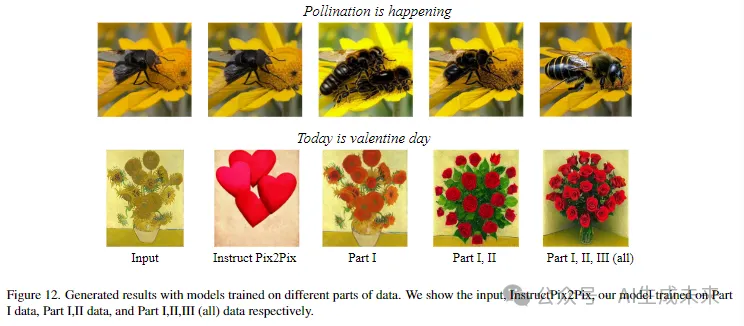

定性結果評估了數據集的三個部分的有效性。下圖12展示了當僅使用Part I、Part I和Part II、以及整個數據集進行訓練時的結果。可以觀察到,當面對需要推理的指令時,之前的方法如InstructPix2Pix往往會編輯為空或產生不合理的編輯結果。使用Part I數據時,模型似乎理解了指令,但仍然很難提供編輯后的圖像。這與本文提出的觀點一致,即僅使用InstructPix2Pix數據集中的圖像時,模型的編輯能力仍然有限。

另一方面,當逐步引入Part II和Part III數據時,編輯結果變得越來越好。有了數據集中的所有數據,模型能夠理解指令并產生相應的結果。

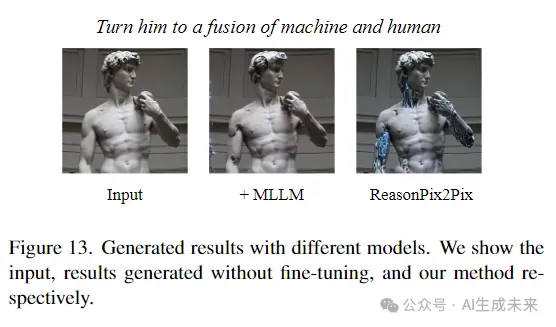

在我們的簡單框架中,將多模態大語言模型集成到圖像編輯模型中,它自然具有推理能力。在這里,比較了InstructPix2Pix的結果,添加了未經微調的MLLM,以及在ReasonPix2Pix上進行了微調的我們的模型。下圖13顯示,未經微調時,圖像編輯模型很難接受MLLM的輸出。當在我們的數據集上進行微調時,模型能夠理解和編輯。

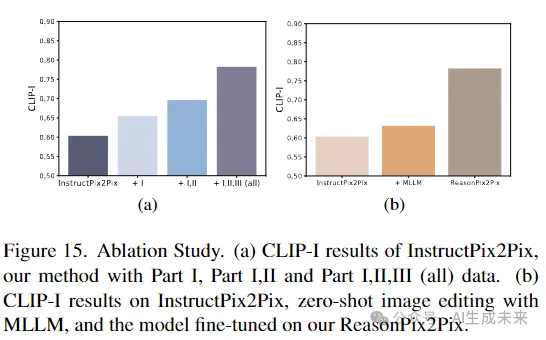

定量結果在下圖15a中,比較了定量結果。當添加Part I、II和III數據時,CLIP-I上升。因此,數據集的三個部分都是必不可少的。同時,如下圖15b所示,MLLM帶來了輕微的改進,而數據集顯然提升了模型的性能。定量結果與定性結果一致。

綜合理解最后,讓我們回到前面的案例,“使其晚50年”。以前的方法無法處理一些情況,例如水果。同時,理解指令不是一個單一模態的問題,一個男人的雕像在50年后不會變成老人。通過我們的框架和數據集,模型考慮了圖像和指令。因此,它根據不同的輸入提供了合理的結果。50年后,一個年輕美麗的女人變成了一個老女人,蘋果變成了腐爛的,雕像變成了一個帶著塵土的破碎的雕像。

限制

由于 API 成本的限制,數據集大小仍然有限。本文已經制定了一個清晰的數據生成流程。如果需要,研究人員可以將數據集擴展到超過 400,000 個樣本。

結論

本文旨在增強編輯模型的推理能力,使其更加智能化。具體地,引入了 ReasonPix2Pix,一個專門用于注入推理能力到圖像編輯中的推理指令編輯數據集。在提出的數據集上微調了一個簡單的框架。廣泛的實驗結果證明,ReasonPix2Pix在不管指令是否需要推理的情況下都取得了競爭性的結果。

本文轉自 AI生成未來 ,作者:Ying Jin等