勇奪三項SOTA!北航&愛詩科技聯合發布靈活高效可控視頻生成方法TrackGo!

論文鏈接:https://arxiv.org/pdf/2408.11475

項目鏈接:https://zhtjtcz.github.io/TrackGo-Page/

★亮點直擊

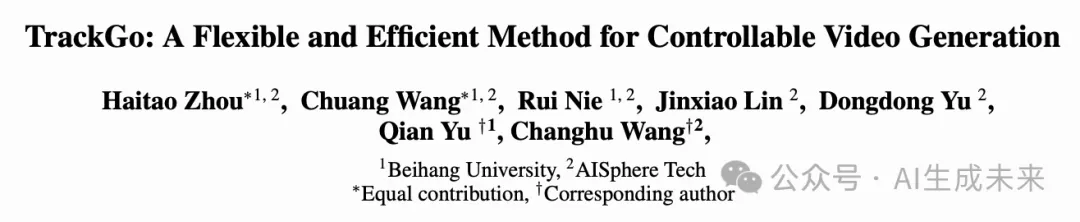

- 本文引入了一種新穎的運動可控視頻生成方法,稱為TrackGo。該方法為用戶提供了一種靈活的運動控制機制,通過結合 masks 和箭頭,實現了在復雜場景中的精確操控,包括涉及多個對象、細粒度對象部件和復雜運動軌跡的場景。

- 本文開發了一個新組件,稱為TrackAdapter,用于有效且高效地將運動控制信息集成到時間自注意力層中。

- 本文進行了廣泛的實驗來驗證本文的方法。實驗結果表明,本文的模型在視頻質量(FVD)、圖像質量(FID)和運動真實性(ObjMC)方面優于現有模型。

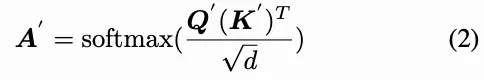

近年來,基于擴散的可控視頻生成領域取得了顯著進展。然而,在復雜場景中實現精確控制仍然是一個挑戰,包括對細粒度的物體部分、復雜的運動軌跡以及連貫的背景運動的控制。在本文中,本文介紹了TrackGo,這是一種利用自由形式的masks和箭頭進行條件視頻生成的新方法。該方法為用戶提供了一種靈活且精確的機制來操控視頻內容。本文還提出了用于控制實現的TrackAdapter,這是一種高效輕量的適配器,旨在無縫集成到預訓練視頻生成模型的時間自注意力層中。該設計利用了本文的觀察,即這些層的注意力圖可以準確激活與視頻中運動對應的區域。本文的實驗結果表明,借助TrackAdapter增強的新方法在關鍵指標如FVD、FID和ObjMC得分上實現了SOTA性能。

方法

概覽

在接下來的部分中,將討論三個主要主題:

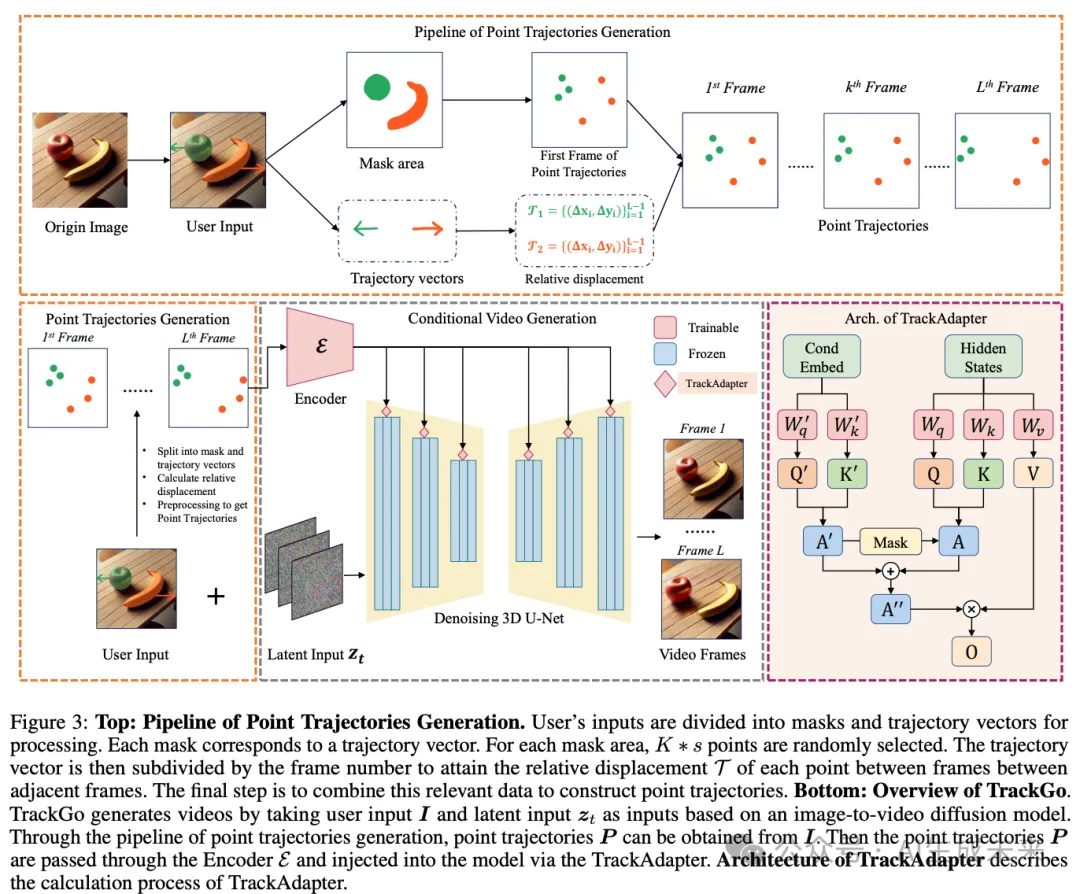

- 點軌跡的優勢以及本文如何獲取和使用它們。

- TrackAdapter的結構以及它如何幫助SVD理解復雜的運動模式并完成復雜動作的生成。

- 我們模型的訓練和推理過程。

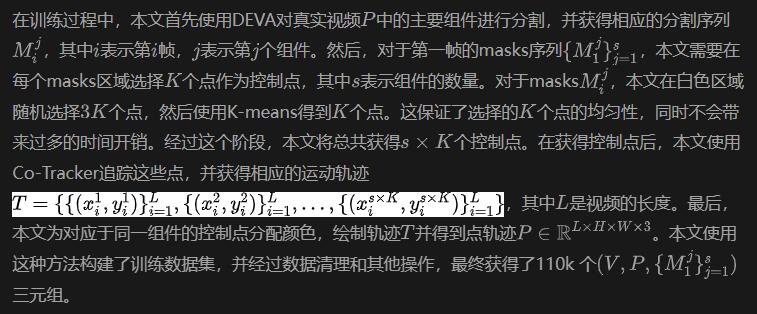

點軌跡生成

在推理過程中,當用戶提供第一幀圖像、編輯區域的masks以及相應的箭頭時,本文的方法可以通過預處理將用戶輸入的masks和箭頭轉換為點軌跡,如上圖3所示。

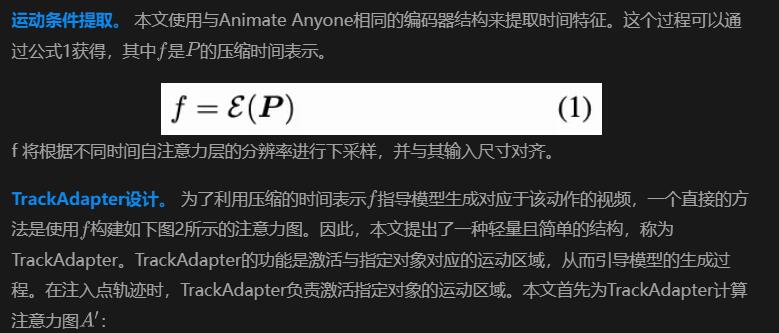

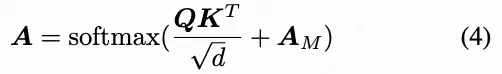

通過 TrackAdapter 注入運動條件

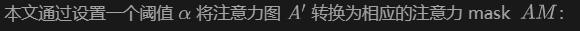

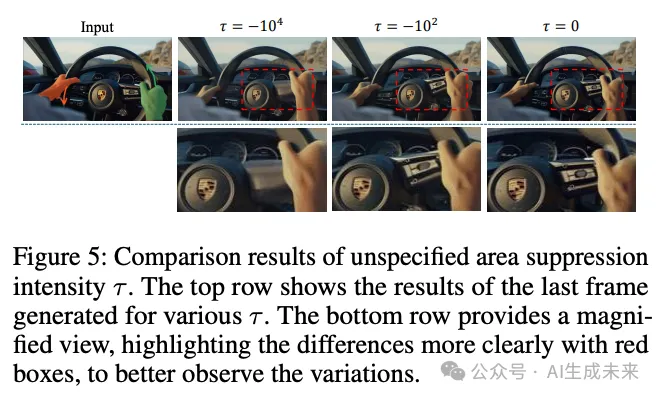

為了避免原始時間自注意力分支對最終活躍區域的影響,本文根據注意力圖獲得一個注意力 mask ,以抑制由原始時間自注意力分支激活的區域。

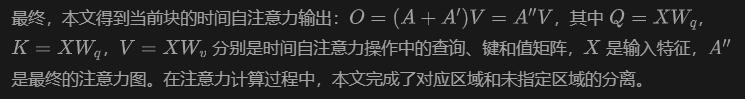

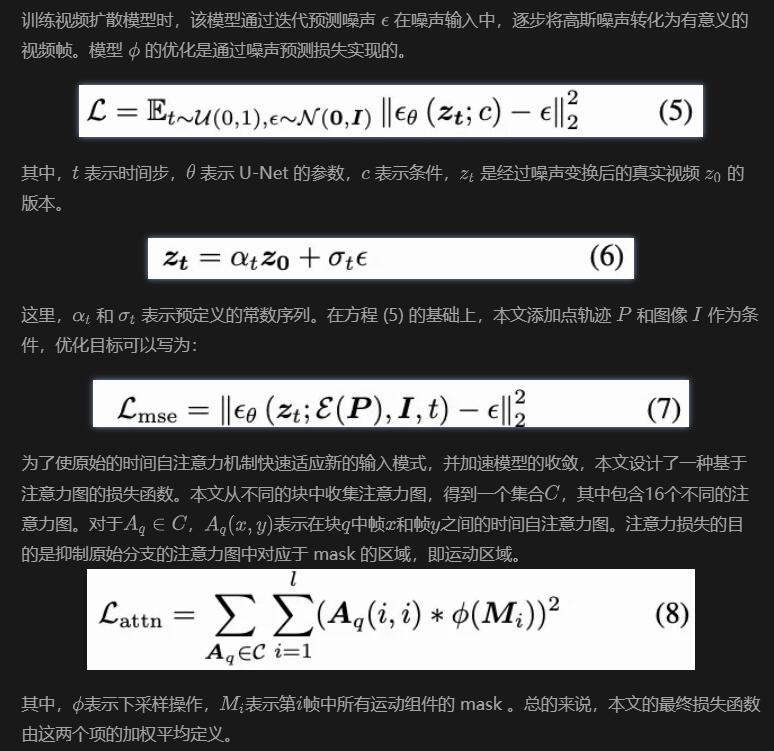

TrackAdapter的訓練和推理

Experiment Settings

數據集。 對于本文的實驗,本文使用了一個內部數據集,該數據集具有優質的視頻質量,包括大約20萬段視頻。根據實驗設計,本文進一步篩選數據,得到約11萬段視頻作為本文的最終訓練數據集。在訓練過程中,每個視頻被調整為1024 × 576的分辨率,并標準化為每段25幀。

本文的測試集包括VIPSeg驗證集以及內部驗證數據集中額外的300段視頻。值得注意的是,VIPSeg數據集中的所有視頻均為16:9的寬高比。為了保持一致性,本文將驗證集中的所有視頻的分辨率調整為1024 × 576,而不是DragAnything中使用的256 × 256。為了評估,本文從測試集中每個視頻的前14幀中提取軌跡。

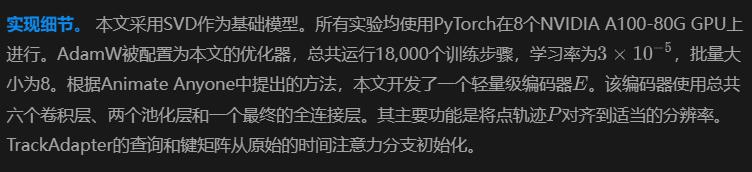

評估指標和基線方法。 本文使用FVD(Frechet Video Distance)來測量視頻質量,并使用FID來測量圖像質量。本文將本文的方法與DragNUWA和DragAnything進行比較,這些方法也可以使用軌跡信息作為條件輸入。根據DragAnything,ObjMC用于通過計算預測軌跡和真實軌跡之間的歐幾里得距離來評估運動控制性能。

定量評價

本文的方法與基線方法的定量比較如下表1所示。本文在VIPSeg驗證集和內部驗證集上測試了所有模型。從結果可以看出,TrackGo在所有指標上都優于其他方法,這表明本文的方法可以生成具有更高視覺質量的視頻,并且更加忠實于輸入的運動控制。本文還比較了三種方法的模型參數和推理速度。由于這三種方法都使用相同的基礎模型,本文的比較專注于新增模塊的總權重。為了評估模型的推理速度,本文在NVIDIA A100 GPU上使用相同的輸入數據對每種方法進行了100次推理測試。結果表明,本文的方法不僅提供了最佳的視覺質量,還實現了最快的推理速度,同時需要的額外參數最少。

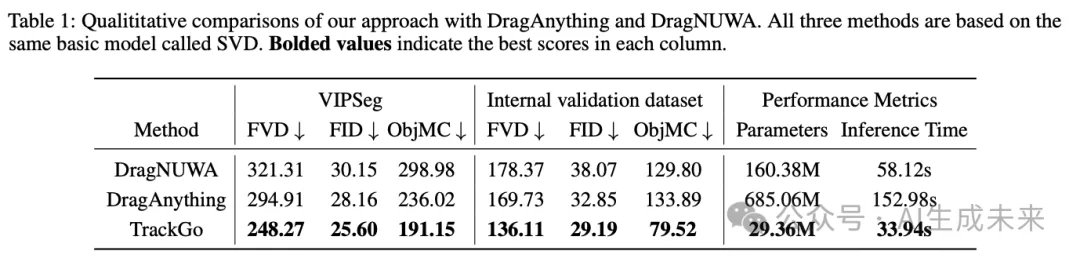

定性評價

可視化。 本文在下圖4中展示了與DragAnything和DragNUWA的可視化比較。本文可以做出以下觀察:首先,DragNUWA在感知控制區域時存在困難,這可能導致光流不完整或不準確。在案例(b)中,行星未被正確感知,而在案例(a)中,槍的移動也是不正確的。在案例(c)中,雖然成功預測了火車的光流,但煙霧的光流缺失導致了刺眼的視覺效果。其次,DragAnything在處理部分或細粒度物體的移動時也面臨困難。如案例(a)所示,只有槍和馬里奧的手應該移動,但馬里奧的整個位置也意外地移動了。類似的問題也出現在案例(b)中。此外,DragAnything難以生成和諧的背景。在案例(c)中,煙霧沒有跟隨移動的火車。相比之下,本文提出的TrackGo可以生成視頻,使目標區域的移動與用戶輸入精確對齊,同時保持背景的一致性和和諧性。這一能力顯著提高了生成視頻的視覺質量和連貫性,展示了TrackGo的有效性。更多本文方法的案例可以在上圖1中找到。

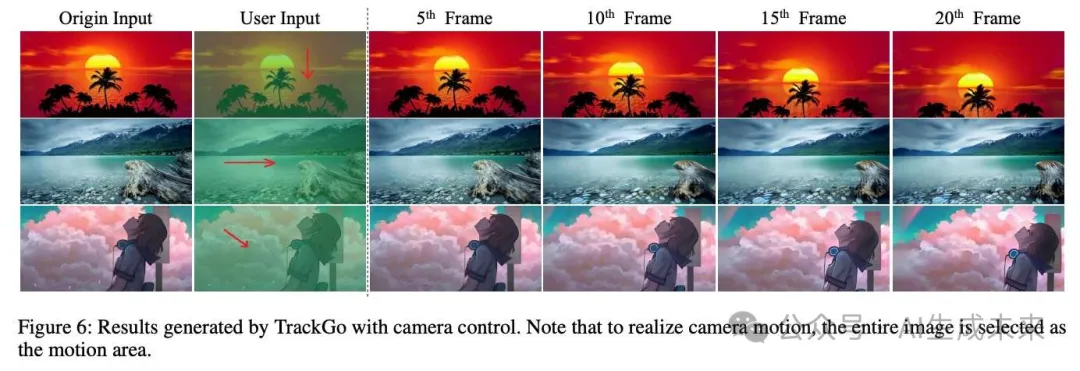

相機運動。 類似于 DragAnything,TrackGo 也能夠實現相機運動效果,如下圖 6 所示。只需選擇整個圖像區域作為運動區域,并提供一個運動軌跡,就可以實現相機沿著該軌跡指定方向移動的效果。

消融研究

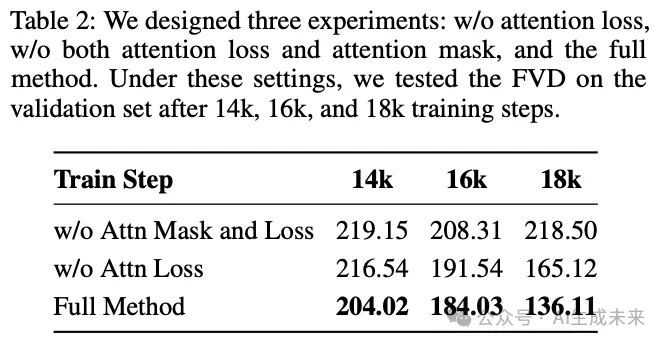

為了驗證注意力 mask 和注意力損失的有效性,本文在不同的訓練步數下報告了內部驗證集上的 FVD 指標,如下表 2 所示。在相同的訓練步數下,未使用注意力損失的模型顯示出略高的 FVD,與使用注意力損失的模型相比。當不使用注意力損失時,FVD 高于應用注意力損失時的水平。這種差異在 18K 訓練步時尤為明顯。這表明使用注意力損失可以加速模型訓練并有助于收斂。在沒有使用注意力 mask 和注意力損失的情況下,FVD 在大約 16K 步時趨于穩定,但仍然顯著高于完整設置下的 FVD。

用戶研究

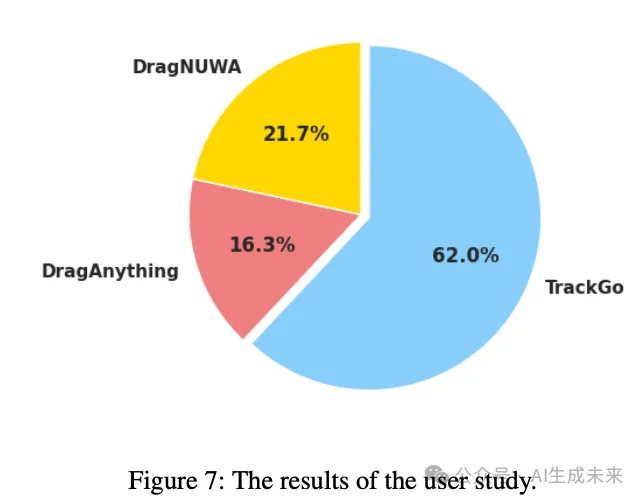

本文進行了一項用戶研究來評估合成視頻的質量。本文隨機抽取了60個案例,并對三種不同的方法進行用戶研究。每份問卷包含從這60個案例中隨機抽取的30個案例。本文要求用戶根據整體質量從兩個方面選擇最佳視頻:生成視頻與給定條件之間的一致性,以及生成視頻的質量(例如,主體是否失真,未選擇的背景是否抖動等)。本文邀請了30人填寫問卷,性別比例約為3:1(男性:女性)。大多數參與者是來自不同科學與工程領域的大學生,年齡在18到27歲之間。結果顯示,本文的方法獲得了62%的投票,高于DragAnything的16.33%和DragNUWA的21.67%,如下圖7所示。

結論

在本文中,本文引入了點軌跡來捕捉視頻中的復雜時間信息。本文提出了TrackAdapter來處理這些點軌跡,重點關注指定目標的運動,并使用注意力 mask 來減輕原始時間自注意力對指定區域的影響。在推理過程中,注意力 mask 可以調節未指定區域的運動,從而使視頻輸出更符合用戶輸入。大量實驗表明,本文的TrackGo在FVD、FID和ObjMC評分上達到了SOTA水平。此外,定性分析顯示,本文的方法在各種復雜場景中提供了精確的控制。

本文轉自 AI生成未來 ,作者:Haitao Zhou等