無需訓(xùn)練!多提示視頻生成最新SOTA!港中文&騰訊等發(fā)布DiTCtrl:基于MM-DiT架構(gòu) 精華

文章鏈接:https://arxiv.org/pdf/2412.18597

項(xiàng)目鏈接:https://github.com/TencentARC/DiTCtrl

亮點(diǎn)直擊

- DiTCtrl,這是一種基于MM-DiT架構(gòu)的、首次無需調(diào)優(yōu)的多提示視頻生成方法。本文的方法結(jié)合了新穎的KV共享機(jī)制和隱混合策略,使得不同提示之間能夠無縫過渡,且無需額外的訓(xùn)練。

- 首度分析了MM-DiT的注意力機(jī)制,發(fā)現(xiàn)其3D全注意力與UNet-like擴(kuò)散模型中的交叉/自注意力塊具有相似的行為,從而實(shí)現(xiàn)了基于mask的精確語義控制,使得不同提示之間的生成更加一致。

- 推出了MPVBench,這是一個(gè)專為多提示視頻生成設(shè)計(jì)的新基準(zhǔn),具有多種過渡類型和專門的評(píng)估指標(biāo),用于多提示視頻的評(píng)估。-大量實(shí)驗(yàn)表明,本文的方法在多提示視頻生成任務(wù)上實(shí)現(xiàn)了業(yè)界領(lǐng)先的性能,同時(shí)保持了計(jì)算效率。

總結(jié)速覽

解決的問題

當(dāng)前的視頻生成模型,尤其是基于單一提示(single-prompt)的模型,如Sora,主要聚焦于生成單一提示下的視頻內(nèi)容。它們?cè)谏啥鄠€(gè)順序提示(multi-prompt)的連貫場(chǎng)景時(shí)存在顯著挑戰(zhàn),尤其是在動(dòng)態(tài)場(chǎng)景中需要反映多個(gè)動(dòng)作時(shí),面臨的問題包括:

- 訓(xùn)練數(shù)據(jù)要求嚴(yán)格;

- 提示跟隨能力較弱;

- 轉(zhuǎn)場(chǎng)不自然,缺乏平滑過渡。

提出的方案本文提出了DiTCtrl方法。這是基于MM-DiT架構(gòu)的、訓(xùn)練無關(guān)的多提示視頻生成方法,首次能夠在沒有額外訓(xùn)練的情況下生成多提示的視頻,且能夠保證多個(gè)提示之間的視頻內(nèi)容平滑過渡。

應(yīng)用的技術(shù)

- MM-DiT架構(gòu):多模態(tài)擴(kuò)散Transformer(Multi-Modal Diffusion Transformer)架構(gòu)被用于視頻生成任務(wù),能夠有效處理文本、圖像和視頻的聯(lián)合表示。

- 3D全注意力機(jī)制:分析了MM-DiT的注意力機(jī)制,發(fā)現(xiàn)其3D全注意力與UNet-like擴(kuò)散模型中的交叉/自注意力模塊相似,能夠在多個(gè)提示之間共享注意力,從而實(shí)現(xiàn)語義一致性。

- KV共享和隱混合策略:為實(shí)現(xiàn)視頻之間的平滑過渡,提出了鍵值共享(KV-sharing)機(jī)制和隱空間混合(latent blending)策略,以連接不同提示生成的視頻片段。

達(dá)到的效果

- 平滑過渡與一致性:通過DiTCtrl方法,生成的視頻在多個(gè)提示之間能夠?qū)崿F(xiàn)平滑的過渡和一致的物體運(yùn)動(dòng),而不需要額外的訓(xùn)練。

- 高效性能:在MPVBench基準(zhǔn)測(cè)試上,DiTCtrl在保持計(jì)算效率的同時(shí),取得了最先進(jìn)的性能。

- 新基準(zhǔn)MPVBench:為了促進(jìn)多提示視頻生成的研究,文章還提出了MPVBench基準(zhǔn),專門用于評(píng)估多提示視頻生成的過渡效果和性能。

方法

MM-DiT 注意力機(jī)制分析

MM-DiT 是當(dāng)前文本到圖像/視頻模型的基礎(chǔ)架構(gòu),與之前的 UNet 架構(gòu)有根本的不同,因?yàn)樗鼘⑽谋竞鸵曨l映射到一個(gè)統(tǒng)一的序列中進(jìn)行注意力計(jì)算。盡管該架構(gòu)已被廣泛使用,但其內(nèi)部注意力機(jī)制的特性尚未得到充分探索,這限制了其在我們多提示長視頻生成任務(wù)中的應(yīng)用。因此,本文首次對(duì)基于最先進(jìn)的視頻模型(即 CogVideoX)的 3D 全注意力圖中的區(qū)域注意力模式進(jìn)行了全面分析。

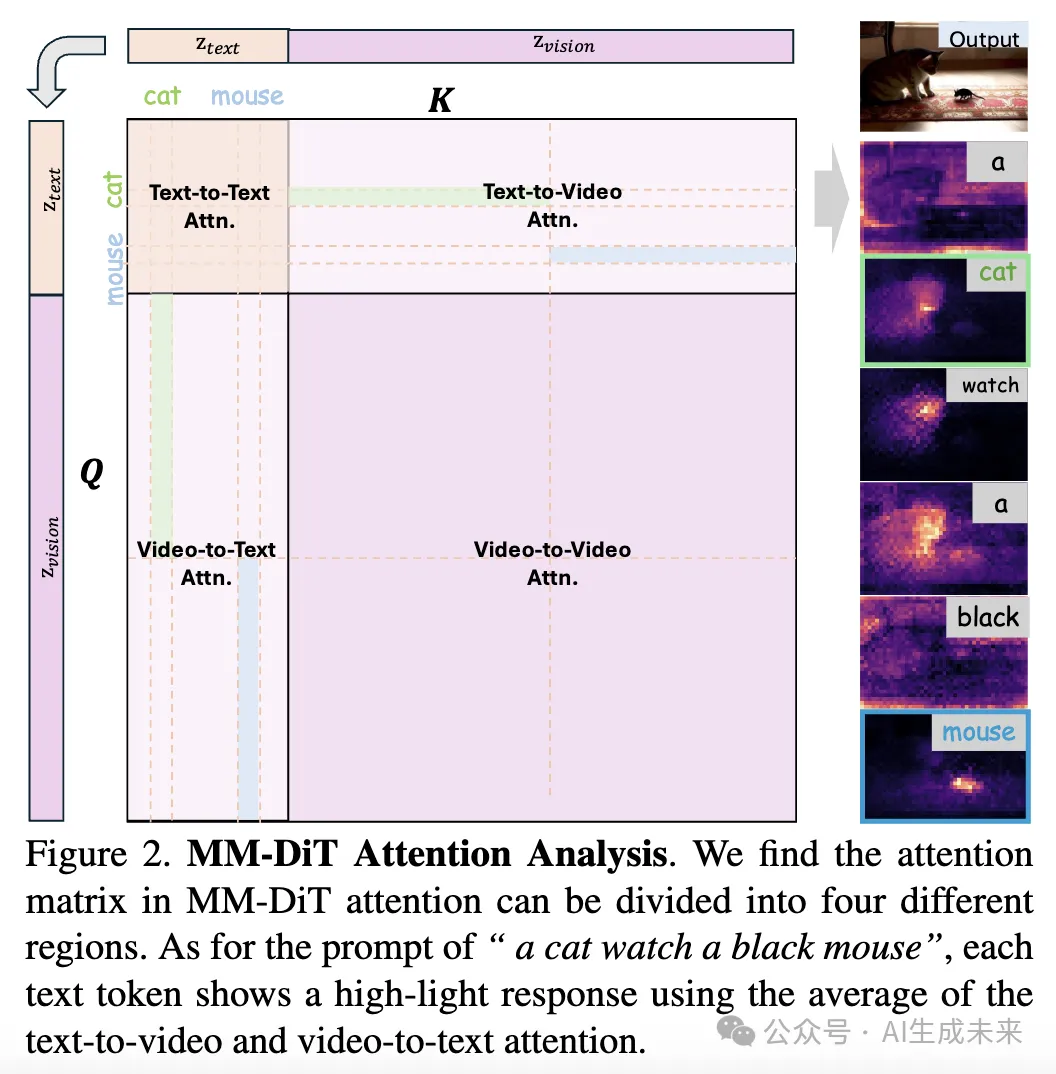

如下圖 2 所示,由于視覺和文本提示的連接,每個(gè)注意力矩陣可以分解為四個(gè)不同的區(qū)域,分別對(duì)應(yīng)不同的注意力操作:視頻到視頻的注意力、文本到文本的注意力、文本到視頻的注意力和視頻到文本的注意力。以下是每個(gè)區(qū)域的詳細(xì)介紹,靈感來源于先前的 UNet-like 結(jié)構(gòu)中的獨(dú)立注意力。

文本到視頻和視頻到文本的注意力

之前的 UNet-like 架構(gòu)通過交叉注意力實(shí)現(xiàn)視頻與文本的對(duì)齊。在 MM-DiT 中,文本到視頻和視頻到文本的注意力發(fā)揮了類似的作用。計(jì)算了所有層和注意力頭的平均注意力值,然后通過選擇特定的列或行來提取文本到視頻和視頻到文本區(qū)域的注意力值,這些列或行對(duì)應(yīng)文本到視頻和視頻到文本區(qū)域中的token索引。接著,這些注意力值被重塑為FxHxW格式,從而能夠可視化每一幀的語義激活圖。如上圖 2 所示,這些可視化結(jié)果顯示了token級(jí)語義定位的顯著精度,能夠有效捕捉文本描述和視覺元素之間的細(xì)粒度關(guān)系。這一發(fā)現(xiàn)為精確的語義控制和定位提供了強(qiáng)有力的基礎(chǔ),為借用已有的圖像/視頻編輯技術(shù)以增強(qiáng)多提示視頻生成的一致性和質(zhì)量提供了支持。

文本到文本和視頻到視頻的注意力

文本到文本和視頻到視頻的區(qū)域注意力在某種程度上是新的,與相應(yīng)的 UNet 結(jié)構(gòu)不同。如下圖 3 所示,本文的分析揭示了這兩個(gè)組件中相似的模式。在文本到文本的注意力組件(圖 3(a)(b),其中 (a) 表示較短提示的注意力模式,(b) 表示較長提示的模式)中,觀察到一個(gè)顯著的對(duì)角線模式,表明每個(gè)文本token主要關(guān)注其鄰近的token。

值得注意的是,隨著文本序列長度的增加,存在明顯的垂直線,這些垂直線向后移動(dòng),表明所有token對(duì)文本序列末尾的特殊token保持顯著關(guān)注。對(duì)于視頻到視頻的注意力組件,由于 MM-DiT 扁平化了空間和時(shí)間token以進(jìn)行 3D 注意力計(jì)算,在單幀級(jí)別的分析揭示了空間注意力中的明顯對(duì)角線模式(上圖 3(c))。更重要的是,當(dāng)檢查來自不同幀中相同空間位置的token構(gòu)建的注意力圖時(shí),還觀察到顯著的對(duì)角線模式(圖 3(d))。這一特征與最近的基于 UNet 的視頻模型中的空間注意力和時(shí)間注意力(如 VideoCrafter 和 Lavie)中的發(fā)現(xiàn)相似,符合 [25] 中的報(bào)告結(jié)果。

由于之前的工作僅訓(xùn)練擴(kuò)散模型的特定部分以進(jìn)行更高級(jí)的控制和生成,本文的發(fā)現(xiàn)為從 MM-DiT 角度看待這些方法提供了有力的證據(jù)。這些在 MM-DiT 架構(gòu)中出現(xiàn)的一致對(duì)角線模式表明了幀間強(qiáng)相關(guān)性,這對(duì)于維持空間-時(shí)間一致性和保留視頻序列中的運(yùn)動(dòng)忠實(shí)度至關(guān)重要。

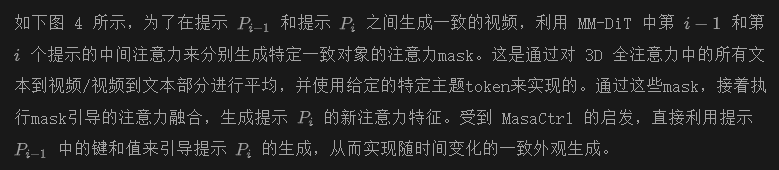

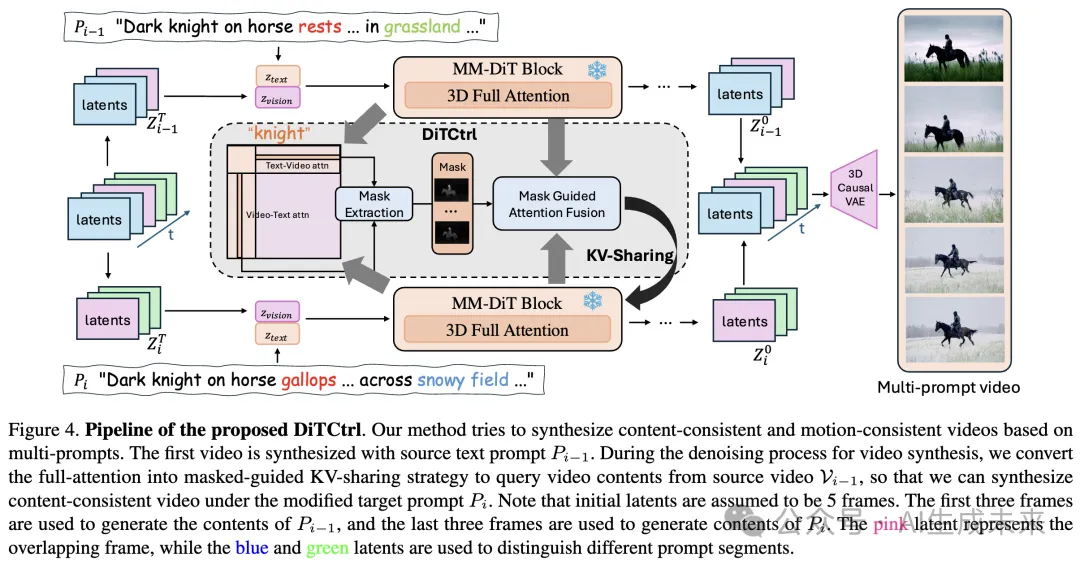

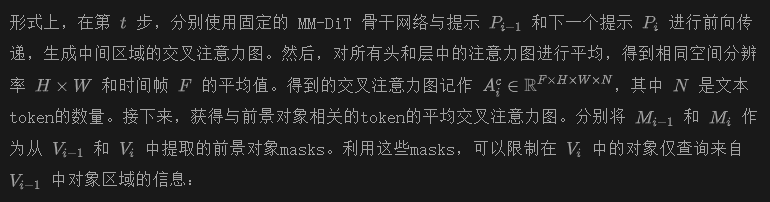

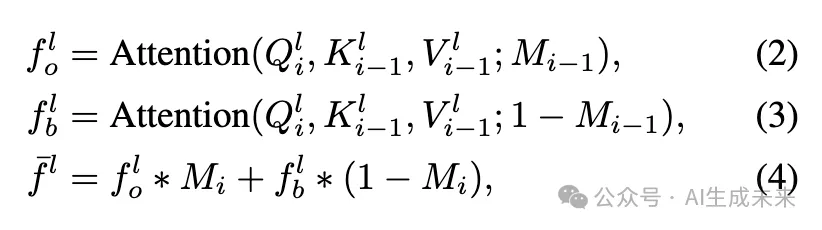

隨時(shí)間一致的視頻生成

MM-DiT 中的注意力機(jī)制與 UNet-like 視頻擴(kuò)散模型中的行為類似。因此,提出了基于mask引導(dǎo)的 KV 共享策略,用于多提示視頻生成任務(wù)中的一致視頻生成。

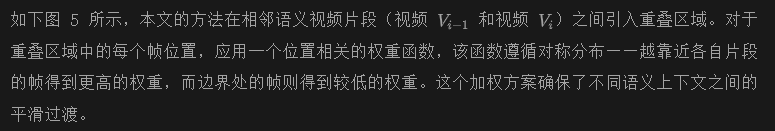

用于過渡的隱混合策略

盡管之前的方法保證了片段之間的語義一致性,但要實(shí)現(xiàn)不同語義片段之間的平滑過渡,仍需要精心設(shè)計(jì)。因此,提出了一種隱混合策略,旨在確保不同語義片段之間的時(shí)間一致性,靈感來源于最近在單提示長視頻生成中的工作 [33, 46]。

本文的方法的關(guān)鍵優(yōu)勢(shì)在于,它不需要額外的訓(xùn)練,同時(shí)能夠有效地處理不同語義上下文之間的過渡。在每個(gè)去噪步驟中,首先獨(dú)立處理每個(gè)片段,然后逐步使用位置相關(guān)的權(quán)重在重疊區(qū)域中融合隱特征。這一策略在保持時(shí)間一致性的同時(shí),平滑地過渡于不同的語義上下文之間,使其特別適用于多提示視頻生成任務(wù)。

實(shí)驗(yàn)

基于 CogVideoX-2B 實(shí)現(xiàn)了 DiTCtrl,CogVideoX-2B 是一種基于 MM-DiT 的先進(jìn)開源文本到視頻擴(kuò)散模型。在實(shí)驗(yàn)中,生成了多提示條件的視頻,每個(gè)視頻片段由 49 幀組成,分辨率為 480×720。此外,還使用了 ChatGPT 來生成不同類型的多個(gè)過渡。在實(shí)驗(yàn)中將隱采樣幀數(shù)和重疊大小設(shè)置為 13 和 6。實(shí)驗(yàn)在單個(gè) NVIDIA A100 GPU 上進(jìn)行。

質(zhì)量結(jié)果

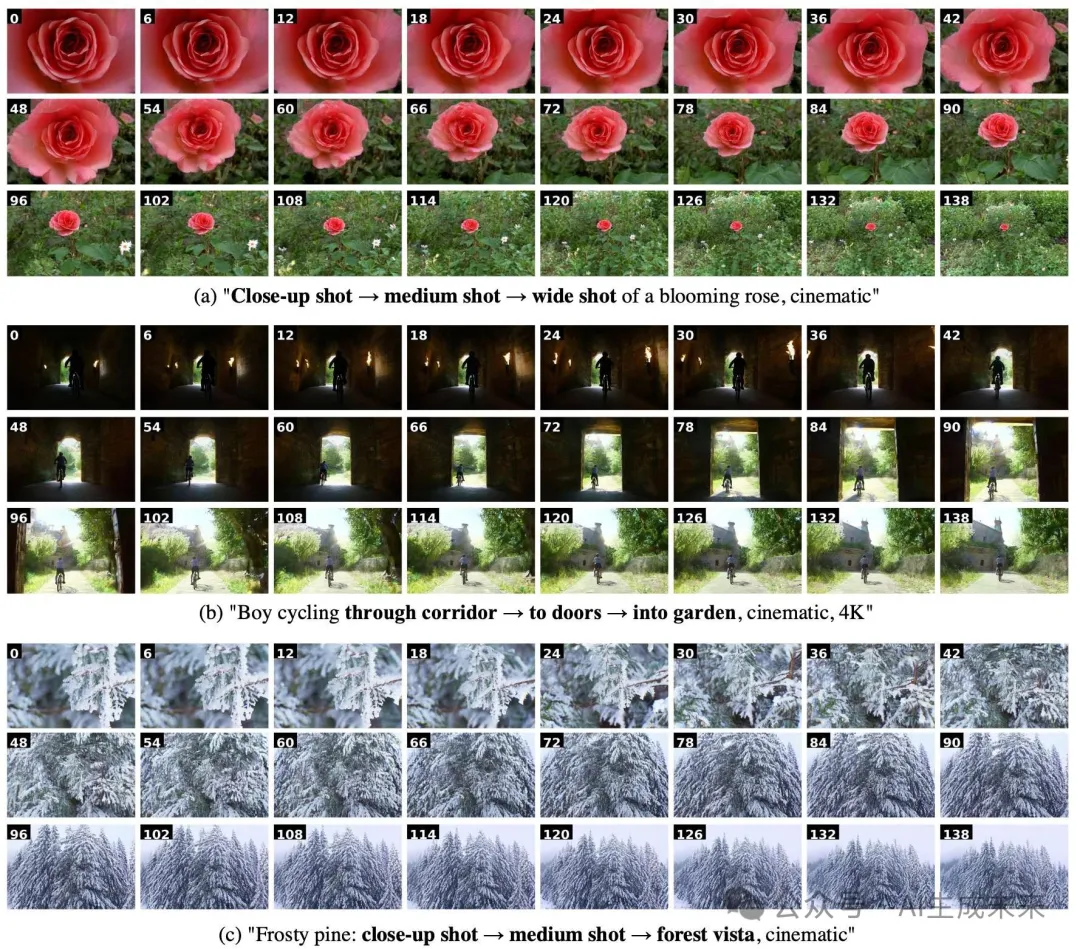

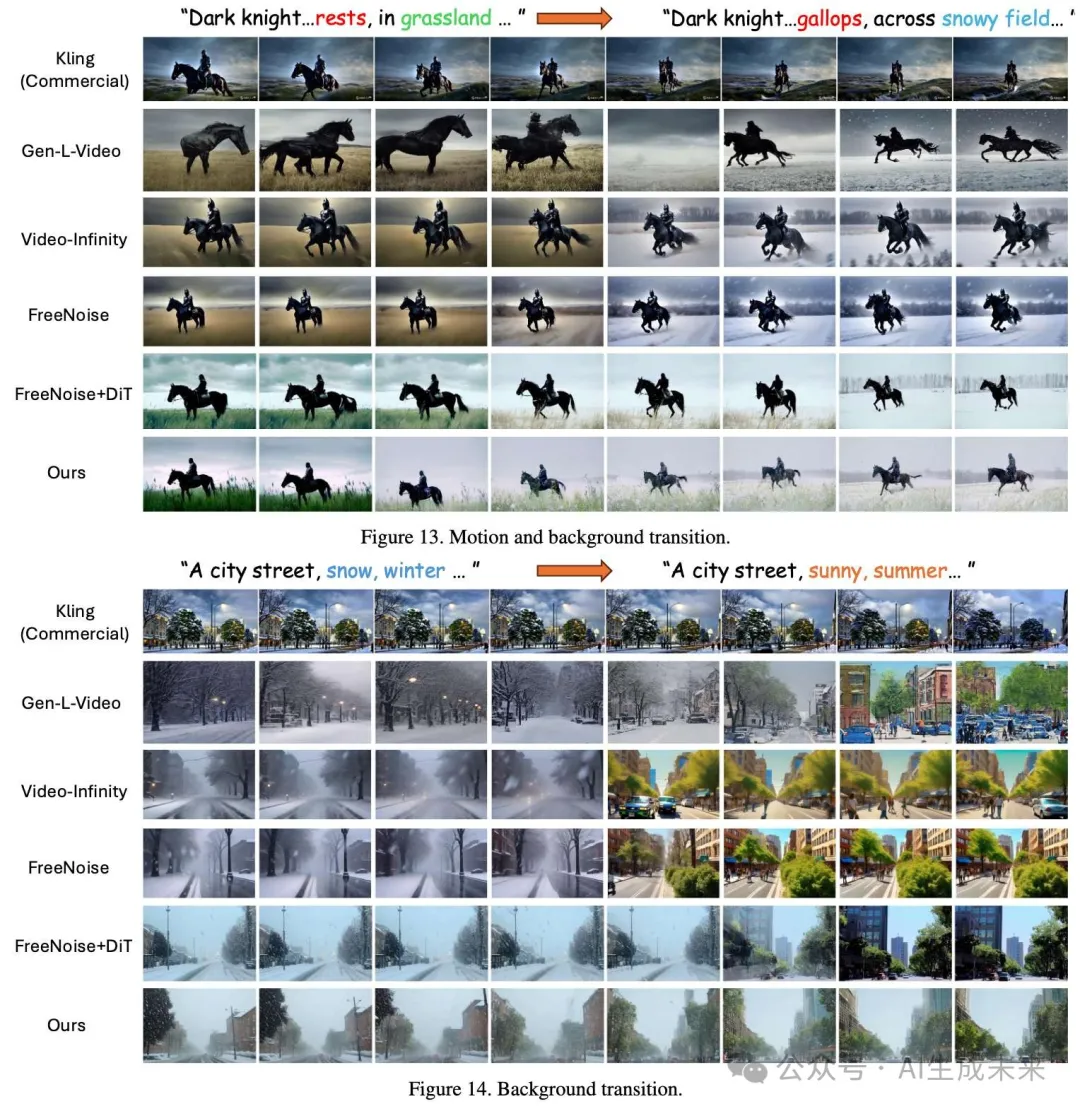

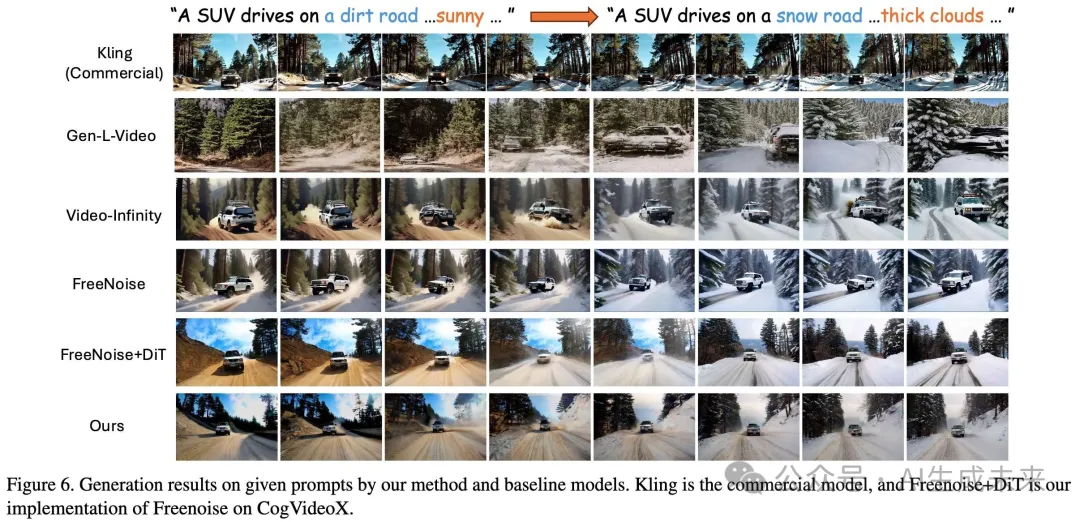

與當(dāng)前最先進(jìn)的多提示視頻生成方法[33, 38, 40] 和領(lǐng)先的商業(yè)解決方案 進(jìn)行了全面的定性比較。為了確保公平比較,還在 CogVideoX 主干上實(shí)現(xiàn)了 FreeNoise,作為增強(qiáng)的基準(zhǔn)。

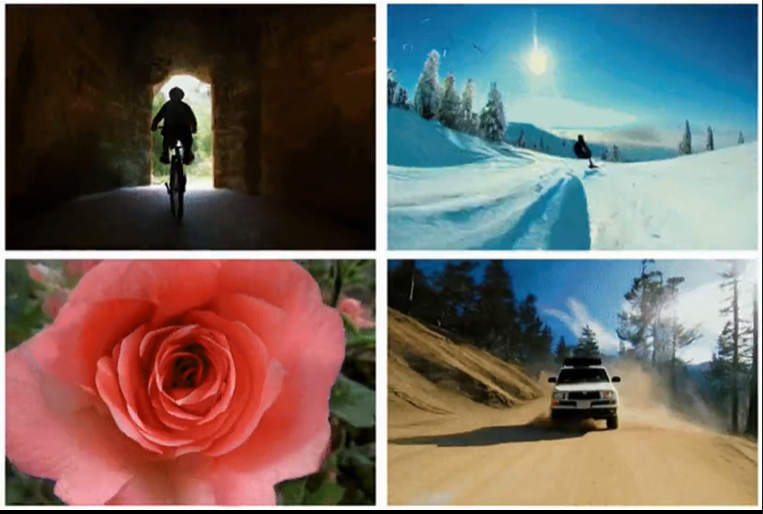

如下圖 6 所示,本文提出的方法在三個(gè)關(guān)鍵方面展示了優(yōu)越的性能:文本到視頻對(duì)齊、時(shí)間一致性和運(yùn)動(dòng)質(zhì)量。盡管 Kling 在高質(zhì)量視頻生成方面展現(xiàn)了令人印象深刻的能力,但它僅限于同時(shí)的多語義混合,而不是順序的語義過渡,這突出了在多提示視頻生成任務(wù)中實(shí)現(xiàn)時(shí)間演變內(nèi)容的重要性。

本文的比較分析揭示了現(xiàn)有方法的 distinct 特征和局限性。Gen-L-Video 存在嚴(yán)重的時(shí)間抖動(dòng)和偶爾的物體消失,影響了整體視頻質(zhì)量。Video-Infinity 和 FreeNoise 都在場(chǎng)景級(jí)語義變化方面取得了成功,但缺乏物理上合理的運(yùn)動(dòng)——例如,在上圖 6 中,車輛看似在運(yùn)動(dòng),但空間位置固定,這是它們基于 UNet 的能力的限制。相比之下,F(xiàn)reeNoise+DiT 利用了 DiT 架構(gòu)的能力實(shí)現(xiàn)了更真實(shí)的物體運(yùn)動(dòng),但在語義過渡上存在困難,導(dǎo)致片段之間出現(xiàn)明顯的中斷。DiTCtrl 方法保留了預(yù)訓(xùn)練 DiT 模型的固有能力,同時(shí)解決了這些局限性,能夠平滑地實(shí)現(xiàn)語義過渡,并在整個(gè)視頻序列中保持運(yùn)動(dòng)一致性。

定量結(jié)果

首先詳細(xì)介紹我們提出的用于評(píng)估多提示視頻生成的新基準(zhǔn) MPVBench,然后討論定量結(jié)果。

MPVBench

MPVBench 包含一個(gè)多樣化的提示數(shù)據(jù)集和一個(gè)專門為多提示生成定制的新度量標(biāo)準(zhǔn)。具體來說,通過利用 GPT-4,生成了 130 個(gè)長格式的提示,涵蓋 10 種不同的過渡模式。然后,對(duì)于多提示視頻生成,觀察到 CLIP 特征在單一提示和多提示場(chǎng)景之間的分布有所不同。如下圖 7 所示,自然視頻的特征點(diǎn)沿著一條連續(xù)曲線分布,而兩個(gè)拼接的孤立視頻的特征點(diǎn)則沿著兩條連續(xù)曲線分布,并且在中間有一個(gè)斷點(diǎn)。

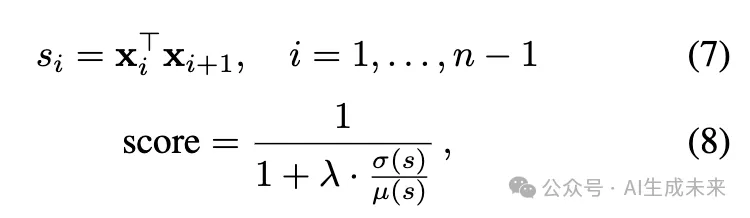

由于常見的 CLIP 相似度計(jì)算的是鄰近相似度的平均值,自然視頻和孤立視頻之間的差異僅在斷點(diǎn)處發(fā)生,并且在按幀數(shù)劃分后,差異會(huì)變得非常小。為了解決這一限制,提出了 CSCV(Clip Similarity Coefficient of Variation),這一度量標(biāo)準(zhǔn)專門用于評(píng)估多提示過渡的平滑度:

自動(dòng)評(píng)估

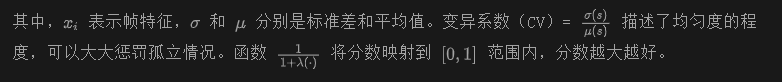

使用 MPVBench 進(jìn)行自動(dòng)評(píng)估。從下表 1 中可以看出,本文的方法獲得了最高的 CSCV 分?jǐn)?shù),證明了在過渡處理和生成模式的整體穩(wěn)定性方面具有優(yōu)勢(shì)。雖然 FreeNoise 排名第二,穩(wěn)定性相對(duì)較強(qiáng),但其他方法在這一方面顯著落后,這與上圖 7 中 CLIP 嵌入的 T-SNE 可視化結(jié)果一致。在運(yùn)動(dòng)平滑性方面,本文的方法在運(yùn)動(dòng)質(zhì)量和一致性方面表現(xiàn)優(yōu)越。在文本-圖像相似度指標(biāo)方面,盡管 FreeNoise 和 Video-Infinity 獲得了更高的分?jǐn)?shù),但這可以歸因于我們方法的 KV-sharing 機(jī)制,在該機(jī)制下,后續(xù)視頻片段本質(zhì)上從前面的語義內(nèi)容中學(xué)習(xí)。

如前面圖6所示,本文的設(shè)計(jì)選擇允許路面逐漸過渡到雪地條件,同時(shí)保留之前場(chǎng)景的特征。盡管可能會(huì)導(dǎo)致較低的文本-圖像對(duì)齊得分,但它確保了序列中的語義連續(xù)性。在實(shí)際應(yīng)用中,這種權(quán)衡并不會(huì)對(duì)多提示場(chǎng)景中的視覺質(zhì)量產(chǎn)生負(fù)面影響,如下面我們展示的用戶研究結(jié)果所示。

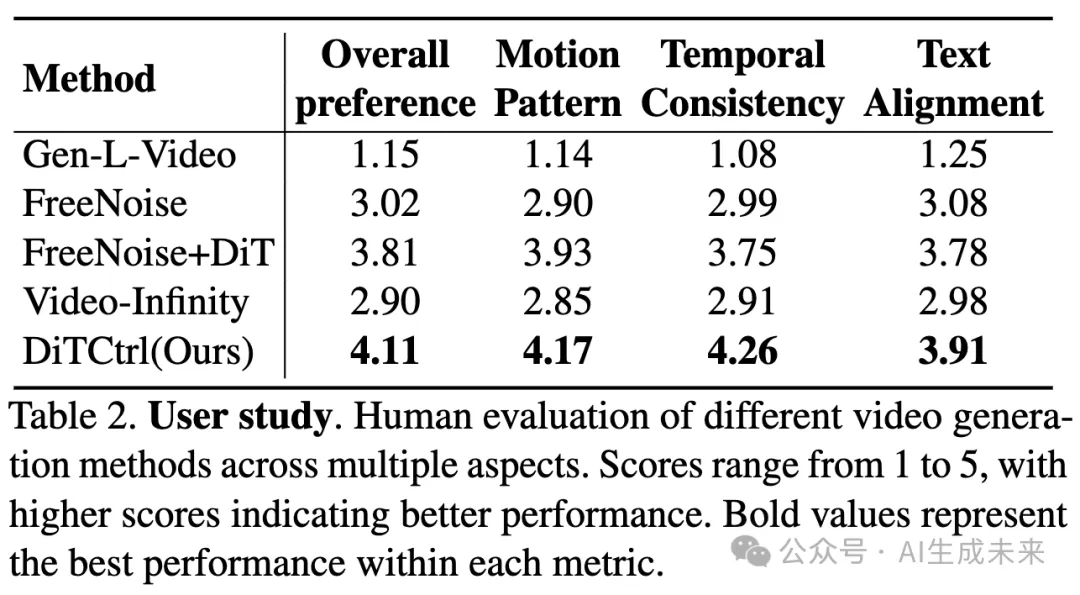

人類評(píng)估

邀請(qǐng)了28名用戶評(píng)估五個(gè)模型:Gen-L-Video、Video-Infinity、FreeNoise、FreeNoise+DiT 和本文的方法。使用5點(diǎn)Likert量表(1代表低質(zhì)量,5代表高質(zhì)量)。參與者根據(jù)16個(gè)不同場(chǎng)景生成的視頻,考慮整體偏好、運(yùn)動(dòng)模式、時(shí)間一致性和文本對(duì)齊情況對(duì)每種方法進(jìn)行評(píng)分。正如下表2所示,本文的方法在所有四個(gè)標(biāo)準(zhǔn)上顯著超越了其他現(xiàn)有方法,展示了在生成具有自然語義過渡的視頻方面的卓越能力,能夠更好地與人類對(duì)視覺連貫性和連續(xù)性的偏好相符。

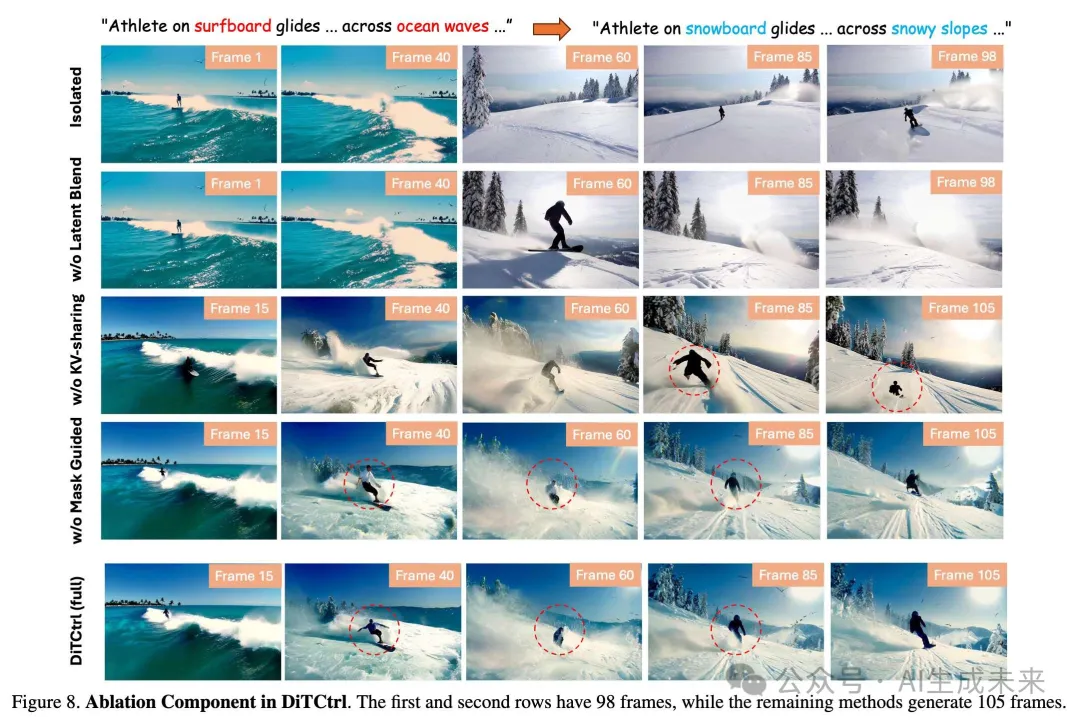

消融研究

進(jìn)行消融研究,以驗(yàn)證DiTCtrl關(guān)鍵組件的有效性:隱融合策略、KV-sharing機(jī)制和掩模引導(dǎo)生成,如下圖8所示。第一行顯示了直接使用文本-視頻模型的結(jié)果,導(dǎo)致場(chǎng)景變化突兀,運(yùn)動(dòng)模式斷裂,無法保持從沖浪到滑雪過程中運(yùn)動(dòng)的一致性。第二行表明,未使用隱融合策略的DiTCtrl能夠?qū)崿F(xiàn)基本的視頻編輯功能,但場(chǎng)景之間缺乏平滑過渡。沒有KV-sharing(第三行)的DiTCtrl表現(xiàn)出不穩(wěn)定的環(huán)境過渡和顯著的運(yùn)動(dòng)偽影,角色縮放不一致,動(dòng)作變形。此外,沒有掩模引導(dǎo)(第四行)的DiTCtrl提高了運(yùn)動(dòng)一致性和過渡效果,但在不同提示和環(huán)境之間的對(duì)象屬性混亂方面存在問題。另一方面,完整的DiTCtrl實(shí)現(xiàn)提供了對(duì)生成內(nèi)容的最精確控制,展示了卓越的對(duì)象一致性和更平滑的提示過渡,同時(shí)保持所需的運(yùn)動(dòng)模式。這些結(jié)果驗(yàn)證了對(duì)MM-DiT注意力機(jī)制的分析及其在實(shí)現(xiàn)準(zhǔn)確語義控制中的作用。

更多應(yīng)用

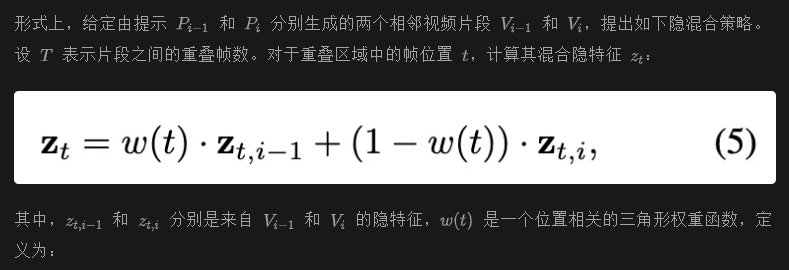

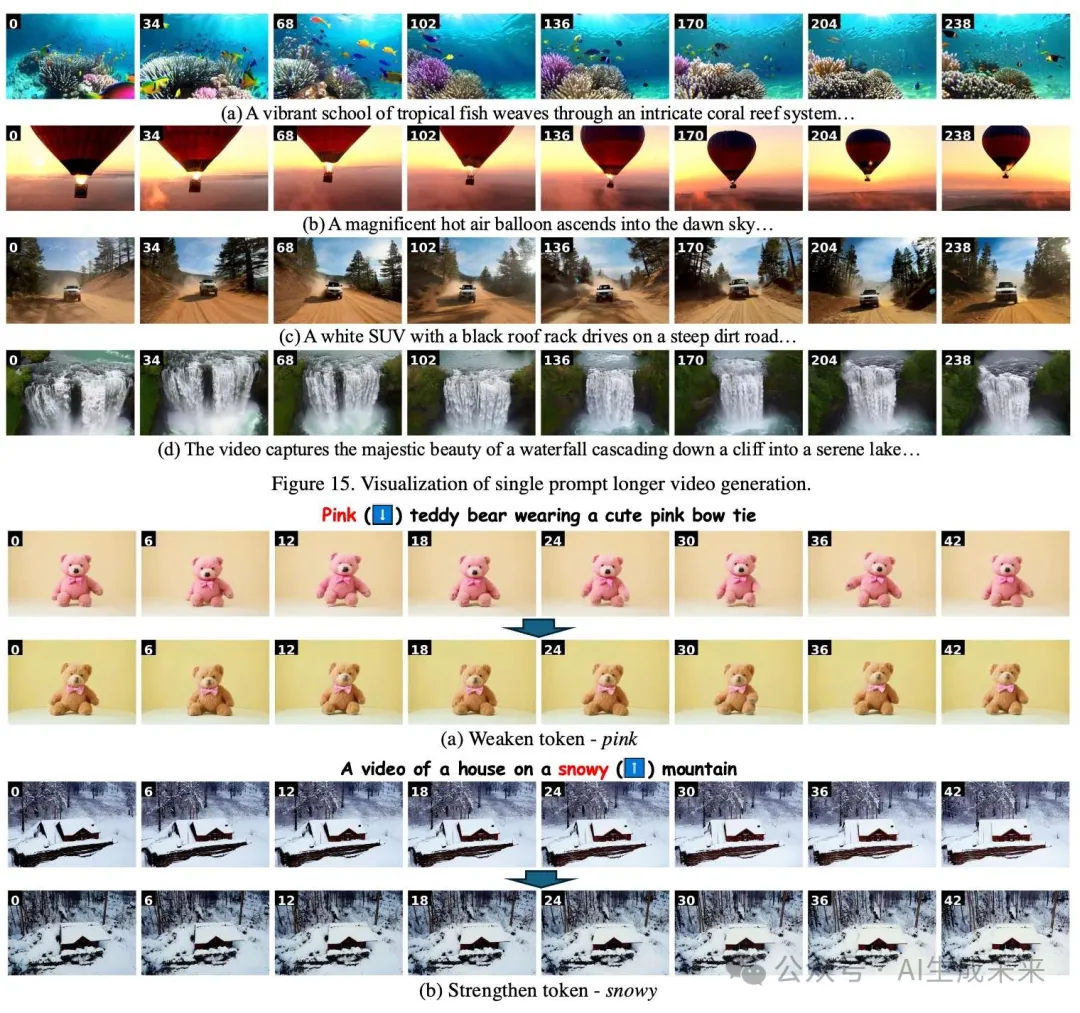

單提示長視頻生成

本文的方法能夠自然地應(yīng)用于單提示長視頻生成。如下圖9所示,使用提示“A white SUV drives on a steep dirt road”,本文的方法成功生成了長度超過原始視頻12倍的視頻,同時(shí)保持了一致的運(yùn)動(dòng)模式和環(huán)境連貫性。這表明,本文的技術(shù)不僅適用于多提示視頻生成任務(wù),還能有效地?cái)U(kuò)展到長時(shí)間視頻的生成,確保了生成內(nèi)容在時(shí)間維度上的連貫性和一致性。

視頻編輯本文展示了如何使用本文的方法實(shí)現(xiàn)視頻編輯功能(例如,“重新加權(quán)”和“單詞替換”)。通過這些操作,能夠在不破壞視頻原有結(jié)構(gòu)和連貫性的情況下,靈活地編輯視頻內(nèi)容。這使得我們的技術(shù)不僅僅適用于新視頻的生成,還能作為強(qiáng)大的視頻編輯工具,在多個(gè)語義變化的場(chǎng)景下保持視頻的整體一致性與流暢過渡。

結(jié)論

本文介紹了DiTCtrl,一種基于MM-DiT架構(gòu)的多提示視頻生成的創(chuàng)新方法,且無需額外的訓(xùn)練。對(duì)MM-DiT的注意力機(jī)制進(jìn)行了開創(chuàng)性的分析,揭示了其與UNet-like擴(kuò)散模型中的交叉/自注意力模塊的相似性,這使得在提示之間能夠?qū)崿F(xiàn)mask引導(dǎo)的語義控制。通過引入KV共享機(jī)制和隱融合策略,DiTCtrl確保了語義段之間的平滑過渡和一致的對(duì)象運(yùn)動(dòng),無需額外的訓(xùn)練。此外,還提出了MPVBench,這是首個(gè)針對(duì)多提示視頻生成的廣泛評(píng)估框架,旨在推動(dòng)該領(lǐng)域未來的研究。

局限性與未來工作盡管本文的方法展示了最先進(jìn)的性能,但仍然存在兩個(gè)主要局限性。首先,與圖像生成模型相比,當(dāng)前開源的視頻生成模型在概念組合能力上較弱,偶爾會(huì)導(dǎo)致不同語義段之間的屬性綁定錯(cuò)誤。其次,基于DiT架構(gòu)的計(jì)算開銷對(duì)推理速度提出了挑戰(zhàn)。這些局限性為未來研究提供了有前景的方向,特別是在增強(qiáng)語義理解和架構(gòu)效率方面。

本文轉(zhuǎn)自AI生成未來 ,作者:AI生成未來