LLM蒸餾到GNN,性能提升6.2%!Emory提出大模型蒸餾到文本圖|CIKM 2024

近年來,隨著文本屬性圖(TAG)在社交媒體、電子商務、推薦系統和學術引用網絡等領域的廣泛應用,研究人員對如何有效地從這些復雜數據結構中學習變得越來越感興趣。TAG不僅包含了節點之間的結構關系,還包含了節點本身的文本特征,因此如何同時處理這兩種信息成為研究中的一個核心問題。

當前,圖神經網絡(GNN)在TAG學習中得到了廣泛的應用,然而其訓練過程通常需要大量的人工標注數據,這在實際應用中往往難以獲取。

大語言模型(LLM)以其在少樣本和零樣本學習中的出色表現,為解決數據稀缺問題帶來了曙光。然而,LLM的部署和使用成本高昂,且存在隱私數據泄露的風險,這使得LLM在一些實際場景中的應用受到了限制。

為了解決這些問題,埃默里大學(Emory)大學的研究團隊提出了一種通過知識蒸餾將LLM的能力轉移到本地圖模型的方法,該方法創新性地結合了LLM的推理能力與GNN的結構化學習能力,通過將LLM生成的詳細推理過程轉化為圖模型能夠理解的信息,從而在無需依賴LLM的情況下,實現高效的TAG學習。

論文鏈接:https://arxiv.org/pdf/2402.12022

在將LLM蒸餾到本地模型的目標下,研究團隊面臨了多重挑戰,主要集中在以下幾個方面:

1. 如何讓語言模型教會圖模型?

大語言模型是生成性模型,能夠輸出詳細而豐富的文本信息,而圖神經網絡則通常是判別性模型,其輸入和輸出都相對簡潔。傳統的知識蒸餾方法通過對齊輸出的方式,難以讓圖模型充分吸收語言模型中的知識。因此,如何在訓練過程中有效地將語言模型中的豐富知識傳遞給圖模型,是研究團隊面臨的一個重要難題。

2. 如何將文本推理轉化為圖推理?

大語言模型生成的推理依據通常以自然語言的形式存在,而圖模型難以直接理解這些文本信息。因此,如何將這些文本推理轉化為圖模型能夠理解的圖推理,是一個未被充分探索且具有挑戰性的問題。研究團隊需要設計出一種方法,使得圖模型能夠利用語言模型的推理依據來增強自身的學習能力。

3. 如何在蒸餾過程中協同文本和圖信息?

文本屬性圖(TAG)同時包含文本和圖結構信息,這兩者之間高度異構。在知識蒸餾過程中,如何確保學生模型能夠同時保留文本和圖信息以及它們之間的相互作用,是研究團隊面臨的另一重大挑戰。研究團隊需要找到一種方法,使得學生模型不僅能從解釋器模型中繼承知識,還能在沒有語言模型支持的情況下,獨立處理并理解這些異構信息。

方法

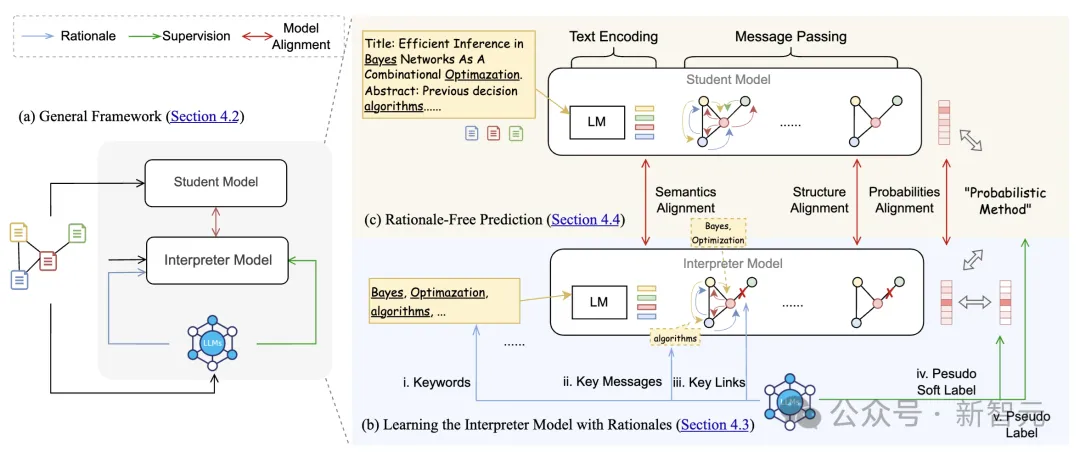

在這項研究中,Emory大學的研究團隊提出了一種創新的框架,通過蒸餾大語言模型(LLM)的知識來增強圖神經網絡(GNN)在文本屬性圖(TAG)學習中的性能。該方法分為兩大核心部分:解釋器模型的訓練和學生模型的對齊優化。

1. 解釋器模型的訓練

多層次特征增強: 研究團隊首先設計了一個解釋器模型,該模型的主要任務是理解并吸收LLM生成的推理依據。為了讓解釋器模型能夠有效地學習LLM的知識,研究團隊將LLM的推理依據轉化為多層次的圖推理增強特征。具體來說,這些特征包括:

- 文本級特征:LLM識別并提取與分類最相關的關鍵詞,從而減少文本中可能干擾模型分類的噪聲信息。這些關鍵詞通過文本編碼器進行處理,以生成增強的文本嵌入。

- 結構級特征:LLM分析每個節點的鄰居節點,識別出對節點分類最重要的鄰居節點,并提取這些鄰居節點中的關鍵信息。這些增強的結構特征用于圖卷積網絡(GNN)的信息傳遞過程中。

- 消息級特征:在結構級特征的基礎上,LLM進一步識別出每個鄰居節點中最關鍵的消息內容,并將其整合到消息傳遞的第一層中。通過這種方式,解釋器模型能夠聚焦于更具相關性的鄰居信息,從而提高分類精度。

偽標簽與偽軟標簽生成:為了提供更加細膩的監督信號,研究團隊使用LLM生成的偽標簽和偽軟標簽來訓練解釋器模型。偽軟標簽包含了每個類別的概率信息,這比硬分類標簽提供了更多的監督信息,有助于解釋器模型更好地學習LLM的推理邏輯。

2. 學生模型的對齊優化

模型對齊方法: 為了讓學生模型在沒有LLM支持的情況下也能做出準確預測,研究團隊設計了一種新的TAG模型對齊方法,該方法同時考慮了語義和結構的對齊。

- 語義對齊:研究團隊通過對比解釋器模型和學生模型的文本嵌入,特別是那些在結構中出現頻率較高且關鍵詞差異較大的節點,來實現語義對齊。這種對齊方式確保了學生模型能夠更好地繼承解釋器模型中的語義信息。

- 結構對齊:在結構對齊中,研究團隊關注那些鄰居結構變化較大的節點,計算這些節點的原始鄰居結構與增強鄰居結構之間的相似度。通過最小化這些差異,確保學生模型能夠在圖結構信息上與解釋器模型保持一致。

多任務學習與對齊目標:在訓練過程中,研究團隊采用多任務學習的方法,使用交叉熵損失來優化偽標簽的預測,同時使用均方誤差損失來對齊解釋器模型和學生模型的輸出。最終的訓練目標整合了語義對齊和結構對齊的損失,使得學生模型能夠在沒有LLM的情況下進行高效推理。

實驗與結果

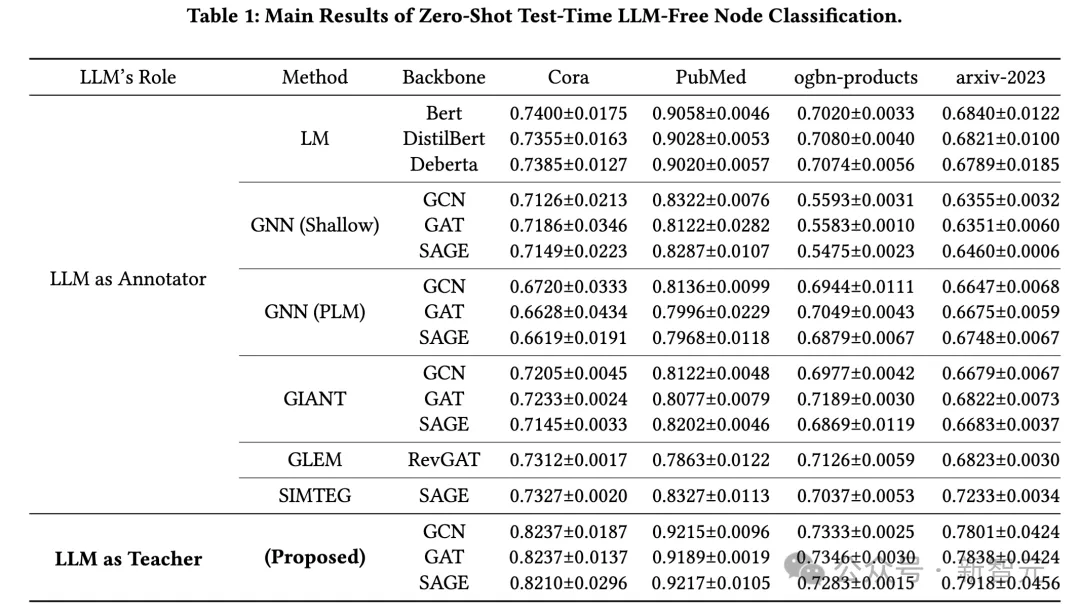

研究團隊在四個廣泛使用的文本屬性圖數據集上驗證了他們的方法,包括Cora、PubMed、ogbn-products和arxiv-2023數據集。實驗結果顯示,該方法在所有數據集上均表現出色,特別是在標簽稀缺的情況下,性能提升尤為顯著。

在Cora數據集上,該方法的準確率相比現有方法提高了10.3%,而在PubMed和ogbn-products數據集上,分別提高了2.2%和4%。特別是在arxiv-2023數據集上,由于其內容超出了現有大語言模型的知識截止日期,研究團隊的方法依然實現了8.3%的性能提升,進一步證明了該方法在處理新穎和未見數據方面的能力。

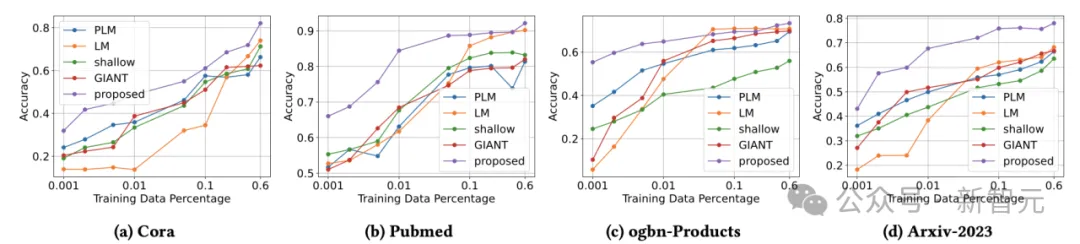

研究團隊進一步分析了不同訓練數據比例下的模型性能,結果顯示該方法在訓練數據稀缺的情況下仍能保持優異的表現。這表明,通過蒸餾LLM的推理能力到學生模型,該方法能夠在有限的數據下有效學習,顯示出強大的泛化能力。

在計算成本方面,盡管研究團隊的方法在訓練時需要處理更多的輸入輸出數據(如LLM生成的推理依據),但其訓練和測試時間與現有方法相當,顯示出良好的效率。尤其是在處理大型數據集時,這種蒸餾方法能夠顯著降低計算成本,使其在實際應用中更具可行性。

結論

研究團隊的工作為如何在不依賴LLM的情況下有效利用其能力提供了新的思路。通過將大語言模型的知識蒸餾到本地圖模型中,研究人員不僅成功解決了TAG學習中的標簽稀缺問題,還顯著提升了模型的性能和遷移性。這一研究不僅在學術界具有重要意義,也為工業界在隱私保護和成本控制方面提供了實用的解決方案。

本文轉自 新智元 ,作者:新智元