兼顧身份保護和文本對齊!中山大學等提出CoRe:任意提示的文本到圖像個性化生成! 精華

文章鏈接:https://arxiv.org/pdf/2408.15914

?

亮點直擊

- CoRe只用于輸出embedding和注意力圖,不需要生成圖像,可以用于任意提示。

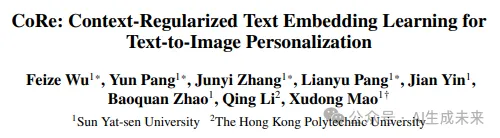

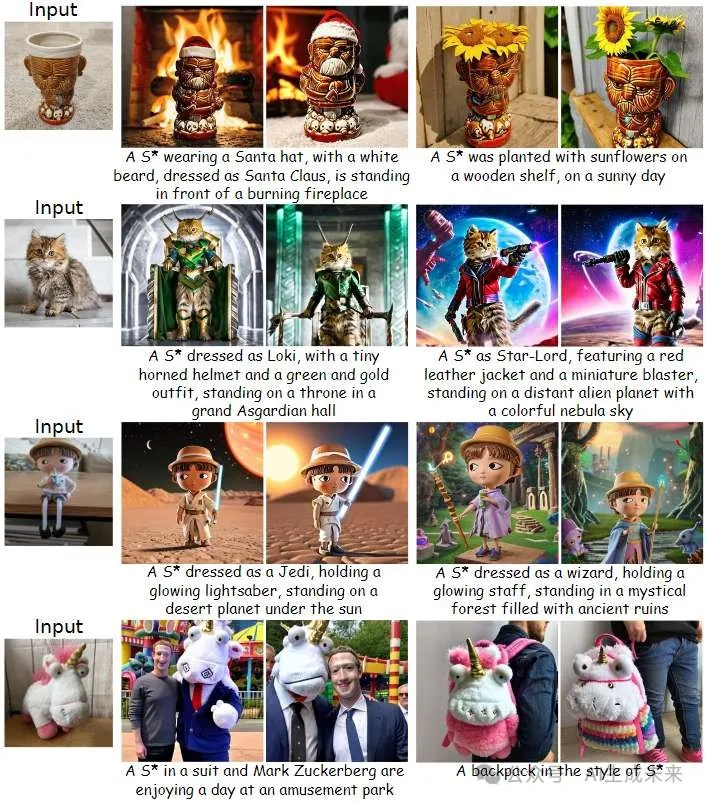

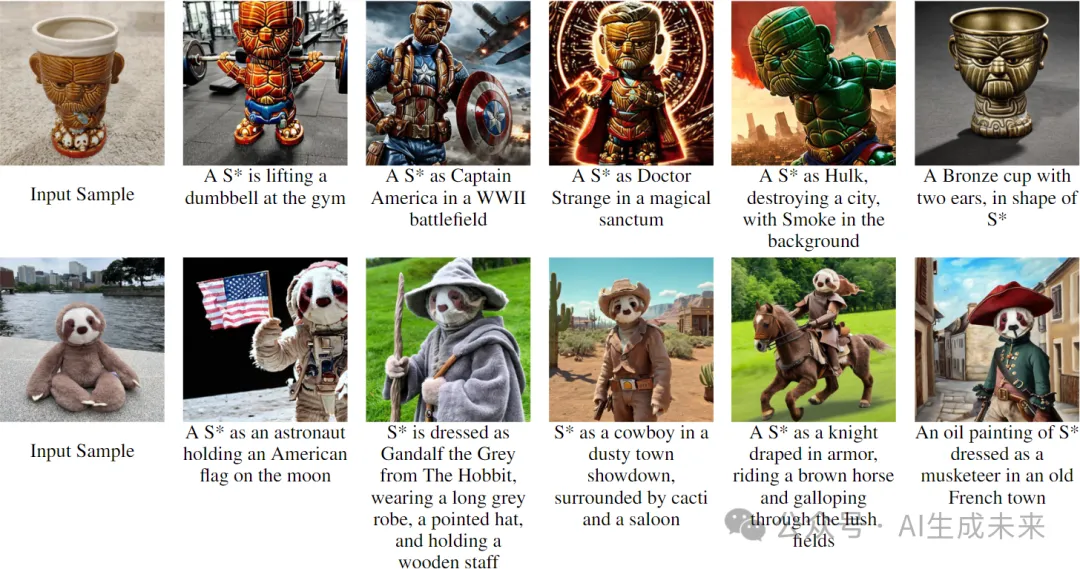

- 在身份保護和文本對齊方面表現出優越的性能,特別是對于需要高度視覺可變性的提示。

- 除了個性化一般對象外,方法還可以很好地實現人臉個性化,與最近的三種人臉個性化方法相比,生成了更多保留身份的人臉圖像。

近年來,文本到圖像的個性化生成技術取得了顯著進展,能夠針對用戶提供的概念實現高質量且可控的圖像合成。然而,現有的方法在平衡身份保留和文本對齊方面仍然面臨挑戰。本方法基于這樣一個事實,即生成與提示語對齊的圖像需要對提示語有精確的語義理解,這涉及到在CLIP文本編碼器中準確處理新概念與其周圍上下文token之間的交互。為了解決這個問題,目標是將新概念正確地嵌入文本編碼器的輸入embedding空間,從而實現與現有token的無縫整合。

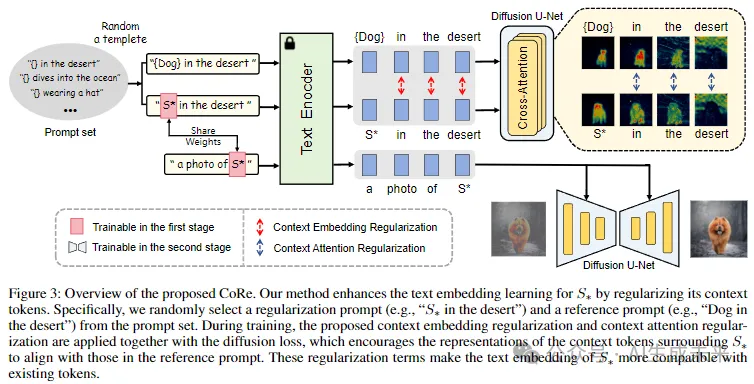

本文引入了上下文正則化(Context Regularization, CoRe),通過對提示語中的上下文token進行正則化,來增強新概念文本embedding的學習。這基于這樣一種洞察:只有當新概念的文本embedding被正確學習時,文本編碼器對上下文token的輸出向量才是合適的。CoRe可以應用于任意提示語,而不需要生成相應的圖像,從而提高了學習到的文本embedding的泛化能力。此外,CoRe還可以作為一種測試時優化技術,進一步增強特定提示語的生成效果。

全面的實驗結果表明,本文方法在身份保護和文本對齊方面均優于若干baseline方法。

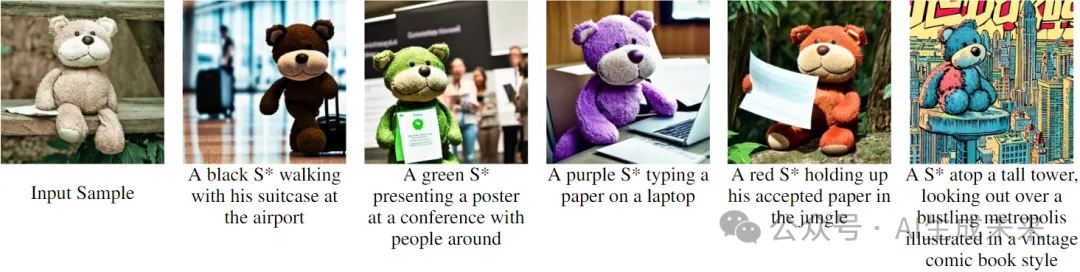

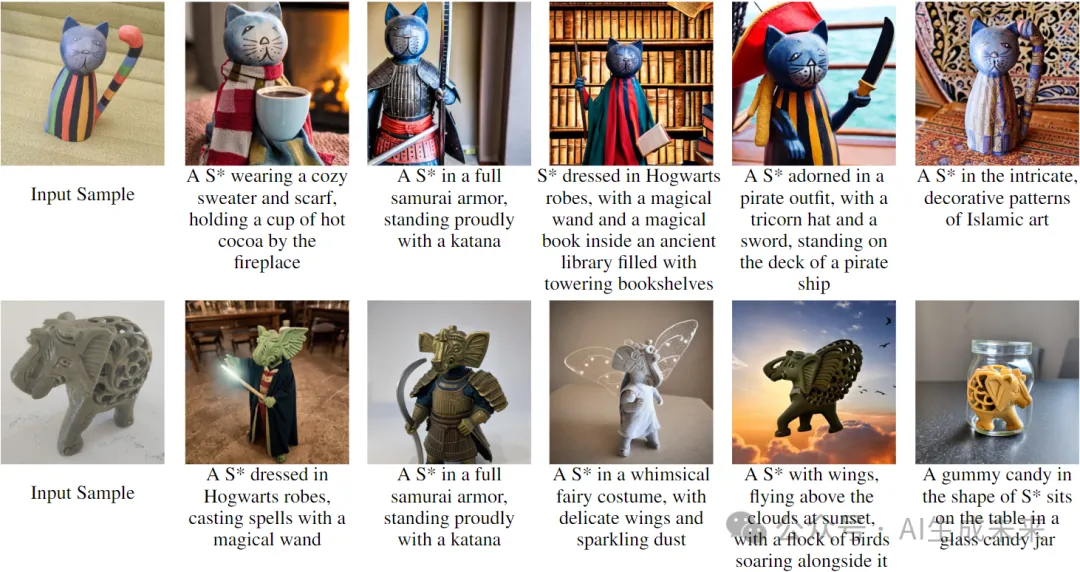

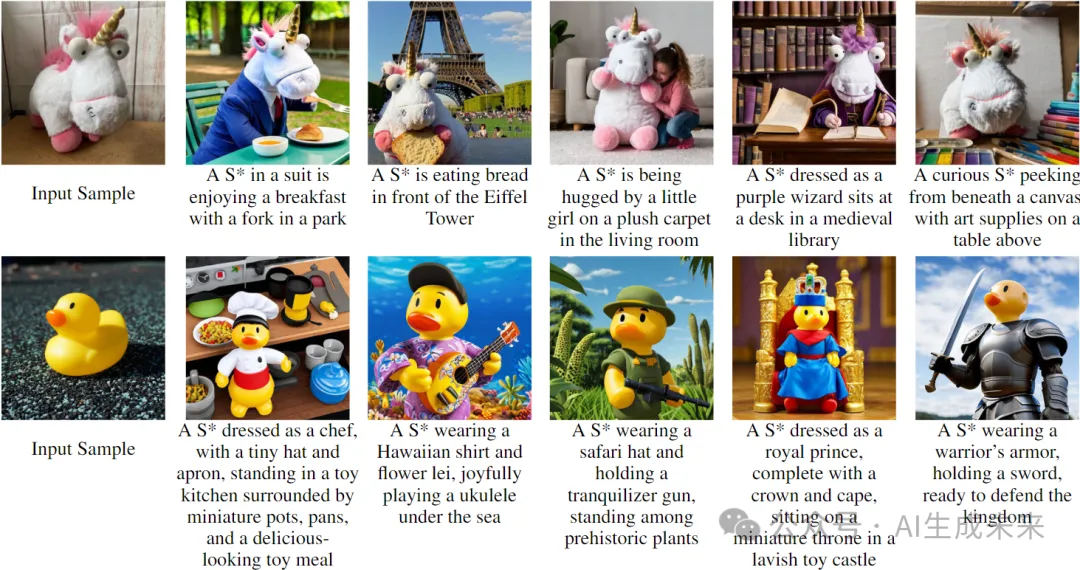

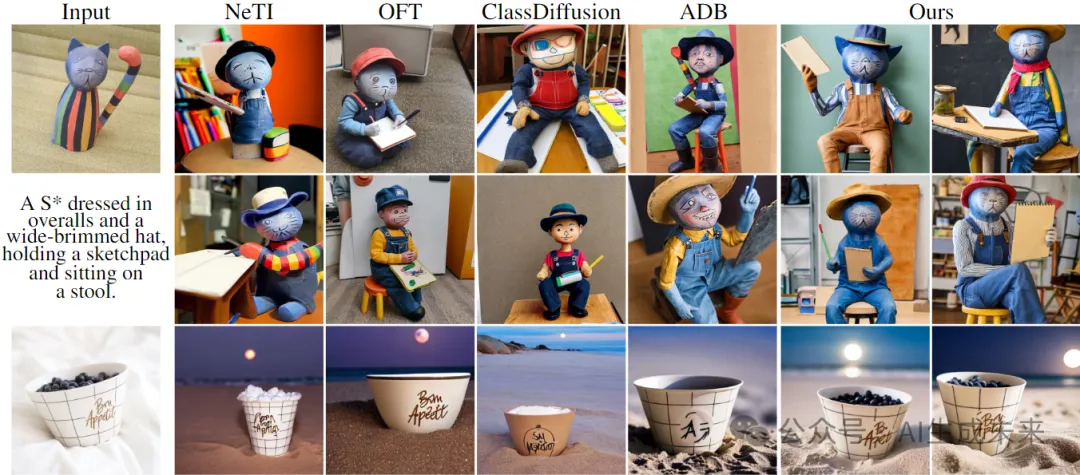

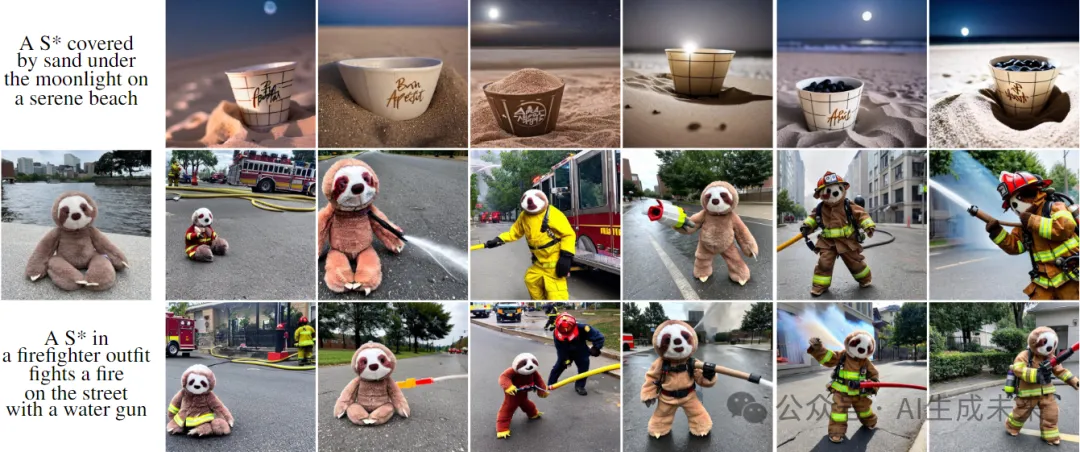

生成效果展示

方法

使用CoRe進行文本embedding學習

為了實現文本對齊的生成,目標是為新概念學習一種合適的文本embedding,使其能夠與現有token兼容并無縫集成。這是因為文本對齊的生成依賴于對提示語的精確語義理解,而這又取決于新概念與其他token之間的正確交互。本方法不是直接改進新概念的嵌入,而是集中于約束新概念周圍的上下文token。

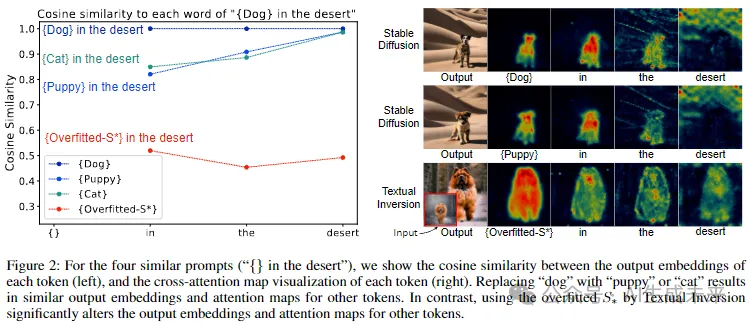

本方法來自于兩個關鍵見解。首先,只有當新概念的輸入embedding被正確學習時,才能獲得合適的上下文token輸出embedding;否則,它會對文本編碼器中的上下文token輸出embedding產生不利影響。其次,當在提示語中將對象token替換為另一個時,上下文token的輸出embedding和注意力圖應大致保持一致。通過實驗驗證了這些見解,如下圖2所示。例如,在提示語“沙漠中的狗”中,用文本反演方法(Textual Inversion)過擬合的embedding替換“狗”會顯著改變其他token的輸出embedding和注意力圖。相比之下,用“貓”替換“狗”則保持了輸出embedding和注意力圖的一致性。

基于這些見解,提出了上下文正則化(Context Regularization, CoRe),通過正則化上下文token來增強新概念的文本embedding學習。對于包含新概念的訓練提示語,通過用超類token替換新概念token來構造參考提示語。然后,對這兩個提示語的上下文token輸出embedding和注意力圖施加相似性約束。需要注意的是,本文上下文正則化可以與任意提示語一起使用,因為它僅應用于輸出embedding和注意力圖,而不需要生成圖像。因此構建了一個正則化提示語集,以覆蓋廣泛的提示語。

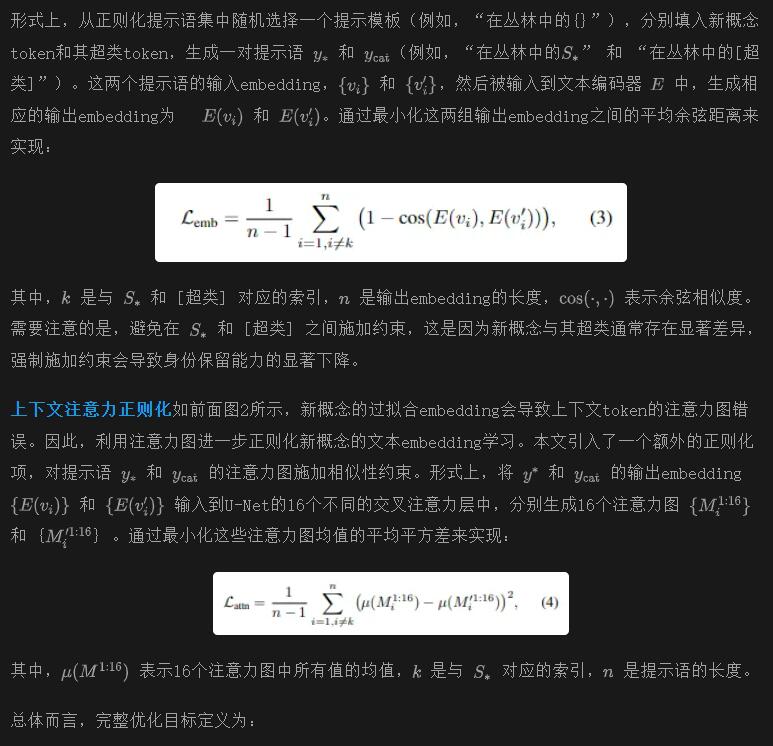

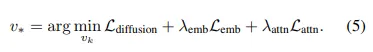

上下文嵌入正則化

Embedding重縮放

正如 (Alaluf et al., 2023; Pang et al., 2024a) 所指出的那樣,在優化過程中,新概念的文本embedding的尺度往往會變得過大,導致文本對齊能力的顯著下降。受到 (Alaluf et al., 2023) 的啟發,本文提出在優化過程中對文本embedding的范數進行重縮放,以緩解這一問題。具體來說,在一次優化步驟后,將更新后的embedding的范數重置為與前一步相匹配。重縮放后的embedding表示為:

Embedding到身份的訓練策略

僅僅優化文本embedding不足以捕捉概念身份。受到 (Roich et al., 2022; Pang et al., 2024b) 的啟發,本文提出了一個兩階段的訓練策略。首先,使用 CoRe 來學習與現有token兼容的新概念的文本embedding。這產生了一個可編輯的嵌入,但僅對概念身份提供了粗略的描述。在第二階段,凍結文本embedding,并微調 U-Net 的所有層,以精確捕捉概念身份。

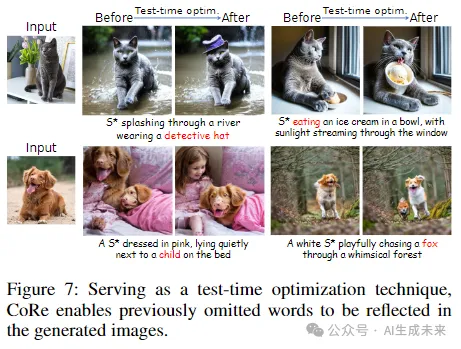

測試時優化

在測試時,CoRe 可以作為一種測試時優化技術,來增強特定提示語的生成。具體來說,給定一個用于生成的提示語,通過使用 CoRe 執行一些額外的優化步驟,來細化與該提示語相關的輸出embedding和注意力圖。這種細化是在不使用擴散損失的情況下完成的。需要注意的是,在本文實驗中,為了確保公平比較,在與baselines方法進行比較時并未應用此測試時優化策略。

實驗

數據集

為了全面評估,研究者們收集了24個來自先前研究的概念 。按照 (Tewel et al., 2023) 的方法,將這些概念分為兩組:有生命的物體(例如“貓”和“娃娃”)和無生命的物體(例如“鐘”和“漿果碗”)。相應地,為這兩組分別使用了兩套提示語。一些提示語適用于所有概念,包括背景變化、概念顏色變化和藝術風格變化,而其他提示語則特定于有生命的物體,例如動作和服裝變化。

評估設置

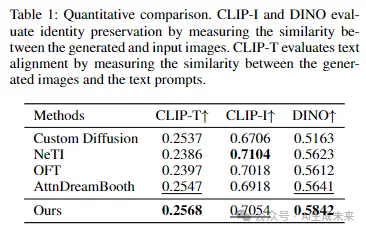

將本文方法與四種近期的baseline方法進行了比較:Custom Diffusion、NeTI、OFT和 AttnDreamBooth。對于定量評估,使用了一組20個提示語,并使用以下指標進行評估:

(1) 身份保留,通過CLIP-I和 DINO特征空間中生成圖像與輸入圖像之間的視覺相似性來衡量;:

(2) 文本對齊,通過生成圖像與提示語之間的 CLIP-T 相似性來衡量。按照 (Zeng et al., 2024) 的方法,CLIP-I 和 DINO 分數僅在前景遮罩的圖像上計算,以消除背景變化,更好地反映概念身份的相似性。此外,涉及風格化或服裝變化的提示語被排除在 CLIP-I 和 DINO 分數計算之外,因為這些修改會顯著改變概念的外觀。本文方法和基線的實現細節在附錄中提供。

結果

定性評估

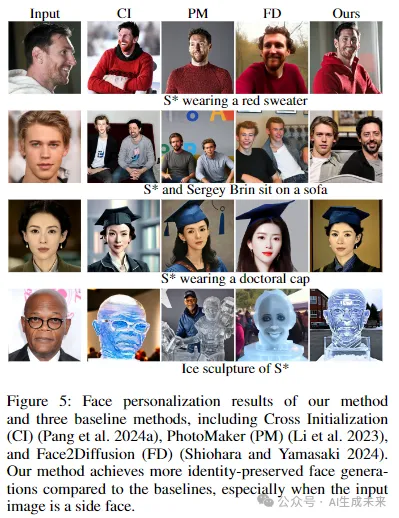

雖然本文方法主要設計用于個性化一般物體,但在個性化人臉方面也表現良好。下圖5展示了我們在人臉個性化方面的結果,與三種專門的人臉個性化方法進行比較,包括 Cross Initialization、PhotoMaker 和 Face2Diffusion。本文結果在身份保留方面優于這些基線方法。

定量評估

研究者們使用24個概念和20個文本提示語對每種方法進行了定量評估,每個概念的每個提示語生成32個樣本。結果如下表1所示。需要注意的是,由于定量指標在準確評估這些提示語的生成圖像質量方面的局限性,需要高視覺可變性的提示語被排除在定量評估之外,主要有兩個原因。首先,這類提示語會顯著改變概念的外觀,使其不適合用于測量與輸入圖像的身份相似性。其次,那些在生成過程中忽略新概念的方法往往會獲得較高的文本對齊分數,因為這些分數的計算不考慮新概念。因此,使用相對簡單的提示語,本文方法在CLIP-T分數上略高于AttnDreamBooth。在CLIP-I和DINO分數方面,本文方法優于AttnDreamBooth,這可能是由于AttnDreamBooth在文本embedding學習方面的不足。NeTI獲得了最高的CLIP-I分數,但在文本對齊方面得分最低,這表明其有過擬合新概念的傾向。總體而言,結果表明本文方法在身份保留和文本對齊之間實現了比基線方法更好的平衡。

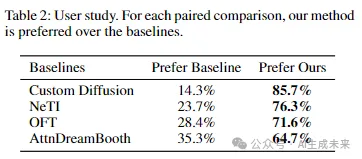

用戶研究

本文進行了一項成對的人工偏好研究,以比較CoRe與基線方法。在每個問題中,展示兩張生成的圖像,一張來自本文方法,一張來自基線方法,使用相同的提示語。參與者被要求根據身份保留和文本對齊來評估生成的圖像。我們從60名參與者那里收集了1200個反饋。正如下表2所示,參與者明顯更偏好本文方法,這表明本文方法在身份保留和文本對齊方面具有優勢。

消融研究

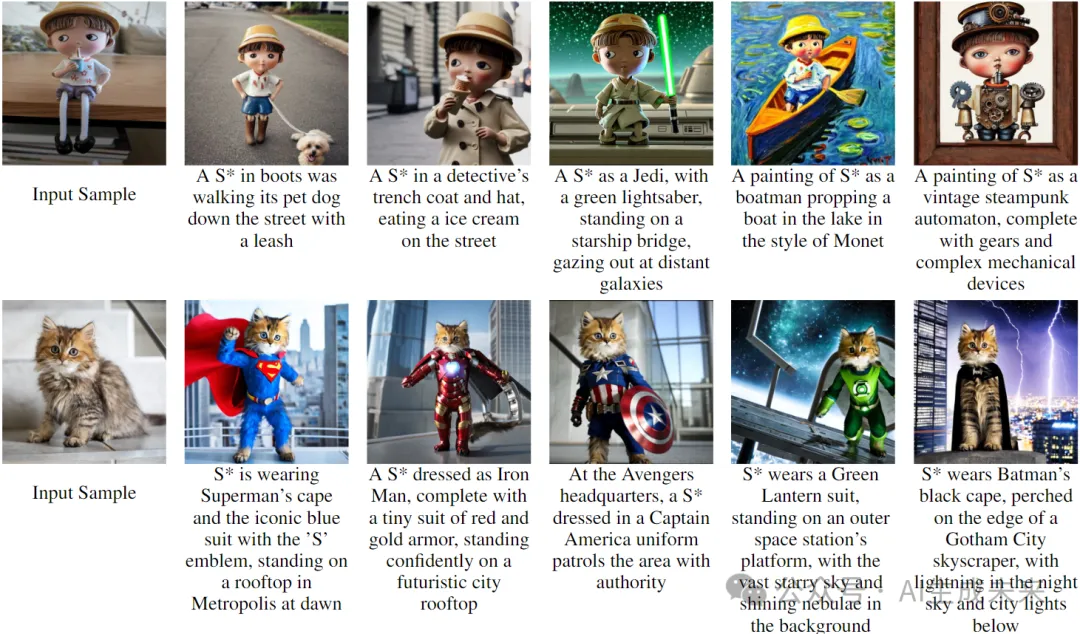

研究者們對方法的每個子模塊進行了消融實驗,以展示其貢獻。圖6展示了消融研究的結果。如圖所示,缺少上下文嵌入正則化會導致身份保留和文本對齊的退化。缺少上下文注意力正則化的模型傾向于生成與輸入相似的圖像,表明可能對概念過擬合。此外,在沒有應用嵌入重縮放策略的情況下,模型在文本對齊和身份保留方面也表現出輕微的退化。更多的消融研究結果可以在附錄中找到。

測試時優化

研究者們評估了CoRe在測試時優化中的有效性。對于給定的特定生成提示語,我們使用CoRe執行額外的10次優化步驟,以細化該提示語的輸出embedding和注意力圖。如圖7所示,這種策略有助于使生成結果更好地與提示語對齊,使之前被忽略的詞匯能夠在新圖像中得到體現。例如,在第二行中,測試時優化有效地將意外出現的“狗”替換為正確的“孩子”,并恢復了丟失的“狐貍”。

結論與局限性

本文提出了一種名為CoRe的個性化方法,通過正則化上下文token來增強新概念的文本embedding學習。該方法基于這樣的見解:只有當新概念的文本embedding正確學習時,才可能實現上下文token的適當輸出embedding。本文實驗結果表明,CoRe優于基線方法。如下圖7所示,本文方法在涉及學習概念和其他物體的復雜組合時仍面臨挑戰,這部分是從預訓練模型中繼承的。CoRe可以作為一種測試時優化技術,來增強此類復雜組合的生成。

本文轉自 AI生成未來 ,作者:Feize Wu等