從弱模型和強模型合成文本到SQL數據 原創

論文來自中國科學院深圳先進技術研究院、中國科學院大學、阿里巴巴集團

論文標題:Synthesizing Text-to-SQL Data from Weak and Strong LLMs

論文鏈接:??https://arxiv.org/pdf/2408.03256??

1、論文背景

在使用標準化提示進行評估后,論文觀察到開源模型與閉源模型之間文本到SQL的性能仍存在顯著差距。特別是,流行的開源模型 CodeLLaMA-13B-Instruct 在 BIRD基準測試中的執行準確率比 GPT-4 低 30%。

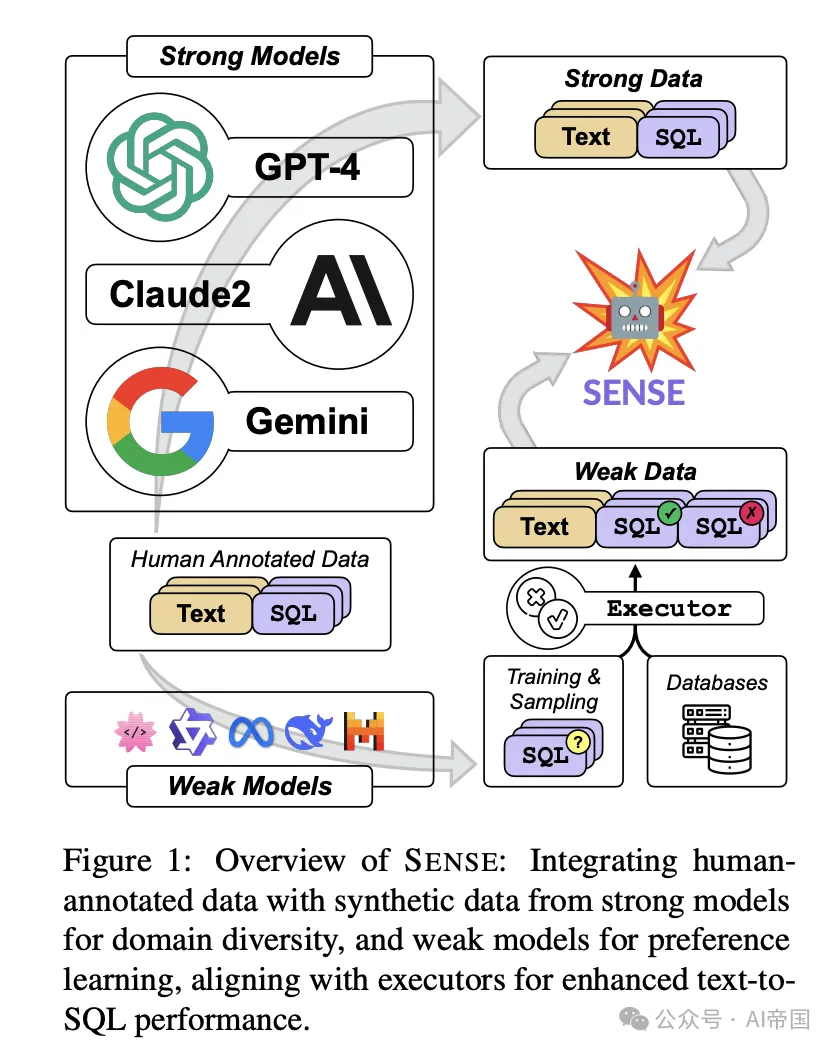

圖 1:SENSE 概覽:將人工標注數據與強模型生成的合成數據結合,以增強領域多樣性,并通過弱模型進行偏好學習,與執行器對齊,從而提升文本到 SQL 的性能。

針對數據稀缺的挑戰,眾多研究致力于利用更大、更強大的大型語言模型(強模型),如GPT-4,生成所謂的強數據。盡管強數據本質上增強了數據多樣性,這對模型的領域泛化至關重要,但其在文本到SQL任務中的應用仍未被探索。此外,生成有價值的不正確文本到SQL數據也構成了單獨的挑戰。強模型通常在正確對齊和安全性方面投入巨大努力,使得獲取錯誤樣本變得困難。因此,論文將注意力轉向較小、對齊程度較低的開源模型(弱模型)。弱模型產生有價值的弱SQL樣本,這些樣本隨后可以通過執行器的輔助進行驗證和錯誤誘導。偏好學習(Rafailov et al., 2023)被用來指導語言模型從正確和錯誤樣本中學習,論文稱之為弱數據。

為了驗證SENSE的有效性,論文對一個流行的開源基礎模型,即CodeLLaMA進行監督微調(SFT),并獲得了一個新的專業模型SENSE。論文全面評估了SENSE在文本到SQL任務上的性能,在標準基準Spider(Yu et al., 2018)和挑戰性基準BIRD(Li et al., 2023c)上都取得了最先進(SOTA)的結果,縮小了開源模型與閉源模型之間的差距。此外,論文在三個魯棒性數據集上評估了SENSE:SYN、REALISTIC和DK,展示了其在魯棒性方面的優勢。

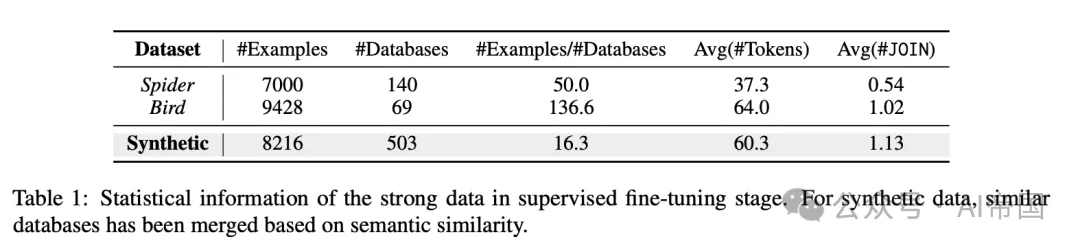

表1 :監督微調階段強數據的統計信息。對于合成數據,基于語義相似性合并了類似的數據庫。

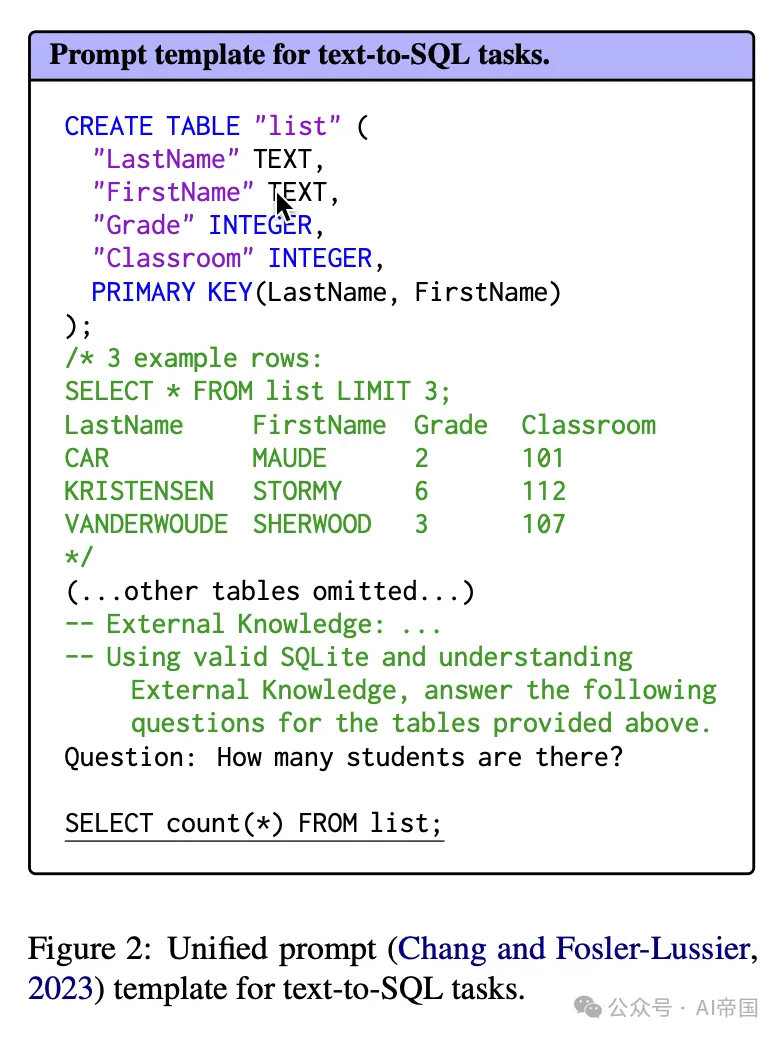

圖2:統一提示(Chang和Fosler-Lussier,2023)模板用于文本到SQL任務。

2、方法論

首先,論文通過監督微調(SFT)增強基礎模型的文本到SQL能力,主要關注數據的多樣性和質量。論文將這部分數據稱為強數據。隨后,論文采用偏好學習,激勵模型從錯誤的SQL中學習,論文將其稱為弱數據,需要使用較弱的語言模型進行錯誤生成。

2.1 強數據:監督微調

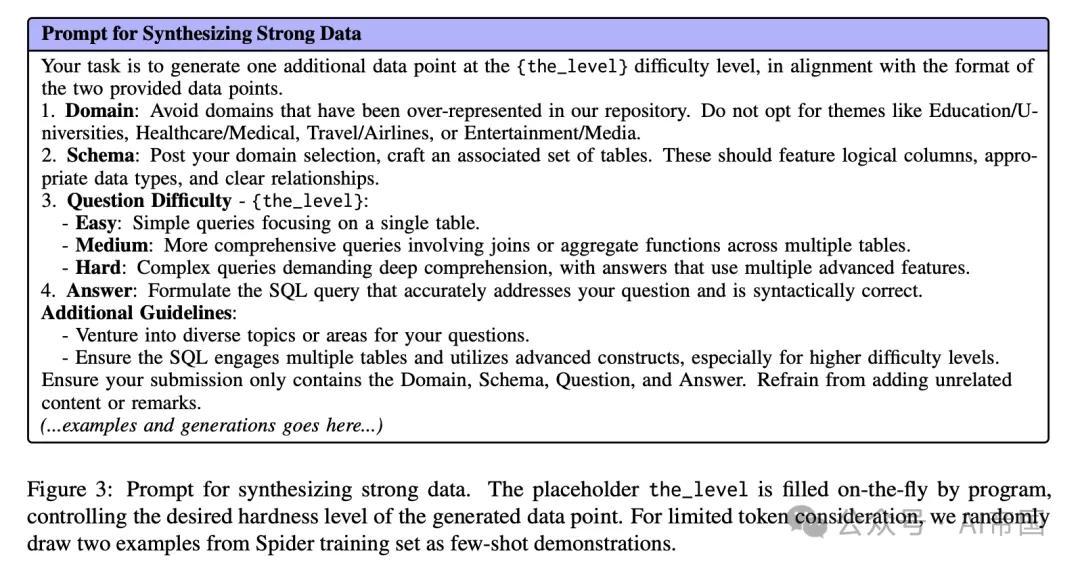

監督微調(SFT)將顯著提升模型生成恰當響應的能力,包括文本到SQL的轉換。當前流行的跨領域數據集,主要是Spider和BIRD,由于需要人類專家進行標注,導致成本高昂。為了緩解這一問題并進一步擴大規模,論文轉向強大的語言模型GPT-4尋求幫助,利用提示來合成目標數據。鑒于跨領域泛化是文本到SQL的核心挑戰,論文設計了提示,鼓勵GPT-4生成足夠多樣化的數據集,如圖3所示。如表1所示,論文合成數據集中每個領域的樣本比例明顯低于Spider和Bird中的比例,這表明更高的領域多樣性。此外,合成數據中的SQL查詢平均包含更多的JOIN操作,表明構建的SQL具有更高的復雜性和深度。這些包括控制問題難度的機制、促進領域多樣性以及明確排除過度代表的領域,從而引導GPT-4生成不僅多樣而且適應不同復雜級別的數據點。

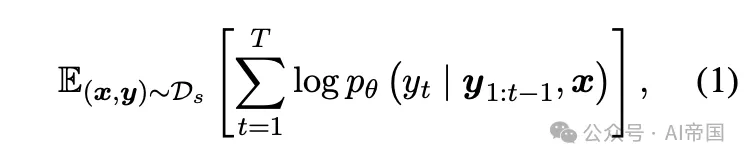

給定一個由輸入提示x和目標響應y生成的強數據集D_s,監督微調可以表述為對數似然損失:

圖3:合成強數據的提示。占位符the-level由程序動態填充,控制生成數據點的期望難度級別。為了考慮有限的令牌,論文隨機從Spider訓練集中抽取兩個示例作為少量示例演示。

2.2 弱數據:偏好學習

第二階段涉及更細致的方法處理弱數據。這里,論文引導模型識別由較弱LLMs故意生成的錯誤SQL查詢。通過偏好學習,模型被鼓勵辨別正確與錯誤的SQL,有效地從錯誤中學習。這一過程不僅精煉了模型對SQL語法的理解,還增強了其對現實場景中可能出現的常見錯誤的抵抗力。

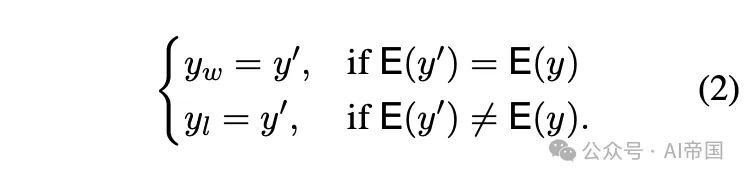

給定一個自然語言描述x,論文使用較弱的模型(規模較小且對齊程度較低)生成輸出y^{\prime。然后使用 SQL 執行器E 執行y‘,如果執行結果與真實值y 匹配,論文將其視為正樣本y_w。相反,如果結果不一致,論文將其標記為負樣本y_l。

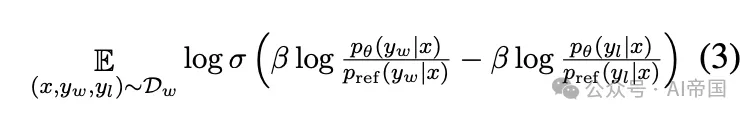

論文構建了一個包含正負樣本的數據集D_w,并使用最近流行的偏好學習方法——直接偏好優化(DPO)來優化模型。DPO 直接基于偏好數據微調模型,繞過獎勵建模階段,旨在最大化以下目標函數:

利用上述方法,論文使用 CodeLLaMA-7B 和 CodeLLaMA-13B 進行了兩階段的訓練,成功生成了最終模型 SENSE-7B 和 SENSE-13B。

3、實驗

3.1 評估基準

論文使用五個數據集上的流行文本到 SQL 基準測試來評估 SENSE 的有效性。

通用基準 Spider包含7,000個文本-SQL對在其訓練集中,以及1,034個對在其開發集中,跨越200個不同的數據庫和138個領域。

挑戰基準 BIRD是一個新的包含大規模真實世界數據庫的基準,包含95個大型數據庫,高質量的文本-SQL對,總計33.4GB的數據跨越37個領域。與Spider不同,BIRD專注于大規模和真實的數據庫內容,自然語言問題與數據庫內容之間的外部知識推理。

魯棒基準 SYN取代了簡單的字符串匹配問題標簽或模式,使用同義詞替換表名。DK要求文本到SQL解析器具備領域知識推理能力。REALISTIC 替換問題中提到的模式項,使其更接近真實世界場景。

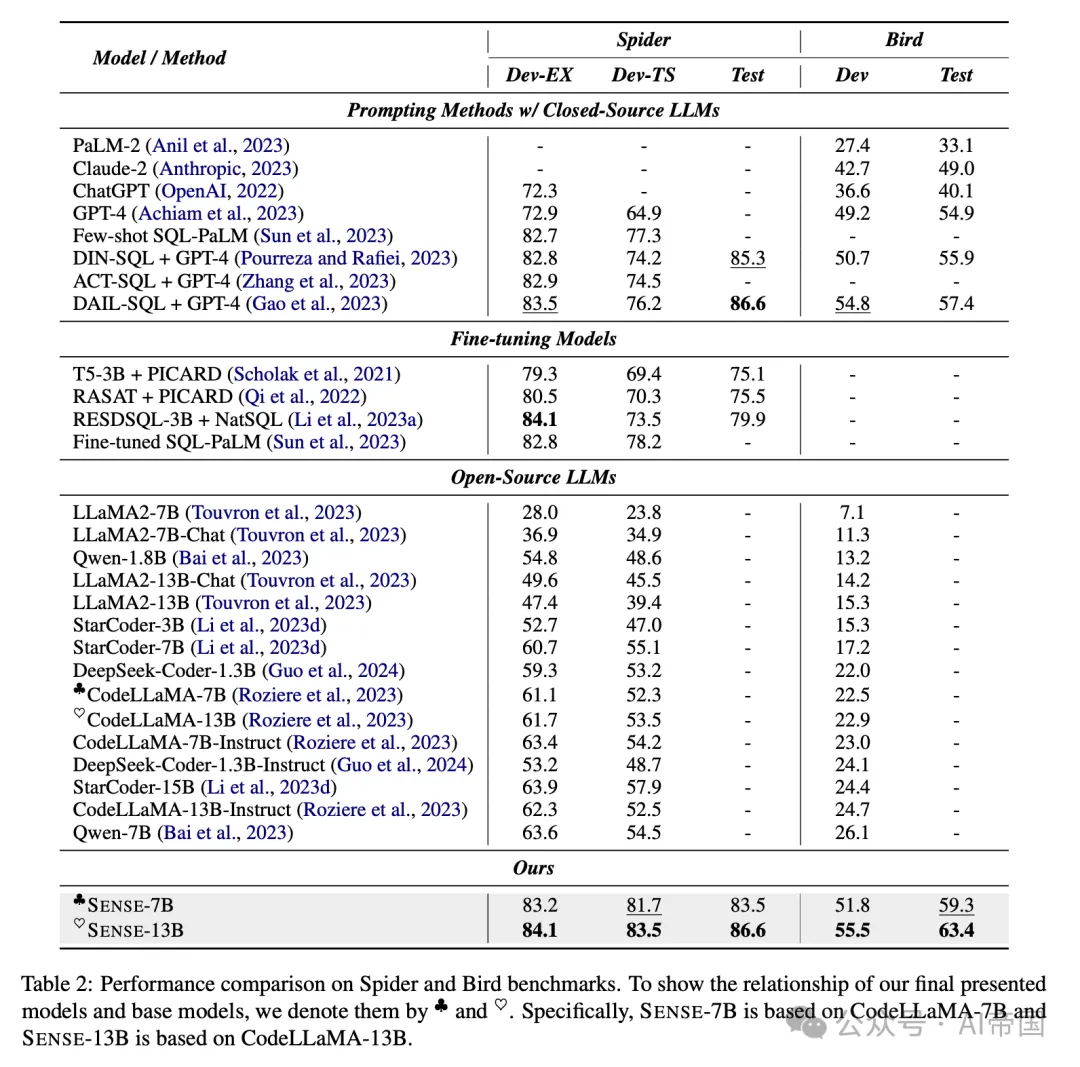

表2:在Spider和Bird基準測試上的性能比較

3.2 評估指標

對于Spider及其魯棒性基準測試,論文遵循Spider的官方評估協議,使用EX和 TS指標。EX衡量SQL輸出是否與提供的黃金SQL的執行結果完全匹配。TS是一個更可靠的指標,確認Spider的SQL查詢是否通過數據庫增強創建的各種測試上的所有EX檢查。對于BIRD,論文采用其官方評估腳本,重點關注EX準確性評估。

3.3 對比方法

論文比較了多種基線方法,這些方法可以分為三類。

提示方法 ACT-SQL引入了一種自動生成思維鏈 (CoT) (Wei et al., 2022) 示例的方法。DIN-SQL (Pourreza and Rafiei, 2023) 使用提示將復雜的文本到SQL任務分解為較小的子任務以提高性能。DAIL-SQL (Gao et al., 2023) 改進了問題表示、示例選擇和樣本序列組織。

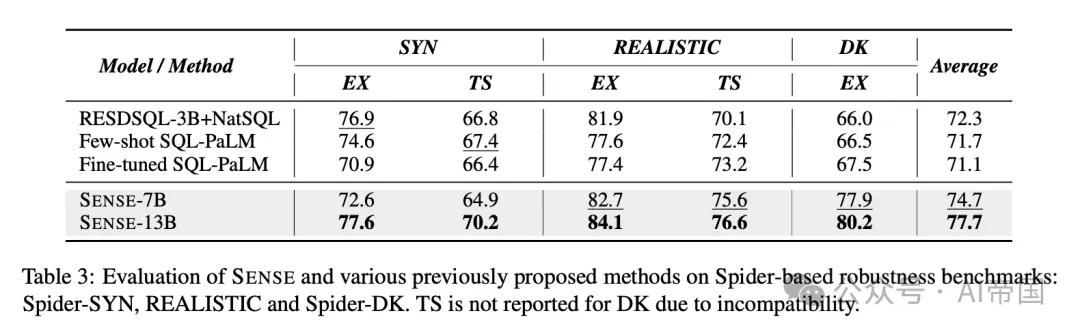

表3 : SENSE和先前提出的各種方法在基于Spider的魯棒性基準測試上的評估:Spider-SYN、REALISTIC和Spider-DK。

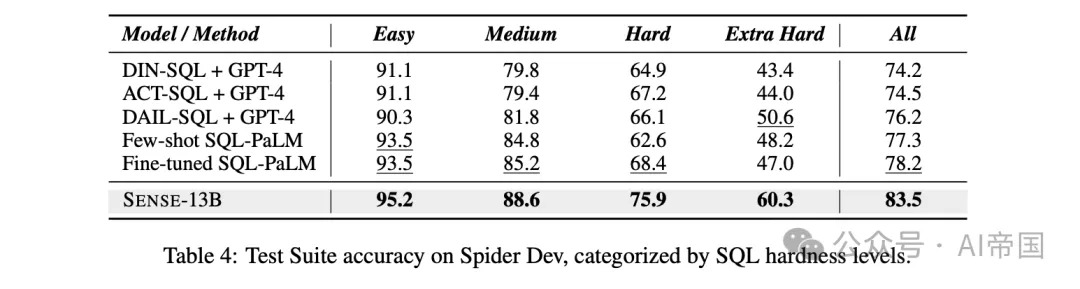

表4:Spider Dev測試集在不同SQL難度級別下的準確率。

微調模型 PICARD 是一種在T5-3B上微調的約束解碼方法。RASAT (Qi et al., 2022) 和 Graphix (Li et al., 2023b) 專注于如何將結構信息融入T5模型(Raffel et al., 2020)的微調過程中,而 RESDSQL-3B (Li et al., 2023a) 則解耦了模式鏈接和骨架解析。

開源LLMs 近期開源LLMs數量激增。論文選取了一些最新流行的LLMs,包括多種規模和版本的DeepSeek-Coder、Qwen、StarCoder、LLaMA2和CodeLLaMA。論文采用了如圖2所示的統一提示,以確保與SENSE進行公平比較。

3.4 實施細節

論文選擇CodeLLaMA-7B和CodeLLaMA-13B作為主要模型,DeepSeek-Coder-1.3B作為弱模型生成偏好數據。論文的實驗在8塊XA100 GPU上進行,結合Spider和Bird數據集與GPT-4生成的數據,使用AdamW優化器以2e-5的學習率和三周期余弦預熱調度器進行監督微調。偏好學習階段始于通過微調的弱模型和SQL評估器生成弱數據。評估器將每個生成的SQL識別為正或負,從而進一步使論文能夠構建偏好數據集。該數據集成為直接偏好優化(DPO,)訓練的基礎。

3.5總體性能

通用設置下的結果 表2顯示,在文本到SQL任務中,提示方法由于閉源LLMs和定制化提示而超越了微調方法。開源LLMs在泛化能力上稍顯不足。模型規模越大,性能通常越好,并且指令調優能提升性能,展示了合成數據調優的有效性。值得注意的是,SENSE在Spider數據集上達到了最先進(SOTA)水平,超過了基于GPT-4的DAlL-SQL。具體而言,SENSE-13B在開發集上比CodeLLaMA-13B-Instruct提升了21.8%,并略微超越了DAIL-SQL,表明SENSE在縮小開源與閉源模型在文本到SQL挑戰中的性能差距方面具有潛力。

挑戰設置下的結果 在BIRD上的實驗揭示了其復雜性,所有開源LLMs在該任務上表現不佳,但SENSE-13B樹立了新標桿,如表2所示,它在測試集上超越了DAIL-SQL 5.98%。這

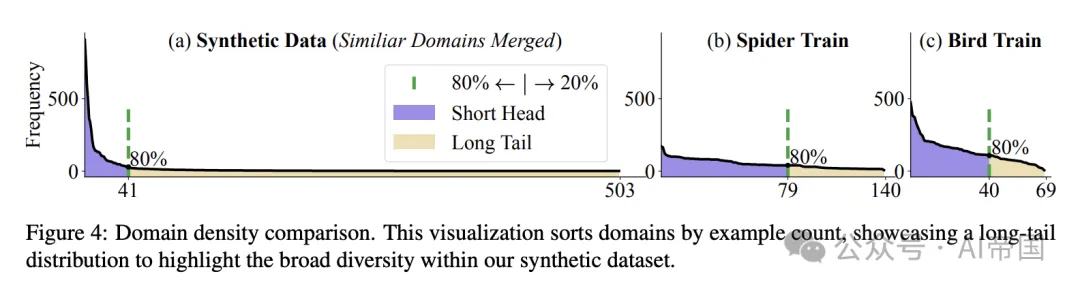

圖4:領域密度比較。該可視化圖按示例數量對領域進行排序,展示了一個長尾分布,以突出論文合成數據集內的廣泛多樣性。

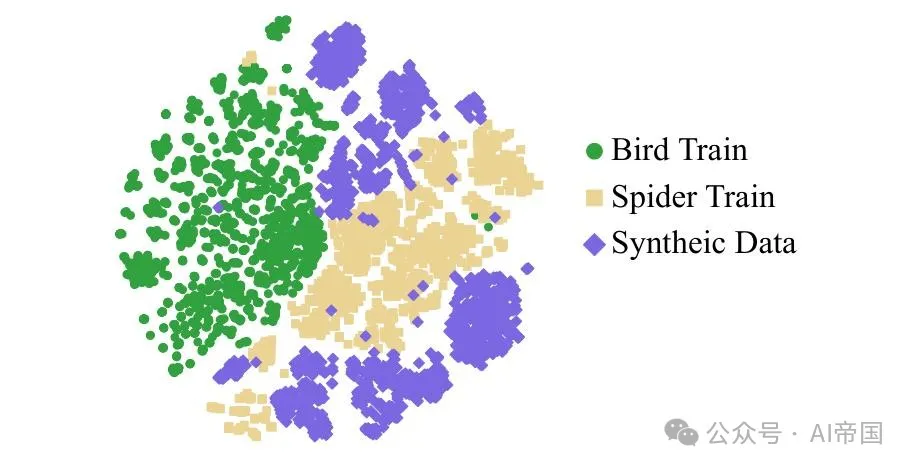

圖5:2-D t-SNE 可視化比較原始數據與合成數據在最后標記上進行監督微調后的最后一層隱藏表示。

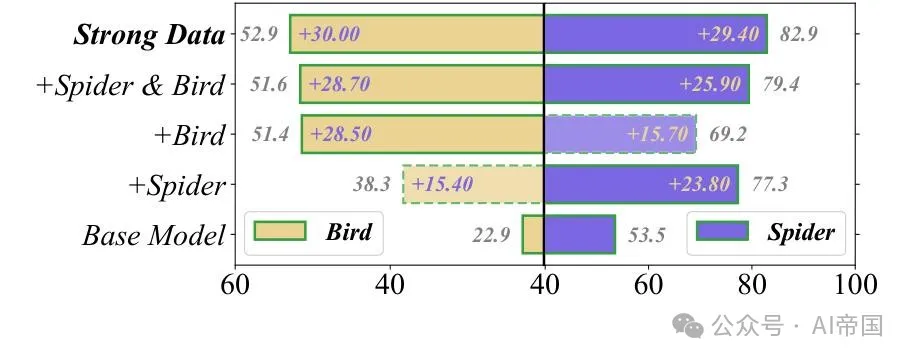

圖6:在CodeLLaMA-13B上使用不同監督微調數據得到的Bird dev和Spider dev分數。論文分別報告Bird和Spider的E X和TS

魯棒性設置結果 表3顯示,即使沒有額外訓練,SENSE在魯棒性(SYN、DK、REALISTIC)方面表現卓越。SENSE-7B和SENSE-13B領先,平均超過RESDSQL-3B 1.4%和5.4%。值得注意的是,SENSE在DK方面的強大能力表明合成數據有效利用了基礎模型的領域知識。

3.6 難度細粒度分析

Spider的難度標簽顯示SENSE-13B在所有級別上的優勢,如表4所示。相對于最佳替代方案的性能提升顯著:簡單(1.6%)、中等(3.4%)、困難(7.5%)和極難(9.7%)。這表明它在處理困難樣本方面具有優勢,得益于合成數據提示中的難度控制。

3.7 消融研究

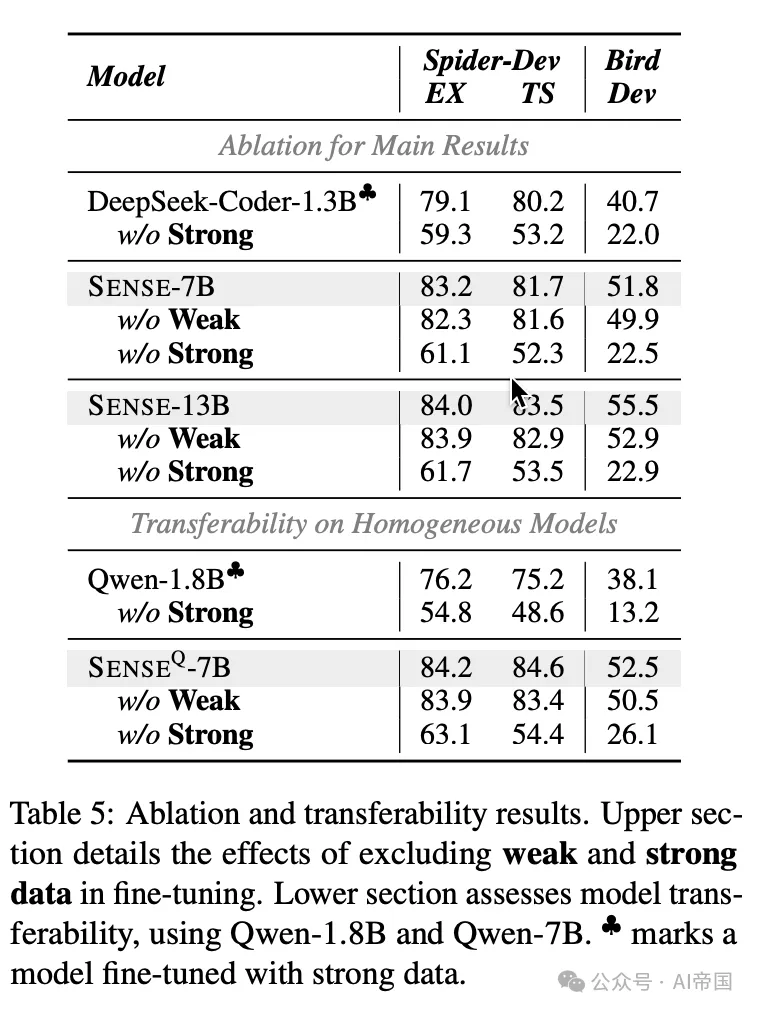

表5展示了針對SENSE的消融研究,剖析其組件以評估各自的影響。研究聚焦于三個關鍵主題。

表5:消融和可遷移性結果。上部詳細說明了排除弱數據和強數據在微調中的影響。下部評估了模型可遷移性,使用Qwen-1.8B和Qwen-7B。

為何強數據大有裨益?從圖6與表5的分析可見,強數據因其更為簡潔的SQL查詢語句及對領域泛化能力的重視,顯著提升了Spider的準確性。同時,當特定領域數據缺失時,鳥類與蜘蛛數據能夠相互補益,這一現象清晰可見。圖4展示了強數據得益于大語言模型所存儲的廣泛知識,呈現出更寬廣的長尾分布,從而增強了SENSE適應新領域的能力。此外,圖5中的t-SNE可視化進一步凸顯了合成樣本在填補人工標注數據空白方面的作用,從而再次驗證了合成數據的價值。

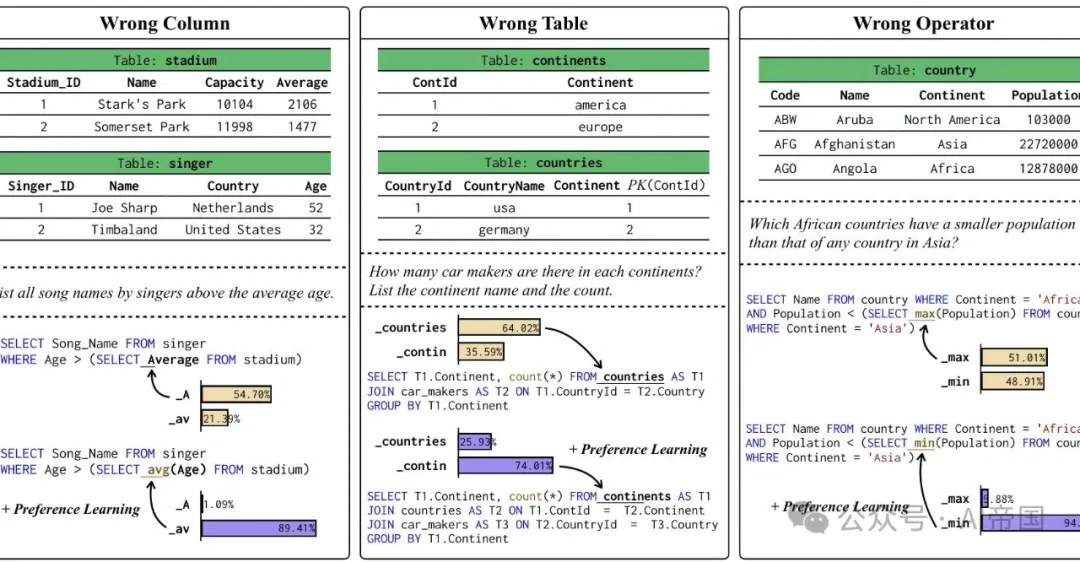

圖7:偏好學習在關鍵標記上提升文本到SQL的性能。

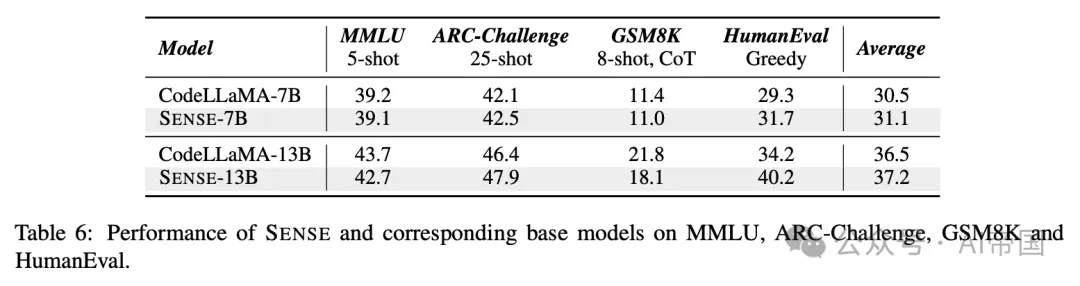

表6:SENSE及其對應基礎模型在MMLU、ARC-Challenge、GSM8K和HumanEval上的性能表現。

為什么弱數據是有幫助的?弱數據,在與偏好學習結合使用時,幫助SENSE通過從錯誤中學習來重新調整其輸出,確保與SQL執行器更緊密的匹配。如表5所示,弱數據顯著提升了整體性能,特別是在提高生成的SQL查詢復雜度方面,與強數據訓練的模型相比,在BIRD上提升了4.9%。此外,圖7和案例研究表明,弱數據在減少SQL生成中的幻覺方面發揮作用,最小化在選擇列、表和操作符時的錯誤,這對于構建復雜的SQL命令至關重要。

跨不同LLM的可遷移性 在表2 中,SENSE 以 CodeLLaMA 初始化,并利用較小的 DeepSeek-Coder 作為弱數據生成器。從模型差異的角度來看,CodeLLaMA 和 DeepSeek-Coder 由于其結構細節和預訓練數據的差異,可以被視為異構模型。這引發了論文對于 SENSE 是否能有效遷移到具有相同預訓練數據的同構模型的疑問。論文選擇了 Qwen 系列,這是一組具有豐富尺寸多樣性的開源模型。論文使用 Qwen-7B 作為基礎模型,Qwen-1.8B 作為弱模型進行合成,創造了一個新的變體,SENSE。如表5 所示,論文發現使用合成數據的方法在同構模型下同樣有效,展示了與 SENSE 相同的改進水平。這證實了所提出方法的可遷移性。

在一般和罕見任務上的表現 除了評估 SENSE 在多個文本到SQL任務上的性能外,論文還通過在幾個基準測試上進行實驗來評估其泛化能力:用于語言理解的 MMLU,用于常識推理的 ARC-Challenge,用于數學推理的 GSM8K,以及用于代碼生成的 HumanEval。表6 中的結果突顯了 SENSE 在這些多樣任務中的競爭性能,展示了其在 SQL 領域之外的廣泛適用性。

值得注意的是,盡管 SENSE 在數學推理上保持了競爭性能,但 SENSE-13B 在代碼生成性能上相較于其基礎模型有顯著提升。這些發現強調了 SENSE 在各種任務中的強大多功能性和泛化能力。此外,論文的實驗顯示,即使專門針對文本到SQL任務進行微調,SENSE 模型在 MMLU 任務上仍能保持性能,證實了論文提出的方法不會影響 LLM 中存儲的知識。此外,如果需要提升 NLP 任務性能,可以通過指令微調加入額外的通用數據,盡管這超出了本文的范圍。

?

本文轉載自 ??AI帝國???,作者: 無影寺