從噪聲中提取情感:中山大學與騰訊AI實驗室基于元學習的多模態情感分析新方法

隨著科技的迅猛發展和社交媒體平臺的普及,多模態數據在各種下游應用中變得越來越普遍。多模態情感分析(Multimodal Sentiment Analysis, MSA)作為一種能夠從語言、聲學和視覺數據流中提取人類情感和觀點的技術,近年來受到了廣泛關注。MSA在多個領域具有重要應用,包括通過分析用戶在社交媒體上的文本、語音和視頻內容,了解用戶的情感傾向和觀點,有助于品牌管理和市場營銷。在智能助手和聊天機器人中,MSA可以幫助系統更好地理解用戶的情感狀態,從而提供更自然和人性化的交互體驗。通過分析患者的多模態數據,MSA可以輔助心理健康專業人士評估患者的情感狀態和心理健康狀況。在電影、電視和游戲中,MSA可以用于分析觀眾的情感反應,優化內容創作和推薦系統。

盡管MSA在多個領域展現了巨大的潛力,但其發展仍面臨諸多挑戰。其中一個主要問題是單模態標簽的缺失。在多模態情感分析任務中,通常只有多模態標簽的注釋,而缺乏單模態標簽。這導致了多模態標簽并不總是單模態標簽的理想替代品,使用多模態標簽來訓練單模態信號可能會引入噪聲,影響模型的性能。不同模態可能傳達不同的情感方面,導致多模態樣本中各模態之間的標簽不一致,進一步加劇了噪聲標簽問題。

針對上述問題,8 月 30 日騰訊 AI 實驗室和中山大學聯合團隊團隊提出了一種新的元學習框架,名為元單標簽生成(Meta Uni-label Generation, MUG),旨在通過弱監督學習單模態標簽來改進多模態情感分析。具體目標包括:

- 單模態標簽學習:利用多模態標簽的弱監督信息,生成準確的單模態標簽。

- 多任務訓練:聯合訓練單模態和多模態學習任務,提取更具辨別力和表達力的單模態特征。

- 噪聲標簽校正:通過設計單模態和多模態去噪任務,顯式監督訓練元單標簽校正網絡(Meta Uni-label Correction Network, MUCN),提高單模態標簽的質量。

這項技術由中山大學電子與信息技術學院和騰訊AI實驗室的研究人員共同完成,具體成員包括來自中山大學電子與信息技術學院的成員Sijie Mai, Ying Zeng, Haifeng Hu。中山大學電子與信息技術學院致力于電子信息技術領域的研究和教育,涵蓋人工智能、通信技術、電子工程等多個方向。團隊成員在多模態情感分析、弱監督學習和元學習等領域具有豐富的研究經驗。來自騰訊AI實驗室的成員:Yu Zhao, Jianhua Yao。騰訊AI實驗室專注于人工智能技術的研究和應用,涵蓋計算機視覺、自然語言處理、語音識別等多個領域。實驗室致力于推動AI技術的發展,并將其應用于實際產品和服務中。團隊成員在多模態學習、情感分析和深度學習等領域具有深厚的專業知識和研究成果。這個研究團隊結合了學術界和工業界的優勢,致力于在多模態情感分析領域取得突破性進展。

方法

研究團隊提出的元單標簽生成(Meta Uni-label Generation, MUG)框架旨在通過弱監督學習單模態標簽,以改進多模態情感分析。MUG框架包括三個主要階段:單模態網絡的構建、多模態框架的預訓練和元學習策略的應用。通過這些階段,MUG能夠生成準確的單模態標簽,并聯合訓練單模態和多模態任務,提取更具辨別力的單模態特征。

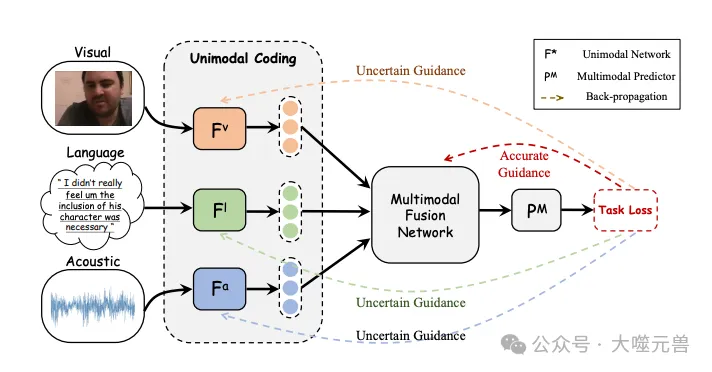

圖1:單峰學習的噪聲標簽問題。多模態標簽可以被視為每個單峰網絡的不確定指導。

單模態網絡的結構和表示生成過程如下:

語言模態

使用BERT(Bidirectional Encoder Representations from Transformers)提取高層次語言表示。具體過程如下:

輸入序列Ul經過BERT網絡,生成表示x?l。

通過全連接層將x?l投影到低維特征空間,得到最終的語言表示xl。

聲音和視覺模態

使用LSTM(Long Short-Term Memory)網絡生成單模態表示。具體過程如下:

輸入特征序列Um經過LSTM網絡,生成表示xm。

其中,Um表示輸入特征序列,xm表示生成的單模態表示。

在多模態框架的預訓練階段,設計了基于對比的投影模塊(Contrastive-based Projection Module, CPM),以縮小單模態和多模態表示之間的差距。具體過程如下:

多模態表示生成

給定三個單模態序列(語言、聲音和視覺),通過單模態網絡生成單模態表示。將單模態表示輸入多模態融合網絡,生成多模態表示x。

對比學習

設計CPM,將多模態表示投影到單模態嵌入空間,并使用投影的多模態嵌入訓練單模態預測器。通過對比學習提高單模態和多模態表示之間的互信息,減少它們之間的分布差距。

元單標簽校正網絡(Meta Uni-label Correction Network, MUCN)的元學習過程包括單模態去噪任務和多模態去噪任務。

在元訓練階段,訓練MUCN以去噪手動損壞的多模態標簽,并恢復原始多模態標簽。通過高斯噪聲防止MUCN學習身份映射,并提供模型學習子最優單模態標簽的能力。

在元測試階段,設計多模態去噪任務,利用干凈的多模態標簽和表示指導MUCN的學習。通過估計MUCN是否能恢復干凈的多模態標簽來評估其有效性。

在元學習過程中,采用雙層優化策略以提高MUCN的訓練效果。具體過程如下:

在單模態去噪任務訓練,通過梯度下降更新MUCN的參數,訓練MUCN以去噪手動損壞的多模態標簽。

多模態去噪任務評估,通過多模態輸入生成后校正損失,評估MUCN的有效性。如果MUCN在元訓練后變得更具辨別性,則跳過元測試階段并更新MUCN參數。如果MUCN在元訓練后變得不夠辨別性,則使用雙層優化策略進行元更新。

在多任務訓練階段,聯合訓練單模態和多模態學習任務,以提取更具辨別力的單模態特征。具體是單模態任務訓練使用元學習階段生成的校正單模態標簽進行單模態任務訓練;多模態任務訓練使用多模態標簽指導多模態任務學習。

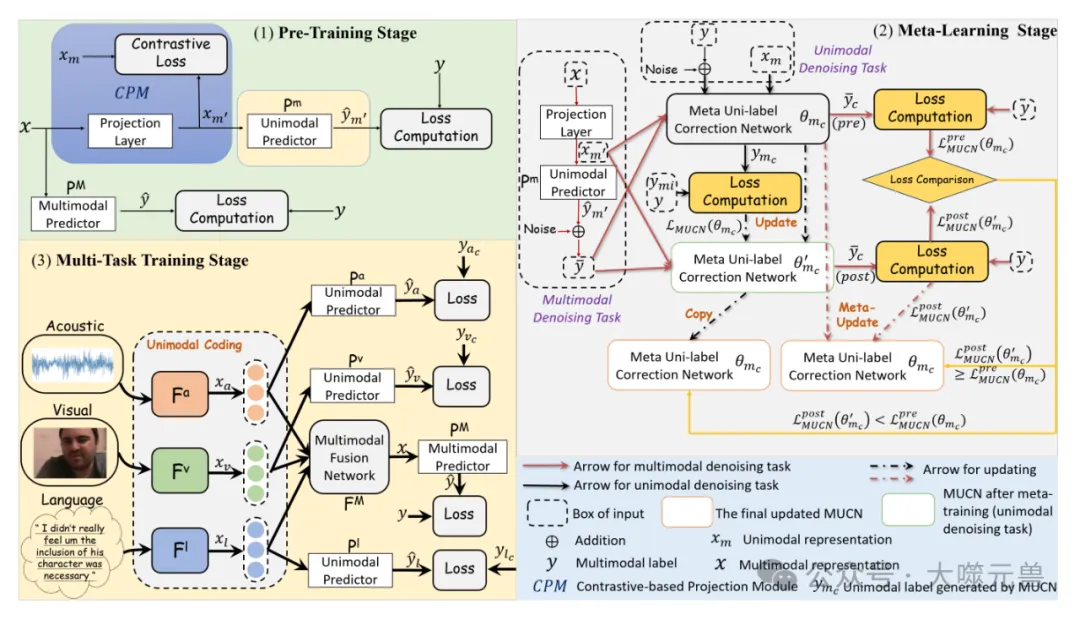

圖2:擬議MUG的示意圖

通過這種方式,MUG能夠最大限度地利用現有的多模態信息,提取更具辨別力和表達力的單模態特征,從而提高多模態情感分析的性能。

實驗

數據集

研究團隊使用了三個主要的數據集來評估MUG框架的性能。

CMU-MOSI是多模態情感分析領域的重要資源,包含超過2000個視頻片段,每個片段的情感強度在-3到+3的Likert量表上進行標注。

數據劃分:1284個片段用于訓練,229個片段用于驗證,686個片段用于測試。

CMU-MOSEI是一個大規模的多模態情感分析數據集,包含超過22000個片段,來自1000多名YouTube演講者,涵蓋250個獨特的話題。每個片段都標注了六種情感狀態和情感得分(-3到+3)。

數據劃分:16326個片段用于訓練,1871個片段用于驗證,4659個片段用于測試。

SIMS是一個獨特的中文多模態情感分析數據集,包含2281個片段,來自電影、電視劇和綜藝節目。每個片段的情感得分在-1到1之間。

數據劃分:1368個片段用于訓練,456個片段用于驗證,457個片段用于測試。

為了評估MUG框架的性能,研究團隊使用了以下評估指標:

- Acc7:7分類準確率,用于細粒度情感得分分類。

- Acc2:二分類準確率,用于區分正面和負面情感。

- F1分數:二分類情感分類的精確率和召回率的調和平均數。

- MAE:平均絕對誤差,量化情感預測與標注標簽之間的平均誤差。

- Corr:相關系數,表示模型預測與情感標簽之間線性關系的強度和方向。

實驗結果

在各數據集上的實驗結果表明,MUG框架在大多數評估指標上優于競爭基線模型。具體結果如下。

CMU-MOSI數據集

MUG (BERT)在Acc7、Acc2和F1分數上分別比HyCon高0.9%、0.6%和0.5%,比AOBERT高7%以上。

MUG (BERT)在Acc2和F1分數上分別比CubeMLP高0.5%和1.1%,在Acc7、F1分數和Corr上優于AOBERT。

CMU-MOSEI數據集

MUG (BERT)在Acc2和F1分數上分別比CubeMLP高0.5%和1.1%,在Acc7、F1分數和Corr上優于AOBERT。

SIMS數據集

MUG在MAE、Corr和Acc2上優于Self-MM和SUGRM,表明MUG的單模態標簽學習策略更具優勢。

消融實驗

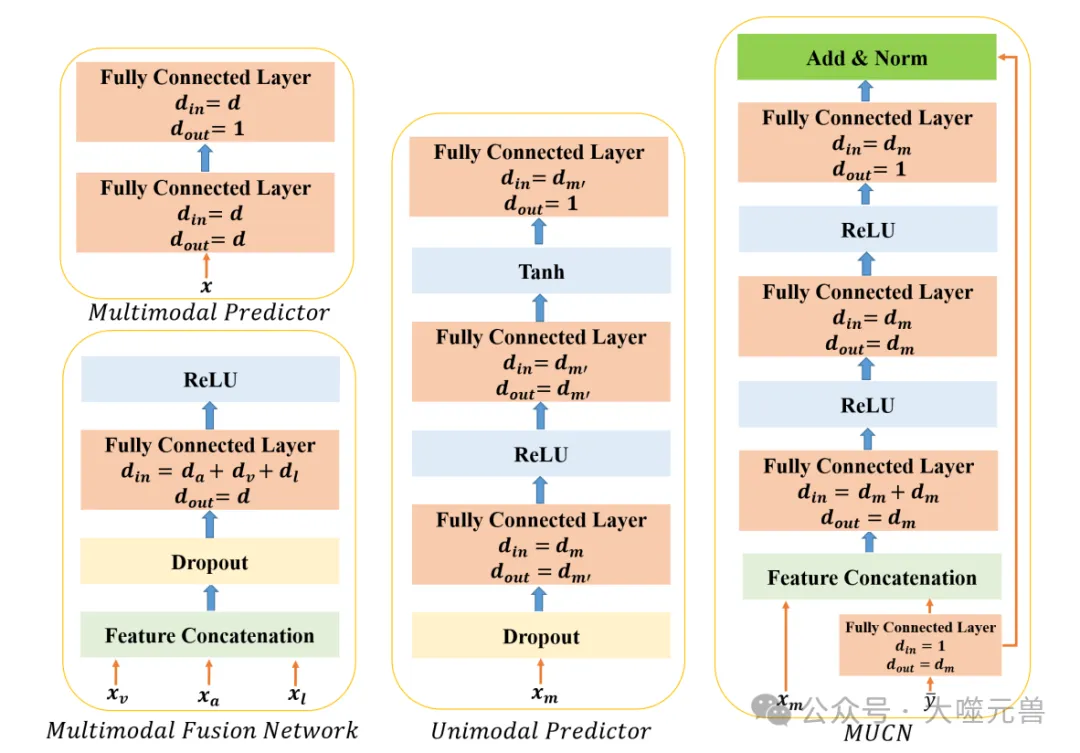

圖3:單峰預測器、多峰預測器、多模態融合網絡和MUCN的結構。我們應用一個簡單的融合網絡來實現有競爭力的性能。

為了分析各組件對模型性能的影響,研究團隊進行了消融實驗。

單模態學習任務:移除單模態學習任務后,性能顯著下降,表明多任務訓練對于提取更具辨別力的單模態特征和提高多模態系統性能的重要性。

多模態去噪任務:移除多模態去噪任務后,性能下降約1%,表明多模態去噪任務對于單模態標簽學習的重要性。

對比學習:移除對比學習后,大多數評估指標的結果顯著下降,表明對比學習在減少單模態和多模態表示之間的分布差距方面的重要性。

直接使用多模態標簽作為單模態標簽:直接使用多模態標簽作為單模態標簽的性能下降,表明元學習的單模態標簽優于直接使用多模態標簽。

元學習策略:使用MLC策略替代提出的元學習策略后,所有評估指標的性能下降,表明提出的元學習策略在學習準確的單模態標簽方面更優。

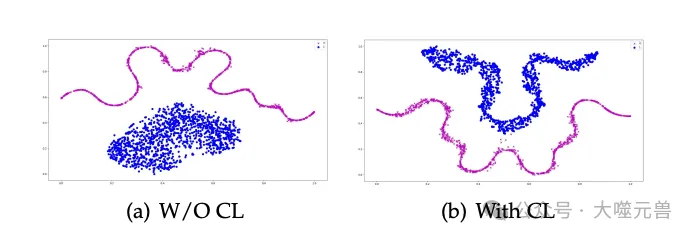

圖4:單峰表示和投影多峰表示的T-SNE可視化CL代表對比學習。我們使用語言模態來說明CL的效果,在其他模態中也觀察到了類似的結果。

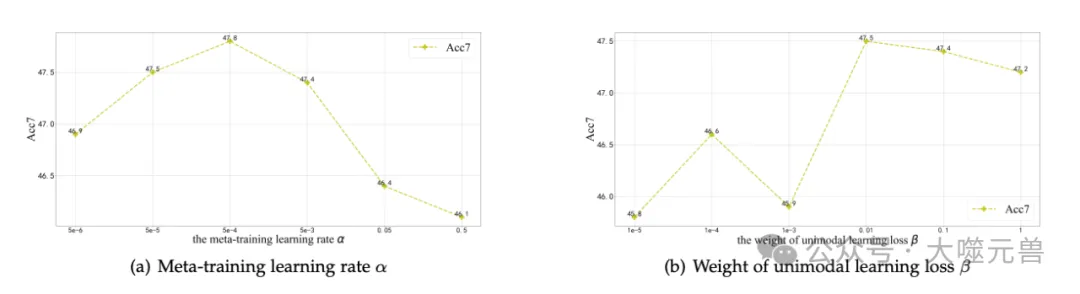

超參數魯棒性分析

研究團隊評估了超參數β(第三階段單模態學習損失的權重)和α(元訓練學習率)對模型性能的影響。結果表明:

- β的影響:當β在0.01-1范圍內時,模型性能較好;當β值較小時,模型性能顯著下降。

- α的影響:當α值適中時,模型性能較好;當α值過大時,模型性能顯著下降。

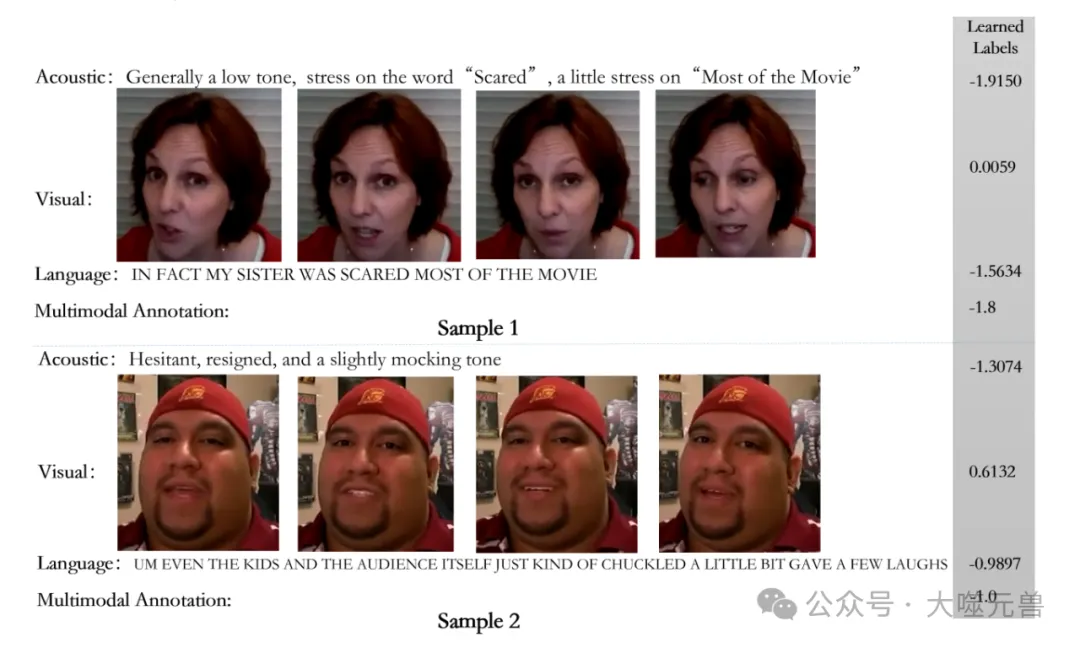

案例分析

圖5:關于超參數α和β變化的模型性能。

圖6:學習單峰標簽的案例分析。

研究團隊提供了兩個來自CMU-MOSI數據集的定性樣本,展示了多模態輸入、學習到的單模態標簽和多模態標簽。結果表明:

樣本1:說話者沒有明顯的面部表情,視覺標簽接近中性;語言標簽為負面,聲學標簽為強負面。MUG能夠準確識別各模態的辨別水平,并為其分配適當的標簽。

樣本2:存在矛盾模態,視覺標簽為弱正面,語言標簽為弱負面,聲學標簽為強負面。MUG能夠處理矛盾模態的情況,通過準確學習單模態標簽,提取更具辨別力的特征以進行準確的多模態推理。

通過這些實驗結果和分析,研究團隊驗證了MUG框架在多模態情感分析中的有效性和優勢。

討論

為了分析對比學習模塊的有效性,研究團隊使用t-SNE對投影的多模態表示和相應的單模態表示在嵌入空間中的分布進行了可視化。t-SNE是一種能夠捕捉高維特征局部結構的降維技術。實驗結果顯示,當移除對比學習時,投影的多模態表示(藍色點)在嵌入空間中呈現橢圓形分布,而單模態表示則呈現條紋狀分布。相反,當應用對比學習時,來自兩種不同來源的數據點均呈現條紋狀分布,且它們之間的差距顯著減小。盡管由于多模態和單模態表示的異質性,分布差距不可避免,但MUG能夠有效減少這種差距,使得它們在嵌入空間中的分布形狀高度相似,從而使單模態模塊能夠處理投影的多模態表示,以指導單模態標簽的學習。

值得注意的是,在單模態-多模態對比學習中,我們停止了單模態表示的梯度,僅改變投影的多模態表示的分布,以迫使投影的多模態表示具有與單模態表示相同的分布。因此,無論是否應用對比學習,單模態表示的分布幾乎相同,而投影的多模態表示在應用對比學習后,其分布變得與單模態表示的分布更加相似。

為了驗證使用真實單模態標簽對模型性能的影響,研究團隊進行了一個實驗,使用標注的單模態標簽訓練SIMS數據集的單模態網絡。結果表明,使用標注的單模態標簽學習單模態表示可以顯著提高多模態系統的整體性能,尤其是與不包含單模態學習任務的MUG版本相比。此外,使用學習到的單模態標簽進行單模態學習任務的MUG版本優于不包含單模態學習任務的版本,但略遜于使用真實標簽的版本。這些結果表明,學習到的單模態標簽是有效的,但仍然包含一定的噪聲。

研究團隊還對模型的空間和時間復雜性進行了分析。

空間復雜性

使用可訓練參數的數量作為空間復雜性的代理。MUG框架的總參數數量為110,089,956個。相比之下,MISA和MAG-BERT的參數數量為110,917,345個,而Self-MM和MMIM的參數數量分別為109,647,908和109,821,129個。因此,MUG的參數數量適中。這是合理的,因為我們為每個模態設計了額外的元單標簽校正網絡和基于對比的投影模塊,而Self-MM沒有設計額外的可學習模塊來學習單模態標簽。

時間復雜性

在訓練時間方面,前兩個階段只運行一次以生成聯合訓練階段(第三階段)所需的單模態標簽。聯合訓練階段和前兩個階段可以解耦,從而大大減少訓練時間。因此,MUG的唯一額外時間成本是前兩個階段的訓練,這只需運行一次且不需要調優,是可以接受的。在第三階段,由于我們沒有設計復雜的融合機制,也不需要在第三階段學習單模態標簽,訓練時間比需要在多任務訓練期間計算單模態標簽的Self-MM更快。具體來說,在相同環境和相同批量大小下,Self-MM每次迭代約需1.16秒,而MUG每次迭代約需0.86秒。

通過這些分析,研究團隊驗證了MUG框架在多模態情感分析中的有效性和優勢,并展示了其在空間和時間復雜性方面的合理性。

結論與未來工作

研究團隊提出了一種新的元學習框架,名為元單標簽生成(Meta Uni-label Generation, MUG),旨在通過弱監督學習單模態標簽來改進多模態情感分析。

提出了MUG框架,通過設計元單標簽校正網絡(MUCN)和基于對比的投影模塊(CPM),MUG能夠生成準確的單模態標簽,并聯合訓練單模態和多模態任務,提取更具辨別力的單模態特征。

單模態去噪任務和多模態去噪任務,通過設計單模態和多模態去噪任務,顯式監督訓練MUCN,提高單模態標簽的質量。

在CMU-MOSI、CMU-MOSEI和SIMS數據集上的實驗結果表明,MUG在大多數評估指標上優于競爭基線模型,驗證了其在多模態情感分析中的有效性和優勢。

通過消融實驗分析了各組件對模型性能的影響,并評估了超參數對模型性能的影響,驗證了MUG框架的穩定性和魯棒性。

提供了定性樣本,展示了學習到的單模態標簽和多模態標簽,進一步驗證了MUG在處理矛盾模態和提取辨別力特征方面的能力。

盡管研究團隊提出的MUG框架在多模態情感分析中取得了顯著的進展,但仍有一些未來的研究方向和應用場景值得探索。

MUG框架可以擴展到其他噪聲標簽學習場景,如圖像分類、語音識別等。未來的研究可以評估MUG在這些任務中的有效性。

將MUG框架應用于實時情感分析系統,如智能助手、聊天機器人等,進一步驗證其在實際應用中的性能和穩定性。

目前的研究主要集中在英文和中文數據集上,未來可以擴展到其他語言的數據集,評估MUG在多語言情感分析中的表現。

盡管MUG在提取辨別力特征方面表現出色,但其內部機制仍然較為復雜。未來的研究可以探索如何增強模型的解釋性,使其更易于理解和調試。

將MUG框架與其他先進的技術結合,如強化學習、自監督學習等,進一步提高模型的性能和適應性。通過這些未來的研究方向和應用場景,MUG框架有望在多模態情感分析及其他相關領域取得更大的突破和應用價值。(END)

參考資料:https://arxiv.org/abs/2408.16029