大模型學習范式之——語境學習(In-context learning) 原創

“ 大模型學習的最終目的,就是提升模型的性能”

在大語言模型技術中,怎么讓大模型擁有更好的表現一直是一個值得思考的問題,研究者用了很多辦法來提高大模型的輸出質量,比如使用大規模高質量參數進行模型預訓練和微調。

后續又增加少樣本和零樣本學習以及提示學習等方法;總之,唯一的目的就是挖掘大模型的潛力,用最小的成本使得大模型性能最大化。

而今天我們討論的就是另一種方式——語境學習(ICL)。

In-context learning

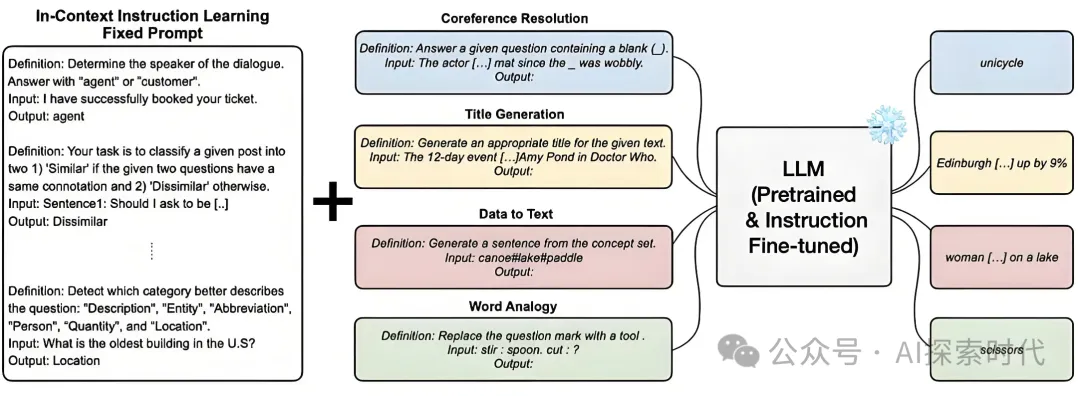

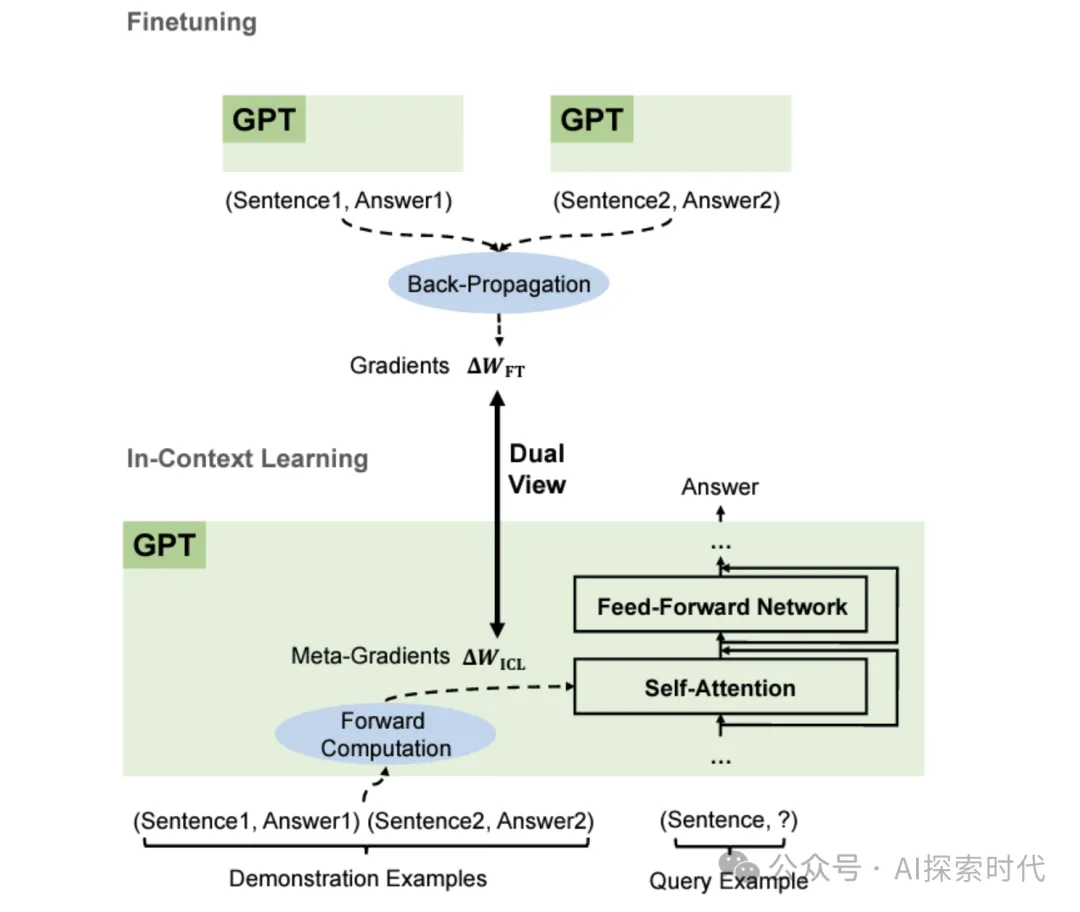

In-context Learning 語境學習是一種學習范式,是現代自然語言處理領域中一種重要的學習方法,尤其在使用大規模,尤其在使用大規模預訓練模型時,它允許模型在給定的上下文中進行學習和推理,而無需真正更新模型參數。

這種方法充分利用了模型的預訓練知識,并通過在推理階段提供相關的上下文信息來生成或調整模型輸出。

In-context Learning 的核心概念

上下文依賴:ICL的核心在于利用模型的上下文理解能力來完成任務,模型根據輸入的上下文信息(包括示例和任務描述)進行推理,而不是依賴于顯示的訓練過程。

無參數更新:ICL不涉及對模型實際參數的修改,模型保持預訓練狀態,只是根據提供的上下文信息調整其生成或分類行為。

動態適應:模型在推理時會動態地適應給定的上下文,通過分析上下文中的示例或指示來生成合適的輸出,這種適應能力來源于模型在預訓練階段學到的通用知識。

In-context Learning的工作原理

提示詞和示例

提示詞:ICL常通過提示詞來引導模型的生成過程,提示詞通常包括任務描述,問題陳述或請求模型執行的操作。

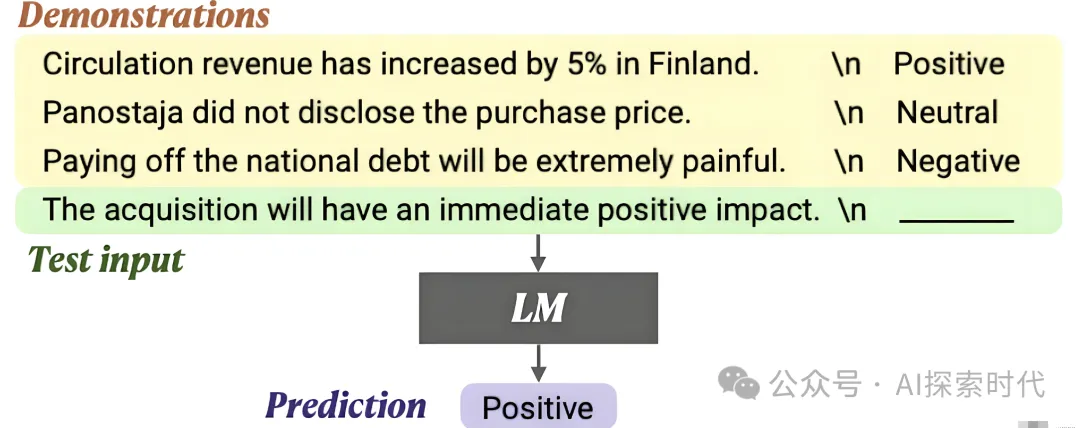

示例:在少樣本學習(Few-Shot Learning)中,提示詞可能包括一些示例輸入和輸出,幫助模型理解如何處理類似的任務。

上下文提供

任務描述:在ICL中,任務描述用于告訴模型要完成的任務,例如:生成一個關于人工智能的總結。

示例輸入輸出:提供幾個示例輸入和輸出對,可以幫助模型理解特定任務的模式或要求,例如:給出一些翻譯示例來幫助模型進行語言翻譯。

推理和生成

推理:模型根據提供的上下文進行推理,生成與上下文相關的響應或輸出。

生成:在ICL中,生成的文本基于模型對上下文的理解,以及預訓練中學到的知識

In-context Learning的優勢

靈活性

任務適應:能夠在沒有重新訓練模型的情況下,靈活地適應不同的任務和要求

快速適應:通過提供上下文,模型能夠快速適應新的任務,而無需對模型進行長期的訓練和調整。

無需再訓練

節省資源:ICL不需要對模型進行再訓練或更新,這節省了計算資源和時間

利用預訓練知識

知識復用:利用模型在預訓練階段獲得的通用知識,能夠在多種任務和場景中發揮作用。

In-context Learning 的應用場景

少樣本學習

示例驅動:在少樣本學習中,通過提供少量示例,模型能夠理解任務并生成所需的輸出,如分類,生成等任務。

對話系統

上下文管理:在對話系統中,ICL可以幫助模型根據對話歷史或上下文生成更加自然和相關的響應

自動化內容生成

定制化內容:可以根據給定的上下文(如主題,風格,格式要求)生成特定內容,如文章,報告,故事等

跨領域應用

靈活應用:ICL可以用于多個領域,處理不同類型的任務,如法律文本生成,醫學診斷,翻譯等,只需調整上下文即可。

In-context Learning 的挑戰

上下文長度限制

長上下文問題:大規模模型對上下文長度有一定的限制,處理非常長的上下文可能會受到影響

上下文選擇

選擇適當的上下文:確定哪些信息應該包含在上下文中,以及如何組織這些信息,是ICL的關鍵挑戰之一

一致性和準確性

輸出一致性:在不同上下文中,模型生成的內容可能會有所不同,確保生成結果的一致性和準確性是需要關注的問題

總結

In-Context Learning 是一種高效的技術,通過在模型推理時提供上下文信息,能夠靈活地適應不同的任務和應用場景。它不需要對模型進行實際的參數更新,而是利用模型的預訓練知識和上下文理解能力來生成或調整輸出。這種方法具有很強的靈活性和應用廣泛性,但也面臨著上下文長度限制和輸出一致性等挑戰。

本文轉載自公眾號AI探索時代 作者:DFires

原文鏈接:??https://mp.weixin.qq.com/s/skJvMWWF7SbHRnSPIKZd_Q??