明白了!機器學習四大范式:監督學習、無監督學習、半監督學習和自監督學習

1、監督學習

今天我們來聊聊機器學習中的那些“監督”的事兒。你知道嗎?在機器學習的江湖里,有那么幾種學習方式,它們各自有著不同的門派和絕學。咱們今天就先從“監督學習”開始說起。

1.1 來源與定義

監督學習,這個名字聽起來是不是有點像咱們上學時老師手把手教我們做題的感覺?其實,它的原理還真有點兒類似。在機器學習中,監督學習是一種需要“老師”(也就是我們人類)提供標準答案來訓練模型的方法。這種學習方式最早可以追溯到20世紀50年代,隨著計算機科學的發展,它逐漸成為機器學習的一個重要分支。

簡單來說,監督學習就是通過已知的輸入和輸出數據來訓練模型,讓模型學會如何根據新的輸入數據預測輸出結果。這里的“監督”就是指我們給模型提供的那些帶標簽的訓練數據。

1.2 優勢

那咱們為啥要用監督學習呢?首先,它的優勢在于能夠提供精確的訓練數據,這意味著我們可以得到非常準確的結果。就像老師告訴我們每個數學題的答案一樣,模型也能通過這些“答案”學會如何解決類似問題。

另一個優勢是,監督學習相對其他學習方式,所需要的數據量較小,更加高效。因為模型知道正確的答案,所以它不需要像無監督學習那樣去大海撈針般地找規律。

1.3 劣勢

但是,監督學習也有它的短板。首先,它需要大量的標簽數據,而標注數據通常需要專業人員,耗費時間和人力成本較高。這就好比我們學習時,如果每道題都需要老師給出詳細解答,那老師得多累啊。

其次,監督學習對數據的要求高,錯誤的數據會導致模型學習不準確而獲取錯誤的結果。這就像老師如果教錯了,學生也就跟著學錯了。

1.4 用途

那么,監督學習都能用在哪兒呢?它的應用范圍非常廣泛,可以應用于圖像識別、語音識別、自然語言處理等多個領域。比如,我們用監督學習來訓練一個識別照片中是不是有貓的模型,就需要先給它一大堆標記好的“有貓”和“沒貓”的照片。

1.5 經典算法

- 線性回歸:用于連續數值預測的問題,如房價預測。

- 邏輯回歸:用于二分類問題,如垃圾郵件檢測。

- 決策樹:用于分類和回歸問題,通過學習決策規則進行預測。

- 支持向量機(SVM):適用于高維空間的分類問題,通過尋找最優超平面進行分類。

- 隨機森林:集成多個決策樹,提高模型的穩定性和準確性。

- 神經網絡:通過模擬人腦神經元網絡處理復雜非線性問題。

2、無監督學習

上面我們聊了監督學習,接下來咱們來聊聊無監督學習,這個在機器學習江湖中同樣重要的門派。

2.1 來源與定義

無監督學習,這個名字聽起來是不是有點像自學成才的感覺?其實,它的原理還真有點兒類似。在機器學習中,無監督學習是一種不需要“老師”提供標準答案來訓練模型的方法。這種方法最早可以追溯到20世紀70年代,隨著模式識別和人工智能的發展,它逐漸成為機器學習的一個重要分支。

簡單來說,無監督學習就是通過未標記的數據來訓練模型,讓模型自己發現數據中的模式和結構。這里的“無監督”就是指我們沒有給模型提供任何標簽,全靠它自己去摸索。

2.2 優勢

那咱們為啥要用無監督學習呢?首先,它的優勢在于非常適合大型數據集。無監督學習可以從大量未標記的數據中發現模式、結構和特征,這對于大型數據集非常有用。

另一個優勢是,無監督學習不需要標注數據,因此不會有因為提供錯誤標注數據而出現的問題,就減小了成本。這就好比我們學習時,如果不需要老師,自己也能通過閱讀和實踐來掌握知識,那得多省錢啊。

2.3 劣勢

但是,無監督學習也有它的短板。首先,結果不夠準確。由于數據沒有標注,在預測時可能出現較大誤差和缺陷,從而導致結果不夠準確。這就像我們自學時,如果沒有正確的指導,可能會走很多彎路。

其次,無監督學習對參數設置和算法選擇較為靈敏,需要更多的技巧和經驗,否則可能出現偏差。這就好比我們自學時,如果選錯了學習方法,可能會事倍功半。

2.4 用途

那么,無監督學習都能用在哪兒呢?它的應用范圍也很廣泛,可以應用于聚類分析、異常檢測、降維和數據壓縮等多個領域。比如,我們用無監督學習來分析消費者的購物習慣,就可以將消費者分為不同的群體,從而進行更精準的營銷。

2.5 經典算法

說到無監督學習,就不得不提幾個經典算法了。比如K-means聚類算法,它通過將數據點分為K個簇,使得簇內的數據點盡可能相似,而簇間的數據點盡可能不同。還有主成分分析(PCA),它是一種常用的降維技術,通過提取數據中最重要的特征來減少數據的維度。這些算法都是無監督學習中的佼佼者,各有千秋,適用于不同的場景和問題。

3、半監督學習

下面來聊聊機器學習中的另一種學習方式——半監督學習。這可是個實用主義者,它結合了監督學習和無監督學習的優點,讓我們一起來探個究竟。

3.1 來源與定義

半監督學習,這個名字聽起來是不是有點像我們在學校里既聽老師講課,又自己摸索的感覺?其實,它的原理還真有點兒類似。在機器學習中,半監督學習是一種結合了少量有標簽數據和大量無標簽數據進行訓練的方法。這種方法最早可以追溯到20世紀90年代,隨著數據挖掘技術的發展,它逐漸成為機器學習的一個重要分支。

簡單來說,半監督學習就是通過已知的少量輸入和輸出數據(有標簽數據)以及未知的大量輸入數據(無標簽數據)來訓練模型,讓模型學會如何根據新的輸入數據預測輸出結果。這里的“半監督”就是指我們給模型提供了一部分標簽,另一部分則需要模型自己去摸索。

3.2 優勢

那咱們為啥要用半監督學習呢?首先,它的優勢在于可以在有限的標簽數據下,利用大量的無標簽數據進行學習,從而提高模型的泛化能力。這就像我們在學習時,老師給了我們一些例題,然后我們通過大量的練習題來提高解題能力。

另一個優勢是,在有些領域,收集標簽數據非常困難或者昂貴,如醫學圖像分析、金融風險評估等。半監督學習可以在這些場景下提供有效的解決方案,減少對大量標簽數據的依賴。

3.3 劣勢

但是,半監督學習也有它的短板。首先,它需要大量的無標簽數據,但是收集無標簽數據的成本也很高。這就好比我們學習時,雖然不需要老師提供所有答案,但是自己去找大量的練習題也是需要時間和精力的。

其次,半監督學習的效果受到無標簽數據的質量和數量的影響,如果無標簽數據質量不高或者數量不足,可能會導致模型性能下降。這就像我們自學時,如果練習題的質量不高,可能會影響我們的學習效果。

3.4 用途

那么,半監督學習都能用在哪兒呢?它的應用范圍也很廣泛,可以應用于文本分類、圖像識別、推薦系統等多個領域。比如,我們用半監督學習來提高垃圾郵件過濾的準確性,就可以利用少量的已標記郵件和大量的未標記郵件來訓練模型。

3.5 經典算法

說到半監督學習,就不得不提幾個經典算法了。比如自適應boosting(AdaBoost)算法,它通過結合多個弱分類器來提高分類性能。還有圖半監督學習算法,它通過構建數據點之間的圖結構,利用圖上的連接關系來傳播標簽信息。這些算法都是半監督學習中的佼佼者,各有千秋,適用于不同的場景和問題。

- 自訓練(Self-training):通過使用模型的初始預測結果來標記未標記的數據,自訓練逐步擴展訓練集,使用模型自信的預測結果作為新的訓練數據進行迭代訓練。

- 協同訓練(Co-training):通過在兩個或多個不同特征視圖上訓練獨立的分類器,協同訓練在每一輪中使用一個分類器的高置信度預測結果為另一個分類器提供標記數據,互相提升學習效果。

- 標簽傳播(Label Propagation):通過構建一個圖,節點表示數據點,邊的權重表示相似度,標簽傳播算法逐步在圖中傳播已標記點的標簽信息到未標記點,直到達到收斂。

- 偽標簽(Pseudo-Labeling):首先使用少量標記數據訓練模型,然后用模型為未標記數據生成預測標簽,這些偽標簽隨后被用來進一步訓練模型。

4、自監督學習

最后,來聊聊機器學習中的一個新興門派——自監督學習。這可是個特立獨行的家伙,它不需要外部的標簽,全靠自己給自己出題和打分。讓我們一起來探個究竟。

4.1 來源與定義

自監督學習,這個名字聽起來是不是有點像我們自己給自己布置作業的感覺?其實,它的原理還真有點兒類似。在機器學習中,自監督學習是一種通過設計輔助任務,讓模型從未標記的數據中學習有用特征的方法。這種方法最早可以追溯到21世紀初,隨著深度學習技術的發展,它逐漸成為機器學習的一個重要分支。

簡單來說,自監督學習就是通過模型自己生成的標簽來訓練自己,讓模型學會如何根據輸入數據預測輸出結果。這里的“自監督”就是指我們不給模型提供任何外部標簽,全靠模型自己去創造標簽。

4.2 優勢

那咱們為啥要用自監督學習呢?首先,它的優勢在于能夠利用大量未標記的數據。自監督學習可以從這些數據中提取有用的信息,這對于數據量巨大的場景非常有用。

另一個優勢是,自監督學習減少了對人工標注的依賴,降低了成本。這就好比我們學習時,不需要老師,自己也能通過閱讀和實踐來掌握知識,那得多省錢啊。

4.3 劣勢

但是,自監督學習也有它的短板。首先,它的效果受限于輔助任務的設計。如果輔助任務設計得不好,模型可能學不到有用的特征,導致性能下降。這就像我們自學時,如果選錯了學習方法,可能會事倍功半。

其次,自監督學習的訓練過程可能需要更多的計算資源。因為模型需要在大量的數據上進行訓練,以確保能夠捕捉到數據中的細微差別。

4.4 用途

那么,自監督學習都能用在哪兒呢?它的應用范圍也很廣泛,可以應用于自然語言處理、計算機視覺等多個領域。比如,我們用自監督學習來訓練一個理解語言的模型,就可以讓模型通過預測句子中缺失的單詞來學習語言的內在結構。

4.5 經典算法

- BERT (Bidirectional Encoder Representations from Transformers):通過Masked Language Model(MLM)任務,BERT能夠從上下文中預測被遮蓋的詞,從而學習到豐富的語言表示。

- SimCLR (Simple Contrastive Learning of Visual Representations):通過對比學習,SimCLR方法展示了自監督學習在圖像分類任務上的有效性,能夠在較少的標簽數據上實現競爭性的性能。

- BYOL (Bootstrap Your Own Latent):BYOL算法通過對比學習框架,不需要負樣本,而是通過優化一個動態的潛在空間來學習有效的視覺表示。

- MoCo (Momentum Contrast):MoCo算法通過維護一個動態的圖像隊列,并使用動量更新的編碼器來增強自監督學習的特征表示。

- DINO (Distributed and Invariant Neural Networks):DINO算法通過自監督學習框架,利用知識蒸餾技術,使得模型能夠在不同的數據分布上學習到魯棒的特征表示。

5、總結

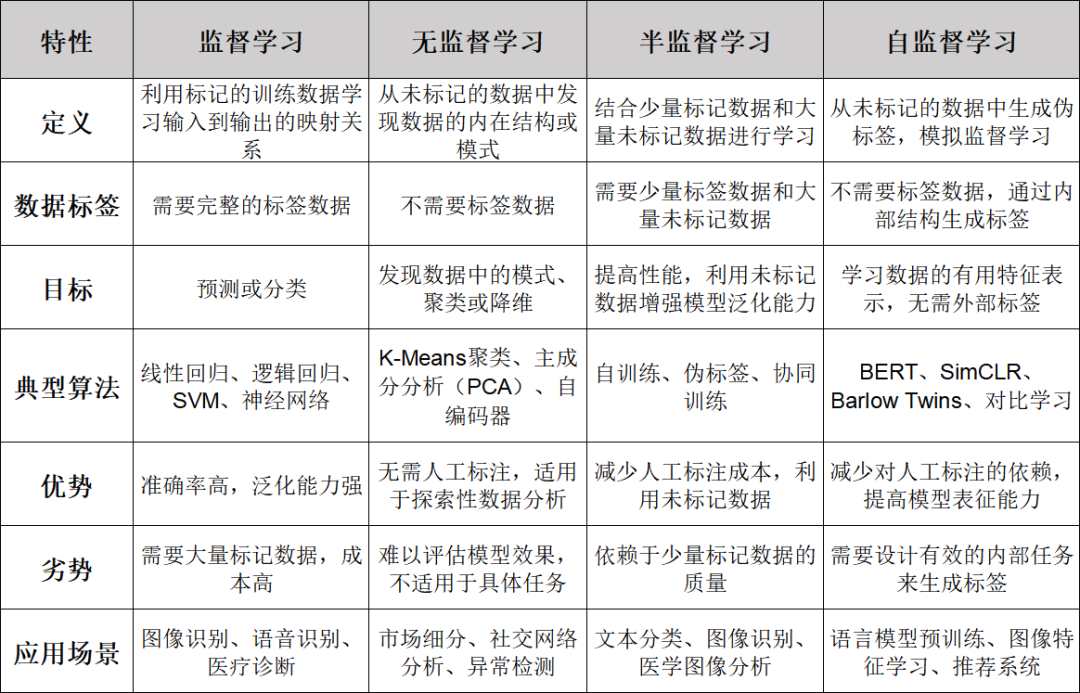

今天我們把監督學習、無監督學習、半監督學習和自監督學習這四種機器學習的方法都聊了一遍。每一種學習方法都有它們獨特的來源、定義、優勢、劣勢和用途,當然還有那些經典的算法。下面,咱們就來總結一下。

首先,監督學習就像有個老師在旁邊指導你,通過已知的答案來訓練模型。它的優勢在于結果準確,效率也高。但是,它的缺點是需要大量的標簽數據,對數據的要求也高。在圖像識別、語音識別等領域,監督學習大顯身手。線性回歸、邏輯回歸和SVM都是它的經典算法。

接著是無監督學習,它更像是自學成才的過程。無監督學習的優勢在于能夠處理大型數據集,而且不需要標注數據。但是,結果的準確性可能不夠高,對參數和算法的選擇也比較敏感。在聚類分析、異常檢測等領域,無監督學習發揮著重要作用。K-means和PCA就是其中的代表算法。

然后是半監督學習,它結合了監督學習和無監督學習的優點。半監督學習可以在有限的標簽數據下,利用大量的無標簽數據進行學習,提高模型的泛化能力。但是,它需要大量的無標簽數據,而且效果受到無標簽數據的質量和數量的影響。在文本分類、圖像識別等領域,半監督學習有著廣泛的應用。AdaBoost和圖半監督學習算法是這個領域的經典。

最后是自監督學習,它通過自己給自己出題和打分來學習。自監督學習的優勢在于能夠利用大量未標記的數據,減少對人工標注的依賴。但是,它的效果受限于輔助任務的設計,而且訓練過程可能需要更多的計算資源。在自然語言處理、計算機視覺等領域,自監督學習有著廣泛的應用。BERT和SimCLR就是這個領域的明星算法。

總的來說,這四種學習方法各有千秋,適用于不同的場景和問題。選擇合適的學習方法,就能在機器學習的江湖中游刃有余。希望今天的分享能讓你們對這些學習方法有了更深的理解。

本文轉載自??智駐未來??,作者: 小智