iText2KG:顯著降低LLM構建知識圖譜時的幻覺現象 精華

1. 當前知識圖譜構建存在的問題

知識圖譜通過捕捉實體之間的關系來構建知識的結構化表示,在分析文本數據集和從結構化異構數據中推斷知識方面具有顯著優勢。比如,知識圖譜能夠融合來自多個來源的不同數據,提供一個具有凝聚力的信息視角。還能為文本語料庫的分析提供更高層次的可解釋性。

知識圖譜的重要性不必多言,最近的GraphRAG又再一次將知識圖譜掀起高潮。

1.1 傳統知識圖譜構建的問題

傳統的命名實體識別、關系提取和實體解析是常用于將非結構化文本轉化為結構化數據、捕獲實體及其關聯和相關屬性的 NLP 技術。然而,這些方法存在一些局限性:往往局限于預定義的實體和關系,或者依賴特定的本體,并且大多依賴監督學習方法,需要大量的人工標注。

1.2 LLM時代知識圖譜構建的問題

LLMs (大語言模型) 的最新進展在包括知識圖譜補全、本體優化和問答等各類 NLP 任務中展現出了潛力和更優的性能,為知識圖譜的構建帶來了良好的前景。

LLMs 在少樣本學習方面也表現出色,能夠實現即插即用的解決方案,并且無需大量的訓練或微調。由于它們在廣泛的信息源中接受訓練,因而能夠跨不同領域提取知識。

所以,近期的研究已開始利用 LLMs 的發展成果,特別是其在知識圖譜構建任務中的少樣本學習能力。

不過,未解決和語義重復的實體及關系仍然構成重大挑戰,導致構建的圖譜出現不一致的情況,需要大量的后期處理。這些不一致可能表現為冗余、模糊以及圖譜擴展的實際困難。

此外,許多現有的方法與主題相關,這意味著其有效性在很大程度上取決于其設計所針對的特定用例。這種依賴性限制了這些方法在不同領域的通用性,需要為每個新的主題領域定制解決方案。

基于大型語言模型(LLM)構建知識圖譜(KG)的解決方案,可依據三種范式來分類:本體引導、微調以及零樣本或少樣本學習。

2. iText2KG

圖片

圖片

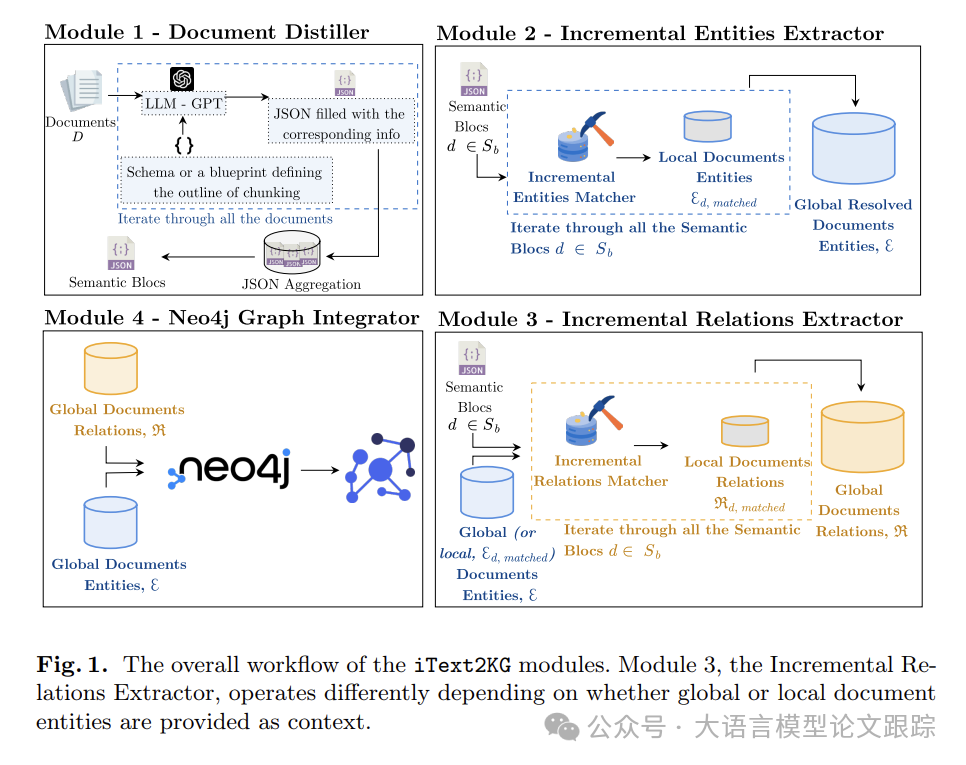

為了解決以上問題,作者提出了iText2KG。上圖是 iText2KG 的工作流程概覽。包含四個模塊:

1)文檔蒸餾器(Document Distiller):利用 LLM,將原始文檔重新整理為預定義和語義塊。該模式類似預定義的 JSON 結構,引導語言模型從每個文檔中提取與特定鍵相關的特定文本信息;

2)增量實體提取器(Incremental Entities Extractor):獲取語義塊,識別語義塊內獨特的語義實體,消除歧義,確保每個實體都有清晰的定義并與其他實體區分開;

3)增量關系提取器(Incremental Relations Extractor):處理已解決的實體和語義塊,以檢測語義上獨特的關系。

4)圖集成器(Graph Integrator):使用 Neo4j 以圖形格式直觀地呈現這些關系和實體。

2.1 文檔蒸餾器(Document Distiller)

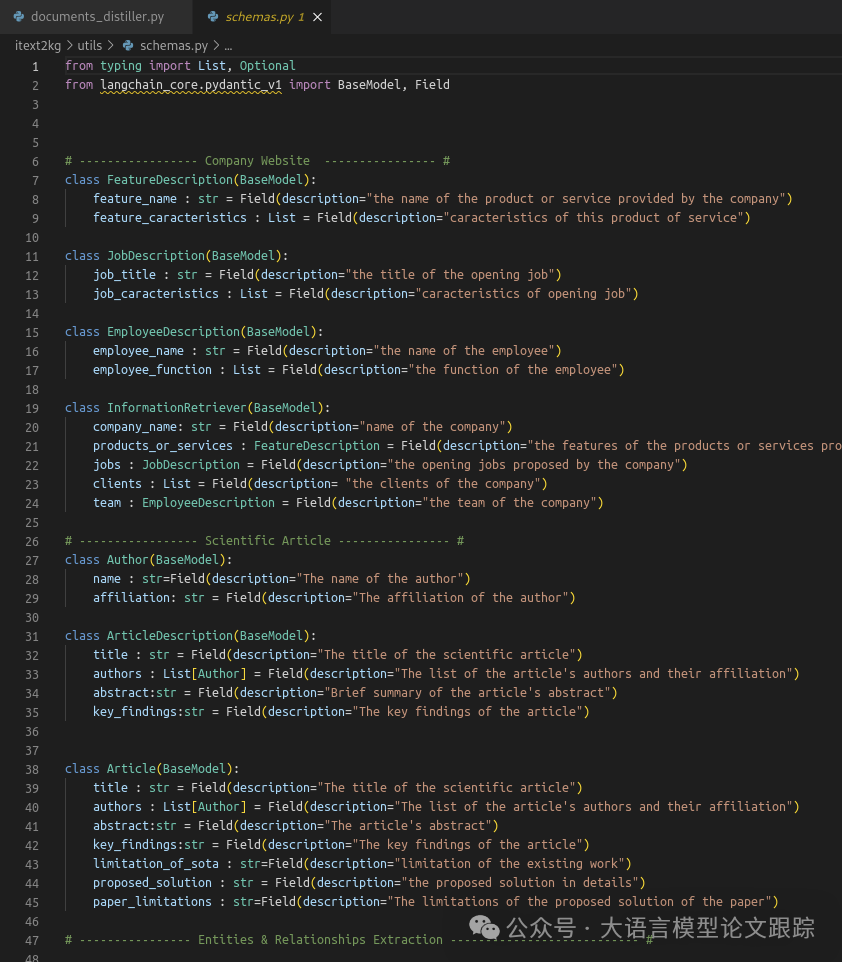

運用大型語言模型(LLM)依照預定義的模式(Schema)或藍圖將輸入文檔重寫為語義塊。這些模式(Schema)并非本體,而是一個藍圖,使 LLM 傾向于特定類別,同時在其他方面保持靈活性。

實際上,該模式(Schema)的功能類似于預定義的 JSON,引導 LLM 從每個文檔中為特定的鍵提取特定的值(文本信息)。在這個項目的Github倉庫里可以找到一些這種Schema的示例(如下圖):

圖片

圖片

對于每個文檔,如果其中存在所需信息,將獲得一個半填充的 JSON。

然后將所有這些半填充的 JSON 聚合起來,形成文檔的語義塊。

該模塊的主要目標為:

-(a)通過減少可能用冗余信息污染圖形的噪聲來提高信噪比。

-(b)利用模式引導圖形構建過程,特別是針對概念鍵。例如,對于一篇科學文章,能夠提取“標題”和“作者”,并添加諸如“具有標題”和“具有作者”之類的關系以及語義信息。為確保解決方案在各種用例中的適用性,Schema是一個取決于用戶偏好和用例特殊性的輸入。通過重新制定原始文檔來增強圖形構建過程的構想已被以下論文所證實。

2.2 增量實體提取器(Incremental Entities Extractor)

增量式實體匹配器(iEntities Matcher)會遍歷所有語義塊并提取全局文檔實體。

圖片

圖片

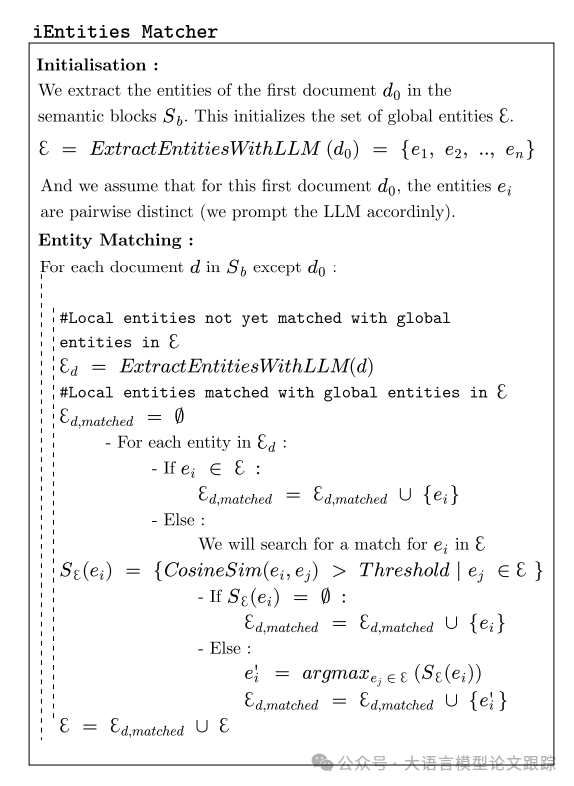

iEntities Matcher 的主要算法如上圖。

iEntities Matcher的核心算法是先利用大型語言模型(LLM)從首個語義塊(即文檔0)中提取實體,構建全局實體集?,且假定這些實體在首次迭代中僅此一次成對獨立。

遵循約束(C1,原文具體定義,即:實體和關系都應該描述一個語義上獨特的概念。),引導LLM提取單一概念的實體,以避免語義混淆。

對于文檔集合中的后續文檔,算法抽取局部實體,并嘗試將其與全局實體集中的實體進行匹配。

如果局部實體在中找到對應,則加入到匹配集中。

若未找到,算法將使用預設閾值的余弦相似度在中尋找相似實體。若依然無匹配項,局部實體將直接加入匹配集;

若有,則基于最高相似度選取最佳匹配的全局實體加入。隨后,全局實體集通過與匹配集的合并進行更新。

這一流程在文檔集合中的每個文檔上重復執行,最終形成一個全面的全局實體集。

2.3 增量關系提取器(Incremental Relations Extractor)

將全局文檔實體與每個語義塊一同作為上下文提供給增量式關系匹配器(iRelations Matcher)以提取全局文檔關系。

采用了與 iEntities Matcher 相同的方法。

根據將全局實體還是本地實體作為與語義塊一起的上下文提供給 LLM,關系提取會有不同的表現。

當提供全局實體作為上下文時,LLM 會提取語義塊直接陳述和隱含的關系,特別是對于語義塊中未明確存在的實體。這為圖形豐富了潛在信息,但增加了不相關關系出現的可能性。

相反,當提供本地匹配的實體作為上下文時,LLM 僅提取上下文直接陳述的關系。這種方式降低了圖形的豐富程度,但也降低了不相關關系的概率。

圖片

圖片

iRelations Matcher 的兩個版本如上圖所示,藍色表局部實體(Local),紅色表示全局實體(Global)。

2.4 圖集成器(Graph Integrator)

將全局文檔實體和全局文檔關系輸入到 Neo4j 中以構建知識圖譜。

這一部分作者描述的比較簡單,大家有興趣可以去Github查看該部分的源代碼:

??https://github.com/AuvaLab/itext2kg/tree/main/itext2kg/graph_integration??

3. 效果評估

所有實驗中,作者均選用了 GPT-4 來作為基礎模型進行評估。GPT-4 即便在零樣本的情境下,也能達成近乎微調后的頂尖性能。

采用了三個用例:網站轉化為知識圖譜、科學文章轉化為知識圖譜以及簡歷轉化為知識圖譜分別對各個模塊進行效果評估,確保 iText2KG 能在不同的知識圖譜構建場景中適用。

3.1 文檔蒸餾器效果評估

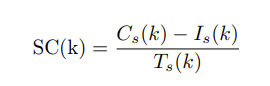

作者首先對模塊 1 (文檔蒸餾器)進行評估,以確保所提取的信息與模式及輸入文檔的語義相符。針對該模塊,作者提出了以下指標:

? 模式一致性(Schema consistency):檢驗重寫文本內容是否與輸入的架構相符。對于架構中每個關鍵點,我們定義 Cs(K)為正確對應到該關鍵點相關架構的元素數目。Is(k) 為那些被加入但不屬于架構的元素數目。架構中某個關鍵點的一致性得分計算如下:

圖片

圖片

? 信息一致性(Information consistency):評估重寫文本的內容是否與原始報告的語義相符,具體分類為:差異極大(<30%)、中等差異(30-60%)、大致一致(60-90%)和完全一致(>90%)。

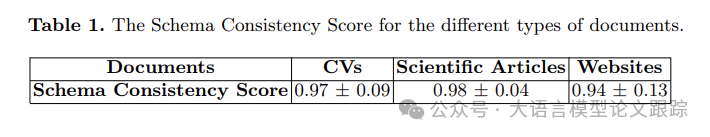

3.1.1 模式一致性

圖片

圖片

上表顯示,文檔蒸餾器在各類文檔類型中均實現了較高的模式一致性。

科學文章和簡歷呈現出最高的模式一致性得分,表明該模塊處理結構化信息的能力出色,特別是對于主要依靠標題來組織數據的文檔。

網站的一致性得分仍高達 0.94,但相對略低,這或許是由于網絡內容的多樣性和結構化程度較低所致。

表明文檔蒸餾器在處理和從不同類型文檔中提取結構化信息方面的穩健性和適應性。

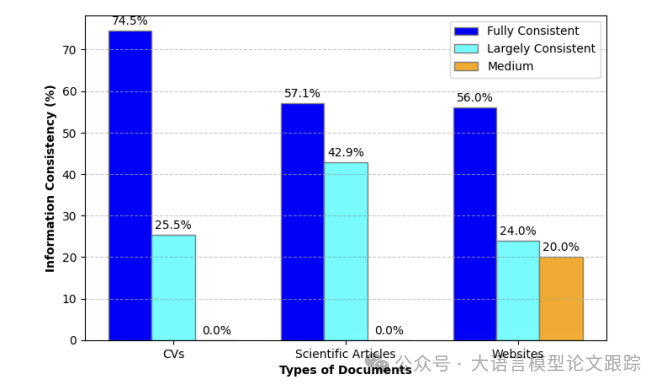

3.1.2 信息一致性

圖片

圖片

上圖展示了不同類型文檔(簡歷、科學文章和網站)的信息一致性情況。

對于簡歷,大部分信息(74.5%)完全一致,25.5%大致一致,不存在中等一致性。表明重寫的文本與簡歷原始內容的語義高度匹配。因為簡歷主要以清晰簡潔的短語編寫,使得大型語言模型更易于捕捉語義。

對于科學文章,57.1%的信息完全一致,42.9%大致一致,在保留原始語義方面展現出較高的準確性,盡管略遜于簡歷。這在預料之中,特別是鑒于科學文章是用更為復雜的科學英語撰寫的。

網站有 56.0%的信息完全一致,24.0%大致一致,20.0%為中等一致性。這可能歸因于網絡內容的非結構化特性,這給準確的語義重寫帶來了更大的挑戰。

3.2 增量實體提取器和增量關系提取器效果評估

? 三元組提取精度(Triplet Extraction Precision):不關心實體/關系解析過程,直接評估與相應文本的三元組一致性。三元組有的時候是隱含的,不一定直接由文本表述。將精度得分定義為提取的相關三元組數量除以提取的三元組總數。

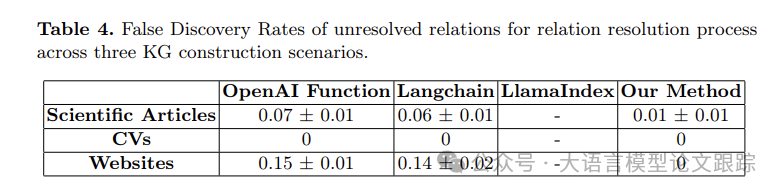

? 實體/關系解析錯誤發現率(Entity/Relation Resolution False Discovery Rate):評估在提取的實體或關系總數中未解決(假陽性)的實體或關系所占比例。具體而言,計算未解決的實體或關系與提取的實體或關系總數的比率。通過突出總提取中的錯誤(未解決的實體/關系)比例,表明實體和關系提取過程的可靠性。

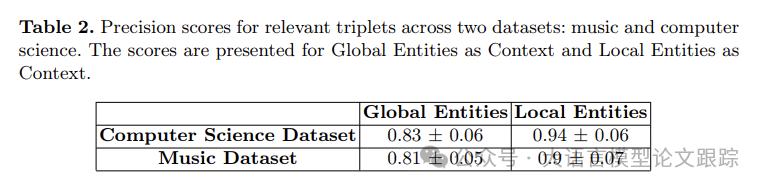

3.2.1 三元組提取

圖片

圖片

參照上圖,作者分別對使用全局還是局部實體作為上下文進行比較,比較二者在關系提取方面呈現出不同的表現。

當以全局實體作為上下文時,相關三元組的精度比以局部實體作為上下文時低 10%。當使用全局實體作為上下文時,大型語言模型會提取語義塊中明確提及和隱含的關系。這會形成一個更豐富的圖,包含更多潛在信息,但也有更高的出現不相關關系的可能性。

使用局部實體 作為上下文會致使大型語言模型僅提取直接陳述的關系,從而導致生成的圖不夠豐富,但不相關關系出現的可能性較低。

這體現了一種取決于用例的權衡。作者讓用戶決定是接受精度降低 10%以換取更豐富的圖,還是獲取 10%的精度但得到相對不那么豐富的圖。

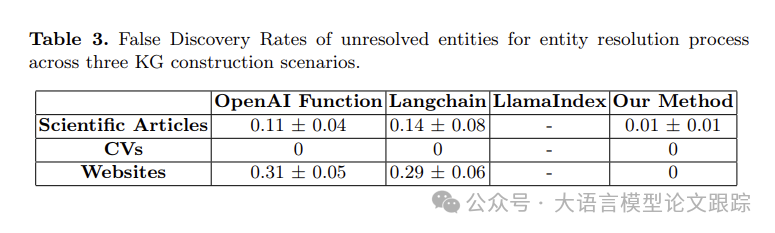

3.2.2 實體/關系解析

LlamaIndex 為檢索增強生成(RAG)構建具有邊級和節點級文本信息的未連接子圖;因此,未將 LlamaIndex 與 iText2KG 進行對比評估。

圖片

圖片

圖片

圖片

從上面兩個圖中,可以看出 iText2KG 在三個不同的知識圖譜構建場景中,在實體和關系解析過程方面取得了更優的成果。

此外,結果顯示,當輸入文檔數量較少且具有清晰、非復雜的短語時,大型語言模型在實體和關系解析方面表現出色,如簡歷到知識圖譜的過程所示。

此外,網站到知識圖譜中未解決實體和關系的錯誤發現率高于其他知識圖譜構建場景。是由于文檔(塊)數量較多以及網站文本信息的非結構化特性所致。

因此,只要文檔(塊)數量龐大且文本是非結構化且語言復雜,實體/關系解析過程對于構建一致的知識圖譜就變得至關重要。

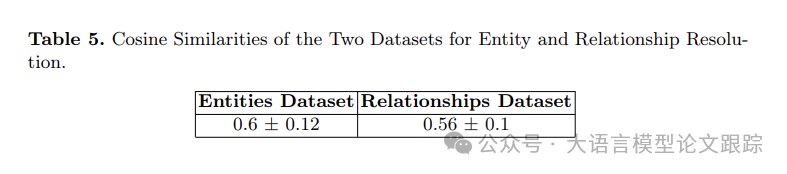

3.3 閾值估計

為基于余弦相似度估計合并實體和關系的閾值,使用 GPT-4 生成了一個包含 1500 個相似實體對和 500 個關系的數據集,其靈感源自不同領域。

圖片

圖片

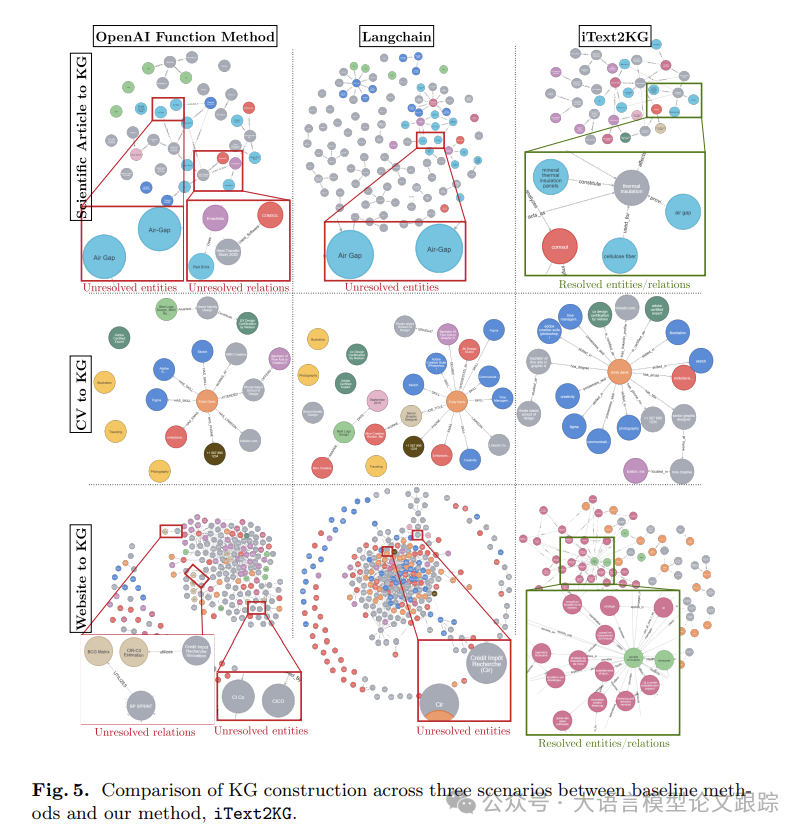

3.4 整體效果

圖片

圖片

上圖對比了其他方法與iText2KG在三種不同情境下的表現:

? 其他基準方法在所有三種知識圖譜構建情境中都暴露出孤立節點,這些節點間缺乏聯系。可能由于實體和關系提取的同時進行,導致語言模型產生幻覺效應,進而引起“遺忘”現象。可以通過分離實體和關系提取步驟可以提升性能。

? 在“網站至知識圖譜”的場景中,輸入文檔數量的增加往往導致圖中噪聲節點的增加。表明文檔蒸餾在有效提煉和精煉輸入數據方面的重要性。

? iText2KG方法在三種知識圖譜構建情境中均展現出了更優的實體和關系解析能力。當輸入文檔較少且內容簡單、不復雜時,語言模型在實體和關系解析上表現出高效性,這一點在“簡歷至知識圖譜”的流程中得到了體現。然而,隨著數據集變得更為復雜和龐大,挑戰也隨之增大,如“網站至知識圖譜”的場景。輸入文檔的分塊大小和閾值對知識圖譜構建的影響不容忽視。文檔蒸餾器的輸入可以是獨立文檔或分塊。分塊越小,語義塊能捕捉到的文檔細節就越具體,反之亦然。

? 論文原文: ??https://arxiv.org/abs/2409.03284??

本文轉載自??大語言模型論文跟蹤??,作者:HuggingAGI