OpenAI發(fā)布新模型:o1系列模型,更像理科生的模型 精華

本來今天準備發(fā)一篇金融相關的Agent論文

結果一大早上,各大群就都開始流傳著各種聊天記錄

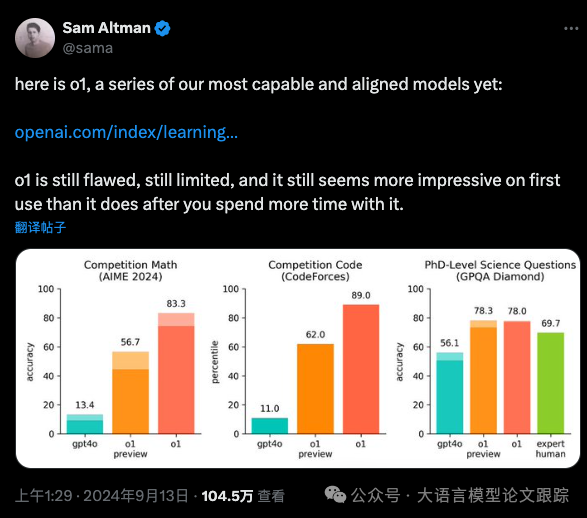

原來是凌晨OpenAI發(fā)布了新的 o1 系列模型(以下簡稱 o1模型或o1),所以迫不及待的找了些資料趕緊學習下。

圖片

圖片

看上去,這個 o1 系列模型在數(shù)學、編碼、科學等一系列理科生擅長的事情上,表現(xiàn)比GPT4還好。

目前,各大微信群的討論大致分為兩種觀點:

? o1 太牛逼了,GPT5來了,AGI立馬到來!

? o1 這不就是個 Workflow + Agent嗎?

收集了各方的【小道消息】,其實就是是【X】上各種OpenAI發(fā)布的消息 + 微信群聊天記錄 + OpenAI官方文檔。

可以總結一下:

? o1模型最大的特點:輸出最終答案前,會進行深入思考,這種思考不是簡單的通過提示工程來注入的,而是通過強化學習實現(xiàn)的。

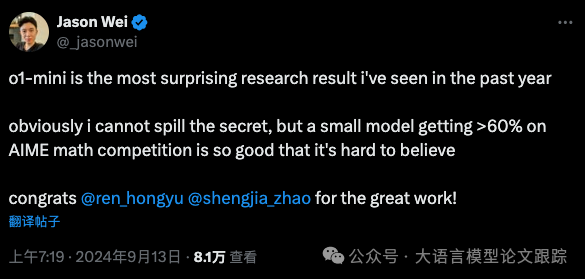

? o1模型的尺寸不會很大,是個小尺寸大模型(證據(jù)來自OpenAI研究院 Jason Wei的X,如下圖),但是到底多小?不知道。

圖片

圖片

緊接著英偉達科學家 Jim Fan 也發(fā)了消息,對 o1 模型做了一些解讀,我們匯總一下要點:

? 模型的大多數(shù)參數(shù)只是用來記憶事實,而推理核心不需要太多參數(shù)。可以從知識中分離出一個小的“推理核心”,這樣可以減少大量的預訓練計算。

? 大量計算由原來的訓練階段,轉移到了服務推理階段。

? o1在實際應用落地的難度遠比學術基準測評要更難,這一塊還有待后續(xù)大家進一步探索。

? o1模型也會像之前ChatGPT一樣,形成數(shù)據(jù)飛輪,催生更多訓練數(shù)據(jù)和模型的出現(xiàn)。

o1是不是GPT5?

目前,根據(jù)各方消息看來,o1并不是部分自媒體吹噓的GPT5。

至少從OpenAI官方文檔中,看不到任何描述能將GPT5和o1模型聯(lián)系在一起的。

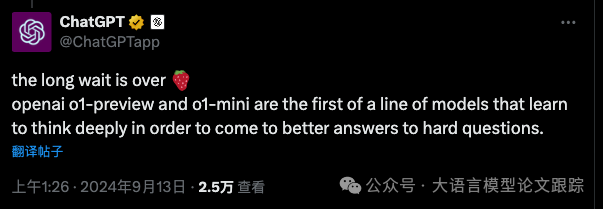

o1算是strawberry / Q* 項目的一個產出。

圖片

圖片

圖片

圖片

雖然沒有被宣稱為GPT5,但是o1是一個不同于傳統(tǒng)的GPT3.5和GPT4的新范式。在OpenAI的開發(fā)者文檔中,我們可以發(fā)現(xiàn),o1模型被單獨列為推理模型(Reasonging Models),這是否意味著之前 Altman 宣稱的將數(shù)據(jù)與推理引擎分離的構想已經(jīng)實現(xiàn),或者已經(jīng)邁出實質性的一步?

這也與前面英偉達科學家 Jim Fan 提到的觀點相呼應:模型的大多數(shù)參數(shù)只是用來記憶事實,而推理核心不需要太多參數(shù),可以從知識中分離出一個小的“推理核心”。

o1模型是不是一個Agentic Workflow?

這是今天很多群里充斥的觀點之一,在大家非常興奮的體驗了o1模型后,部分同學,包括一些自媒體也紛紛得出這樣的結論,甚至開始唱衰OpenAI。

比如,有的自媒體開始【大膽】的猜測:這次的草莓o1有可能是 gpt-4o 在進行一些微調/對齊后的 agent。

包括說:

這有沒有可能就是封裝了workflow而已?

在仔細閱讀了各種資料后,我的猜測, o1模型肯定不是 agent,原因如下:

1、o1是經(jīng)過強化學習的推理模型

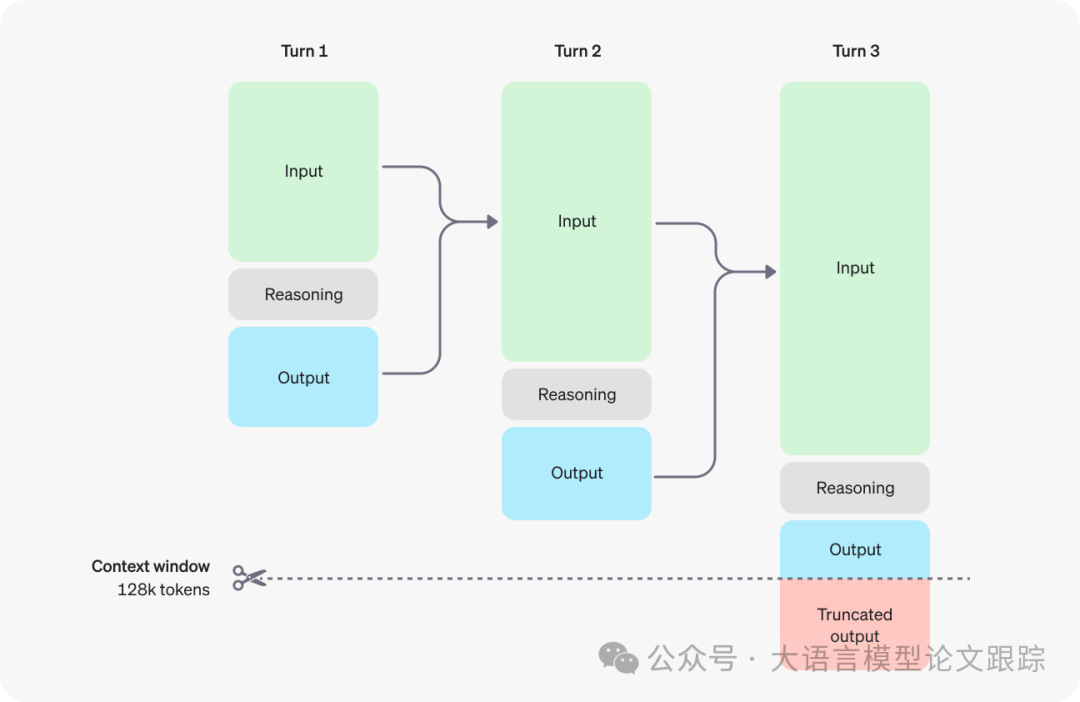

在官方文檔中,o1模型被定義為推理模型,而且是經(jīng)過強化學習訓練的模型,使用了思維鏈進行推理。o1模型的一個顯著區(qū)別就是o1模型引入了一個成為推理token的概念,對用戶提出的問題,探索多種生成回答的方法,最后模型以一種被稱為可見token的方式輸出答案。

這種token的設計,也導致了一些與之前的模型的區(qū)別,比如:

- ?實際生成的token數(shù)與系統(tǒng)返回的token數(shù)存在差異:甚至一個很簡單的問題,也會消耗大量token。比如,當回答一個簡單的提示詞“你好”的時候(雖然個人認為,這樣的提示詞并不是推理模型所擅長的),模型消耗了 400 多個token。PS:在OpenAI的官方文檔中,明確提出大家在使用o1模型的時候要預留窗口空間給推理token。比如下圖,當輸出長度超出了限制時,可見輸出就看不到了。

圖片

圖片

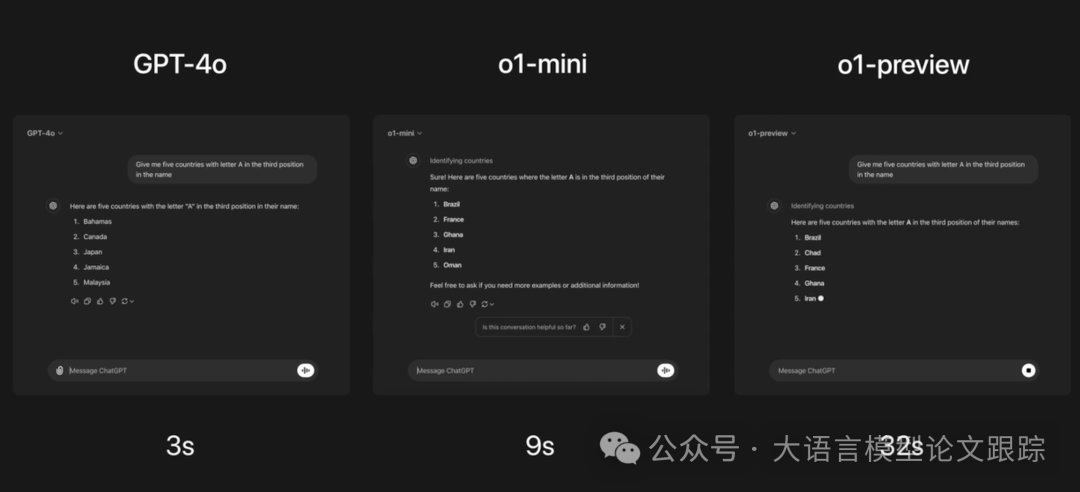

?模型耗時增加:因為中間多了一個推理過程(多方式推理,可能通過一種類似MCTS的方法來進行最佳路徑搜索),所以模型輸出會比其他模型消耗更多的時間(如下圖)。

圖片

圖片

2、沒有多模態(tài)、沒有系統(tǒng)提示詞、沒有工具調用、沒有stream輸出等等

如果o1只是一個Agent應用,那么為什么不把這些系統(tǒng)提示詞、工具調用、stream輸出加上?這些對OpenAI的工程師來說是個難題?咱們國內的組合式創(chuàng)新團隊都能做的事情,OpenAI居然做不了?

3、完全不同的提示詞策略

在OpenAI的官方文檔中,我們可以發(fā)現(xiàn),OpenAI給出了針對推理模型的提示詞建議:

? 由于模型內部已經(jīng)進行推理,過去的few shot或者zero shot cot(要求模型逐步思考)的提示詞技巧,可能并不會提升性能,反而可能會降低性能。

? 保持提示簡潔明了:模型擅長理解并回應簡短而清晰的指令,無需過多指導。

? 利用分隔符提高清晰度:使用三重引號、XML標簽或小節(jié)標題等分隔符,明確區(qū)分輸入的不同部分,幫助模型更準確地解讀。

? 在檢索增強生成(RAG)中限制額外上下文:提供額外上下文或文檔時,只包含最相關的信息,以免模型的回應過于復雜。

綜上,o1模型應該并不是一個Agentic Workflow應用,而是一個確確實實的新的模型范式。而且這應該只是OpenAI在這個事情上踏出的第一步(也許我們從代號1就可以看出,重新命名,而不是繼承),而不是最后一步,目前的o1模型也不打算取代GPT4\GPT4-o等模型的地位。

o1模型到底強還是弱?

答案是,o1肯定強,但是也沒有強到無與倫比。

目前流傳的各種體驗,測試結果來看,o1肯定是強的,特別是在需要推理的STEM領域(STEM是Science、Technology、Engineering、Mathematics 四個英文單詞首字母的縮寫)。

各種數(shù)據(jù)我就不羅列了,應該鋪天蓋地都是。

但是o1仍然是不強的,比如,o1還是無法完全正確回答一些問題,比如大家都在嘗試問他9.11和9.8到底誰大的問題。

這側面說明,即使o1是一個推理引擎,但他始終還是利用語言來模擬自然世界,與規(guī)則的方法不一樣。

所以,對于o1模型,我們需要客觀的看待,即使o1模型很強,但是也仍然是有幻覺的。

圖片

圖片

當然,有人我們未來可能遇到號稱比 o1 強69倍的GPT-5模型,但是如果范式不變,我想仍然是無法從根本上解決 9.11和9.8 誰大這類問題的。

為什么說o1是一個更像理科生的模型?

不知道大家有沒有關注到,OpenAI的文檔里,花了很大篇幅描述o1模型在STEM和安全方面的評估。

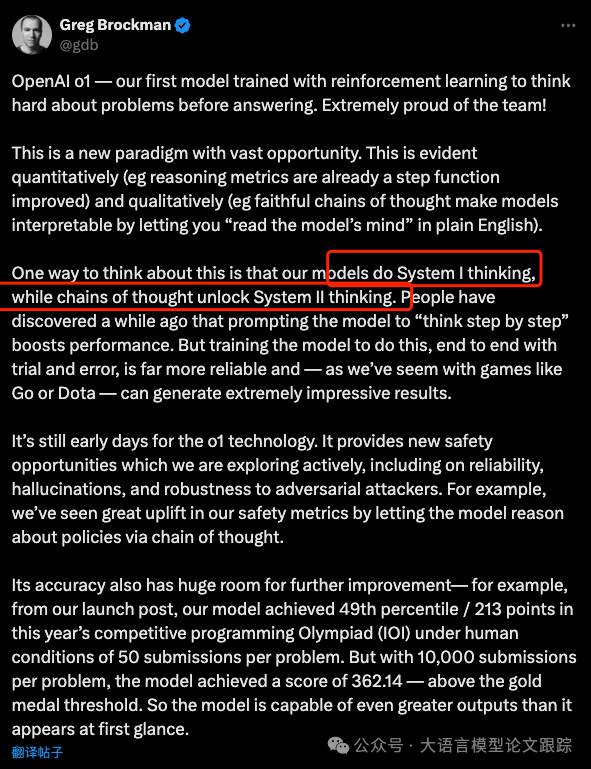

以及,在 Greg Brockman 發(fā)的消息里可以看到,OpenAI是認可 o1 模型實際上是使模型從 System1 向 System 2 靠近的動作(之所以說靠近,是因為個人認為System1和System2邊界并不明顯)。

圖片

圖片

在之前的論文里我們也討論過,System1和System2的區(qū)別在于:

System1:快速,不加思考、不做計算、僅憑直覺就做出判斷。比如,當我們回答1+1這個問題的時候,我們的大腦可以不加思考的回答出等于2。所以系統(tǒng)一的特點是:快思考、熱啟動、直覺判斷。

System2:速度,需要做復雜的計算、推理,但回答準確度高。比如,當我們回答123乘以879的時候,我們無法通過我們的快思考來回答,我們需要調用大腦的計算模塊,對這個問題進行復雜的計算后才能回答。所以系統(tǒng)二的特點是:慢思考、啟動慢、耗費能量高、判斷準確。

而o1則是試圖使用內置的CoT來引導模型生成更加準確的答案,而需要這些嚴格推理邏輯的則是STEM里的這幾門學科。所以我們可以認為,相比過去的大語言模型(真快,這才2年不到,就可以說過去了),o1更加像一個理科生思考。這并不是說o1是理科生,而是說,大語言模型過去更像一個文科生,特別是zero shot的時候,而現(xiàn)在的o1則是在彌補理科生這個短板。

是否要馬上把o1模型用起來?

對于這塊,我的答案是謹慎!

1、模型仍不完善

o1模型并非一個成熟的產品,這點從官方文檔、X上的討論都可以看得出。目前還處于beta狀態(tài),而且各種功能的缺失,比如System Prompt、tool調用、參數(shù)設置等等。以及 o1-mini 所涉及的知識、領域仍然比較有限。

2、推理速度限制

雖然o1模型是個新模型,是新一代模型范式,是大家眼中的未來。但是o1模型因為自身設計的原因,會導致比其他模型消耗更長的時間。所以在很多應用中,特別是對時間敏感的應用,需要謹慎考慮:我們的產品、應用能否接受這樣的響應時間?

3、也許更高的成本

因為o1模型在推理過程中,會消耗大量的推理token,很多人稱之為OpenAI的扣費陷阱。當然,o1模型也帶來一個新的優(yōu)勢,就是我們可以不用傳few shot案例,也許可以減少一些token的輸入,但是這一增一減,到底是增加了成本還是降低了成本,目前還不是特別明朗,推薦大家多多測試后,再做定論。

4、新的提示詞結構

o1模型因為設計的原因,帶來了一些新的提示詞范式,過去的提示詞在 o1模型上不一定適用了。

比如過去的 few shot 或者 COT 提示詞,根據(jù)官方建議,這些技巧不僅不能帶來收益,還會降低效果。

所以,綜上,是否要使用o1模型來替換我們現(xiàn)有應用的模型,我們需要謹慎對待,需要做充分的測試評估。這與過去的模型參數(shù)增加不一樣,這次是一個范式的變化。

雖然有這么多不利因素,但是有利因素也是顯而易見:推理能力增強了,過去做不到、或者無法實現(xiàn)的應用,也許會成為可能。

會有新的一輪大模型風潮嗎?

過去,ChatGPT的出現(xiàn),隨之而來的是合成數(shù)據(jù)帶來了一大批新的模型出現(xiàn)。那么這次,還會是這樣嗎?

不敢做非常確定性的答復,但是我想這次可能有點不一樣。

這次帶來的合成數(shù)據(jù)不會那么容易,按照OpenAI官方文檔,推理token是不可見的,所以至少推理token大家應該是拿不到的。那么,后續(xù)的合成數(shù)據(jù)訓練新模型這條路看上去被堵死了。

但是,事情也不是絕對的。一件事情最難的部分往往是“證明這件事可行”,所以OpenAI證明了這個路徑是可行的,也讓大家關注到了這個新的路徑,即使沒有合成數(shù)據(jù)的幫助,但是也會有其他辦法來貢獻這些數(shù)據(jù)。期待開源社區(qū)進一步的表現(xiàn)。

本文轉載自??大語言模型論文跟蹤??,作者: HuggingAGI ????