Llama 3.2 強勢震撼登場:從 1B 純文本躍至 90B 多模態,成就端側 AI 巔峰杰作 原創

在當今科技飛速發展的時代,人工智能技術正以驚人的速度不斷演進,為我們的生活和工作帶來了翻天覆地的變化。Meta 公司作為科技領域的巨頭之一,一直致力于推動人工智能的發展。2024 年 9 月 25 日,Meta 公司重磅推出了 Llama 3.2。 引起了廣泛關注,它究竟有哪些令人矚目的特點和創新呢?讓我們一同深入探索。

一、Llama 3.2簡介

Llama 3.2 是 Meta 公司開發的一款強大的人工智能模型。它在之前版本的基礎上進行了優化和升級,擁有更加出色的性能和廣泛的適用性。Llama 3.2 包括了不同參數規格的視覺模型和輕量級純文本模型,為各種應用場景提供了靈活的選擇。

二、Llama 3.2功能特點

1. 強大的視覺處理能力

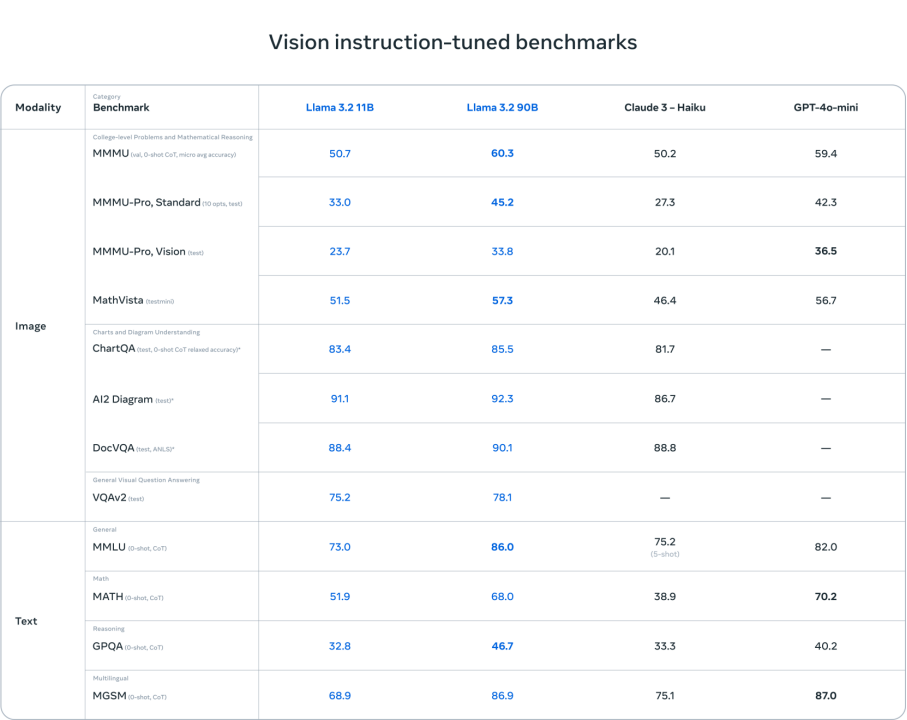

Llama 3.2 擁有 90b 和 11b 兩種參數規格的視覺模型,在圖像理解任務上表現卓越。它可以完成圖像理解、視覺推理、圖像標題、圖像文本檢索、文檔視覺問題解答等多種任務。在相關的基準評分中,Llama 3.2 的視覺模型高于包括 Claude 3 Haiku 和 GPT-4 Omini 在內的封閉模型,展現出了強大的競爭力。

例如,在圖像理解任務中,Llama 3.2 可以準確地識別圖像中的物體、場景和動作,并給出詳細的描述。在視覺推理任務中,它能夠根據圖像中的信息進行邏輯推理,回答各種復雜的問題。這種強大的視覺處理能力為圖像相關的應用提供了有力的支持。

2. 輕量級純文本模型

除了視覺模型,Llama 3.2 還包括能在設備端本地運行的 1b 和 3b 輕量級純文本模型。這些模型支持 128k tokens 上下文,適配高通和聯發科硬件,并針對 ARM 處理器做了優化。這意味著開發者可以在資源受限的設備上運行這些模型,為移動應用等場景提供了強大的人工智能支持。

輕量級純文本模型具有多語言文本生成和工具調用能力,可用于移動人工智能寫作助手和客戶服務應用等場景。在保證數據隱私的同時,為用戶提供個性化的服務。

三、Llama 3.2模型評估

Meta 公司發布了 Llama 3.2 視覺模型的部分評估數據。具體如下:

1. 文本相關任務方面

對于輕量級的 Llama 3.2 3b 模型,在指令遵從、總結、提示詞重寫、工具使用等任務上的表現優于 Gemma 22.6b 和 Phi 3.5-mini;而 1b 的表現與 Gemma 相當。這說明 Llama 3.2 的輕量級模型在文本處理的一些常見任務上也具有較好的性能,能夠滿足一定的應用需求。

2. 圖像理解任務方面

在涉及多種語言的 150 多個基準數據集上進行了評估。其視覺模型在圖像識別等一系列視覺理解任務上足以比肩業界領先的基礎模型 Claude 3 Haiku 和 GPT-4 Omini。這意味著 Llama 3.2 在圖像理解的準確性、對不同圖像場景和內容的識別能力等方面達到了較高的水平,能夠與這些知名模型相媲美。

這些只是 Meta 公司公布的部分性能測試結果,隨著更多開發者和研究機構對 Llama 3.2 的使用和測試,可能會有更全面、深入的性能分析和評估結果出現。如果你想了解更詳細的性能測試信息,可以關注 Meta 公司的官方發布或相關的技術論壇、研究報告等。

四、本地部署體驗

1. 安裝依賴

需確保安裝的 transformers 版本不低于 4.43.0。

pip install transformers

pip install 'accelerate>=0.26.0'

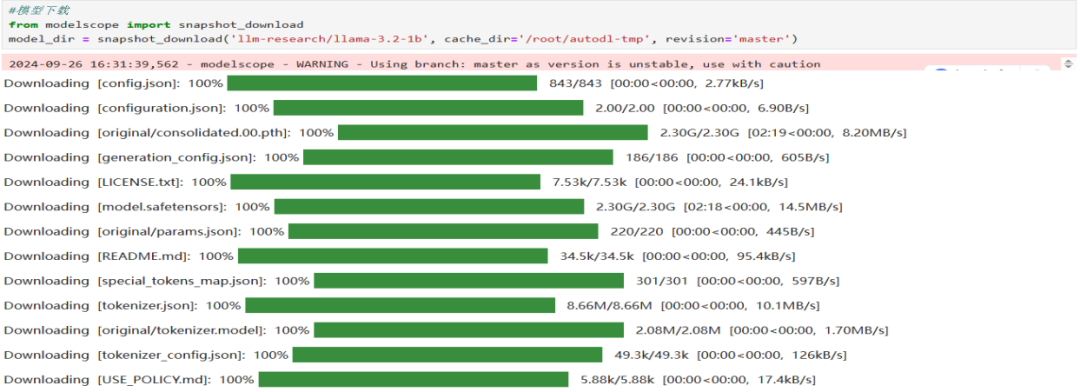

pip install modelscope2. 模型下載

使用 modelscope 中的 snapshot_download 函數下載模型(提前安裝modelscope :pip install modelscope)。第一個參數為模型名稱,參數 cache_dir 用于指定模型的下載路徑。

#模型下載

from modelscope import snapshot_download

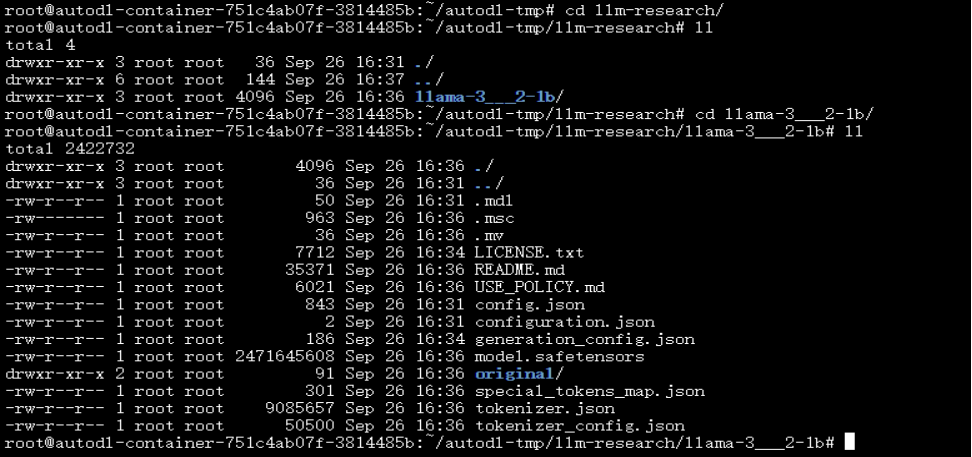

model_dir = snapshot_download('llm-research/llama-3.2-1b', cache_dir='/root/autodl-tmp', revisinotallow='master')下載完成如下:

模型下載完成后,可在/root/autodl-tmp/llm-research/llama-3___2-1b目錄下查看模型文件

注意檢查對比文件數量和大小,確認文件下載是否完整。

3. 模型推理

以下是使用 Python 進行模型推理的代碼示例。

import torch

from transformers import pipeline

model_id = "/root/autodl-tmp/llm-research/llama-3___2-1b"

pipe = pipeline(

"text-generation",

model=model_id,

torch_dtype=torch.bfloat16,

device_map="auto"

)

pipe("The key to life is")輸出:

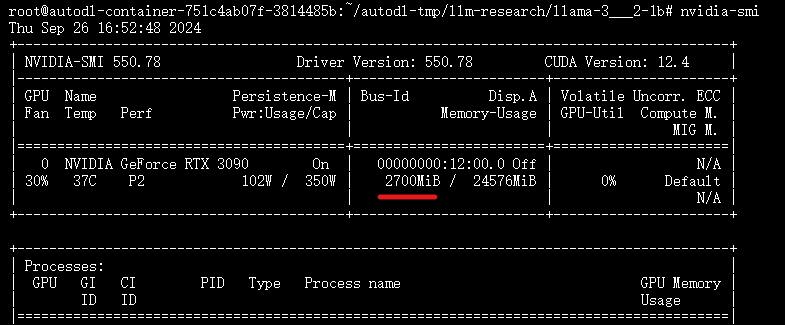

[{'generated_text': 'The key to life is to be happy. The key to happiness is to be kind. The'}]GPU資源消耗如下:

圖片

圖片

結語

Llama 3.2 的推出標志著 Meta 在人工智能領域又邁出了堅實的一步。它強大的功能特點和廣泛的應用場景,為我們展示了人工智能的無限潛力。隨著技術的不斷進步,我們相信 Llama 3.2 將在未來的日子里為我們的生活和工作帶來更多的驚喜和便利。讓我們拭目以待,共同見證人工智能的輝煌未來。同時,我們也期待著更多的科技公司能夠推出更加先進的人工智能技術,共同推動人工智能行業的發展。

相關資料

- 官網地址:??https://www.llama.com/??

- 模型地址:??https://huggingface.co/meta-llama/Llama-3.2-1B??

- Github地址:???https://github.com/meta-llama/llama-models/tree/main/models/llama3_2??

本文轉載自 ??小兵的AI視界??,作者: 小兵