Llama3.2開源:Meta發布1B和3B端側模型、11B和90B多模態模型

早上起來發現,Meta AI又開源模型,文本模型開源了端側小模型1B和3B模型,也是首次開源了多模態大模型11B和90B兩個版本;同時還開源了一個 Llama Stack項目。

Blog: https://ai.meta.com/blog/llama-3-2-connect-2024-vision-edge-mobile-devices/

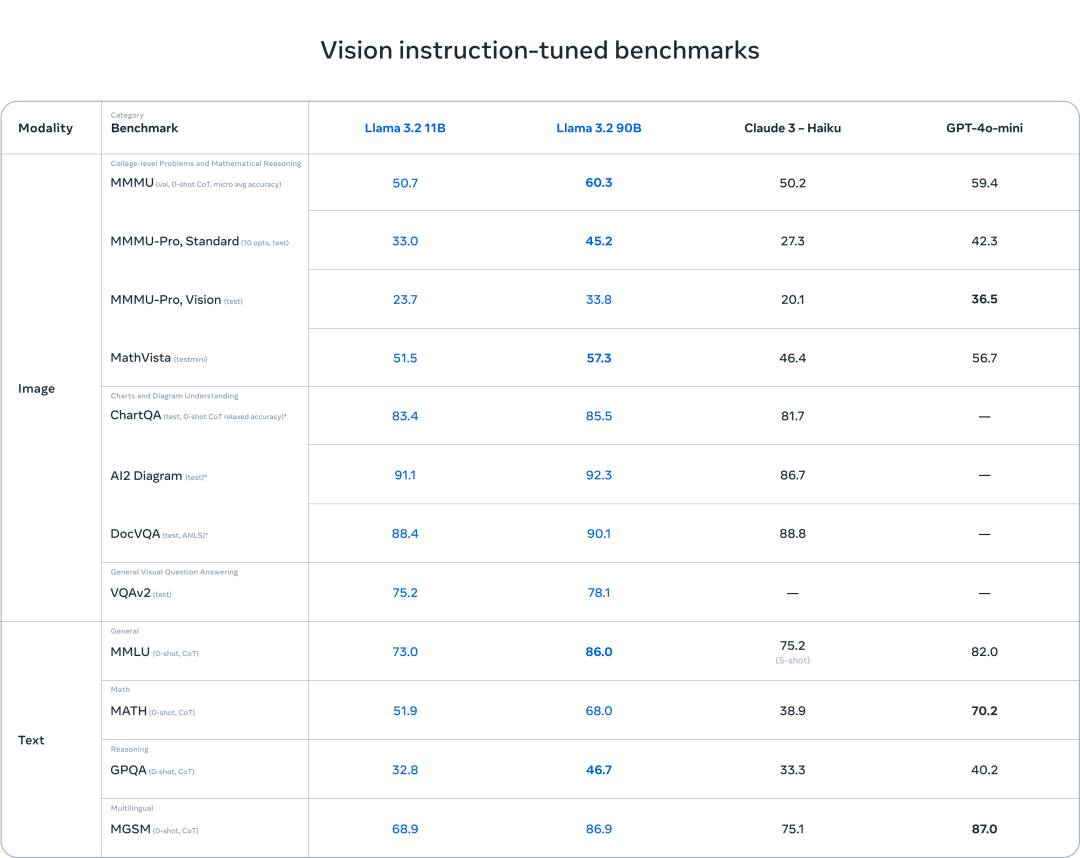

HF: https://huggingface.co/collections/meta-llama/llama-32-66f448ffc8c32f949b04c8cf其中Llama3.2多模態模型在圖像識別和一系列視覺理解任務方面效果優于Claude 3 Haiku 和 GPT4o-mini。文本模型-Llama3.2-3B模型在循指令、總結、提示重寫和工具使用等任務上優于 Gemma 2 2.6B 和 Phi 3.5-mini 模型。

多模態模型效果

端側模型效果

多模態模型

Llama3.2的11B和90B模型多模態是基于Llama3.1-8B、70B文本模型上,增量增加圖像模型。

pretrain階段:

- 文本模塊由Llama3.1模型初始化,并初始化圖像編碼器,利用大規模噪聲(圖像、文本、6B數據對)對數據進行預訓練

- 再用中等規模的高質量的領域、知識增強的(圖像、文本、3M數據對)數據預訓練。

posting-train階段:

- 通過監督微調、拒絕采樣和直接偏好優化進行多輪對齊

- 使用 Llama 3.1 模型 過濾和增強 圖像上的問題和答案,利用合成數據生成和獎勵模型對所有候選答案打分排序,獲取高質量的微調數據

- 還添加了安全數據

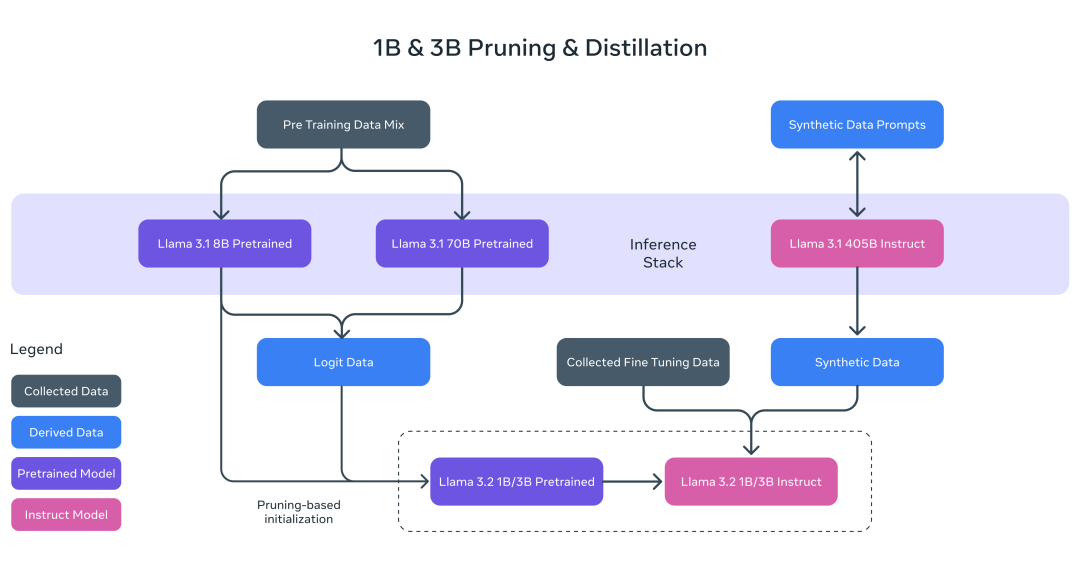

端側小模型

1B和3B模型都是基于8B模型裁剪后進行模型初始化,并且利用8B和70B模型進行模型蒸餾,9T數據預訓練。

特別注意,這里蒸餾不是那種通過更大模型進行數據生成的蒸餾,而是再模型訓練階段,利用8B 和 70B 模型輸出的 logits 影響模型loss,也就是傳統的蒸餾方法。

在post-traning階段,訓練方式語Llama3.1一致,采樣監督微調、拒絕采樣和直接偏好優化模型。

最后模型支持上下文擴展到 128K 個,同時也針對性優化了模型的多種能力,例如摘要、重寫、指令遵循、語言推理和工具使用。

Llama Stack項目

Github: https://github.com/meta-llama/llama-stack定義并標準化了將生成式 AI 應用程序推向市場所需的構建模塊,跨越整個開發生命周期:從模型訓練和微調,到評估,再到在生產環境中構建和運行AI Agent。

主要是為了簡化開發人員在不同環境(包括單節點、本地、云和設備上)中使用 Llama 模型的方式,幫助快速實現檢索增強生成、工具使用等能力的快速部署。

本文轉載自 ??NLP工作站??,作者: 劉聰NLP