Meta開源多模態(tài)模型——Llama 3.2

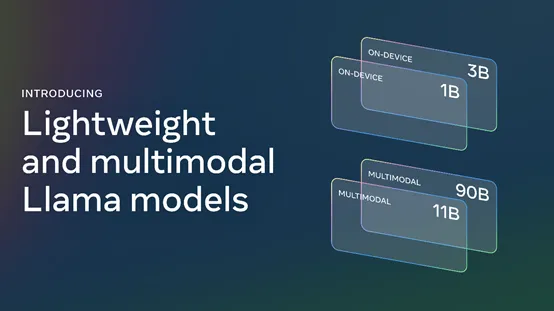

Meta開源了首個(gè)多模態(tài)大模型Llama-3.2,這是Llama-3系列的一次重大升級,一共有4個(gè)版本。

Llama 3.2 1B、3B是整個(gè)系列最輕量級的模型,適合邊緣設(shè)備和移動應(yīng)用程序的檢索和摘要,可用于個(gè)人信息管理和多語言知識檢索等,支持 128k標(biāo)記的上下文長度,可在手機(jī)、平板電腦等設(shè)備中使用。

值得一提的是,這兩款模型在發(fā)布時(shí)便對高通和聯(lián)發(fā)科的硬件進(jìn)行了適配,并針對 Arm 處理器進(jìn)行了優(yōu)化,廣泛的兼容性將加速其在各種移動和物聯(lián)網(wǎng)設(shè)備中的應(yīng)用。

開源地址:https://www.llama.com/?utm_source=twitter&utm_medium=organic_social&utm_content=video&utm_campaign=llama32

11B和90B視覺模型是 Llama首次發(fā)布的多模態(tài)大模型,能理解和推理圖像,實(shí)現(xiàn)文檔分析、圖像字幕和視覺問答等任務(wù)。

Llama 3.2 90B版本擅長常識、長文本生成、多語言翻譯、編碼、數(shù)學(xué)和高級推理等,還引入了圖像推理功能,可完成圖像理解和視覺推理任務(wù),能進(jìn)行圖像標(biāo)題生成、圖像文本檢索、視覺基礎(chǔ)、視覺問題解答和視覺推理,以及文檔視覺問題解答等。

Llama 3.2 11B版本適合內(nèi)容創(chuàng)建、對話式人工智能、語言理解和需要視覺推理的企業(yè)應(yīng)用。在文本摘要、情感分析、代碼生成和執(zhí)行指令方面表現(xiàn)出色,也增加了圖像推理能力,其用例與 90B 版本類似,包括圖像標(biāo)題生成、圖像文本檢索、視覺基礎(chǔ)、視覺問題解答和視覺推理,以及文檔視覺問題解答等。

根據(jù)測試數(shù)據(jù)顯示,Llama 3.2模型在圖像識別和視覺理解基準(zhǔn)測試中與領(lǐng)先的閉源模型具有競爭力,例如,Claude 3 haiku等。

本文轉(zhuǎn)自 AIGC開放社區(qū) ,作者:AIGC開放社區(qū)