微軟提出LLM-dCache:GTP驅動本地數據緩存優化的大模型

大型語言模型(LLM)在系統級優化中的新進展

近年來,大型語言模型(LLM)在解決復雜問題的推理能力方面取得了顯著進展,使其能夠有效管理數千種工具和API調用。這些改進釋放了它們在大規模系統中的潛力,包括UI/網絡界面、移動應用程序、SQL后端和遠程感應平臺。這些用途通過需要集成各種API來加載、過濾、處理和跨多個時間和空間維度可視化數據,體現了系統級的復雜性。

隨著Copilots規模的擴大,底層堆棧的開銷從云端點到本地執行設備都在增加,這促使我們從根本上改變設計基于LLM的大規模系統和軟件的方式。然而,早期的系統優化主要針對簡化的查詢或定義良好的基準,可能無法捕捉系統級任務模式和數據依賴性的細微差別。在現實的LLM工作負載中,數據顯示出顯著的可重用性。例如,一個地理空間分析師可能會問:“顯示加州紐波特海灘周圍的衛星圖像。”隨后的提示是“現在,在這個區域檢測飛機”,這展示了一個數據元素被反復訪問的場景。

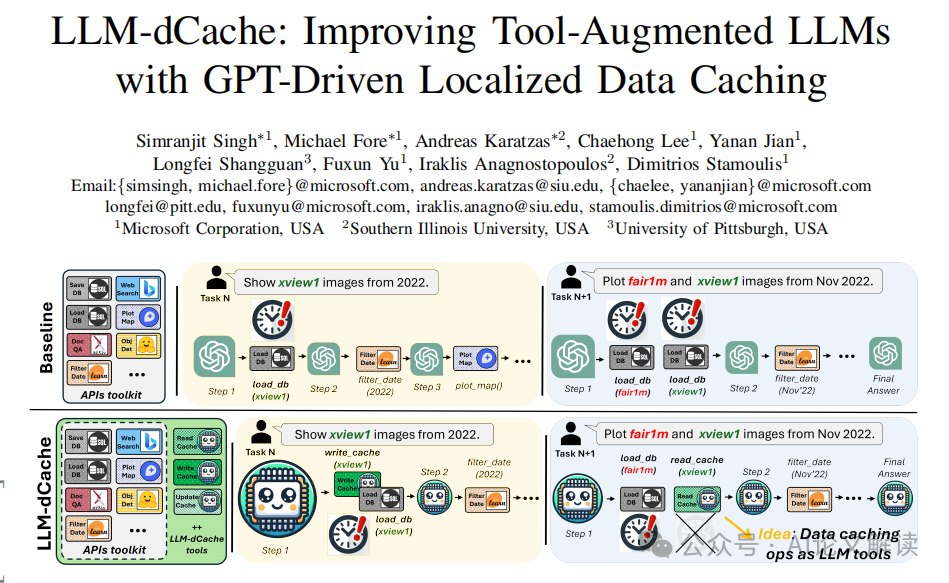

在這項工作中,我們從類似于CPU緩存系統中觀察到的時間和空間可重用性模式中汲取靈感,我們引入了LLM-dCache,一種GPT驅動的緩存策略,用于優化LLM數據訪問模式。我們的關鍵直覺在于一種新穎的設計選擇,其中緩存管理無縫集成為LLM可用的工具之一,實現了與現有的函數調用機制和基線代理兼容的完全GPT驅動的即插即用方法,同時施加最小的開銷。通過在大規模地理空間平臺上的評估,我們證明了我們的方法在不同的GPT和提示技術中實現了LLM延遲的減少。我們希望這些發現能激勵進一步探索賦予LLM其他系統級優化的可能性。

論文標題:LLM-dCache: Improving Tool-Augmented LLMs with GPT-Driven Localized Data Caching

機構:Microsoft Corporation, USA; Southern Illinois University, USA; University of Pittsburgh, USA

論文鏈接:https://arxiv.org/pdf/2406.06799.pdf

LLM-dCache的概念與設計動機

1. 從CPU緩存系統中獲取靈感

LLM-dCache的設計靈感來源于CPU緩存系統,特別是其對時間和空間可重用性模式的利用。在CPU緩存中,頻繁訪問的數據被存儲在快速訪問的硬件中,以減少數據檢索時間和提高處理效率。類似地,LLM-dCache旨在通過緩存經常被重新訪問的數據來優化大型語言模型(LLM)的數據訪問模式,從而減少延遲并提高系統效率。

2. 針對大規模系統的緩存策略

在大規模系統中,如地理空間平臺,數據的重用性顯著,例如在連續的查詢中多次訪問相同的衛星圖像數據。LLM-dCache通過將緩存操作集成為LLM可調用的API工具,使得緩存管理能夠無縫地融入到LLM的操作中。這種設計不僅適應了大規模數據處理的需求,還通過減少對主存儲的訪問需求,顯著提高了任務處理速度。

緩存操作的集成與實現

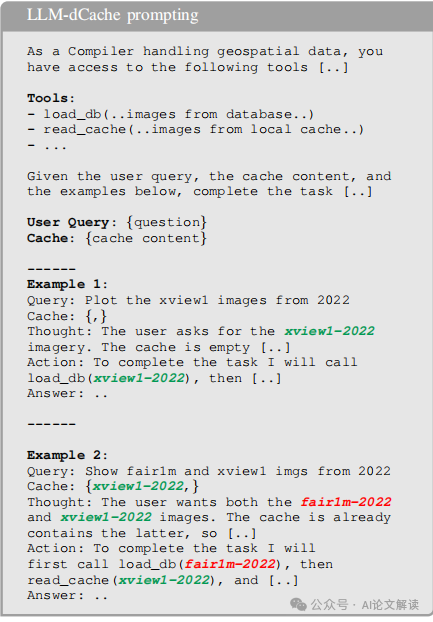

1. 緩存讀取操作

在LLM-dCache中,緩存讀取操作被設計為GPT的一部分決策過程。當LLM接收到用戶查詢時,它會檢查當前的緩存內容,并決定是否執行緩存加載工具。例如,如果用戶請求的數據已經存在于緩存中,則LLM會直接從緩存中讀取數據,而不是重新從數據庫或其他存儲系統加載。

2. 緩存更新策略

LLM-dCache采用最近最少使用(LRU)策略作為主要的緩存更新策略,并通過GPT來動態管理緩存更新。在每輪操作中,GPT根據當前的緩存狀態和新的數據加載操作,決定如何更新緩存。這種策略不僅優化了緩存的使用效率,還減少了因緩存不命中而重新加載數據的需要。

3. GPT工具作為緩存操作的實現

將緩存功能作為GPT工具的一部分,簡化了緩存操作的實現,并使其與平臺無關。這種方法不僅減少了需要進行的更改,還允許LLM自主管理緩存操作,從而在出現緩存未命中時,LLM可以重新評估其工具序列,以實時糾正工具選擇中的不準確性。這種動態適應性是系統優化中的關鍵。

實驗設置與數據集

1. GeoLLM-Engine平臺介紹

GeoLLM-Engine是一個大規模的、可參數化的LLM引擎,專門用于處理地理空間任務。該平臺設計用于捕捉代理性能,配備了長期多工具LLM操作,這些操作需要頻繁地檢索和過濾數據。平臺還集成了一整套開源API、交互式地圖用戶界面、RAG和數據檢索工具,擁有超過110萬張衛星圖像。

2. 數據集的構建與特點

為了測試GeoLLM-Engine的性能,我們擴展了GeoLLM-Engine采樣器以獲取GeoLLM-Engine-1k數據集的變體。通過調整采樣率參數,并加入控制數據重用可能性的參數,我們選擇性地采樣了80%概率需要已在緩存中的數據的提示,構建了一個包含1000個多步驟提示的測試數據集(總共約50000個工具調用)。此外,我們還準備了一個包含500個查詢的小型數據集用于分析。最后,我們使用模型檢查器模塊來驗證生成任務的功能正確性。

實驗結果與分析

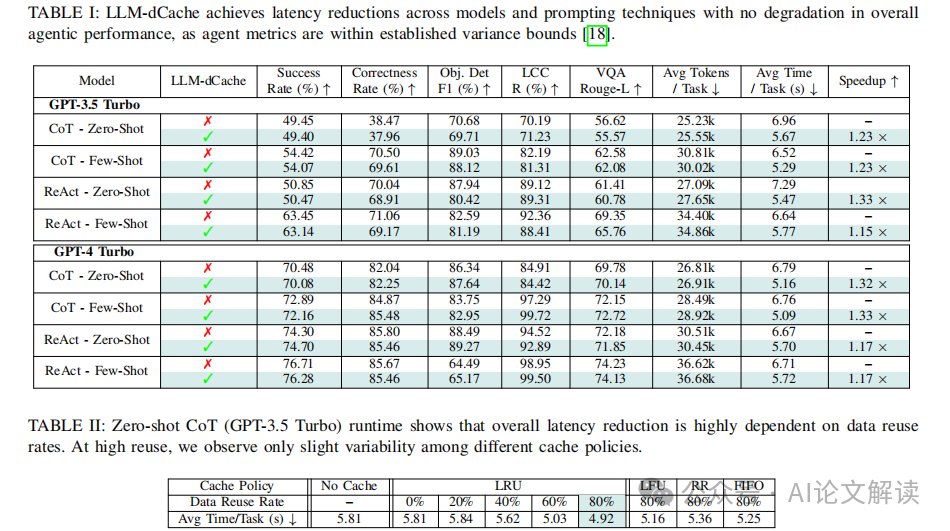

1. 不同配置下的任務完成時間比較

根據實驗結果,LLM-dCache在不同配置下(包括GPT-4和GPT-3.5,以及Chain-of-Thought和ReAct技術,無論是少數樣本還是零樣本場景)平均能夠將任務完成時間提高1.24倍(表I)。這表明緩存策略不會降低輸出質量和代理的功能性,代理指標仍在既定的方差范圍內。

2. 緩存策略的有效性分析

通過對不同的緩存策略(LRU、LFU、RR和FIFO)進行分析,我們發現在數據重用率高的情況下,不同策略之間的延遲差異不明顯(表II頂部)。這表明數據重用模式而非模型選擇或提示策略是影響性能的主要因素。此外,我們還進行了多個小型驗證子集的分析,每個子集包含500個查詢,但具有不同的重用率,結果顯示更高的重用率與更大的延遲節省相關。

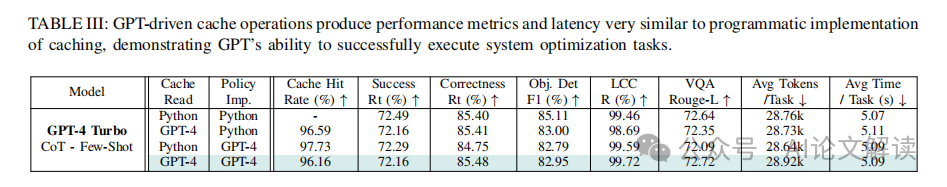

通過將緩存操作作為GPT工具進行提示,我們的實驗顯示,GPT驅動的緩存操作在性能指標和延遲方面與程序化緩存操作非常接近,這證明了GPT成功執行系統優化任務的能力(表III)。這種方法展示了LLM在傳統程序化解決方案之外,指導緩存管理的多功能性和潛力。

討論:GPT驅動的緩存操作與傳統編程實現的比較

1. GPT驅動的緩存操作

GPT驅動的緩存操作,如LLM-dCache所示,通過將緩存操作作為可調用的API工具暴露給GPT,使其能夠動態地讀取和更新緩存數據以響應用戶查詢。這種方法允許GPT在上下文提示的幫助下自主管理緩存操作,例如通過提示解釋LRU方案。這種集成方式使得緩存讀取和更新操作成為GPT的決策過程的一部分,從而只需很少的更改。此外,賦予LLM對緩存決策的自主權還能夠處理緩存未命中的情況:在功能調用失敗時,LLM會被提示重新評估其工具序列,就像處理任何其他工具選擇失誤一樣。

2. 傳統編程實現的緩存操作

傳統的編程實現緩存操作通常涉及直接在代碼中硬編碼緩存邏輯,如使用特定的緩存更新策略(LRU、LFU等)和緩存大小限制。這種方法在效率和可靠性方面可以達到很高的標準,因為它直接控制了所有的底層操作,但它缺乏靈活性,并且通常需要針對每個應用程序或系統進行定制。

3. 性能比較

根據研究,GPT驅動的緩存操作與傳統編程實現的緩存操作在性能指標和延遲方面非常相似,表明GPT能夠成功執行系統優化任務。例如,GPT驅動的變體在緩存“命中率”和延遲方面與完全編程方法相匹配,后者可以被視為效果和可靠性的上限。

限制與未來工作:擴展到更多系統級優化和其他計算環境

1. 限制

當前的研究主要集中在云優先環境中的代理性能和平均延遲上,這涉及到大量使用云端點。雖然這為系統性能提供了一定的基準,但它限制了在不依賴云基礎設施的環境中的應用廣泛性。此外,目前的實現主要關注地理空間數據,這可能限制了其在其他類型的數據密集型任務中的應用。

2. 未來工作

為了克服這些限制并進一步提升系統級優化的能力,未來的工作將探索將GPT驅動的緩存操作擴展到其他計算環境,如本地執行設備,這可能包括使用能夠在本地運行的GPT替代品,如Llama-3和Phi-3.5。此外,計劃將評估擴展到更廣泛的任務范圍,包括那些在最近的系統級LLM優化論文中考慮的正交任務。

通過這些努力,希望能夠進一步利用LLM進行系統級優化,以提高復雜數據密集型環境中的系統效率。

總結:LLM-dCache的貢獻與系統級優化的潛力

在大型語言模型(LLM)的發展中,LLM-dCache的引入標志著一個重要的進步,它通過緩存機制優化了數據訪問模式,顯著提升了系統效率。本章節將總結LLM-dCache的主要貢獻,并探討其在系統級優化中的潛力。

1. LLM-dCache的核心貢獻

LLM-dCache通過將緩存操作作為可調用的API工具集成到LLM中,使得大型語言模型能夠自主管理緩存操作。這種設計不僅減少了對傳統程序邏輯的依賴,還提高了緩存管理的靈活性和效率。例如,在處理地理空間數據時,LLM-dCache能夠根據數據的重用模式動態調整緩存內容,從而減少了數據加載時間并提高了任務完成速度。

2. 系統級優化的實現

通過將緩存操作嵌入到LLM的決策過程中,LLM-dCache有效地將系統優化的決策權下放給了語言模型本身。這一策略不僅簡化了系統設計,還提高了操作的靈活性。在實際應用中,這意味著LLM可以根據當前的任務需求和數據狀態,自主決定何時讀取或更新緩存,從而優化整體的系統性能。

3. 提升任務處理速度和準確性

在多個測試場景中,LLM-dCache顯示出了顯著的性能提升。例如,在地理空間平臺上的評估顯示,通過使用LLM-dCache,任務完成時間平均縮短了1.24倍。此外,緩存策略的優化還確保了在不同的模型和提示技術中,輸出的質量和功能性不受影響。

4. 對未來系統級優化的啟示

LLM-dCache的成功實施為未來的系統級優化提供了新的思路。通過進一步探索和擴展這種以LLM為中心的優化策略,我們可以將其應用于更廣泛的任務和環境中,如動態電壓頻率調整(DVFS)、核心分配和熱管理等。此外,這種策略的推廣還可能促進其他非GPT工具增強型代理在不同計算環境中的無縫集成。

總之,LLM-dCache不僅提升了大型語言模型在處理復雜數據任務時的效率和靈活性,還展示了利用LLM進行系統級優化的巨大潛力。隨著技術的進一步發展,我們期待看到更多基于LLM的系統優化解決方案的出現。

本文轉載自 ??AI論文解讀??,作者:柏企