3D語言模型的新突破:解鎖虛擬現實中的'幻覺'問題 精華

隨著人工智能技術的飛速發展,3D語言模型(3D-LLMs)已成為研究的熱點,它們在理解和生成語言指令方面展現出了巨大的潛力。這些模型不僅能夠處理文本信息,還能理解和操作三維空間中的物體,這對于發展能夠與物理世界互動的智能系統至關重要。

3D語言模型的核心在于其能夠將語言與三維場景緊密結合。傳統的大型語言模型(LLMs)如GPT和BERT等已經在文本處理方面取得了顯著成就,但它們主要處理的是二維圖像和文本數據。而3D-LLMs則是在此基礎上的進一步擴展,它們能夠處理和理解三維點云數據,從而在空間理解和物體操作方面提供更為豐富的信息。

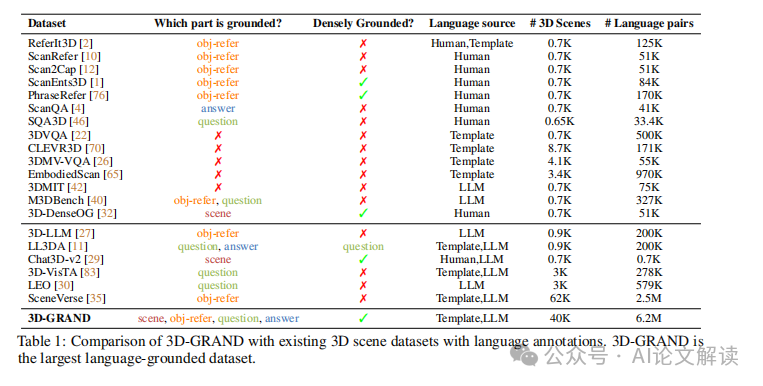

然而,3D-LLMs的發展仍面臨一些挑戰,尤其是在數據集的構建和模型訓練方面。目前,與二維圖像和文本配對的數據集已經非常豐富,但專門針對三維場景和語言指令的大規模數據集還相對較少。這限制了模型在理解復雜三維環境中的能力。

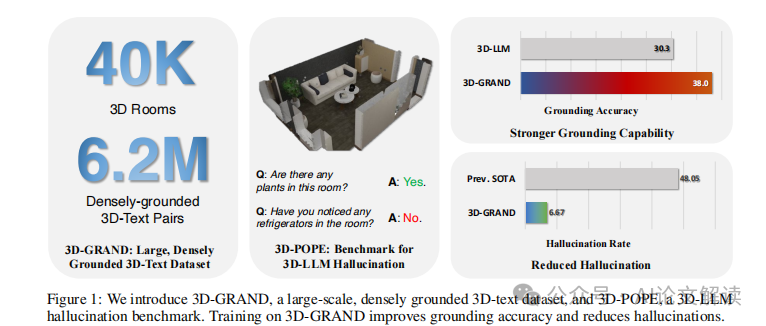

為了解決這一問題,研究人員開發了3D-GRAND數據集,這是一個創新的大規模數據集,包含了超過40,000個家庭場景和620萬個與場景密切相關的語言指令。這一數據集的推出,極大地推動了3D-LLMs在空間理解和語言生成方面的研究,使模型能夠更好地理解和描述復雜的三維環境。

此外,為了系統評估3D-LLMs在處理虛構對象(即“幻覺”問題)方面的表現,研究人員還提出了3D-POPE基準測試。這一測試旨在通過一系列的評估任務,檢測模型在確認三維場景中對象存在與否方面的準確性。

通過這些先進的數據集和評估工具,3D語言模型正在逐步克服早期的限制,展現出在多種實際應用中的巨大潛力,例如在機器人技術、虛擬現實和自動化系統中的應用。這些研究不僅推動了人工智能技術的發展,也為我們提供了一個全新的視角,來理解和創造與三維世界互動的智能系統。

3D-GRAND數據集的創新與重要性

1. 數據集規模與密集地面實體關聯

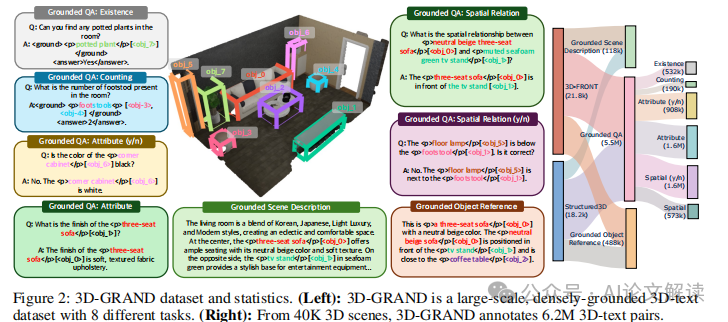

3D-GRAND數據集是一個開創性的大規模數據集,包含40,087個家庭場景和6.2百萬個與場景密切相關的語言指令。這種密集的短語到對象的地面實體關聯是此數據集的一大特色,它極大地豐富了3D語言模型的訓練材料,使得模型在理解和生成與3D環境相關的語言時更為準確和自然。

2. 提高模型性能與減少幻覺

通過在3D-GRAND上進行指令調整訓練,顯著提高了3D語言模型的地面實體關聯能力,并有效減少了模型在生成語言時的幻覺現象。這一點在模型訓練和評估中表現尤為突出,通過系統的實驗驗證,使用3D-GRAND數據集訓練的模型在多個基準測試中都顯示出優越的性能。

3. 支持多樣化的語言任務

3D-GRAND不僅僅支持基本的對象引用任務,還包括空間推理、場景理解等復雜的語言任務。這種多樣化的任務支持使得3D-GRAND能夠更全面地評估和訓練3D語言模型,推動模型在更廣泛的應用場景中的部署和使用。

4. 高質量的注釋和可擴展性

3D-GRAND的語言注釋經過嚴格的人工評估,確保了數據的高質量和多樣性。此外,該數據集的設計考慮到了未來的可擴展性,支持從仿真數據到真實世界數據的轉換,這為使用合成數據進行3D文本理解提供了新的可能性。

5. 早期信號顯示有效的仿真到現實的轉換

初步結果表明,通過在3D-GRAND上訓練的模型能夠有效地轉移到真實世界的3D掃描數據上,這為未來低成本、可持續的3D數據擴展提供了有力的早期信號。

總之,3D-GRAND數據集的引入不僅解決了現有3D語言模型訓練數據不足的問題,還通過提供大規模、高質量和密集地面實體關聯的數據,極大地推動了3D語言模型在理解和交互3D環境方面的研究和應用。

3D-POPE基準測試:評估3D語言模型的幻覺行為

在3D語言模型(3D-LLMs)的研究和應用中,一個重要的挑戰是如何準確地識別和處理模型在處理3D場景時可能出現的“幻覺”行為,即模型錯誤地識別或生成不存在的對象。為了系統地評估這一行為,我們引入了一個全新的基準測試——3D-POPE(3D Polling-based Object Probing Evaluation)。

1. 3D-POPE基準測試的設計

3D-POPE旨在通過一系列標準化的測試來評估3D-LLMs在3D場景中對對象存在性的判斷能力。這些測試包括向模型提出關于場景中某個對象是否存在的問題,并根據模型的是或否回答來評估其性能。

為了構建這一基準測試,我們從ScanNet數據集中挑選了一組場景,并使用ScanNet200的語義類別來定義測試對象。我們特別關注模型對于對象存在性的判斷能力,因此設計了一系列包含存在和不存在對象的問題,以確保測試的全面性和平衡性。

2. 采樣策略

在構建3D-POPE測試集時,我們采用了三種不同的采樣策略來選擇負樣本(即不存在的對象):

- 對抗性采樣:對于場景中已確認存在的每一個對象,我們選擇與之共現頻率最高的不存在對象作為對抗樣本。這種方法有助于測試模型在復雜場景中的魯棒性。

這些策略的設計旨在挑戰模型的魯棒性,評估其在不同級別的對象幻覺情況下的表現。

3. 性能評估指標

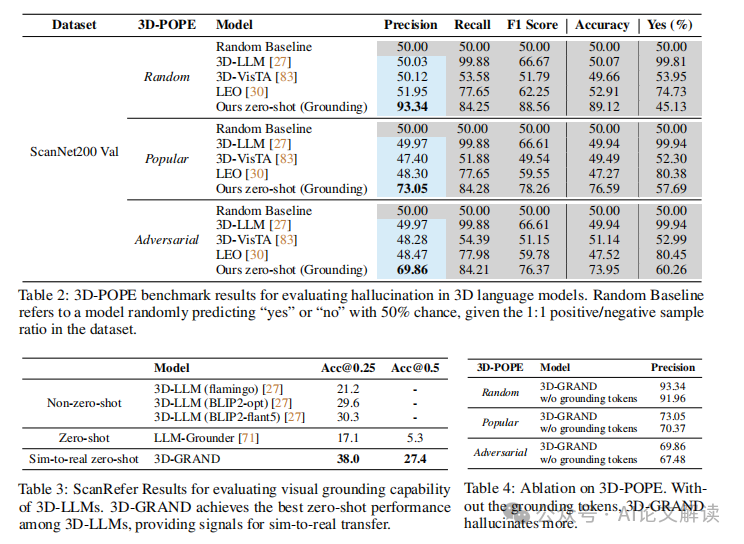

我們使用幾個關鍵指標來評估3D-LLMs在3D-POPE基準測試上的表現,包括精確度(Precision)、召回率(Recall)、F1分數、準確率(Accuracy)以及錯誤肯定率(Yes %)。這些指標綜合反映了模型在確認對象存在性方面的能力和可靠性。

4. 公開排行榜

為了促進研究社區的公平比較和合作,我們設立了一個公開的3D-POPE排行榜,研究人員可以提交他們的3D-LLM結果,并與其他最先進模型進行比較。排行榜將根據上述評估指標顯示每個模型的性能,為研究人員提供一個透明和標準化的評估平臺。

通過3D-POPE基準測試,我們希望能夠深入了解3D-LLMs在處理復雜3D場景時的對象幻覺問題,為未來研究提供指導,并推動更可靠和準確的3D語言模型的發展。

實驗設計與結果分析

1. 實驗設計

在本研究中,我們引入了一個全新的大規模數據集3D-GRAND,專為3D環境中的語言指令調整而設計。該數據集包含40,087個家庭場景,與6.2百萬個密集地與場景語言指令相結合。為了評估3D語言模型(3D-LLMs)在處理這些數據時的表現,我們設計了一系列實驗,旨在測試模型在不同數據規模下的性能,并探索模型訓練的有效性。

我們還引入了一個新的基準測試3D-POPE(3D Polling-based Object Probing Evaluation),用于系統地評估3D-LLMs在對象幻覺方面的表現。這一基準測試通過提出存在性問題來評估模型的回答,從而檢測模型是否會產生幻覺——即錯誤地認為某個不存在的對象存在于場景中。

2. 結果分析

2.1 3D-GRAND數據集的影響

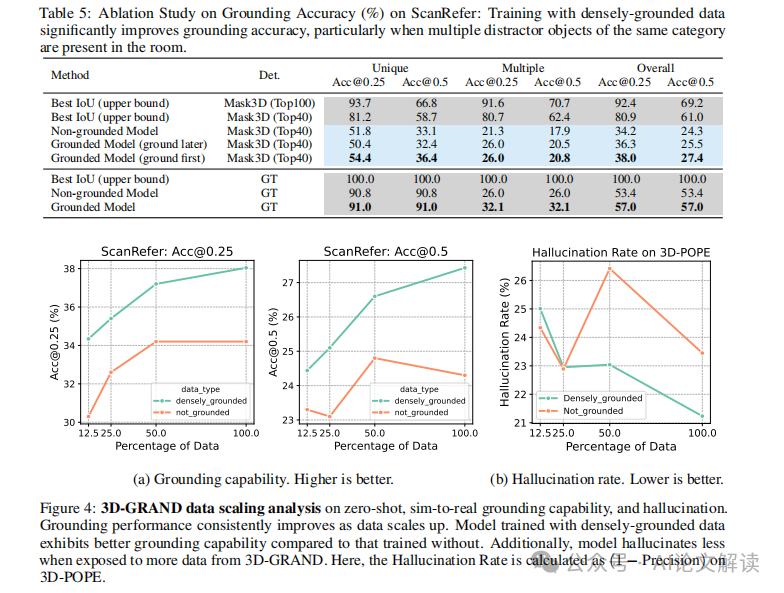

使用3D-GRAND進行訓練的結果顯示,該數據集顯著提高了3D-LLMs的地面真實性(grounding)能力,并有效減少了幻覺現象。具體來說,模型在3D-POPE基準測試中的表現優于所有基線模型,尤其是在隨機抽樣策略下,模型展示了93.34%的精確度和89.12%的準確率。這一結果強調了密集地面數據對于提高模型性能的重要性。

2.2 3D-POPE基準測試

在3D-POPE基準測試中,我們采用了多種抽樣策略來評估模型對于不存在對象的識別能力。結果表明,盡管在更具挑戰性的抽樣設置(如流行和對抗樣本)中表現存在下降,3D-GRAND模型仍然能夠維持較高的性能,顯示出其魯棒性。

2.3 數據規模與模型性能的關系

我們的實驗還揭示了數據規模與模型性能之間的正相關關系。隨著訓練數據的增加,模型在真實世界3D掃描數據上的表現也隨之提高,這為使用合成3D場景數據進行訓練提供了一種可行的策略,可能會在未來降低成本并提高模型的可訪問性和擴展性。

3. 模擬到真實的轉換

我們的研究結果提供了模擬到真實轉換的初步信號,表明在大規模合成數據上訓練的模型能夠有效地遷移到真實世界的3D掃描中。這一發現對于未來3D-LLMs的應用和發展具有重要意義,可能會推動3D視覺語言模型在更廣泛的實際應用中的部署。

通過這些實驗和分析,我們不僅驗證了3D-GRAND數據集的有效性,也展示了大規模、密集地面數據在提升3D語言模型性能中的關鍵作用。我們相信這些發現將為未來的研究提供寶貴的指導,并推動3D-LLMs在各種實際應用中的進一步發展。

模型的消融研究與深入分析

在深入分析和消融研究中,我們關注的核心是評估3D-LLMs在處理3D場景時的性能,尤其是在減少幻覺(hallucination)和增強語言與3D場景的對應(grounding)方面的能力。通過對3D-GRAND數據集的使用,我們能夠系統地評估模型在這些關鍵任務上的表現。

1. 消融研究的設計與實施

消融研究的目的是通過系統地移除或修改模型的某些部分,來理解這些部分對模型性能的具體影響。在我們的研究中,特別關注了以下幾個方面:

- 數據密集度的影響:我們比較了在不同密集度的數據訓練下,3D-LLMs的性能變化。結果表明,使用密集標注的數據(如3D-GRAND)可以顯著提高模型的地面真實性(ground truth fidelity)和減少幻覺現象。

- 輸入數據的變化:通過改變輸入數據的類型(如只使用文本指令而不是結合3D場景信息),我們評估了3D場景理解對模型性能的影響。

- 模型結構的變化:我們嘗試了不同的模型架構,包括更改層的深度和寬度,以及引入或去除特定的功能模塊,如對象檢測器和語義分割器。

2. 深入分析的關鍵發現

通過消融研究,我們得到了一些關鍵的發現,這些發現幫助我們更好地理解3D-LLMs在處理3D語言任務時的行為:

- 數據密集度對性能的顯著影響:在3D-GRAND這樣的大規模、密集標注的數據集上訓練的模型,在減少幻覺和提高語言地面真實性方面表現更好。這強調了高質量、密集標注數據在訓練有效的3D-LLMs中的重要性。

- 模型對3D場景信息的依賴性:輸入數據中包含的3D場景信息對模型的性能至關重要。模型在沒有3D場景信息的情況下性能顯著下降,這表明了3D信息在理解和生成與場景相關的語言中的核心作用。

- 模型結構的優化:通過調整模型結構,我們發現某些結構變化(如增加層的深度)可以改善模型的細節理解能力,而其他變化(如去除語義分割器)則可能導致性能下降。

這些發現不僅增強了我們對3D-LLMs行為的理解,也為未來研究提供了 valuable insights,特別是在設計更高效和準確的模型結構以及創建更有效的訓練數據集方面。

結論與未來展望

在本研究中,我們介紹了3D-GRAND和3D-POPE兩個創新的資源,它們為3D語言模型(3D-LLMs)的發展提供了重要的支持。通過這些資源,我們不僅顯著提高了模型在理解和生成與3D場景密切相關的語言指令的能力,還有效減少了模型在生成過程中的幻覺現象。

1. 主要成果

我們的研究首次在大規模的數據集上實現了3D場景與語言指令的密集配對,這在之前的研究中是未曾有過的。3D-GRAND數據集包含超過40,000個家庭場景和620萬條語言指令,這些指令與場景中的具體對象緊密相關聯。使用這一數據集進行訓練的3D-LLMs在減少幻覺和提高語言地面真實性(grounding)方面表現出色。

此外,我們還開發了3D-POPE基準測試,這是一個系統評估3D-LLMs在對象幻覺方面表現的工具。通過這一基準測試,我們可以更公平、更系統地比較不同模型的性能,并進一步理解模型在處理復雜3D場景時的行為。

2. 未來的研究方向

盡管我們取得了一定的進展,但在3D-LLMs的研究領域,仍有許多問題需要解決。首先,盡管3D-GRAND數據集的規模已經很大,但與現實世界的復雜多變相比,它仍然有限。未來的工作可以探索如何進一步擴展這種類型的數據集,包括更多種類的3D場景和更復雜的語言指令。

其次,從模擬數據到真實世界數據的遷移仍是一個挑戰。雖然我們的模型在模擬數據上表現良好,但如何確保這些模型在現實世界中同樣有效仍需進一步研究。這可能涉及到新的模型架構或是更精細的訓練策略。

最后,隨著技術的發展,我們預見到3D-LLMs將在更多實際應用中發揮作用,如自動駕駛、機器人導航等領域。因此,如何將這些模型有效地集成到具體的應用場景中,也是未來研究的一個重要方向。

通過3D-GRAND和3D-POPE,我們為3D-LLMs的研究和應用提供了堅實的基礎。我們期待未來的研究能在此基礎上,繼續推動3D理解和交互技術的邊界,最終實現更智能、更自主的機器人和虛擬代理人。

標題: 3D-GRAND: Towards Better Grounding and Less Hallucination for 3D-LLMs

作者: Jianing Yang, Xuweiyi Chen, Nikhil Madaan, Madhavan Iyengar, Shengyi Qian, David F. Fouhey, Joyce Chai

機構: University of Michigan, New York University

鏈接: https://3d-grand.github.io/