清華大學最新發布:統一時序預測模型,上下文長度首次擴展至千級別,適用各類數據集

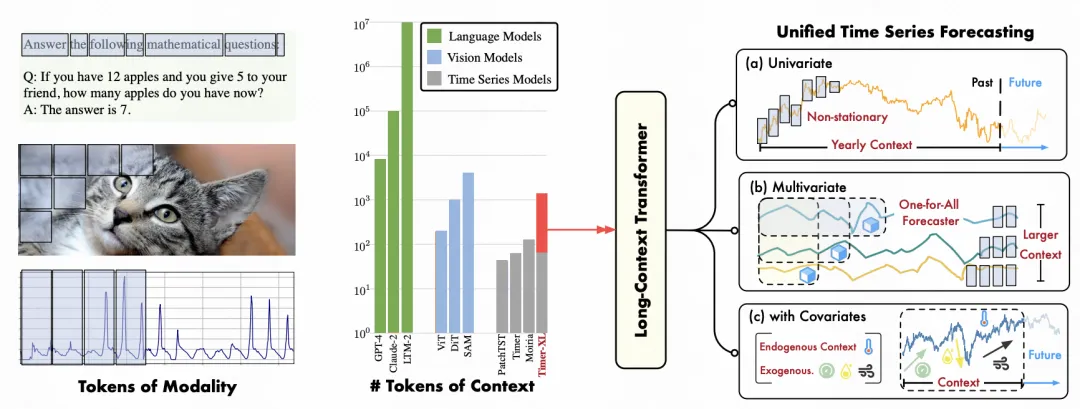

今天給大家介紹一篇清華大學的時間序列預測最新工作,提出了統一的Transformer時序預測模型,能同時處理單變量和多變量時序預測,并將時序預測的上下文長度首次擴充到千級別。

論文標題:TIMER-XL: LONG-CONTEXT TRANSFORMERS FOR UNIFIED TIME SERIES FORECASTING

下載地址:??https://arxiv.org/pdf/2410.04803v1??

1.背景

構建類似NLP領域的統一大模型是時序預測領域近期研究的焦點。雖然前序已經涌現很多工作,但是這些建模方法只能處理最多幾百長度的上下文序列,比如根據歷史200個數據點預測未來時刻的序列值。而NLP中的建模可以利用千級別甚至萬級別的上下文信息。歷史序列長度的不足,導致時序預測模型無法根據完整的、長周期的歷史信息進行預測,影響了預測效果。

為了解決上述問題,本文構建了基于Decoder-only Transformer模型的統一時間序列預測模型Timer-XL,可以同時處理單變量和多變量的時序預測,并同時建模變量間關系,對比其他SOTA模型實現了效果提升。

2.Next Token Prediction任務

類似NLP中的語言模型,Timer-XL使用了Next Token Prediction任務進行模型訓練。在語言模型中,Next Token Prediction任務的目標是根據前面的token,預測下一個token是什么。在時間序列中,Time-XL將token定義為一個窗口內的時間序列,也就是一個patch作為一個token。優化的目標就變成了預測下一個patch的時間序列,以MSE為目標進行擬合。

上述方式只適用于單變量時間序列。為了擴展到多變量時間序列,Timer-XL采用了多元Next Token Prediction的建模方式。整體可以理解為,每個變量仍然獨立的預測下一個token,但是會根據所有變量的歷史序列來預測各個變量的下一個token,公式可以表示為如下形式:

通過這種多變量Next Token Prediction的擴展,模型可以同時建模序列關系和變量間關系,實現了從1D建模到2D建模的擴展。

3.模型結構

Timer-XL整體基于Transformer Decoder的模型結構,位置編碼采用目前主流語言模型使用較多的RoPE。

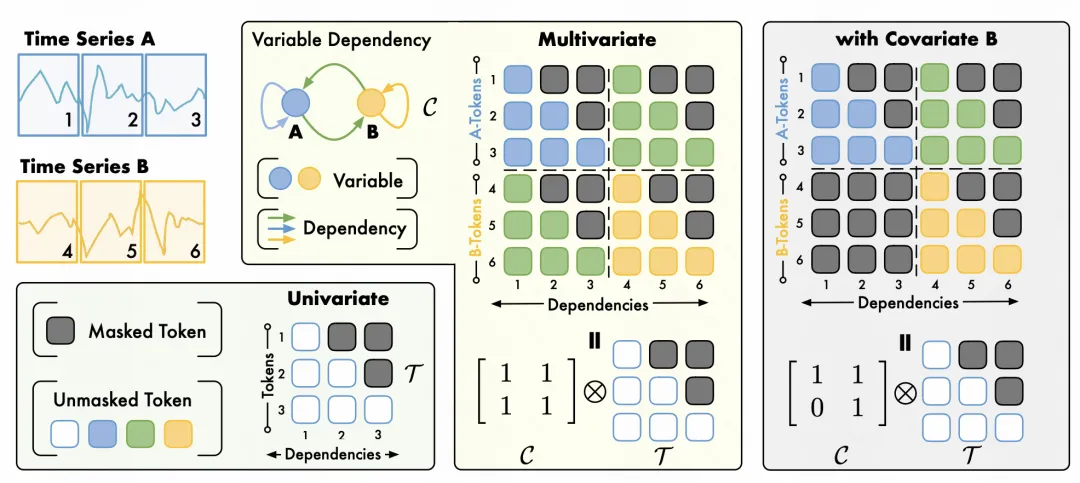

其中一個核心問題是,引入多元Next Token Prediction任務后,如何構建attention。文中提出了TimeAttention模塊,其基本思路也很簡單,在預測每一個變量的值時,通過attention mask的方式讓其只和各個變量該時刻之前的值進行attention。比如下圖中預測A序列的第3個token的值,會和A、B的第一個時刻、第二個時刻的tokne計算attention。

此外,這種attention mask的方式也可以靈活引入變量間關系的建模。比如可以根據兩個變量之間是否相互依賴,修改整個attention mask的構造方式,融合時間(序列)和空間(變量間)的關系。

4.實驗效果

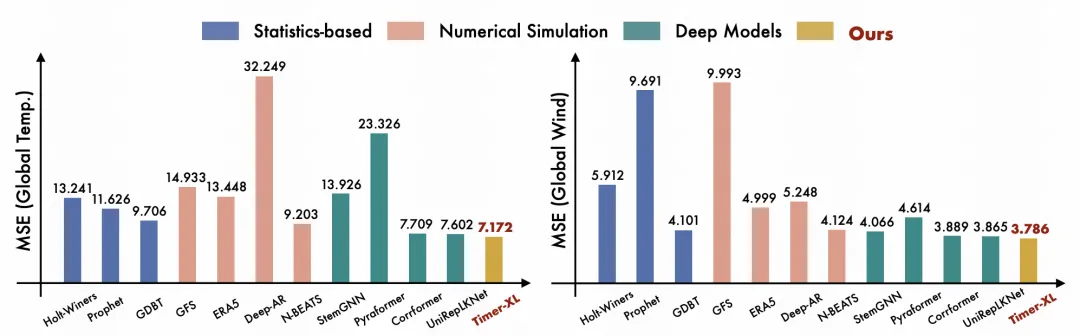

在實驗部分,文中對比了和各類時序預測模型,包括統計模型、深度模型等SOTA方法的效果,本文的整體MSE都取得了較明顯的下降。

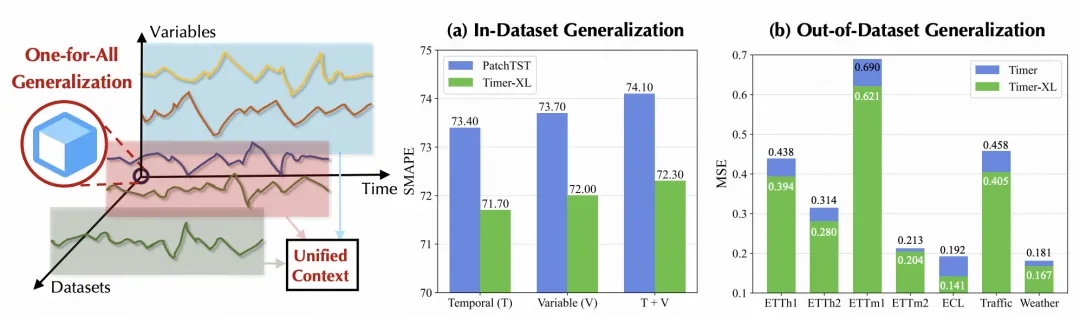

實驗部分也重點論證了Timer-XL的通用性,一個模型可以用于各類數據集,包括在訓練數據內的數據集,以及非訓練數據的數據集,有較強的泛化性。

本文轉載自 ??圓圓的算法筆記??,作者: Fareise