完全在頻域學習的時序預測模塊,提升各類SOTA模型效果

今天給大家介紹一篇浙大、中南、南洋理工、上交、北大等多所高校聯合提出的一種時間序列預測建模方法,針對目前時序預測直接預測方法沒有考慮到預測各個時間步關系的問題,提出了在頻域中進行預測的方法,可適配到各類時序SOTA模型中,取得了長短周期時序預測的效果提升。

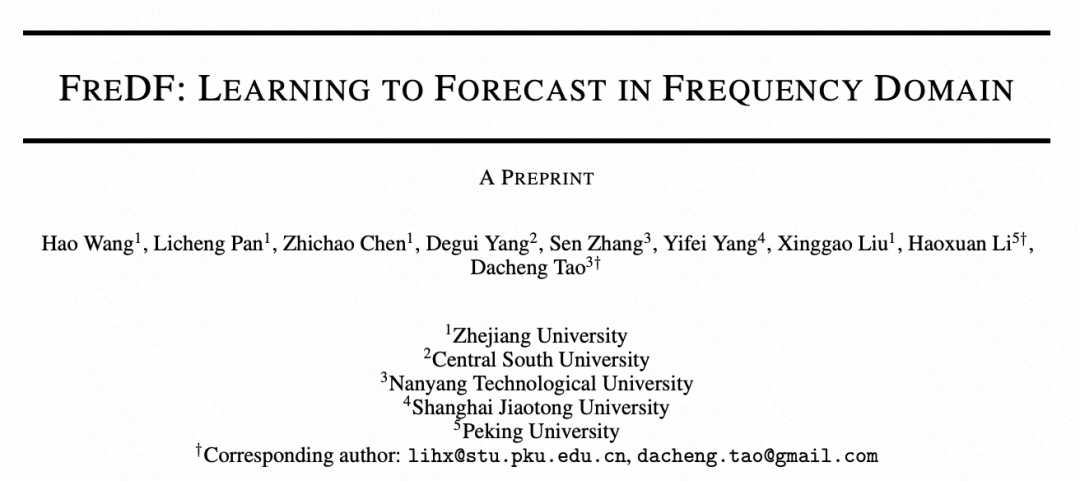

論文標題:FREDF: LEARNING TO FORECAST IN FREQUENCY DOMAIN

下載地址:??https://arxiv.org/pdf/2402.02399??

開源代碼:??https://github.com/Master-PLC/FreDF??

1.背景

在天氣預報、工業維護等領域,準確的時序預測可以幫助我們做出更好的決策和規劃。時間序列數據的自相關性——即不同時間點數據之間的相關性——為預測帶來了獨特的挑戰。這種自相關性既存在于多步輸入序列中,也存在于多步預測的標簽序列中。

現有的時間序列預測方法主要關注輸入序列中的自相關性。為了建模自相關性,各種模型結構(如RNN、CNN、GNN等)被相繼提出。但大多數方法卻忽略了一個關鍵方面:預測標簽之間的自相關性:這種相關關系難以通過設計模型結構來建模,需要對預測范式進行特別設計。

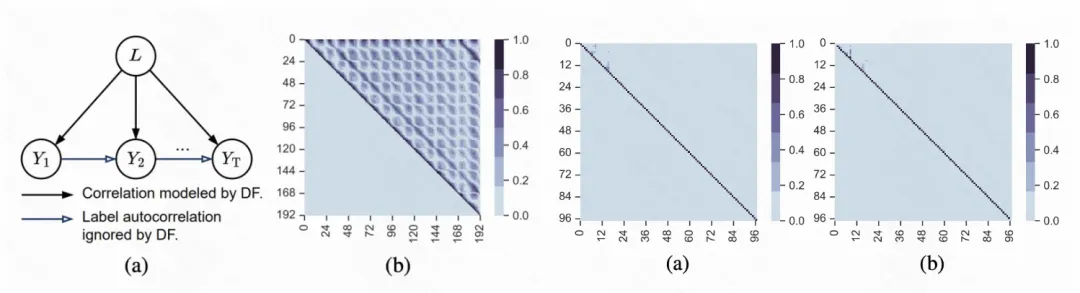

特別是,時下流行的直接預測方法(Direct Forecast,DF),通過多任務方式一次性預測多步,以避免誤差累積,從而提升建模精度。然而本文證明:DF假設標簽序列在給定輸入序列的條件下是條件獨立的,從而忽略了標簽序列中的自相關性。

為了繞開標簽序列在時域中的自相關性,本文提出將其投影到“自相關不顯著”的視圖中,再用DF對投影值做模型訓練和預測。例如,把標簽序列投影到頻域:,其中 是不同頻率上的頻譜分量。與時域中的自相關 不同,在頻域中,頻點1的頻譜分量對頻點2的頻譜分量沒有直接影響,從而對標簽自相關性的影響進行了抑制。

※和現有FFT-based工作的區別:在時間序列預測領域,已經有了較多基于頻域學習的工作,例如AutoFormer、FedFormer、FreTS等。這些方法主要是通過設計模型結構處理輸入序列中的自相關性。相對地,FreDF使用頻域變換優化預測范式,處理標簽序列中的自相關性(LA);不涉及改變模型結構以處理輸入序列中的自相關性。

2.標簽序列中的自相關性

LA在時域的顯著性:在時間序列的生成過程中,當前時刻的預測不僅與歷史數據有關,更與上一時刻的狀態有關。也就是說:在給定歷史數據后,不同時間步之間的標簽也應該存在相關性(如藍色箭頭表示)。為驗證這一假說,使用DoubleML方法量化給定歷史數據后預測時間步之間的因果關系強度,結果說明:LA在真實數據中是非常顯著的。

現有直接預測范式忽略了對LA的建模:直接預測(Direct Forecast,DF)范式使用一個多輸出頭同時預測未來多個時間步的標簽值。然而,DF只是復用了一般的多任務學習方法,沒有考量標簽之間的依存關系(LA)。特別是,即使標簽之間沒有關聯,也可以使用上述損失函數訓練一個多任務模型。在訓練模型時,DF試圖最小化預測標簽序列與真實標簽序列之間的誤差;這假設了標簽序列在不同時間步之間是條件獨立的,從而忽略了標簽序列內部各時間步之間的相關性(LA)。

LA在頻域的顯著性得到抑制:為了處理LA,是不是可以對標簽序列進行一定的變換,使得變換后序列的相關性得到抑制呢?對序列來說,一個很自然的方法是傅里葉變換,將序列用時域轉換到頻域為驗證這一假說,圖1(c-d)量化了給定歷史數據后頻域點之間的因果關系強度,發現不同頻點上的頻譜分量基本沒有相關性。所以,將標簽序列變換到頻域可以有效抑制LA。

論文中進一步提供了在3個額外真實數據的驗證,實驗結果均展現出類似性質。

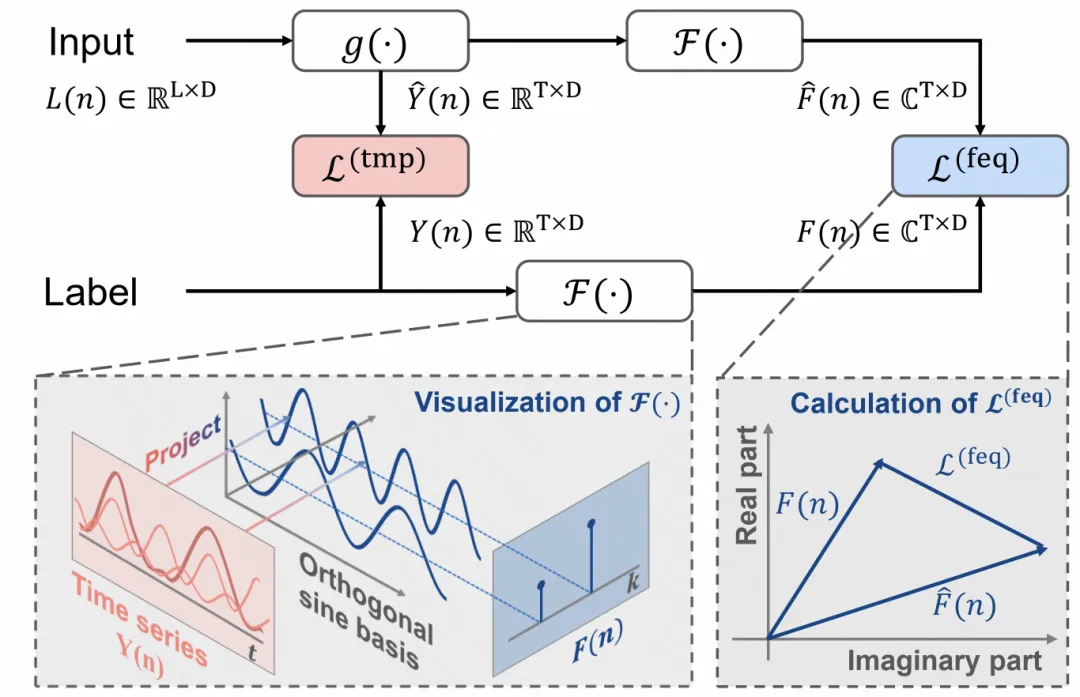

3.FreDF模型結構

FreDF 的核心思想是將預測任務從時域轉換到頻域。之前的驗證表明,標簽序列變換到頻域后LA不顯著,因此適配DF的條件獨立性假設,所以可以使用多任務方法直接預測多個頻點的頻譜分量。這種方法避免了自相關性對模型的影響,且繞開了顯式建模自相關性的復雜性。

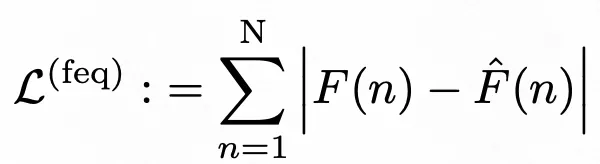

具體的實現方法如下。文中使用傅里葉變換將標簽序列和預測序列都從時域轉換到頻域。這里和其他頻域信息引入工作的區別在于,其他工作一般是將輸入轉換到頻域,但最后還是在時域中預測。本文則是完全將數據轉換到頻域,預測也是在頻域中進行預測的,損失函數也定義在頻域中。頻域損失函數如下:

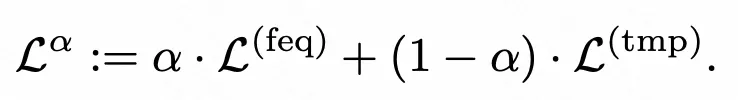

最終損失函數由時域和頻域損失函數融合得到:

FreDF 方法不依賴于特定的預測模型或變換方法。它可以與現有的多種預測模型(Transformer、MLP)和變換方法(如用Chebyshev、Legendre變換代替FFT等)結合使用,從而提高了方法的適用性和靈活性。

4.實驗效果

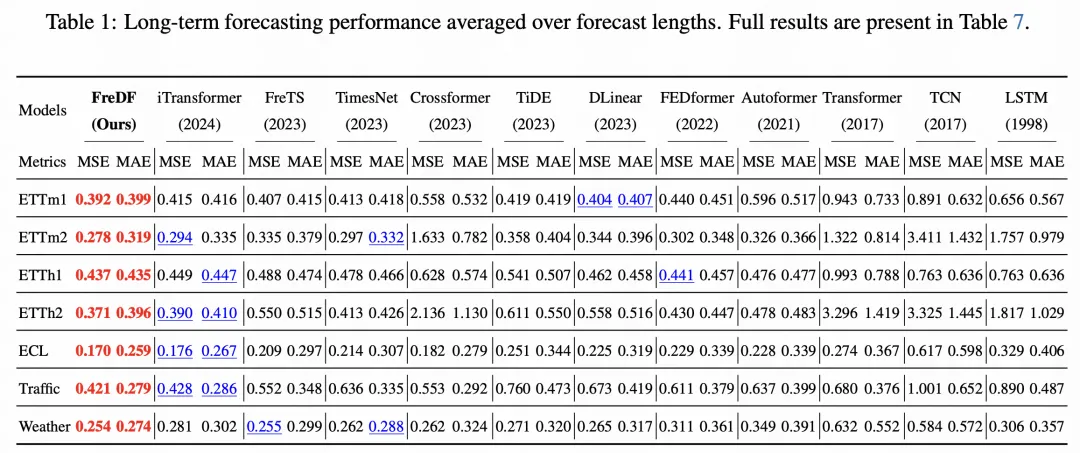

文中在長期和短期時間序列預測上均進行了實驗驗證。FreDF可以顯著提高預測性能。以ETTm1數據集為例,FreDF將iTransformer的MSE降低了0.019,這一改進與過去1.5年中該數據集性能提升可比(Fedformer到TimesNet,MSE降低了0.017)。FreDF這一簡單的改進,可以超越部分設計精巧的模型架構所能帶來的性能提升。在部分數據集上,它將iTransformer的性能提升到了超過了一些原本優于iTransformer的模型:ETT、Weather。

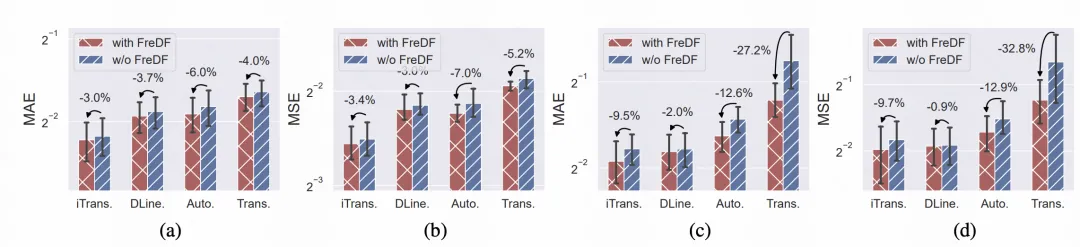

論文還測試了FreDF在不同神經網絡架構上的表現,包括iTransformer、DLinear、Autoformer和Transformer等,以證明其與模型無關的特性:可以切實有效提升大多數主流時序預測模型的精度。

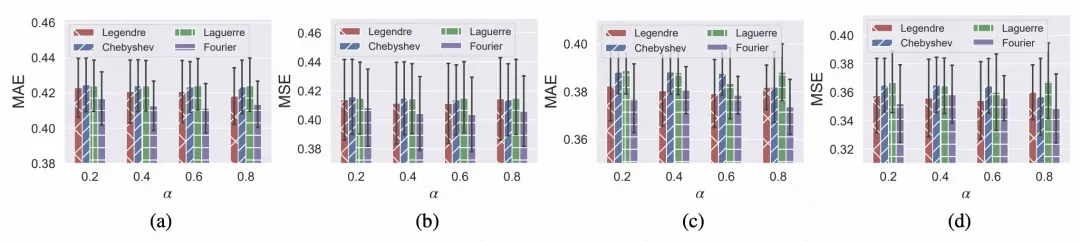

論文進一步測試了FreDF使用不同變換方案的性能表現,包括廣義FFT方法(沿時間維度的1dFFT、沿變量維度的1dFFT、時間-變量維度的2dFFT)和正交基投影方法(勒讓德基、拉蓋爾基、切比雪夫基、傅里葉基),也有一些很有趣的發現和討論;具體請參考論文原文。

本文轉載自 ??圓圓的算法筆記??,作者: Fareise