大模型之嵌入與向量化的區別是什么? 原創

“ 嵌入是更高層次的向量化,是智能化的;而向量化是一種數值轉化的過程,是機械式的 ”

在前面寫了幾篇關于嵌入和向量化的文章,然而在今天才發現之前理解的有偏差,嵌入和向量并不是一個東西,其效果雖然相似但卻并不完全一樣。

嵌入與向量化

先來思考一下向量化和嵌入是同一個東西嗎?如果不是,那他們的區別是什么?

我們都知道向量是大模型的底層數據結構,可以說沒有向量就沒有大模型;因此,在神經網絡中唯一能夠處理的數據格式就只有一種——向量。

但從實際的情況來看,向量只是最終的導向結果;普通數據在轉化為向量之前,存在著不同的情況,雖然最終的目標都是向量,但原因和過程卻不太一樣。

在大模型技術體系中,向量化主要存在以下兩種情況:

- Embedding——嵌入

- 數據向量化

雖然兩種方式都是為了向量化,但其原因是有本質區別的。

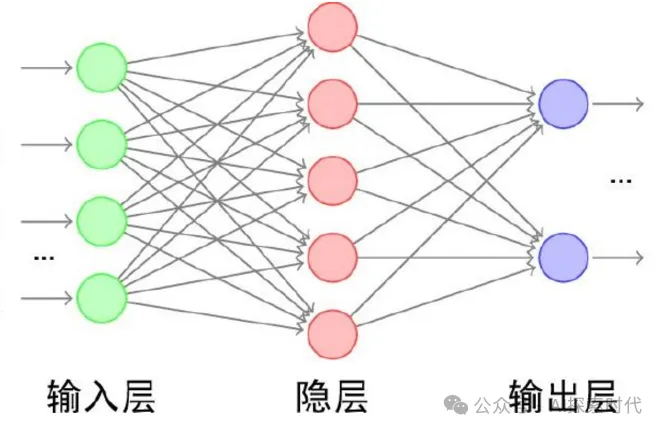

我們知道大模型是由一個輸入層,一個輸出層,以及一個隱藏層(包括多個神經網絡層);而其中比較特殊的兩個層就是輸入層和輸出層。

輸入層的數據并不是由神經網絡通過學習或訓練獲得,而是由外部人為輸入的數據;因此,在輸入層有一個很重要的操作就是把這些人為輸入的數據轉換成向量格式,然后隱藏層才能進行處理。

而這個過程就是向量化的過程,但不知道大家有沒有發現這個向量化的過程有沒有特殊的地方?

首先,在神經網絡輸入層的向量化過程,它只是單純的把輸入數據轉換為向量表示;而其中并沒有去維持輸入數據原本的語義關系。

因為在無監督學習模式下,神經網絡訓練過程需要做的并不是去重建數據之間的語義關系;而是去學習這些數據之間的語義關系。

然后經過訓練之后的模型,才能去理解用戶輸入數據的語義關系,然后再生成新的語義關系。

但是嵌入的過程是一個什么樣的過程?

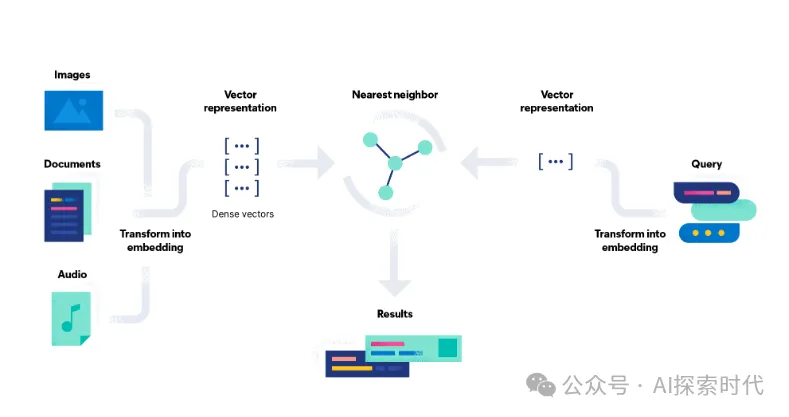

嵌入的本質也是數據向量化的過程,但這里有一個區別就是嵌入需要維護數據之間的語義關系;也就是說經過嵌入之后的數據是具有語義關系的;而不是毫無關系的離散向量。

這也是為什么嵌入的過程需要使用一些經過專門訓練過的嵌入模型,或者其它機器學習模型;而不僅僅只是一個向量化的工具。原因就在于嵌入需要維護其語義關系。

所以,向量化和嵌入都是為了把數據轉換為向量格式;但嵌入的目的是捕獲數據的底層結構或屬性,通常通過訓練算法或模型習得。

“嵌入”強調以有意義和結構化的方式表示數據的概念,而“向量”指的是數值表示形式本身。

??https://www.elastic.co/cn/what-is/vector-embedding#are-embeddings-and-vectors-the-same-thing??

嵌入(Embedding)和向量化(Vectorization)是機器學習和自然語言處理中的兩個重要概念,雖然它們都與將數據表示為向量有關,但在概念、應用和實現上有顯著的區別。

嵌入(Embedding)

定義:

嵌入是一種將高維、稀疏或非結構化數據(如單詞、句子、圖像)轉換為低維、密集向量的方法,同時保留數據的語義或結構信息。

特點:

- 低維稠密表示:嵌入通常將數據從高維稀疏表示(如詞袋模型)映射到低維稠密空間。

- 語義相關性:嵌入向量在低維空間中保留了數據的語義相似性(如詞語間的關系)。

- 通過學習生成:嵌入通常由神經網絡通過優化學習得到,如詞嵌入(word2vec、GloVe)或句嵌入(BERT)。

- 應用領域:

- 自然語言處理(如單詞或句子的語義表示)

- 推薦系統(如用戶或物品的特征表示)

- 圖數據分析(如節點嵌入)

例子:

- 使用word2vec將單詞 "king" 和 "queen" 嵌入為向量,這些向量可以捕捉性別和王室關系。

- 使用BERT將句子嵌入為向量,用于捕捉句子級別的語義信息。

向量化(Vectorization)

定義:

向量化是一種將數據轉換為向量形式的過程,通常用于將非數值數據轉化為數值形式,便于機器學習模型處理。

特點:

- 數值化的操作:向量化主要是將原始數據表示為可以直接輸入模型的數值向量。

- 不一定學習:向量化可以是簡單的規則轉換,而不需要通過訓練得到。

- 可能是高維稀疏向量:向量化的結果不一定是稠密向量,常見的高維稀疏向量化方法包括詞袋模型和TF-IDF。

- 應用領域:

- 特征工程(如將文本、圖像、或其他數據轉化為數值特征)

- 數據預處理(如編碼分類變量)

例子:

- 詞袋模型將句子 "I like apples" 表示為一個詞頻向量:?

?[1, 1, 1, 0, 0, 0]??(假設詞匯表是??[I, like, apples, oranges, bananas, grapes]??)。 - 使用TF-IDF表示文檔特征。

核心區別

維度 | 嵌入(Embedding) | 向量化(Vectorization) |

目的 | 學習低維稠密語義表示 | 將數據轉換為數值向量,可能稀疏,也可能稠密 |

是否需要學習 | 需要(通常通過神經網絡或優化算法學習) | 不需要(可以基于規則或統計方法生成) |

語義表示能力 | 保留語義關系和相似性 | 可能不保留語義,僅是特征的機械化表示 |

典型方法 | word2vec、GloVe、BERT、node2vec | 詞袋模型(BoW)、TF-IDF、獨熱編碼(One-hot Encoding) |

結果向量維度 | 通常低維且稠密 | 通常是高維且稀疏 |

總結

- 嵌入更注重語義特征,能夠通過學習捕捉數據之間的深層關系,是一種“智能化”的表示方法。

- 向量化更注重數據表示的直接性,通常是基于規則或統計的“機械化”過程。

兩者可以結合使用。例如,向量化生成初始特征表示,而嵌入通過深度學習進一步優化表示質量。

本文轉載自公眾號AI探索時代 作者:DFires

原文鏈接:??https://mp.weixin.qq.com/s/eisOBrLQb1UL5dLC25HTrA??