AdaBoost分類器完全圖解 原創(chuàng)

本文將通過完整的源碼與圖解方式向你展示AdaBoost算法運行邏輯,并指出其優(yōu)點與不足,還將其與隨機(jī)森林算法進(jìn)行對比分析。

簡介

每個人都會犯錯,即使是機(jī)器學(xué)習(xí)領(lǐng)域最簡單的決策樹也存在這個問題。AdaBoost(自適應(yīng)增強(qiáng))算法不會忽略這些錯誤,而是會做一些不同的事情:它會從這些錯誤中學(xué)習(xí)(或適應(yīng))以變得更好。

與一次生成多棵樹的隨機(jī)森林不同,AdaBoost算法從一棵簡單的樹開始,并識別它錯誤分類的實例。然后,它會構(gòu)建新的樹來修復(fù)這些錯誤,從錯誤中學(xué)習(xí),并在每一步中變得更好。

在本文中,我們將詳細(xì)探討AdaBoost算法是如何進(jìn)行預(yù)測的。我們將會看到AdaBoost算法能夠通過結(jié)合有針對性的弱學(xué)習(xí)器來增強(qiáng)力量,就像將有針對性的鍛煉變成全身力量的鍛煉程序一樣。

作者本人使用Canva Pro創(chuàng)建(針對移動設(shè)備進(jìn)行了優(yōu)化;在桌面PC上可能顯得過大)。

定義

AdaBoost算法是一種集成機(jī)器學(xué)習(xí)模型,它能夠創(chuàng)建一系列加權(quán)決策樹,通常使用淺樹(通常只是單層“樹樁”)來實現(xiàn)。每棵樹都在整個數(shù)據(jù)集上進(jìn)行訓(xùn)練,但采用了自適應(yīng)樣本權(quán)重,使先前分類錯誤的樣本更加重要。

對于分類任務(wù),AdaBoost通過加權(quán)投票系統(tǒng)組合樹,其中表現(xiàn)更好的樹在最終決策中具有更大的影響力。

該模型的優(yōu)勢來自其自適應(yīng)學(xué)習(xí)過程——雖然每棵簡單的樹可能都是“弱學(xué)習(xí)器”,其表現(xiàn)僅略優(yōu)于隨機(jī)猜測,但樹的加權(quán)組合創(chuàng)造了一個“強(qiáng)學(xué)習(xí)器”,可以逐步關(guān)注和糾正錯誤。

AdaBoost是增強(qiáng)算法系列的一部分,因為它一次構(gòu)建一棵樹。每棵新樹都會嘗試修復(fù)先前樹所犯的錯誤。然后,它使用加權(quán)投票來組合它們的答案并做出最終預(yù)測。

測試數(shù)據(jù)集

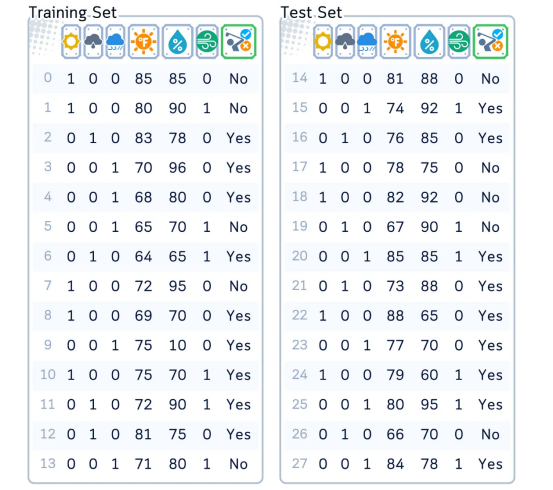

在本文中,我們將重點介紹經(jīng)典高爾夫數(shù)據(jù)集作為分類的樣本。

各列含義:“Outlook(展望)”——獨熱編碼為3列、“Temperature(溫度)”——華氏度、“Humidity(濕度)”——百分比、“Windy(有風(fēng))——(是/否)和“播放(Play)”——是/否,代表目標(biāo)特征。

import pandas as pd

import numpy as np

from sklearn.model_selection import train_test_split

# 創(chuàng)建和準(zhǔn)備數(shù)據(jù)集

dataset_dict = {

'Outlook': ['sunny', 'sunny', 'overcast', 'rainy', 'rainy', 'rainy', 'overcast',

'sunny', 'sunny', 'rainy', 'sunny', 'overcast', 'overcast', 'rainy',

'sunny', 'overcast', 'rainy', 'sunny', 'sunny', 'rainy', 'overcast',

'rainy', 'sunny', 'overcast', 'sunny', 'overcast', 'rainy', 'overcast'],

'Temperature': [85.0, 80.0, 83.0, 70.0, 68.0, 65.0, 64.0, 72.0, 69.0, 75.0, 75.0,

72.0, 81.0, 71.0, 81.0, 74.0, 76.0, 78.0, 82.0, 67.0, 85.0, 73.0,

88.0, 77.0, 79.0, 80.0, 66.0, 84.0],

'Humidity': [85.0, 90.0, 78.0, 96.0, 80.0, 70.0, 65.0, 95.0, 70.0, 80.0, 70.0,

90.0, 75.0, 80.0, 88.0, 92.0, 85.0, 75.0, 92.0, 90.0, 85.0, 88.0,

65.0, 70.0, 60.0, 95.0, 70.0, 78.0],

'Wind': [False, True, False, False, False, True, True, False, False, False, True,

True, False, True, True, False, False, True, False, True, True, False,

True, False, False, True, False, False],

'Play': ['No', 'No', 'Yes', 'Yes', 'Yes', 'No', 'Yes', 'No', 'Yes', 'Yes', 'Yes',

'Yes', 'Yes', 'No', 'No', 'Yes', 'Yes', 'No', 'No', 'No', 'Yes', 'Yes',

'Yes', 'Yes', 'Yes', 'Yes', 'No', 'Yes']

}

# 準(zhǔn)備數(shù)據(jù)

df = pd.DataFrame(dataset_dict)

df = pd.get_dummies(df, columns=['Outlook'], prefix='', prefix_sep='', dtype=int)

df['Wind'] = df['Wind'].astype(int)

df['Play'] = (df['Play'] == 'Yes').astype(int)

# 重新安排各列

column_order = ['sunny', 'overcast', 'rainy', 'Temperature', 'Humidity', 'Wind', 'Play']

df = df[column_order]

# 準(zhǔn)備特征和目標(biāo)

X,y = df.drop('Play', axis=1), df['Play']

X_train, X_test, y_train, y_test = train_test_split(X, y, train_size=0.5, shuffle=False)Main MechanismAdaBoost算法主要機(jī)制

AdaBoost算法的工作原理如下:

- 初始化權(quán)重:為每個訓(xùn)練樣本分配相同的權(quán)重。

- 迭代學(xué)習(xí):在每個步驟中,訓(xùn)練一個簡單的決策樹并檢查其性能。錯誤分類的樣本獲得更多權(quán)重,使其成為下一棵樹的優(yōu)先級。正確分類的樣本保持不變,所有權(quán)重都調(diào)整為總和為1。

- 構(gòu)建弱學(xué)習(xí)器:每個新的簡單樹都針對前幾棵樹的錯誤,創(chuàng)建一系列專門的弱學(xué)習(xí)器。

- 最終預(yù)測:通過加權(quán)投票合并所有樹,其中每棵樹的投票都基于其重要性值,從而為更準(zhǔn)確的樹提供更大的影響力。

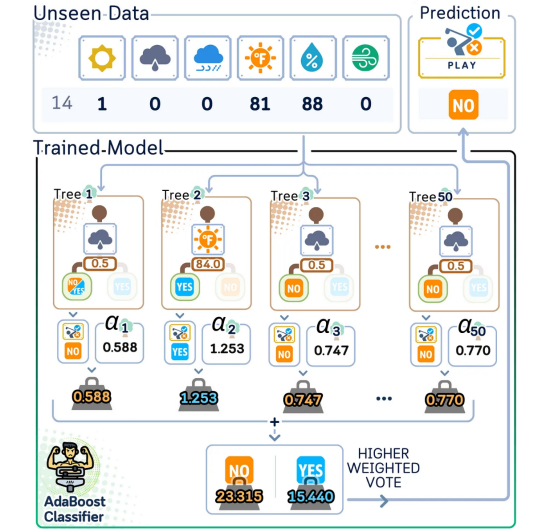

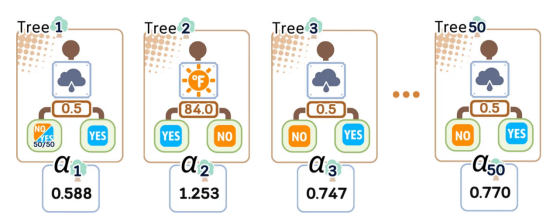

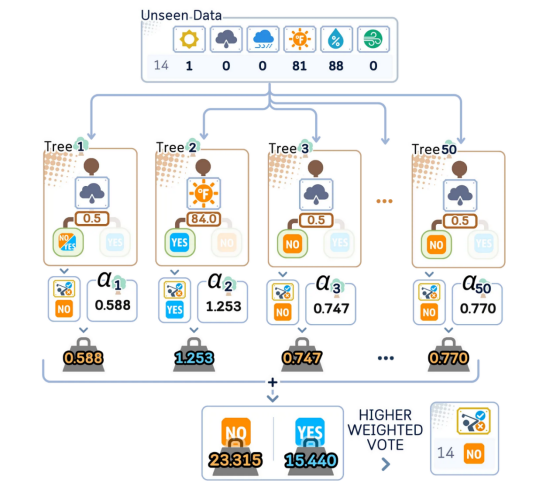

AdaBoost分類器使用許多簡單的決策樹(通常為50~100棵)進(jìn)行預(yù)測。每棵樹稱為“樹樁”,專注于一個重要特征,如溫度或濕度。最終預(yù)測是通過合并所有樹的投票做出的,每個投票都根據(jù)該樹的重要性(“alpha”)加權(quán)。

訓(xùn)練步驟

在這里,我們將遵循SAMME(使用多類指數(shù)損失函數(shù)的分階段加性建模)算法,這是scikit-learn庫中處理二分類和多類分類的標(biāo)準(zhǔn)方法。

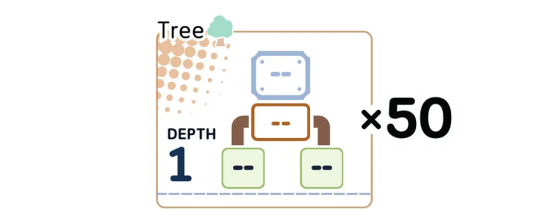

1.1.決定要使用的弱學(xué)習(xí)器。其中,單級決策樹(或“樹樁”)是默認(rèn)選擇。

1.2.決定要構(gòu)建多少個弱學(xué)習(xí)器(在本例中為樹的數(shù)量)(默認(rèn)值為50棵樹)。

我們從深度為1的決策樹(樹樁)開始作為弱學(xué)習(xí)器。每個樹樁只進(jìn)行一次分割,我們將按順序訓(xùn)練其中的50個,并在此過程中調(diào)整權(quán)重。

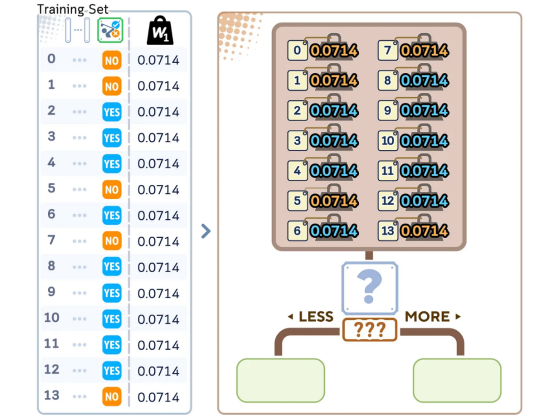

1.3.開始時,為每個訓(xùn)練樣本賦予相同的權(quán)重:

- 每個樣本的權(quán)重=1/N(N是樣本總數(shù))

- 所有權(quán)重加起來為1

所有數(shù)據(jù)點的權(quán)重都相同(0.0714),總權(quán)重加起來為1。這確保在訓(xùn)練開始時每個樣本都同等重要。

對于第一棵樹

2.1.在考慮樣本權(quán)重的同時構(gòu)建決策樹樁

在進(jìn)行第一次分割之前,算法會檢查所有數(shù)據(jù)點及其權(quán)重,以找到最佳分割點。這些權(quán)重會影響每個樣本在進(jìn)行分割決策時的重要性。

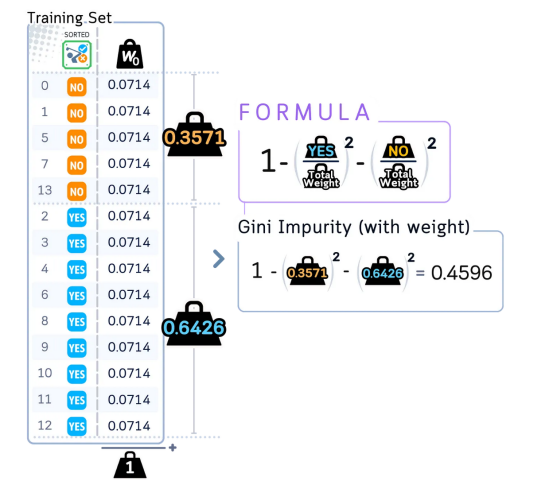

計算根節(jié)點的初始加權(quán)基尼不純度

算法計算根節(jié)點的基尼不純度分?jǐn)?shù),但現(xiàn)在考慮所有數(shù)據(jù)點的權(quán)重。

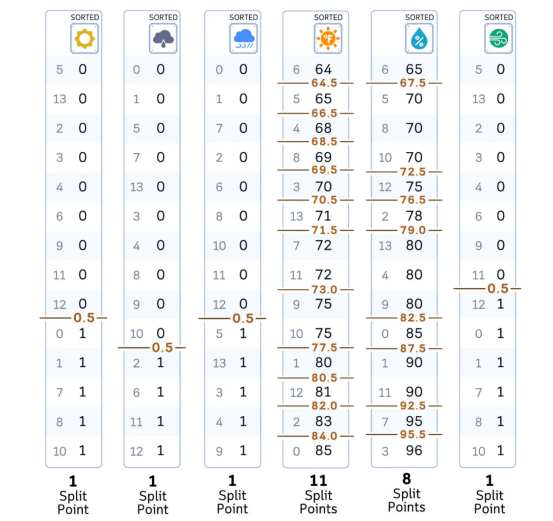

對于每個特征:

- 按特征值對數(shù)據(jù)進(jìn)行排序(與決策樹分類器完全相同)

對于每個特征,算法都會對數(shù)據(jù)進(jìn)行排序并識別潛在的分割點,與標(biāo)準(zhǔn)決策樹完全相同。

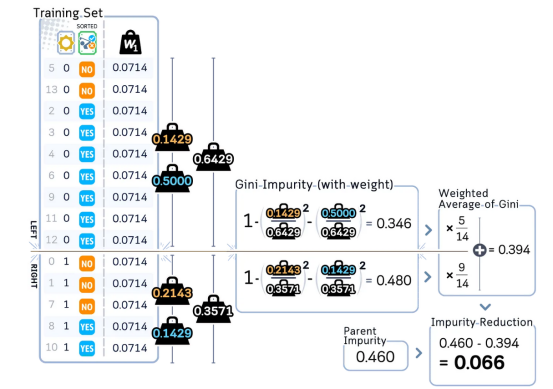

對于每個可能的分割點:

- 將樣本分成左組和右組

- 計算兩個組的加權(quán)基尼不純度

- 計算此分割的加權(quán)基尼不純度減少量

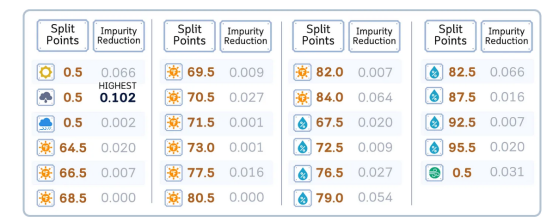

該算法計算每個潛在分割的加權(quán)基尼不純度并將其與父節(jié)點進(jìn)行比較。對于分割點為0.5的特征“sunny”,此不純度減少量(0.066)顯示了此分割對數(shù)據(jù)分離的改善程度。

選擇提供最大基尼不純度減少量的分割

在檢查所有可能的分割特征后,“overcast”列(分割點為0.5)提供最高的不純度減少量0.102。這意味著它是分離類別的最有效方法,使其成為第一次分割的最佳選擇。

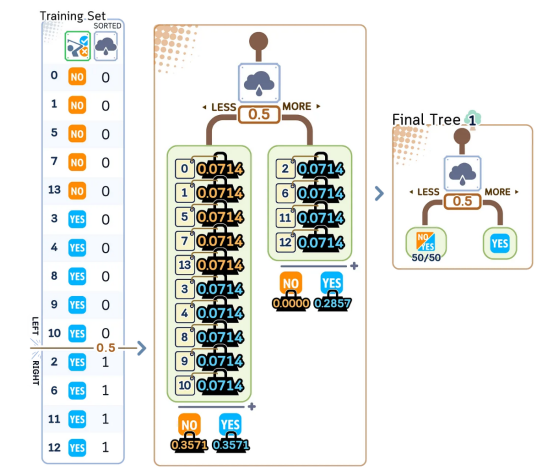

d. 使用此決策創(chuàng)建一個簡單的單分割樹

使用找到的最佳分割點,算法將數(shù)據(jù)分成兩組,每組保留其原始權(quán)重。這個簡單的決策樹故意保持較小和不完美,使其略優(yōu)于隨機(jī)猜測。

2.2.評估這棵樹有多好

a. 使用樹預(yù)測訓(xùn)練集的標(biāo)簽。

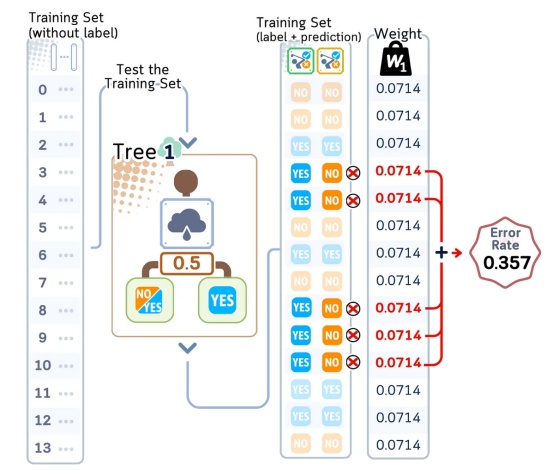

b. 將所有錯誤分類的樣本的權(quán)重相加以獲得錯誤率。

第一個弱學(xué)習(xí)器對訓(xùn)練數(shù)據(jù)進(jìn)行預(yù)測,我們檢查它在哪里犯了錯誤(標(biāo)記為X)。0.357的錯誤率表明這棵簡單的樹對一些預(yù)測有誤,這是預(yù)料之中的,并將有助于指導(dǎo)接下來的訓(xùn)練步驟。

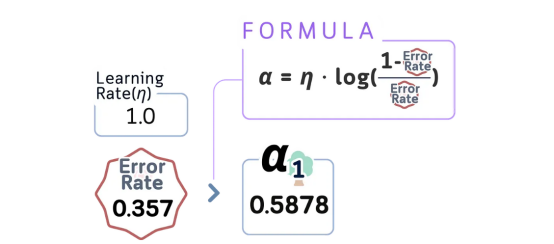

c. 使用以下方法計算樹重要性(α):

α = learning_rate × log((1-error)/error)

我們使用錯誤率計算樹的影響力得分(α = 0.5878)。分?jǐn)?shù)越高意味著樹越準(zhǔn)確,這棵樹因其良好的性能獲得了中等重要性。

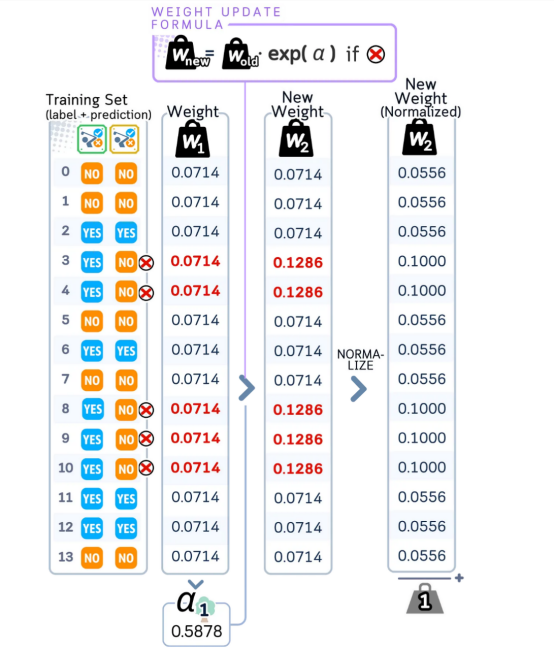

2.3.更新樣本權(quán)重

a. 保留正確分類樣本的原始權(quán)重。

b.將錯誤分類的樣本的權(quán)重乘以e^(α)。

c. 將每個權(quán)重除以所有權(quán)重的總和。此歸一化可確保所有權(quán)重的總和仍為1,同時保持其相對比例。

樹出錯的情況(標(biāo)記為X)在下一輪中獲得更高的權(quán)重。增加這些權(quán)重后,所有權(quán)重均被歸一化為總和為1,確保錯誤分類的樣本在下一棵樹中得到更多關(guān)注。

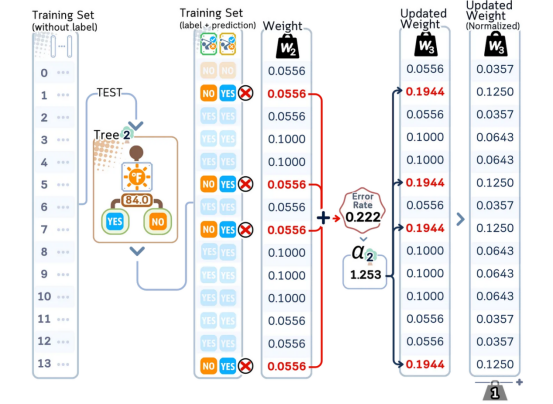

對于第二棵樹

2.1.構(gòu)建新的樹樁,但現(xiàn)在使用更新后的權(quán)重

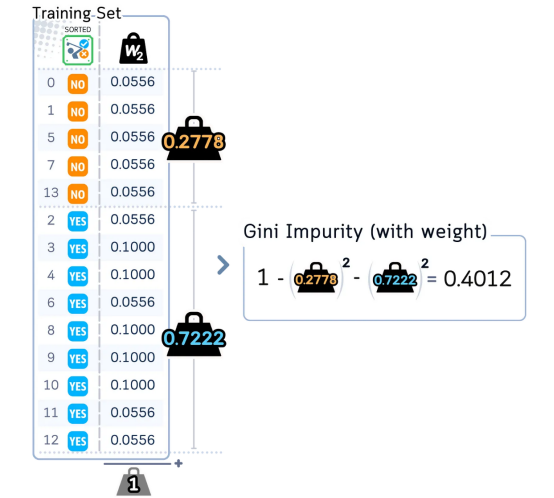

a. 計算根節(jié)點的新加權(quán)基尼不純度:

- 將會有所不同,因為錯誤分類的樣本現(xiàn)在具有更大的權(quán)重

- 正確分類的樣本現(xiàn)在具有更小的權(quán)重

使用更新后的權(quán)重(其中錯誤分類的樣本現(xiàn)在具有更高的重要性),算法計算根節(jié)點的加權(quán)基尼不純度。這開始了構(gòu)建第二棵決策樹的過程。

b. 對于每個特征:

- 使用與之前相同的過程,但權(quán)重已更改。

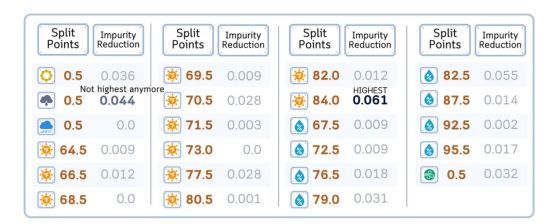

c. 選擇具有最佳加權(quán)基尼不純度減少的分割。

- 通常與第一棵樹的分割完全不同。

- 關(guān)注第一棵樹錯誤的樣本。

使用更新后的權(quán)重,不同的分割點顯示出不同的有效性。請注意,“overcast(陰天)”不再是最佳分割——算法現(xiàn)在發(fā)現(xiàn)溫度(84.0)可以最大程度地減少不純度,從而顯示權(quán)重變化如何影響分割選擇。

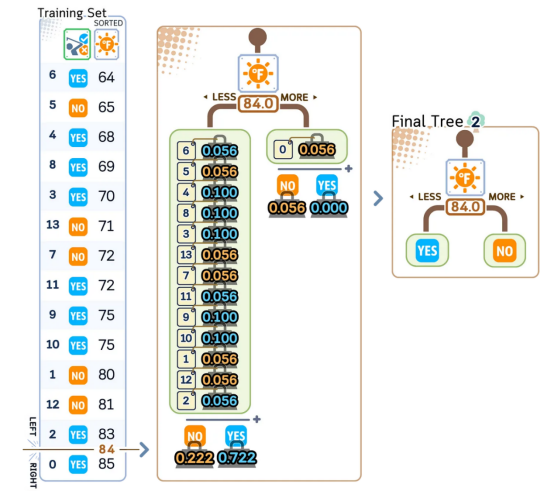

d.創(chuàng)建第二個樹樁。

使用溫度≤84.0作為分割點,算法根據(jù)哪個類在該組中的總權(quán)重更大,而不是僅通過計算樣本,為每個葉子分配YES/NO。這種加權(quán)投票有助于糾正前一棵樹的錯誤。

2.2.評估這棵新樹

a.用當(dāng)前權(quán)重計算錯誤率。

b.使用與之前相同的公式計算其重要性(α)。

2.3.再次更新權(quán)重——相同的過程(增加錯誤權(quán)重,然后歸一化)

第二棵樹的錯誤率(0.222)和重要性得分(α=1.253)比第一棵樹低。和以前一樣,錯誤分類的樣本在下一輪中獲得更高的權(quán)重。

對于第三棵樹及以后的所有剩余樹

重復(fù)上述步驟2.1-2.3。

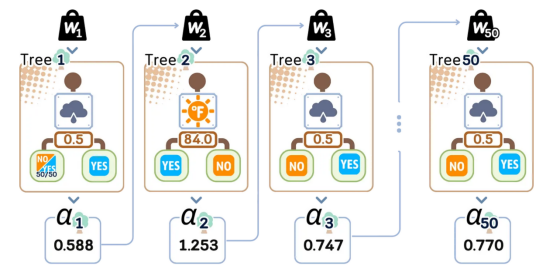

該算法按順序構(gòu)建50棵簡單決策樹,每棵都有自己的重要性得分(α)。每棵樹通過關(guān)注數(shù)據(jù)的不同方面從以前的錯誤中學(xué)習(xí),從而創(chuàng)建一個強(qiáng)大的組合模型。請注意,有些樹(如樹2)在表現(xiàn)更好時會獲得更高的權(quán)重分?jǐn)?shù)。

第3步:組合到一起

3.1.保留所有樹及其重要性分?jǐn)?shù)

50棵簡單決策樹作為一個團(tuán)隊一起工作,每棵都有自己的重要性分?jǐn)?shù)(α)。在進(jìn)行預(yù)測時,具有較高α值的樹(如樹2的1.253)對最終決策的影響比分?jǐn)?shù)較低的樹更大。

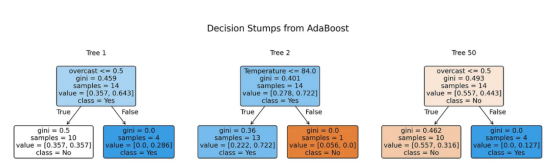

from sklearn.tree import plot_tree

from sklearn.ensemble import AdaBoostClassifier

from sklearn.tree import plot_tree

import matplotlib.pyplot as plt

#訓(xùn)練AdaBoost算法

np.random.seed(42) # 可重復(fù)性

clf = AdaBoostClassifier(algorithm='SAMME', n_estimators=50, random_state=42)

clf.fit(X_train, y_train)

# 為樹1、2和50創(chuàng)建可視化形式

trees_to_show = [0, 1, 49]

feature_names = X_train.columns.tolist()

class_names = ['No', 'Yes']

#設(shè)置繪圖

fig, axes = plt.subplots(1, 3, figsize=(14,4), dpi=300)

fig.suptitle('Decision Stumps from AdaBoost', fontsize=16)

#繪制每棵樹

for idx, tree_idx in enumerate(trees_to_show):

plot_tree(clf.estimators_[tree_idx],

feature_names=feature_names,

class_names=class_names,

filled=True,

rounded=True,

ax=axes[idx],

fontsize=12) #增加字體大小

axes[idx].set_title(f'Tree {tree_idx + 1}', fontsize=12)

plt.tight_layout(rect=[0, 0.03, 1, 0.95])

每個節(jié)點將其“值”參數(shù)顯示為[weight_NO, weight_YES],表示該節(jié)點上每個類型的加權(quán)比例。這些權(quán)重來自我們在訓(xùn)練期間計算的樣本權(quán)重。

測試步驟

為了預(yù)測,需要:

- 獲取每棵樹的預(yù)測值。

- 將每個預(yù)測值乘以其權(quán)重得分(α)。

- 將它們?nèi)考悠饋怼?/span>

- 總權(quán)重較高的類型將是最終預(yù)測結(jié)果。

在預(yù)測新數(shù)據(jù)時,每棵樹都會做出預(yù)測并將其乘以其權(quán)重得分(α)。最終決定來自將所有加權(quán)投票相加。在這里,NO類型獲得更高的總分(23.315相對于15.440),因此模型預(yù)測這個未見過的樣本為NO。

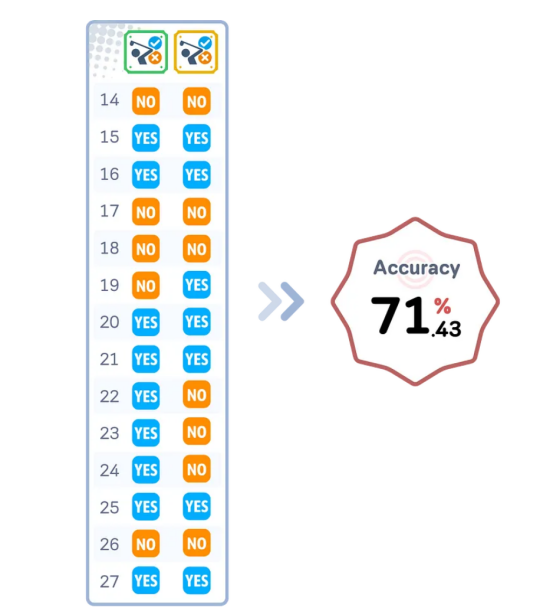

評估步驟

構(gòu)建完所有樹后,接下來,我們就可以進(jìn)行測試集評估了。

通過迭代訓(xùn)練和加權(quán)弱學(xué)習(xí)器以關(guān)注錯誤分類的樣本,AdaBoost創(chuàng)建了一個強(qiáng)大的分類器,可實現(xiàn)高精度——通常比單個決策樹或更簡單的模型更好!

#獲得預(yù)測結(jié)果

y_pred = clf.predict(X_test)

#使用實際值和預(yù)測值創(chuàng)建數(shù)據(jù)幀

results_df = pd.DataFrame({

'Actual': y_test,

'Predicted': y_pred

})

print(results_df) # 顯示結(jié)果數(shù)據(jù)幀

# 計算和顯示精度

from sklearn.metrics import accuracy_score

accuracy = accuracy_score(y_test, y_pred)

print(f"\nModel Accuracy: {accuracy:.4f}")關(guān)鍵參數(shù)解釋

以下是AdaBoost算法的關(guān)鍵參數(shù)解釋(特別是在scikit-learn庫中提供的那些):

estimator(估計器)

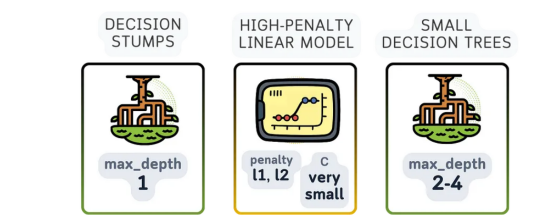

這是AdaBoost用來構(gòu)建最終解決方案的基本模型。三個最常見的弱學(xué)習(xí)器是:

- 深度為1的決策樹(決策樹樁):這是默認(rèn)且最受歡迎的選擇。由于它只有一個分割,因此它被認(rèn)為是一種非常弱的學(xué)習(xí)器,比隨機(jī)猜測略好一點,這正是提升過程所需要的。

- 邏輯回歸:邏輯回歸(尤其是高懲罰)也可以在這里使用,即使它并不是真正的弱學(xué)習(xí)器。它可能對具有線性關(guān)系的數(shù)據(jù)有用。

- 深度較小的決策樹(例如深度2或3):這些比決策樹樁稍微復(fù)雜一些。它們?nèi)匀幌喈?dāng)簡單,但可以處理比決策樹樁稍微復(fù)雜一些的模式。

AdaBoost的基礎(chǔ)模型可以是簡單的決策樹樁(深度=1)、小型樹(深度2-3)或懲罰線性模型。每種類型都保持簡單以避免過度擬合,同時提供不同的方法來捕獲模式。

n_estimators

要組合的弱學(xué)習(xí)器的數(shù)量,通常約為50-100;當(dāng)這個值超過100時很少有更好的效果。

learning_rate

控制每個分類器對最終結(jié)果的影響程度。常見的起始值為0.1、0.5或1.0。較低的數(shù)字(如0.1)和稍高的n_estimator通常效果更好。

與隨機(jī)森林算法的主要區(qū)別

由于隨機(jī)森林和AdaBoost都適用于多棵樹,因此很容易混淆所涉及的參數(shù)。關(guān)鍵區(qū)別在于隨機(jī)森林獨立組合多棵樹(裝袋),而AdaBoost一棵樹接一棵樹地構(gòu)建樹以修復(fù)錯誤(提升)。以下是關(guān)于它們之間的差異的其他一些細(xì)節(jié):

- 沒有bootstrap參數(shù),因為AdaBoost使用所有數(shù)據(jù),但權(quán)重會發(fā)生變化

- 沒有oob_score參數(shù),因為AdaBoost不使用bootstrap放回抽樣

- learning_rate變得至關(guān)重要(隨機(jī)森林中不存在)

- 與隨機(jī)森林的較深樹不同,樹的深度通常保持得很淺(通常只是樹樁)

- 關(guān)鍵之處從并行獨立樹轉(zhuǎn)移到順序依賴樹,這使得n_jobs等參數(shù)不那么重要

AdaBoost算法的優(yōu)點與缺點

優(yōu)點:

- 自適應(yīng)學(xué)習(xí):AdaBoost通過賦予其所犯錯誤更多權(quán)重而變得更好。每棵新樹都會更加關(guān)注它出錯的困難情況。

- 抵抗過度擬合:盡管它不斷逐一添加更多樹,但AdaBoost通常不會過于專注于訓(xùn)練數(shù)據(jù)。這是因為它使用加權(quán)投票,因此沒有一棵樹可以過多地控制最終答案。

- 內(nèi)置特征的選擇:AdaBoost自然會找到最重要的特征。每棵簡單樹都會為該輪選擇最有用的特征,這意味著它在訓(xùn)練時會自動選擇重要特征。

缺點:

- 對噪聲敏感:由于它更重視錯誤,AdaBoost可能會在處理混亂或錯誤的數(shù)據(jù)時遇到麻煩。如果一些訓(xùn)練樣本帶有錯誤標(biāo)簽,它可能會過于關(guān)注這些不好的樣本,從而使整個模型變得更糟。

- 必須是連續(xù)的:與可以同時訓(xùn)練多棵樹的隨機(jī)森林不同,AdaBoost必須一次訓(xùn)練一棵樹,因為每棵新樹都需要知道之前的樹的表現(xiàn)。這使得訓(xùn)練速度變慢。

- 學(xué)習(xí)率敏感性:雖然它比隨機(jī)森林需要調(diào)整的設(shè)置更少,但學(xué)習(xí)率確實會影響它的效果。如果學(xué)習(xí)率太高,它可能會過于精確地學(xué)習(xí)訓(xùn)練數(shù)據(jù)。如果學(xué)習(xí)率太低,它需要更多的樹才能正常工作。

結(jié)語

AdaBoost是一種關(guān)鍵的增強(qiáng)算法,許多新方法都從中吸取了教訓(xùn)。它的主要思想——通過關(guān)注錯誤來變得更好——幫助塑造了許多現(xiàn)代機(jī)器學(xué)習(xí)工具。雖然其他方法都試圖從一開始就做到完美,但AdaBoost卻試圖表明,有時解決問題的最佳方法是從錯誤中學(xué)習(xí)并不斷改進(jìn)。

AdaBoost在二元分類問題中以及數(shù)據(jù)干凈時也最有效。雖然隨機(jī)森林可能更適合更一般的任務(wù)(如預(yù)測數(shù)字)或混亂的數(shù)據(jù),但AdaBoost在正確使用時可以產(chǎn)生非常好的結(jié)果。這么多年后人們?nèi)栽谑褂盟@一事實表明其核心思想有多好用!

AdaBoost分類器代碼歸納

import pandas as pd

import numpy as np

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

from sklearn.ensemble import AdaBoostClassifier

from sklearn.tree import DecisionTreeClassifier

# 創(chuàng)建數(shù)據(jù)集

dataset_dict = {

'Outlook': ['sunny', 'sunny', 'overcast', 'rainy', 'rainy', 'rainy', 'overcast',

'sunny', 'sunny', 'rainy', 'sunny', 'overcast', 'overcast', 'rainy',

'sunny', 'overcast', 'rainy', 'sunny', 'sunny', 'rainy', 'overcast',

'rainy', 'sunny', 'overcast', 'sunny', 'overcast', 'rainy', 'overcast'],

'Temperature': [85.0, 80.0, 83.0, 70.0, 68.0, 65.0, 64.0, 72.0, 69.0, 75.0, 75.0,

72.0, 81.0, 71.0, 81.0, 74.0, 76.0, 78.0, 82.0, 67.0, 85.0, 73.0,

88.0, 77.0, 79.0, 80.0, 66.0, 84.0],

'Humidity': [85.0, 90.0, 78.0, 96.0, 80.0, 70.0, 65.0, 95.0, 70.0, 80.0, 70.0,

90.0, 75.0, 80.0, 88.0, 92.0, 85.0, 75.0, 92.0, 90.0, 85.0, 88.0,

65.0, 70.0, 60.0, 95.0, 70.0, 78.0],

'Wind': [False, True, False, False, False, True, True, False, False, False, True,

True, False, True, True, False, False, True, False, True, True, False,

True, False, False, True, False, False],

'Play': ['No', 'No', 'Yes', 'Yes', 'Yes', 'No', 'Yes', 'No', 'Yes', 'Yes', 'Yes',

'Yes', 'Yes', 'No', 'No', 'Yes', 'Yes', 'No', 'No', 'No', 'Yes', 'Yes',

'Yes', 'Yes', 'Yes', 'Yes', 'No', 'Yes']

}

df = pd.DataFrame(dataset_dict)

#準(zhǔn)備數(shù)據(jù)

df = pd.get_dummies(df, columns=['Outlook'], prefix='', prefix_sep='', dtype=int)

df['Wind'] = df['Wind'].astype(int)

df['Play'] = (df['Play'] == 'Yes').astype(int)

#拆分特征和目標(biāo)

X, y = df.drop('Play', axis=1), df['Play']

X_train, X_test, y_train, y_test = train_test_split(X, y, train_size=0.5, shuffle=False)

# 訓(xùn)練AdaBoost

ada = AdaBoostClassifier(

estimator=DecisionTreeClassifier(max_depth=1), # 創(chuàng)建基本估計器(決策樁)

n_estimators=50, #典型情況下使用比隨機(jī)森林算法更少的樹

learning_rate=1.0, # 默認(rèn)學(xué)習(xí)率

algorithm='SAMME', # 目前唯一可用的算法(將在未來的scikit-learn更新中刪除)

random_state=42

)

ada.fit(X_train, y_train)

#預(yù)測和評估

y_pred = ada.predict(X_test)

print(f"Accuracy: {accuracy_score(y_test, y_pred)}")進(jìn)一步閱讀

有關(guān)??AdaBoostClassifier??及其在scikit-learn中的實現(xiàn)的詳細(xì)說明,讀者可以參考官方文檔,其中提供了有關(guān)其用法和參數(shù)的全面信息。

本文編程技術(shù)環(huán)境

本文使用Python 3.7和 scikit-learn 1.6。雖然討論的概念普遍適用,但具體代碼實現(xiàn)可能會因版本不同而略有不同。

關(guān)于插圖

除非另有說明,本文所有圖像均由作者本人創(chuàng)建,并采用了Canva Pro的授權(quán)設(shè)計元素。

譯者介紹

朱先忠,51CTO社區(qū)編輯,51CTO專家博客、講師,濰坊一所高校計算機(jī)教師,自由編程界老兵一枚。

原文標(biāo)題:??AdaBoost Classifier, Explained: A Visual Guide with Code Examples??,作者:Samy Baladram