大模型技術全面解析,從大模型的概念,技術,應用和挑戰多個方面介紹大模型 原創

引言

- 大模型(Large Models)是人工智能發展的里程碑,特別是基于深度學習的預訓練模型(如 GPT、BERT)。

- 隨著模型參數規模的指數級增長,大模型在自然語言處理(NLP)、計算機視覺(CV)等領域取得了突破性成果。

- 本文將深入解析大模型的核心技術、應用場景、優化策略及未來挑戰。

大模型的背景與定義

1.1 什么是大模型

- 大模型指的是參數規模超過億級甚至千億級的深度學習模型。

- 特點:

- 高容量:能夠捕捉復雜模式和分布。

- 通用性:支持多任務、多模態(如文本、圖像、音頻)學習。

- 可擴展性:在預訓練基礎上,通過少量樣本(Few-shot)或無監督微調(Zero-shot)完成特定任務。

1.2 大模型發展的階段

- 1.0 傳統機器學習模型:如 SVM、決策樹。

- 2.0 深度學習模型:如 CNN、RNN。

- 3.0 預訓練模型:BERT、GPT。

- 4.0 多模態模型:如 OpenAI 的 CLIP,DeepMind 的 Gato。

1.3 參數規模的增長

- 參數規模從早期的百萬級(如 LSTM)發展到百億級(如 GPT-3)再到萬億級(如 GPT-4、PaLM)。

- 參數規模增長的驅動力:

- 更強的硬件支持(GPU/TPU)。

- 更高效的分布式訓練算法。

- 海量標注與非標注數據的積累。

2. 大模型的核心技術

2.1 模型架構

- Transformer 架構:

基于注意力機制(Attention Mechanism),實現更好的全局信息捕獲。

Self-Attention 的時間復雜度為 O(n2)O(n2),適合并行化訓練。

- 改進的 Transformer:

Sparse Attention(稀疏注意力):降低計算復雜度。

Longformer:處理長文本輸入。

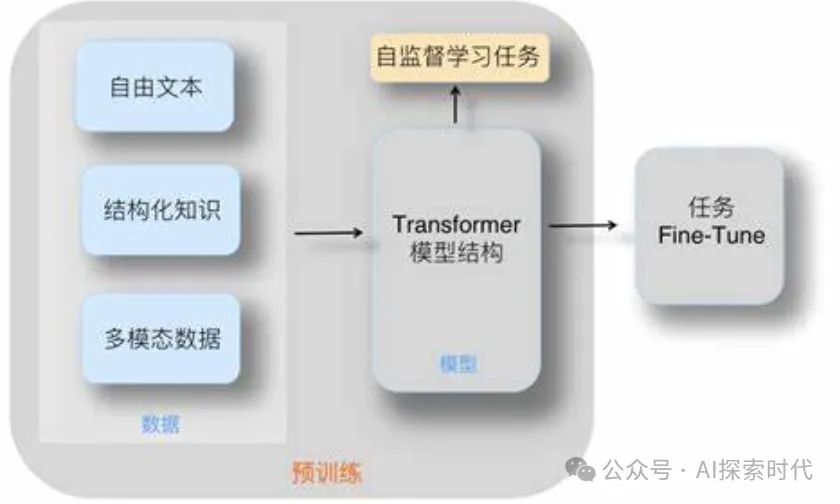

2.2 數據處理與預訓練

- 數據處理:

使用海量數據(如文本、代碼、圖像)進行去噪和清洗。

多模態融合技術,將圖像與文本聯合編碼。

- 預訓練目標:

自回歸(Auto-Regressive):預測下一個 token(如 GPT)。

自編碼(Auto-Encoding):掩蓋部分輸入并恢復原始內容(如 BERT)。

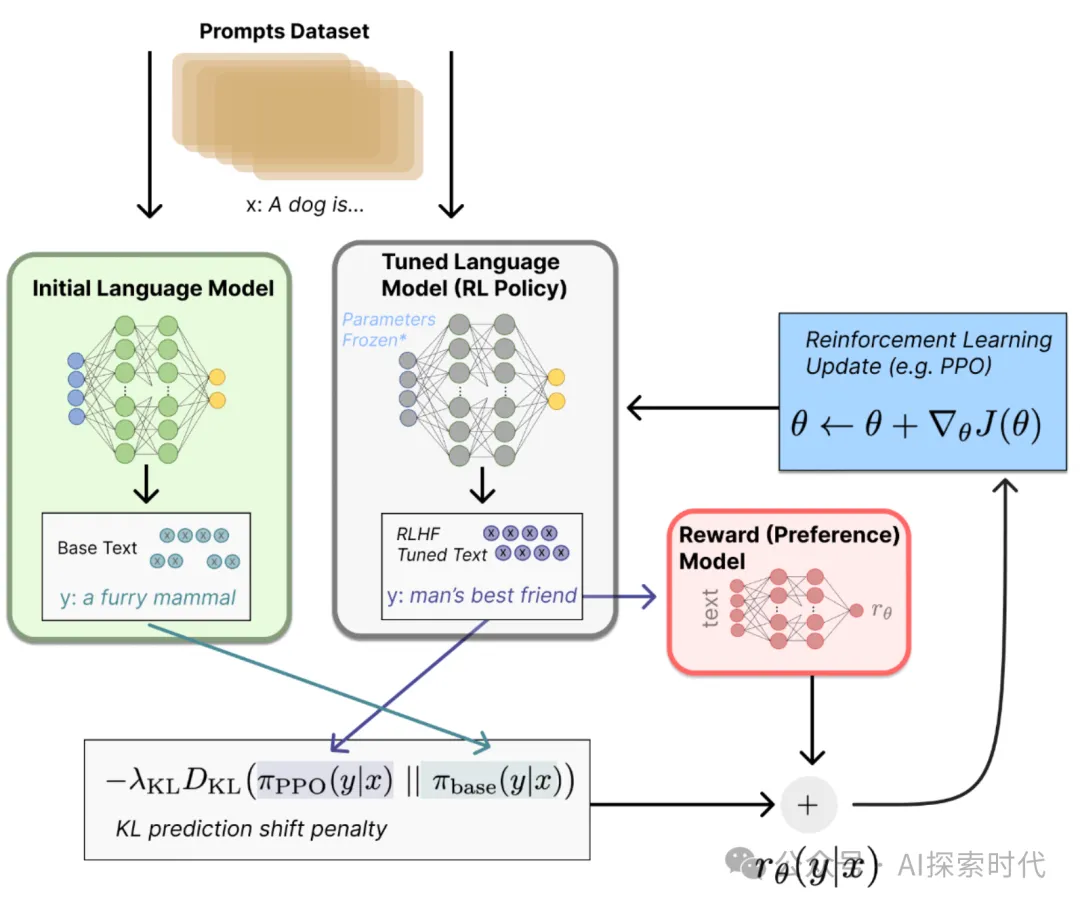

2.3 模型訓練與優化

- 分布式訓練:

數據并行(Data Parallelism):多個設備共享模型權重,不同設備處理不同數據。

模型并行(Model Parallelism):將模型切分為多個部分,分布到不同設備。

- 優化技術:

混合精度訓練(Mixed Precision Training):提升訓練速度,降低顯存占用。

大批量訓練(Large Batch Training):結合學習率調度策略。

2.4 模型壓縮

- 模型蒸餾(Knowledge Distillation):用大模型指導小模型訓練。

- 參數量化(Quantization):減少模型權重的精度(如 32-bit 到 8-bit)。

- 稀疏化(Sparsification):去除冗余參數。

3. 大模型的應用場景

3.1 自然語言處理

- 文本生成:如 ChatGPT、Bard。

- 機器翻譯:如 Google Translate。

- 文本摘要:從長文檔中提取核心信息。

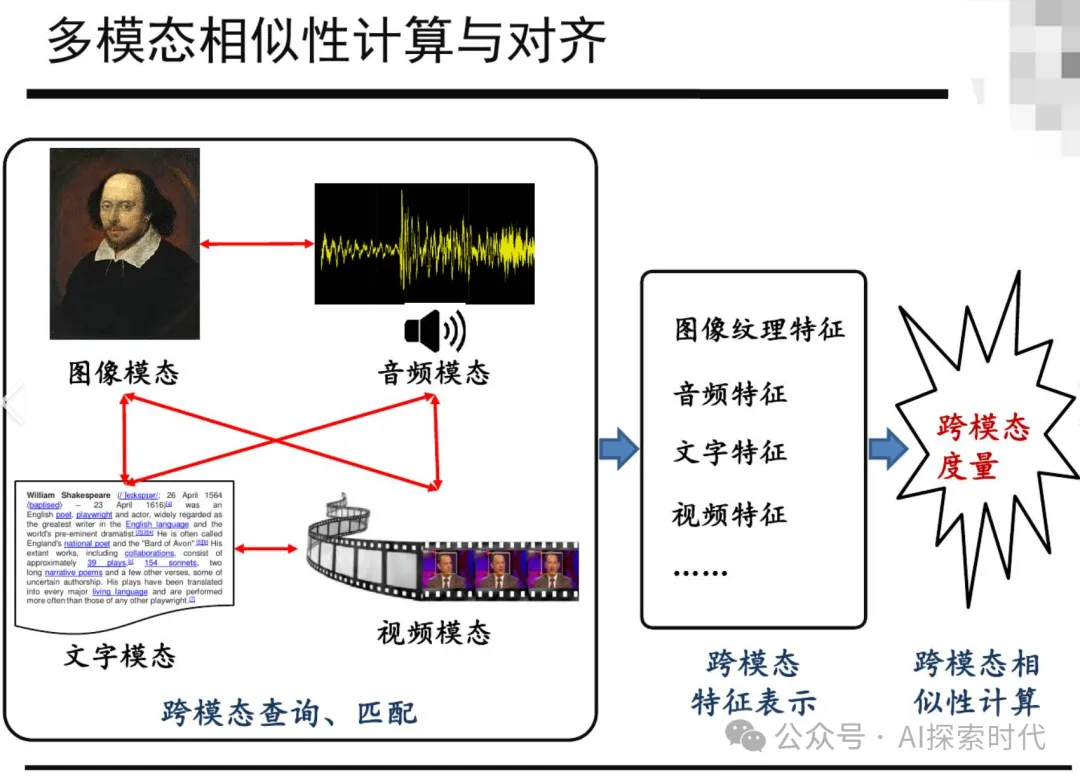

3.2 多模態學習

- 圖像與文本結合:如 OpenAI 的 DALL·E,通過文本生成圖像。

- 視頻理解:如 DeepMind 的 Flamingo,支持跨模態推理。

- 醫學影像分析:結合文本描述輔助診斷。

3.3 科學研究

- 蛋白質折疊預測:如 DeepMind 的 AlphaFold。

- 化學反應模擬:利用大模型加速新材料發現。

4. 大模型的挑戰

4.1 計算資源與成本

- 訓練大模型需要大量計算資源(如數千張 GPU),成本高昂。

- 推理效率仍是瓶頸,特別是在邊緣設備上。

4.2 數據質量與偏差

- 大模型對數據高度依賴,低質量數據可能導致偏差。

- 隱私和倫理問題:如訓練數據中包含敏感信息。

4.3 可解釋性

- 大模型通常被視為“黑盒”,其決策過程難以理解。

- 需要開發更好的模型可視化和解釋技術。

4.4 通用性與專用性

- 通用大模型在某些領域表現優異,但專用領域可能需要針對性優化。

5. 大模型的未來

5.1 模型設計的創新

- 向高效化、稀疏化方向發展,如 Modular Transformer。

- 探索生物啟發的架構(如腦啟發計算)。

5.2 更好的多模態集成

- 實現真正的“通用智能”(AGI),支持跨模態任務協作。

5.3 環境友好型 AI

- 開發綠色 AI 技術,降低碳排放。

- 通過知識重用減少訓練次數。

5.4 開放與合作

- 開源大模型(如 Meta 的 LLaMA)促進了研究社區的合作。

- 更多跨學科應用,如金融、醫學、物理等。

結論

大模型是當前 AI 技術的核心驅動力,從技術架構到實際應用都帶來了深遠影響。然而,隨著模型規模的持續擴大,也暴露出資源消耗、倫理風險等挑戰。未來,優化模型效率、提升可解釋性、推動多模態融合將成為關鍵研究方向。

本文轉載自公眾號AI探索時代 作者:DFires

?著作權歸作者所有,如需轉載,請注明出處,否則將追究法律責任

標簽

已于2024-11-27 11:27:41修改

贊

收藏

回復

分享

微博

QQ

微信

舉報

回復

相關推薦