Kimi把自家底層推理架構都開源了,開源貢獻陣容相當豪華:清華、阿里、華為、AISoft、面壁智能 原創

就在昨天,Kimi宣布要把自家底層的大模型推理架構Mooncake開源出來!

有媒體稱該架構正是承載了月之暗面Kimi線上80%以上流量的正在用的底層架構。

小編立馬求證了一番,的確Github上有提到:Mooncake 正在服務Kimi平臺。而且上線還不到一天就已經斬獲了1600+ stars。

圖片

圖片

開源地址:https://github.com/kvcache-ai/Mooncake

1.開源最終目標:高性能語義存儲的標準接口

“在大模型時代,更多的數據、更大的模型、更長的上下文窗口帶來更高的智能,但也對大模型推理系統的效率提出更高挑戰。如何應對高推理負載、降低推理成本、降低響應延遲成為業界共同面臨的難題。”

大家都知道,月之暗面在長文本、深度推理、高并發等方面一直有著不錯的研究和發布,這一次Kimi選擇在感恩節將這個牛逼的技術開源出來,確實讓大家感到意外和興奮。

據月之暗面官方公眾號介紹,此次是月之暗面聯合清華大學等機構開源共建大模型推理架構Mooncake。

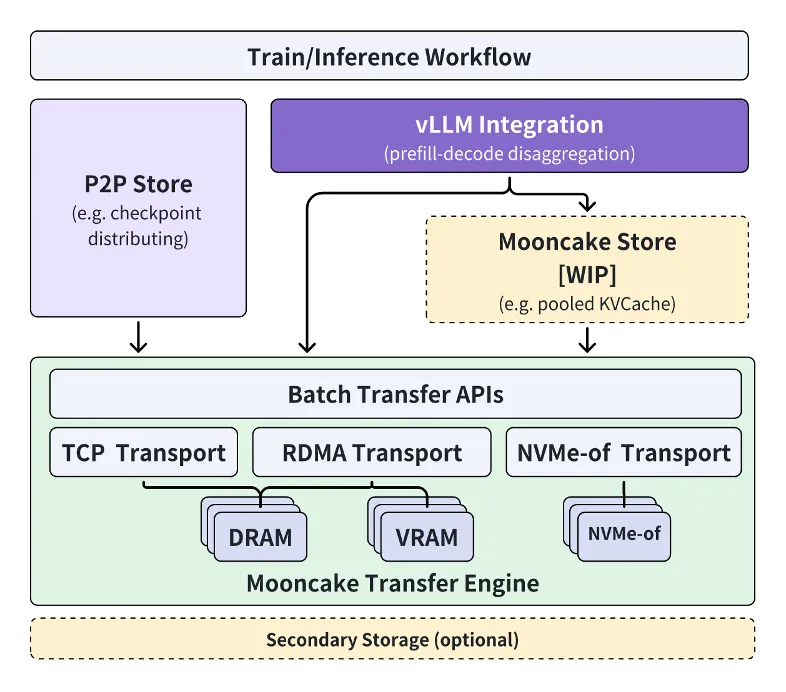

官方文檔還透露了,本次開源將采用分階段的方式:

逐步開源高性能KVCache多級緩存Mooncake Store的實現,同時針對各類推理引擎和底層存儲/傳輸資源進行兼容。

其中傳輸引擎Transfer Engine現在已經在GitHub全球開源。

其最終開源目標是,為大模型時代打造一種新型高性能內存語義存儲的標準接口,并提供參考實現方案。

月之暗面Kimi工程副總裁許欣然表示:

通過與清華大學MADSys實驗室緊密合作,我們共同打造了分離式大模型推理架構Mooncake,實現推理資源的極致優化。

Mooncake不僅提升了Kimi的用戶體驗,降低了成本,還為處理長文本和高并發需求提供了有效的解決方案。

我們相信,通過與產學研機構開源合作,可以推動整個行業向更高效的推理平臺方向發展。

圖片

圖片

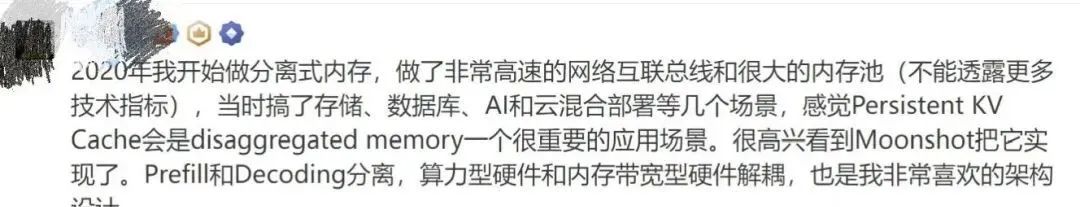

實際上,這個項目早在今年6月就已啟動,當時已受到業內廣泛關注——

圖片

圖片

2.大模型推理架構Mooncake核心思路

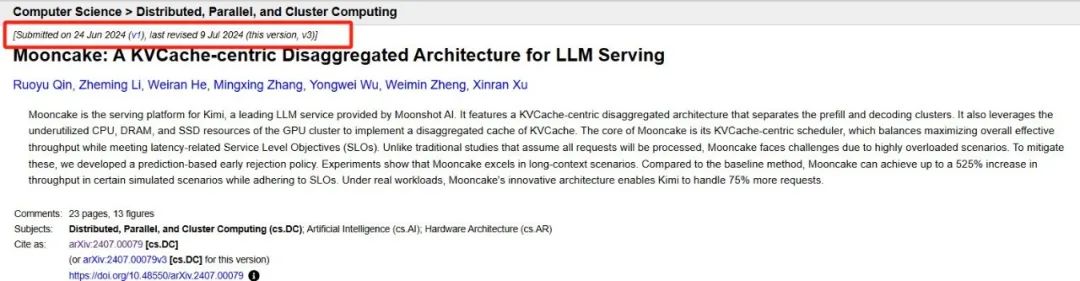

今年6月24日,月之暗面和清華大學MADSys實驗室聯合發布了Kimi底層的Mooncake推理系統設計方案。

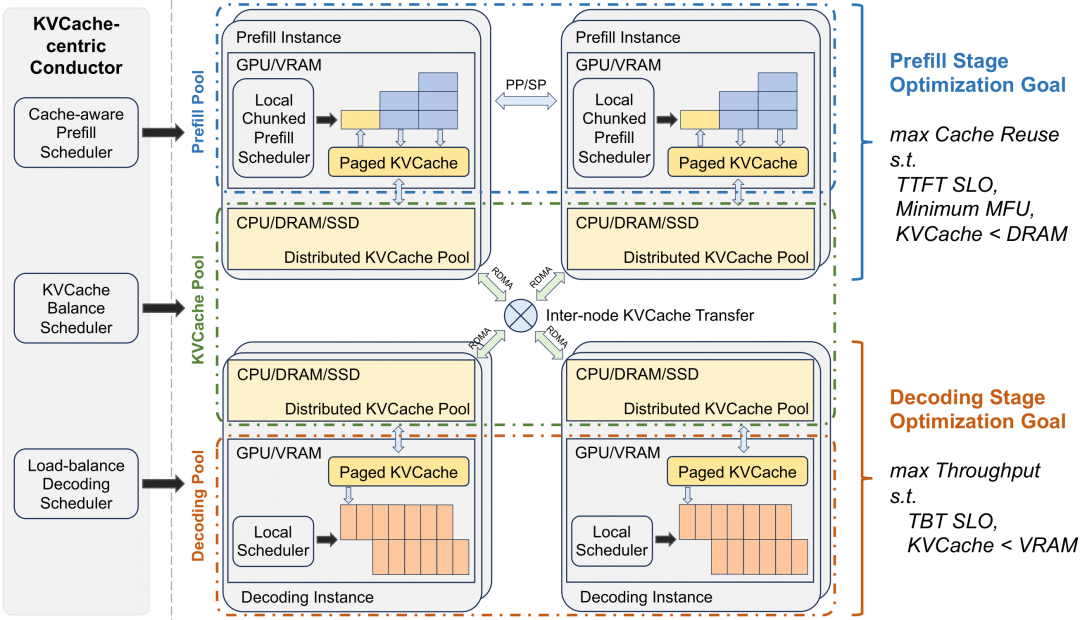

在這篇名為《Mooncake: A KVCache-centric Disaggregated Architecture for LLM Serving》的論文中,作者詳細介紹了Mooncake這種系統架構。

該系統基于以KVCache為中心的PD分離和以存換算架構,大幅度提升了推理吞吐。

圖片

圖片

論文地址:https://arxiv.org/pdf/2407.00079

具體而言,Mooncake采用以KVCache為中心的解耦架構,將預填充集群與解碼集群分離,并充分利用GPU集群中未充分利用的CPU、DRAM和SSD資源,實現KVCache的解耦緩存。

其核心思路在于以KVCache為中心的調度程序:

在最大化整體有效吞吐量和滿足與延遲相關的服務級別目標 (SLO) 要求之間取得平衡

當面對流量高峰期時,Mooncake通過早期拒絕策略和預測未來負載的方法,來處理超載問題。

- 早期拒絕策略

簡單說,其核心思想是在請求實際開始處理之前,根據當前系統的負載情況預測是否有足夠的資源來處理新的請求。

如果預測結果表明系統資源不足以保證請求的及時處理,系統就會在請求到達之前予以拒絕,從而避免了無效的資源占用和不必要的延遲。

- 預測未來負載

在Mooncake中,系統需要能夠預測在未來一段時間內的負載情況,以便做出更準確的接受或拒絕請求的決策。

3.如何實現?

通常來說,這種預測會基于當前的請求模式、系統的資源使用情況以及歷史數據等信息。

再通過對信息的進一步分析建模,Mooncake就能夠估計接下來的請求處理需求,并據此調整其調度策略。

論文實驗結果顯示,與基線方法相比,Mooncake在某些模擬場景中可以實現高達525%的吞吐量提升,同時遵守SLO(與延遲相關的服務級別目標)。

在實際工作負載下,Mooncake使Kimi能夠處理75%以上的請求。

圖片

圖片

而且據許欣然在其他場合透露:目前這套系統承載了Kimi線上80%以上的流量。

圖片

圖片

4.開源陣容相當豪華!!!

而現在,為了進一步加速該技術框架的應用與推廣,Kimi聯合清華大學等機構共同發布開源項目Mooncake。

參與開源的首批陣容包括:

AISoft、阿里云、華為存儲、面壁智能、趨境科技等。

可以說,云計算、存儲、AI模型玩家等產學研力量都聚齊了。

據悉,Mooncake開源項目從論文延伸,以超大規模KVCache緩存池為中心,通過以存換算的創新理念大幅度減少算力開銷,顯著提升了推理吞吐量。

目前Mooncake技術框架已正式開源上線,官方還表示:

歡迎更多企業和研究機構加入Mooncake項目共建,共同探索更加高效和先進的模型推理系統架構創新,讓基于大模型技術的AI助手等產品,持續惠及更廣泛人群。

開源實在是一個大殺器,推理架構層面的開源,意味著Kimi正在重新定義自己在模型側的運作模式甚至商業計劃。希望看到國內LLM推理方面的開源能夠進一步助力大模型應用的真正爆發!

參考鏈接:

??https://mp.weixin.qq.com/s/NsKDtC7qp2JxA_EunwSqvg??

??https://mp.weixin.qq.com/s/-0YxV77HnEEtrvxJSSujmQ??

本文轉載自??51CTO技術棧??