VLM版o1超越一眾開源和閉源模型!LLaVA-o1:多階段自主推理(北大&清華&阿里等)

論文鏈接:https://arxiv.org/abs/2411.10440

亮點直擊

- 引入了LLaVA-o1,這是一種專為系統性推理設計的視覺語言模型,在需要結構化思維和推理的任務中表現出色。

- 證明了LLaVA-o1使用階段級束搜索具有推理時的可擴展性。這意味著通過增加計算資源,本文的方法性能可以進一步提升,從而適用于更復雜的任務和場景。

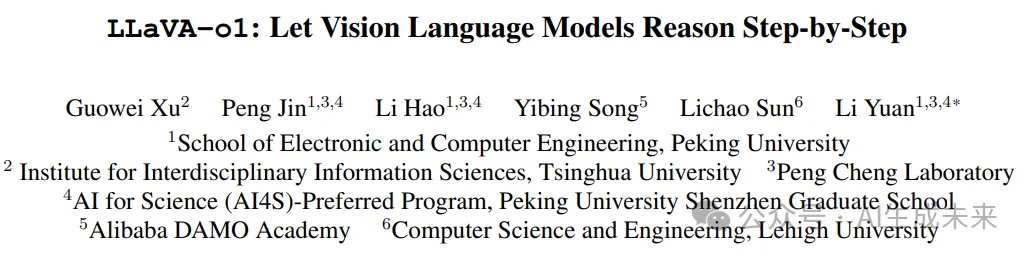

- 在各種基準測試上的廣泛實驗表明,本文的方法相較于更大規模和閉源模型實現了更優異的性能,凸顯了 LLaVA-o1 在多模態推理中的有效性。

總結速覽

解決的問題

當前視覺語言模型(VLMs)在處理復雜的視覺問答任務時,系統性和結構化推理能力較弱,尤其在多階段推理任務中表現不佳。

提出的方案

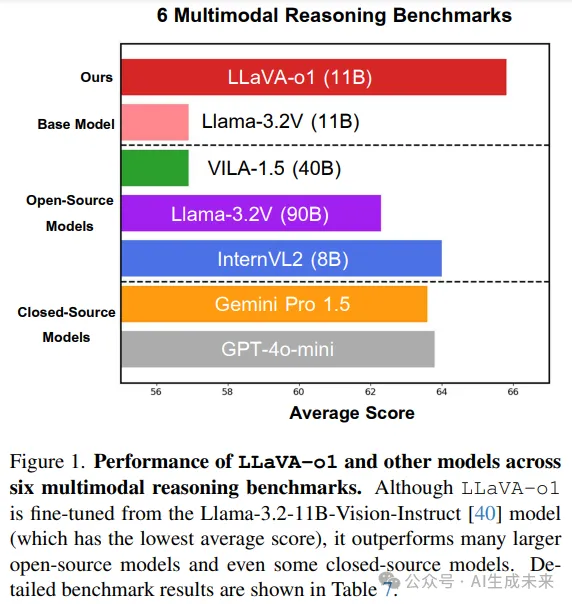

引入 LLaVA-o1,一個新型 VLM,采用自主的多階段推理策略。與鏈式思維(chain-of-thought)提示不同,LLaVA-o1 將推理分為以下獨立階段:總結、視覺解釋、邏輯推理和結論生成。

應用的技術

- 構建 LLaVA-o1-100k 數據集,整合多種視覺問答數據來源,提供結構化推理標注。

- 提出推理階段級別的束搜索(beam search)方法,以實現推理時的擴展能力。

達到的效果

- LLaVA-o1 在推理密集型任務的精確性上顯著提高。

- 使用僅 100k 訓練樣本及簡單有效的推理擴展方法,LLaVA-o1 在多模態推理基準測試上表現超越基礎模型 8.9%。

- 超越包括 Gemini-1.5-pro、GPT-4o-mini 和 Llama-3.2-90B-Vision-Instruct 等更大規模甚至閉源模型的性能。

方法

LLaVA-o1 通過漸進式的逐步推理過程增強了視覺語言模型(VLMs)的推理能力,并支持高效的推理時間擴展。通過結構化思維,LLaVA-o1 實現了系統化且高效的推理過程。其推理時間框架使其在推理時間可擴展性方面超越現有方法。這一設計確保了在需要推理的復雜任務中具備魯棒性和準確性,與傳統方法形成了鮮明對比。下圖 1 展示了推理過程的總體框架。

通過結構化思維增強推理能力

在訓練過程中,本文的目標是開發一種能夠執行擴展推理鏈的視覺語言模型,使其能夠進行系統化和深入的推理。

推理階段

LLaVA-o1 將答案生成過程分解為四個結構化推理階段:

- 總結階段在初始階段,LLaVA-o1 提供問題的高層次總結性解釋,概述其需要解決的主要問題。

- 描述階段如果有圖像存在,LLaVA-o1 提供與問題相關的視覺元素的簡要概述,以幫助理解多模態輸入。

- 推理階段在總結的基礎上,LLaVA-o1 進行結構化的邏輯推理,得出初步答案。

- 結論階段在最終階段,LLaVA-o1 根據之前的推理綜合生成答案。在這一階段,結論輸出直接提供給用戶,而前三個階段是 LLaVA-o1 的內部“隱藏階段”,代表其推理過程。結論階段的輸出會根據用戶的需求進行調整:例如,如果用戶請求簡短的答案,結論將簡明扼要;如果需要詳細解釋,結論將提供詳盡的、全面的回應。

每個階段由模型自主啟動,無需外部提示工程框架或額外提示。為模型提供了四組特殊標簽:??<SUMMARY></SUMMARY>???、??<CAPTION></CAPTION>???、??<REASONING></REASONING>??? 和 ??<CONCLUSION></CONCLUSION>??。這些標簽分別對應總結響應方法、描述相關圖像內容、進行推理以及準備最終答案。

在訓練過程中,模型根據自身判斷自主選擇這些標簽,并激活相應階段。與 OpenAI o1 類似,所有階段均在單次推理中由模型完成。這種結構化的方法使模型能夠獨立管理其推理過程,從而提升其在復雜推理任務中的適應性和性能。

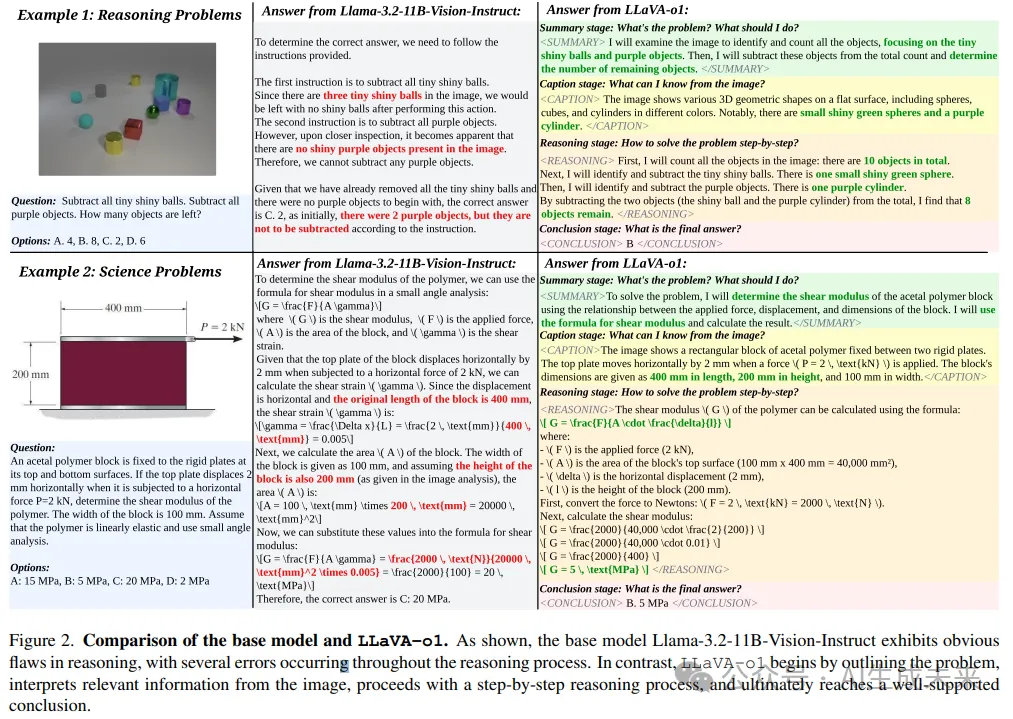

數據準備與模型訓練

現有的大多數 VQA 數據集缺乏訓練 LLaVA-o1 所需的詳細推理過程。因此,整合多個常用 VQA 數據集,構建了一個包含 99k 圖像問答對的新數據集(每對可能包括一個或多個回合的問答)。如下圖 3 所示,由于當前沒有多模態模型能夠直接生成系統化的結構化推理,研究者們使用 GPT-4o 生成詳細的推理過程,包括總結、描述、推理和結論,并將這些數據匯編成 LLaVA-o1-100k 數據集,計劃公開發布。

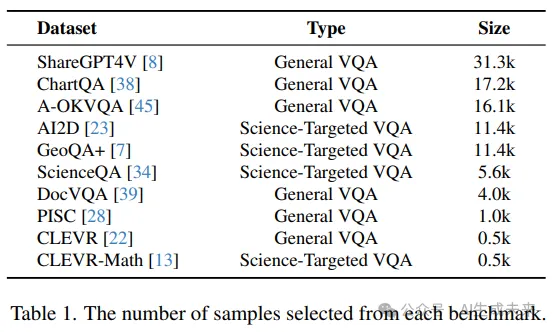

整合的數據既包括通用型 VQA 數據集,也包括面向科學的 VQA 數據集,具體如下:

通用 VQA 數據集

- ShareGPT4V:提供來自 GPT4V 交互的多輪問答數據。

- ChartQA:專注于解釋圖表和圖形。

- A-OKVQA:強調超越可見內容的外部知識。

- DocVQA:涉及基于文檔的問題,需理解文本內容。

- PISC:用于理解社會關系。

- CLEVR:解決對象屬性、空間關系和計數任務。

面向科學的 VQA 數據集 這些數據集包括用于幾何推理的 GeoQA+,以及專注于科學問題的 AI2D 和 ScienceQA。CLEVR-Math 是 CLEVR 的擴展版,專注于視覺背景下的算術分析。下表 1 列出了從每個數據集中選擇的問答對數量。

模型訓練

本文構建的 LLaVA-o1-100k 數據集可以用于對現有模型進行監督微調(Supervised Fine-Tuning, SFT),以增強其推理能力。在本研究中,選擇 Llama-3.2-11B-Vision-Instruct 模型作為基礎模型,并使用 LLaVA-o1-100k 數據集對其進行全參數微調。訓練在一臺配備 8 張 H100 GPU 的節點上完成。

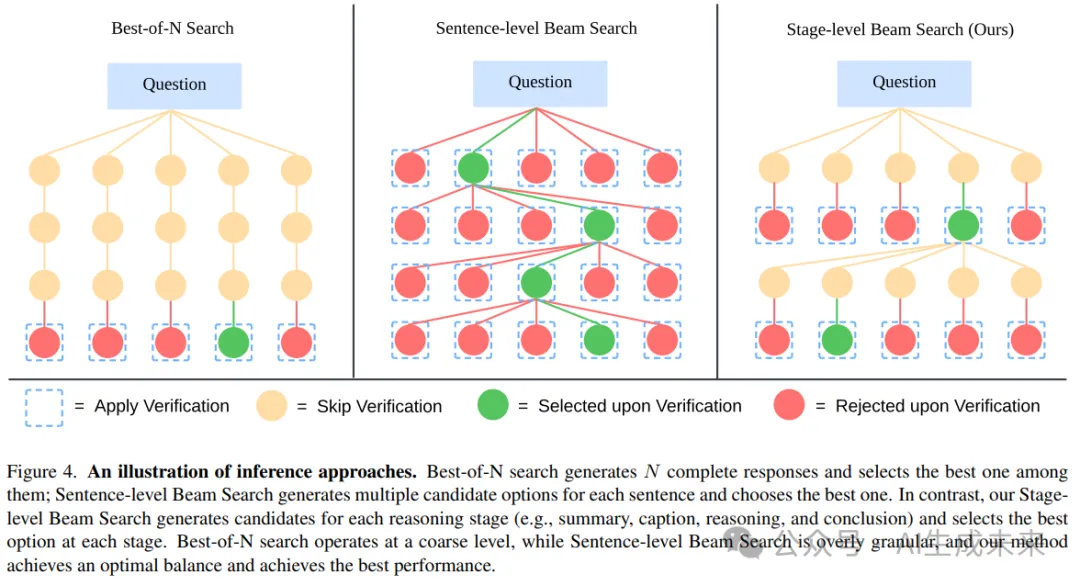

使用階段級束搜索實現有效的推理時間擴展

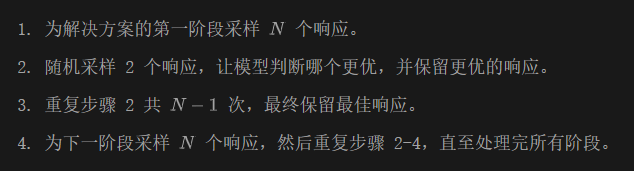

訓練完成后,在推理過程中進一步增強模型的推理能力。利用 LLaVA-o1 的階段輸出,這種分階段的結構化輸出為推理時間擴展提供了理想的粒度。方法包括以下步驟:

值得注意的是,正是 LLaVA-o1 的結構化輸出設計使得這一方法成為可能,從而在每個階段實現高效且準確的驗證。這驗證了結構化輸出在提高推理時間擴展中的有效性。三種方法的示意圖見下圖 4。

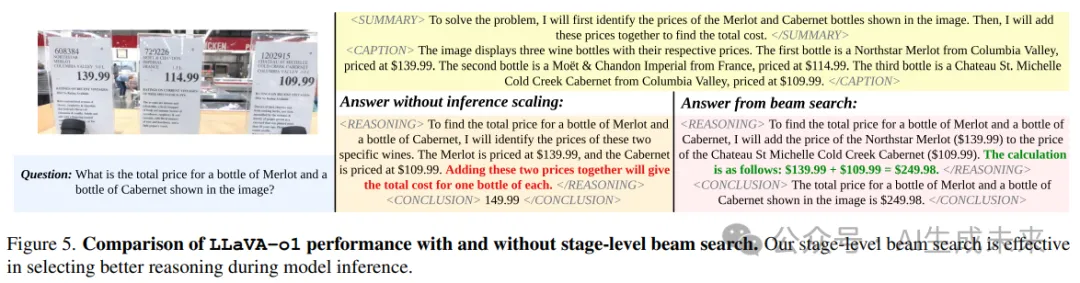

下圖 5 中提供了一個示例。當未應用推理時間擴展時,盡管模型生成了正確的推理步驟,但在推理過程中未能得出具體答案。這導致模型在結論階段進行猜測,從而得出錯誤結果。相比之下,應用推理時間擴展后,模型保留了通向最終結果的推理步驟,確保了答案的正確性。

后訓練性能

本節將 LLaVA-o1 與基礎模型 Llama-3.2-11B-Vision-Instruct 在六個常用的多模態基準上進行比較,以展示本文方法在訓練階段的有效性。隨后,通過消融研究評估方法中各組件的貢獻,重點解決以下三個關鍵問題:

- LLaVA-o1-100k 數據集是否比直接使用原始數據集的問答對更有效?

- 結構化標簽對性能的影響如何?具體而言,探討 LLaVA-o1 在沒有標簽的情況下,能否通過隱式分段實現響應的不同階段。

- 與基礎模型相比,本文的模型在哪些具體領域表現出最大的改進?是否真正增強了推理能力?

實驗設置

本文選擇了六個廣泛使用且具有挑戰性的基準數據集進行實驗:MMStar、MMBench V1.1、MMVet、MathVista、AI2D] 和 HallusionBench。

- MMStar、MMBench和MMVet主要評估模型的一般視覺問答能力。

- MathVista和AI2D關注模型在數學和科學推理方面的能力。

- HallusionBench專門評估模型處理語言幻覺和視覺錯覺的能力。

在 MMBench 基準中,使用測試集 V1.1;對于 MathVista,使用測試子集 testmini;其余數據集則各自包含單一測試集。

為確保公平性和可復現性,所有評估均使用開源評估工具包 VLMEvalKit 進行。所有基線模型的性能指標均來源于 VLMEvalKit 的測試結果。

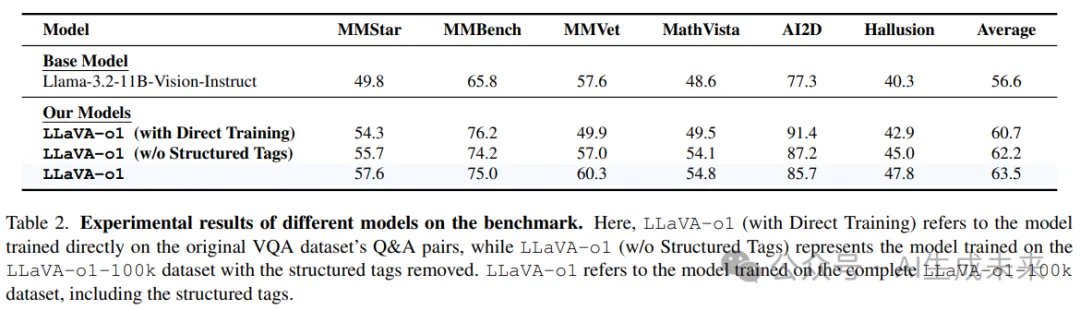

基準測試結果

盡管僅使用 100k 數據,LLaVA-o1 的性能仍顯著提升。根據下表 2,與基礎模型 Llama-3.2-11B-Vision-Instruct 相比,LLaVA-o1 在一般問答、數學推理、科學問答以及幻覺控制任務上均表現出顯著改進,平均基準得分提高了 6.9%,驗證了本文方法的有效性。

消融研究

LLaVA-o1-100k 數據集相比原始數據集的有效性

為了驗證改進后的 LLaVA-o1-100k 數據集的有效性,對比了 LLaVA-o1 和直接在原始問答對上訓練的模型在不同基準上的表現(見上表 2)。盡管直接在原始問答對上訓練的模型對基礎模型有一定的整體提升,其平均性能仍顯著較低,尤其是在需要更詳細回答的 MMVet 基準上,其表現甚至低于基礎模型。這一結果強調了 LLaVA-o1-100k 數據集中多階段格式在訓練具備高級推理能力的模型時的重要性。

結構化標簽對性能的必要性

為了研究引入的四個標簽是否提升了模型性能,比較了使用和不使用結構化標簽訓練的 LLaVA-o1 模型(均基于 LLaVA-o1-100k 數據集)。如上表 2 所示,去除標簽后性能顯著下降,表明結構化標簽促進了推理能力的發揮并提升了模型性能。LLaVA-o1 是首次通過帶標簽的結構化推理成功提升模型推理能力和整體性能的嘗試。

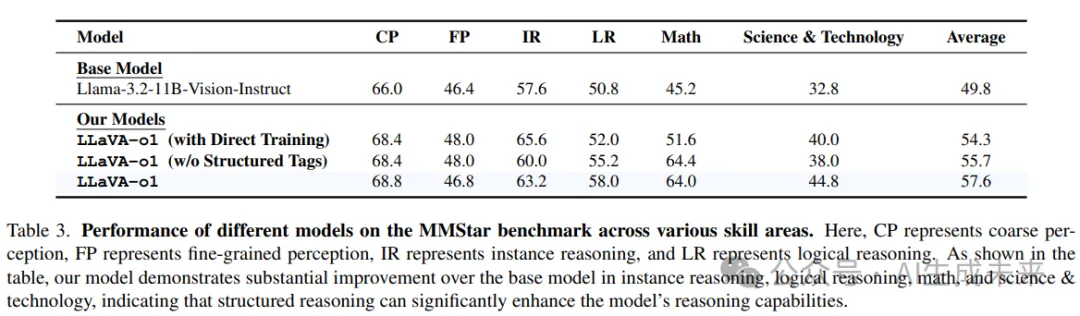

性能主要提升集中在推理密集領域為分析 LLaVA-o1 相較基礎模型在哪些具體領域有所提升,在 MMStar 基準上對模型在不同技能方面的表現進行了詳細評估。MMStar 用于評估六項核心能力:粗略感知、細粒度感知、實例推理、邏輯推理、數學以及科學與技術。

如下表 3 所示,LLaVA-o1 在需要系統推理的任務上(如實例推理、邏輯推理、數學、科學與技術)表現出顯著改進,而在粗略感知和細粒度感知上的提升相對較小。這表明本文的方法主要增強了模型的推理能力。

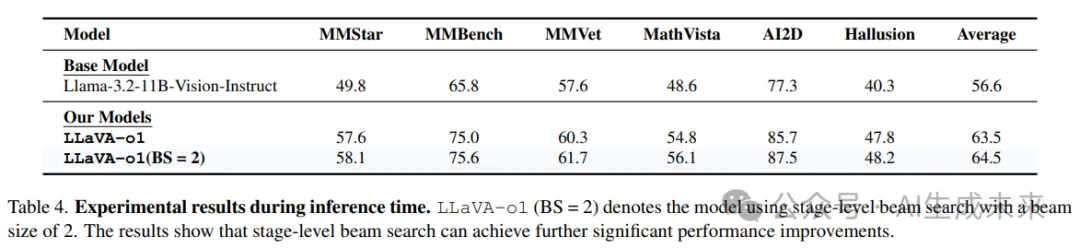

推理時間擴展

本節旨在比較階段級束搜索方法與傳統方法(如最佳 N 選擇法和句子級束搜索)在相似計算約束下的有效性。實驗設置與上一節一致,評估基準包括 MMStar、MMBench V1.1、MMVet、MathVista、AI2D 和 HallusionBench,所有評估均通過 VLMEvalKit 進行以確保結果可復現。

基準測試結果

如下表 4 所示,階段級束搜索在利用 LLaVA-o1 的結構化推理階段方面表現出了顯著的有效性。通過在每個推理階段評估輸出,該方法在嚴格的質量控制與計算效率之間達成了平衡,在復雜推理任務上顯著提升了推理準確性,同時未帶來明顯的計算開銷。這表明階段級束搜索是一種高效而強大的推理時間擴展方法,而這一點得益于 LLaVA-o1 的結構化輸出設計。

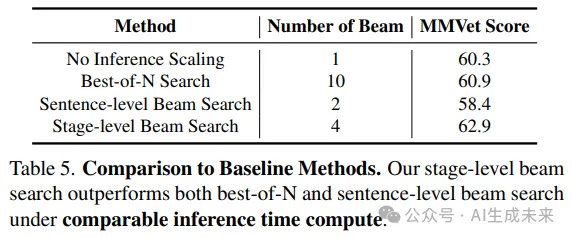

與基線方法的對比

為了評估相對性能,在 MMVet 基準上將階段級束搜索方法與基線推理擴展方法進行了對比。在公平比較的前提下,所有方法使用了相似的推理時間計算成本:

- 最佳 N 選擇法設置 (N = 10)。

- 階段級束搜索在每個階段生成 4 個候選響應。

- 句子級束搜索每句生成 2 個候選響應。

如下表 5 所示:

- 最佳 N 選擇法的性能僅提升了 0.6%。

- 句子級束搜索的性能甚至下降了 1.9%,主要原因是過于細粒度的句子級方法難以有效處理開放式問題。

- 階段級束搜索的性能提高了 2.6%,突顯了階段級搜索的優越性。

階段級束搜索的擴展趨勢

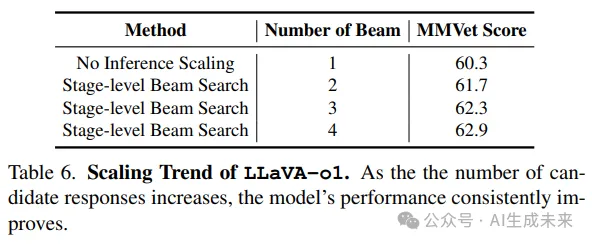

為了進一步驗證階段級束搜索在推理時間計算增加時的有效性,在 MMVet 基準上評估了不同束寬度下的 LLaVA-o1 性能。

如下表 6 所示,在每個推理階段生成 1 個(即無推理時間擴展)、2 個、3 個和 4 個候選響應,供模型選擇最佳答案。實驗結果表明,隨著候選響應數量的增加,模型性能持續提升,確認了階段級束搜索方法的可擴展性。

由于計算資源限制,僅測試了在所有基準上束寬度為 2 的情況。然而,預計進一步增加束寬度將帶來更顯著的性能提升。

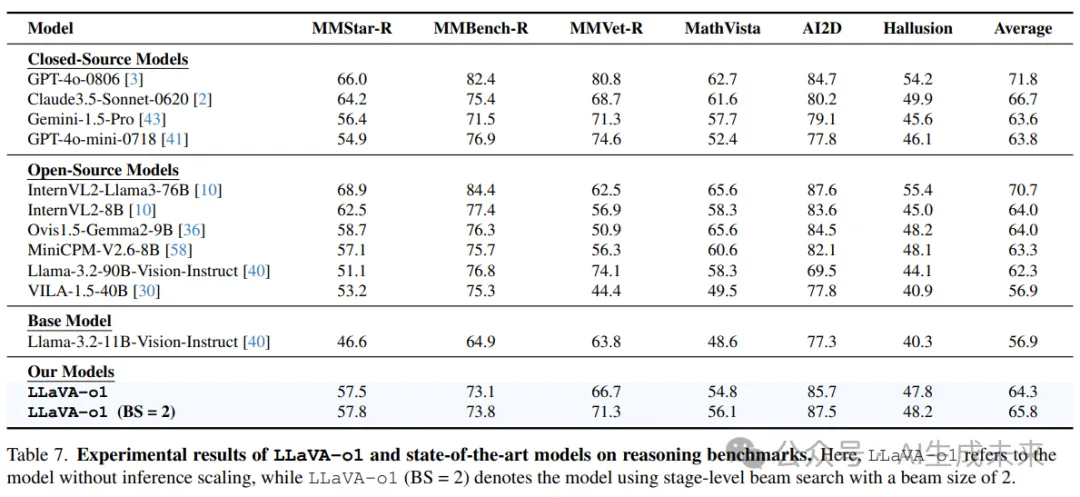

與最先進的視覺語言模型(VLMs)的比較

如下表7所示,將LLaVA-o1與其他最先進的開源和閉源視覺語言模型(VLM)在六個需要高級推理能力的基準上進行了比較:MMStar-R、MMBench-R、MMVet-R、MathVista、AI2D和HallusionBench。MMStar-R、MMBench-R和MMVet-R是從MMStar、MMBench V1.1和MMVet中衍生的自定義基準,去除了僅需要粗略感知、細粒度感知和OCR的任務。這些過濾后的基準保留了需要復雜推理的任務。MathVista、AI2D和HallusionBench本身聚焦于高級推理,因此保留了這些基準中的所有任務。

結果表明,LLaVA-o1在多個基準上始終優于許多開源模型,甚至是類似或更大規模的模型,如InternVL2-8B、Ovis1.5-Gemma2-9B、MiniCPM-V2.6-8B、Llama-3.2-90B-VisionInstruct和VILA-1.5-40B。值得注意的是,LLaVA-o1甚至超越了某些閉源模型,如GPT-4o-mini和Gemini-1.5-pro,凸顯了結構化推理方法的有效性。這一比較驗證了本文方法的優勢,特別是在那些高度依賴推理能力的基準上,并突出了LLaVA-o1在推理密集型VLM任務中的競爭力。

結論

本文提出了LLaVA-o1,一種新穎的視覺語言模型,能夠在多個階段執行結構化的自主推理。通過引入四個明確的階段——總結、描述、推理和結論——LLaVA-o1實現了一種系統化的推理過程。

本文的貢獻有兩個方面:首先,創建了LLaVA-o1-100k數據集,該數據集具有詳細的推理標注,支持對系統化、結構化響應的訓練;其次,提出了階段級束搜索方法,使推理時間擴展變得高效。

總的來說,LLaVA-o1為多模態推理樹立了新的標準,提供了強大的性能和可擴展性,尤其是在推理時間方面。本文的工作為未來在VLM中開展結構化推理的研究奠定了基礎,包括通過外部驗證器的擴展,以及使用強化學習進一步增強復雜多模態推理能力的潛力。

本文轉自AI生成未來 ,作者:AI生成未來